显著性目标检测中的视觉特征及融合

第34卷第8期2017年8月

计算机应用与软件

Computer Applications and Software

VoL34 No.8

Aug.2017

显著性目标检测中的视觉特征及融合

袁小艳u王安志1潘刚2王明辉1

\四川大学计算机学院四川成都610064)

2 (四川文理学院智能制造学院四川达州635000)

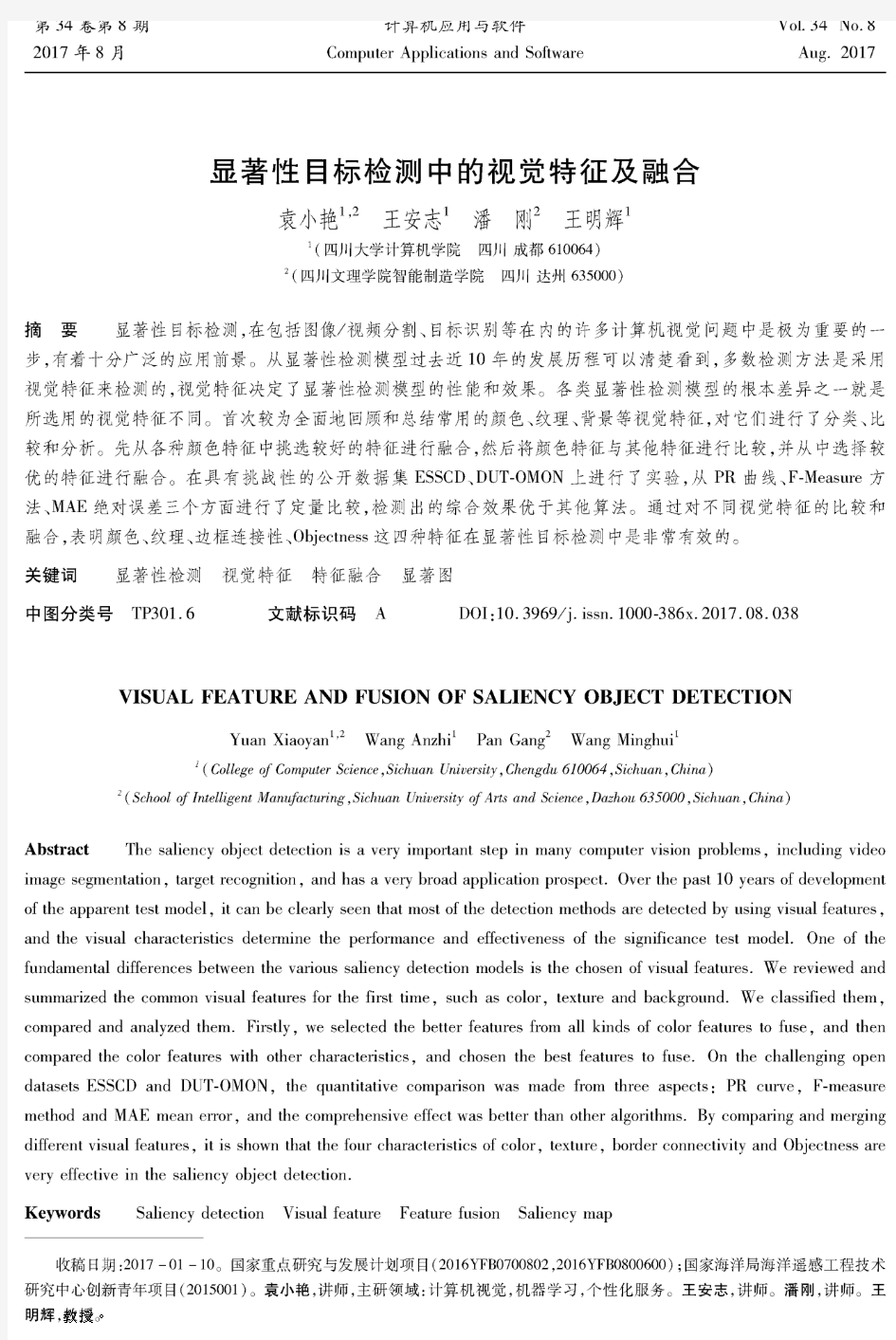

摘要显著性目标检测,在包括图像/视频分割、目标识别等在内的许多计算机视觉问题中是极为重要的一 步,有着十分广泛的应用前景。从显著性检测模型过去近10年的发展历程可以清楚看到,多数检测方法是采用 视觉特征来检测的,视觉特征决定了显著性检测模型的性能和效果。各类显著性检测模型的根本差异之一就是 所选用的视觉特征不同。首次较为全面地回顾和总结常用的颜色、纹理、背景等视觉特征,对它们进行了分类、比较和分析。先从各种颜色特征中挑选较好的特征进行融合,然后将颜色特征与其他特征进行比较,并从中选择较 优的特征进行融合。在具有挑战性的公开数据集ESSCD、DUT-0M0N上进行了实验,从P R曲线、F-M easure方法、M A E绝对误差三个方面进行了定量比较,检测出的综合效果优于其他算法。通过对不同视觉特征的比较和 融合,表明颜色、纹理、边框连接性、Objectness这四种特征在显著性目标检测中是非常有效的。

关键词显著性检测视觉特征特征融合显著图

中图分类号TP301.6 文献标识码 A DOI:10. 3969/j. issn. 1000-386x. 2017.08. 038

VISUAL FEATURE AND FUSION OF SALIENCY OBJECT DETECTION

Yuan Xiaoyan1,2Wang Anzhi1Pan Gang2Wang Minghui1

1 (College o f Computer Science,Sichuan University,Chengdu 610064,Sichuan,China)

2 {School o f Intelligent M anufacturing, Sichuan University o f A rts and Science, Dazhou 635000, Sichuan, China)

Abstract The saliency object detection is a very important step in many computer vision problems, including video image segmentation, target recognition, and has a very broad application prospect. Over the past 10 years of development of the apparent test model, it can be clearly seen that most of the detection methods are detected by using visual features, and the visual characteristics determine the performance and effectiveness of the significance test model. One of the fundamental differences between the various saliency detection models is the chosen of visual features. We reviewed and summarized the common visual features for the first time, such as color, texture and background. We classified them, compared and analyzed them. Firstly, we selected the better features from all kinds of color features to fuse, and then compared the color features with other characteristics, and chosen the best features to fuse. On the challenging open datasets ESSCD and DUT-OMON, the quantitative comparison was made from three aspects:PR curve, F-measure method and MAE mean error, and the comprehensive effect was better than other algorithms. By comparing and merging different visual features, it is shown that the four characteristics of color, texture, border connectivity and Objectness are very effective in the saliency object detection.

Keywords Saliency detection Visual feature Feature fusion Saliency map

收稿日期:2017-01-10。国家重点研究与发展计划项目(2016丫?80700802,2016丫?80800600);国家海洋局海洋遥感工程技术 研究中心创新青年项目(2015001)。袁小艳,讲师,主研领域:计算机视觉,机器学习,个性化服务。王安志,讲师。潘刚,讲师。王 明辉,教授。

结合域变换和轮廓检测的显著性目标检测

第30卷第8期计算机辅助设计与图形学学报Vol.30No.8 2018年8月Journal of Computer-Aided Design & Computer Graphics Aug. 2018结合域变换和轮廓检测的显著性目标检测 李宗民1), 周晨晨1), 宫延河1), 刘玉杰1), 李华2) 1) (中国石油大学(华东)计算机与通信工程学院青岛 266580) 2) (中国科学院计算技术研究所智能信息处理重点实验室北京 100190) (lizongmin@https://www.360docs.net/doc/527398407.html,) 摘要: 针对多层显著性图融合过程中产生的显著目标边缘模糊、亮暗不均匀等问题, 提出一种基于域变换和轮廓检测的显著性检测方法. 首先选取判别式区域特征融合方法中的3层显著性图融合得到初始显著性图; 然后利用卷积神经网络计算图像显著目标外部轮廓; 最后使用域变换将第1步得到的初始显著性图和第2步得到的显著目标轮廓图融合. 利用显著目标轮廓图来约束初始显著性图, 对多层显著性图融合产生的显著目标边缘模糊区域进行滤除, 并将初始显著性图中检测缺失的区域补充完整, 得到最终的显著性检测结果. 在3个公开数据集上进行实验的结果表明, 该方法可以得到边缘清晰、亮暗均匀的显著性图, 且准确率和召回率、F-measure, ROC以及AUC等指标均优于其他8种传统显著性检测方法. 关键词: 显著性目标; 卷积神经网络; 轮廓检测; 域变换融合 中图法分类号:TP391.41 DOI: 10.3724/SP.J.1089.2018.16778 Saliency Object Detection Based on Domain Transform and Contour Detection Li Zongmin1), Zhou Chenchen1), Gong Yanhe1), Liu Yujie1), and Li Hua2) 1)(College of Computer & Communication Engineering , China University of Petroleum, Qingtao 266580) 2) (Key Laboratory of Intelligent Information Processing, Institute of Computing Technology, Chinese Academy of Sciences, Beijing 100190) Abstract: In order to solve the problem of edge blur and brightness non-uniformity of salient object in the process of multi-level saliency maps integration, this paper proposes a saliency detection method based on domain transform and contour detection. Firstly, we obtain initial saliency map by integrate three saliency maps using DRFI method. Then, the salient object contour of image are computed by convolutional neural network. Finally, we use domain transform to blend the initial saliency map and the salient object contour. Under the constraints of the salient object contour, we can filter out the errors in the initial saliency map and compensate the missed region. The experimental results on three public datasets demonstrates that our method can produce a pixel-wised clearly saliency map with brightness uniformity and outperform other eight state-of-the-art saliency detection methods in terms of precision-recall curves, F-measure, ROC and AUC. Key words: salient object; convolutional neural network; contour detection; domain transform fuse 人类视觉系统可以快速定位图像中的显著区域, 显著性检测就是通过模拟人类大脑的视觉 收稿日期: 2017-07-10; 修回日期: 2017-09-12. 基金项目: 国家自然科学基金(61379106, 61379082, 61227802); 山东省自然科学基金(ZR2013FM036, ZR2015FM011). 李宗民(1965—), 男, 博士, 教授, 博士生导师, CCF会员, 主要研究方向为计算机图形学与图像处理、模式识别; 周晨晨(1992—), 女, 硕士研究生, 主要研究方向为计算机图形学与图像处理; 宫延河(1989—), 男, 硕士研究生, 主要研究方向为计算机图形学与图像处理; 刘玉杰(1971—), 男, 博士, 副教授, CCF会员, 主要研究方向为计算机图形图像处理、多媒体数据分析、多媒体数据库; 李华(1956—), 男, 博士, 教授, 博士生导师, CCF会员, 主要研究方向为计算机图形图像处理. 万方数据

基于全局对比度的显著性区域检测

基于全局对比度的显著性区域检测 Ming-Ming Cheng1Guo-Xin Zhang1 Niloy J. Mitra2 Xiaolei Huang3Shi-Min Hu1 1TNList, Tsinghua University 2 KAUST 3 Lehigh University 摘要 视觉显著性的可靠估计能够实现即便没有先验知识也可以对图像适当的处理,因此在许多计算机视觉任务中留有一个重要的步骤,这些任务包括图像分割、目标识别和自适应压缩。我们提出一种基于区域对比度的视觉显著性区域检测算法,同时能够对全局对比度差异和空间一致性做出评估。该算法简易、高效并且产出满分辨率的显著图。当采用最大的公开数据集进行评估时,我们的算法比已存的显著性检测方法更优越,具有更高的分辨率和更好的召回率。我们还演示了显著图是如何可以被用来创建用于后续图像处理的高质量分割面具。 1 引言 人们经常毫不费力地判断图像区域的重要性,并且把注意力集中在重要的部分。由于通过显著性区域可以优化分配图像分析和综合计算机资源,所以计算机检测图像的显著性区域存在着重要意义。提取显著图被广泛用在许多计算机视觉应用中,包括对兴趣目标物体图像分割[13, 18]、目标识别[25]、图像的自适应压缩[6]、内容感知图像缩放[28, 33,30, 9]和图像检索[4]等。 显著性源于视觉的独特性、不可预测性、稀缺性以及奇异性,而且它经常被归因于图像属性的变化,比如颜色、梯度、边缘和边界等。视觉显著性是通过包括认知心理学[26, 29]、神经生物学[8, 22]和计算机视觉[17, 2]在内的多学科研究出来的,与我们感知和处理视觉刺激密切相关。人类注意力理论假设人类视力系统仅仅详细处理了部分图像,同时保持其他的图像基本未处理。由Treisman和Gelade [27],Koch和Ullman [19]进行的早期工作,以及随后由Itti,Wolfe等人 提出的注意力理论提议将视觉注意力分为两个阶段:快速的、下意识的、自底向 上的、数据驱动显著性提取;慢速的、任务依赖的、自顶向下的、目标驱动显著

视觉检测系统报告

视觉检测系统报告 年春季学期研究生课程考核(阅读报告、研究报告)考核科目:视觉测量系统学所在院(系):电气工程及自动化学院学生所在学科:仪器科学与技术学生姓名:***学 号:10S001***学生类别:工学硕士考核结果: 阅卷人: 视觉测量系统课程报告第一部分视觉测量系统发展现状综述机器视觉自起步发展到现在,已有15年的发展历史。应该说机器视觉作为一种应用系统,其功能特点是随着工业自动化的发展而逐渐完善和发展的。 目前全球整个视觉市场总量大概在60~70亿美元,是按照每年 8、8%的增长速度增长的。而在中国,这个数字目前看来似乎有些庞大,但是随着加工制造业的发展,中国对于机器视觉的需求将承上升趋势。 一、机器视觉的定义及特点简言之,机器视觉就是用机器代替人眼来做测量和判断。机器视觉系统是指通过机器视觉产品(即图像摄取装置,分CMOS和CCD两种)将被摄取目标转换成图像信号,传送给专用的图像处理系统,根据像素分布和亮度、颜色等信息,转变成数字化信号;图像系统对这些信号进行各种运算来抽取目标的特征,进而根据判别的结果来控制现场的设备动作。

机器视觉系统的特点是提高生产的柔性和自动化程度。在一些不适合于人工作业的危险工作环境或人工视觉难以满足要求的场合,常用机器视觉来替代人工视觉;同时在大批量工业生产过程中,用人工视觉检查产品质量效率低且精度不高,用机器视觉检测方法可以大大提高生产效率和生产的自动化程度。而且机器视觉易于实现信息集成,是实现计算机集成制造的基础技术。 正是由于机器视觉系统可以快速获取大量信息,而且易于自动处理,也易于同设计信息以及加工控制信息集成,因此,在现代自动化生产过程中,人们将机器视觉系统广泛地用于工况监视、成品检验和质量控制等领域。在中国,这种应用也在逐渐被认知,且带来最直接的反应就是国内对于机器视觉的需求将越来越多。 二、机器视觉在国内外的应用现状在国外,机器视觉的应用普及主要体现在半导体及电子行业,其中大概40%~50%都集中在半导体行业。具体如PCB印刷电路:各类生产印刷电路板组装技术、设备;单、双面、多层线路板,覆铜板及所需的材料及辅料;辅助设施以及耗材、油墨、药水药剂、配件;电子封装技术与设备;丝网印刷设备及丝网周边材料等。SMT表面贴装:SMT工艺与设备、焊接设备、测试仪器、返修设备及各种辅助工具及配件、SMT材料、贴片剂、胶粘剂、焊剂、焊料及防氧化油、焊膏、清洗剂等;再流焊机、波峰焊机及自动化生产线设备。电子生产加工设备:电子元件制造设备、半导体及集成电路制造设备、元

视觉检测原理介绍

技术细节 本项目应用了嵌入式中央控制及工业级图像高速传输控制技术,基于CCD/CMOS与DSP/FPGA的图像识别与处理技术,成功建立了光电检测系统。应用模糊控制的精选参数自整定技术,使系统具有对精确检测的自适应调整,实现产品的自动分选功能。 图1 控制系统流程图 光电检测系统主要通过检测被检物的一些特征参数(灰度分布,RGB分值等),从而将缺陷信息从物体中准确地识别出来,通过后续的系统进行下一步操作,主要分为以下几部分 CCD/CMOS图像采集部分 系统图像数据采集处理板中光信号检测元件CCD/CMOS采用进口的适合于高精度检测的动态分析单路输出型、保证实际数据输出速率为320MB/s的面阵CCD/CMOS。像素分别为4000*3000和1600*1200,帧率达到10FPS。使用CCD/CMOS 作为输入图像传感器,从而实现了图像信息从空间域到时间域的变换。为了保证所需的检测精度,需要确定合理的分辨率。根据被检测产品的大小,初步确定系统设计分辨率为像素为0.2mm。将CCD/CMOS接收的光强信号转换成电压幅值,再经过A/D转换后由DSP/ FPGA芯片进行信号采集,即视频信号的量化处理过程,图像采集处理过程如图所示:

图2 图像采集处理过程 数据处理部分 在自动检测中,是利用基于分割的图像匹配算法来进行图像的配对为基础的。图像分割的任务是将图像分解成互不相交的一些区域,每一个区域都满足特定区域的一致性,且是连通的,不同的区域有某种显著的差异性。分割后根据每个区域的特征来进行图像匹配,基于特征的匹配方法一般分为四个步骤:特征检测、建立特征描述、特征匹配、利用匹配的“特征对”求取图像配准模型参数。 算法基本步骤如下: 1)利用图像的色彩、灰度、边缘、纹理等信息对异源图像分别进行分割,提取区域特征; 2)进行搜索匹配,在每一匹配位置将实时图与基准图的分割结果进行融合,得到综合分割结果; 3)利用分割相似度描述或最小新增边缘准则找出正确匹配位置。 设实时图像分割为m个区域,用符号{A1,A2,… Am}表示,其异源基准图像分割为n个区域,用符号{B1,B2,…Bn}表示。分割结果融合方法如下: 在每一个匹配位置,即假设的图像点对应关系成立时,图像点既位于实时图中,又位于其异源基准图像中,则融合后区域点的标识记为:(A1B1,A1B2,…,A2B1,A2B2,…)。标识AiBj表示该点在实时图中位于区域i,在基准图中位于区域j。算法匹配过程如下图所示:

显著性目标检测中的视觉特征及融合

第34卷第8期2017年8月 计算机应用与软件 Computer Applications and Software VoL34 No.8 Aug.2017 显著性目标检测中的视觉特征及融合 袁小艳u王安志1潘刚2王明辉1 \四川大学计算机学院四川成都610064) 2 (四川文理学院智能制造学院四川达州635000) 摘要显著性目标检测,在包括图像/视频分割、目标识别等在内的许多计算机视觉问题中是极为重要的一 步,有着十分广泛的应用前景。从显著性检测模型过去近10年的发展历程可以清楚看到,多数检测方法是采用 视觉特征来检测的,视觉特征决定了显著性检测模型的性能和效果。各类显著性检测模型的根本差异之一就是 所选用的视觉特征不同。首次较为全面地回顾和总结常用的颜色、纹理、背景等视觉特征,对它们进行了分类、比较和分析。先从各种颜色特征中挑选较好的特征进行融合,然后将颜色特征与其他特征进行比较,并从中选择较 优的特征进行融合。在具有挑战性的公开数据集ESSCD、DUT-0M0N上进行了实验,从P R曲线、F-M easure方法、M A E绝对误差三个方面进行了定量比较,检测出的综合效果优于其他算法。通过对不同视觉特征的比较和 融合,表明颜色、纹理、边框连接性、Objectness这四种特征在显著性目标检测中是非常有效的。 关键词显著性检测视觉特征特征融合显著图 中图分类号TP301.6 文献标识码 A DOI:10. 3969/j. issn. 1000-386x. 2017.08. 038 VISUAL FEATURE AND FUSION OF SALIENCY OBJECT DETECTION Yuan Xiaoyan1,2Wang Anzhi1Pan Gang2Wang Minghui1 1 (College o f Computer Science,Sichuan University,Chengdu 610064,Sichuan,China) 2 {School o f Intelligent M anufacturing, Sichuan University o f A rts and Science, Dazhou 635000, Sichuan, China) Abstract The saliency object detection is a very important step in many computer vision problems, including video image segmentation, target recognition, and has a very broad application prospect. Over the past 10 years of development of the apparent test model, it can be clearly seen that most of the detection methods are detected by using visual features, and the visual characteristics determine the performance and effectiveness of the significance test model. One of the fundamental differences between the various saliency detection models is the chosen of visual features. We reviewed and summarized the common visual features for the first time, such as color, texture and background. We classified them, compared and analyzed them. Firstly, we selected the better features from all kinds of color features to fuse, and then compared the color features with other characteristics, and chosen the best features to fuse. On the challenging open datasets ESSCD and DUT-OMON, the quantitative comparison was made from three aspects:PR curve, F-measure method and MAE mean error, and the comprehensive effect was better than other algorithms. By comparing and merging different visual features, it is shown that the four characteristics of color, texture, border connectivity and Objectness are very effective in the saliency object detection. Keywords Saliency detection Visual feature Feature fusion Saliency map 收稿日期:2017-01-10。国家重点研究与发展计划项目(2016丫?80700802,2016丫?80800600);国家海洋局海洋遥感工程技术 研究中心创新青年项目(2015001)。袁小艳,讲师,主研领域:计算机视觉,机器学习,个性化服务。王安志,讲师。潘刚,讲师。王 明辉,教授。

图像显著性目标检测算法研究

图像显著性目标检测算法研究 随着移动电子设备的不断升级与应用,使用图像来记录或表达信息已成为一种常态。我们要想快速地在海量图像中提取出有价值的信息,那么需要模拟人类视觉系统在机器视觉系统进行计算机视觉热点问题的研究。 图像显著性目标检测对图像中最引人注意且最能表征图像内容的部分进行检测。在图像显著性目标检测任务中,传统的方法一般利用纹理、颜色等低层级视觉信息自下向上地进行数据驱动式检测。 对于含有单一目标或高对比度的自然场景图像,可以从多个角度去挖掘其显著性信息,如先验知识、误差重构等。然而,对于那些具有挑战性的自然场景图像,如复杂的背景、低对比度等,传统的方法通常会检测失败。 基于深度卷积神经网络的算法利用高层级语义信息结合上下文充分挖掘潜在的细节,相较于传统的方法已取得了更优越的显著性检测性能。本文对于图像显著性检测任务存在的主要问题提出了相应的解决方法。 本文的主要贡献如下:为充分挖掘图像多种显著性信息,并使其能够达到优势互补效果,本文提出了一种有效的模型,即融合先验信息和重构信息的显著性目标检测模型。重构过程包括密度重构策略与稀疏重构策略。 密度重构其优势在于能够更准确地定位存在于图像边缘的显著性物体。而稀疏重构更具鲁棒性,能够更有效地抑制复杂背景。 先验过程包含背景先验策略与中心先验策略,通过先验信息可更均匀地突出图像中的显著性目标。最后,把重构过程与先验过程生成的显著特征做非线性融合操作。 实验结果充分说明了该模型的高效性能与优越性能。针对图像中存在多个显

著性目标或者检测到的显著性目标存在边界模糊问题,本文提出了一种基于多层级连续特征细化的深度显著性目标检测模型。 该模型包括三个阶段:多层级连续特征提取、分层边界细化和显著性特征融合。首先,在多个层级上连续提取和编码高级语义特征,该过程充分挖掘了全局空间信息和不同层级的细节信息。 然后,通过反卷积操作对多层级特征做边界细化处理。分层边界细化后,把不同层级的显著特征做融合操作得到结果显著图。 在具有挑战性的多个基准数据集上使用综合评价指标进行性能测试,实验结果表明该方法具有优越的显著性检测性能。对于低对比度或者小目标等问题,本文提出一种新颖模型,即通道层级特征响应模型。 该模型包含三个部分:通道式粗特征提取,层级通道特征细化和层级特征图融合。该方法基于挤压激励残差网络,依据卷积特征通道之间的相关性进行建模。 首先,输入图像通过通道式粗特征提取过程生成空间信息丢失较多的粗糙特征图。然后,从高层级到低层级逐步细化通道特征,充分挖掘潜在的通道相关性细节信息。 接着,对多层级特征做融合操作得到结果显著图。在含有复杂场景的多个基准数据集上与其它先进算法进行比较,实验结果证明该算法具有较高的计算效率和卓越的显著性检测性能。

机器视觉检测分解

研究背景: 产品表面质量是产品质量的重要组成部分,也是产品商业价值的重要保障。产品表面缺陷检测技术从最初的依靠人工目视检测到现在以CCD 和数字图像处理技术为代表的计算机视觉检测技术,大致经历了三个阶段,分别是传统检测技术阶段、无损检测技术阶段、计算机视觉检测技术阶段。[] 传统检测技术 (1)人工目视检测法 (2)频闪检测法 无损检测技术 (1)涡流检测法 (2)红外检测法 (3)漏磁检测法 计算机视觉检测技术 (1)激光扫描检测法 (2)CCD 检测法 采用荧光管等照明设备,以一定方向照射到物体表面上,使用CCD摄像机来扫描物体表面,并将获得的图像信号输入计算机,通过图像预处理、缺陷区域的边缘检测、缺陷图像二值化等图像处理后,提取图像中的表面缺陷的相关特征参数,再进行缺陷图像识别,从而判断出是否存在缺陷及缺陷的种类信息等。 优点:实时性好,精确度高,灵活性好,用途易于扩充,非接触式无损检测。 基于机器视觉的缺陷检测系统优点: 集成化生产缩短产品进入市场时间改进生产流程100%质量保证实时过程监控提高产量精确检测100%检测 由于经济和技术原因国内绝大多数图像处理技术公司都以代理国外产品为主,没有或者很少涉足拥有自主知识产权的机器视觉在线检测设备,对视觉技术的开发应用停留在比较低端的小系统集成上,对需要进行大数据量的实时在线检测的研究很少也很少有成功案例,但是随着国内经济发展和技术手段不断提高对产品质量检测要求就更高,对在线检测设备的需求也就更大具有巨大的市场潜力。 机器视觉图像处理技术是视觉检测的核心技术 铸件常见缺陷:砂眼气孔缩孔披缝粘砂冷隔掉砂毛刺浇不足缺陷变形 问题的提出: 1.水渍、污迹等不属于铸件缺陷,但由于其外观形貌与缺陷非常类似, 因此易被检测系统误识为缺陷。从目前发表的文献来看,对于伪缺陷的识别率较低。 2.不同种缺陷之间可能存在形状、纹理等方面的相似性,造成缺陷误判。 国外研究发展现状: 20 世纪90 年代后,基于机器视觉检测系统的自动化功能和实用化水平得到了进一步的提高。 1990 年芬兰Rautaruukki New Technology公司研制了Smartivis表面检测系统[],该系统具有自学习分类功能,应用机器学习方法对决策树结构进行自动设计优化。 1996 年美国Cognex公司研发了一套iLearn自学习分类器软件系统并应用于其研制了iS-2000 自动检测系统。通过这两套系统的无缝衔接,极大地提高了检测系统实时的运算速度,有效的改进了传统自学习分类方法在算法执行速度、数据实时吞吐量、样本训练集规模及模式特征自动选择等方面的不足之处[]。 2004 年Parsytec公司发布了新一代表面质量检测产品Parsytec5i,该系统运用了自学习神经

图像处理文献综述

文献综述 近年来,随着计算机视觉技术的日益发展,图像处理作为该领域的关键方向受到越来越多研究人员的关注与思考。在现在的日常生活中,由于通信设备低廉的价格和便捷的操作,人们越来越喜欢用图像和视频来进行交流和分享,消费性的电子产品在消费者中已经非常普遍,例如移动手机和数码相机等等。在这个纷繁多变的世界,每天都有数以万计的图像产生,同时信息冗余问题也随之而来。尽管在一定的程度上,内存技术的增加和网络带宽的提高解决了图像的压缩和传输问题,但是智能的图像检索和有效的数据存储,以及图像内容的提取依然没有能很好的解决。 视觉注意机制可以被看做是人类对视觉信息的一个筛选过程,也就是说只有一小部分重要的信息能够被大脑进行处理。人类在观察一个场景时,他们往往会将他们的注意力集中在他们感兴趣的区域,例如拥有鲜艳的颜色,光滑的亮度,特殊的形状以及有趣的方位的区域。传统的图像处理方法是将整幅图像统一的处理,均匀的分配计算机资源;然而许多的视觉任务仅仅只关系图像中的一个或几个区域,统一的处理整幅图像很明显会浪费过多的计算机资源,减少处理的效率[1,2]。因此,在计算机视觉领域,建立具有人类视觉系统独特数据筛选能力的数学模型显得至关重要。受高效的视觉信息处理机制的启发,计算机视觉领域的显著性检测应运而生。图像显著性检测是通过建立一定的数学模型,让计算机来模拟人类的视觉系统,使得计算机能够准确高效的定位到感兴趣的区域。 一般来说,一个信号的显著性可以表示为其和周围环境的差异性。正是因为这个信号和周围的其他信号的迥异性,使得视觉系统不需要对环境中的所有感兴趣的区域进行逐个的扫描,显著的目标会自动从环境中凸显出来。另外,一些心理学研究表明人类的视觉机制不仅仅是由低级的视觉信号来驱动的,基于记忆、经验等的先验知识同样能够决定场景中的不同信号的显著性,而这些先验知识往往是和一些高层次的事件以及视觉任务联系在一起的。基于当前场景的视觉显著性机制是低级的,慢速的。而基于先验知识的显著性机制通常是和高层次的任务关联在一起的,其效率通常低于由视觉信号驱动的显著性机制。人眼视觉系统通过显著性原理来处理复杂的视觉感知是不争的事实,这种显著性的处理机制使得复杂背景下的目标检测、识别有了很大程度的提升。 在模式识别、计算机视觉等领域,越来越多的计算机工作者致力于开发显著性计算模型,用以简单的表达图像的主要信息。这些显著性模型的检测结果是一个显著性灰度图,其每个像素点的灰度值表示了该像素的显著性,灰度值越大,表明该像素越显著。从信息处理的方式看,显著性模型大致可以分为两类:自顶向下(任务驱动)和自底向上(数据驱动)的方法。 自顶向下的显著性检测方法之所以是任务驱动,这是因为该类模型通常是和某一特定的任务相关。在同样的场景或模式下,检测到的结果因任务的不同而不同是自顶向下模型最突出的特点。例如在目标检测中,检测者需要首先告诉需要检测的目标是什么,检测到的显著性图则表示目标可能出现的位置。自顶向下的显著性检测方法的依据是:如果研究者事先知道需要检测目标的颜色、形状或者方向等特征,那么该检测算法自然会高效的检测到需要检测的目标。因此,自顶向下的算法通常需要人工标记,或是从大量的包含某种特定目标的图像中学习该类目标的特征信息,这些学习方法一般是监督的;然后求测试图像对于训练学习得到的信息的响应,从而得到测试图像的显著性图。现存的一些自顶向下的算法在某些特定的目标上取得了一定的效果,不过这些算法往往只对某些特定的目标有效,对于复杂多变的自然图像,该类算法存在很大的缺陷。自顶向下的模型是慢速的、任务驱动的,有意识的,以及封闭回路的。由于自顶向下模型的特点,其应用受到了很大的限制。

视觉目标检测算法说明

视觉目标检测算法说明 1.功能 通过安装在战车上的摄像头,检测视野范围内的敌方战车。 2.算法: 2.1目标检测与识别 1.颜色检测 采集大量敌方机器人的图片数据,并进行训练,得到对方机器人的颜色区间, 并以此为阈值对整幅图像进行颜色检测,找到疑似敌方机器人的区域,量化 成二值图。 2.滤除噪声点 对得到的二值图像进行开运算处理,滤除颜色检测结果中的噪声点。 3.连通区域检测 对图像中的疑似区域进行连通区域检测,计算出每个疑似区域的外部轮廓, 用矩形近似表示。 4.连通区域合并 根据连通区域之间的距离和颜色相似性,将距离接近且相似性高的连通区域 进行合并。 5.形状和大小过滤 对大量敌方机器人图片进行训练,得到对方机器人的形状信息(例如长宽比) 和大小信息(面积),并以此为依据将不符合的区域过滤掉。 经过以上五步的处理,可以初步得到敌方机器人的位置、大小和形状信息。 2.2目标运动跟踪 对上步中的检测结果进行运动跟踪。 1.状态估计 根据上一时刻地方机器人的运动状态(包括位置和速度),估算当前时刻机 器人的运动状态。 2.轨迹关联 根据位置和颜色信息,对当前时刻机器人的估计状态和检测结果进行关联。 3.状态更新 若上一步中关联成功,更新当前时刻的运动状态。 通过对检测结果进行运动跟踪,可以计算出当前时刻敌方机器人的运动速度和方 向。 2.3预估提前量

1.评估延迟时间 根据己方机器人实际的调试情况,通过多次试验和统计的方法,估算己方机器人从接收命令到炮弹(或子弹)击中目标区域的时间延时(包括图像处理 时间、落弹时间和炮弹飞行时间)。 2.计算提前量 根据延迟时间和敌方机器人的运动速度,计算炮弹发射的提前量,补偿到敌方机器人的运动状态中。 3.总结: 对于机器人战车中的敌方目标检问题,有很多种方法可以实现,视觉检测只是其中的一种方法,而基于颜色识别的目标检测也只是视觉算法中比较简单有效的一种。所以,本段代码只是抛砖引玉的一个样本,适用范围只针对于2014年RoboMasters夏令营的场地和战车,希望可以看到大家更加简单有效的算法。

基于视觉显著性的红外与可见光图像融合

第38卷第4期 2016年8月 光学仪器 OPTICAL INSTRUMENTS Vol. 38,No. 4 August,2016 文章编号:1005-5630(2016)04-0303-05 基于视觉显著性的红外与可见光图像融合 华玮平S赵巨岭S李梦S高秀敏〃 (1.杭州电子科技大学电子信息学院,浙江杭州310018; 2.上海理工大学光电信息与计算机工程学院,上海200093) 摘要:多波段图像融合可以有效综合各个波段图像中包含的特征信息。针对可见光和红外图 像,提出了一种结合红外图像视觉显著性提取的双波段图像融合方法,一方面旨在凸显红外图 像的目标信息,另一方面又尽可能的保留了可见光图像的丰富细节信息。首先,在局部窗口内 实现红外图像的显著性图提取,并通过窗口尺寸的变化形成多尺度的显著性图,并对这些显著 性图进行最大值的优选叠加,以获取能反映整幅红外图像各个尺寸目标的显著性图;其次,通过 结合显著性图与红外图实现显著性图的加权增强;最后,利用增强的红外显著性图进行双波段 图像的融合。通过两组对比实验,数据表明该方法给出的融合图像视觉效果好,运算速度快,客 观评价值优于对比的7种融合方法。 关键词:图像融合;红外图像增强;视觉显著性 中图分类号:TN 911. 73 文献标志码:A doi:10. 3969/j. issa 1005-5630. 2016. 04. 005 Dual-band image fusion for infrared and visible images based on image visual saliency HUA Weiping1, ZHAO Jufeng1, LI Meng1, GAO Xiumin1,2 (1. Electronics and Information College, Hangzhou Dianzi University, Hangzhou 310018, China; 2. School of Optical-Electrical and Computer Engineering, University of Shanghai for Science and Technology, Shanghai 200093,China) Abstract: Dual-band image fusion is able to well synthesize the feature information from the different bands. To fuse visible and infrared images, in this paper, an infrared image visual saliency detection-based approach was proposed. This method aimed to highlight the target information from infrared image, meanwhile preserve abundant detail information from visible one as much as possible. Firstly, visual saliency map was extracted within a local window, and multiple window-based saliency maps could be obtained by changing the size of local window. And the final saliency map was generated by selecting maximum value, and this map could mirror all target information in the infrared image. Secondly,the saliency map was enhanced by combining infrared image and the previous saliency map. Finally, the enhanced saliency map was used for dual-band image fusion. Comparing with other seven methods, the 收稿日期:2015-10-13 基金项目:国家自然科学基金项目(61405052,61378035) 作者简介:华玮平(1994 ),男,本科生,主要从事光学成像等方面的研究。E-m ail:564810049@qq.c〇m 通信作者:赵巨峰(1985 ),男,讲师,主要从事光学成像、图像处理等方面的研究。E-m ail:daba〇zjf@https://www.360docs.net/doc/527398407.html,.C n

视觉显著性检测方法及其应用研究

视觉显著性检测方法及其应用研究 随着科学技术和多媒体技术的发展,人们在日常生活中产生的多媒体数据,尤其是图像数据呈指数级增长。海量的图像数据除了使人们的日常生活变得丰富多彩和便利之外,也给计算机视觉处理技术提出了新的挑战。 大部分图像中只包含了少量重要的信息,人眼视觉系统则具有从大量数据中找出少量重要信息并进行进一步分析和处理的能力。计算机视觉是指使用计算机模拟人眼视觉系统的机理,并使其可以像人类一样视察与理解事物,其中的一个关键问题为显著性检测。 本文针对目前已有显著性检测方法存在的问题,将重点从模拟人眼视觉注意机制以及针对图像像素和区域的鲁棒特征提取方法进行专门的研究。同时,本文还将显著性检测思想和方法引入到场景文本检测的研究中,既能提高场景文本检测的性能,又能拓展基于显著性检测的应用范畴。 针对人眼视觉注意机制的模拟,本文提出了一种基于超像素聚类的显著性检测方法。该方法分析了人眼视觉注意机制中由粗到细的过程,并采用计算机图像处理技术来模拟该过程。 具体而言,本文首先将原始图像分割为多个超像素,然后采用基于图的合并聚类算法将超像素进行聚类,直到只有两个类别为止,由此得到一系列具有连续类别(区域)个数的中间图像。其中在包含类别数越少的中间图像中的区域被给予更大的权重,并采用边界连通性度量来计算区域的显著性值,得到初始显著性图。 最终基于稀疏编码的重构误差和目标偏见先验知识对初始显著性图进一步细化得到最终的显著性图。针对鲁棒特征提取,本文提出了一种基于区域和像素级融合的显著性检测方法。

对于区域级显著性估计,本文提出了一种自适应区域生成技术用于区域提取。对于像素级显著性预测,本文设计了一种新的卷积神经网络(CNN)模型,该模型考虑了不同层中的特征图之间的关系,并进行多尺度特征学习。 最后,提出了一种基于CNN的显著性融合方法来充分挖掘不同显著性图(即 区域级和像素级)之间的互补信息。为了提高性能和效率,本文还提出了另一种基于深层监督循环卷积神经网络的显著性检测方法。 该网络模型在原有的卷积层中引入循环连接,从而能为每个像素学习到更丰富的上下文信息,同时还在不同层中分别引入监督信息,从而能为每个像素学习 到更具区分能力的局部和全局特征,最后将它们进行融合,使得模型能够进行多 尺度特征学习。针对基于文本显著性的场景文本检测方法的研究,本文提出了一种仅对文本区域有效的显著性检测CNN模型,该模型在不同层使用了不同的监督信息,并将多层信息进行融合来进行多尺度特征学习。 同时为了提高文本检测的性能,本文还提出了一种文本显著性细化CNN模型和文本显著性区域分类CNN模型。细化CNN模型对浅层的特征图与深层的特征图进行整合,以便提高文本分割的精度。 分类CNN模型使用全卷积神经网络,因此可以使用任意大小的图像作为模型的输入。为此,本文还提出了一种新的图像构造策略,以便构造更具区分能力的图像区域用于分类并提高分类精度。

育龄妇女计划外妊娠原因分析

育龄妇女计划外妊娠原因分析 临床资料 根据1848例病历中病史记载及b超检查,统计育龄妇女避孕失败原因及节育器失败的原因及类型,其中工具避孕失败976例,居首位,占意外妊娠总数的528%;带器妊娠322例(174%),无措施376例(203%),脱环87例(471%),漏服避孕药4 例(022%),其他83例(449%)。 带器妊娠322例中,圆形环35例(1087%),宫形环67例(20 81%),圆宫环43例(1335%),t形环127例(687%),母体乐4例(124%),吉妮6例(186%),安舒29例(9%),环状不清11例(342%)。 节育器脱落87例中,圆形11例(1264%),宫形23例(26 44%),t形17例(1954%),母体乐4例(460%),吉妮2例(230%),安舒6例(690%),圆宫18例(2069%),环状不清6例(690%)。 避孕失败原因分析 本研究资料显示,导致意外妊娠的主要原因依次为避孕套漏用、带器妊娠、无措施、节育器脱落、避孕药漏服,其他可能与以下因素有关:①育龄妇女对避孕药具的正确使用方法掌握不到位:避孕套较高的使用率与避孕知识不足,导致其不正确使用以及使用体外

排精和安全期避孕方法仍可导致避孕失败,或不愿全程使用避孕套,导致避孕失败。②对无措施人员管理不到位,宣传力度不够:因漏管造成意外怀孕,发生无保护性行为后,能主动采取紧急避孕措施施与以补救的比例很低,虽然大多数育龄妇女认为其男伴关注避孕问题,但主动采用比例并不高。③宫腔大、宫口松驰、体力劳动过强及放置宫内节育器后月经过多易造成节育器移位或脱落外,多与手术者的技术操作熟练程度、选用宫内节育器的大小及制作材料有关。如宫内节育器未放置到底或宫内节育器过小,位于宫腔的下方或一侧,均可导致脱落、带器妊娠或移位,导致怀孕。如宫内节育器放置到位,其下移和脱落的动因是与子宫的收缩、宫内节育器的材料、形状、与子宫形态的匹配以及子宫的敏感性和收缩强度等因素有关。没有定期进行环情监测,对环移位及脱落者不能及时发现,环到期没有及时更换,造成意外怀孕。④避孕知识不足,有效避孕措施采用缺失,现有咨询宣教与药具发放服务空白式避孕失败的重要问题。 讨论 加强计划生育服务知识宣教,国际上提倡流产后计划生育服务,借助人工流产服务的机会向育龄妇女提供生殖健康宣教及避孕药具,帮助每位妇女自己决定是否需要及如何选择恰当避孕方法,并使其及其性伴侣能有效的使用这种避孕方法,目前中国流产后计划生育服务仍与国际有较大差距。流产后育龄妇女急需由专业医务人员对其进行系统的避孕方法知识宣教,增强有关知识,纠正以往的

基于多尺度深度特征的视觉显著性

基于多尺度深度特征的视觉显著性 视觉显著性在认知和计算科学是一个基本的问题,包括计算机视觉。在本文中,我们发现一个高质量的视觉显著性模型可以使用深度卷积神经网络抽取多尺度特征来学习,这些在视觉识别工作中已经有很多成功的例子。为了学习显著性模型,我们提出一种为了在三个不同的尺度提取的特征可以和CNN的顶层充分连接的神经网络架构。接着我们提出了一个细化方法来加强显著性结果的空间一致性。最后,融合多个显著图计算为图像分割的不同水平可以更好的促进性能,收益率显著图比从单一分割产生的图像要好。为了促进视觉显著模型的进一步研究和评价,我们也建立一个新的拥有4447张挑战性图片的大型数据库及其注释。实验结果表明,我们提出的方法在所有公共基准能够实现最先进的性能,在MSRA-B数据集和我们的新数据集(HKU-IS)改善F-Measure的效果分别为5.0%和13.2%,降低了这两个数据集平均绝对误差分别为5.7%和35.1%。 1.介绍 总结,这篇文章有以下贡献: 一个新的视觉显著模型被提出用于从一个拥有多个完全连接层的深度神经网络的嵌套的窗口将多尺度CNN特征提取。用于显著性估计的深度神经网络是可以用一组标记的显著图区域来训练的。 一个完整的显著性框架是由进一步整合我们的用空间一致性模型和多级图像分割基于CNN的显著性模型开发而成的。 HKU-IS是用来显著性模型研究和评估而创建的一个新的具有挑战的数据集。这个数据集是对外公开的。我们提出的显著性模型已经成功地验证了这个新数据集和所有现有的数据集。 2.相关工作 视觉显著计算可以分为自底向上和自顶向下的方法或两者的混合。自底向上的模型主要是基于c enter-surround方案,通过低级视觉属性的线性或非线性结合来计算主显著图,如颜色、强度、结构和方向。自上而下的方法通常需要高层知识的整合,如在计算过程中目标和人脸识别检测。最近,设计区别特征和显著先验的工作已经取得了很大成效。大多数方法基本上都遵循区域对比框架,旨在设计更好的描述图像区域与其周边地区的特殊性的特性。在【26】中,三个新奇特征与条件随机场(条件随机场(conditional random field,简称 CRF),是一种鉴别式机率模型,是随机场的一种,常用于标注或分析序列资料,如自然语言文字或是生物序列。条件随机场为无向性之图模型,图中的顶点代表随机变量,顶点间的连线代表随机变量间的相依关系,在条件随机场当中,随机变量 Y 的分布为条件机率,给定的观察值则为随机变量 X。原则上,条件随机场的图模型布局是可以任意给定的,一般常用的布局是链结式的架构,链结式架构不论在训练(training)、推论(inference)、或是解码(decoding)上,都存在有效率的算法可供演算。)结合。在【33】中提出了一个基于低秩矩阵恢复的模型用于整合底层视觉特征与高层次先验。 显著先验和中心先验与边界先验一样被广泛应用于启发结合低级线索的和改善显著估计。这些显著先验直接结合其他显著的线索权重或者用于特征学习算法。虽然这些经验对于很多图像来说可以改变显著结果,但当显著目标偏离中心或明显在图像边界重叠就会失败。我们应该注意到目标位置线索和基于背景的背景模型在我们的框架中并没有被忽视,而是一直通过CNN的多尺度特征提取和神经网络训练含蓄地纳入进我们的模型。 最近,CNNs在视觉识别工作中取得了很多成就,包括图像分类、目标检测和场景解析。Dona hue等在【11】中指出从ImageNet数据集训练的Krizhevsky的CNN提取的特征可以转化成一般的任务。Razavian等在【30】中拓展他们的结果并得出深度学习和CNNs对于所有的视觉识别任务可以成为一个强有力的候选的结论。然而,CNN特征并没有探索视觉显著性研究主要是因为在【11,30】