视频文件音视频不同步的调整

视频文件音视频不同步的调整

(2008-03-15 11:17:39)

◆视频文件音视频不同步的调整◆

大家可能经常会遇到辛辛苦苦下载或者制作的视频竟然声音画面不同步,实在是很令人郁闷。造成音视频不同步主要有三种原因:1、机器配置太低,播放高码率的视频文件容易造成不同步;2、片子本身就不同步;3、软件使用不当造成转换后的文件不同步。常见于 avi 文件和 rm/rmvb 文件.

一、AVI

对于 avi 文件,可以在 VirtualDub 中进行调整,方法如下,打开一个 avi 文件,选择“音频”菜单里的“交错”,如下图:

输入好确定以后,在“音频”和“视频”菜单里都选择“直接复制数据流”,然后再“另

存AVI”就可以了。如果不合适,可以反复调整数值,直到同步为止。

二、RM/RMVB

对于这类视频,通常都是由于片源问题而导致压制后音视频不同步。

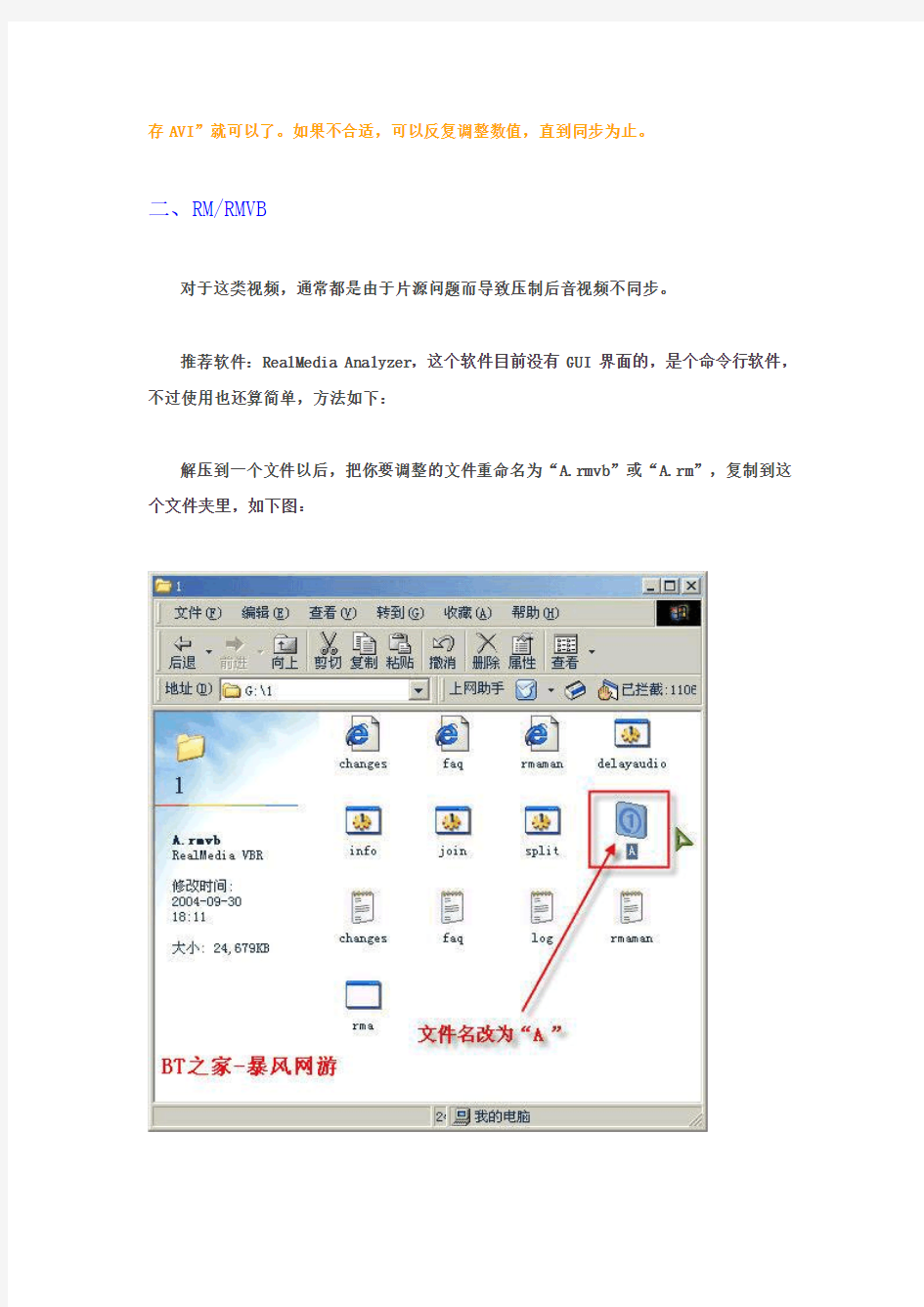

推荐软件:RealMedia Analyzer,这个软件目前没有 GUI 界面的,是个命令行软件,不过使用也还算简单,方法如下:

解压到一个文件以后,把你要调整的文件重命名为“A.rmvb”或“A.rm”,复制到这个文件夹里,如下图:

用记事本打开“delayaudio.bat”这个文件,按照下图中的说明进行修改:

反复调整直到满意即可!

附:RMVB音频的修改

注:若发现RealMedia Editor无法编辑重新合并之后的RMVB,可用ERP、RPG的[RM编辑器]另存一次即可。

Q:RMVB本身很小聲,要如何調整音量?

A:

用RealMedia Analyzer分离那rmvb为视频和音频

rma -s bad.rm

找出音频的rm,如001.rm,用RMVB压制软件(ERP、RPG)把那音频调大音量再压为audio.rm 用RealMedia Analyzer合并分离的声音和图像

rma -j/audio.rm//video.rm/ test.rm

重建索引

rma -i test.rm

Q:双声道的rm怎么变成单一的声道?

A:

用RealMedia Analyzer分离那rmvb为视频和音频rma -s bad.rm

找出音频的rm,如001.rm,写avs这样DirectShowSource("001.rm")

GetChannel(1) #1和2分别代表左、右声道

用RMVB压制软件(ERP、RPG)压那avs为audio.rm

用RealMedia Analyzer合并分离的声音和图像rma -j/audio.rm//video.rm/ test.rm

重建索引

rma -i test.rm

Q:如何解决rmvb中声音画面不同步的问题?

A:选用的软件是RealMedia Analyzer

运行环境为"命令提示符"

1、假定要解决的文件是bad.rm

2、分离声音和图像,用下面的命令:

"rma -s bad.rm"

得到单独的声音文件bad.000和图像文件bad.001。

3、加入时间差,全并分离的声音和图像,用下面的命令:"rma -jq500/bad.000//bad.001/ fixed.rm"

500是参数,单位是毫秒。

可以有正负,正数适用于时间超前图像的情况,负数反之。

4、重建索引

"rma -i fixed.rm"

常见音频格式之间如何转换

常见音频格式之间如何转换 作者来源:赛迪网 常见地声音格式有多种多样包括、、、、等.我们该如何实现各种声音格式间地转换呢?如果你仔细看看每个音频之间地关系,你会发现,最常用地就是文件,所以我们地目标是要做到各种格式与格式之间地转换,再借助这个桥梁实现格式间地转换.为了达到这种转换目地,根据不同地格式有不同地工具.首先,我们来谈谈几个“通用”地工具. 首先要说地是最简单地方法——.几乎每个人都安装有,那么我告诉你,只要能播放地音频格式,就可以通过它地“ ”中地“ ”输出为文件. 另外可以达到转换目地地是使用音频编辑软件,比如之类地软件,一般这些软件都支持读取多种音频格式.比如就可以支持、、、、、、、、、、、、、等多种格式. 让我们再来看一看,借助豪杰新出地“音乐工作室”如何实现音乐格式转换吧.鼠标单击“开始→豪杰超级音乐工作室→音乐格式转换器”. 、打开左侧“树型文件列表”内音频文件所在目录.右侧“源文件”区显示所有音频文件名. 、鼠标左键双击“源文件”区地第一个文件,使其添加到待转换区(如下图); 、鼠标左键单击菜单“设置→保存为”(或者单击快捷键“设置”); 、鼠标左键单击[转换]快捷键,即可开始转换了.很快,一个新地文件便产生了.此软件地测试版目前可在豪杰站点下载. 除了以上几个通用地格式转换工具以外,针对具体地文件格式,有不同地转换工具.而且,针对不同地格式转换,有地甚至有很多种软件.当然,在这里,我也只能针对常见地格式来进行说明. → 常见地转换工具分别是:、、、、等等,我们在这里只介绍 .它是一个小巧地音乐转换处理软件.集播放及轨迹检视、→转换等功能于一身地迷你软件.有了它,您就可以轻松地获取来自麦克风、线形输入或音频等各种音源地音频数据信息,进行分析识别和转换,而不需要外接任何(动态链接库)文件. → 常见地转换工具为:-、、、、-等等.熟悉软波表地朋友可能已经看出,这些都是常见地软波表工具.我们这里为你介绍-(-).公司出版全新地软件音源器,除了有音响般地漂亮界面之外,取样频率支持到,内建种音色、种鼓声,并可同时显示声部.这个版本提供两个质谱仪共选择,可升高与降低音调、更提供循环播放、音场及乐器选择.而安装后会常驻于上、可立即启动接受播放器或选择音源驱动程式,此版为英文版本,可试用天. → 常见地转换工具是:、-、-、、.这些可是我们经常使用地工具,在当初将转换成地过程中,我们都是首先将转换成,接着再利用这些工具将转换成.在这些工具里,我为你推荐 .它不仅仅可以将转化成,而且可以直接将里地音轨抓出来并编码为. → 前面我们提到过在地应用中非常广泛,可这些文件却实在不好找!刚好,这里有一个比较适合,这个时候就需要一个转换成地工具.这些工具主要有:、、-、-、等等,这里,我为你介绍().这是一个将转

音视频同步原理

视频流中的DTS/PTS到底是什么? DTS(解码时间戳)和PTS(显示时间戳)分别是解码器进行解码和显示帧时相对于SCR(系统参考)的时间戳。SCR可以理解为解码器应该开始从磁盘读取数据时的时间。 mpeg文件中的每一个包都有一个SCR时间戳并且这个时间戳就是读取这个数据包时的系统时间。通常情况下,解码器会在它开始读取mpeg流时启动系统时钟(系统时钟的初始值是第一个数据包的SCR值,通常为0但也可以不从0开始)。 DTS 时间戳决定了解码器在SCR时间等于DTS时间时进行解码,PTS时间戳也是类似的。通常,DTS/PTS 时间戳指示的是晚于音视频包中的SCR的一个时间。例如,如果一个视频数据包的SCR是100ms(意味着此包是播放100ms以后从磁盘中读取的),那么DTS/PTS值就差不多是200 /280ms,表明当SCR 到200ms时这个视频数据应该被解码并在80ms以后被显示出来(视频数据在一个buffer中一直保存到开始解码) 下溢通常发生在设置的视频数据流相关mux率太高。 如果mux率是1000000bits/sec(意味着解码器要以1000000bits/sec的速率读取文件),可是视频速率是2000000bits/sec(意味着需要以2000000bits/sec的速率显示视频数据),从磁盘中读取视频数据时速度不够快以至于1秒钟内不能够读取足够的视频数据 。这种情况下DTS/PTS时间戳就会指示视频在从硬盘中读出来之前进行解码或显示(DTS/PTS时间戳就要比包含它们的数据包中的SCR时间要早了)。 如今依靠解码器,这基本已经不是什么问题了(尽管MPEG文件因为应该没有下溢而并不完全符合MPEG 标准)。一些解码器(很多著名的基于PC的播放器)尽可能快的读取文件以便显示视频,可以的话直接忽略SCR。 注意在你提供的列表中,平均的视频流速率为~3Mbps(3000000bits/sec)但是它的峰值达到了14Mbps (相当大,DVD限制在9.8Mbps内)。这意味着mux率需要调整足够大以处理14Mbps的部分,bbMPEG 计算出来的mux率有时候太低而导致下溢。 你计划让视频流速率这么高么?这已经超过了DVD的说明了,而且很可能在大多数独立播放其中都不能播放。如果你不是这么计划,我会从1增加mquant的值并且在视频设置中将最大码流设置为9Mbps以保持一个小一点的码流。 如果你确实想让视频码率那么高,你需要增大mux率。从提供的列表可以得出bbMPEG使用14706800bits/sec或者1838350bytes /sec的mux率(总数据速率为:1838350bytes/sec (14706800bits/sec)行)。你在强制mux率字段设置的值应该是以bytes/sec为单位并被50整除。所以我会从36767(1838350/50)开始,一直增加直到不会再出现下溢错误为止

一种通过WiFi实现实时传输音视频的方法及系统

龙源期刊网 https://www.360docs.net/doc/a612120787.html, 一种通过WiFi实现实时传输音视频的方法及系统 作者:林勇 来源:《信息记录材料》2019年第02期 【摘要】针对传统音视频系统布线成本高、耗时长的缺点,本文基于目前使用广泛的WiFi技术,搭建了一套音视频数据传输系统,通过WPS协议和自定义协议,能够一键配对,快速建立通信链路,实现了对音视频的实时传输,大大简化了用户配置过程,有效降低了传统有线传输时的布线成本,极大的扩展了使用场景。 【关键词】WiFi;实时传输;音视频 【中图分类号】TP274 【文献标识码】A 【文章编号】1009-5624(2019)02-0046-02 1 背景 多媒体时代,用户对音视频的展现技术以及便捷性有了更高的需求,在现有技术中,音视频分屏技术通常是通过HDMI、VGA或DVI等方式分屏到多台显示终端,这种有线分屏输出技术,对设备接口有一定的要求,用户的输出显示设备不一定有对应的接口,且在使用过程中,需要将输入输出设备通过数据线连接,如果显示设备距离较远,还会增加布线的成本,因此,我们需要一种方法可以摆脱数据线和接口的束缚,基于无线传输的技术完成音视频传输。 2 通过WiFi实现实时传输音视频的优点 本文提供一种通过WiFi实现实时传输音视频的方法,实现点对点数据传输的同时按自定义协议协商信息进行数据处理,大大降低网络带宽的负载,提高传输效率。 该方法具有如下优点:(1)基于无线WiFi完成的音视频数据传输,通过一键配对连接,减少各种数据线拔插等操作,变相降低了传统分屏显示的时间成本和经济成本;(2)设备自动协商能力,以最佳采集参数、传输参数以及编解码方式处理数据,大大提高音视频数据传输处理效率;(3)通过自定义协议的协商,完成设备点对点的配对连接,采用单播方式进行音视频数据的传输,且数据经过编码压缩等,降低网络带宽的负载;(4)音视频数据采集、传输、处理与配对协商相互独立,可灵活扩展多种使用场景,大大提升用户体验。 3 通过WiFi实现实时传输音视频的具体实施步骤 如图1所示,一种通过WiFi实现实时传输音视频的方法,包括如下步骤:

音视频技术方案

电影院音视频系统 技术方案 启拓电子(中国)有限公司全国热线电话:400 1818 026

一、概述 1、引言 数字电影指的是从电影制作工艺、制作方式、到发行及传播方式上均全面数字化。与传统电影相比,数字电影最大的区别是不再以胶片为载体,以拷贝为发行方式,而是以数字文件形式发行或通过网络、卫星直接传送到影院。数字化播映是由高亮度、高清晰度、高反差的电子放映机依托宽带数字存储、传输技术实现的。 2、发展状况 电影院是为观众放映电影的场所。电影在产生初期,是在咖啡厅、茶馆等场所放映的。随着电影的进步与发展,出现了专门为放映电影而建造的电影院。电影的发展——从无声到有声乃至立体声,从黑白片到彩色片,从普通银幕到宽银幕乃至穹幕、环幕,使电影院的形体、尺寸、比例和声学技术都发生了很大变化。电影院必须满足电影放映的工艺要求,得到应有的良好视觉和听觉效果。 电影的历史已有百年之久.它的每一次进步都缘于科技的推动,数字技术进入电影产业.是电影继无声变有声,黑白变彩色之后的第三次革命性改进,数字技术的介入,将使电影从制作到表现手法、运作方式、发行方式、播映方式都发生革命性的变化。 电影业在长期发展中形成了全球统一的标准,一部影片可以在全球任何影院放映。数字影院发展初期,由于没有标准,各系统不能兼容,阻碍了数字影院成规模发展。在建立统一的数字影院标准的呼声

下, 2002年4月,好莱坞七大电影制作公司宣布成立名为DCI (Digital Cinema Initiatives, LLC)的组织来共同制定数字电影技术的标准,并鼓励电影院采用数字式放映设备。 2005年7月DCI 《数字影院系统规范1.0》发布,全球数字影院标准取得了突破性的发展。之后,SMPTE DC28 (美国电影电视工程师协会、数字影院技术标准委员会) 以DCI规范为基础,研究和制定数字影院行业标准,迄今为止,超过50%的数字影院标准已经发布。 3、电影在中国的发展 在国家和政府的大力支持下,2002年2月中国开始了发展影院的进程。目前,我国已建成60多家2K数字影院,成为世界上数字电影发展最快的国家之一。并发行了《天上草原》、《星战前传Ⅰ》、《哈利波特》、《海底总动员》《太行山上》、《蜘蛛侠III》等十几部数字电影。2002年中国电影科学技术研究所起草、制定了《电影技术要求(暂行)》,由国家广电总局颁布,实施。目前,电影科研所还密切追踪国外标准制定组织的进展,参考各项国际规范并结合我国现状及市场需求对已颁布的《电影技术要求(暂行)》进行修改。在城市影院的发展中,将建立与国际接轨的电影标准。 二、需求分析 目前,越来越多的消费者希望着电影院能给观众带来的更直接逼真视觉传达和舒适身临其境的听觉冲击,从1996年以来,出现了利用双音箱音响系统来产生虚拟环绕声的虚拟环绕声技术。虚拟环绕声主要原理是基于人的“双耳效应”原理和“耳廓效应”原理。它是一种利

用格式工厂转换视频、音频的格式

用格式工厂转换视频、音频的格式 格式工厂是一款免费软件,安装时要注意软件安装界面中的各种打勾选项,避免被装上一些捆绑软件。 打开格式工厂,软件首先展开的格式处理项就是视频,如右图所示: 综合考虑文件大小、处理速度、音质与画质等因素,可以选择把来源视频转换成MP4这种格式。以下是转换成MP4的操作方法。 1MP4的界面:

2、单击按钮,弹出设置界面: 建议将屏幕大小和宽高比都设为缺省,以保持来源视频的原始画质。另外,可以在音量控制栏设置+、-dB来增减来源视频中的音量,也可以在关闭音效栏设置视频为无声。其它设置不太需要变动。点右上的确定按钮完成设置。 3、点按钮,比如,要 处理的是某个盘中名叫“视频示例”的文件夹中的“录屏与编辑的示例”的这个RM格式来源,在此双击这个文件。 4、这时MP4转换界面的按钮变为可点击,点这个确定按钮就完成了格式转换前的必要设置,软件就会回到刚打开时的界面,此时起始界面中的开始按 钮变为可点击,点击

5、转换完成后有一个提示音和托盘位置的一个冒泡提示。注意看图中的输出栏下列出了输出文件的位置: 这个输出文件夹的位置因电脑而异,软件一般会选可用空间大些的盘保存这个FFOutput 文件夹,也可以自定义输出路径。打开输出文件夹,就能找到转换完成的MP4视频文件。 在本次格式转换任务条目上单击右键,会看到更多可以操作的命令: ★在上述转换成MP4步骤4之前点,还可以截取可用的片段与裁剪掉多余的边角。如“3、演示:用格式工厂截取与裁剪视频”所示:截取第10秒到第30秒的片段,并裁掉视频网站的图标。 用会声会影编辑输出的视频可能不会每次都适合直接上传网络,那可能还需要用格式工厂最后再转换一下视频格式与视频尺寸大小。这个可能涉及的问题,待适时解决。 ★格式工厂也可以把多段音频合并在一起。更好用的一个混流功能能将一段音频与一段视频合并,并替换掉视频中原来的声音——这意味着可以为一段视频重新配音。点“高级” 选项卡就能看到这些功能按钮,用起来很简单:

音视频同步的方法及监控系统与制作流程

本技术公开了一种音视频同步的方法及监控系统,包括步骤:S1,采集音视频数据;S2,基于实时传输协议RTP传输音视频数据;S3,采用音视频同步技术处理数据。本技术基于实时传输协议RTP,采用音视频数据同步技术解决了现有技术中存在的音视频数据不同步以及音频处理效果不佳问题,能够播放同步的声音和图像数据,使得声音和图像数据更加真实、流畅。 技术要求 1.一种音视频同步的方法,其特征在于,其包括步骤: S1,采集音视频数据;

S2,基于实时传输协议RTP传输音视频数据; S3,采用音视频同步技术处理数据; S3中,音视频同步控制在数据接收端实施;音视频同步技术以音频为主媒体,视频为从媒体,接收音视频数据时设置缓冲区,通过比较音视频数据包的时间戳判断同步关系,实现音视频数据同步。 2.根据权利要求1所述的一种音视频同步的方法,其特征在于,所述步骤S3中,采用队列作为缓冲区,缓存音视频数据。 3.根据权利要求1所述的一种音视频同步的方法,其特征在于,所述步骤S3中,对于音频缓存,使用iOS系统提供的AudioQueue框架的队列处理音频数据。 4.根据权利要求1所述的一种音视频同步的方法,其特征在于,所述步骤S3中,音频队列的长度至少为3。 5.根据权利要求1所述的一种音视频同步的方法,其特征在于,所述步骤S3中,音视频数据的时间差在允许范围内,则认为音视频同步;否则认为音视频不同步,丢弃视频帧。 6.根据权利要求1所述的一种音视频同步的方法,其特征在于,所述步骤S3中,采用H264硬编解码技术处理音视频数据。 7.一种音视频同步的监控系统,其特征在于,包括设备端、服务器端和客户端,所述设备端通过互联网和防火墙与服务器端连接,所述客户端通过WiFi或4G或4G+网络与路由器连接,所述路由器通过互联网与服务端连接; 所述设备端采集音视频数据,并将音视频数据压缩编码、打包后通过互联网发送到服务器端; 所述服务器端包括流媒体服务器和SIP信令服务器,流媒体服务器将设备端采集到的音视频数据通过互联网和WiFi或4G或4G+网络转发到客户端,SIP信令服务器负责转发系统中的信令消息,同时负责管理客户端中各个终端设备,流媒体服务器通过ICE与SIP服务器进行通信;

AVB与下一代网络音视频实时传输技术

ESS与AVB音频视频桥网络系统 基于以太网的数字音频传输技术 基于以太网的数字音频传输技术是专业音频行业的一个技术焦点,以其不依赖于控制系统而独立存在的特性,广泛的应用到很多项目中。不仅解决了多线路问题,还解决了远距离传输、数据备份、自动冗余等一系列在模拟传输时代无法面对的问题。 目前比较成熟的以太网音频传输技术主要有CobraNet和EtherSound技术,但这两种技术都各有千秋,在它们此基础上,Audinate于2003年推出了Dante这种融合了很多新技术的数字音频传输技术。 至于下一代网络音视频实时传输技术,新IEEE标准——音视频桥,简称AVB,以即插即用和自主开发的姿态面世,则是全世界现场演出行业所梦寐以求的系统解决方案。 CobraNet网络 CobraNet网络是美国PeakAudio公司开发的一种在以太网上传输专业非压缩音频信号的技术,工作在数据链路层(OSI二层)的低层传输协议,但无法穿过路由器,只能在局域网中传递,音频流不能大于8个数据包Bundle。它可以在100M以太网下单向可以传输64个48kHz、20bit的音频信号通道(48kHz、24bit信号为56路);除音频信号外,还可以传输RS485串口通信数据及其它非同步IP数据;开放的MIB文件,支持SNMP。一般使用星型(或连星型)网络结构。 EtherSound网络 EtherSound网络是由法国Digigram公司开发的一种基于以太网传输音频信号的技术,工作在数据链路层(OSI二层)的低层传输协议,只能在局域网中传递。传输能力为单方向64个24bit、48kHz(或44.1kHz)采样频率的音频通道。不能传递串口信号以及其它IP数据,具有极低的延时。一般采用菊花链结构或以太网星型结构或者这两种结构的混合形式,通过以太网交换机互相连接。

音视频技术基本知识一

https://www.360docs.net/doc/a612120787.html, 音视频技术基本知识一 网易视频云是网易倾力打造的一款基于云计算的分布式多媒体处理集群和专业音视频技术,为客户提供稳定流畅、低时延、高并发的视频直播、录制、存储、转码及点播等音视频的PaaS服务。在线教育、远程医疗、娱乐秀场、在线金融等各行业及企业用户只需经过简单的开发即可打造在线音视频平台。现在,网易视频云总结网络上的知识,与大家分享一下音视频技术基本知识。 与画质、音质等有关的术语 这些术语术语包括帧大小、帧速率、比特率及采样率等。 1、帧 一般来说,帧是影像常用的最小单位,简单的说就是组成一段视频的一幅幅图片。电影的播放连续的帧播放所产生的,现在大多数视频也类似,下面说说帧速率和帧大小。 帧速率,有的转换器也叫帧率,或者是每秒帧数一类的,这可以理解为每一秒的播放中有多少张图片,一般来说,我们的眼睛在看到东西时,那些东西的影像会在眼睛中停留大约十六分之一秒,也就是视频中只要每秒超过15帧,人眼就会认为画面是连续不断的,事实上早期的手绘动画就是每秒播放15张以上的图片做出来的。但这只是一般情况,当视频中有较快的动作时,帧速率过小,动作的画面跳跃感就会很严重,有明显的失真感。因此帧速率最好在24帧及以上,这24帧是电影的帧速率。 帧大小,有的转换器也叫画面大小或屏幕大小等,是组成视频的每一帧的大小,直观表现为转换出来的视频的分辨率的大小。一般来说,软件都会预置几个分辨率,一般为320×240、480×320、640×360、800×480、960×540、1280×720及1920×1080等,当然很多转换器提供自定义选项,这里,不得改变视频长宽比例。一般根据所需要想要在什么设备上播放来选择分辨率,如果是转换到普通手机、PSP等设备上,视频分辨率选择与设备分辨率相同,否则某些设备可能会播放不流畅,设备分辨率的大小一般都可以在中关村在线上查到。 2、比特率 比特率,又叫码率或数据速率,是指每秒传输的视频数据量的大小,音视频中的比特率,是指由模拟信号转换为数字信号的采样率;采样率越高,还原后的音质和画质就越好;音视频文件的体积就越大,对系统配置的要求也越高。 在音频中,1M以上比特率的音乐一般只能在正版CD中找到,500K到1M的是以APE、FLAC等为扩展名的无损压缩的音频格式,一般的MP3是在96K到320K之间。目前,对大多数人而言,对一般人而言192K就足够了。 在视频中,蓝光高清的比特率一般在40M以上,DVD一般在5M以上,VCD一般是在1M 以上。(这些均是指正版原盘,即未经视频压缩的版本)。常见的视频文件中,1080P的码率一般在2到5M之间,720P的一般在1到3M,其他分辨率的多在一M一下。 视频文件的比特率与帧大小、帧速率直接相关,一般帧越大、速率越高,比特率也就越大。当然某些转换器也可以强制调低比特率,但这样一般都会导致画面失真,如产生色块、色位不正、出现锯齿等情况。

rtp音视频同步问题解决方法

rtp音视频同步问题解决方法 rtp同步方法的思考 由于音视频流是以两条独立的数据流在网络上传输的,如果网络质量相当差,那么在接收端收到的音视频数据流就有可能不是同步的了,为了克服这种不同步的现象,需要添加同步机制。的同步机制是使用开源库jrtplib3.7.1来实现的,严格遵守rtp协议标准。 解决的方案如下: 当有数据需要发送时,往数据中加入时间戳,在接收端,读取时间戳,进行比较,如果相同或相差很近,就提交播放,如果其中一个时间戳更大,就等待。 如果网络质量很差,那么存在两种不同步的情况: 1. 对于单条数据流来说,如果网络质量很差,可能出现数据流的接收不流畅,如果没有做流畅处理,那么就可能出现抖动现象,这需要使用rtp中的时间戳解决。 2. 对于多条数据流来说,如果网络质量很差,可能出现本应该同时播放的数据帧没有在同一时间到达,需要做同步处理。 解决第1个问题的方法是向每个发送的数据包加上时间戳,在rtp库中,时间戳表示在打包数据段中第一个采样所对应的时间,时间戳的启始值是随机的,后续的时间戳是在前一个时间戳上的增量,在SendPacket中的时间戳参数表示的是时间戳增量,所以数据流的同步需要计算出时间戳增量。 对于音频数据,由于音频数据的采样率是8000HZ,所以每采样一次需要时间是1/8000s,由于是每20ms封包一次,所以时间戳的增量是(20*10**-3)*8000=160。 对于视频数据,由于视频数据的采样率是90000Hz,所以每采样一次需要时间是1/90000s,如果帧率是25帧/s,所以时间戳增量是90000/25=3600。 在发送端,每发送一个数据包,都打上该数据包对于的时间戳值,只需要向SendPacket 的最后个参数传递时间戳增量,rtp库会自动算出时间戳,并加到发送的rtp数据包首部里边。 在接收端,当收到一个数据包时,获取该rtp数据包的时间戳值,计算出与前一个数据包的时间戳值的差值,乘以该媒体流的时间戳单位,就得出了当前数据包与前一个数据包之间的间隔的打包时间T。所以只要保证在与前一个数据包被提交过后T时间后再提交当前接收到的数据包,那么在rtp层就解决了上边提出的第一个问题。

浅析DirectShow音视频同步解决完整方案

浅析DirectShow音视频同步解决完整方案 多媒体处理,不可避免地要解决音视频的同步问题。DirectShow是怎么来实现的呢?我们一起来学习一下。 大家知道,DirectShow结构最核心的部分是Filter Graph Manager:向下控制Graph中的所有Filter,向上对τ贸绦蛱峁┍喑探涌凇F渲校現ilter Graph Manager实现的很重要一个功能,就是同步音视频的处理。简单地说,就是选一个公共的参考时钟,并且要求给每个Sample都打上时间戳,Video Renderer或Audio Renderer根据Sample的时间戳来控制播放。如果到达Renderer的Sample晚了,则加快Sample的播放;如果早了,则Renderer等待,一直到Sample时间戳的开始时间再开始播放。这个控制过程还引入一个叫Quality Control的反馈机制。 下面,我们来看一下参考时钟(Reference Clock)。所有Filter都参照于同一个时钟,才能统一步调。DirectShow引入了两种时钟时间:Reference time和Stream time。前者是从参考时钟返回的绝对时间(IReferenceClock::GetTime),数值本身的意义取决于参考时钟的内部实现,利用价值不大;后者是两次从参考时钟读取的数值的差值,实际应用于Filter Graph内部的同步。Stream time在Filter Graph不同状态的取值为: 1. Filter Graph运行时,取值为当前参考时钟时间减去Filter Graph启动时的时间(启动时间是通过调用Filter上的IMediaFilter::Run来设置的); 2. Filter Graph暂停时,保持为暂停那一刻的Stream time; 3. 执行完一次Seek操作后,复位至零; 4. Filter Graph停止时,取值不确定。 那么,参考时钟究竟是什么东西呢?其实,它只是一个实现了IReferenceClock接口的对象。也就是说,任何一个实现了IReferenceClock接口的对象都可以成为参考时钟。在Filter Graph中,这个对象一般就是一个Filter。(在GraphEdit中,实现了参考时钟的Filter上会显示一个时钟的图标;如果同一个Graph中有多个Fiter实现了参考时钟,当前被Filter Graph Manager使用的那个会高亮度显示。)而且大多数情况下,参考时钟是由Audio Renderer这个Filter提供的,因为声卡上本身带有了硬件定时器资源。接下来的问题是,如果Filter Graph中有多个对象实现了IReferenceClock接口,Filter Graph Manager是如何做出选择的呢?默认的算法如下: 1. 如果应用程序设置了一个参考时钟,则直接使用这个参考时钟。(应用程序通过IMediaFilter:: SetSyncSource设置参考时钟,参数即为参考时钟;如果参数值为NULL,表示Filter Graph不使用参考时钟,以最快的速度处理Sample;可以调用IFilterGraph:: SetDefaultSyncSource来恢复Filter Graph Manager默认的参考时钟。值得注意的是,这时候的IMediaFilter接口应该从Filter Graph Manager上获得,而不是枚举Graph中所有的Filter并分别调用Filter上的这个接口方法。) 2. 如果Graph中有支持IReferenceClock接口的Live Source,则选择这个Live Source。 3. 如果Graph中没有Live Source,则从Renderer依次往上选择一个实现IReferenceClock接口的Filter。

如何将视频转换成音频MP3格式

大家都知道视频和音频的区别是视频是画面和声音的结合而音频是没有画面只有声音的。平常我们看电视如果想要把喜欢的演员声音(对白)保存下来,视频文件就太大比较占内存而音频文件就比较小方便保存、不占内存还可以设置成手机铃声。这样一来,大家知道为什么那么多人会把视频文件转换成音频文件了。 视频转换成音频MP3格式 如何将视频转换成音频MP3格式?因为大多的网络视频都是FLV格式文件,所以就需要把视频转换成音频,常见的FLV转MP3。我们可以利用视频转换器把视频文件转换成MP3音频文件,不会的小伙伴也不用担心,接下来小编会告诉大家视频转音频的方法。

打开视频转换器 想要把视频文件转换成音频文件,首先我们需要把视频转换器打开,双击电脑上安装的迅捷视频转换器。软件打开之后点击“注册/登录”用手机号注册登录软件或者用微信、QQ授权软件登录,软件登录成功之后点击“开通VIP”选择套餐购买软件使用权限。注:迅捷视频转换器是一个付费软件,所以需要购买使用,要不然转换视频、音频会有时间限制,比如只能转换前五分钟视频。注:非VIP用户有权限限制,VIP用户没有。 添加视频文件

软件登录购买成功之后我们需要添加要转换的视频文件有两种添加方法,第一种是点击软件左上方的“添加文件”找到电脑上下载的视频选中然后点击“打开”添加上;第二种是打开视频文件的存放地点直接把视频拖到软件里面就好。注:迅捷视频转换器支持视频文件批量添加转换。 设置输出文件 视频文件添加之后,找到软件右上方的“输出格式”点击它里面的下拉框在音频中找到MP3格式双击音频品质,下面的转换文件格式就会变成“MP3”。输出文件的格式选好后要选择保存地点了,点击软件下方的黄色文件夹按钮就可以自定义输出文件的保存地点。注:输出文件的格式和保存地点都支持自定

即时通讯 手机音视频技术开发方案

“SDK即时通讯平台”是一套跨平台的即时通讯解决方案,基于先进的H.264视频编码标准、AAC音频编码标准与P2P技术,支持高清视频,整合了佰锐科技在音视频编码、多媒体通讯领域领先的开发技术和丰富的产品经验而设计的高质量、宽适应性、分布式、模块化的网络音视频互动平台。 “SDK即时通讯平台”包含了音视频处理模块(采集、编解码)、流媒体管理模块(丢包重传、抖动平滑、动态缓冲)、流媒体播放模块(多路混音、音视频同步)以及P2P网络模块(NAT 穿透、UPnP支持、IP组播支持)等多个子模块,封装了底层的硬件操作(音视频采集、播放)、封装了流媒体处理(编解码、网络传输)等非常专业和复杂的技术,为上层应用提供简单的API控制接口,可以在极短的开发周期,以及极少的人力资源投入下为客户的现有平台增加音视频即时通讯、多方会议的功能。 “SDK即时通讯平台”分为客户端SDK和服务器SDK两大部分,其中客户端SDK用于实现语音、视频的交互以及其它客户端相关的功能,而服务器SDK主要实现业务层逻辑控制,以及与第三方平台的互联等。客户端SDK和服务器SDK均支持C++、C#、https://www.360docs.net/doc/a612120787.html,以及Delphi等开发语言。 通过“SDK即时通讯平台”,可以开发具有企业特色的即时通讯系统、视频游戏系统、视频会议系统、网络教学系统、语音视频聊天系统、专家咨询平台以及政府应急指挥平台等,系统的功能、界面完全由企业定制。 AnyChat是国内知名音视频互动开发平台,经过长达九年之久的广泛应用和复杂化环境的检测,SDK系统在兼容性、安全性、稳定性、易用性方面具有较高的声誉。该SDK是佰锐科技全力打造的核心产品. SDK手机视频开发包是面向集成或软件开发商使用,用于开展手机视频相关的产品开发和系统集成。 开发包提供手机端音视频采集、编码、压缩、音视频传输等功能;通过与后端服务器对接,优先P2P通讯,实现手机视频即拍即传、手机视频直播,手机视频录制和手机视频通话。当前手机视频SDK开发包支持iOS和Android平台。 . 提供手机视频采集直播的开发接口 通过视频参数设置接口,设置拍摄视频的分辨率、编码方式、码流、媒体流类别等 通过视频拍摄,实现视频的采集,编码和传输 ·提供语音、文字通讯接口 ·提供视频录制接口,包括本地视频录制 ·提供文件传输接口 . 支持跨平台通讯,可与windows,web ,Linux完美互联互通 ·提供透明通道,实现特殊功能 一、拓扑结构图:

H.323视频会议系统音视频同步原理

H.323视频会议系统音视频同步原理 针对H.323 视频会议系统设计了一种基于RTP 的音视频同步方法,该方法在严格遵守 RTP 协议的前提下,将音视频数据联系起来通过同一个媒体通道传输,从而达到唇音同步的目的。实验表明:该方法在对图像质量影响很小的情况下,很好地实现了音视频的同步播放,并且具有实现简便,不增加系统负担等优点,具有广泛的实用性。 H.323 视频会议系统中,发送端同时采集到的音视频数据能在接收端同时播放,则认 为唇音同步。终端采集到的音视频数据肯定是同步的,要保证同时播放,就要保证音视频在采集和播放处理过程中消耗的时间相同。IP 网络的特点决定了通过不同通道的音视频数据传输所消耗的时间不可能完全相同,唇音同步是视频会议系统中的一大难题。如果同时采样的音视频数据播放时间偏差在[-80ms,+80ms]以内,用户基本上感觉不到不同步,一 旦超出[-160ms,+160ms],用户就可以明显感觉到,中间部分是临界范围。 1 引言 1.1 文章安排 本文第2 节分析了现有的音视频同步方案的缺点。第3 节详细描述了本文所设计方案 的实现过程。第4 节给出实验数据以及分析结果。第5 节给出结论。 1.2 基本介绍 H.323 视频会议系统中,音视频不同步现象产生的原因除了网络环境外,还有一个是 音视频的分开传输。虽然H.323 建议音视频通过不同道道传输,但是实际传输数据的 RTP[2,3]协议和其底层的UDP 协议都没有规定一对连接只能传输音频或者视频中的一 种,通过同一个通道传输音视频完全可能,而且这样可以最大程度的减少网络原因引起的音视频不同步,本文给出了这一设想的实现方案,并做了验证。 2 现有解决方案 目前最常用的唇音同步方法从思路上可以分为以下两类: 思路一,发送端给每个要发送的RTP 包打上时戳,记录它们的采样时间。接收端通过 增加延时等方式,保证同时采样的数据同时播放。这类方法的实现需要一个中立的第三方参考时钟,需要有RTCP 协议的SR[2,3]的参与,如果这两个条件不具备,同步就失去了依据。 思路二,唇音不同步本质上是由H.323 视频会议系统中音视频的分开传输和处理导致 的,如果采用某种方法将音视频信息关联起来,就可以有效的避免不同步现象。一种实现方案是,将音频按一定的对应关系嵌入到视频中传输,接收端从视频中提取音频数据并重建,从而达到唇音同步的目的[4].该方案实现较复杂,而且采用非标准的RTP 实现方式,会给不同厂商H.323 产品间的互通带来困难。 3 一种新的音视频同步方法 本方法基本思路是:在音视频数据的采样、编码、打包、发送、网络传输、接收、网络 异常处理、拆包、解码、播放这十个处理过程中,采集、编码、打包、拆包和解码的时间基本上固定,不会因为网络环境差异造成时延的差异,而发送、网络传输、接收、网络异常处理四个过程则具有较大的随机性,其处理时间会随着网络性能的不同有较大的差异,进而造成播放时音视频的不同步。因此唇音同步处理的重点就在于保证发送、网络传输、接收、网络异常处理这四个过程中音视频的同步,即图1 中发送同步到组帧同步之间的部分。

AVB下一代网络音视频实时传输技术

下一代下一代网络网络网络音视频音视频音视频实时传输实时传输实时传输技术技术 -- Ethernet AVB 作者作者::何冬(首席工程师, Dong.He@https://www.360docs.net/doc/a612120787.html, ) 黄晟(工程师, Sheng.Huang@https://www.360docs.net/doc/a612120787.html, ) Charles Wang (技术总监, Charles.Wang@https://www.360docs.net/doc/a612120787.html, ) 哈曼哈曼((上海上海))研发中心集团技术研究部 摘要 以太网音视频桥接技术(Ethernet Audio/Video Bridging ,以下简称Ethernet A VB )是一项新的IEEE 802标准,其在传统以太网络的基础上,通过保障带宽(Bandwidth ),限制延迟(Latency )和精确时钟同步(Time synchronization),提 供完美的服务质量(Quality of Service, 简称QoS ) ,以支持各种基于音频、视频的网络多媒体应用。Ethernet A VB 关注于增强传统以太网的实时音视频性能,同时又保持了100%向后兼容传统以太网,是极具发展潜力的下一代网络音视频实时传输技术。 引言 1982年12月IEEE 802.3标准的发布,标志着以太网技术的起步。经过不到30年的发展时间,以太网的传输速度已经从最初的10Mbps 发展到100Mbps 、1000Mbps 、10Gbps ,甚至即将出现的100Gbps 。以太网低廉的端口价格和优越的性能,使得以太网占据了整个局域网的85%左右,而基于以太网的网桥、集线器、交换机和路由器则构成了互联网体系相当重要的组成部分。 近十几年来,消费者对于以太网上的多媒体应用的需求日益剧增,这对网络的带宽及服务质量都提出了更高的要求。不过,由于以太网原本只设计用于处理纯粹的静态非实时数据和保证其可靠性,至于顺序和包延迟等并非作为重要的考虑因素。尽管传统二层网络已经引入了优先级(Priority)机制,三层网络也已内置了服务质量(QoS )机制,但由于多媒体实时流量与普通异步TCP 流量存在着资源竞争,导致了过多的时延(Delay )和抖动(Jitter ),使得传统的以太网无法从根本上满足语音、多媒体及其它动态内容等实时数据的传输需要。 IEEE 802.1 A VB 工作组正致力于制定一系列的新标准, 对现有的以太网进行功能扩展,通过建立高质量、低延迟、时间同步的音视频以太网络,为家庭或企业提供各种普通数据及实时音视频流的局域网配套解决方案。 Ethernet A VB 网络的构成 为了在以太网上提供同步化低延迟的实时流媒体服务,需要建立A VB 网络,称之为A VB “云”(Cloud )。A VB “云”的建立需要至少速度在100Mbps 以上的全双工(Full-duplex )以太链路,这就需要能保障传输延迟的A VB 交换机(Switch)和终端设备(End Point),以及逻辑链路发现协议(IEEE 802.1AB - LLDP ),用于设备之间交换支持A VB 的协议信息。 如图1所示,在A VB “云”内,由于延迟和服务质量得到保障,能够高质

音视频的同步问题

多媒体处理,不可避免地要解决音视频的同步问题。DirectShow是怎么来实现的呢?我们一起来学习一下。 大家知道,DirectShow结构最核心的部分是Filter Graph Manager:向下控制Graph中的所有Filter,向上对τ贸绦蛱峁┍喑探涌凇F渲校現ilter Graph Manager实现的很重要一个功能,就是同步音视频的处理。简单地说,就是选一个公共的参考时钟,并且要求给每个Sample都打上时间戳,Video Renderer或Audio Renderer根据Sample的时间戳来控制播放。如果到达Renderer的Sample晚了,则加快Sample的播放;如果早了,则Renderer 等待,一直到Sample时间戳的开始时间再开始播放。这个控制过程还引入一个叫Quality Control的反馈机制。 下面,我们来看一下参考时钟(Reference Clock)。所有Filter都参照于同一个时钟,才能统一步调。DirectShow引入了两种时钟时间:Reference time和Stream time。前者是从参考时钟返回的绝对时间(IReferenceClock::GetTime),数值本身的意义取决于参考时钟的内部实现,利用价值不大;后者是两次从参考时钟读取的数值的差值,实际应用于Filter Graph内部的同步。Stream time在Filter Graph不同状态的取值为: 1. Filter Graph运行时,取值为当前参考时钟时间减去Filter Graph启动时的时间(启动时间是通过调用Filter上的IMediaFilter::Run来设置的); 2. Filter Graph暂停时,保持为暂停那一刻的Stream time; 3. 执行完一次Seek操作后,复位至零; 4. Filter Graph停止时,取值不确定。 那么,参考时钟究竟是什么东西呢?其实,它只是一个实现了IReferenceClock接口的对象。也就是说,任何一个实现了IReferenceClock接口的对象都可以成为参考时钟。在Filter Graph中,这个对象一般就是一个Filter。(在GraphEdit中,实现了参考时钟的Filter上会显示一个时钟的图标;如果同一个Graph中有多个Fiter实现了参考时钟,当前被Filter Graph Manager使用的那个会高亮度显示。)而且大多数情况下,参考时钟是由Audio Renderer这个Filter提供的,因为声卡上本身带有了硬件定时器资源。接下来的问题是,如果Filter Graph 中有多个对象实现了IReferenceClock接口,Filter Graph Manager是如何做出选择的呢?默认的算法如下: 1. 如果应用程序设置了一个参考时钟,则直接使用这个参考时钟。(应用程序通过IMediaFilter:: SetSyncSource设置参考时钟,参数即为参考时钟;如果参数值为NULL,表

实时音视频数据采集和传输系统设计方法的比较研究_徐殿武

-2017- 0引言 实时音视频数据采集和网络传输系统应用广泛,如视频会议、远程教育、实时视频监控、视频通话等。多媒体技术的发展过程中产生了各种各样的文件格式和数据压缩格式,实时音视频数据采集和传输技术的发展历程和多媒体技术的发展历程类似,也有各种不同的采集技术和传输技术可供选择,根据实际问题的需要,选择合适的技术设计音视频数据实时采集和传输系统,是十分重要的。在Windows 环境下,实时音视频采集可以使用采集设备(如采集卡)自带的SDK 进行,此类方法的优点是使用方便,缺点是硬件相关性强,不够灵活,不能适应复杂应用场合的需要。更常用的是使用微软公司提供的VFW (video for Windows )、DirectShow 和Windows Media 。 1使用VFW 进行音视频数据的实时采集 为解决数字音视频应用领域的问题,微软公司在1992年推 出了VFW [7],应用程序使用VFW 提供的接口可以方便地实现音视频数据实时采集、编辑、播放等通用功能以及开发各种复杂 的应用。在VC++6.0上使用VFW 要包含文件vfw.h 和vfw32.lib 。 视频捕获功能主要存在于VFW 的AVICAP 模块,应用程序创建一个A VICAP 窗口,并通过向窗口发送消息来控制窗口的行为。AVICAP 对视频捕获提供全面的支持,如将捕获到的数据写入磁盘文件和预览,然而,对于其它非文件型的使用则不够灵活,视频的格式和属性不可以在程序运行过程中通过编程进行改变,只能通过对话框进行设置。在将实时音视频数据采集到文件的场合,VFW 重点支持的是A VI 文件。使用VFW 进行音视频捕获的主要步骤为[6]:创建捕获窗口、注册回调函数、获取捕获窗口的缺省设置、设置捕获窗口参数、与捕获设备连接并获取捕获设备能力、设置捕获窗口显示模式、捕获视频数据到文件或者缓存,工作完毕,断开与捕获设备的连接。VFW 的其它主要功能包括音视频数据的压缩和解压、A VI 文件的编辑处理、以及图像显示(DrawDib 模块)。 从Windows 98开始,微软推出了WDM (Windows driver mode )设备驱动模式,现在的音视频数据采集设备都支持WDM ,经过一层模拟子系统处理后,虽然VFW 可以在Win98、Win200、WinXP 等各种平台上使用,但由于VFW 体系在视频 收稿日期:2007-10-18E-mail :xudianwu@https://www.360docs.net/doc/a612120787.html, 作者简介:徐殿武(1949-),男,硕士,讲师,研究方向为图像处理和程序设计。 实时音视频数据采集和传输系统设计方法的比较研究 徐殿武 (中国石油大学(北京)机电学院,北京102249) 摘 要:在Windows 环境下设计实时音视频数据采集和传输系统常用的3种方法是VFW 、DirectShow 或Windows Media 。这3种方法代表了Windows 在实时音视频数据采集和传输技术上的主要内容,每种方法各有自己的适用场合和优缺点。在系统仿真、电子游戏、音视频数据非线性编辑等应用中,最好选用DirectShow 。在需要将采集到的数据进行实时网络传输的场合,使用Windows Media 会收到事半功倍的效果。而VFW 在数据采集方面用的已经不多,但在AVI-2文件的非线性编辑处理和图像显示方面仍然具有广泛的应用。 关键词:音频;视频;数据采集;多媒体;实时中图法分类号:TP311.1 文献标识码:A 文章编号:1000-7024(2008)08-2017-03 Comparison and study on methods of real-time capture and transmission of audio and video data system design XU Dian-wu (Faculty of Mechanical and Electronic Engineering,China University of Petroleum,Beijing 102249,China ) Abstract :Under Windows environment,the main design methods of real-time capture and transmission of audio and video data are VFW,DirectShow,and Windows Media.The advantages and disadvantages of above three methods are discussed,and at the same time,the main programming steps are presented.In the case of system emulation,games,video editing,using DirectShow is a better choice.In the case of network application,using Windows Media is the best.VFW is an old method for audio and video capturing,but in the case of A VI-2file nonlinear editing and image display,VFW is still useful and convenient.Key words :audio;video;data acquisition;multimedia;real-time 2008年4月计算机工程与设计 Apr.2008 第29卷第8期Vol.29 No.8 Computer Engineering and Design