【原创】R语言支持向量机svm实践案例报告附代码数据

机器学习SVM(支持向量机)实验报告

实验报告实验名称:机器学习:线性支持向量机算法实现学员: 张麻子学号: *********** 培养类型:硕士年级:专业:所属学院:计算机学院指导教员:****** 职称:副教授实验室:实验日期:ﻬ一、实验目得与要求实验目得:验证SVM(支持向量机)机器学习算法学习情况要求:自主完成。

二、实验内容与原理支持向量机(Support Vector Machine,SVM)得基本模型就是在特征空间上找到最佳得分离超平面使得训练集上正负样本间隔最大。

SVM就是用来解决二分类问题得有监督学习算法。

通过引入了核方法之后SVM也可以用来解决非线性问题。

但本次实验只针对线性二分类问题。

SVM算法分割原则:最小间距最大化,即找距离分割超平面最近得有效点距离超平面距离与最大。

对于线性问题:假设存在超平面可最优分割样本集为两类,则样本集到超平面距离为:需压求取:由于该问题为对偶问题,可变换为:可用拉格朗日乘数法求解。

但由于本实验中得数据集不可以完美得分为两类,即存在躁点。

可引入正则化参数C,用来调节模型得复杂度与训练误差。

作出对应得拉格朗日乘式:对应得KKT条件为:故得出需求解得对偶问题:本次实验使用python编译器,编写程序,数据集共有270个案例,挑选其中70%作为训练数据,剩下30%作为测试数据。

进行了两个实验,一个就是取C值为1,直接进行SVM训练;另外一个就是利用交叉验证方法,求取在前面情况下得最优C值.三、实验器材实验环境:windows7操作系统+python编译器。

四、实验数据(关键源码附后)实验数据:来自UCI机器学习数据库,以Heart Disease数据集为例。

五、操作方法与实验步骤1、选取C=1,训练比例7:3,利用python库sklearn下得SVM()函数进行训练,后对测试集进行测试;2、选取训练比例7:3,C=np、linspace(0、0001,1,30)}。

利用交叉验证方法求出C值得最优解。

R语言-支持向量机

支持向量机一、SVM的想法回到我们最开始讨论的KNN算法,它占用的内存十分的大,而且需要的运算量也非常大。

那么我们有没有可能找到几个最有代表性的点(即保留较少的点)达到一个可比的效果呢?我们先看下面一个例子:假设我们的训练集分为正例与反例两类,分别用红色的圆圈与蓝色的五角星表示,现在出现了两个未知的案例,也就是图中绿色的方块,我们如何去分类这两个例子呢?在KNN算法中我们考虑的是未知样例与已知的训练样例的平均距离,未知样例与正例和反例的“距离”谁更近,那么他就是对应的分类。

同样是利用距离,我们可以换一个方式去考虑:假设图中的红线是对正例与反例的分类标准(记为w x+b=0),那么我们的未知样例与红线的“距离”就成了一个表示分类信度的标准,而w y+b(y为未知样例的数据)的符号则可以看成是分类的标识。

但是遗憾的是我们不知道这样的一条分类标准(分类线)是什么,那么我们一个比较自然的想法就是从已知的分类数据(训练集)里找到离分割线最近的点,确保他们离分割面尽可能的远。

这样我们的分类器会更稳健一些。

从上面的例子来看,虚线穿过的样例便是离分割线最近的点,这样的点可能是不唯一的,因为分割线并不确定,下图中黑线穿过的训练样例也满足这个要求:所以“他们离分割面尽可能的远”这个要求就十分重要了,他告诉我们一个稳健的超平面是红线而不是看上去也能分离数据的黄线。

这样就解决了我们一开始提出的如何减少储存量的问题,我们只要存储虚线划过的点即可(因为在w x+b=-1左侧,w x+b=1右侧的点无论有多少都不会影响决策)。

像图中虚线划过的,距离分割直线(比较专业的术语是超平面)最近的点,我们称之为支持向量。

这也就是为什么我们这种分类方法叫做支持向量机的原因。

至此,我们支持向量机的分类问题转化为了如何寻找最大间隔的优化问题。

二、SVM的一些细节支持向量机的实现涉及许多有趣的细节:如何最大化间隔,存在“噪声”的数据集怎么办,对于线性不可分的数据集怎么办等。

svm算法r语言代码

svm算法r语言代码SVM算法是一种常用的机器学习算法,它在分类和回归问题中都有广泛的应用。

本文将介绍SVM算法的基本原理,并给出在R语言中实现SVM算法的代码示例。

SVM(Support Vector Machine)算法是一种基于统计学习理论的分类算法。

它的基本思想是通过在特征空间中找到一个最优的超平面,将不同类别的样本分开。

这个超平面被称为分离超平面,它使得同一类别的样本尽可能地靠近,不同类别的样本尽可能地远离。

在SVM算法中,我们首先需要将样本映射到高维特征空间中,然后在特征空间中找到一个最优的超平面。

为了找到这个最优的超平面,我们需要定义一个目标函数,并通过优化算法来求解。

在R语言中,我们可以使用e1071包来实现SVM算法。

首先,我们需要安装e1071包,并加载它:```Rinstall.packages("e1071")library(e1071)```接下来,我们可以使用svm函数来训练一个SVM模型。

假设我们有一个包含两个特征的数据集X和对应的标签y,其中y为1表示正样本,为-1表示负样本。

我们可以使用以下代码来训练一个线性SVM模型:```Rmodel <- svm(y ~ ., data = X, kernel = "linear")```在这个代码中,y ~ .表示使用所有的特征进行分类,data = X表示数据集为X,kernel = "linear"表示使用线性核函数。

训练完成后,我们可以使用predict函数来对新的样本进行分类。

以下是一个示例代码:```Rnew_data <- data.frame(feature1 = c(1, 2, 3), feature2 = c(4, 5, 6))predictions <- predict(model, newdata = new_data)```在这个代码中,我们创建了一个新的数据集new_data,然后使用predict函数对其进行分类,并将结果保存在predictions变量中。

svm算法r语言代码

svm算法r语言代码(实用版5篇)目录(篇1)1.引言2.SVM 算法简介3.R 语言简介4.SVM 算法在 R 语言中的实现5.示例代码6.结论正文(篇1)1.引言支持向量机(SVM)是一种非常强大和灵活的监督学习算法,广泛应用于分类和回归问题。

R 语言是一种统计计算和图形展示的强大工具,广泛应用于数据分析和建模领域。

本文将介绍如何在 R 语言中实现 SVM 算法。

2.SVM 算法简介SVM 算法的核心思想是找到一个最佳超平面,将不同类别的数据分开。

它通过最大化边缘(即支持向量与超平面之间的距离)来实现这一目标。

SVM 算法可以解决线性可分支持向量机(linearly separable)和非线性支持向量机(non-linearly separable)问题。

3.R 语言简介R 语言是一种统计计算和图形展示的强大工具,广泛应用于数据分析和建模领域。

它有一个丰富的函数库,可以进行各种数据处理和分析任务。

在 R 语言中,可以使用不同包来实现 SVM 算法。

4.SVM 算法在 R 语言中的实现要在 R 语言中实现 SVM 算法,可以使用一些特定的包,如"svm", "e1071"等。

以下是一个简单的示例,使用"svm"包对鸢尾花数据集进行分类:```R# 加载所需的库library(svm)library(datasets)# 加载鸢尾花数据集data(iris)# 将数据集拆分为训练集和测试集set.seed(123)index <- sample(1:nrow(iris), 0.7 * nrow(iris))train_data <- iris[index, ]test_data <- iris[-index, ]# 定义 SVM 模型参数svm_model <- svm(Species ~., data = train_data, kernel = "rbf", C = 1, gamma = 0.1)# 对测试集进行预测predictions <- predict(svm_model, test_data)# 计算准确率accuracy <- mean(predictions == test_data$Species)cat("Accuracy:", accuracy, "")```5.示例代码在上面的示例中,我们使用"svm"包对鸢尾花数据集进行了分类。

支持向量回归案例代码

支持向量回归案例代码支持向量回归(Support Vector Regression, SVR)是一种基于支持向量机的回归方法,可以用于解决回归问题。

下面列举了一些支持向量回归的案例代码,以帮助读者更好地理解和应用该方法。

1. 一维线性回归案例:```pythonfrom sklearn.svm import SVRimport numpy as np# 创建训练数据X = np.sort(5 * np.random.rand(100, 1), axis=0)y = np.sin(X).ravel()# 训练支持向量回归模型svr = SVR(kernel='linear', C=1.0, epsilon=0.2)svr.fit(X, y)# 预测X_test = np.linspace(0, 5, 100).reshape(-1, 1)y_pred = svr.predict(X_test)# 可视化结果import matplotlib.pyplot as pltplt.scatter(X, y, color='darkorange', label='data') plt.plot(X_test, y_pred, color='navy', label='SVR') plt.xlabel('X')plt.ylabel('y')plt.title('SVR - Linear Kernel')plt.legend()plt.show()```2. 多维非线性回归案例:```pythonfrom sklearn.svm import SVRimport numpy as np# 创建训练数据X = np.sort(5 * np.random.rand(100, 2), axis=0)y = np.sin(X[:, 0]) + np.cos(X[:, 1])# 训练支持向量回归模型svr = SVR(kernel='rbf', C=1.0, epsilon=0.2)svr.fit(X, y)# 预测X1 = np.linspace(0, 5, 50)X2 = np.linspace(0, 5, 50)X_test = np.array(np.meshgrid(X1, X2)).T.reshape(-1, 2)y_pred = svr.predict(X_test)# 可视化结果import matplotlib.pyplot as pltfrom mpl_toolkits.mplot3d import Axes3Dfig = plt.figure()ax = fig.add_subplot(111, projection='3d')ax.scatter(X[:, 0], X[:, 1], y, color='darkorange', label='data')ax.scatter(X_test[:, 0], X_test[:, 1], y_pred, color='navy', label='SVR')ax.set_xlabel('X1')ax.set_ylabel('X2')ax.set_zlabel('y')ax.set_title('SVR - RBF Kernel')plt.legend()plt.show()```3. 支持向量回归中的参数调优:```pythonfrom sklearn.svm import SVRfrom sklearn.model_selection import GridSearchCVimport numpy as np# 创建训练数据X = np.sort(5 * np.random.rand(100, 1), axis=0)y = np.sin(X).ravel()# 定义参数范围param_grid = {'C': [0.1, 1.0, 10.0], 'epsilon': [0.1, 0.2, 0.5], 'kernel': ['linear', 'rbf']}# 使用网格搜索寻找最佳参数svr = SVR()grid_search = GridSearchCV(svr, param_grid, cv=5)grid_search.fit(X, y)# 输出最佳参数print("Best Parameters: ", grid_search.best_params_)# 预测X_test = np.linspace(0, 5, 100).reshape(-1, 1)y_pred = grid_search.predict(X_test)# 可视化结果import matplotlib.pyplot as pltplt.scatter(X, y, color='darkorange', label='data') plt.plot(X_test, y_pred, color='navy', label='SVR') plt.xlabel('X')plt.ylabel('y')plt.title('SVR - Best Parameters')plt.legend()plt.show()```4. 使用SVR进行时间序列预测:```pythonfrom sklearn.svm import SVRimport numpy as np# 创建时间序列数据X = np.arange(0, 10, 0.1).reshape(-1, 1)y = np.sin(X).ravel()# 训练支持向量回归模型svr = SVR(kernel='rbf', C=1.0, epsilon=0.2)svr.fit(X, y)# 预测X_test = np.arange(10, 20, 0.1).reshape(-1, 1)y_pred = svr.predict(X_test)# 可视化结果import matplotlib.pyplot as pltplt.plot(X, y, color='darkorange', label='data') plt.plot(X_test, y_pred, color='navy', label='SVR') plt.xlabel('X')plt.ylabel('y')plt.title('SVR - Time Series')plt.legend()plt.show()```5. 使用SVR进行异常点检测:```pythonfrom sklearn.svm import SVRimport numpy as np# 创建训练数据X = np.sort(5 * np.random.rand(100, 1), axis=0)y = np.sin(X).ravel()# 添加异常点X_outliers = np.array([[2.5]])y_outliers = np.array([10.0])X = np.concatenate((X, X_outliers))y = np.concatenate((y, y_outliers))# 训练支持向量回归模型svr = SVR(kernel='linear', C=1.0, epsilon=0.2)svr.fit(X, y)# 预测X_test = np.linspace(0, 5, 100).reshape(-1, 1)y_pred = svr.predict(X_test)# 可视化结果import matplotlib.pyplot as pltplt.scatter(X, y, color='darkorange', label='data')plt.plot(X_test, y_pred, color='navy', label='SVR')plt.scatter(X_outliers, y_outliers, color='red', label='outliers')plt.xlabel('X')plt.ylabel('y')plt.title('SVR - Outliers')plt.legend()plt.show()```6. 使用SVR进行多任务学习:```pythonfrom sklearn.svm import SVRimport numpy as np# 创建训练数据X = np.sort(5 * np.random.rand(100, 1), axis=0)y1 = np.sin(X).ravel()y2 = np.cos(X).ravel()# 训练支持向量回归模型svr = SVR(kernel='linear', C=1.0, epsilon=0.2, multioutput='uniform_average')svr.fit(X, np.column_stack((y1, y2)))# 预测X_test = np.linspace(0, 5, 100).reshape(-1, 1)y_pred = svr.predict(X_test)# 可视化结果import matplotlib.pyplot as pltplt.scatter(X, y1, color='darkorange', label='data1')plt.scatter(X, y2, color='limegreen', label='data2')plt.plot(X_test, y_pred[:, 0], color='navy', label='SVR1') plt.plot(X_test, y_pred[:, 1], color='purple', label='SVR2') plt.xlabel('X')plt.ylabel('y')plt.title('SVR - Multi-task Learning')plt.legend()plt.show()```7. 使用SVR进行特征选择:```pythonfrom sklearn.svm import SVRfrom sklearn.datasets import load_bostonfrom sklearn.feature_selection import SelectFromModel# 加载波士顿房价数据集X, y = load_boston(return_X_y=True)# 特征选择svr = SVR(kernel='linear', C=1.0, epsilon=0.2)sfm = SelectFromModel(svr)X_new = sfm.fit_transform(X, y)# 输出选择的特征print("Selected Features: ", sfm.get_support(indices=True)) ```8. 使用SVR进行稀疏数据回归:```pythonfrom sklearn.svm import SVRimport numpy as np# 创建稀疏训练数据X = np.sort(5 * np.random.rand(100, 1), axis=0)y = np.sin(X).ravel()X[::5] = np.nany[::5] = np.nan# 训练支持向量回归模型svr = SVR(kernel='linear', C=1.0, epsilon=0.2)svr.fit(X, y)。

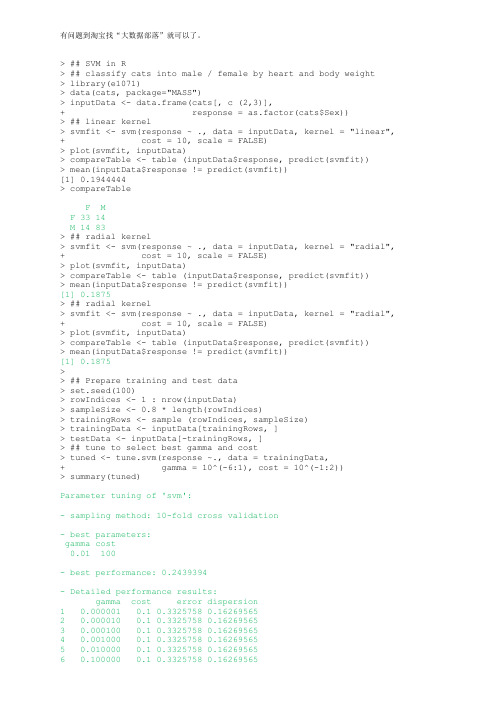

【原创】r语言SVM-in-R代码

> ## SVM in R> ## classify cats into male / female by heart and body weight> library(e1071)> data(cats, package="MASS")> inputData <- data.frame(cats[, c (2,3)],+ response = as.factor(cats$Sex))> ## linear kernel> svmfit <- svm(response ~ ., data = inputData, kernel = "linear", + cost = 10, scale = FALSE)> plot(svmfit, inputData)> compareTable <- table (inputData$response, predict(svmfit))> mean(inputData$response != predict(svmfit))[1] 0.1944444> compareTableF MF 33 14M 14 83> ## radial kernel> svmfit <- svm(response ~ ., data = inputData, kernel = "radial", + cost = 10, scale = FALSE)> plot(svmfit, inputData)> compareTable <- table (inputData$response, predict(svmfit))> mean(inputData$response != predict(svmfit))[1] 0.1875> ## radial kernel> svmfit <- svm(response ~ ., data = inputData, kernel = "radial", + cost = 10, scale = FALSE)> plot(svmfit, inputData)> compareTable <- table (inputData$response, predict(svmfit))> mean(inputData$response != predict(svmfit))[1] 0.1875>> ## Prepare training and test data> set.seed(100)> rowIndices <- 1 : nrow(inputData)> sampleSize <- 0.8 * length(rowIndices)> trainingRows <- sample (rowIndices, sampleSize)> trainingData <- inputData[trainingRows, ]> testData <- inputData[-trainingRows, ]> ## tune to select best gamma and cost> tuned <- tune.svm(response ~., data = trainingData,+ gamma = 10^(-6:1), cost = 10^(-1:2))> summary(tuned)Parameter tuning of 'svm':- sampling method: 10-fold cross validation- best parameters:gamma cost0.01 100- best performance: 0.2439394- Detailed performance results:gamma cost error dispersion1 0.000001 0.1 0.3325758 0.162695652 0.000010 0.1 0.3325758 0.162695653 0.000100 0.1 0.3325758 0.162695654 0.001000 0.1 0.3325758 0.162695655 0.010000 0.1 0.3325758 0.162695656 0.100000 0.1 0.3325758 0.162695657 1.000000 0.1 0.3325758 0.162695658 10.000000 0.1 0.3325758 0.162695659 0.000001 1.0 0.3325758 0.1626956510 0.000010 1.0 0.3325758 0.1626956511 0.000100 1.0 0.3325758 0.1626956512 0.001000 1.0 0.3325758 0.1626956513 0.010000 1.0 0.3325758 0.1626956514 0.100000 1.0 0.3159091 0.1778842815 1.000000 1.0 0.2628788 0.1028277116 10.000000 1.0 0.3409091 0.1073752117 0.000001 10.0 0.3325758 0.1626956518 0.000010 10.0 0.3325758 0.1626956519 0.000100 10.0 0.3325758 0.1626956520 0.001000 10.0 0.3325758 0.1626956521 0.010000 10.0 0.2886364 0.1275914922 0.100000 10.0 0.2530303 0.0951722123 1.000000 10.0 0.2530303 0.1115235724 10.000000 10.0 0.2977273 0.1157794525 0.000001 100.0 0.3325758 0.1626956526 0.000010 100.0 0.3325758 0.1626956527 0.000100 100.0 0.3325758 0.1626956528 0.001000 100.0 0.2795455 0.1248634629 0.010000 100.0 0.2439394 0.0973975230 0.100000 100.0 0.2530303 0.0866864431 1.000000 100.0 0.2886364 0.1148615232 10.000000 100.0 0.3151515 0.12827686> ## select the best model> bestmod =tuned$best.model> summary(bestmod)Call:best.svm(x = response ~ ., data = trainingData, gamma = 10^(-6:1), cost = 10^(-1:2))Parameters:SVM-Type: C-classificationSVM-Kernel: radialcost: 100gamma: 0.01Number of Support Vectors: 67( 34 33 )Number of Classes: 2Levels:F M> plot(bestmod,inputData)>> ## prediction> svmfit <- svm (response ~ ., data = trainingData, kernel = "radial",+ cost = 100, gamma=0.01, scale = FALSE)> plot(svmfit, trainingData)> compareTable <- table(testData$response, predict(svmfit, testData))> mean(testData$response != predict(svmfit, testData))[1] 0.1034483> ## polynomial kernel> svmfit <- svm(response ~ ., data = inputData, kernel = "polynomial", degree=2,+ cost = 10, scale = FALSE)> plot(svmfit, inputData)> tuned <- tune.svm(response ~., data = trainingData, kernel="polynomial", + degree=(1:6), cost = 10^(-1:2))WARNING: reaching max number of iterationsWARNING: reaching max number of iterations> bestmod =tuned$best.model> summary(bestmod)Call:best.svm(x = response ~ ., data = trainingData, degree = (1:6), cost =10^(-1:2),kernel = "polynomial")Parameters:SVM-Type: C-classificationSVM-Kernel: polynomialcost: 1degree: 1gamma: 0.5coef.0: 0Number of Support Vectors: 71( 36 35 )Number of Classes: 2Levels:F M> plot(bestmod,inputData)>>> ## prediction> svmfit <- svm (response ~ ., data = trainingData, kernel = "polynomial", + cost = 1, gamma=0.5,degree=1, scale = FALSE)> plot(svmfit, trainingData)> compareTable <- table(testData$response, predict(svmfit, testData))> mean(testData$response != predict(svmfit, testData))[1] 0.1034483。

svm 实验报告

svm 实验报告SVM 实验报告摘要:支持向量机(SVM)是一种常用的机器学习算法,广泛应用于模式识别、文本分类、图像识别等领域。

本实验旨在通过对SVM算法的实验研究,探讨其在不同数据集上的分类性能和泛化能力。

实验结果表明,在合适的参数设置下,SVM算法能够有效地对数据进行分类,并且在处理高维数据和小样本数据方面表现出优异的性能。

本文将详细介绍实验设计、实验数据、实验结果和分析讨论,旨在为读者提供对SVM算法的深入理解和应用指导。

1. 实验设计本实验选取了两个经典的数据集,分别是Iris数据集和MNIST手写数字数据集。

Iris数据集是一个经典的分类数据集,包含了150个样本,分为3类,每类有50个样本,每个样本有4个特征。

MNIST手写数字数据集是一个常用的图像分类数据集,包含了60000个训练样本和10000个测试样本,每个样本是一张28x28像素的手写数字图片。

在实验中,我们使用Python编程语言和Scikit-learn机器学习库进行实验。

对于Iris数据集,我们将数据集分为训练集和测试集,然后使用SVM算法进行训练和测试。

对于MNIST数据集,我们将数据集进行预处理,然后使用SVM算法进行训练和测试。

2. 实验数据在实验中,我们使用了Iris数据集和MNIST数据集作为实验数据。

Iris数据集是一个经典的分类数据集,包含了150个样本,分为3类,每类有50个样本,每个样本有4个特征。

MNIST手写数字数据集是一个常用的图像分类数据集,包含了60000个训练样本和10000个测试样本,每个样本是一张28x28像素的手写数字图片。

3. 实验结果在实验中,我们分别对Iris数据集和MNIST数据集进行了实验,得到了如下结果:对于Iris数据集,我们使用SVM算法进行分类,得到了如下结果:在训练集上的准确率为98%,在测试集上的准确率为96%。

对于MNIST数据集,我们使用SVM算法进行分类,得到了如下结果:在训练集上的准确率为98%,在测试集上的准确率为96%。

svm 实验报告

svm 实验报告SVM实验报告引言支持向量机(Support Vector Machine,SVM)是一种常用的机器学习算法,广泛应用于模式识别、图像分类、文本分类等领域。

本篇实验报告将介绍SVM的原理、实验设计和结果分析。

一、SVM原理SVM是一种监督学习算法,其基本思想是通过寻找一个最优的超平面来将不同类别的样本分开。

在二维空间中,这个超平面就是一条直线,而在多维空间中,这个超平面则是一个超平面。

SVM的目标是使得两个不同类别的样本点离超平面的距离最大化,从而提高分类的准确性。

二、实验设计本次实验使用了一个开源的数据集,该数据集包含了一些花朵的特征数据,共分为三个类别。

首先,我们将数据集划分为训练集和测试集,其中70%的数据用于训练,30%的数据用于测试。

然后,我们使用Python编程语言中的scikit-learn库来实现SVM算法,并将训练集输入模型进行训练。

最后,使用测试集对模型进行评估,并计算分类的准确率。

三、实验结果分析经过训练和测试,我们得到了如下结果:SVM在测试集上的准确率为90%。

这意味着模型能够正确分类90%的花朵样本。

通过观察分类结果,我们发现SVM对于不同类别的花朵具有较好的区分能力,分类边界清晰。

然而,也存在一些分类错误的情况,可能是由于样本之间的重叠或噪声数据的干扰所导致。

四、结果讨论在本次实验中,我们成功地应用了SVM算法进行花朵分类,并取得了较好的分类准确率。

然而,我们也发现了一些问题。

首先,SVM对于噪声数据和重叠样本的处理能力相对较弱,这可能导致一些错误分类的情况。

其次,SVM的计算复杂度较高,在处理大规模数据时可能会面临一些挑战。

因此,在实际应用中需要对数据进行预处理,如特征选择和降维等,以提高算法的效率和准确性。

五、结论本次实验通过实现SVM算法对花朵数据集进行分类,取得了较好的结果。

SVM 作为一种常用的机器学习算法,在模式识别和分类问题中具有广泛的应用前景。

利用R语言实现支持向量机(SVM)数据挖掘案例

利用R语言实现支持向量机(SVM)数据挖掘案例建立模型svm()函数在建立支持向量机模型的时候有两种建立方式。

简单地说,一种是根据既定公式建立模型;而另外一种方式则是根据所给的数据模型建立模型。

根据函数的第一种使用格式,针对上述数据建模时,应该先确定所建立的模型所使用的数据,然后再确定所建立模型的结果变量和特征变来那个。

代码如下:library(e1071)data(iris)#建立svm模型model <- svm(Species~.,data = iris)在使用第一种格式建立模型时,如果使用数据中的全部特征变量作为模型特征变量时,可以简要地使用“Species~.”中的“.”代替全部的特征变量。

根据函数的第二种使用格式,在针对iris数据建立模型时,首先应该将结果变量和特征变量分别提取出来。

结果变量用一个向量表示,而特征向量用一个矩阵表示。

在确定好数据后还应根据数据分析所使用的核函数以及核函数所对应的参数值,通常默认使用高斯内积函数作为核函数,具体分析代码如下:#提取iris数据中除第5列以外的数据作为特征变量x <- iris[,-5]#提取iris数据中第5列数据作为结果变量y <- iris[,5]#建立svm模型model <- svm(x,y,kernel = "radial", gamma = if(is.vector(x)) 1 else 1/ncol(x))在使用第二种格式建立模型时,不需要特别强调所建立模型的哪个是,函数会自动将所有输入的特征变量数据作为建立模型所需要的特征变来那个。

在上述过程中,确定核函数的gamma系数时所使用的R语言所代表的意思为:如果特征向量是向量则gamma值取1,否则gamma值为特征向量个数的倒数。

结果分析summary(model)Call:svm.default(x = x, y = y, kernel = "radial", gamma = if (is.vector(x)) 1 else 1/ncol(x))Parameters:SVM-Type: C-classificationSVM-Kernel: radialcost: 1gamma: 0.25Number of Support Vectors: 51( 8 22 21 )Number of Classes: 3Levels:setosa versicolor virginica通过summary()函数可以得到关于模型的相关信息。

机器学习中支持向量机算法的使用教程及实战案例分析

机器学习中支持向量机算法的使用教程及实战案例分析支持向量机(Support Vector Machine,SVM)是一种重要的机器学习算法,被广泛应用于分类和回归问题。

它在许多实际应用中显示出了出色的性能和鲁棒性。

本文将详细介绍支持向量机算法的原理、使用方法和实战案例分析。

一、支持向量机算法的原理支持向量机算法的基本原理是基于最大间隔分类的思想,通过在特征空间中找到一个最优超平面,将不同类别的数据样本完全分开。

该超平面由支持向量确定,支持向量是距离超平面最近的样本点。

支持向量机算法的目标是最大化间隔。

间隔指的是超平面到最近的样本点的距离,最大化间隔可以提高模型的鲁棒性。

支持向量机算法可以处理线性可分和线性不可分的问题。

对于线性可分问题,可以使用硬间隔支持向量机;对于线性不可分问题,可以使用软间隔支持向量机,通过引入松弛变量来容忍一定的错分类。

二、支持向量机算法的使用方法1. 数据预处理在应用支持向量机算法之前,需要对数据进行预处理。

首先,对数据进行清洗,处理缺失值和异常值。

然后,对数据进行标准化或归一化,以便不同特征之间的数值范围一致。

2. 特征选择选择合适的特征对支持向量机算法的性能至关重要。

可以通过统计方法、相关性分析或专业知识等方式选择最具区分度的特征。

3. 模型训练将数据集分为训练集和测试集,使用训练集对支持向量机模型进行训练。

在模型训练过程中,需要选择合适的核函数和参数,并进行交叉验证来确定最优的模型。

4. 模型评估使用测试集对训练好的支持向量机模型进行评估。

常用的评估指标包括准确率、精确率、召回率和F1值等。

通过评估结果可以判断模型的性能。

三、支持向量机算法的实战案例分析为了更好地理解支持向量机算法的应用,下面将介绍一个实战案例:乳腺癌分类。

乳腺癌是女性常见的恶性肿瘤之一,及早发现和诊断对于治疗和预后非常重要。

在这个案例中,我们将使用支持向量机算法对乳腺癌进行分类。

首先,我们收集了乳腺癌相关的临床特征数据,包括肿块的厚度、大小、形状等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

支持向量机(support vector machine)第一次见到这个词可能难以理解这个奇怪的名字,这是一个90年代产生在深度学习出来之前逼格满满的算法,被认为是适应性最广的分类器之一。

SVM是一个基于严格的数学推导的算法(但本文不推导),本文只大概介绍基本思想和简单原理及实践过程。

最大间隔分类器

在二维平面上,一条直线可以把平面分成两边;在三维空间中,一个平面可以把空间分成两块……那么同理,在p+1的高维空间中,一个p维的超平面也可以将其成本两部分,超平面的定义:

超平面的定义

根据高中空间几何的知识可知,把一个点代入上式,如果等于0说明正好在超平面上;大于0在其上方,小于0在其下方。

那么就可以根据这个特点来映射二分类问题。

只要我们可以构建出超平面方程,再把样本点代入,根据结果的正负就可以进行分类。

超平面分隔

实际上,能把不同类别样本分隔开来的超平面并不止一个,有无数个。

如图中蓝色和橙色虚线都能把两类样本分开,那么你认为这两个哪一个分隔效果更好?

如果用蓝色分隔超平面,那上面的白球就被分成橙色,下面的白球则被分成蓝色;如果用橙色分隔超平面,则结果完全相反。

可是根据KNN的思想,很容易看出上面的白球应该被分成蓝色,下面的白球应该被分成橙色。

可以观察到,橙色超平面总体上距离两边的球都比蓝色的远,这就是涉及到最大间隔超平面的概念。

对于任一个超平面(以实线表示),把它往两边平移,直至与两边的样本相交(以虚线表示,相交点就叫支持向量,现在知道支持向量机这个名字的由来了吧~),如果两边的虚线的距离最大,这个超平面就是最大间隔超平面。

因为最大间隔超平面总体上把不同类别的样本分得最大,所以泛化性能最好。

最大间隔超平面

那么SVM算法的优化实际上就是对超平面间距的最大值优化,以数字公式来表达是这样的:

SVM的约束条件及优化目标

其中M是超平面间隔,也是优化目标。

β是归一化参数,y取1或-1表示二分类。

优化过程涉及到复杂的数学推导就不细说了。

线性不可分情况

上面的例子中,不同样本之间本来就分隔得挺好,所以很容易被线性超平面分隔开来。

但现实中的数据往往不太可能自动地分离得这么好,甚至存在着线性不可分,比如请用一条直线把下面两种类别的点完全区分开来:

线性不可分示例

既然数据本来就是线性不可分,为了使用线性超平面作分割,就要作出一些让步,即可以容忍一部分分错的情况(这样类似于以提高一部分偏差为代价来减小方差),那么优化函数就变成以下:

有调节的优化目标

C是非负调节参数,ε是一个松弛变量,用来进行一定程度的线性不可分调节,有了这个松弛变量,样本就可以不必严格地在虚线一侧,可以有一定的偏移。

非线性SVM

然而现实中的数据往往是根本不可能用线性分类器就能区分,即使再怎么让步调整也没用,这个时候只能用非线性分类器。

之前提到的PCA是把高维降成低维,减少特征间的相关性,只抽象出最主要的分成——虽然说维度越高越复杂,但是反过来,把低维空间投影至高维空间有没有意义?

对于上面那张线性不可分示意图,它是在一维坐标轴上的,如果把它投影到二维平面上,比如:

二维平面上的线性可分.png

现在是不是就能很容易地用一条直线把两种类别的球分开了?

所以低维空间上线性不可分的问题映射至高维空间就有了线性可分的可能,这就是非线性SVM的核心思想。

然而把低维数据映射到高维空间,会不会使计算复杂很多,甚至会产生维度灾难?这就是SVM的另一巧妙之处,通过核函数把低维变量映射成高维变量,高维变量主要是向量的内积计算,却可以转化成低维向量的内积计算。

也就是说通过核函数把低维向量映射到高维空间可以解决线性不可分的问题,却不会额外产生复杂的计算代价!

常用的核函数有多项式核函数、径向核函数等等,这个不做专门研究不需要理解太深,会调包解决问题即可。

通过核函数复合的非线性SVM的超平面的投影就不是直线了。

多项式核函数与径向核函数

支持向量机与逻辑回归的区别

SVM与LR都是分类器,有联系也有差别。

SVM vs LR

SVM与LR的损失函数曲线

当f(x)>=1时损失函数为0,表示观测点被正确地分到一侧。

此外,LR的拟合是由全部的样本决定的,而SVM的拟合实际上只由少数几个支持向量决定的。

以下是Andrew Ng的《Machine Learning》中给出的SVM与LR的选择技巧:

∙如果相对于样本量m,特征变量个数n很大,选择逻辑回归或者线性核函数的SVM(这种情况下相当于过拟合的状况,适合用简单的逻辑回归或不带核函数的SVM);

∙如果特征变量个数n很少,样本量m中等,使用带核函数的SVM;

∙如果特征变量个数n很少,样本量m很大(这种情况相当于低拟合的状态),增加更多的特征,然后使用逻辑回归或者不带核函数的SVM。