MPI环境搭建

MPICH2在Windows环境下Visual_Studio_2010的环境搭建

MPICH2在Windows系统Visual Studio 2010的环境搭建本机运行环境:机器型号:联想G450处理器:Pentium(R)Dual-Core CPU T4200 @ 2.00GHz运行内存(RAM):2GB操作系统:Windows 7(32位)程序开发环境:Visual Studio 2008MPI版本:mpich2-1.3.2p1-win-ia32安装程序MPI的编译和运行对于简单的程序,可以使用专门的编译命令。

对于大的项目,最好使用标准的Makefile。

MPICH提供的编译命令有mpicc和mpif77,它们分别是C和Fortran的编译命令: mpicc -o first first.cmpif77 -o first firstf.f对于编译得到的目标程序,运行的命令为:mpirun –arch xxx –np yyy first其中xxx为machines.<arch>的<arch>,yyy为申请的进程数目。

MPICH的安装和配置文中使用的MPICH2安装文件是mpich2-1.4-win-ia32(/mpi/mpich),在Windows下安装MPICH2比较简单,但是要有Microsoft .NET Framework的支持。

安装基本上只要单击“Next”即可。

在安装过程中会提示输入进程管理器的密码,这个密码被用来访问所有的程序,这里使用的密码为admin。

如果是多台机器执行mpi,那么这多台机器上必须配置相同的mpi用户,就是新用户的用户名和密码必须相同。

安装完成后,安装目录下的include子目录包含了编程所需要的所有头文件,lib子目录包含了相应的程序库,而子目录bin则包含了MPI在Windows下面必须的运行程序。

运行时需要的动态链接库被安装在了Windows系统目录中。

在Windows平台下可以使用Microsoft Visual Studio来开发MPI程序。

并行程序实验报告

并行程序设计实验报告姓名:学号:一、实验目的通过本次试验,了解使用OpenMP编程的基本方法和MPI的编程方法,通过实践实现的基本程序,掌握基本的线程及进程级并行应用开发技术,能够分析并行性能瓶颈及相应优化方法。

二、实验环境Linux操作系统,mpi库,多核处理器三、实验设计与实现(一)MPI并行程序设计用MPI编写一个greeting程序,编号为0的进程接受其它各进程的“问候”,并在计算机屏幕上显示问候情况。

用MPI编写一个多进程求积分的程序,并通过积分的方法求π的值,结果与π的25位精确值比较。

(二)多线程程序设计用Pthreads或OpenMP编写通过积分的方法求π的程序。

把该程序与相应的MPI程序比较。

用Pthreads或OpenMP编写编写矩阵相乘的程序,观察矩阵增大以及线程个数增减时的情形。

四、实验环境安装(一)MPI环境安装1.安装kylin操作系统的虚拟机(用VirtualBox)2.安装增强功能,使之与windows主机能够文件共享。

3.拷贝mpich-3.0.4.tar.gz到/root/myworkspace/目录下,并解压(tar xzf mpich-3.0.4.tar.gz)4.下面开始安装mkdir /root/myworkspace/mpi./configure --prefix=/root/myworkspace/mpi --disable-f77 --disable-fcmakemake install5.配置环境变量打开/root/.bashrc文件,在文件的末尾加上两行:PATH=$PATH:/root/myworkspace/mpi/binexport PATH保存退出,然后执行命令source /root/.bashrc(二)openMP实验环境安装Visual Studio中修改:项目->属性->c/c++->语言,将“OpenMP支持”改成“是”:五、实验结果及分析(一)MPI并行程序设计实验一:问候发送与接收非零号进程将问候的信息发送给0号进程,0号进程依次接收其它进程发送过来的消息并将其输出。

openfoam mpi编译

OpenFOAM是一个由英国OpenCFD公司开发的开源计算流体力学软件。

它采用C++编程语言,可以在Linux操作系统上运行。

OpenFOAM具有模块化的结构,使得用户可以方便地定制和扩展其功能。

为了加快计算速度,OpenFOAM还支持MPI并行计算。

MPI(Message Passing Interface)是一种用于编写并行程序的标准。

使用MPI,用户可以在多个处理器上同时执行程序,从而加快计算速度。

在OpenFOAM中,MPI被用于加速求解大规模计算流体力学问题的速度。

在本文中,我们将介绍如何在OpenFOAM中使用MPI进行编译。

一、安装MPI库我们需要安装MPI库。

在Linux系统中,MPI一般通过包管理器进行安装。

以Ubuntu系统为例,可以使用以下命令安装MPI库:sudo apt-get install mpich二、配置MPI环境安装完MPI库后,需要配置MPI环境。

在OpenFOAM中,MPI的配置是通过修改OpenFOAM的环境变量来实现的。

我们需要找到OpenFOAM的安装路径,然后在用户目录下找到.bashrc文件,在其中添加如下行:export WM_MPLIB=SYSTEMOPENMPIexport WM_COMPILE_OPTION=mpi其中,WM_MPLIB指定了使用的MPI库,这里我们使用了OpenMPI;WM_COMPILE_OPTION指定了编译选项为MPI。

三、进行编译配置完成后,就可以进行编译了。

需要清理之前的编译结果,可以使用以下命令进行清理:wclean all进行新的编译:wmake这样就可以在OpenFOAM中使用MPI进行编译了。

四、检查编译结果需要检查编译结果是否正确。

可以通过运行一个包含MPI并行计算的例子来验证编译是否成功。

如果例子能够正确运行并且加速效果明显,说明MPI编译成功。

总结通过本文介绍,我们了解了如何在OpenFOAM中使用MPI进行编译。

MPI综合实验报告

MPI综合实验报告一、实验目的本次实验旨在探究MPI并行计算技术在多节点集群中的应用,并通过编写相关代码实现一个简单的并行计算任务,验证MPI的计算能力和效果。

二、实验原理MPI(Message Passing Interface)是一种并行计算中进程间通信的标准接口。

MPI通过发送和接收消息来实现进程之间的通信,协调各个计算节点的工作。

一般而言,MPI程序由多个进程组成,每个进程可以独立地执行计算任务,当需要进行通信时,进程可以通过MPI提供的接口来发送和接收消息。

三、实验过程1.配置MPI环境在实验开始前,需要在多个节点上安装MPI环境,并确保各节点之间能够正常通信,可以互相发送和接收消息。

2.编写代码首先,需要编写一个主进程(通常为进程0)和多个子进程参与计算的代码。

主进程负责将计算任务分配给子进程,并收集子进程的计算结果。

子进程则负责进行具体的计算任务。

以下是一个简单的示例代码:```pythonfrom mpi4py import MPIif rank == 0:#主进程负责任务分配data = [i for i in range(size-1)] # 分配给每个子进程的数据for i in range(1, size):#主进程接收结果result = []for i in range(1, size):print("Result:", result)else:#子进程接收任务数据#子进程进行计算result = data * 2#子进程发送计算结果```以上代码使用了mpi4py库来实现MPI的功能。

在主进程中,首先准备要分配的数据,然后将每个子进程的数据发送给相应的子进程,并接收子进程的计算结果。

在子进程中,首先接收来自主进程的数据,然后进行计算,并将计算结果发送给主进程。

3.运行实验在配置好MPI环境和编写好代码后,将代码保存并上传到各个节点上。

然后,在主节点上执行以下命令来运行程序:``````其中,`-np 5`表示使用5个进程来进行计算。

基于Linux的MPI并行环境的配置

MPI简介

MPI(Message

P鹪sing

“pich一1.2.6.tⅡ.f5z/(/表示enter键操作)。

(3)解包tar—xvfmpich—1.2.6/。 Inted如e)的定义是多种 (4)进人解压缩解包后的目录。cd 2.6/。 (5)安装mpich一1.2.6。在此我mpich—1.2.6

mpich—I.

多样的,但不外乎下面三个方面的内容,他们限定 了MPI的内涵和外延: (1)MPI是一个库,不是一种语言。按照并行 语言的分类,可以把在F0nraIl或c上实现的MPI 看作是在串行程序的基础上扩展后得到的并行语 言。MPI可以看作是Fortran或C语言的函数库的 调用,它遵守所有对库函数/过程的调用规则,与一 般的函数/过程调用没什么区别。 (2)MPI足一种规范或标准的代表,而不特指 某一个对它的具体实现。 (3)MPI足一种消息传递模型,并成为这种编 程模型的代表和事实上的标准。MH主要和最终 的目的都足服务于进程间通信。 MPIcH是一种重要的MPI实现,本文主要配置

行的并行程序的同一目录下)。

vi

co曲g/

进程名

0 1 l

小结

本文比较详细地叙述了在bnux环境下如何

其中文件的格式为: 主机名 比如:

hpcl hpcl hpcl /usr/home/p’og /usr/home/p’09

路径名

配置MPI,以实现多机的并行运行,或者单机情况

下以多进程来模拟多机并行计算。需要明确的是, 本文只是搭建了一个并行环境编写与运行的软件

一1.2.6/bin。

(8)检查安装是否成功。可以运行mpimn/ (安装成功会显示商ss

MPI使用操作流程

《mpi使用操作流程》xx年xx月xx日contents •MPI介绍•MPI安装与配置•MPI基本使用方法•MPI并行文件IO操作•MPI并行计算实例•MPI错误处理与调试目录01 MPI介绍Multiple Processor Interface:一种并行计算编程模型,用于多处理器或多线程并行计算。

Message Passing Interface:一种消息传递编程模型,用于分布式或并行计算系统中的进程间通信。

MPI含义MPI标准由美国Argonne国家实验室开发,成为并行计算领域的重要工具。

1993年MPI-2标准发布,增加了对异步通信和动态进程管理的支持。

1997年MPI-3标准发布,优化了并行计算性能和可扩展性。

2008年MPI发展历程MPI应用场景并行数据库MPI可以用于并行数据库系统中的数据分发和通信,提高数据处理速度和效率。

并行图处理MPI可以用于大规模图处理中的并行计算,提高图算法的效率和速度。

高性能计算MPI是高性能计算中常用的并行计算编程模型,被广泛应用于天气预报、物理模拟、数据分析等领域。

02MPI安装与配置确认操作系统版本和支持的MPI版本准备MPI安装所需组件和工具确认网络连接和远程访问能力下载对应版本的MPI安装包解压缩MPI安装包执行安装脚本,如`.bin/install.sh`等待安装过程完成,不要手动中断按照提示进行下一步操作,如选择安装路径、配置环境变量等MPI配置步骤进入MPI安装目录下的`etc`子目录编辑`mpd.conf`文件,配置MPI守护进程的参数配置MPI启动脚本,如`mpd.sh`、`mpdstart.sh`等设置启动脚本属性为可执行,如`chmod +x mpd.sh`使用启动脚本启动MPI守护进程,如`./mpd.sh &`确认MPI守护进程是否成功启动,可以使用`ps -ef |grep mpd`命令查看进程状态03MPI基本使用方法MPI运行环境设置安装MPI选择适合的MPI版本并按照说明进行安装。

MPICH2配置和使用

MPICH2配置和使用MPICH2是一个开源的高性能并行计算库,用于构建和管理分布式内存系统。

它是Message Passing Interface(MPI)的一个实现,MPI是一种用于在并行计算环境中进行通信和同步的标准。

MPICH2允许开发者在多个计算机之间发送消息和执行并行任务,以实现高效的并行计算。

本文将介绍如何配置和使用MPICH2来构建一个简单的并行计算应用程序。

一、环境准备2.配置计算机网络在使用MPICH2之前,需要配置计算机网络以便计算机之间进行通信。

可以使用本地网络(例如以太网)或者虚拟网络(例如VMware或VirtualBox)来模拟分布式计算环境。

3.配置环境变量将MPICH2的安装目录添加到系统的PATH环境变量中,以便在命令行中直接调用MPI的相关命令。

二、配置主节点1.选择一个计算机作为主节点,并在该计算机上打开命令行窗口。

2.启动MPD守护进程在命令行窗口中输入以下命令来启动MPD守护进程:```mpd &```3.配置主节点在命令行窗口中输入以下命令来配置主节点:```mpiexec -n 1 mpdtrace -l > mpd.hosts```以上命令将创建一个名为mpd.hosts的配置文件,其中包含了主节点的名称。

三、配置从节点1.选择其他计算机作为从节点,并对每个从节点重复以下步骤。

2.在从节点上打开命令行窗口,并输入以下命令来启动MPD守护进程:```mpd &```3.将从节点加入主节点的计算机网络中在主节点的命令行窗口中,输入以下命令来将从节点添加到主节点的计算机网络中:```mpiexec -n 1 -f mpd.hosts hostname```其中,mpd.hosts是主节点上创建的配置文件。

四、编写并行应用程序1.使用MPI的编程接口使用C、C++、Fortran等编程语言,使用MPI的编程接口来编写并行应用程序。

例如,以下是一个使用C语言和MPI编写的简单并行计算应用程序的示例代码:```c#include <stdio.h>#include <mpi.h>int main(int argc, char* argv[])int rank, size;MPI_Init(&argc, &argv);printf("Hello from node %d of %d\n", rank, size);MPI_Finalize(;return 0;```2.编译并行应用程序在主节点的命令行窗口中,使用适当的编译器来编译并行应用程序。

win7下vs+ivf+mpi配置

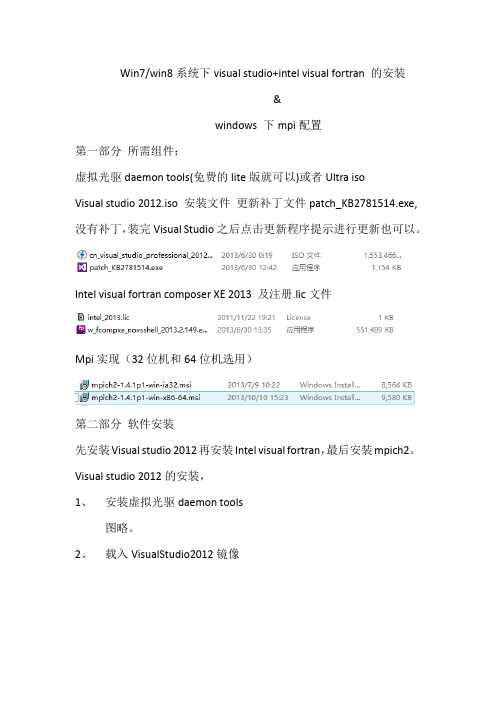

Win7/win8系统下visual studio+intel visual fortran 的安装&windows 下mpi配置第一部分所需组件:虚拟光驱daemon tools(免费的lite版就可以)或者Ultra isoVisual studio 2012.iso 安装文件更新补丁文件patch_KB2781514.exe,没有补丁,装完Visual Studio之后点击更新程序提示进行更新也可以。

Intel visual fortran composer XE 2013 及注册.lic文件Mpi实现(32位机和64位机选用)第二部分软件安装先安装Visual studio 2012再安装Intel visual fortran,最后安装mpich2。

Visual studio 2012的安装,1、安装虚拟光驱daemon tools图略。

2、载入VisualStudio2012镜像3、载入之后再磁盘窗口可以看到下图4、点击进入,双击运行安装程序5、接下来就是30分钟左右的等待时间(vs的确很庞大。

)6、安装完vs2012之后,在开始菜单找到程序运行,第一次运行默认环境设置选择C++,如图7、这时,右下角会出现更新提示,点击进行更新8、这两个更新是比较慢的,可以省略这一步,直接安装前面提到的补丁patch_KB2781514.exe直接双击安装,大概5分钟装完。

9、至此VS2012安装完毕,注意补丁是必须的。

IVF的安装1、直接双击安装文件安装,2、下一步,下一步,直到Activation,选择choose alternative activation2、然后use a license file,将intel_2013.lic文件选入,下一步3、怕麻烦就选full installation,那样的话会花费一些C盘内存。

或者选custom installation4、如果选择custom istallation ,参照下图5、至此,IVF安装完成。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

MPI 并行环境的搭建1、在计算机中,安装两个CentOS系统2、[root@node1 etc]# ifconfig #查看ip192.168.241.128[root@node2 etc]# ifconfig192.168.241.1293、互ping[root@node1 etc]# ping 192.168.241.129 #测试网络是否联通 [root@node2 etc]# ping 192.168.241.1284、修改/etc/hosts文件,在节点设置节点名称192.168.241.128 node1192.168.241.129 node2[root@node1 etc]# source /etc/hosts[root@node2 etc]# source /etc/hosts5、各个节点是否互通[root@node1 etc]# ping node2 #测试主机名修改是否成功[root@node2 etc]# ping node16、关闭iptables防火墙[root@node1 etc]# serviceiptables stop[root@node2 etc]# serviceiptables stop在各个节点设置iptables 防火墙开机关闭[root@node1 usr]# chkconfigiptables off #设置iptables开机关闭 [root@node2 usr]# chkconfigiptables off #设置iptables开机关闭7、在各个节点创建共享目录[root@node1 etc]#mkdir /usr/cluster[root@node2 etc]#mkdir /usr/cluster在node1上修改/usr/cluster为777[root@node1 etc]#chmod –R 777 /usr/cluster8、挂在nfs文件系统/etc/exports文件配置在node1(主节点)节点配置[root@node1 etc]# vi /etc/exportsusr/cluster 192.168.241.128(rw)/usr/cluster 192.168.241.129(rw)启动nfs服务在node1节点执行[root@node1 usr]# yum install nfs-utilsrpcbind #安装nfs[root@node1 usr]# service rpcbind start #启动rpc[root@node1 usr]# service nfs start #启动nfs服务[root@node1 usr]# chkconfigrpcbind on #设置rpcbind开机启动[root@node1 usr]# chkconfignfs on #设置nfs开机启动在node2节点执行[root@node2 usr]# yum install nfs-utilsrpcbind #安装nfs[root@node2 usr]# service rpcbind start #启动服务[root@node2 usr]# service nfs start #启动nfs服务[root@node2 usr]# chkconfigrpcbind on #设置rpcbind开机启动[root@node2 usr]# chkconfignfs on #设置nfs开机启动9、查看服务器已有的共享目录查看node2的共享目录[root@node2 usr]# showmount -e 192.168.241.129Export list for 192.168.241.129:/usr/cluster 192.168.241.129,192.168.241.128挂在共享目录node2的共享目录挂在node1[root@node1 etc]# mount -t nfs 192.168.241.129:/usr/cluster /usr/cluster设置文件系统启动时自动挂载在node2的/etc/fstab文件下添加下边代码[root@node2 etc]# vi /etc/fstab192.168.241.128:/usr/cluster /usr/cluster nfsdefaults 0 010、配置ssh实现MPI节点的无密码登陆在各个节点上操作[root@node1 ~]# cd ~/.ssh/[root@node1 .ssh]# ssh-keygen -t rsa #一直按回车键会产生一个私钥id_rsa 和公钥id_rsa.pub[root@node2 ~]# cd ~/.ssh/[root@node2 .ssh]# ssh-keygen -t rsa #一直按回车键会产生一个私钥id_rsa 和公钥id_rsa.pub将各个节点的公钥合并到authorized_keys文件[root@node1 .ssh]# cat id_rsa.pub >>authorized_keys[root@node1 .ssh]# ssh root@node2 cat /root/.ssh/id_rsa.pub >>authorized_keys将authorized_keys拷贝到各个节点[root@node1 .ssh]# scpauthorized_keys root@node2:/root/.ssh/[root@node1 .ssh]# scpknown_hosts root@node2:/root/.ssh/无密钥测试[root@node1 .ssh]# ssh node2 #node1登陆到node2[root@node2 .ssh]# ssh node1 #node2登陆到node111、安装MPICH2(在各个节点都需要操作)将下载的mpich-3.2.tar.gz文件拷贝到/usr/src目录下[root@node2 src]# tar -zxvf mpich-3.2.tar.gz #解压文件[root@node2 src]# cd mpich-3.2配置安装路径最新版本mpich3的进程管理默认使用hydra[root@node2 mpich-3.2]# yum -y install gcc-c++ #安装c++编译器[root@node2 mpich-3.2]# mkdir /usr/cluster/mpich3 #创建mpich3目录[root@node2 mpich-3.2]# ./configure --prefix=/usr/cluster/mpich3/ --with-pm=hydra --disable-fortran #配置安装路径[root@node2 mpich-3.2]# make #编译[root@node2 mpich-3.2]# make install #安装在node1里执行[root@node1 ~]# vi .bashrc #添加mpich3的路径export PATH=$PATH:/usr/cluster/mpich3/bin[root@node1 ~]# source .bashrc #配置生效在node2里执行[root@node2 ~]# vi .bashrc #添加mpich3的路径export PATH=$PATH:/usr/cluster/mpich3/bin检测是否配置成功[root@node2 ~]# which mpicc #显示mpicc的路径[root@node2 ~]# which mpiexec #显示mpiexec的路径11、配置hostfile文件在当前用户主目录下建立并编辑配置文件hostfile。

将所有你允许访问本机进行并行计算的机器名填入,一行一个机器名,如果该机器上有两个CPU,就将它的名字加入两次,以此类型。

在node1上[root@node2 ~]# vihostfilenode1node2在node2上[root@node1 ~]# vihostfilenode1node212、执行测试使用mpich自带的例子,执行:[root@node2 bin]# mpiexec -n 6 -hostfile ~/hostfile /usr/src/mpich-3.2/examples/cpi Process 0 of 6 is on node1Process 2 of 6 is on node1Process 4 of 6 is on node1Process 1 of 6 is on node2Process 5 of 6 is on node2Process 3 of 6 is on node2pi is approximately 3.1415926544231243, Error is 0.0000000008333312wall clock time = 5.918241执行自己编写的程序[root@node2 ~]# vihello.c#include <stdio.h>#include "mpi.h"int main(intargc, char ** argv){intmyrank, nprocs, namelen;charprocessor_name[MPI_MAX_PROCESSOR_NAME];MPI_Init(&argc, &argv);MPI_Comm_size(MPI_COMM_WORLD, &nprocs);MPI_Comm_rank(MPI_COMM_WORLD, &myrank);MPI_Get_processor_name(processor_name, &namelen);printf("Hello World! I'm rank %d of %d on %s\n", myrank, nprocs, processor_name);MPI_Finalize();return 0;}编译命令:[root@node2 ~]# mpicc -o hello hello.c #编译[root@node2 ~]# mpirun -np 2 ./hello #运行Hello World! I'm rank 1 of 2 on node2Hello World! I'm rank 0 of 2 on node2挂载NFSServicenfs startMount –t nfs node1:/usr/cluster/usr/cluster/Which mpiccVim /etc/fstabChkconfignfs on编译:mpiccwho.c -o who执行:mpiexec -f /root/hostfile -np 6 ./who//所有个节点共运行6次mpiexec -np 6 ./who//一个节点运行6次mpirun -f /root/hostfile -np 6 ./whosublime建立过程:cd /opt/cd ./sublime_text./sublime_text重启网络Service network restart。