F R E A K 特 征 点 匹 配 算 法 介 绍 ( 2 0 2 0 )

基于特征点匹配的图像拼接方法

提取 , 则计 算 量 会 过 于 庞 大 。 为此 在 进 行 SF 提 IT 取 特 征前应 先将 彩 色图转 变为 灰度 图 , 即采用 公式

fr a geH ti,teeo e ma et e woi g s ihh v n l df rn e du t ov ri o m n l mar x h rfr , k h t ma e c a ea ge iee c js et wh f a t — cl h oigpa e ial , si iga jse woi g sa cr igS F n rjcinag — a s o t ln .F n l mo ac n du tdt n y k ma e codn I a dpoet lo T o

抽样一致性去粗 算法求得 两幅图像 间的 H 矩 阵初值 , 并运 用迭代精 炼算法求 出 H 矩阵的精确值 , 用摄像 头预 先 利

拍摄好 的固定角度 的 图像 来得 到转换角度的 H 矩 阵, 而将 均具有 角度 差的 两幅图像调 整至垂直拍摄 的平 面, 从 最 后根据尺度 不变特征 变换 匹配算法及投影算法将调 整后 的 两幅 图像拼 接 。实验表 明, 本方 法简单 易行 , 可降低 具 有 角度 差的两幅图像 拼接 后的边缘变形 , 而改善拼接 质量 。 从 关键词 : 尺度不变特征 变换 匹配算法; 图像拼 接 ; 影矩 阵; 投 投影 变形 中图分 类号 : P 5 . T 7 11 文献标识码 : A 文章编 号 :0 7 2 4 2 1 )1 0 8 —0 1 0 —3 6 (0 2 0 — 0 7 5

析 图像 中 的多种 不 变量 , 从 多 方 面进 行 限制 与 筛 并 选 , 而在选 择候 选 特征 点 时充 分 根据 配准 的需 要 进

基于sift特征的图像匹配算法

21 .特征点方向的确定

利用特征点邻域像素的的梯 度方 向分布特征 ,为每

一

个特征点指定方 向参数 ,使算子具有 尺度不变性 。

mx )√ + y L 一) + , 1 L , l ( = l) ( 1) ) (Y , , 一 x , , +一 x— 0x )o n OyO L , 1/ ( 1)三 一) ) 9 , = 2 , -(y )( x ,一 O 1) ( ) y t t a +  ̄ -)L + ,) ,

22 * 个种子 点 ,每个 种子 点8 方 向 ,共可生 产3 个数 个 2

二 、算 法 实现 和 实验 结果

实验算法采用V 2 0 开发 。结果如下 : C 08 第一 组实 验 ,上 图是 由下 图放大 而来 ,且 ±

光 照 强 度 。两 幅 图 中

的箭 头 方 向代 表 了该 像 素 点 的梯 度 方 向 ,

LxYo =G xY ) (,) ( ) (,, ) (, ,o Ix 2

SF 特征匹配算法是Dai L we 0 4 IT vdG.o 在2 0 年总结了

现有 的基于不变量特征检测技术的基 础上 ,提出的一种

基于尺度空 间的,对 图像缩放 、旋转甚至仿 射变换保持

不 变性 的 图像 局部特 征描述算 法 。SF 特征是 图像 局 IT

骤 :1 特征点 的检测 ;2特 征 向量 的生成 ;3特 征 向 . 是 . .

量的匹配。

尺度对应 于图像 的概貌特征 ,小尺度对应于图像 的细节

特征 。选择 合适 的尺度 因子平 滑是建 立 尺度空 间 的关 键 。在这里 ,主要是建立高斯金字塔和D G( i ee c O D f rn e

1 . .

第三章水文地质参数计算

内,s~t/r2曲线和W(u)~1/u标准曲线在形状上是相同的,只是

纵坐标平移了 Q 4T,横坐标平移了

* 。 4T

将二曲线重合,任选一匹配点,记下对应的坐标值,代入

Theis公式可求。

②具体步骤

在双对数坐标纸上绘制W(u)—1/u标准曲线。

在另一张模数相同的透明双对数纸上绘制实测的s—t/r2曲 线。

流计算。其降深s的计算公式为:

s

Q

2KM

r K0( B)

因为:r r B

B

对二式两边取对数,得:

lg

s

lg

k0

r B

lg

Q

2T

lg

r

lg

r B

lg

B

式中,lg Q 和 lg B是常数。曲线 lg s ~ lg r与曲线

2T

相似l,gk只0 是Br 坐~标lg Br平移了

lg

Q

2T

在另一张模数相同的透明双对数纸上绘制实测的 s—t曲线。

将实际曲线置于标准曲线上,在保持对应坐标轴彼 此平行的条件下相对平移,直至两曲线重合为止。

任取一配点(在曲线上或曲线外均可),记下匹配 点的对应坐标:W(u)、1/u、s、t,代入下式求参数:

T

Q

4 s

W

* 4T t

r

2

1 u

u

配线法的优点:

)

,

K M

T B2

B

§3-3 利用地下水动态资料确定 水文地质参数

利用地下水动态长期观测资料来确定水文地质参数 是一种比较经济的方法,并且确定参数的范围比前 者更为广泛,可以求出一些用抽水试验不能求得的 一些参数。

本节主要介绍给水度、降水入渗系数和潜水蒸发系 数的确定方法。

s k l e a r n 介 绍 ( 2 0 2 0 )

Sklearn_工具--2SKlearn介绍SKlearn介绍一.Python科学计算环境Final二.SKlearn算法库的顶层设计 1.SKlearn包含哪些模块 2.SKlearn六大板块统一API2.1API2.2sklearn监督学习工作流程2.2sklearn无监督学习工作流程2.3sklearn数据预处理工作流程 2.4SKlearn算法模块的学习顺序三.SKlearn数据集操作API1.自带小数据集1.1鸢尾花数据集1.2手写数字数据集:load_digits()1.3乳腺癌数据集:load_breast_cancer()1.4糖尿病数据集:load_diabetes()1.4波士顿房价数据集:load_boston()1.5体能训练数据集:load_linnerud()1.6图像数据集:load_sample_image(name)2.svmlight-libsvm格式的数据集3.可在线下载的数据集(Downloadable Dataset)3.1 20类新闻文本数据集3.2 野外带标记人脸数据集:fetch_lfw_people()-fetch_lfw_pairs()3.3Olivetti人脸数据集:fetch_olivetti_faces()3.4rcv1多标签数据集:fetch_rcv1()3.5Forest covertypes:预测森林表面植被类型4计算机生成的数据集 4.1用于分类任务和聚类任务的4.2make_multilabel_classification,多标签随机样本4.3用于回归任务的4.4用于流形学习的4.4用于因子分解的一.Py【现场实操追-女教-程】thon科学计算环境FinalScik【QQ】it-Image是专门用来处理图像的机器学习接口处理图【1】像的还有OpenCV,OpenCV使用c和c++写的,但是提供了py【О】thon接口,可以用python去调用二.SK【⒈】learn算法库的顶层设计科学包【6】是如何架构起来的1.S【⒐】Klearn包含哪些模块SKl【⒌】earn监督学习模块有15种SKle【2】arn无监督学习模块SKle【б】arn数据变换模块管道流pipline严格来说不是数据变换模块,pipline负责输出重定向,sklearn通过pipline可以将train,test,得分估计连成一个一长串的,方便整理代码。

基于SURF的特征点快速匹配算法

1 引 言

可 以大 大减 少 匹配 计 算 量 , 应 用 在 对 图像 处 理 实 时 性 要求 较 高 的光 电跟踪 系统 中具 有 明显 的优势 。 特征 匹配 的关 键在 于寻 找一 种较 好 的特征 描述 法 和特 征 匹配算 法 。就 点 特 征 而 言 , 目前 常见 的特 征点提 取 方 法 有 H a r r i s 特征 、 S U S A N特 征 、 S I F T特 征 等 I 4 。其 中 , D . G . L o w e提 出 的 S I T 特 征 由于 F 对 光照 、 旋转 、 尺 度 等 变换 具 有 不 变 性 , 受 到 了学 者 的广泛关 注 J , 但是 S I T 特 征需 要进 行 1 F 2 8维 的矢 量 特征运 算 , 在 高速 视 频 处 理 系 统 中实 时实 现 较 为 困难 。He r b e r t B a y等 提 出 的 S U R F特 征 在 S I F T的 基础 上 简 化 了 图像 金 字 塔 分 解 的操 作 _ 6 J 。类 似 于

中图分 类号 : T P 3 9 1 . 4 1 文献 标识 码 : A D OI : 1 0 . 3 9 6 9 / j . i s s n . 1 0 0 1 — 5 0 7 8 . 2 0 1 4 . 0 3 . 2 8

Fa s t f e a t u r e p o i n t ma t c h i ng a l g o r i t hm b a s e d o n S URF

・图像 与信 号处 理 ・

基于 S U R F的特 征 点 快 速 匹 配算 法

尧思 远 , 王晓明, 左 帅

( 华 北 光 电技 术 研 究 所 , 北京 1 0 0 0 1 5 )

C o r n e r N e t 算 法 解 读 ( 2 0 2 0 )

扫盲记-第五篇--图像全景分割全景分割(Panoptic Segmentation)在计算机视觉中,图像语义分割(Semantic Segmentation)的任务是预测每个像素点的语义类别;实例分割(Instance Segmentation)的任务是预测每个实例物体包含的像素区域。

全景分割(Panoptic Segmentation)最先由 FAIR 与德国海德堡大学联合提出,其任务是为图像中每个像素点赋予类别 Label 和实例 ID ,生成全局的、统一的分割图像。

CCV 2018 最受瞩目的 COCO + Mapillary 联合挑战赛也首次加入全景分割任务,是全景分割领域中最权威与具有挑战性的国际比赛,代表着当前计算机视觉识别技术最前沿。

在全景分割比赛项目中,旷视研究院Detection 组参与了COCO 比赛项目与 Mapillary 比赛项目,并以大幅领先第二名的成绩实力夺魁,在全景分割指标 PQ 上取得了0.532的成绩,超越了 human consistency ,另外,相关工作An End-to-End Network for Panoptic Segmentation发表于 CVPR 2019。

全景分割任务,下面这张思维导图有助于整体把握全景分割任务特性:全景分割解读思维导图本文介绍思路:首先,将分析全景分割任务的评价指标及基本特点,并介绍目前最新的研究进展;然后介绍发表于CVPR 2019 的工作Occlusion Aware Network (OANet),以及旷视研究院 Detection 组参与的 2018 COCO Panoptic Segmentation 比赛工作介绍;最后对全景分割当前研究进行总结与分析。

任务与前沿进展解读全景分割任务,从任务目标上可以分为object instance segmentation 子任务与 stuff segmentation 子任务。

M P 算 法 和 O M P 算 法 及 其 思 想 ( 2 0 2 0 )

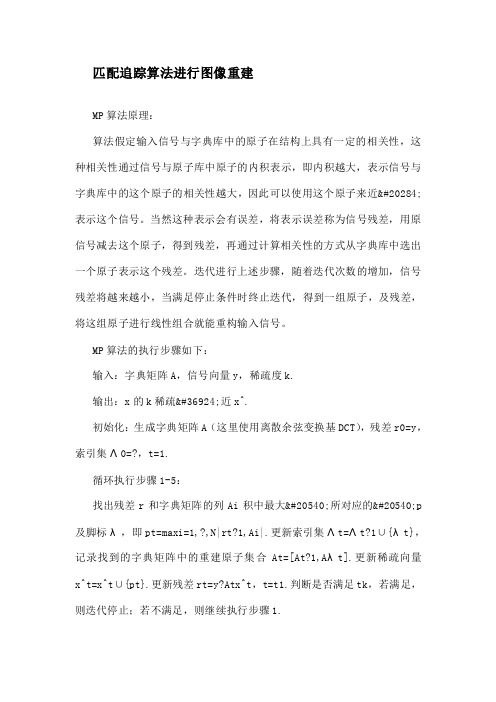

匹配追踪算法进行图像重建MP算法原理:算法假定输入信号与字典库中的原子在结构上具有一定的相关性,这种相关性通过信号与原子库中原子的内积表示,即内积越大,表示信号与字典库中的这个原子的相关性越大,因此可以使用这个原子来近似表示这个信号。

当然这种表示会有误差,将表示误差称为信号残差,用原信号减去这个原子,得到残差,再通过计算相关性的方式从字典库中选出一个原子表示这个残差。

迭代进行上述步骤,随着迭代次数的增加,信号残差将越来越小,当满足停止条件时终止迭代,得到一组原子,及残差,将这组原子进行线性组合就能重构输入信号。

MP算法的执行步骤如下:输入:字典矩阵A,信号向量y,稀疏度k.输出:x的k稀疏逼近x^.初始化:生成字典矩阵A(这里使用离散余弦变换基DCT),残差r0=y,索引集Λ0=?,t=1.循环执行步骤1-5:找出残差r和字典矩阵的列Ai积中最大值所对应的值p 及脚标λ,即pt=maxi=1,?,N|rt?1,Ai|.更新索引集Λt=Λt?1∪{λt},记录找到的字典矩阵中的重建原子集合At=[At?1,Aλt].更新稀疏向量x^t=x^t∪{pt}.更新残差rt=y?Atx^t,t=t1.判断是否满足tk,若满足,则迭代停止;若不满足,则继续执行步骤1.Python代码实现(针对二维图像):import numpy as npdef bmp(mtx, codebook, threshold):""":param mtx: 原始图像(mxn):param codebook: 字典(mxk):param threshold: 非零元素个数的最大值:return: 稀疏编码系数3 """n = mtx.shape[1] if len(mtx.shape) 1 else 1 # 原始图像mtx中向量的个数k = codebook.shape[1] # 字典dictionary中向量的个数result = np.zeros((k, n)) # 系数矩阵result中行数等于dictionary中向量的个数,列数等于mtx中向量的个数for i in range(n):indices = [] # 记录选中字典中原子的位置coefficients = [] # 存储系数向量residual = mtx[:, i]for j in range(threshold):projection = np.dot(codebook.T, residual)# 获取内积向量中元素绝对值的最大值max_value = projection.max()if abs(projection.min()) = abs(projection.max()):max_value = projection.min()pos = np.where(projection == max_value)[0]indices.append(pos.tolist()[0]) # 只存储在字典中的列(因为计算过程中对codebook进行了转置,所以这里取第一个元素) coefficients.append(max_value)residual = mtx[:, i] - np.dot(codebook[:, indices[0: j 1]], np.array(coefficients))if (residual ** 2).sum() 1e-6:for t, s in zip(indices, coefficients):result[t][i] = sreturn result基于MP的图像重建这样字典矩阵的行数就仅仅和分块矩阵的大小有关,和原始图像的大小没有关系了。

基于仿射变换的局部特征匹配算法

基于仿射变换的局部特征匹配算法戚海想【摘要】Aiming at the situation of the ASIFT algorithm where there areone-to-many, and many-to-one matching, and eventually leading to cor-rect matching are eliminated, proposes a local feature matching algorithm based on affine transformation (LMA). The method is based on the matching key point set under the ASIFT algorithm, in different local areasof an image, chooses three pairs of matching key point and calculates the corresponding affine transformation matrix, for every key point in the reference image, searches for matching key point by the nearest affine transformation matrix, and eliminate the matching key points which have bigger error in the matching key point set by the RANSAC algorithm. The experimental results show that by this kind of space constraint, improved algorithm can obviously increase the number of matching key points, atthe same time of ensuring high matching accuracy.%针对SIFT算法中存在一对多和多对一匹配,并最终导致正确匹配被剔除的情况,提出一种基于仿射变换的局部特征匹配算法(LMA)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

图像特征描述子之FREAK?在前【给力追-女生资-源】面的博文中,介绍的BRIEF、ORB、BRISK 算法都是基于特征点周围邻域像素点对之间的比较,形成二进制编码串作为特征【QQ】描述子,这种描述方法计算速度快,且占用内存小,满足一些实时【⒈】应用场景的需求。

对于这类特征描述子,关键是确定邻域哪些像【0】素点对进行比较,以及如何匹配。

BRIEF算法中特征点邻域的像素【1】点对是随机采样生成的,ORB算法是通过贪婪穷举的方法,在所有【6】可能的像素点对中选取相关性较小的若干点对,BRISK则是采用平【9】均采样的方法生成若干采样点。

特征匹配方法通常都是采样Ham【⒌】ming距离来进行度量,由于是二进制编码方式,可通过异或操作快速计【2】算。

特征点检【б】测?FAST算法可实现快速检测图像特征点,而且对应有一个加速版本AGAST,因此在诸多特征描述子中,都是首先通过FAST算法搜索定位特征点,再加以描述。

FREAK同BRISK算法类似,也是建立多尺度空间,在不同尺度的图像上使用FAST算法检测特征点。

采样模式?FREAK算法中采样模式接近于人眼视网膜接收图像信息的采样模型,如下图所示,人眼视网膜中,Fovea区域主要对高精度的图像信息进行处理,而Para区域则主要对低精度的图像信息进行处理。

在FREAK的采样模式中,图中每一个黑点代表一个采样点,每个圆圈代表一个感受野,每个采样点需进行高斯模糊处理,以降低噪声影响,感受野的半径表示高斯模糊的标准差。

这种采样模式与BRISK的不同之处在于,感受野之间存在重叠的区域;与BRIEF和ORB算法的不同之处在于,FREAK的采样点根据与特征点的距离远近,采用了不同大小的高斯核函数进行平滑处理。

不同大小的感受野在人眼视网膜中也存在类似的结构,通过重叠的感受野,可以获得更多的信息,使最终的描述符更具独特性和可区分性。

最终FREAK算法的采样结构为6、6、6、6、6、6、6、1,6代表每层中有6个采样点并且这6个采样点在一个同心圆上,一共有7个同心圆,最后的1表示特征点。

特征描述?FREAK算法同样采用二进制编码描述特征点,用FF表示编码特征F=Σ0≤aN2aT(Pa)F=Sigma_{0 leq a < N} 2^a T(P_a)T(Pa)={1,I(Pr1a)I(Pr2a) 0,otherwiseT(P_a) = begin{cases} 1,I(P_a^{r_1}) > I(P_a^{r_2}) 0,otherwise end{cases}式中,I(Pr1a)I(P_a^{r_1})表示采样点经过高斯模糊后的灰度值。

?FREAK的采样模式中一共有43个采样点,可以产生N=43(43?1)-2=903N = 43(43 - 1)-2 = 903个采样点对,有些采样点对的编码值对特征描述并没有实际作用,反而会造成特征冗余,因此需要对特征的描述向量进行筛选,也就是降维。

原论文中采用与ORB中类似的贪婪穷举的方法筛选采样点对。

- 对M(M=50000)M(M=50000)个特征点建立一个M×NM times N的矩阵DD,矩阵的每一行表示每个特征点的二进制描述符- 对矩阵的每一列,计算其均值。

由于DD中元素是0-1分布的,均值越接近0.5说明方差越大- 根据均值与0.5的距离从小到大,对矩阵的所有列重新排序(即按方差从大到小)- 选取前k(k=512)k(k=512)列作为最终的二进制描述符特征方向?FREAK描述子自身的圆形对称采样结构,在某种程度上使其具有旋转不变性;采样的位置和半径随着尺度的变化使其具有尺度不变性;对每个采样点进行高斯模糊,也具有一定的抗噪性能;像素点的强度对比生成二进制描述子使其具有光照不变性。

由此产生的二进制描述子可以用来进行特征匹配。

但是在匹配之前,可以进一步描述特征点的方向信息。

由于BRISK算法与FREAK算法对特征点邻域的采样模式相近,因此FREAK算法特征点方向的计算也与之类似。

BRISK算法是通过计算具有长距离的采样点对的梯度来表示特征点的方向,FREAK算法则采用其中45个距离长的、对称的采样点计算其梯度,如下图所示:梯度计算公式为O=1MΣPo∈G(I(Pr1o)?I(Pr2o))Pr1o?Pr2o||Pr1o?Pr2o||O = dfrac{1}{M} Sigma_{P_o in G} (I(P_o^{r_1}) - I(P_o^{r_2})) dfrac{P_o^{r_1} - P_o^{r_2}}{||P_o^{r_1} - P_o^{r_2}||}式中,OO表示特征点局部邻域梯度,MM表示采样点对的个数,GG表示采样点对集合,PoP_o表示采样点对的位置。

可根据梯度进一步求得特征点的主方向。

特征匹配?在特征描述中,得到了512bit的二进制描述符,该描述符的列是方差由高到低的排列,而高方差表征了模糊信息,低方差表征了细节信息,与人眼视网膜相似,人眼先处理的是模糊信息,再处理细节信息。

因此,选取前128bit即16bytes进行匹配,若两个待匹配的特征点前16bytes 距离小于设定的阈值,则再用剩余的比特位进行匹配。

第一步匹配可以剔除掉90%的不相关匹配点,这种级联的操作在很大程度上提高了匹配的速度。

Experiment Result#include opencv2-core-core.hpp#include opencv2-features2d-features2d.hpp#include opencv2-highgui-highgui.hpp#include opencv2-nonfree-features2d.hpp#include opencv2-legacy-legacy.hpp#include iostream#include vectorusing namespace cv;using namespace std;int main(void)string filename1 = "beaver1.png";string filename2 = "beaver2.png";Mat imgA_Freak = imread(filename1);Mat imgB_Freak = imread(filename2);vectorKeyPoint keypointsA_Freak, keypointsB_Freak;Mat descriptorsA_Freak, descriptorsB_Freak;vectorDMatch matches_Freak;-- DetectorSurfFeatureDetector detector_Freak(200, 4);-- DescriptorFREAK freak;-- MAatcherBruteForceMatcherHammingLUT matcher_Freak;detector_Freak.detect(imgA_Freak, keypointsA_Freak);detector_Freak.detect(imgB_Freak, keypointsB_Freak);pute(imgA_Freak, keypointsA_Freak, descriptorsA_Freak);pute(imgB_Freak, keypointsB_Freak, descriptorsB_Freak);matcher_Freak.match(descriptorsA_Freak, descriptorsB_Freak, matches_Freak);double max_dist = 0;double min_dist = 100;for (int i=0; idescriptorsA_Freak.rows; i++)double dist = matches_Freak[i].distance;if (dist min_dist) min_dist = dist;if(dist max_dist) max_dist = dist;vectorDMatch good_matches_Freak;for (int i=0; idescriptorsA_Freak.rows; i++)if(matches_Freak[i].distance 0.7*max_dist)good_matches_Freak.push_back(matches_Freak[i]);Mat imgMatch_Freak;drawMatches(imgA_Freak, keypointsA_Freak, imgB_Freak, keypointsB_Freak, good_matches_Freak, imgMatch_Freak, Scalar::all(-1), Scalar::all(-1),vectorchar(), DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS);imshow("matchFREAK", imgMatch_Freak);waitKey(0);return 0;从图示对比实验结果可以看出,ORB(上图左)的特征点匹配效果要好。

FREAK的突出特点在于将人眼视网膜的视觉机理引入了随机点对的采样模式,以及在特征匹配时采用Saccadic Search由粗到精的级联匹配方式,提高了特征匹配速度。

referencePaper: FREAK: Fast Retina Keypointdouble dist = matches_Freak[i].distance;dst(i,j)=dst(i,j)+sum(sum(abs(temp-mask)));int s_2_2 = l.getAgastScore(point.x + 1, point.y + 1, 1);既然FREAK算法是通过人眼的视觉系统得到启发提出的算法,那么我们首先来看看人眼的视觉系统。

A={(p?i?,p?j?)∈R?2?×R?2?|iN且ji且i,j∈N}?A={(pi,pj)∈R2×R2|iN且ji且i,j∈N}ptr2[0] = kp2[sub_des2].pt.x; ptr2[1] = kp2[sub_des2].pt.y;图像匹配能够应用的场合非常多,如目标跟踪,检测,识别,图像拼接等,而角点匹配最核心的技术就要属角点匹配了,所谓角点匹配是指寻找两幅图像之间的特征像素点的对应关系,从而确定两幅图像的位置关系。

?由于有N个采样点,则采样点两两组合成一对,共有N(N-1)-2钟组合方式,所有组合方式的集合称作采样点对,用集合表示,其中像素分别是、,δ表示尺度。