机器学习》16-实验二 手写体数字识别参考代码[3页]

手写数字识别实验项目

手写数字识别实验项目

手写数字识别实验项目是一个涉及机器学习和计算机视觉的有趣且实用的项目。

该项目的目标是训练一个模型来识别手写数字,使得计算机能够像人一样理解并识别这些数字。

在项目的开始阶段,我们首先需要收集大量的手写数字数据。

这通常可以通过扫描文档、使用在线数据集或从用户那里收集样本来实现。

一旦我们有了足够的数据,我们就可以开始预处理这些数据,包括图像清理、尺寸归一化和像素值标准化等步骤。

接下来,我们需要选择一个合适的机器学习模型来进行训练。

常用的模型包括支持向量机(SVM)、随机森林、神经网络等。

在这个项目中,我们通常会选择神经网络,特别是卷积神经网络(CNN),因为它们在图像识别任务中表现出色。

在训练模型的过程中,我们需要设置合适的超参数,如学习率、批量大小、迭代次数等,并使用交叉验证等技术来防止过拟合。

同时,我们还需要对模型进行调优,以提高其识别准确率和泛化能力。

一旦模型训练完成,我们就可以使用它来识别新的手写数字了。

用户可以通过扫描或拍照将手写数字输入到系统中,然后系统会使用训练好的模型对这些数字进行识别,并输出结果。

除了基本的数字识别功能外,我们还可以为这个项目添加一些额外的功能,如数字分类、数字排序等。

这些功能可以进一步扩展项目的应用场景,使其更加实用和有趣。

总的来说,手写数字识别实验项目是一个非常有意义的项目,它不仅可以帮助我们了解机器学习和计算机视觉的基本原理,还可以为我们提供实用的工具来解决现实生活中的问题。

手写数字识别代码解释

一. 进行数据预处理1导入相关库from keras.datasets import mnist 从keras的datasets中导入mnist数据集from keras.utils import np_utils 从keras导入将整型标签转换方法utilsimport numpy as np 导入Python扩充程序库numPy,作为np调用。

numPy支持大量的维度数组与矩阵运算,也针对数组运算提供大量的数学函数库。

np.random.seed(10)设置随机数种子为10 。

将随机数发生器初始化为恒定值,以获得可重复结果。

2.读取MNIST数据(X_train, y_train), (X_test, y_test) = mnist.load_data()返回手写图片的两个tuple,第一个tuple存储已经人工分类好的图片及标签,标签指出该图片表示的数字(0—9),供训练使用;第二个tuple存储未分类的图片,在用第一个tuple 训练完后,可以对第二个tuple利用神经网络进行分类,根据实验结果的真实值与预测值对比得到相应的损失值,再利用反向传播进行参数更新,再进行分类,然后重复前述步骤直至损失值最小。

元组不能修改reshape to be [samples][pixels][width][height]X_train = X_train.reshape(X_train.shape[0], 28, 28, 1).astype('float32')X_test = X_test.reshape(X_test.shape[0], 1, 28, 28).astype('float32')将fetures(数字图像特征值)转换(reshape)为6000 x 28 x 28 x 1的四维矩阵CNN的输入是4维的张量(可看做多维向量),第一维是样本规模(图像数量),第四维是像素通道(这里为1通道,单色),第二维和第三维是长度和宽度。

手写数字识别代码

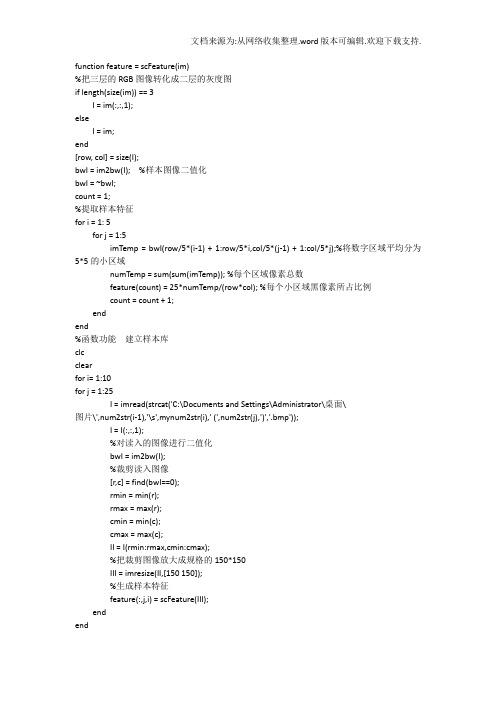

function feature = scFeature(im)%把三层的RGB图像转化成二层的灰度图if length(size(im)) == 3I = im(:,:,1);elseI = im;end[row, col] = size(I);bwI = im2bw(I); %样本图像二值化bwI = ~bwI;count = 1;%提取样本特征for i = 1: 5for j = 1:5imTemp = bwI(row/5*(i-1) + 1:row/5*i,col/5*(j-1) + 1:col/5*j);%将数字区域平均分为5*5的小区域numTemp = sum(sum(imTemp)); %每个区域像素总数feature(count) = 25*numTemp/(row*col); %每个小区域黑像素所占比例count = count + 1;endend%函数功能建立样本库clcclearfor i= 1:10for j = 1:25I = imread(strcat('C:\Documents and Settings\Administrator\桌面\图片\',num2str(i-1),'\s',mynum2str(i),' (',num2str(j),')','.bmp'));I = I(:,:,1);%对读入的图像进行二值化bwI = im2bw(I);%裁剪读入图像[r,c] = find(bwI==0);rmin = min(r);rmax = max(r);cmin = min(c);cmax = max(c);II = I(rmin:rmax,cmin:cmax);%把裁剪图像放大成规格的150*150III = imresize(II,[150 150]);%生成样本特征feature(:,j,i) = scFeature(III);endend%以结构体形式存储样本特征for i = 1:10pattern(i).num = 25;pattern(i).feature = feature(:,:,i);endsave myTemplet%函数功能降维function [y1,y2]=pcapro(sample)load myTemplet pattern;%加载样品库mixedsig=[];sum1=0;%将所有类别的所有样品合并到mixedsigfor i=1:10;sum1=sum1+ pattern(i).num;mixedsig=[mixedsig pattern(i).feature];end[Dim,NumofSampl]=size(mixedsig);%Dim为特征值NumofSampl为样品总个数dsig_cov=cov(mixedsig');%求协方差矩阵%利用pcacov()函数求的从小到大的排序好的协方差矩阵的特征值latent和相应特征向量pc[pc,latent,tspuare]=pcacov(dsig_cov);temp=0;con=0;m=0;%根据贡献率取舍特征向量sum2=sum(latent);for i=1:25if(con<0.9)temp=temp+latent(i);con=temp/sum2;m=m+1;elsebreak;endendpc(:,m+1:25)=[];%求待测样品主成分x=sample*pc;%求样本库品成分y=mixedsig'*pc;y1=y';y2=x';%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%函数名称bayesleasterror()%参数sample待识别样品特征%返回值y待识别样品所属类别%函数功能最小错误率概率的贝叶斯分类器%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% function y=bayesleasterror(sample)clc;load myTemplet pattern;%对样品库和待测样品进行主成分分析[pcapat,pcasamp]=pcapro(sample);temp=0;for i=1:10pattern(i).feature=pcapat(:,temp+1:temp+pattern(i).num);temp=temp+pattern(i).num;ends_cov=[];s_inv=[];s_det=[];for i=1:10s_cov(i).dat=cov(pattern(i).feature');%求各类别的协方差矩阵s_inv(i).dat=inv(s_cov(i).dat);%求协方差矩阵的逆矩阵s_det(i)=det(s_cov(i).dat);%求协方差矩阵的行列式endsum1=0;p=[];for i=1:10sum1=sum1+pattern(i).num;%求样品库样品总数endfor i=1:10p(i)=pattern(i).num/sum1;%求各类别的先验概率endh=[];mean_sap=[];for i=1:10mean_sap(i).dat=mean(pattern(i).feature')';%求每一类样品的特征值end%计算最大的判别函数for i=1:10h(i)=(pcasamp-mean_sap(i).dat)'*s_inv(i).dat*(pcasamp-mean_sap(i).dat)*(-0.5)+log(p(i))+ log(abs(s_det(i)))*(-0.5);end[maxval maxpos]=max(h);y=maxpos-1;%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %函数名称fisherclassify()%参数sample待识别样品特征class1 ,class2 :0-9中的任意两个类别%返回值classfit返回与样品sample最接近的类别%函数功能两类Fisher分类器%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%function classfit=fisherclassify(class1,class2,sample)load myTemplet pattern;%求两类样品均值向量m1=(mean(pattern(class1).feature'))';m2=mean(pattern(class2).feature')';%求两类样品类内离散度矩阵s1=cov(pattern(class1).feature')*(pattern(class1).num-1);s2=cov(pattern(class2).feature')*(pattern(class2).num-1);sw=s1+s2;%求总累间离散度矩阵sb=(m1-m2)*(m1-m2)';%求样品类间离散度矩阵w=inv(sw)*(m1-m2);%求w%求已知类别在w上的投影y1=w'*pattern(class1).feature;y2=w'*pattern(class2).feature;%求各类别样品在投影空间上的均值mean1=mean(y1');mean2=mean(y2');%求阈值y0y0=(pattern(class1).num*mean1+pattern(class2).num*mean2)/(pattern(class1).num+patter n(class1).num);%对于未知样本sample计算在w上的投影yy=w'*sample';%根据决策规则分类if y>y0classfit=class1;elseclassfit=class2;end%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%函数名称fisher()%参数sample待识别样品特征%返回值y待识别样品所属类别%函数功能Fisher分类器%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%function y=fisher(sample);clc;num=zeros(1,10);classnum=0;for i=1:10for j=1:iclassnum=fisherclassify(i,j,sample);num(classnum)=num(classnum)+1;endend[max_val,max_pos]=max(num);y=max_pos-1; %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %函数名称caijian()%函数功能对图像进行裁剪然后进行特征提取%参数读入图像I%返回值特征y %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% function y=caijian(I)I = I(:,:,1);%对读入的图像进行二值化bwI = im2bw(I);%裁剪读入图像[r,c] = find(bwI==0);rmin = min(r);rmax = max(r);cmin = min(c);cmax = max(c);II = I(rmin:rmax,cmin:cmax);%把裁剪图像放大成规格的150*150III = imresize(II,[150 150]);imshow(III)%生成特征y= scFeature(III);。

手写体数字识别

说明书手写体数字识别系统分为:图像数据的采集,图像预处理,特征抽取,分类识别和对识别结果进行统计几部分。

首先要将提前写好的数字转换成bmp格式的图片,将其导入,并将图像进行切分,即选中几个数并将其分成一个一个的。

然后对图像进行预处理,图像预处理就是将每一个数字进行灰度化处理、二值化处理、边缘检测、膨胀等处理。

然后分别对采集到的每一个数字图像进行特征提取,特征提取选用的方法是粗网格特征提取。

识别时用的是BP神经网络算法。

神经网络的原理是不断的对数据进行学习、训练,随着学习的不断进行,误差会越来越小。

完成后把上一步提取出来的特征用神经网络去识别。

图1系统整体设计准备一张手写数字的图片,首先要将其转换成MATLAB能识别的格式。

在本程序中将图片格式设为bmp格式。

进行图像采集的方法有两种,一种是先将数字图像导入到程序中,然后切分图像,得到一个一个的数字图像。

这样做主要是为了能够更方便快捷的进行预处理工作。

另一种方式则是先把图像做预处理,然后再进行数字的切分,这样做的好处是就省去了对多个图像进行预处理的繁琐过程,本软件的设计采用的是先分割图像再预处理的方法。

手写体数字识别的预处理过程主要分为:将每一个数字进行灰度化处理、二值化处理、边缘检测、膨胀等。

首先将彩色图像进行灰度化处理,得到灰度图像。

在灰度图像中,通常用0表示黑,255表示白,从0到255亮度逐渐增加,但是并没有色彩信息。

然后进行二值化处理得到二值化图像,即黑白图像。

就是图像像素只存在0,1两个灰度。

接着对图像进行边缘检测,边缘检测的目的是找出图像中亮度发生了巨大变化的点。

边缘检测可以减少数据量,去掉一些不相关的信息,加快运算速度,提高运行速率。

图像的膨胀的目的是扩大物体的边界,可以将断裂的部分连接起来,即使书写不准确补充完可以识别出来。

预处理对于系统的设计非常重要,预处理的好坏直接影响着识别结果。

经过预处理后的图像才能进行特征的提取,因此必须提高程序的预处理能力。

基于机器学习的手写体数字识别技术研究

基于机器学习的手写体数字识别技术研究随着数字化时代的到来,数字信息的处理已经成为一项必备的技能。

而现在,人工智能的加入又让数字信息处理变得更加轻松。

其中,机器学习技术被广泛应用于数字图像处理中,手写体数字识别技术也是其中的一个重要领域。

机器学习是一种以数据为中心的算法,可以让计算机自己学习,从而进行预测和决策。

而手写体数字识别技术正是利用机器学习技术对手写数字进行自动识别。

在机器学习的应用中,手写体数字识别技术算得上是一个很经典的例子。

它可以帮助人们把手写数字转化为计算机可以处理的数字化数据。

尤其是在一些需要对大量的手写数字进行处理的场景下,例如邮政编码、银行支票或者透过手写笔录入信息等领域,手写体数字识别技术可以极大地提高工作效率。

那么手写体数字识别的基本原理是什么呢?首先需要明白的是,计算机只能处理数字化信息。

而人们写的数字是以像素为基本单位的图片,因此首先需要将手写数字的图片转换为数字化数据。

以手写数字“0”为例,我们可以将其分割为若干像素点,每个像素点可以表示为0或1。

这样,一个手写数字的图片就可以被转换为一个数字矩阵,矩阵中每个元素表示该像素点的颜色值。

接下来,就需要对这些数字化的数据进行特征提取,以便分析数字的不同特征。

例如,在手写数字“0”的数字矩阵中,我们会发现它的中间是一个白色的圆形,周围围绕着黑色的边缘。

这些特征也可以被表示为数字化的数据。

通过特征提取,我们可以将数字矩阵转换为一组数字表示的特征向量。

在得到特征向量之后,就可以利用机器学习算法进行分类处理,并对不同的数字进行识别。

目前,常用的机器学习算法包括支持向量机(SVM)、神经网络、决策树等。

这些算法不仅可以对手写数字进行有效识别,还可以在遇到新的手写数字时进行自动学习和调整,提高识别的精度。

不过,手写体数字识别技术也存在着一些挑战与限制。

例如,不同人的手写风格可能存在着非常大的差异,这就需要技术能够在不同的人写的数字之间进行有效区分。

数据挖掘技术与应用:手写数字识别实训

实训内容

1. 导入必要的库。 2. 导入手写数字。 3. 以将数据转换为(样本,特征)矩阵。 4. 创建一个支持向量机分类器。 5. 取一半数据作为训练集。 6. 对剩余的数据进行预测。 7. 输出结果。

手写数字识别实现代码

导入数据包

from sklearn import datasets, svm, metrics

classifier = svm.SVC(gamma=0.001)

取一半数据作为训练集

classifier.fit(data[:n_samples // 2], digits.target[:n_samples // 2])

对剩余的数据进行预测

expected = digits.target[n_samples // 2:] predicted = classifier.predict(data[n_samples // 2:])

编辑器。

3. numpy、pandas、sklearn

实训数据

选取的数据集是由8x8的数字图像组成的,数据集 的images属性中的前4张图像。如果使用图像文件 ,则可以使用matplotlib.pyplot.imread加载它们。请 注意,每个图像必须具有相同的大小。对于这些 图像,需要指导它们代表哪个数字:它在数据集 的“目标”中给出。

digits = datasets.load_digits()

在对该数据应用分类器前,要将 展开图像,以将数据转换为(样

本,特征)矩阵:

n_samples = len(digits.images)

data = digits.images.reshape((n_samples, -1))

创建一个支持向量机分类器

手写体数字的识别

手写体数字的识别手写体数字识别第一章绪论 (4)1.1课题研究的意义 (4)1.2国内外究动态目前水平 (4)1.3手写体数字识别简介 (5)1.4识别的技术难点 (5)1.5主要研究工作 (6)第二章手写体数字识别基本过程: (6)2.1手写体数字识别系统结构 (6)2.2分类器设计 (7)2.2.1 特征空间优化设计问题 (7)2.2.2分类器设计准则 (8)2.2.3分类器设计基本方法 (9)3.4 判别函数 (9)3.5训练与学习 (10)第三章贝叶斯方法应用于手写体数字识别 (11)3.1贝叶斯由来 (11)3.2贝叶斯公式 (11)3.3贝叶斯公式Bayes决策理论: (12)3.4贝叶斯应用于的手写体数字理论部分: (16)3.4.1.特征描述: (16)3.4.2最小错误分类器进行判别分类 (17)第四章手写体数字识别的设计流程及功能的具体实现 (18) 4.1 手写体数字识别的流程图 (18)4.2具体功能实现方法如下: (19)结束语 (25)致谢词 (25)参考文献 (26)附录 (27)摘要数字识别就是通过计算机用数学技术方法来研究模式的自动处理和识别。

随着计算机技术的发展,人类对模式识别技术提出了更高的要求。

特别是对于大量己有的印刷资料和手稿,计算机自动识别输入己成为必须研究的课题,所以数字识别在文献检索、办公自动化、邮政系统、银行票据处理等方面有着广阔的应用前景。

对手写数字进行识别,首先将汉字图像进行处理,抽取主要表达特征并将特征与数字的代码存储在计算机中,这一过程叫做“训练”。

识别过程就是将输入的数字图像经处理后与计算机中的所有字进行比较,找出最相近的字就是识别结果。

本文主要介绍了数字识别的基本原理和手写的10个数字字符的识别系统的设计实现过程。

第一章介绍了数字识别学科的发展状况。

第二章手写体数字识别基本过程。

第三章贝叶斯方法应用于手写体数字识别。

第四章手写体数字识别的设计流程及功能的具体实现,并对实验结果做出简单的分析。

python实现手写数字识别(小白入门)

python实现手写数字识别(小白入门)要实现手写数字识别,可以使用机器学习库Scikit-learn和图像处理库OpenCV。

下面是一个简单的示例代码:```pythonimport cv2from sklearn import datasetsfrom sklearn.model_selection import train_test_splitfrom sklearn.neighbors import KNeighborsClassifier#加载手写数字数据集digits = datasets.load_digitsX = digits.images.reshape((len(digits.images), -1))y = digits.target#划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)#创建K近邻分类器knn = KNeighborsClassifier#训练分类器knn.fit(X_train, y_train)#从图像文件中读取手写数字图像image = cv2.imread('handwritten_digit.png',cv2.IMREAD_GRAYSCALE)#调整图像大小为8x8image = cv2.resize(image, (8, 8))#将图像转换为一维数组image = image.reshape(1, -1)#使用分类器进行预测prediction = knn.predict(image)print("预测结果:", prediction[0])```在这个示例中,首先使用`datasets.load_digits(`函数加载Scikit-learn库中的手写数字数据集。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

# encoding:utf-8

# 从sklearn.datasets里导入手写体数字加载器。

from sklearn.datasets import load_digits

# 从通过数据加载器获得手写体数字的数码图像数据

#并储存在digits变量中。

digits = load_digits()

# 检视数据规模和特征维度。

print(digits.data.shape)

#import matplotlib.pyplot as plt

#plt.gray()

#plt.matshow(digits.images[0])

#plt.show()

# 从sklearn.cross_validation中导入train_test_split用于数据分割。

from sklearn.model_selection import train_test_split

# 随机选取75%的数据作为训练样本;其余25%的数据作为测试样本。

X_train, X_test, y_train, y_test = train_test_split(\

digits.data, digits.target, test_size=0.25, random_state=33)

print(y_train.shape)

print(y_test.shape)

# 从sklearn.preprocessing里导入数据标准化模块。

from sklearn.preprocessing import StandardScaler

# 从仍然需要对训练和测试的特征数据进行标准化。

ss = StandardScaler()

X_train = ss.fit_transform(X_train)

X_test = ss.transform(X_test)

from sklearn.linear_model import LogisticRegression,SGDClassifier lgr = LogisticRegression()

lgr.fit(X_train, y_train)

lgr_predict = lgr.predict(X_test)

sgc = SGDClassifier()

sgc.fit(X_train, y_train)

sgc_predict = sgc.predict(X_test)

# 从sklearn.svm里导入基于线性假设的支持向量机分类器LinearSVC。

from sklearn.svm import LinearSVC,SVC,NuSVC

# 初始化线性假设的支持向量机分类器LinearSVC。

lsvc = LinearSVC(max_iter=3000)

#进行模型训练

lsvc.fit(X_train, y_train)

# 利用训练好的模型对测试样本的数字类别进行预测,

#预测结果储存在变量y_predict中。

lsvc_predict = lsvc.predict(X_test)

svc = SVC()

svc.fit(X_train, y_train)

svc_predict = svc.predict(X_test)

nusvc = NuSVC()

nusvc.fit(X_train, y_train)

nusvc_predict = nusvc.predict(X_test)

from sklearn.neighbors import KNeighborsClassifier

kneighbor = KNeighborsClassifier()

kneighbor.fit(X_train,y_train)

kneighbor_predict = kneighbor.predict(X_test)

from sklearn.naive_bayes import GaussianNB,BernoulliNB

gs = GaussianNB()

gs.fit(X_train,y_train)

gs_predict = gs.predict(X_test)

bnl = BernoulliNB()

bnl.fit(X_train,y_train)

bnl_predict = bnl.predict(X_test)

from sklearn.tree import DecisionTreeClassifier

dtc = DecisionTreeClassifier()

dtc.fit(X_train,y_train)

dtc_predict = dtc.predict(X_test)

from sklearn.ensemble import RandomForestClassifier

rfcc = RandomForestClassifier()

rfcc.fit(X_train,y_train)

rfcc_predict = rfcc.predict(X_test)

from sklearn.ensemble import GradientBoostingClassifier

gbcc = GradientBoostingClassifier()

gbcc.fit(X_train,y_train)

gbcc_predict = gbcc.predict(X_test)

from sklearn.metrics import classification_report

print('LogisticRegression',classification_report(y_test,

lgr_predict))

print('SGDClassifier',classification_report(y_test, sgc_predict)) print('LinearSVC',classification_report(y_test,

lsvc_predict))

print('SVC',classification_report(y_test,

svc_predict))

print('NuSVC',classification_report(y_test,

nusvc_predict))

print('KNeighbors',classification_report(y_test,

kneighbor_predict))

print('GaussianNB',classification_report(y_test,

gs_predict))

print('BernoulliNB',classification_report(y_test,

bnl_predict))

print('DecisionTreeClassifier',

classification_report(y_test,dtc_predict))

print('RandomForestClassifier',

classification_report(y_test,rfcc_predict))

print('GradientBoostingClassifier',

classification_report(y_test,gbcc_predict))。