数据挖掘_Standard & Poor's Home Price Index (1991-2009)(标准普尔房价指数(1991-2009))

数据标准化处理公式

数据标准化处理公式数据标准化是数据预处理的重要步骤,它可以将不同维度、不同量纲的数据转换为统一的标准数据,使得数据更易于比较和分析。

在实际应用中,我们常常会遇到需要对数据进行标准化处理的情况,因此掌握数据标准化处理公式是非常重要的。

本文将介绍几种常用的数据标准化处理公式,帮助读者更好地理解和运用数据标准化方法。

1. 最大-最小标准化(Min-Max Normalization)。

最大-最小标准化是一种线性变换方法,通过对原始数据进行线性变换,将数据映射到[0, 1]的范围内。

其公式如下:\[X_{norm} = \frac{X X_{min}}{X_{max} X_{min}}\]其中,\(X_{norm}\)为标准化后的数据,\(X\)为原始数据,\(X_{min}\)和\(X_{max}\)分别为原始数据的最小值和最大值。

2. Z-score标准化(Standard Score Normalization)。

Z-score标准化是一种常用的标准化方法,它将原始数据转换为均值为0,标准差为1的标准正态分布。

其公式如下:\[Z = \frac{X \mu}{\sigma}\]其中,\(Z\)为标准化后的数据,\(X\)为原始数据,\(\mu\)为原始数据的均值,\(\sigma\)为原始数据的标准差。

3. 小数定标标准化(Decimal Scaling Normalization)。

小数定标标准化是一种简单而有效的标准化方法,它通过移动数据的小数点位置来实现标准化。

其公式如下:\[X_{norm} = \frac{X}{10^j}\]其中,\(X_{norm}\)为标准化后的数据,\(X\)为原始数据,\(j\)为使得\(X_{norm}\)的绝对值最大的整数。

4. 独热编码标准化(One-Hot Encoding)。

独热编码是一种用于处理类别型数据的标准化方法,它将类别型数据转换为二进制向量表示。

数据挖掘基础

数据挖掘基础一、数据挖掘的概念和基本流程数据挖掘是指从大量数据中提取出有价值的信息和知识的过程,是一种自动化的发现模式和规律的方法。

其基本流程包括:数据预处理、特征选择、建立模型、模型评估和应用。

二、数据预处理1. 数据清洗:去除重复值、缺失值和异常值等。

2. 数据集成:将多个数据源中的数据合并成一个整体。

3. 数据变换:对原始数据进行转换,如归一化、离散化等。

4. 数据规约:对原始数据进行压缩,如抽样等。

三、特征选择特征选择是指从原始特征中选取一部分对分类或回归有用的特征。

其目的是减少维度,提高模型效率和精度。

四、建立模型建立模型是指根据已选取的特征,使用各种算法构建分类或回归模型。

常用算法包括决策树、神经网络、支持向量机等。

五、模型评估模型评估是指通过交叉验证等方法对建立好的模型进行评估,以确定其预测效果是否良好。

六、应用应用是指将建立好的模型应用到实际问题中,进行预测和决策。

七、数据挖掘的应用领域1. 金融:如信用评估、风险管理等。

2. 医疗:如疾病预测、药物研发等。

3. 零售业:如销售预测、客户细分等。

4. 航空航天:如飞机维修优化、航班调度等。

5. 电信业:如用户行为分析、网络优化等。

八、数据挖掘的常用算法1. 决策树算法:通过对数据进行分类和回归,构建决策树模型,可用于分类和预测。

2. 神经网络算法:通过模拟人类神经系统,构建神经网络模型,可用于分类和预测。

3. 支持向量机算法:通过寻找最大间隔超平面,构建支持向量机模型,可用于分类和回归。

4. 聚类算法:将数据分成若干个类别,常见的聚类算法包括K-Means 和层次聚类等。

5. 关联规则挖掘算法:通过寻找频繁项集和关联规则,发现数据中隐藏的关联关系。

九、数据挖掘的发展趋势1. 大数据时代:随着数据量的增加,数据挖掘将更加重要。

2. 人工智能:机器学习和深度学习等技术将广泛应用于数据挖掘中。

3. 可视化分析:通过可视化技术,更好地呈现和理解数据。

数据挖掘简介

数据挖掘简介数据挖掘简介2010-04-28 20:47数据挖掘数据挖掘(Data Mining)是采用数学、统计、人工智能和神经网络等领域的科学方法,从大量数据中挖掘出隐含的、先前未知的、对决策有潜在价值的关系、模式和趋势,并用这些知识和规则建立用于决策支持的模型,为商业智能系统服务的各业务领域提供预测性决策支持的方法、工具和过程。

数据挖掘前身是知识发现(KDD),属于机器学习的范畴,所用技术和工具主要有统计分析(或数据分析)和知识发现。

知识发现与数据挖掘是人工智能、机器学习与数据库技术相结合的产物,是从数据中发现有用知识的整个过程。

机器学习(Machine Learning)是用计算机模拟人类学习的一门科学,由于在专家系统开发中存在知识获取的瓶颈现象,所以采用机器学习来完成知识的自动获取。

数据挖掘是KDD过程中的一个特定步骤,它用专门算法从数据中抽取模式(Patterns)。

1996年,Fayyad、Piatetsky-Shapiror和Smyth将KDD过程定义为:从数据中鉴别出有效模式的非平凡过程,该模式是新的、可能有用的和最终可理解的;KDD是从大量数据中提取出可信的、新颖的、有效的,并能被人理解的模式的处理过程,这种处理过程是一种高级的处理过程。

数据挖掘则是按照既定的业务目标,对大量的企业数据进行探索,揭示隐藏其中的规律性,并进一步将其设计为先进的模型和有效的操作。

在日常的数据库操作中,经常使用的是从数据库中抽取数据以生成一定格式的报表。

KDD与数据库报表工具的区别是:数据库报表制作工具是将数据库中的某些数据抽取出来,经过一些数学运算,最终以特定的格式呈现给用户;而KDD则是对数据背后隐藏的特征和趋势进行分析,最终给出关于数据的总体特征和发展趋势。

报表工具能制作出形如"上学期考试未通过及成绩优秀的学生的有关情况"的表格;但它不能回答"考试未通过及成绩优秀的学生在某些方面有些什么不同的特征"的问题,而KDD就可以回答。

数据挖掘的算法逻辑-概述说明以及解释

数据挖掘的算法逻辑-概述说明以及解释1.引言1.1 概述数据挖掘是一种通过发现并提取隐藏在大量数据背后的有用信息和模式的方法。

在现代信息时代,我们面临着大量的数据积累,这些数据包含着宝贵的知识和见解。

然而,由于数据的庞大和复杂性,直接从中提取出有用的信息变得异常困难。

数据挖掘的出现为我们提供了解决这个难题的有力工具。

它通过应用统计学、人工智能和机器学习等方法,发掘数据中隐藏的模式和关联规则,帮助我们理解和解释数据,并从中获取有价值的信息。

通过数据挖掘,我们可以发现数据的潜在规律,预测未来的趋势,优化决策,改善业务流程以及提升绩效。

数据挖掘的算法逻辑是指实现数据挖掘任务所采用的算法和方法的逻辑过程。

它包含了一系列的步骤和技术,如数据预处理、特征选择、模型构建和评估等,旨在从海量的数据中提取有用的信息。

不同的数据挖掘算法逻辑在处理不同类型的数据和解决不同的问题时展现出不同的效果和性能。

本文将系统地介绍数据挖掘的算法逻辑。

首先,我们将回顾数据挖掘的基本概念,包括数据挖掘的定义、目标和应用领域等。

然后,我们将详细介绍数据挖掘的算法分类,将常用的数据挖掘算法按照不同的技术、任务和方法进行划分和分类。

最后,我们将深入探讨每种算法逻辑的具体实现过程和相应的应用示例,以加深对数据挖掘的算法逻辑的理解。

通过本文的阅读,读者将能够全面了解数据挖掘的算法逻辑,并掌握应用不同算法解决实际问题的能力。

同时,本文还将展望数据挖掘的未来发展趋势,并提出了进一步研究的方向和建议,以推动数据挖掘技术的不断创新和应用。

1.2 文章结构本文将围绕数据挖掘的算法逻辑展开详细的论述。

文章主要分为三个部分:引言、正文和结论。

引言部分将首先给出数据挖掘的概述,介绍数据挖掘的基本概念以及其在实际应用中的重要性。

接着,会对整篇文章的结构做出说明,为读者提供一个整体的概览。

最后,明确本文的目的,即通过介绍数据挖掘的算法逻辑,使读者对此有更深入的理解。

数据挖掘英语

数据挖掘英语随着信息技术和互联网的不断发展,数据已经成为企业和个人在决策和分析中不可或缺的一部分。

而数据挖掘作为一种利用大数据技术来挖掘数据潜在价值的方法,也因此变得越来越重要。

在这篇文章中,我们将会介绍数据挖掘的相关英语术语和概念。

一、概念1.数据挖掘(Data Mining)数据挖掘是一种从大规模数据中提取出有用信息的过程。

数据挖掘通常包括数据预处理、数据挖掘和结果评估三个阶段。

2.机器学习(Machine Learning)机器学习是一种通过对数据进行学习和分析来改善和优化算法的方法。

机器学习可以被视为是一种数据挖掘的技术,它可以用来预测未来的趋势和行为。

3.聚类分析(Cluster Analysis)聚类分析是一种通过将数据分组为相似的集合来发现数据内在结构的方法。

聚类分析可以用来确定市场细分、客户分组、产品分类等。

4.分类分析(Classification Analysis)分类分析是一种通过将数据分成不同的类别来发现数据之间的关系的方法。

分类分析可以用来识别欺诈行为、预测客户行为等。

5.关联规则挖掘(Association Rule Mining)关联规则挖掘是一种发现数据集中变量之间关系的方法。

它可以用来发现购物篮分析、交叉销售等。

6.异常检测(Anomaly Detection)异常检测是一种通过识别不符合正常模式的数据点来发现异常的方法。

异常检测可以用来识别欺诈行为、检测设备故障等。

二、术语1.数据集(Dataset)数据集是一组数据的集合,通常用来进行数据挖掘和分析。

2.特征(Feature)特征是指在数据挖掘和机器学习中用来描述数据的属性或变量。

3.样本(Sample)样本是指从数据集中选取的一部分数据,通常用来进行机器学习和预测。

4.训练集(Training Set)训练集是指用来训练机器学习模型的样本集合。

5.测试集(Test Set)测试集是指用来测试机器学习模型的样本集合。

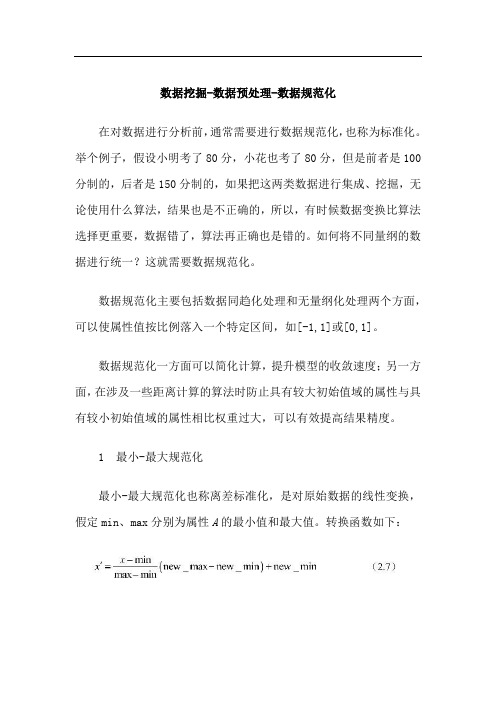

数据挖掘-数据预处理-数据规范化

数据挖掘-数据预处理-数据规范化在对数据进行分析前,通常需要进行数据规范化,也称为标准化。

举个例子,假设小明考了80分,小花也考了80分,但是前者是100分制的,后者是150分制的,如果把这两类数据进行集成、挖掘,无论使用什么算法,结果也是不正确的,所以,有时候数据变换比算法选择更重要,数据错了,算法再正确也是错的。

如何将不同量纲的数据进行统一?这就需要数据规范化。

数据规范化主要包括数据同趋化处理和无量纲化处理两个方面,可以使属性值按比例落入一个特定区间,如[-1,1]或[0,1]。

数据规范化一方面可以简化计算,提升模型的收敛速度;另一方面,在涉及一些距离计算的算法时防止具有较大初始值域的属性与具有较小初始值域的属性相比权重过大,可以有效提高结果精度。

1 最小-最大规范化最小-最大规范化也称离差标准化,是对原始数据的线性变换,假定min、max分别为属性A的最小值和最大值。

转换函数如下:将x转换到区间[new_min,new_max]中,结果为x′。

这种方法有一个缺陷就是当有新的数据加入时,可能导致max、min值的变化,需要重新定义。

另外,如果要做0-1规范化,式(2.7)可以简化为:【例2-11】表1中是某部分学生的数学和语文成绩,数学是100分制的,语文是150分制的,两组数据不在同一个量纲,需要对其进行最小-最大规范化。

表1 成绩表程序实现:在sklearn库中有个函数MinMaxScaler是专门进行最小-最大规范化的,会把原始数据投射到[0,1]范围内。

运行结果:结果分析:以姓名为胡建的学生为例,他的(数学,语文)成绩是(80,80),由于分制不同,所以直接比较是不正确的,经过最小-最大规范化后可以得出(数学,语文)成绩是(0.57142857,0),这样就可以比较得出该同学的数学成绩要比语文成绩好。

2 z-score规范化z-score规范化也称为标准差标准化,经过处理的数据符合标准正态分布,即平均值为0,标准差为1。

数据挖掘基础

在广义线性模型中,因变量Y 的变化速率是Y 均 值的一个函数;这一点与线性回归不同。常见的 广义线性模型有:对数回归和泊松回归。

对数回归模型是利用一些事件发生的概率作为自 变量所建立的线性回归模型。

泊松回归模型主要是描述数据出现次数的模型, 因为它们常常表现为泊松分布。

剪枝步:但Ck可能很大,这样所涉及的计算量就 很大。根据Apriori性质如果一个候选k-项集的(k1)-子集不在Lk-1中,则该候选也不可能是频繁的, 从而可以由Ck中删除。

Apriori性质(逆反描述):任何非频繁的(k-1)-项集 都不是可能是频繁k-项集的子集。

3.2 决策树

决策树学习是归纳推理算法。它是一种逼近离散 函数的方法,且对噪声数据有很好的健壮性。在 这种方法中学习到的知识被表示为决策树,决策 树也能再被表示为多个if-then的规则,以提高可 读性。

(4)可视化:将数据、知识和规则转化为图 形表现的形式。

1.6 数据仓库

(1)数据仓库是一个面向主题的、集成的、随时间变 化的、非易失性数据的集合,用于支持管理人员的 决策。

(2)数据仓库是一种多个异种数据源在单个站点以统 一的模式组织的存储,以支持管理决策。数据仓库 技术包括数据清理、数据集成和联机分析处理 (OLAP)。

1.7 数据仓库的模型

(1)星形模式:最常见模型;其中数据仓库包 括一个大的、包含大批数据、不含冗余的中心 表(事实表);一组小的附属表(维表),每 维一个。

(2)雪花模式:雪花模式是星型模式的变种, 其中某些维表是规范化的,因而把数据进一步 分解到附加的表中。

(3)星系模式:多个事实表共享维表。这种模 式可以看作星形模式集,因此称为星系模式, 或事实星座。

数据挖掘 填空题

1.知识发现是一个完整的数据分析过程,主要包括以下几个步骤:确定知识发现的目标、数据采集、数据探索、数据预处理、__数据挖掘_、模式评估。

2._特征性描述_是指从某类对象关联的数据中提取这类对象的共同特征(属性)。

3.回归与分类的区别在于:___回归__可用于预测连续的目标变量,___分类__可用于预测离散的目标变量。

4.__数据仓库_是面向主题的、集成的、相对稳定的、随时间不断变化的数据集合,与传统数据库面向应用相对应。

5.Pandas的两种核心数据结构是:__Series__和__DataFrame__。

6.我们可以将机器学习处理的问题分为两大类:监督学习和_无监督学习__。

7.通常,在训练有监督的学习的机器学习模型的时候,会将数据划分为__训练集__和__测试集__,划分比例一般为0.75:0.25。

1.分类问题的基本流程可以分为__训练__和__预测_两个阶段。

2.构建一个机器学习框架的基本步骤:数据的加载、选择模型、模型的训练、__模型的预测_、模型的评测、模型的保存。

3.__回归分析_是确定两种或两种以上变量间相互依赖关系的一种统计分析方法是应用及其广泛的数据分析方法之一。

4.在机器学习的过程中,我们将原始数据划分为训练集、验证集、测试集之后,可用的数据将会大大地减少。

为了解决这个问题,我们提出了__交叉验证_这样的解决办法。

5.当机器学习把训练样本学得“太好”的时候,可能已经把训练样本自身的一些特点当作所有潜在样本都会具有的一般性质,这样会导致泛化性能下降。

这种现象在机器学习中称为__过拟合__。

6.常用的降维算法有__主成分分析__、___因子分析__和独立成分分析。

7.关联规则的挖掘过程主要包含两个阶段__发现频繁项集_和__产生关联规则__1、数据仓库是一个(面向主题的)、(集成的)、(相对稳定的)、(反映历史变化)的数据集合,通常用于(决策支持的)目的2、如果df1=pd.DataFrame([[1,2,3],[NaN,NaN,2],[NaN,NaN,NaN],[8,8,NaN]]),则df1.fillna(100)=?([[1,2,3],[100,100,2],[100,100,100],[8,8,100]])3、数据挖掘模型一般分为(有监督学习)和(无监督学习)两大类4、如果df=pd.DataFrame({'key':['A','B','C','A','B','C','A','B','C'],'data':[0,5,10,5,10,15,10,15,20]}),则df.groupby('key').sum()=?(A:15,B:30,C:45)5、聚类算法根据产生簇的机制不同,主要分成(划分聚类)、(层次聚类)和(密度聚类)三种算法6、常见的数据仓库体系结构包括(两层架构)、(独立型数据集市)、(依赖型数据集市和操作型数据存储)、(逻辑型数据集市和实时数据仓库)等四种7、Pandas最核心的三种数据结构,分别是(Series)、(DataFrame)和(Panel)8、数据挖掘中计算向量之间相关性时一般会用到哪些距离?(欧氏距离、曼哈顿距离、切比雪夫距离、闵可夫斯基距离、杰卡德距离、余弦夹角、相关距离、汉明距离(答对3个即可))等9、在决策树算法中用什么指标来选择分裂属性非常关键,其中ID3算法使用(信息增益),C4.5算法使用(信息增益率),CART算法使用(基尼系数)10、OLAP的中文意思是指(在线分析处理)1、常见的数据仓库体系结构包括(两层架构)、(独立型数据集市)、(依赖型数据集市和操作型数据存储)、(逻辑型数据集市和实时数据仓库)等四种2、Pandas最核心的三种数据结构,分别是(Series)、(DataFrame)和(Panel)3、数据挖掘中计算向量之间相关性时一般会用到哪些距离?(欧氏距离、曼哈顿距离、切比雪夫距离、闵可夫斯基距离、杰卡德距离、余弦夹角、相关距离、汉明距离(答对3个即可))等4、在决策树算法中用什么指标来选择分裂属性非常关键,其中ID3算法使用(信息增益),C4.5算法使用(信息增益率),CART算法使用(基尼系数)5、OLAP的中文意思是指(在线分析处理)6、如果ser=pd.Series(np.arange(4,0,-1),index=["a","b","c","d"]),则ser.values二?([4,3,2,1]),ser*2=([&6,4,2])7、线性回归最常见的两种求解方法,一种是(最小二乘法),另一种是(梯度下降法)8、对于回归分析中常见的过拟合现象,一般通过引入(正则化)项来改善,最有名的改进算法包括(Ridge岭回归)和(Lasso套索回归)9、Python字符串str='HelloWorld!',print(str[-2])的结果是?(d)10、数据抽取工具ETL主要包括(抽取)、(清洗)、(转换)、(装载)1、数据挖掘中计算向量之间相关性时一般会用到哪些距离?(欧氏距离、曼哈顿距离、切比雪夫距离、闵可夫斯基距离、杰卡德距离、余弦夹角、相关距离、汉明距离(答对3个即可))等2、在决策树算法中用什么指标来选择分裂属性非常关键,其中ID3算法使用(信息增益),C4.5算法使用(信息增益率),CART算法使用(基尼系数)3、OLAP的中文意思是指(在线分析处理4、如果ser=pd.Series(np.arange(4,0,-1),index=["a","b","c","d"]),则ser.values二?([4,3,2,1]),ser*2=([&6,4,2])5、线性回归最常见的两种求解方法,一种是(最小二乘法),另一种是(梯度下降法)6、对于回归分析中常见的过拟合现象,一般通过引入(正则化)项来改善,最有名的改进算法包括(Ridge岭回归)和(Lasso套索回归)7、Python字符串str='HelloWorld!',print(str[-2])的结果是?(d)8、数据抽取工具ETL主要包括(抽取)、(清洗)、(转换)、(装载)9、CF是协同过滤的简称,一般分为基于(用户)的协同过滤和基于(商品)的协同过滤10、假如Li二[1,2,3,4,5,6],则Li[::-1]的执行结果是([6,5,4,3,2,1])1、数据仓库是一个(面向主题的)、(集成的)、(相对稳定的)、(反映历史变化)的数据集合,通常用于(决策支持的)目的2、如果df1=pd.DataFrame([[1,2,3],[NaN,NaN,2],[NaN,NaN,NaN],[8,8,NaN]]),则df1.fillna(100)=?([[1,2,3],[100,100,2],[100,100,100],[8,8,100]])3、数据挖掘模型一般分为(有监督学习)和(无监督学习)两大类4、如果df=pd.DataFrame({'key':['A','B','C','A','B','C','A','B','C'],'data':[0,5,10,5,10,15,10,15,20]}),则df.groupby('key').sum()=?(A:15,B:30,C:45)5、聚类算法根据产生簇的机制不同,主要分成(划分聚类)、(层次聚类)和(密度聚类)三种算法6、如果ser=pd.Series(np.arange(4,0,-1),index=["a","b","c","d"]),则ser.values二?([4,3,2,l]),ser*2=([&6,4,2])7、线性回归最常见的两种求解方法,一种是(最小二乘法),另一种是(梯度下降法)8、对于回归分析中常见的过拟合现象,一般通过引入(正则化)项来改善,最有名的改进算法包括(Ridge岭回归)和(Lasso套索回归)9、Python字符串str='HelloWorld!',print(str[-2])的结果是?(d)10、数据抽取工具ETL主要包括(抽取)、(清洗)、(转换)、(装载)1、数据仓库是一个(面向主题的)、(集成的)、(相对稳定的)、(反映历史变化)的数据集合,通常用于(决策支持的)目的2、数据挖掘模型一般分为(有监督学习)和(无监督学习)两大类3、聚类算法根据产生簇的机制不同,主要分成(划分聚类)、(层次聚类)和(密度聚类)三种算法4、Pandas最核心的三种数据结构,分别是(Series)、(DataFrame)和(Panel)5、在决策树算法中用什么指标来选择分裂属性非常关键,其中ID3算法使用(信息增益),C4.5算法使用(信息增益率),CART算法使用(基尼系数)6、如果ser=pd.Series(np.arange(4,0,-1),index=["a","b","c","d"]),则ser.values二?([4,3,2,1]),ser*2=([&6,4,2])7、对于回归分析中常见的过拟合现象,一般通过引入(正则化)项来改善,最有名的改进算法包括(Ridge岭回归)和(Lasso套索回归)8、数据抽取工具ETL主要包括(抽取)、(清洗)、(转换)、(装载)9、CF是协同过滤的简称,一般分为基于(用户)的协同过滤和基于(商品)的协同过滤10、假如Li二[1,2,3,4,5,6],则Li[::-1]的执行结果是([6,5,4,3,2,1])1如果dfl二pd.DataFrame([[l,2,3],[NaN,NaN,2],[NaN,NaN,NaN],[&&NaN]]), 则dfl.fillna(100)=?([[l,2,3],[100,100,2],[100,100,100],[8,8,100]])2、如果df=pd.DataFrame({'key':['A','B','C','A','B','C','A','B','C'],'data':[0,5,10,5,10,15,10 ,15,20]})则df.groupby('key').sum()=?(A:15,B:30,C:45)3、常见的数据仓库体系结构包括(两层架构)、(独立型数据集市)、(依赖型数据集市和操作型数据存储)、(逻辑型数据集市和实时数据仓库)等四种4、数据挖掘中计算向量之间相关性时一般会用到哪些距离?(欧氏距离、曼哈顿距离、切比雪夫距离、闵可夫斯基距离、杰卡德距离、余弦夹角、相关距离、汉明距离(答对3个即可))等5、OLAP的中文意思是指(在线分析处理)6、线性回归最常见的两种求解方法,一种是(最小二乘法),另一种是(梯度下降法)7、Python字符串str='HelloWorld!',print(str[-2])的结果是?(d)8、数据抽取工具ETL主要包括(抽取)、(清洗)、(转换)、(装载)9、CF是协同过滤的简称,一般分为基于(用户)的协同过滤和基于(商品)的协同过滤10、假如Li二[1,2,3,4,5,6],则Li[::-1]的执行结果是([6,5,4,3,2,1])1、数据挖掘模型一般分为(有监督学习)和(无监督学习)两大类2、聚类算法根据产生簇的机制不同,主要分成(划分聚类)、(层次聚类)和(密度聚类)三种算法3、常见的数据仓库体系结构包括(两层架构)、(独立型数据集市)、(依赖型数据集市和操作型数据存储)、(逻辑型数据集市和实时数据仓库)等四种4、数据挖掘中计算向量之间相关性时一般会用到哪些距离?(欧氏距离、曼哈顿距离、切比雪夫距离、闵可夫斯基距离、杰卡德距离、余弦夹角、相关距离、汉明距离(答对3个即可))等5、如果ser=pd.Series(np.arange(4,0,-1),index=["a","b","c","d"]),则ser.values二?([4,3,2,l]),ser*2=([8,6,4,2])6、对于回归分析中常见的过拟合现象,一般通过引入(正则化)项来改善,最有名的改进算法包括(Ridge岭回归)和(Lasso套索回归)7、Python字符串str='HelloWorld!',print(str[-2])的结果是?(d)8、数据抽取工具ETL主要包括(抽取)、(清洗)、(转换)、(装载)9、CF是协同过滤的简称,一般分为基于(用户)的协同过滤和基于(商品)的协同过滤10、假如Li二[1,2,3,4,5,6],则Li[::-1]的执行结果是([6,5,4,3,2,1])1、数据仓库是一个(面向主题的)、(集成的)、(相对稳定的)、(反映历史变化)的数据集合,通常用于(决策支持的)目的2、如果df=pd.DataFrame({'key':['A','B','C','A','B','C','A','B','C'],'data':[0,5,10,5,10,15,10,15,20]})则df.groupby('key').sum()=?(A:15,B:30,C:45)3、数据挖掘中计算向量之间相关性时一般会用到哪些距离?(欧氏距离、曼哈顿距离、切比雪夫距离、闵可夫斯基距离、杰卡德距离、余弦夹角、相关距离、汉明距离(答对3个即可))等4、在决策树算法中用什么指标来选择分裂属性非常关键,其中ID3算法使用(信息增益),C4.5算法使用(信息增益率),CART算法使用(基尼系数)5、OLAP的中文意思是指(在线分析处理)6、如果ser=pd.Series(np.arange(4,0,-1),index=["a","b","c","d"]),则ser.values二?([4,3,2,1]),ser*2=([&6,4,2])7、线性回归最常见的两种求解方法,一种是(最小二乘法),另一种是(梯度下降法)8、对于回归分析中常见的过拟合现象,一般通过引入(正则化)项来改善,最有名的改进算法包括(Ridge岭回归)和(Lasso套索回归)9、数据抽取工具ETL主要包括(抽取)、(清洗)、(转换)、(装载)10、CF是协同过滤的简称,一般分为基于(用户)的协同过滤和基于(商品)的协同过滤。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Standard & Poor's Home Price Index (1991-2009)(标

准普尔房价指数(1991-2009))

数据摘要:

The S&P/Case-Shiller Home Price Index measures the residential housing market, tracking changes in the value of the residential real estate market in about 20 metropolitan regions across the United States. These indices use the repeat sales pricing technique to measure housing markets. First developed by Karl Case and Robert Shiller, this methodology collects data on single-family home re-sales, capturing re-sold sale prices to form sale pairs. This index family consists of 20 regional indices and two composite indices as aggregates of the regions.

中文关键词:

数据挖掘,美国,标准,普尔房价指数,1991-2009,SOCR,

英文关键词:

Data mining,USA,Standard,Poor Home Price

Index,1991-2009,SOCR,

数据格式:

TEXT

数据用途:

The data can be used for data mining and analysis.

数据详细介绍:

Standard & Poor's Home Price Index

(1991-2009)

∙Abstract

The S&P/Case-Shiller Home Price Index measures the residential housing market, tracking changes in the value of the residential real estate market in about 20 metropolitan regions across the United States.

These indices use the repeat sales pricing technique to measure housing markets. First developed by Karl Case and Robert Shiller, this methodology collects data on single-family home re-sales, capturing re-sold sale prices to form sale pairs. This index family consists of 20 regional indices and two composite indices as aggregates of the regions.

∙Data Description

The S&P/Case-Shiller Home Price Indices are calculated monthly and published with a two month lag. New index levels are released at 9am Eastern Standard Time on the last Tuesday of every month.

In addition, the S&P/Case-Shiller U.S. National Home Price Index is a broader composite of single-family home price indices for the nine U.S.

Census divisions and is calculated quarterly.

Note: The S&P/Case Shiller Indices are calculated by Fiserv, Inc. In addition, Fiserv also offers indices covering thousands of zip codes and metro areas using the Case-Shiller methodology. For more information

regarding Fiserv’s products, please call Fiserv Customer Support at 877-279-2272.

This index is maintained by an Index Committee, whose members include Standard & Poor's, Fiserv and leading industry experts. It follows a set of published guidelines and policies that provide the transparent methodologies used to maintain the index.

Definitions: Columns and rows in this table include:

Metropolitan Areas: AZ-Phoenix, CA-LosAngeles, CA-SanDiego, CA-SanFrancisco, CO-Denver, DC-Washington, FL-Miami, FL-Tampa, GA-Atlanta, IL-Chicago, MA-Boston, MI-Detroit, MN-Minneapolis, NC-Charlotte, NV-LasVegas, NY-NewYork, OH-Cleveland, OR-Portland, WA-Seattle.

Years: 1991-2009 (monthly)

Reference

数据预览:

点此下载完整数据集。