浅谈简单线性回归模型与对数线性回归模型的选择

线性与对数模型比较分析

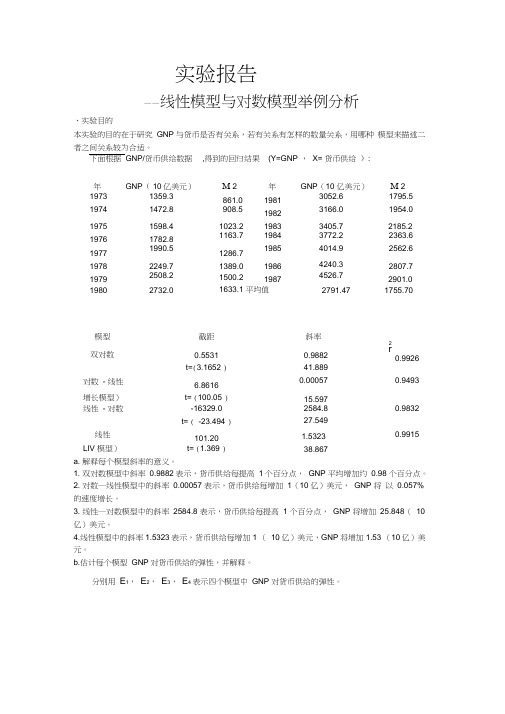

实验报告——线性模型与对数模型举例分析、实验目的本实验的目的在于研究GNP 与货币是否有关系,若有关系有怎样的数量关系,用哪种模型来描述二者之间关系较为合适。

下面根据GNP/货币供给数据,得到的回归结果(Y=GNP ,X= 货币供给):年GNP( 10亿美元)M 2 年GNP(10 亿美元)M 2 1973 1359.3 861.0 1981 3052.6 1795.5 1974 1472.8 908.519823166.0 1954.0 1975 1598.4 1023.2 1983 3405.7 2185.2 1976 1782.8 1163.7 1984 3772.2 2363.61977 1990.51286.71985 4014.9 2562.61978 2249.7 1389.0 1986 4240.3 2807.7 1979 2508.2 1500.2 1987 4526.7 2901.0 1980 2732.0 1633.1 平均值2791.47 1755.70模型截距斜率2r0.9926双对数0.5531 0.9882t=(3.1652 )41.889对数- 线性 6.8616 0.00057 0.9493 增长模型)t= (100.05 )15.597线性- 对数-16329.0 2584.8 0.9832t= ( -23.494 )27.549线性101.20 1.5323 0.9915 LIV 模型)t= (1.369 )38.867a. 解释每个模型斜率的意义。

1. 双对数模型中斜率0.9882表示,货币供给每提高1个百分点,GNP 平均增加约0.98 个百分点。

2. 对数―线性模型中的斜率0.00057 表示,货币供给每增加1(10 亿)美元,GNP 将以0.057% 的速度增长。

3. 线性―对数模型中的斜率2584.8 表示,货币供给每提高1 个百分点,GNP 将增加25.848(10 亿)美元。

各种线性回归模型原理

各种线性回归模型原理线性回归是一种用于建立和预测变量之间线性关系的统计模型。

它的原理基于以下假设:1.线性关系假设:线性回归假设自变量和因变量之间存在线性关系。

这意味着因变量可以通过自变量的线性组合来预测。

2.单一解释变量:线性回归模型只能处理一个自变量。

如果有多个自变量,可以使用多元线性回归模型。

3.常态分布假设:线性回归假设误差项服从正态分布。

这意味着对于任意给定的自变量值,因变量值的分布应该是一个正态分布。

基于以上假设,线性回归模型可以采用最小二乘法来估计参数。

最小二乘法的目标是最小化观测值与模型预测值之间的残差平方和。

最简单的线性回归模型是一元线性回归模型,它可以用以下方程表示:Y=β0+β1*X+ε其中,Y是因变量,X是自变量,β0和β1是回归系数,ε是误差项。

一元线性回归模型可以通过最小二乘法来估计回归系数。

最小二乘法的目标是找到使得残差平方和最小的β0和β1值。

除了一元线性回归模型,还有其他几种常见的线性回归模型:1.多元线性回归模型:可以处理多个自变量的线性回归模型。

它可以用以下方程表示:Y=β0+β1*X1+β2*X2+...+βn*Xn+ε2.多项式回归模型:通过添加自变量的高次项来捕捉非线性关系。

多项式回归模型可以用以下方程表示:Y=β0+β1*X+β2*X^2+...+βn*X^n+ε3.对数线性回归模型:对响应变量或自变量取对数后,拟合线性回归模型。

它可用于处理响应变量和自变量之间的指数关系。

4.加权线性回归模型:对不同数据点赋予不同的权重,通过加权的最小二乘法来估计回归系数。

这可以用来处理数据点的不同可信度和影响力。

5.弹性网络回归模型:结合L1和L2惩罚项的线性回归模型。

它可以用来处理具有高维特征和冗余特征的数据集。

6.岭回归模型:引入L2惩罚项来控制回归系数的大小,防止过拟合。

除了这些常见的线性回归模型,还有许多其他的改进和扩展模型,用于不同类型的数据和问题。

线性回归模型是统计学和机器学习中最常见和基础的模型之一,可以广泛应用于各个领域和问题的预测和分析中。

各种线性回归模型原理

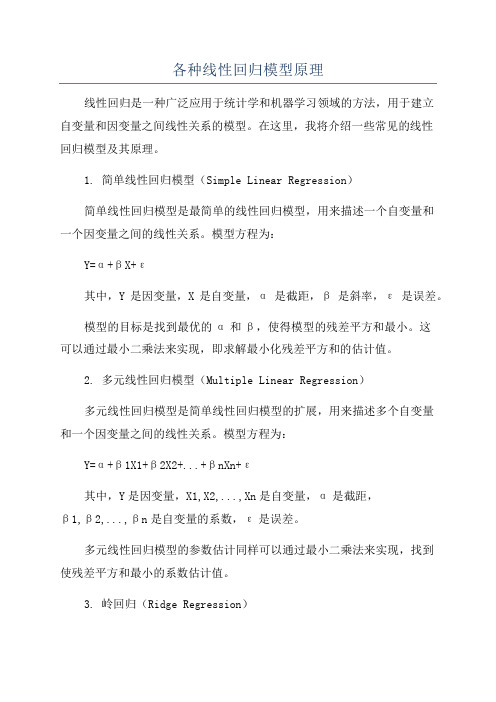

各种线性回归模型原理线性回归是一种广泛应用于统计学和机器学习领域的方法,用于建立自变量和因变量之间线性关系的模型。

在这里,我将介绍一些常见的线性回归模型及其原理。

1. 简单线性回归模型(Simple Linear Regression)简单线性回归模型是最简单的线性回归模型,用来描述一个自变量和一个因变量之间的线性关系。

模型方程为:Y=α+βX+ε其中,Y是因变量,X是自变量,α是截距,β是斜率,ε是误差。

模型的目标是找到最优的α和β,使得模型的残差平方和最小。

这可以通过最小二乘法来实现,即求解最小化残差平方和的估计值。

2. 多元线性回归模型(Multiple Linear Regression)多元线性回归模型是简单线性回归模型的扩展,用来描述多个自变量和一个因变量之间的线性关系。

模型方程为:Y=α+β1X1+β2X2+...+βnXn+ε其中,Y是因变量,X1,X2,...,Xn是自变量,α是截距,β1,β2,...,βn是自变量的系数,ε是误差。

多元线性回归模型的参数估计同样可以通过最小二乘法来实现,找到使残差平方和最小的系数估计值。

3. 岭回归(Ridge Regression)岭回归是一种用于处理多重共线性问题的线性回归方法。

在多元线性回归中,如果自变量之间存在高度相关性,会导致参数估计不稳定性。

岭回归加入一个正则化项,通过调节正则化参数λ来调整模型的复杂度,从而降低模型的过拟合风险。

模型方程为:Y=α+β1X1+β2X2+...+βnXn+ε+λ∑βi^2其中,λ是正则化参数,∑βi^2是所有参数的平方和。

岭回归通过最小化残差平方和和正则化项之和来估计参数。

当λ=0时,岭回归变为多元线性回归,当λ→∞时,参数估计值将趋近于0。

4. Lasso回归(Lasso Regression)Lasso回归是另一种用于处理多重共线性问题的线性回归方法,与岭回归不同的是,Lasso回归使用L1正则化,可以使得一些参数估计为0,从而实现特征选择。

回归分析线性回归Logistic回归对数线性模型【精选】

50 .7 58 ** . 0 00

50 1 . 00 0

. 50

7

定量变量的线性回归分析

• 对例1中的两个变量的数据进行线性回归,就是要找到一条直线 来最好地代表散点图中的那些点。

y 0 1x

100

90

80

70

S1

60

50

y 26.44 0.65x

Si g. (2-tai l ed)

.

N

50

s1

Correl ati on Coeffi ci ent

.5 95 **

Si g. (2-tai l ed)

. 0 00

Spearman's rho j 3

N Correl ati on Coeffi ci ent

50 1 . 00 0

Si g. (2-tai l ed)

.

N

50

s1

Correl ati on Coeffi ci ent

Si g. (2-tai l ed)

.7 58 ** . 0 00

N

50

**. Correl ati on i s si gnifi cant at the 0.01 l evel (2-tai l ed).

s1 .5 95 ** . 0 00 50

• 不算序号和(192个)国家有21个变量 • 包括地区(Region)、(在城镇和乡村)使用干净水的

%、生活污水处理的%、饮酒量 (litre/yearperson)、(每万人中)内科医生数目、护 士和助产士数、卫生工作者数、病床数、护士助产 士和内科医生之比、卫生开支占总开支的%、占政 府开支的%、人均卫生开支$、成人识字率、人均 收入$、每千个出生中5岁前死亡人数、人口增长率 %、(男女的)预期寿命(年)、每10万生育的母亲死 亡数

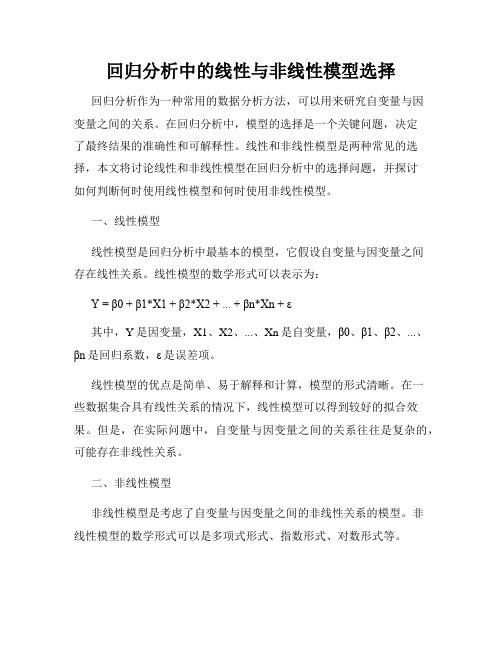

回归分析中的线性与非线性模型选择

回归分析中的线性与非线性模型选择回归分析作为一种常用的数据分析方法,可以用来研究自变量与因变量之间的关系。

在回归分析中,模型的选择是一个关键问题,决定了最终结果的准确性和可解释性。

线性和非线性模型是两种常见的选择,本文将讨论线性和非线性模型在回归分析中的选择问题,并探讨如何判断何时使用线性模型和何时使用非线性模型。

一、线性模型线性模型是回归分析中最基本的模型,它假设自变量与因变量之间存在线性关系。

线性模型的数学形式可以表示为:Y = β0 + β1*X1 + β2*X2 + ... + βn*Xn+ ε其中,Y是因变量,X1、X2、...、Xn是自变量,β0、β1、β2、...、βn是回归系数,ε是误差项。

线性模型的优点是简单、易于解释和计算,模型的形式清晰。

在一些数据集合具有线性关系的情况下,线性模型可以得到较好的拟合效果。

但是,在实际问题中,自变量与因变量之间的关系往往是复杂的,可能存在非线性关系。

二、非线性模型非线性模型是考虑了自变量与因变量之间的非线性关系的模型。

非线性模型的数学形式可以是多项式形式、指数形式、对数形式等。

在回归分析中,选择合适的非线性模型是一个挑战。

一种常见的方法是通过观察自变量与因变量的散点图来判断是否需要使用非线性模型。

如果散点图呈现出明显的非线性趋势,那么使用非线性模型可能会得到更好的拟合效果。

此外,可以使用统计方法来判断是否需要使用非线性模型,例如利用残差分析、F检验、信息准则等。

三、线性与非线性模型的选择在实际应用中,选择线性模型还是非线性模型需要综合考虑多个因素。

以下是一些建议:1. 数据的线性性:观察数据集合自变量与因变量的散点图,判断是否存在明显的非线性趋势。

如果散点图呈现出明显的非线性关系,那么考虑使用非线性模型。

2. 拟合效果:比较线性模型和非线性模型的拟合效果。

可以使用拟合优度指标(如R方值)来评估模型的拟合程度,选择拟合效果较好的模型。

3. 解释性:考虑模型的解释性和可解释性。

SPSS专题2 回归分析(线性回归、Logistic回归、对数线性模型)

19

Correlation s lif e_ expectanc y _ f emale(y ear) .503** .000 164 1.000 . 192 .676**

cleanwateraccess_rura... life_expectancy_femal... Die before 5 per 1000

Model 1 2

R .930

a

R Square .866 .879

Model 1

df 1 54 55 2 53 55

Regres sion Residual Total Regres sion Residual Total

Mean Square 54229.658 155.861 27534.985 142.946

2

回归分析 • 一旦建立了回归模型 • 可以对各种变量的关系有了进一步的定量理解 • 还可以利用该模型(函数)通过自变量对因变量做 预测。 • 这里所说的预测,是用已知的自变量的值通过模型 对未知的因变量值进行估计;它并不一定涉及时间 先后的概念。

3

例1 有50个从初中升到高中的学生.为了比较初三的成绩是否和高中的成绩 相关,得到了他们在初三和高一的各科平均成绩(数据:highschool.sav)

50名同学初三和高一成绩的散点图

100

90

80

70

60

高 一成 绩

50

40 40

从这张图可以看出什么呢?

50 60 70 80 90 100 110

4

初三成绩

还有定性变量 • 该数据中,除了初三和高一的成绩之外,还有 一个定性变量 • 它是学生在高一时的家庭收入状况;它有三个 水平:低、中、高,分别在数据中用1、2、3 表示。

回归分析线性回归Logistic回归对数线性模型

逻辑回归的模型为 (P(Y=1) = frac{1}{1+e^{-z}}),其中 (z = beta_0 + beta_1X_1 + beta_2X_2 + ... + beta_nX_n)。

逻辑斯蒂函数

பைடு நூலகம்

定义

逻辑斯蒂函数是逻辑回归模型中用来描述自变量与因变量之 间关系的函数,其形式为 (f(x) = frac{1}{1+e^{-x}})。

。

在样本量较小的情况下, logistic回归的预测精度可能高 于线性回归。

线性回归的系数解释较为直观 ,而logistic回归的系数解释相 对较为复杂。

对数线性模型与其他模型的比较

对数线性模型假设因变量和自变量之间存在对 数关系,而其他模型的假设条件各不相同。

对数线性模型的解释性较强,可以用于探索自变量之 间的交互作用和效应大小。

THANKS

感谢您的观看

预测市场细分中的消费者行为等。

对数线性模型还可以用于探索性数据分析,以发现数 据中的模式和关联。

Part

04

比较与选择

线性回归与logistic回归的比较

线性回归适用于因变量和自变 量之间存在线性关系的场景, 而logistic回归适用于因变量为

二分类或多分类的场景。

线性回归的假设条件较为严格 ,要求因变量和自变量之间存 在严格的线性关系,而logistic 回归的假设条件相对较为宽松

最小二乘法

最小二乘法是一种数学优化技术,用于最小化预测值与实际观测值之间的平方误差总和。

通过最小二乘法,可以估计回归系数,使得预测值与实际观测值之间的差距最小化。

最小二乘法的数学公式为:最小化 Σ(Yi - (β0 + β1X1i + β2X2i + ...))^2,其中Yi是实际观 测值,X1i, X2i, ...是自变量的观测值。

庞浩计量经济学第二章简单线性回归模型

最小二乘法的应用

在统计学和计量经济学中,最 小二乘法广泛应用于估计线性 回归模型,以探索解释变量与 被解释变量之间的关系。

通过最小二乘法,可以估计出 解释变量的系数,从而了解各 解释变量对被解释变量的影响 程度。

最小二乘法还可以用于时间序 列分析、预测和数据拟合等场 景。

最小二乘法的局限性

最小二乘法假设误差项是独立同分布 的,且服从正态分布,这在实际应用 中可能不成立。

最小二乘法无法处理多重共线性问题, 当解释变量之间存在高度相关关系时, 最小二乘法的估计结果可能不准确。

最小二乘法对异常值比较敏感,异常 值的存在可能导致参数估计的不稳定。

04

模型的评估与选择

R-squared

总结词

衡量模型拟合优度的指标

详细描述

R-squared,也称为确定系数,用于衡量模型对数据的拟合程度。它的值在0到1之间,越接近1表示模型拟合越 好。R-squared的计算公式为(SSreg/SStot)=(y-ybar)2 / (y-ybar)2 + (y-ybar)2,其中SSreg是回归平方和, SStot是总平方和,y是因变量,ybar是因变量的均值。

数据来源

本案例的数据来源于某大型电商 平台的销售数据,包括商品的销 售量、价格、评价等。

数据处理

对原始数据进行清洗和预处理, 包括处理缺失值、异常值和重复 值,对分类变量进行编码,对连 续变量进行必要的缩放和转换。

模型建立与评估

模型建立

基于处理后的数据,使用简单线性回 归模型进行建模,以商品销售量作为 因变量,价格和评价作为自变量。

线性回归模型是一种数学模型, 用于描述因变量与一个或多个 自变量之间的线性关系。它通 常表示为:Y = β0 + β1X1 + β2X2 + ... + ε