Relational Latent Class Models

latent consistency models原理 -回复

latent consistency models原理-回复[latent consistency models原理]一、引言在自然语言处理领域,理解句子的含义是一个非常关键的任务。

然而,句子的含义往往是隐含在句子的表层结构之中。

为了解决这个问题,研究者们提出了一种叫做"latent consistency models"的模型。

本文将详细介绍该模型的原理以及其在自然语言处理中的应用。

二、latent consistency models的基本原理latent consistency models是一种基于隐含一致性的模型,旨在通过学习语义级别的一致性来提升句子的意义理解。

其基本原理如下:1. 数据准备首先,需要准备一个大规模的语料库作为训练数据。

这个语料库包含了大量的句子对,每个句子对由两个语义相似或相关的句子组成。

例如:“我是一个学生。

”和“我在上学。

”这两个句子就是一个语义相似的句子对。

2. 建模latent consistency models使用神经网络模型来建模,该模型由两个主要组件组成:编码器和解码器。

(1)编码器:编码器将句子映射到一个低维潜在语义空间。

这里可以使用一种称为Transformer的深度学习模型作为编码器。

编码器将输入的句子转换成一个潜在语义向量。

(2)解码器:解码器根据潜在语义向量生成一个句子。

解码器也可以使用Transformer模型,它可以接受潜在语义向量作为输入,并生成一个与输入句子相似的句子。

3. 训练模型的训练过程可以分为以下几个步骤:(1)对于每个句子对,将其中一个句子作为输入送入编码器,得到潜在语义向量。

(2)将潜在语义向量送入解码器,生成一个与输入句子相似的句子。

(3)使用生成的句子和实际句子之间的差异作为损失函数,通过反向传播算法来更新模型参数。

(4)迭代以上步骤,直到模型收敛。

4. 评估训练完成后,可以使用训练好的模型来进行句子的意义理解。

从零开始学推荐系统二:隐语义模型

从零开始学推荐系统⼆:隐语义模型2. 隐语义模型隐语义模型⼜可称为LFM(latent factor model),它从诞⽣到今天产⽣了很多著名的模型和⽅法,其中和该技术相关且⽿熟能详的名词有pLSA、 LDA、隐含类别模型(latent class model)、隐含主题模型(latent topic model)、矩阵分解(matrix factorization)。

本节将对隐含语义模型在Top-N推荐中的应⽤进⾏详细介绍,并通过实际的数据评测该模型。

核⼼思想:通过隐含特征(latent factor)联系⽤户兴趣和物品。

举例:⽤户A的兴趣涉及侦探⼩说、科普图书以及⼀些计算机技术书,⽽⽤户B的兴趣⽐较集中在数学和机器学习⽅⾯。

对A和B推荐图书时,根据第⼀篇⽂章,我们可以采⽤基于邻域的算法:UserCF 和ItemCF。

UserCF:⾸先需要找到和他们看了同样书的其他⽤户(兴趣相似的⽤户),然后给他们推荐那些⽤户喜欢的其他书。

ItemCF:需要给他们推荐和他们已经看的书相似的书,⽐如⽤户B看了很多关于数据挖掘的书,可以给他推荐机器学习或者模式识别⽅⾯的书。

还有⼀种是基于兴趣分类的⽅算法,也就是隐语义模型,隐语义模型通过如下公式计算⽤户u对物品 i 的兴趣:其中,pu,k 和 qi,k 是模型的参数,其中 pu,k 度量了⽤户u的兴趣和第k个隐类的关系,⽽ qi,k 度量了第k个隐类和物品 i 之间的关系。

这样,就可以通过隐类,把⽤户u与物品 i 的兴趣联系起来。

需要注意的是推荐系统的⽤户⾏为分为显性反馈和隐性反馈。

LFM在显性反馈数据(也就是评分数据)上解决评分预测问题并达到了很好的精度。

不过本章主要讨论的是隐性反馈数据集,这种数据集的特点是只有正样本(⽤户喜欢什么物品),⽽没有负样本(⽤户对什么物品不感兴趣)。

因此,需要构造负样本数据。

构造负样本时,要注意以下两点:1. 对每个⽤户,要保证正负样本的平衡(数⽬相似)。

latent diffusion models讲解

latent diffusion models讲解Latent Diffusion Models是一种统计模型,用于分析社会网络中信息传播的过程。

在社交媒体时代,信息传播已成为影响公众舆论的关键因素。

因此,研究信息的传播方式和传播速度对于理解公众态度和行为模式具有重要意义。

Latent Diffusion Models的核心思想是将传播过程视为一个以时间为轴的连续事件,并通过建立概率模型来分析每个事件的概率和影响程度。

具体而言,该模型将时间分为若干步,每一步都代表了信息传播的一个阶段。

在每个阶段中,信息可以传播到相邻节点,传播概率和节点间的关系可以由节点间的连边和节点属性来决定。

传播的效果也可以体现为节点的激活程度,一般情况下激活的节点会继续将信息传播给邻居节点,形成信息传播的“链式反应”。

而在这个链式反应的过程中,一些“潜在节点”可能并不会被直接触发,即使这些节点没有被激活,它们依然能够影响传播的扩散。

这里的“潜在节点”指的是具有影响传播的能力,但当前并没有被激活的节点。

使用Latent Diffusion Models就能够准确预测这些节点的影响程度,这就是模型的“潜在效应”。

Latent Diffusion Models主要有两种模式:unsupervised learning和supervised learning。

unsupervised learning模式是一种无监督学习模型,对于信息传播的相关参数进行估计,并对传播行为进行建模分析。

而supervised learning模式是一种有监督学习模型,需要人工干预来导入关于传播的标签数据,并根据标签进行预测和分析。

在现实应用中,Latent Diffusion Models可以应用于多种领域,如社交媒体舆情分析、市场营销策略分析、疾病传播模拟等。

比如,可以通过建立社交媒体平台的用户社交网络,并使用Latent Diffusion Models来分析用户间的消息传播和意见扩散。

latent consistency models原理 -回复

latent consistency models原理-回复latent consistency models(潜在一致性模型)是一种用于学习潜在变量的机器学习模型。

它们通过对数据中存在的潜在变量进行建模和学习,从而能够更好地理解和预测数据。

本文将一步一步回答关于latent consistency models的原理和应用。

第一部分:潜在变量的定义与意义(300字)在许多实际问题中,我们往往无法直接观测到感兴趣的变量,比如人们的情感状态、物体的属性等。

这些变量被称为潜在变量(latent variables)。

潜在变量是对数据背后未被直接观测到的现象的一种建模方式,它们能够帮助我们更好地理解和预测数据。

潜在变量的存在可以提供一种更简洁和有用的数据表示方式。

通过建立潜在变量与可观测变量之间的关系,我们能够通过观测可观测变量来推断潜在变量的状态,从而对数据进行更深入的分析和理解。

因此,潜在一致性模型的目标就是从观测数据中学习潜在变量的状态,以达到对数据进行建模和预测的目的。

第二部分:潜在一致性模型的基本原理(600字)潜在一致性模型的基本原理是通过最大化模型的似然函数来学习潜在变量的状态。

假设我们有一个包含观测变量和潜在变量的数据集,我们的目标是找到最优的潜在变量状态,使得给定这些状态下观测数据发生的概率最大。

为了实现这个目标,潜在一致性模型采用了一种迭代的学习算法,称为期望最大化算法(Expectation-Maximization algorithm)。

这个算法分为两个步骤:E步和M步。

在E步中,我们假设潜在变量的状态已知,然后通过计算给定这些状态下的观测数据的概率来估计潜在变量的状态概率分布。

这个步骤通常利用贝叶斯定理和条件概率进行计算。

在M步中,我们根据在E步中估计得到的潜在变量的状态概率分布,最大化似然函数来更新模型参数。

这一步通常涉及到求解最优化问题。

通过反复迭代E步和M步,我们可以逐渐提高潜在一致性模型的性能,并找到最优的潜在变量状态和模型参数。

信息检索模型nlp

信息检索模型nlp

1. 向量空间模型(Vector Space Model,VSM):这是一种基于词袋模型的简单信息检索模型。

它将文档表示为向量,其中每个向量的维度对应于词汇表中的一个词。

通过计算文档和查询之间的相似度来评估它们的相关性。

2. 语言模型(Language Model):语言模型是一种统计模型,用于预测给定序列中的下一个词。

在信息检索中,语言模型可以用于评估查询和文档之间的相似度,以及对文档进行排序。

3. 概率检索模型(Probabilistic Retrieval Model):这类模型基于概率推理和贝叶斯定理来估计文档与查询相关的概率。

常见的概率检索模型包括布尔模型、向量空间模型的扩展(如 TF-IDF)和BM25 模型。

4. 排序学习模型(Learning to Rank):排序学习是一种机器学习方法,用于训练模型以对文档进行排序。

这些模型可以基于监督学习、强化学习或其他学习算法进行训练。

5. 深度学习模型:近年来,深度学习技术在信息检索中得到了广泛应用。

例如,使用卷积神经网络(CNN)或循环神经网络(RNN)来学习文本表示,并用于文档分类、情感分析等任务。

6. 知识图谱(Knowledge Graph):知识图谱是一种基于语义网络的模型,用于表示实体、关系和概念。

在信息检索中,知识图谱可以用于理解查询意图、扩展查询和增强搜索结果。

这些只是信息检索模型的一些示例,实际上还有许多其他的方法和技术可用于信息检索任务。

具体的模型选择取决于应用场景、数据特点和性能要求等因素。

latent diffusion model训练

一、概述在机器学习领域,概念模型的训练是一个至关重要的步骤。

一种常见的模型是潜在扩散模型(Latent Diffusion Model,LDM),它被广泛应用于推荐系统、社交网络分析和信息传播等领域。

在本文中,我们将讨论潜在扩散模型的训练方法,并深入探讨其原理和技术细节。

二、潜在扩散模型简介潜在扩散模型是一种基于概率图模型的模型,用于描述信息在网络中的传播过程。

该模型假设信息的传播是由一系列潜在因素影响的,这些因素包括节点之间的关系、节点的属性特征和信息的内容等。

通过对这些潜在因素进行建模,可以很好地描述信息传播的规律和趋势。

三、潜在扩散模型的训练潜在扩散模型的训练通常包括以下步骤:1. 数据准备在进行潜在扩散模型的训练之前,首先需要准备数据集。

数据集通常包括网络的拓扑结构、节点的属性特征和信息的传播记录等信息。

这些数据将被用来训练模型和验证模型的效果。

2. 模型构建接下来,需要构建潜在扩散模型的结构。

模型的结构通常包括潜在因素的表示、信息传播的参数和目标函数等。

通过对模型的结构进行设计和建模,可以很好地描述信息传播的过程和规律。

3. 参数估计一旦模型的结构确定,接下来需要对模型的参数进行估计。

参数估计的目标是找到最优的参数组合,使得模型在数据集上能够达到最佳的拟合效果。

参数估计通常使用最大似然估计、梯度下降等方法。

4. 模型评估需要对训练好的模型进行评估。

评估的目标是验证模型在未知数据上的泛化能力和预测效果。

评估通常包括交叉验证、模型对比、预测误差等指标。

四、潜在扩散模型训练的技术细节1. 模型的表示潜在扩散模型通常使用概率图模型进行表示,如贝叶斯网络、隐马尔科夫模型等。

这些模型能够很好地描述信息传播的概率关系和影响因素。

2. 参数估计的算法在参数估计的过程中,通常使用最大似然估计、EM算法、梯度下降等方法进行优化。

这些方法能够有效地估计模型的参数,使得模型能够在数据上达到最佳的拟合效果。

3. 模型的评估指标在模型的评估过程中,通常会使用交叉验证、AUC、准确率、召回率等指标进行评估。

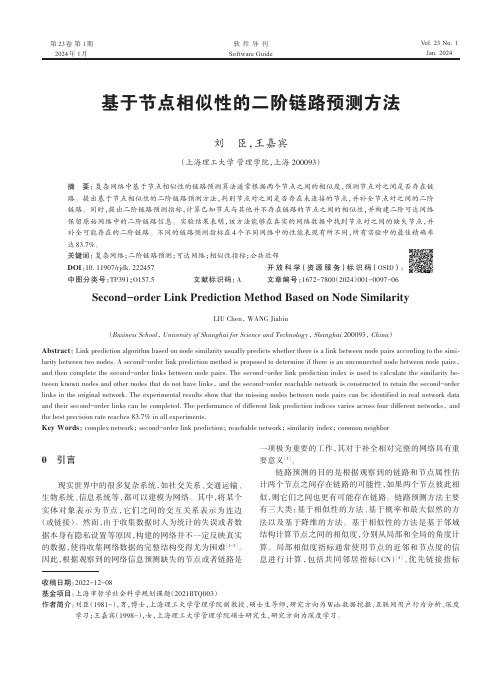

基于节点相似性的二阶链路预测方法

第 23卷第 1期2024年 1月Vol.23 No.1Jan.2024软件导刊Software Guide基于节点相似性的二阶链路预测方法刘臣,王嘉宾(上海理工大学管理学院,上海 200093)摘要:复杂网络中基于节点相似性的链路预测算法通常根据两个节点之间的相似度,预测节点对之间是否存在链路。

提出基于节点相似性的二阶链路预测方法,判别节点对之间是否存在未连接的节点,并补全节点对之间的二阶链路。

同时,提出二阶链路预测指标,计算已知节点与其他并不存在链路的节点之间的相似性,并构建二阶可达网络保留原始网络中的二阶链路信息。

实验结果表明,该方法能够在真实的网络数据中找到节点对之间的缺失节点,并补全可能存在的二阶链路。

不同的链路预测指标在4个不同网络中的性能表现有所不同,所有实验中的最佳精确率达83.7%。

关键词:复杂网络;二阶链路预测;可达网络;相似性指标;公共近邻DOI:10.11907/rjdk.222457开放科学(资源服务)标识码(OSID):中图分类号:TP391;O157.5 文献标识码:A文章编号:1672-7800(2024)001-0097-06Second-order Link Prediction Method Based on Node SimilarityLIU Chen, WANG Jiabin(Business School, University of Shanghai for Science and Technology, Shanghai 200093, China)Abstract:Link prediction algorithm based on node similarity usually predicts whether there is a link between node pairs according to the simi⁃larity between two nodes. A second-order link prediction method is proposed to determine if there is an unconnected node between node pairs,and then complete the second-order links between node pairs. The second-order link prediction index is used to calculate the similarity be⁃tween known nodes and other nodes that do not have links, and the second-order reachable network is constructed to retain the second-order links in the original network. The experimental results show that the missing nodes between node pairs can be identified in real network data and their second-order links can be completed. The performance of different link prediction indices varies across four different networks, and the best precision rate reaches 83.7% in all experiments.Key Words:complex network; second-order link prediction; reachable network; similarity index; common neighbor0 引言现实世界中的很多复杂系统,如社交关系、交通运输、生物系统、信息系统等,都可以建模为网络。

双线性模型(一)(RESCAL、LFM、DistMult)

双线性模型(⼀)(RESCAL、LFM、DistMult)今天开始,就要开始阅读双线性模型的⽂章了。

⼤约有⼗七⼋篇⽂章,都是在综述经常见到的经典双线性模型,计划在⼋⽉中旬之前看完。

虽然后⾯不会去做这类⽅法,但是作为这个领域的研究者,觉得还是应该读⼀读,否则总感觉⾃⼰的知识体系是有漏洞的。

开题报告⾥对于这⼀类模型的简介:语义匹配模型采⽤基于相似性的打分函数,通过匹配实体和关系在嵌⼊向量空间的潜在语义衡量三元组事实成⽴的可能性。

该类模型的典型代表有:RESCAL[28]、DistMult[29]、HolE[30]、ComplEx[31]、ANALOGY[32]、SEEK[50]等。

RESCAL[28]⼜称双线性模型,该模型⽤向量表⽰实体,⽤矩阵表⽰关系,并通过⾃定义的打分函数捕捉三元组的内部交互。

DistMult[29]通过将RESCAL的关系矩阵限制为对⾓矩阵对其进⾏了简化。

HolE(Holographic Embedding)[30]结合了RESCAL的表⽰能⼒与DistMult的简洁⾼效,将实体和关系都表⽰为空间中的向量,并定义了头尾实体进⾏交互的循环关联操作,操作结果与关系的表⽰进⾏匹配以计算三元组得分。

ComplEx(Complex Embedding)[31]在DistMult的基础上引⼊复值嵌⼊,实体和关系的embedding不再位于实值空间⽽是复空间。

此外ComplEx的三元组打分函数并⾮对称形式,对于⾮对称关系类型的三元组可根据头尾实体的位置关系得到不同的得分,从⽽可以更好地建模⾮对称关系。

ANALOGY[32]在RESCAL的基础上进⾏扩展,以更好地建模实体和关系的推理属性。

它采⽤了和RESCAL同样的双线性函数作为三元组打分函数。

SEEK(Segmented Embedding of Knowledge)[50]针对现有模型的表⽰能⼒与复杂度不能兼顾的问题,提出轻量级的嵌⼊框架,核⼼思想是对实体和关系进⾏分段嵌⼊,并通过段间组合计算三元组得分,可以在不增加模型复杂度的情况下获得较好的表⽰能⼒,并实现对于对称和⾮对称关系类型的处理能⼒。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Corporate Research and Technology Relational Latent Class ModelsVolker TrespSiemens Corporate Research and Technology Munich, GermanyWith: Zhao Xu(1,2), Stefan Reckow(1,2), Achim Rettinger(2,4) Kai Yu (3), Shipeng Yu (2) and Hans-Peter Kriegel(1)1: University of Munich, Germany2: Siemens AG3: NEC Laboratories America4: Technical University of MunichOverview: Learning with Relations (incomplete)Social Network Analysis:Descriptive, deterministic (network structure analysis)Increasing focus on statistical inferenceDriven by solving the problem at hand; often one type of actor and relationSpecialized Algorithms:Page Rank, most collaborative filtering algorithms …InternetInductive Logic Programming (ILP):FOL based; focus on generality; lost in generality?Learning of rules for prediction of predicates(relationships, attributes)Mostly deterministic; but recent extensions: Stochastic Logic Programs (Muggleton), Bayesian Logic programs (Kersting et al.))Statistical Relational LearningPrincipled probabilistic approaches from machine learning and AIFocus on uncertainty in relational domains;Analysis of dependencies; prediction of attributes and relationsStatistical Relational LearningProbabilistic relational models (PRM)(Koller, Friedman, Getoor, Pfeffer, …) Combines a relational description with components from frame-basedsystems and Bayesian networksDirected acyclic probabilistic entity-relationship (DAPER) model (Heckermann, Meek, Koller)ER (entity relationship) models with Bayesian networksRelational Dependency Networks(Jennifer Neville, David Jensen)Relational Markov networks(Taskar, …)Markov Logic Networks(Richardson, Domingos, …)This WorkWhat do we do:In this work we apply nonparametric hierarchical Bayesian modeling to relational learning and achieve nonparametric relational Bayes in form of an infinite hidden relational model (IHRM) and touch on relatedapproachesAdvantages of the IHRMStraightforward to apply without any extensive structural learningBoth attributes and identities of entities can have predictive powerClustering in relational domain (multi-relational clustering)Identify roles of actorsII. Before Relational LearningTowards Relational Learning: Hierarchical Bayesian ModelingIII RelationalModeling andLearningStatistical machine learning is in the midst of a"relational revolution"T. Dietterichuser movie rateuser m/w birth occu.movie dire.year …name …dire.typeStructural Learning in Relational ModelingIn many applications it isunreasonable to assumethat the probabilisticdependency structure isknownConsiderable work in PRMmodeling has been devotedto structural learningStructural learning in relational models is more involved than on non-relational Bayesian networks, due to the explosion in possible attributes candidates as parentsTypically a Bayesian score is optimized using some reasonable search strategyIV Infinite Hidden Relational Modeling: Combining Relational Learning with nonparametric Hierarchical BayesHierarchical Bayes and Relational LearningProbabilistic relational models (PRM, DAPER) are templates leading to parameter sharing in the ground BNThis might be too stiff for many applicationsWe have seen how hierarchical Bayesian modeling allowed parameters to be personalized in a sensible way: patient outcome could have somehospital specific effectsThus the natural question is how to generalize HB to relational modeling If the parameter dependency is relational, a parametric HB approach is quite difficult to conceive: one would have to define a prior distribution whose hyperparameters depend on two or more entitiesFortunately, a nonparametric HB approach is much easier to generalize!The RecipeTo each entity an infinite latent variable, specific to each entity class, is assignedThis latent variable is the parent of the (remaining) attributes of the entityThe parents of the attributes of a relationship are the latent variables of the associated entitiesBut isn’t this too limited? The model implies local dependencies following the relationship structureNot necessarily: information can propagatethrough the network of latent variablesIHRMWork on Nonparametric Relational Learning C. Kemp, T. Griffiths, and J. R. Tenenbaum (2004). Discovering Latent Classes in Relational Data (Technical Report AI Memo 2004-019)Kemp, C., Tenenbaum, J. B., Griffiths, T. L., Yamada, T. & Ueda, N. (2006). Learning systems of concepts with an infinite relational model. AAAI 2006Z. Xu, V. Tresp, K. Yu, S. Yu, and H.-P. Kriegel (2005). Dirichlet enhanced relational learning. In Proc. 22nd ICML, 1004-1011. ACM PressZ. Xu, V. Tresp, K. Yu, and H.-P. Kriegel. Infinite hidden relational models. In Proc. 22nd UAI, 2006K. Nowicki and T.A.B. Snijders. Estimation and prediction for stochastic blockstructures. JASA 96(455), 2001Jake M. Hofman, Chris H. Wiggins . A Bayesian Approach to Network Modularity (this workshop)IRM“HRM”∞∞Airoldi EM, Blei DM, Fienberg SE, Xing EP (2006) Mixed-membershipstochastic block models for relational data with application to protein-protein interaction. In Proceed. of the Intern. Biometrics Society Annual Meeting.MMSPJ. Sinkkonen, J. Aukia, and S. Kaski. Inferring vertex properties from topology ∞V Making it all workInference in the IHRMWe derived and compared various inference and learning approachesGibbs sampler derived from the Chinese restaurant process representation (Kemp et al. 2004, 2006, Xu et al. 2006);Gibbs sampler derived finite approximations to the stick breaking representationDirichlet multinomial allocation (DMA)Truncated Dirichlet process (TDP)Two mean field approximations based on those two approximationsA memory-based empirical approximation (EA)Movie cluster analysis Gibbs sampling with CRP (2)User Attributes and User ClustersAge frequency Gender frequencyAction Thriller DramaComedyThrillerMysteryWarActionMusicalSci-FiSci-FiFilm-NoirMysteryStudent EducatorEngineerArtistProgrammer OtherProgrammerEducatorLibrarian StudentTechnicianEngineerAdministratorOtherDifference to mean distributionUser Clusters versus Movie ClustersAll attributes and relations Only relationsExperiment 2:Gene Interaction and Gene FunctionTaskCluster analysisPrediction of gene functions given the information on the gene level and the protein level, as well as the interaction between the genes.Attribute data: CYGD (Comprehensive Yeast Genome Database) from MIPS (Munich Information Center for Protein Sequences)1000 GenesAttributes: Chromosome, Motif, Essential, Class, Phenotype, Complex, FunctionInteraction data:DIP (data base of interacting proteins)Ground Network GeneFor a gene one or more phenotypes(11)[1-6] are observed in theorganismHow the expression of the gene can complex with others to form a larger protein (56)[1-3]The protein coded by the gene might belong to one or more structural A gene might contain one or morecharacteristic motifs(351) [1-6](information about the amino acid sequence of the protein)Gene attributes are: essential (an organism with a mutation cansurvive?), which chromosomeGround NetworkNode: gene Link: interaction Color: cluster.signal peptidase actin filamentsmicrotubulescytoskeletontranslocon Complex OntologyGene…。