基于BP神经网络的语音识别技术

基于深度学习的语音识别技术研究

基于深度学习的语音识别技术研究随着人工智能技术的发展,语音识别技术也日渐成熟。

从最初的基于模板匹配的语音识别到后来的基于统计学习的语音识别,再到今天的基于深度学习的语音识别,语音识别技术已经不再是未来科技,而是已经进入了我们的日常生活。

一、基于深度学习的语音识别技术深度学习技术是人工智能领域的热门技术之一,因其在图像识别、语音识别、自然语言处理等领域的卓越表现而备受关注。

深度学习算法通过模拟人脑的神经元网络实现对输入数据的多层抽象表示和处理。

而在语音识别任务中,深度学习算法可以通过对音频信号的建模和自适应模型训练来有效降低语音识别的误识别率。

目前基于深度学习的语音识别技术主要包括深度神经网络(Deep Neural Networks, DNNs)、卷积神经网络(Convolutional Neural Networks, CNNs)、长短时记忆网络(Long Short-Term Memory, LSTM)等多种模型。

其中,DNNs是基于前馈神经网络实现的语音识别模型,通过多个隐层抽象输入特征,将输入的音频信号映射到语音单元上,通过输出层的激活函数可以得到对音频信号的识别结果。

CNNs则是通过卷积层和池化层实现特征的提取和降维,然后再使用全连接层实现的识别。

而LSTM则是基于循环神经网络实现的模型,对于长序列信号的记忆、建模和识别效果尤为出色。

二、深度学习技术的优点相对于传统语音识别算法,深度学习技术具有以下优点:1. 非线性特征提取: 传统语音信号的特征提取通常采用Mel频率倒谱系数(Mel-frequency cepstral coefficients, MFCCs)等算法,而深度学习技术可以通过多层的非线性变换实现更为复杂的特征提取。

2. 优秀的分类性能: 深度学习算法可以通过大规模数据训练和模型自适应调整,从而获得优秀的分类性能,尤其对于噪声干扰、口音变化等情况的适应能力更强。

3. 高效的训练方法: 深度学习算法可以使用反向传播算法实现模型训练,而且可以结合GPU等并行计算技术加速训练完成。

基于BP神经网络的语音情感识别研究

基于BP神经网络的语音情感识别研究作者:徐照松元建来源:《软件导刊》2014年第04期摘要:随着科技的迅速发展,人机交互越来越受到人们的重视,语音情感识别更是学术界研究的热点。

将BP神经网络算法用于语音情感识别研究,并在汉语情感数据集上进行了相关实验,识别的准确率达到了91.5%,相较于SVM算法分类精度提高了5%。

关键词关键词:语音情感识别;BP神经网络;SVM中图分类号:TP302文献标识码:A 文章编号文章编号:16727800(2014)004001103作者简介作者简介:徐照松(1990-),男,广西师范学院计算机与信息工程学院硕士研究生,研究方向为数据挖掘、语音情感、智能计算;元建(1986-),男,广西师范学院计算机与信息工程学院硕士研究生,研究方向为数据挖掘、智能计算。

0 引言随着科技的迅速发展,人机交互显得尤为重要。

语音是语言的载体,是人与人之间交流的重要媒介。

相较于其它交流方式而言,语音交流更加直接、便捷。

近年来,随着人机交互研究的不断深入,语音情感识别更成为了学术界研究的热点,其涉及到信号处理、模式识别、人工智能等相关领域。

语音中除了能够传达语义信息外,还包含了一些情感信息,然而这些情感信息往往被人们所忽略[3]。

语音情感识别实际上是利用计算机所提取的语音信号特征来判断其属于哪一类情感。

利用模式识别方法研究语音情感识别的文献较多,朱菊霞[4]等使用SVM算法对语音情感进行识别,并取得了86%的识别率。

余华[5]等使用粒子群算法优化神经网络来进行语音情感识别,识别率较高。

BP神经网络是神经网络的一种,属于多层前馈神经网络,与其它神经网络算法所不同的是采用了反向传播的学习算法,不断地计算输出端的误差向回传递来进行权值调整,从而达到误差最小的效果。

文中结合了BP神经网络的优点,将其用于语音情感识别研究中,并且在汉语情感数据集上进行了相关实验,识别的准确率达到了91.5%,相较于其它方法提高了5%。

基于神经网络的语音情感识别

tains a better perform ance with the application of neural network. Key words: speech emotion recognition;emotion features;artificial neural networks;Mel-Frequency Cepstral Coemcients(MFCC)

Abstract: The main goal of this thesis is to search the most useful features wit h analyzing the features related with emotions, and f ind a recognition m odel to m ake use of these features.It studies t h e m ethod and technolog y in the research of the speech emotion recogn ition,and creates the database of the speech emotion recognition and picks-up t he features of t he speech sig n a1. Then it studies the efect in emotion—speech recognition from those common features such as pitch,amplitude energ y ,formant and

深度神经网络在语音识别中的应用

深度神经网络在语音识别中的应用一、引言语音识别是一项具有挑战性的技术,其能够将口语转化为可执行命令或可供存储的文本。

随着科技的进步,语音识别已经成为了许多设备和应用程序中必备的功能,如语音助手、语音搜索等。

本文将探讨深度神经网络在语音识别中的应用以及其优势。

二、深度神经网络深度神经网络(deep neural network,DNN)是一种人工神经网络的模型,它由多个非线性变换层堆叠而成,一般具有深度超过两层。

每个层的参数是由前面各层的特征自动地学习生成的。

深度神经网络在图像处理、自然语言处理、声音识别等方面具有广泛的应用。

三、深度神经网络在语音识别中的应用在语音识别技术中,深度神经网络起到了重要作用。

当前,深度神经网络已经在许多领域及各个层面展现出了杰出的性能。

而在语音识别中,它也为语音模型的建立提供了新的途径。

传统上,语音识别使用的是基于隐马尔可夫模型和贝叶斯网络等方法。

然而,随着深度神经网络技术的发展,人们不再需要将大量的特征提取和手动设计语音模型。

相反,深度神经网络使用端到端的数据驱动训练方法,从原始语音信号中学习包含有关发音、语速、音量等方面的特征,然后通过模拟出人类大脑处理语言信息的过程来实现语音识别。

深度神经网络的语音识别系统可分为前端和后端。

前端主要是将语音信号转化为一个特征向量,而后端将该向量转化为文字。

前端通常使用声学处理来分析信号,比如将信号转化为声谱图。

在后端部分,深度神经网络负责处理前端产生的数据,识别出语音中的文本信息。

深度神经网络采用的是序列模型,其目的是将语音序列映射到文字或者指令序列中。

四、深度神经网络在语音识别中的优势相对于传统的语音识别方法,深度神经网络在语音识别中具有以下优势:1、端到端训练,减少了特征工程流程的复杂度。

深度神经网络通过自己学习语音特征,无需专家买服务,从而减少了对人类专业知识的依赖。

2、提高了准确性。

深度神经网络在数据驱动下对语音数据的处理更加精细,通过节省特征处理步骤,使其能够更好地适应数据,从而提高语音识别的准确率。

基于深度神经网络的语音合成技术

基于深度神经网络的语音合成技术深度神经网络(Deep Neural Network,DNN)是一种通过构建多层神经元来模拟人脑神经网络的一种机器学习算法。

近年来,深度神经网络在各个领域取得了巨大的成功,尤其是在语音合成技术方面。

本文将介绍基于深度神经网络的语音合成技术及其应用。

一、深度神经网络的语音合成原理深度神经网络的语音合成技术是基于机器学习的方法,通过训练神经网络模型来学习声学特征和语音模型。

其基本原理如下:1. 数据预处理:首先,需要获取大量的音频数据进行训练。

这些音频数据需要进行预处理,包括音频采样、声学特征提取等步骤。

2. 特征提取:接下来,使用特征提取算法从音频数据中提取出一系列的声学特征,如梅尔频率倒谱系数(Mel-frequency Cepstral Coefficients,MFCC)等。

3. 训练模型:将提取的声学特征作为神经网络的输入,通过大量的训练数据对神经网络进行训练,使其学习到音频数据中的潜在模式和规律。

4. 语音合成:训练完成后,使用训练好的深度神经网络模型来合成语音。

通过输入文本(文本到语音合成,Text-To-Speech,TTS),神经网络模型可以生成相应的声学特征,然后将其转化为音频信号。

二、基于深度神经网络的语音合成技术的优势基于深度神经网络的语音合成技术相较于传统方法具有以下优势:1. 自然度高:深度神经网络可以模拟人脑神经网络的结构,能够更好地捕捉语音的声学特征和语义信息,因此生成的语音更为自然、流畅。

2. 灵活性强:深度神经网络可以根据不同的训练数据和模型结构进行灵活调整,可以适应不同语种、口音和语音风格的合成需求。

3. 学习能力强:深度神经网络具有很强的学习能力,通过大量的训练数据和迭代优化训练过程,可以不断提高语音合成的质量和准确性。

4. 实时性好:基于深度神经网络的语音合成技术可以实时生成语音,响应速度快,适用于各种实时系统和应用场景。

三、基于深度神经网络的语音合成技术的应用基于深度神经网络的语音合成技术在多个领域有广泛的应用,包括但不限于以下几个方面:1. 语音助手:如智能手机的语音助手、智能音箱等,基于深度神经网络的语音合成技术可以生成自然流畅的语音回应用户的指令和问题。

语音识别技术(数学建模)

amplitude

Energy

5 0

1

2

3

4

5

6

7

8

9 x 10

4

3

ZCR

300 400 500 600 700 800

2 1 0 1 2 3 4 5 6 7 8 9 x 10

4

5.4图 5.1.4 快速傅里叶转换(FTT) 由于信号在时域上的变化通常很难看出其特性, 所以通常将它转换成频域上 的能力分布来观察,不同的能量分布,就代表不同的语音特性。故乘上汉明窗后 每个音框还需经过FTT以得到频域上的能量分布。 乘上汉明窗的主要目的, 是要加强音框左端和右端的连续性,这是因为在进 行FFT 时, 都是假设一个音框内的讯号是代表一个周期性讯号,如果这个周期性 不存在, FFT 会为了要符合左右端不连续的变化,而产生一些不存在原讯号的能 量分布,造成分析上的误差。当然,如果我们在取音框时,能够使音框中的讯号 就已经包含基本周期的整数倍, 这时候的音框左右端就会是连续的,那就可以不 需要乘上汉明窗了。但是在实作上,由于基本周期的计算会需要额外的时间, 而 且也容易算错,因此我们都用汉明窗来达到类似的效果。 5.1.5 三角带通滤波器 将能量频谱能量乘以一组20个三角带通滤波器, 求得每一个滤波器输出的对 数能量(Log Energy) 。必须注意的是:这20个三角带通滤波器在梅尔频率(Mel Frequency)上是平均分布的,而梅尔频率和一般频率f的关系式如下:

7

mel(f)=2595*log 10 (1+f/700) 或是 mel(f)=1125*ln(1+f/700) 梅尔频率代表一般人耳对于频率的感受度,由此也可以看出人耳对于频率f 的感受是呈对数变化的:在低频部分,人耳感受是比较敏锐;在高频部分,人耳 的感受就会越来越粗糙。 定义若干个带通三角滤波器(k),0<=m<=M,M为滤波器个数,其中心频率为 f(m),每个带通三角滤波器的频率响应为:

深层神经网络在语音识别中的应用

深层神经网络在语音识别中的应用近年来,随着人工智能技术的发展,深度学习作为其中的一种算法,逐渐在许多领域发挥着重要的作用。

其中,深层神经网络(Deep Neural Network,DNN)作为深度学习的核心之一,已经被广泛应用于语音识别领域,取得了显著的进展。

本文将介绍深层神经网络在语音识别中的应用及其技术原理。

一、语音识别技术语音识别技术,指的是通过计算机对人类语音进行分析和处理,将其转化成可供计算机理解和处理的数据格式,从而完成语音识别的过程。

语音识别技术的应用非常广泛,如语音控制、语音翻译、语音搜索、语音识别等。

其中,语音识别技术在自然语言处理领域中扮演着重要的角色,被广泛应用于智能家居、智能手机、语音助手等领域。

二、深度学习及其在语音识别中的应用1.深度学习深度学习(Deep Learning),属于机器学习的一种,是指利用神经网络等算法,通过多层次的参数化学习,从海量数据中挖掘出数据的内在规律或特征,并利用这些特征进行预测、分类等任务。

深度学习的一个重要特点是,在生产和学习数据集之间不存在人工设计的特征提取器,而是直接从原始数据中学习。

2.深层神经网络深层神经网络是深度学习的基础,它是一种模仿人类神经系统结构的计算模型,由多层神经元组成。

每层神经元完成特定的特征提取任务,把上一层的输出作为输入,并通过激活函数将这些值转换为下一层的输入。

深层神经网络的训练过程需要大量的数据来指导权值的学习,并且在训练时需要进行大量的迭代,才能获得较高的准确度。

3.深层神经网络在语音识别中的应用深层神经网络在语音识别中的应用主要分为两种方法:基于声学模型的深度神经网络(Deep Neural Network Acoustic Model,DNN-HMM)和基于端到端的深度神经网络(End-to-End Deep Neural Network,E2E-DNN)。

基于声学模型的深度神经网络是在传统的语音识别体系中引入深层神经网络,主要任务是提取语音信号的高层抽象特征,然后通过隐马尔可夫模型(Hiden Markov Model,HMM)将这些特征转化为对应的词语或拼音。

基于深度自编码器神经网络完成语音识别的预训练方法

基于深度自编码器神经网络完成语音识别的预训练方法 深度自编码器神经网也是一种无监督模型,其输出向量与输入向量同维,训练的目标是使其目标值等于输入值,即尝试逼近一个恒等函数。

这样就可以将其隐层激活值看作为对原始数据的压缩表示或有效编码。

通常也采用逐层贪婪训练法来训练深度自编码器神经网。

每次采用基于随机梯度下降的BP算法来训练仅一个隐层的自编码器神经网,然后将其堆叠在一起构成深度网络。

这样的深度自编码器网络也被称为栈式自编码器神经网络。

其训练过程如下:先利用原始输入数据训练一个单隐层自编码器网络,学习其权重参数,从而得到第一个隐层。

然后将其隐层神经元激活值组成的向量作为输入,继续训练一个新的单隐层自编码器网络,从而得到第二个隐层及其权重参数,以此类推。

同样,最后增加一个Softmax层作为输出。

这样也能构成一个自下而上的前馈深层且具有区分性的DNN,并能得到其网络参数的一个有效初值,可以对其进行进一步的基于BP算法的有监督精调训练。

DNN-HMM 对DNN首先进行无监督的预训练,然后进行有监督的调整是DNN-HMM声学模型能够成功应用于语音识别任务,并在性能上超越GMM-HMM的主要原因之一。

无监督预训练避免了有监督训练时常常过拟合于泛化能力很差的局部极值点的问题,而逐层的贪婪训练弥补了梯度消失问题带来的影响。

然而深度学习技术发展迅猛,从近年的研究进展看,预训练的重要性日益降低:①使用海量数据进行训练能有效避免过拟合问题,Dropout等随机优化算法的出现,也极大提高了DNN模型的泛化能力;②采用整流线性单元(Rectified Linear Units, ReLU)作为激活函数,以及采用卷积神经网络(Convolutional Neural Networks, CNN),这种深度网络结构也成功的减小了梯度消失问题的影响。

下面将简短介绍一下ReLU和CNN。

ReLU 相关的研究表明,采用基于ReLU激活函数的DNN与基于Sigmoid激活函数的DNN相比,不仅可以获得更好的性能,而且不需要进行预训练,可以直接采用随机初始化。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

海事大学神经网络与语音识别院系: 物流工程学院课程名称: 制造与物流决策支持系统学生姓名: 学号:时间:目录一.绪论 (3)1.1 研究背景及意义 (3)1.2 语音识别的国外研究现状 (3)1.3研究容 (4)二.语音识别技术 (5)2.1语音信号 (5)2.2语音信号的数学模型 (5)2.3 语音识别系统结构 (6)2.4 语音信号预处理 (7)2.4.1 语音信号的采样 (8)2.4.2语音信号的分帧 (8)2.4.3语音信号的预加重 (9)2.4.4 基于短时能量和过零率的端点检测 (9)2.5 特征参数提取 (12)三.基于BP神经网络语音识别算法实现 (14)3.1 BP神经网络原理 (14)3.2 输入层神经元个数的确定 (14)3.3网络隐含层数的确定 (15)3.4隐含层神经元个数的确定 (15)3.5 BP神经网络构造 (15)3.6 BP神经网络的训练 (16)3.6.1训练样本集合和目标值集合 (16)3.6.2 网络训练 (16)3.7网络训练 (17)3.8 语音的识别结果 (18)四.总结 (19)参考文献 (20)附录 (21)一.绪论计算机的飞速发展,使人们的生活方式发生了根本性的改变,鼠标、键盘,这些传统的人机接口使人们体会到了生活的便利。

科学技术日新月异,假如让“机器”能够听懂人的语言,并根据其信息去执行人的意图,那么这无疑是最理想的人机智能接口方式,因此语音识别作为一门极具吸引力的学科应运而生,很多专家都指出语音识别技术将是未来十年信息技术领域十大重要的科技发展技术之一。

语音识别(Speech Recognition)是指,计算机从人类获取语音信息,对语音信息进行分析处理,准确地识别该语音信息的容、含义,并对语音信息响应的过程。

语音信号具有非稳定随机特性,这使得语音识别的难度大。

目前人类甚至仍没有完全理解自身听觉神经系统的构造与原理,那么要求计算机能像人类一样地识别语音信号很有挑战性。

1.1 研究背景及意义语言在人类的智能组成中充当着很重要的角色,人与人之间的交流和沟通大部分是通过语言的方式有效的完成。

作为人与人之问交流最方便、自然、快捷的手段,人们自然希望它成为人与计算机交流的媒介。

随着数字信号处理及计算机科学的飞速发展,人们对实现人机对话产生越来越迫切的要求,使得语音识别技术近年来得到了迅速的发展,语音识别技术的研究进入了一个比较成熟的时期。

语音识别是一门交叉科学,它综合了声学、语言学、语音学、生理科学、数字信号处理、通信理论、电子技术、计算机科学、模式识别和人工智能等众多学科。

也是人机交互最重要的一步。

1.2 语音识别的国外研究现状通过语音传递信息是人类最重要,最有效,和最方便的交换信息的形式,语音识别主要指让机器转达人说的话,即在各种情况下,准确的识别出语音的容,从而根据其信息,执行人的各种意图。

广义的语音识别包括说话人的识别和容的识别两部分。

这里所说的语音识别,是指容识别方面。

采用计算机进行语音识别到现在已经发展了50年。

从特征参数上改进,采用各种办法进行语音增强是一个研究方向,但是到目前为止,还没有一种办法能把语音信号完美地从噪音环境提取出来。

语音识别有广泛的商业化运用前景,主要可以分为通用场合和专用场合两个方面。

1.3研究容本文研究的主要容是结合模式识别的基本理论,研究BP神经网络孤立词语音识别的问题,实现1-5共5个数字的识别。

分析了语音信号的预处理,特征提取及BP神经网络算法实现。

二.语音识别技术2.1语音信号语音信号是随时间变化的一维信号,由一连串的音素组成,各个音素的排列有一定的规则。

语音具有声学特征的物理性质,声音质量与它的频率围有关,语音信号的频谱分量主要集中在200~3400Hz的围。

语音信号的另一个重要特点是它的短时性。

语音信号的特征是随时间变化而变化,只有在一段很短的时间间隔中,才保持相对稳定的特性。

研究表明,在5ms~40ms的围语音信号的频谱特性和一些物理特征基本保持不变。

语音信号短时特征和短时参数包括它的短时能量、短时过零率、短时相关函数、短时频谱等。

语音信号的最基本组成单位是音素。

音素可分成浊音和清音两大类。

如果将只有背景噪声的情况定义为“无声”,那么音素可分成“无声”、“浊音”和“清音”三类。

在短时分析的基础上可以判断一小段语音属于哪一类。

如果是浊语音段,还可测定它的另一些重要参数,如基音频率和共振峰等。

2.2语音信号的数学模型建立语音信号的数学模型是语音信号处理的基础。

从人的发音器官的机理来假设,将语音信号分为一些相继的短段进行处理,在这些短段中可以认为语音信号特征是不随着时间变化的平稳随机过程。

这样在这些短段时间表示语音信号时可以采用线性时不变模型。

通过上面的分析,将语音生成系统分成三个部分,喉的部分称为声门,在声门(声带)以下,称为“声门子系统”,它负责产生激励振动,是“激励系统”。

从声门到嘴唇的呼气通道是声道,是“声道系统”,声道的形状主要由嘴唇和舌头的位置来决定。

在说话的时候,声门处气流冲击声带产生振动,然后通过声道响应变成声音,由于发不同音时,声道的形状不同,所以能够听到不同的语音。

语音从嘴唇辐射出去,所以嘴唇以外是“辐射系统”。

激励的不同情况发不同性质的音,激励一般分为浊音激励和清音激励。

发浊音时声道受到声带振动的激励引起共振,产生间歇的类斜三角形脉冲;发清音时声道被阻碍形成湍流,可以把清音激励模拟成随机白噪声。

完整的语音信号的数学模型可以用三个子模型:激励模型、声道模型、辐射模型的串联来表示。

激励模型一般分为浊音激励和清音激励。

发浊音时,由于声带不断开和关闭将产生间歇的脉冲波,这个脉冲波类似于斜三角形的脉冲。

发清音时,无论是发阻塞音或摩擦音,声道都被阻碍形成湍流。

所以,可把清音激励模拟成随机白噪声。

声道模型有两种最常见的建模方式。

一是把声道视为由多个等长的不同截面积的管子串联而成的系统,按此观点推导出的叫“声管模型”;另一个是把声道视为一个谐振腔,按此推倒出的叫“共振峰模型”。

从声道模型输出的速度波与语音信号的声压波之倒比称为辐射阻抗,它表征口唇的辐射效应。

由辐射引起的能量损耗正比于辐射阻抗的实部,所以辐射模型是一阶类高通滤波器。

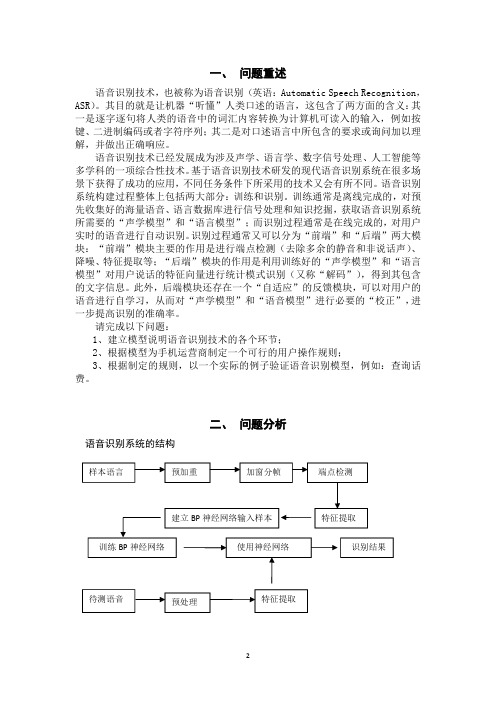

2.3 语音识别系统结构孤立词语音识别是对特定的不连续的词语作为处理单元。

语音识别系统的基本组成一般可以分为预处理模块、特征值提取模块及模式匹配三个模块。

如图2.1所示为语音识别系统结构框图。

图2.1 语音识别系统结构框图从图2.1的系统整体架构可以看到,建立基于BP神经网络的语音识别系统可分为两个阶段,即训练阶段和识别阶段。

首先由用户通过麦克风输入语音形成原始语音,然后系统对其进行预处理。

预处理包括预加重,加窗分帧和端点检测三个过程。

系统的前端采用了端点检测,目的是在一段语音信号中确定起点和终点。

在特征提取部分,本系统采用了MFCC作为特征参数,用于有效地区分数字1-5.在训练阶段,通过说话人多次重复语音,本系统从原始语音样本中去除冗余信息,提取说话人的特征参数并存储为BP神经网络的输入样本,在此基础上建立输入与输出的BP神经网络模型。

在识别阶段,待测语音经过预处理,使用已经训练好的BP神经网络进行识别得到结果。

2.4 语音信号预处理图2.2是语音信号的预处理的流程图。

从图2.2可以看到预处理模块包括预加重,加窗分帧和端点检测。

前级预加重、加窗分帧及端点检测是语音识别的准备工作,每一个环节对整个识别系统的性能有着重要的影响。

前级预处理主要是对信号进行一定的滤波和分帧;加窗分帧就是将语音信号进行分段处理,使语音信号连续并保持一定的重叠率:端点检测是确定语音有用信号的起始点与终止点,并通过一定的手段处理,将没有意义的语音信号去除,从而减少语音匹配识别模块的运算量,同时也可以提高系统的识别率。

预处理不合理或语音起止点及终止点判别不够准确都会使后续的特征矢量提取及模式匹配过程等工作受到很大的影响,甚至达不到语音识别的效果,因此预处理工作作为语音识别的第一步工作,必须达到所需的要求,为下一步的特征参数提取做好铺垫。

图2.2 语音信号预处理流程图2.4.1 语音信号的采样Matlab环境中语音信号的采集可使用wavrecord(n,fs,ch,dtype)函数录制,也可使用Windows的“录音机”程序录制成.wav文件然后使用wavread(file) 函数读入。

在本实验中,使用matlab的语音工具包录取0-共10段语音。

如图2.3所示为数字0的训练语音0a.wav的信号波形图,第(I)幅图为完整的语音波形,第(II)、(III)幅图分别为语音的起始部分和结束部分的放大波形图。

2.4.2语音信号的分帧语音信号是一种典型的非平稳信号,它的均值函数u(x)和自相关函数R(xl,x2)都随时间而发生较大的变化。

但研究发现,语音信号在短时间频谱特性保持平稳,即具有短时平稳特性。

因此,在实际处理时可以将语音信号分成很小的时间段(约10~30ms),称之为“帧”,作为语音信号处理的最小单位,帧与帧的非重叠部分称为帧移,而将语音信号分成若干帧的过程称为分帧。

分帧小能清楚地描绘语音信号的时变特征但计算量大;分帧大能减少计算量但相邻帧间变化不大,容易丢失信号特征。

一般取帧长20ms ,帧移为帧长的1/3~1/2。

在语音信号数字处理中常用的窗函数是矩形窗、汉明窗等,它们的表达式如下(其中N 为帧长):矩形窗:⎩⎨⎧-≤≤=其他 ,010 ,1)(N n n ϖ (2-1) 汉明窗:0.540.46cos(2/(1)),01()0,n N n N n πϖ--≤≤-⎧=⎨⎩其他 (2-2)2.4.3语音信号的预加重预加重是指在A /D 转换后加一个6dB /倍频程的高频提升滤波器,语音信号的平均功率谱由于受声门激励和口鼻辐射的影响,高频端大约在800Hz 以上按6dB /Oct(倍频程)跌落。

所以求语音信号频谱时,频率越高相应的成份越小,高频部分的频率比低频部分的难求。

因此,预加重的目的是加强语音中的高频共振峰,使语音信号的短时频谱变得更为平坦,还可以起到消除直流漂移、抑制随机噪声和提高清音部分能量的效果,便于进行频谱分析和声道参数分析。

此外,通常的方法是使用一阶零点数字滤波器实现预加重,其形式为:(2-3)频域相对应的形式为:(2-4) 其中,a 为预加重系数。

2.4.4 基于短时能量和过零率的端点检测在语音信号的预处理中,端点检测是关键的一步,语音信号的模型参数和噪声模型参数以及自适应滤波器中的适应参数都得依赖对应的信号段(语音段或噪声段)来计算确定。

因此,只有准确地判定语音信号的端点,才能正确地进行语音处理。

端点检测的目的是从包含语音的一般信号中确定出语音的起点以及终点,一般采用平均能量或平均幅度值与过零率相乘的方法来判断。