Hadoop和Mapreduce的介绍

hadoop 三大部件基础知识

hadoop 三大部件基础知识Hadoop是一个分布式计算框架,由三个主要部件组成:Hadoop分布式文件系统(Hadoop Distributed File System,简称HDFS)、Hadoop MapReduce和Hadoop YARN(Yet Another Resource Negotiator)。

HDFS是Hadoop的文件系统,它被设计为能够容纳大规模数据集,并且能够在廉价硬件上高效运行。

HDFS将数据划分为多个块,并将这些块分布在集群的不同节点上,以实现数据的可靠存储和高效读写。

HDFS还提供了高容错性和高可伸缩性,通过数据冗余和自动数据备份来保证数据的安全性。

MapReduce是Hadoop的计算模型,它能够并行地处理大规模数据集。

MapReduce将任务分为两个主要阶段:Map阶段和Reduce阶段。

在Map阶段,数据被划分为多个小任务,并由集群中的不同节点并行处理。

在Reduce阶段,Map阶段的结果被整合和汇总。

MapReduce模型的优势在于能够充分利用大规模集群的计算能力,从而加速数据处理过程。

YARN是Hadoop的资源管理系统,它负责集群资源的调度和管理。

YARN将集群的计算资源划分为多个容器,每个容器都有一定的计算能力和内存资源。

YARN可以根据任务的需求,动态地分配和管理集群资源,以提高系统的利用率和性能。

YARN的灵活性和可扩展性使得Hadoop能够更好地适应不同类型的工作负载。

通过使用HDFS、MapReduce和YARN,Hadoop能够处理大规模的数据,并提供高效的分布式计算能力。

它已经被广泛应用于各个领域,包括搜索引擎、社交网络分析、数据挖掘等。

Hadoop的三大部件相互协作,共同构建了一个强大的分布式计算平台,为大数据处理提供了可靠和高效的解决方案。

无论是处理海量数据还是提供实时分析,Hadoop都是一个不可或缺的工具。

Hadoop 生态系统介绍

Hadoop 生态系统介绍Hadoop生态系统是一个开源的大数据处理平台,它由Apache基金会支持和维护,可以在大规模的数据集上实现分布式存储和处理。

Hadoop生态系统是由多个组件和工具构成的,包括Hadoop 核心,Hive、HBase、Pig、Spark等。

接下来,我们将对每个组件及其作用进行介绍。

一、Hadoop核心Hadoop核心是整个Hadoop生态系统的核心组件,它主要由两部分组成,一个是Hadoop分布式文件系统(HDFS),另一个是MapReduce编程模型。

HDFS是一个高可扩展性的分布式文件系统,可以将海量数据存储在数千台计算机上,实现数据的分散储存和高效访问。

MapReduce编程模型是基于Hadoop的针对大数据处理的一种模型,它能够对海量数据进行分布式处理,使大规模数据分析变得容易和快速。

二、HiveHive是一个开源的数据仓库系统,它使用Hadoop作为其计算和存储平台,提供了类似于SQL的查询语法,可以通过HiveQL 来查询和分析大规模的结构化数据。

Hive支持多种数据源,如文本、序列化文件等,同时也可以将结果导出到HDFS或本地文件系统。

三、HBaseHBase是一个开源的基于Hadoop的列式分布式数据库系统,它可以处理海量的非结构化数据,同时也具有高可用性和高性能的特性。

HBase的特点是可以支持快速的数据存储和检索,同时也支持分布式计算模型,提供了易于使用的API。

四、PigPig是一个基于Hadoop的大数据分析平台,提供了一种简单易用的数据分析语言(Pig Latin语言),通过Pig可以进行数据的清洗、管理和处理。

Pig将数据处理分为两个阶段:第一阶段使用Pig Latin语言将数据转换成中间数据,第二阶段使用集合行处理中间数据。

五、SparkSpark是一个快速、通用的大数据处理引擎,可以处理大规模的数据,支持SQL查询、流式数据处理、机器学习等多种数据处理方式。

hadoop技术、方法以及原理的理解

hadoop技术、方法以及原理的理解Hadoop技术、方法以及原理的理解Hadoop是一个开源的分布式计算框架,它能够存储和处理海量的数据。

它由Apache基金会开发和维护,是目前最流行的大数据处理解决方案之一。

Hadoop的技术、方法以及原理是构成Hadoop 的核心部分,下面我们将对其进行详细的解析。

一、Hadoop的技术1. HDFSHadoop分布式文件系统(HDFS)是Hadoop的核心组件之一。

它是一种高度容错的分布式文件系统,具有高可靠性和高可用性。

该文件系统将海量数据分散存储在多个节点上,以实现快速访问和处理。

2. MapReduceMapReduce是Hadoop的另一个核心组件,它是一种编程模型和处理数据的方式。

MapReduce将数据分成小的块,然后在分布式计算机集群上处理这些块。

MapReduce将任务分为Map和Reduce两个阶段。

在Map阶段,数据被分割并分配给不同的节点进行计算。

在Reduce阶段,计算的结果被合并起来并输出。

3. YARNHadoop资源管理器(YARN)是另一个重要的组件,它是一个分布式的集群管理系统,用于管理Hadoop集群中的资源。

YARN允许多个应用程序同时运行在同一个Hadoop集群上,通过动态管理资源来提高集群的使用效率。

二、Hadoop的方法1. 大数据存储Hadoop通过HDFS实现对海量数据的存储和管理。

HDFS的设计目标是支持大型数据集的分布式处理,它通过多个节点存储数据,提供高可靠性和高可用性。

2. 数据处理Hadoop通过MapReduce实现对海量数据的处理。

MapReduce 将数据分成小的块,然后在分布式计算机集群上处理这些块。

在Map阶段,数据被分割并分配给不同的节点进行计算。

在Reduce 阶段,计算的结果被合并起来并输出。

3. 数据分析Hadoop通过Hive、Pig和Spark等工具实现数据分析。

这些工具提供了高级查询和数据分析功能,可以通过SQL和其他编程语言来处理海量数据。

hadoop基本架构和工作原理

hadoop基本架构和工作原理Hadoop是一个分布式开源框架,用于处理海量数据。

它能够使用廉价的硬件来搭建集群,同时还提供了高度可靠性和容错性。

Hadoop基本架构包括Hadoop Common、Hadoop Distributed File System (HDFS)和Hadoop MapReduce三个部分,下面将详细介绍Hadoop的工作原理。

1. Hadoop CommonHadoop Common是整个Hadoop架构的基础部分,是一个共享库,它包含了大量的Java类和应用程序接口。

Hadoop集群的每一台机器上都要安装Hadoop Common,并保持相同版本。

2. HDFSHadoop Distributed File System(HDFS)是Hadoop的分布式文件存储部分。

它的目的是将大型数据集分成多个块,并且将这些块在集群中的多个节点间分布式存储。

HDFS可以实现高度可靠性,因为它将每个块在存储节点之间备份。

HDFS可以在不同的节点中进行数据备份,这确保了数据发生故障时,可以轻松恢复。

3. MapReduceHadoop MapReduce是一种编程模型,用于处理大型数据集。

它将处理任务分成两个主要阶段,即Map阶段和Reduce阶段。

在Map阶段,MapReduce将数据集分成小块,并将每个块分配给不同的节点进行处理。

在Reduce阶段,结果被聚合,以生成最终的输出结果。

总的来说,MapReduce作为Hadoop的核心组件,负责对数据集进行处理和计算。

它充当的角色是一个调度员,它会将不同的任务分发到集群中的不同节点上,并尽力保证每个任务都可以获得足够的计算资源。

Hadoop采用多种技术来提供MapReduce的分布式计算能力,其中包括TaskTracker、JobTracker和心跳机制等。

TaskTracker是每个集群节点的一个守护程序,负责处理MapReduce任务的具体实现。

hadoop的生态体系及各组件的用途

hadoop的生态体系及各组件的用途

Hadoop是一个生态体系,包括许多组件,以下是其核心组件和用途:

1. Hadoop Distributed File System (HDFS):这是Hadoop的分布式文件系统,用于存储大规模数据集。

它设计为高可靠性和高吞吐量,并能在低成本的通用硬件上运行。

通过流式数据访问,它提供高吞吐量应用程序数据访问功能,适合带有大型数据集的应用程序。

2. MapReduce:这是Hadoop的分布式计算框架,用于并行处理和分析大规模数据集。

MapReduce模型将数据处理任务分解为Map和Reduce两个阶段,从而在大量计算机组成的分布式并行环境中有效地处理数据。

3. YARN:这是Hadoop的资源管理和作业调度系统。

它负责管理集群资源、调度任务和监控应用程序。

4. Hive:这是一个基于Hadoop的数据仓库工具,提供SQL-like查询语言和数据仓库功能。

5. Kafka:这是一个高吞吐量的分布式消息队列系统,用于实时数据流的收集和传输。

6. Pig:这是一个用于大规模数据集的数据分析平台,提供类似SQL的查询语言和数据转换功能。

7. Ambari:这是一个Hadoop集群管理和监控工具,提供可视化界面和集群配置管理。

此外,HBase是一个分布式列存数据库,可以与Hadoop配合使用。

HBase 中保存的数据可以使用MapReduce来处理,它将数据存储和并行计算完美地结合在一起。

Hadoop MapReduce简介

Hadoop MapReduce简介本节首先简单介绍大数据批处理概念,然后介绍典型的批处理模式MapReduce,最后对Map 函数和Reduce 函数进行描述。

批处理模式批处理模式是一种最早进行大规模数据处理的模式。

批处理主要操作大规模静态数据集,并在整体数据处理完毕后返回结果。

批处理非常适合需要访问整个数据集合才能完成的计算工作。

例如,在计算总数和平均数时,必须将数据集作为一个整体加以处理,而不能将其视作多条记录的集合。

这些操作要求在计算进行过程中数据维持自己的状态。

需要处理大量数据的任务通常最适合用批处理模式进行处理,批处理系统在设计过程中就充分考虑了数据的量,可提供充足的处理资源。

由于批处理在应对大量持久数据方面的表现极为出色,因此经常被用于对历史数据进行分析。

为了提高处理效率,对大规模数据集进行批处理需要借助分布式并行程序。

传统的程序基本是以单指令、单数据流的方式按顺序执行的。

这种程序开发起来比较简单,符合人们的思维习惯,但是性能会受到单台计算机的性能的限制,很难在给定的时间内完成任务。

而分布式并行程序运行在大量计算机组成的集群上,可以同时利用多台计算机并发完成同一个数据处理任务,提高了处理效率,同时,可以通过增加新的计算机扩充集群的计算能力。

Google 最先实现了分布式并行处理模式MapReduce,并于2004 年以论文的方式对外公布了其工作原理,Hadoop MapReduce 是它的开源实现。

Hadoop MapReduce 运行在HDFS 上。

MapReduce 简释如图1 所示,如果我们想知道相当厚的一摞牌中有多少张红桃,最直观的方式就是一张张检查这些牌,并且数出有多少张是红桃。

这种方法的缺陷是速度太慢,特别是在牌的数量特别高的情况下,获取结果的时间会很长。

图1 找出有多少张红桃MapReduce 方法的规则如下。

∙把这摞牌分配给在座的所有玩家。

∙让每个玩家数自己手中的牌中有几张是红桃,然后把这个数目汇报上来。

HadoopMapReduce

hadoop是一种架构,用来搭建分布式平台使用。Mapreduce是一种分布式编程模型,是一种编程方法。

mapreduce是hadoop的核心组件之一hadoop要搭建分布式平台包括两部分一是分布式文件系统hdfs一部是分布式计算框架就是mapreduce缺一不可也就是说可以通过mapreduce很容易在hadoop平台上进行分布式的计算编程

HadoopMapReduce

hadoop是一种分布式系统的平台,通过它可以很轻的功能的极大扩充,包括Zookeeper,Hive,Hbase等。

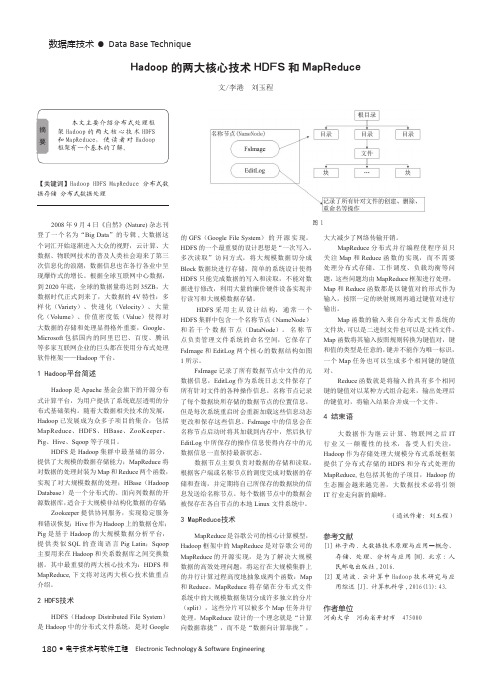

Hadoop的两大核心技术HDFS和MapReduce

180 •电子技术与软件工程 Electronic Technology & Software Engineering数据库技术• Data Base Technique【关键词】Hadoop HDFS MapReduce 分布式数据存储 分布式数据处理2008年9月4日《自然》(Nature)杂志刊登了一个名为“Big Data ”的专辑,大数据这个词汇开始逐渐进入大众的视野,云计算、大数据、物联网技术的普及人类社会迎来了第三次信息化的浪潮,数据信息也在各行各业中呈现爆炸式的增长。

根据全球互联网中心数据,到2020年底,全球的数据量将达到35ZB ,大数据时代正式到来了,大数据的4V 特性:多样化(Variety )、快速化(Velocity )、大量化(V olume )、价值密度低(Value )使得对大数据的存储和处理显得格外重要,Google 、Microsoft 包括国内的阿里巴巴、百度、腾讯等多家互联网企业的巨头都在使用分布式处理软件框架——Hadoop 平台。

1 Hadoop平台简述Hadoop 是Apache 基金会旗下的开源分布式计算平台,为用户提供了系统底层透明的分布式基础架构。

随着大数据相关技术的发展,Hadoop 已发展成为众多子项目的集合,包括MapReduce 、HDFS 、HBase 、ZooKeeper 、Pig 、Hive 、Sqoop 等子项目。

HDFS 是Hadoop 集群中最基础的部分,提供了大规模的数据存储能力;MapReduce 将对数据的处理封装为Map 和Reduce 两个函数,实现了对大规模数据的处理;HBase (Hadoop Database )是一个分布式的、面向列数据的开源数据库,适合于大规模非结构化数据的存储;Zookeeper 提供协同服务,实现稳定服务和错误恢复;Hive 作为Hadoop 上的数据仓库;Pig 是基于Hadoop 的大规模数据分析平台,提供类似SQL 的查询语言Pig Latin ;Sqoop 主要用来在Hadoop 和关系数据库之间交换数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Mapreduce和Hdfs的使用以

及原理

讲解员——吴杰

hadoop解决的两个问题•海量数据的存储---HDFS

•海量数据的分析---MapReduce

什么是HDFS •Hadoop Distributed File System,简称HDFS,是一个分布式文件系统。

HDFS是高容错性的,可以部署在低成本的硬件之上,HDFS提供高吞吐量地对应用程序数据访问,它适合大数据集的应用程序。

HDFS架构设计

HDFS使用

•hdfs管理

•安全模式

•添加节点

•节点故障

•负载均衡

MapReduce •MapReduce是Google提出的一个软件架构,用于大规模数据集(大于

1TB)的并行运算。

概念“Map(映射)”和“Reduce(化简)”,及他们的主要思想,都是从函数式编

程语言借来的,还有从矢量编程语

言借来的特性。

[1]当前的软件实现

是指定一个Map(映射)函数,用来把一组键值对映射成一组新的键值

对,指定并发的Reduce(化简)函数,用来保证所有映射的键值对中

的每一个共享相同的键组。

标题六

流程分析:

• 1.在客户端启动一个作业。

• 2.向JobTracker请求一个Job ID。

• 3.将运行作业所需要的资源文件复制到HDFS上,包括MapReduce程序打包的JAR文件、配置文件和客户端计

算所得的输入划分信息。

这些文件都存放在JobTracker专门为该作业创建的文件夹中。

文件夹名为该作业的Job ID。

JAR文件默认会有10个副本(mapred.submit.replication 属性控制);输入划分信息告诉了JobTracker应该为这个作业启动多少个map任务等信息。

流程分析

• 4.JobTracker接收到作业后,将其放在一个作业队列里,等待作业调度器对其进行调度(这里是不是很像微机中的进程调度呢,呵呵),当作业调度器根据自己的调度算法调度到该作业时,会根据输入划分信息为每个划分创建一个map任务,并将map任务分配给TaskTracker 执行。

对于map和reduce任务,TaskTracker根据主机核的数量和内存的大小有固定数量的map槽和reduce槽。

这里需要强调的是:map 任务不是随随便便地分配给某个TaskTracker的,这里有个概念叫:数据本地化(Data-Local)。

意思是:将map任务分配给含有该map 处理的数据块的TaskTracker上,同时将程序JAR包复制到该

TaskTracker上来运行,这叫“运算移动,数据不移动”。

而分配

reduce任务时并不考虑数据本地化。

• 5.TaskTracker每隔一段时间会给JobTracker发送一个心跳,告诉JobTracker它依然在运行,同时心跳中还携带着很多的信息,比如当前map任务完成的进度等信息。

当JobTracker收到作业的最后一个任务完成信息时,便把该作业设置成“成功”。

当JobClient查询状态时,它将得知任务已完成,便显示一条消息给用户。

谢谢。