Hadoop介绍+环境搭建

Hadoop环境搭建及wordcount实例运行

环境概述

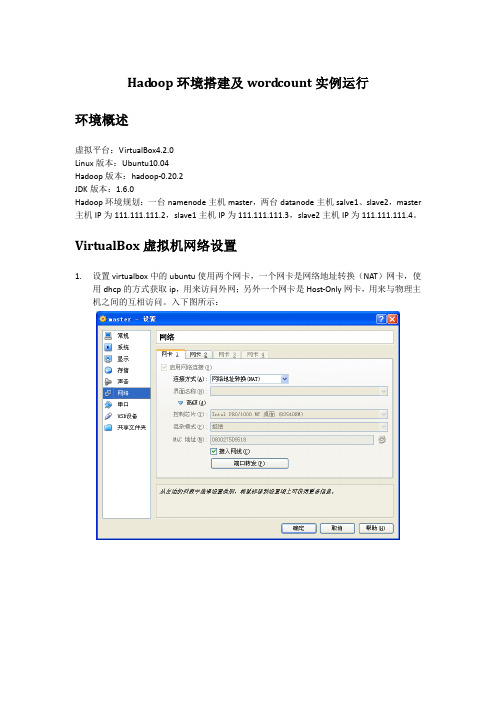

虚拟平台:VirtualBox4.2.0

Linux版本:Ubuntu10.04

Hadoop版本:hadoop-0.20.2

JDK版本:1.6.0

Hadoop环境规划:一台namenode主机master,两台datanode主机salve1、slave2,master主机IP为111.111.111.2,slave1主机IP为111.111.111.3,slave2主机IP为111.111.111.4。

ssh_5.3p1-3ubuntu3_all.deb

依次安装即可

dpkg -i openssh-client_5.3p1-3ubuntu3_i386.deb

dpkg -i openssh-server_5.3p1-3ubuntu3_i386.deb

dpkg -i ssh_5.3p1-3ubuntu3_all.deb

14/02/20 15:59:58 INFO mapred.JobClient: Running job: job_201402201551_0003

14/02/20 15:59:59 INFO mapred.JobClient: map 0% reduce 0%

14/02/20 16:00:07 INFO mapred.JobClient: map 100% reduce 0%

111.111.111.2 master

111.111.111.3 slave1

111.111.111.4 slave2

然后按以下步骤配置master到slave1之间的ssh信任关系

用户@主机:/执行目录

操作命令

说明

hadoop@master:/home/hadoop

hadoop核心组件概述及hadoop集群的搭建

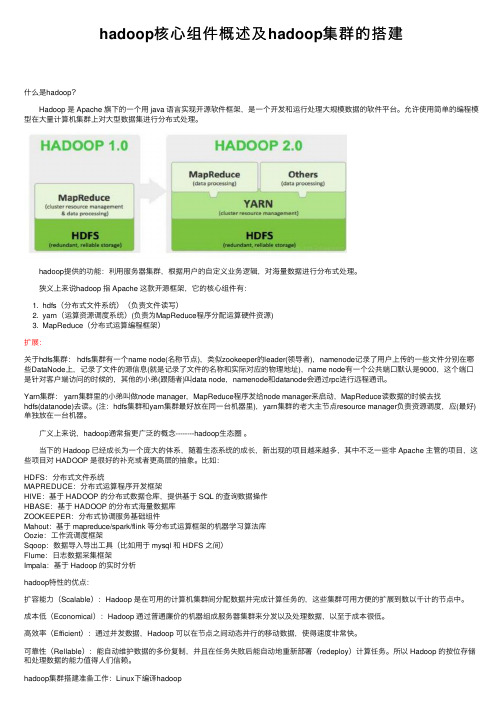

hadoop核⼼组件概述及hadoop集群的搭建什么是hadoop? Hadoop 是 Apache 旗下的⼀个⽤ java 语⾔实现开源软件框架,是⼀个开发和运⾏处理⼤规模数据的软件平台。

允许使⽤简单的编程模型在⼤量计算机集群上对⼤型数据集进⾏分布式处理。

hadoop提供的功能:利⽤服务器集群,根据⽤户的⾃定义业务逻辑,对海量数据进⾏分布式处理。

狭义上来说hadoop 指 Apache 这款开源框架,它的核⼼组件有:1. hdfs(分布式⽂件系统)(负责⽂件读写)2. yarn(运算资源调度系统)(负责为MapReduce程序分配运算硬件资源)3. MapReduce(分布式运算编程框架)扩展:关于hdfs集群: hdfs集群有⼀个name node(名称节点),类似zookeeper的leader(领导者),namenode记录了⽤户上传的⼀些⽂件分别在哪些DataNode上,记录了⽂件的源信息(就是记录了⽂件的名称和实际对应的物理地址),name node有⼀个公共端⼝默认是9000,这个端⼝是针对客户端访问的时候的,其他的⼩弟(跟随者)叫data node,namenode和datanode会通过rpc进⾏远程通讯。

Yarn集群: yarn集群⾥的⼩弟叫做node manager,MapReduce程序发给node manager来启动,MapReduce读数据的时候去找hdfs(datanode)去读。

(注:hdfs集群和yarn集群最好放在同⼀台机器⾥),yarn集群的⽼⼤主节点resource manager负责资源调度,应(最好)单独放在⼀台机器。

⼴义上来说,hadoop通常指更⼴泛的概念--------hadoop⽣态圈。

当下的 Hadoop 已经成长为⼀个庞⼤的体系,随着⽣态系统的成长,新出现的项⽬越来越多,其中不乏⼀些⾮ Apache 主管的项⽬,这些项⽬对 HADOOP 是很好的补充或者更⾼层的抽象。

基于Hadoop的大数据处理平台搭建与部署

基于Hadoop的大数据处理平台搭建与部署一、引言随着互联网和信息技术的快速发展,大数据已经成为当今社会中不可或缺的重要资源。

大数据处理平台的搭建与部署对于企业和组织来说至关重要,而Hadoop作为目前最流行的大数据处理框架之一,其搭建与部署显得尤为重要。

本文将介绍基于Hadoop的大数据处理平台搭建与部署的相关内容。

二、Hadoop简介Hadoop是一个开源的分布式存储和计算框架,能够高效地处理大规模数据。

它由Apache基金会开发,提供了一个可靠、可扩展的分布式系统基础架构,使用户能够在集群中使用简单的编程模型进行计算。

三、大数据处理平台搭建准备工作在搭建基于Hadoop的大数据处理平台之前,需要进行一些准备工作: 1. 硬件准备:选择合适的服务器硬件,包括计算节点、存储节点等。

2. 操作系统选择:通常选择Linux系统作为Hadoop集群的操作系统。

3. Java环境配置:Hadoop是基于Java开发的,需要安装和配置Java环境。

4. 网络配置:确保集群内各节点之间可以相互通信。

四、Hadoop集群搭建步骤1. 下载Hadoop从Apache官网下载最新版本的Hadoop压缩包,并解压到指定目录。

2. 配置Hadoop环境变量设置Hadoop的环境变量,包括JAVA_HOME、HADOOP_HOME等。

3. 配置Hadoop集群编辑Hadoop配置文件,包括core-site.xml、hdfs-site.xml、mapred-site.xml等,配置各个节点的角色和参数。

4. 启动Hadoop集群通过启动脚本启动Hadoop集群,可以使用start-all.sh脚本启动所有节点。

五、大数据处理平台部署1. 数据采集与清洗在搭建好Hadoop集群后,首先需要进行数据采集与清洗工作。

通过Flume等工具实现数据从不同来源的采集,并进行清洗和预处理。

2. 数据存储与管理Hadoop提供了分布式文件系统HDFS用于存储海量数据,同时可以使用HBase等数据库管理工具对数据进行管理。

Hadoop的安装与配置

Hadoop的安装与配置建立一个三台电脑的群组,操作系统均为Ubuntu,三个主机名分别为wjs1、wjs2、wjs3。

1、环境准备:所需要的软件及我使用的版本分别为:Hadoop版本为0.19.2,JDK版本为jdk-6u13-linux-i586.bin。

由于Hadoop要求所有机器上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户。

所以在三台主机上都设置一个用户名为“wjs”的账户,主目录为/home/wjs。

a、配置三台机器的网络文件分别在三台机器上执行:sudo gedit /etc/network/interfaceswjs1机器上执行:在文件尾添加:auto eth0iface eth0 inet staticaddress 192.168.137.2gateway 192.168.137.1netmask 255.255.255.0wjs2和wjs3机器上分别执行:在文件尾添加:auto eth1iface eth1 inet staticaddress 192.168.137.3(wjs3上是address 192.168.137.4)gateway 192.168.137.1netmask 255.255.255.0b、重启网络:sudo /etc/init.d/networking restart查看ip是否配置成功:ifconfig{注:为了便于“wjs”用户能够修改系统设置访问系统文件,最好把“wjs”用户设为sudoers(有root权限的用户),具体做法:用已有的sudoer登录系统,执行sudo visudo -f /etc/sudoers,并在此文件中添加以下一行:wjsALL=(ALL)ALL,保存并退出。

}c、修改三台机器的/etc/hosts,让彼此的主机名称和ip都能顺利解析,在/etc/hosts中添加:192.168.137.2 wjs1192.168.137.3 wjs2192.168.137.4 wjs3d、由于Hadoop需要通过ssh服务在各个节点之间登陆并运行服务,因此必须确保安装Hadoop的各个节点之间网络的畅通,网络畅通的标准是每台机器的主机名和IP地址能够被所有机器正确解析(包括它自己)。

搭建hadoop集群的步骤

搭建hadoop集群的步骤Hadoop是一个开源的分布式计算平台,用于存储和处理大规模的数据集。

在大数据时代,Hadoop已经成为了处理海量数据的标准工具之一。

在本文中,我们将介绍如何搭建一个Hadoop集群。

步骤一:准备工作在开始搭建Hadoop集群之前,需要进行一些准备工作。

首先,需要选择适合的机器作为集群节点。

通常情况下,需要至少三台机器来搭建一个Hadoop集群。

其次,需要安装Java环境和SSH服务。

最后,需要下载Hadoop的二进制安装包。

步骤二:配置Hadoop环境在准备工作完成之后,需要对Hadoop环境进行配置。

首先,需要编辑Hadoop的配置文件,包括core-site.xml、hdfs-site.xml、mapred-site.xml和yarn-site.xml。

其中,core-site.xml用于配置Hadoop的核心参数,hdfs-site.xml用于配置Hadoop分布式文件系统的参数,mapred-site.xml用于配置Hadoop的MapReduce参数,yarn-site.xml用于配置Hadoop的资源管理器参数。

其次,需要在每个节点上创建一个hadoop用户,并设置其密码。

最后,需要在每个节点上配置SSH免密码登录,以便于节点之间的通信。

步骤三:启动Hadoop集群在完成Hadoop环境的配置之后,可以启动Hadoop集群。

首先,需要启动Hadoop的NameNode和DataNode服务。

NameNode是Hadoop分布式文件系统的管理节点,负责管理文件系统的元数据。

DataNode是Hadoop分布式文件系统的存储节点,负责实际存储数据。

其次,需要启动Hadoop的ResourceManager和NodeManager服务。

ResourceManager 是Hadoop的资源管理器,负责管理集群中的资源。

NodeManager是Hadoop的节点管理器,负责管理每个节点的资源。

Hadoop 搭建

(与程序设计有关)

课程名称:云计算技术提高

实验题目:Hadoop搭建

Xx xx:0000000000

x x:xx

x x:

xxxx

2021年5月21日

实验目的及要求:

开源分布式计算架构Hadoop的搭建

软硬件环境:

Vmware一台计算机

算法或原理分析(实验内容):

Hadoop是Apache基金会旗下一个开源的分布式存储和分析计算平台,使用Java语言开发,具有很好的跨平台性,可以运行在商用(廉价)硬件上,用户无需了解分布式底层细节,就可以开发分布式程序,充分使用集群的高速计算和存储。

三.Hadoop的安装

1.安装并配置环境变量

进入官网进行下载hadoop-2.7.5, 将压缩包在/usr目录下解压利用tar -zxvf Hadoop-2.7.5.tar.gz命令。同样进入 vi /etc/profile 文件,设置相应的HADOOP_HOME、PATH在hadoop相应的绝对路径。

4.建立ssh无密码访问

二.JDK安装

1.下载JDK

利用yum list java-1.8*查看镜像列表;并利用yum install java-1.8.0-openjdk* -y安装

2.配置环境变量

利用vi /etc/profile文件配置环境,设置相应的JAVA_HOME、JRE_HOME、PATH、CLASSPATH的绝对路径。退出后,使用source /etc/profile使环境变量生效。利用java -version可以测试安装是否成功。

3.关闭防火墙并设置时间同步

通过命令firewall-cmd–state查看防火墙运行状态;利用systemctl stop firewalld.service关闭防火墙;最后使用systemctl disable firewalld.service禁止自启。利用yum install ntp下载相关组件,利用date命令测试

《hadoop基础》课件——第三章 Hadoop集群的搭建及配置

19

Hadoop集群—文件监控

http://master:50070

20

Hadoop集群—文件监控

http://master:50070

21

Hadoop集群—文件监控

http://master:50070

22

Hadoop集群—任务监控

http://master:8088

23

Hadoop集群—日志监控

http://master:19888

24

Hadoop集群—问题 1.集群节点相关服务没有启动?

1. 检查对应机器防火墙状态; 2. 检查对应机器的时间是否与主节点同步;

25

Hadoop集群—问题

2.集群状态不一致,clusterID不一致? 1. 删除/data.dir配置的目录; 2. 重新执行hadoop格式化;

准备工作:

1.Linux操作系统搭建完好。 2.PC机、服务器、环境正常。 3.搭建Hadoop需要的软件包(hadoop-2.7.6、jdk1.8.0_171)。 4.搭建三台虚拟机。(master、node1、node2)

存储采用分布式文件系统 HDFS,而且,HDFS的名称 节点和数据节点位于不同机 器上。

2、vim编辑core-site.xml,修改以下配置: <property>

<name>fs.defaultFS</name> <value>hdfs://master:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/opt/soft/hadoop-2.7.6/tmp</value> </property> <property> <name>fs.trash.interval</name> <value>1440</value> </property>

Hadoop集群的搭建方法与步骤

Hadoop集群的搭建方法与步骤随着大数据时代的到来,Hadoop作为一种分布式计算框架,被广泛应用于数据处理和分析领域。

搭建一个高效稳定的Hadoop集群对于数据科学家和工程师来说至关重要。

本文将介绍Hadoop集群的搭建方法与步骤。

一、硬件准备在搭建Hadoop集群之前,首先要准备好适合的硬件设备。

Hadoop集群通常需要至少三台服务器,一台用于NameNode,两台用于DataNode。

每台服务器的配置应该具备足够的内存和存储空间,以及稳定的网络连接。

二、操作系统安装在选择操作系统时,通常推荐使用Linux发行版,如Ubuntu、CentOS等。

这些操作系统具有良好的稳定性和兼容性,并且有大量的Hadoop安装和配置文档可供参考。

安装操作系统后,确保所有服务器上的软件包都是最新的。

三、Java环境配置Hadoop是基于Java开发的,因此在搭建Hadoop集群之前,需要在所有服务器上配置Java环境。

下载最新版本的Java Development Kit(JDK),并按照官方文档的指引进行安装和配置。

确保JAVA_HOME环境变量已正确设置,并且可以在所有服务器上运行Java命令。

四、Hadoop安装与配置1. 下载Hadoop从Hadoop官方网站上下载最新的稳定版本,并将其解压到一个合适的目录下,例如/opt/hadoop。

2. 编辑配置文件进入Hadoop的安装目录,编辑conf目录下的hadoop-env.sh文件,设置JAVA_HOME环境变量为Java的安装路径。

然后,编辑core-site.xml文件,配置Hadoop的核心参数,如文件系统的默认URI和临时目录。

接下来,编辑hdfs-site.xml文件,配置Hadoop分布式文件系统(HDFS)的相关参数,如副本数量和数据块大小。

最后,编辑mapred-site.xml文件,配置MapReduce框架的相关参数,如任务调度器和本地任务运行模式。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

问题:节点失效是常态!

• DataNode中的磁盘挂了怎么办? • DataNode所在机器挂了怎么办? • NameNode挂了怎么办? • Client挂了怎么办?

DataNode的磁盘挂了怎么办?

• DataNode正常服务 • 坏掉的磁盘上的数据尽快通知NameNode

DataNode所在机器挂了怎么办?

• ②软件环境 软件统一安装在虚拟机系统VMware上, Linux系统采用Ubuntu,jdk使用jdk1.6.0 版,Hadoop使用hadoop-0.20.2版本。

2.准备工作

• ①虚拟机VMware的安装 下载安装软件并分别在3台机器上安装。由 于3台机器的某盘剩余空间都较大,统一将 VMware安装在某盘上,分配磁盘空间时统 一分配为10G。

• ② Ubuntu的安装 新建虚拟机,加载Linux系统Ubuntu的iso镜 像文件,并在VMware环境下安装Ubuntu 系统。

在《hadoop the definate guide》的P227的 “secondary sort”章节中,以<year,temperature>为例, 在map阶段按照year来分发temperature,在reduce阶段 按照同一year对应的temperature大小排序。

MapReduce

• 问:NameNode怎么知道DataNode挂掉了 ?

• 答:datanode每3秒钟向namenode发送心 跳,如果10分钟datanode没有向 namenode发送心跳,则namenode认为该 datanode已经dead,namenode将取出该 datanode上对应的block,对其进行复制。

• 高效。通过分配数据,Hadoop能够在存放数据的节点之 间平行的处理它们,因此其处理速度非常快。

• 可信。Hadoop能够自动保存数据的多份副本,并且能够 自动地将失败的任务重新分配

谢谢!

Hadoop环境搭建

1.安装环境

• ①硬件环境 实验共使用三台PC机,一台机器用作 NameNode,另两台用作DateNode。

HDFS:文件读取流程图

HDFS client

1:open 3:read

6:close

client JVM

client node

Distributed FileSystem

FSData InputStream

4:read

2:get block locations

NameNode namenode

5:read

DataNode datanode

DataNode datanode

DataNode datanode

HDFS:文件写入流程图

HDFS client

1:create 3:write

6:close

client JVM

client node

Distributed FileSystem

FSData InputStream

Namenode是一个中心服务 器,负责管理文件系统的名 字空间和客户端对文件的访 问。

Datanode在集群中一般是一 个节点一个,负责管理它所在 节点上的存储。

HDFS:Namenode 和 Datanode

HDFS把节点分为两类:Namenode和Datanode。 Namenode是唯一的,程序与之通信,然后从Datanode上

独立的数据块,由Map任务(Task)以完全并行的方式处 理它们 • MapReduce框架会先排序map任务的输出,然后把结果 输入到reduce任务

• 通常计算结点和存储结点是同一个结点,也就是说 MapReduce框架和HDFS是运行在相同的结点集上。

• MapReduce框架是由一个单独运行在主结点的 JobTracker和运行在每个集群从结点的TaskTracker(任 务跟踪)共同构成。

4.HDFS基本结构

HDFS基本储存单元——

Block(数据块)

一个文件有可能包含多个块,一个块有可以包含多个文件,由 文件的大小和块大小的参数决定。

HDFS结构特点

HDFS是一个大规模的分布式文件系统,采用master/slave架构。 一个HDFS集群是有一个Namenode和一定数目的Datanode组成。

3.Hadoop分布式文件系统(HDFS)简介

Hadoop也跟其他云计算项目有共同点和目标:实现海量数 据的计算。而进行海量计算需要一个稳定的、安全的数据容器, 于是就有了Hadoop分布式文件系统(HDFS)。

Hadoop 分布式文件系统是具有高可靠性和高可扩展性的 分布式文件系统,能够提供海量的文件存储能力。它的开发 和实现遵循了Google 文件系统(GFS)的核心原理,受到 了业界极大关注,并已被广泛应用。

MapReduce

举例:WordCount的Map 过程 WordCount的Reduce 过程

举例:事例MapReduce过程

Hadoop优势:

• 可扩展。不论是存储的可扩展还是计算的可扩展都是 Hadoop的设计根本。

• 经济。它在通常可用的计算机集簇间分配数据和处理,这 些集簇可以被计入数以千计的节点当中

HDFS:数据复制

HDFS被设计成能够在一个大集群中跨机器可靠地存储超大文 件。它将每个文件存储成一系列的数据块,除了最后一个,所有 的数据块都是同样大小的。

为了容错,文件的所有数据块都要备份有副本。每个文件的数 据块大小和副本数目都是可配置的。应用程序可以指定某个文件 的副本系数。

HDFS:数据复制

• Secondary NameNode

– 将NameNode的fsimage (HDFS元数据镜像文件 )与edit log(HDFS文件改动日志)从Namenode 复制到临时目录

– 将fsimage同edit log合并,并产生新的fsimage ( 减少启动时间)

– 将产生的新的fsimage上传给NameNode – 清除NameNode中的edit log

注:可以修改compareTo来实现自己所需的比较算法

MapReduce的二次排序

Hadoop的MapReduce模型支持基于key的排序, 即在一次MapReduce之后,结果都是按照key的大小排序 的。但是在很多应用情况下,我们需要对映射在一个key 下的value集合进行排序,即“secondary sort”。

1.Hadoop概述

Hadoop是一个分布式系统基础架构,是一个能够对大量 数据进行分布式处理的软件框架,由Apache基金会开发。 用户可以在不了解分布式底层细节的情况下,开发分布式程 序,充分利用集群的的威力高速运算和存储。

Hadoop框架中最核心的设计就是:MapReduce和HDFS。

Hadoop程序目前大多运行在Linux系统上,windows上运行 需要安装其他插件(Cygwin)。

Map/Reduce 数据流程

• Input • Split (可缺省,由系统完成) • Recordreader (可缺省,由系统完成) • Mapper • Combiner (可缺省) • Shuffler(partitionner)(可缺省,由系统完成) • Sort (可缺省,由系统完成) • Reducer (可缺省) • Output

[注]: Secondary NameNode仅仅对NameNode中 元数据提供冷备方案

Secondary NameNode

辅助NN处理FsImage和事务日志 1、从NN拷贝FsImage和事务日志到临时目录 2、合并FsImage和事务日志生成一个新的FsImage 3、上传新的FsImage到NN上 4、NN更新FsImage并清理原来的事务日志

• Map-Reduce 计算模型的实现 – 大规模数据处理的框架 • 所有数据作为KEY-VALUE对进行处理 – 嵌入用户数据处理程序

• 简单计算模型,但可以处理很多不同类型的问题 – 日志数据处理 – 搜索引擎

Hadoop Map-Reduce

对于任务处理的两步: • 一个MapReduce作业(Jop)通常会把输入集切分成若干

HDFS集群框架图

5.HDFS的文件操作

HDFS:文件读取和写入基本过程

读取文件: • Client向NameNode发起文件读取的请求 • NameNode返回文件存储的DataNode的信息 • Client读取文件信息 写入文件: • Client向NameNode发起文件写入的请求 • NameNode根据文件大小和文件块配置情况返回给Client它 所管理部分DataNode的信息 • Client将文件划分为多个文件块,根据DataNode的地址信息 按顺序写入到每一个DataNode块中

MapReduce处理

MapReduce物理上处理过程

MapReduce

MapReduce的key排序逻辑

MapReduce本身Key的数据类型的排序逻辑其实就是依 赖于Hadoop本身的继承与WritableComparable<T>的基本数 据类型和其他类型(相关类型可参考《Hadoop权威指南》第二 版的90页)的compareTo方法的定义。 Key排序的规则:

4:write packet

5:Байду номын сангаасck packet

2:create 7:complete

NameNode namenode

4:

4:

Pipeline of

DataNode

DataNode

DataNode

datanodes

5:

5:

datanode

datanode

datanode

HDFS中的文件都是一次性写入的,并且严格要求在任何时候 只能有一个写入者。