hadoop的运行环境配置

Hadoop的配置及运行WordCount

Hadoop的配置及运行WordCount目录Hadoop的配置及运行WordCount (1)一、环境: (1)二、步骤: (1)1 JDK及SSH安装配置: (1)1.1 卸载Fedora自带的OpenJDK,安装Oracle的JDK (1)1.2 配置SSH (2)2 Hadoop安装配置: (4)2.1 下载并配置Hadoop的JDK环境 (4)2.2 为系统配置Hadoop环境变量 (5)2.3 修改Hadoop的配置文件 (6)2.4 初始化HDFS文件系统,和启动Hadoop (8)2.5 关闭HDFS (11)3 运行WordCount: (11)3.1 下载和编译WordCount示例 (11)3.2 建立文本文件并上传至DFS (13)3.3 MapReduce执行过程显示信息 (14)结尾: (15)一、环境:计算机Fedora 20、jdk1.7.0_60、Hadoop-2.2.0二、步骤:1 JDK及SSH安装配置:1.1 卸载Fedora自带的OpenJDK,安装Oracle的JDK*由于Hadoop,无法使用OpenJDK,所以的下载安装Oracle的JDK。

1.1.1、以下为卸载再带的OpenJDK:然后到/technetwork/java/javase/downloads/index.html下载jdk,可以下载rpm格式的安装包或解压版的。

rpm版本的下载完毕后可以运行安装,一般会自动安装在/usr/java/的路径下面。

接下来就配置jdk的环境变量了。

1.1.2、进入到系统的环境变量配置文件,加入以下内容:(按i进行编辑,编辑完毕按ESC,输入:wq,回车即保存退出)截图如下:Java环境变量配置输入这个回车即可保存退出java –version,检测配置是否成功。

如下结果则Java 配置安装成功。

1.2 配置SSH搭建hadoop分布式集群平台,为了实现通讯之间的可靠,防止远程管理过程中的信息泄露问题。

Hadoop环境配置与实验报告

李富豪

Байду номын сангаас

学号

131440

计算机新技术综合实践

2014 年 4 月 至 2014 年 6 月 周学时 1 学分 2

简

(1) 小组答辩过程表述很清晰;

要

(2) 实验结果的演示表明搭建的系统以及编写的程序很好地满

评

足功能要求;

(3) 报告内容很好地符合要求。

语

考核论题 总评成绩 (含平时成绩)

备注

任课教师签名:

3 Java 环境安装 ...................................................................................................................... 9 3.1 安装 JDK ...................................................................................................................... 10 3.2 配置环境变量 ............................................................................................................. 10 3.2.1 编辑"/etc/profile"文件 ........................................................................................ 10 3.2.2 添加 Java 环境变量 ............................................................................................. 10 3.2.3 使配置生效.......................................................................................................... 10 3.3 验证安装成功 ............................................................................................................. 10 3.4 安装剩余机器 ............................................................................................................. 11

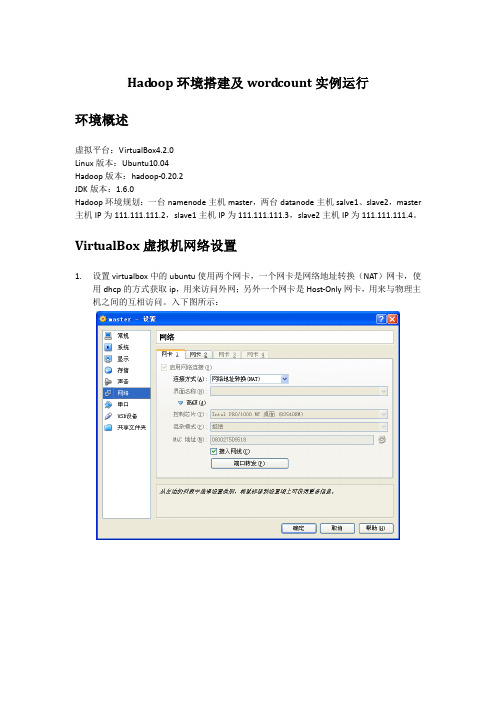

Hadoop环境搭建及wordcount实例运行

环境概述

虚拟平台:VirtualBox4.2.0

Linux版本:Ubuntu10.04

Hadoop版本:hadoop-0.20.2

JDK版本:1.6.0

Hadoop环境规划:一台namenode主机master,两台datanode主机salve1、slave2,master主机IP为111.111.111.2,slave1主机IP为111.111.111.3,slave2主机IP为111.111.111.4。

ssh_5.3p1-3ubuntu3_all.deb

依次安装即可

dpkg -i openssh-client_5.3p1-3ubuntu3_i386.deb

dpkg -i openssh-server_5.3p1-3ubuntu3_i386.deb

dpkg -i ssh_5.3p1-3ubuntu3_all.deb

14/02/20 15:59:58 INFO mapred.JobClient: Running job: job_201402201551_0003

14/02/20 15:59:59 INFO mapred.JobClient: map 0% reduce 0%

14/02/20 16:00:07 INFO mapred.JobClient: map 100% reduce 0%

111.111.111.2 master

111.111.111.3 slave1

111.111.111.4 slave2

然后按以下步骤配置master到slave1之间的ssh信任关系

用户@主机:/执行目录

操作命令

说明

hadoop@master:/home/hadoop

hadoop环境配置以及hadoop伪分布式安装实训目的

Hadoop环境配置以及Hadoop伪分布式安装是用于学习和实践大数据处理和分析的重要步骤。

下面将详细解释配置Hadoop环境以及安装Hadoop伪分布式的目的。

一、Hadoop环境配置配置Hadoop环境是为了在实际的硬件或虚拟机环境中搭建Hadoop集群,包括安装和配置Hadoop的各个组件,如HDFS(Hadoop分布式文件系统)、MapReduce(一种编程模型和运行环境)等。

这个过程涉及到网络设置、操作系统配置、软件安装和配置等步骤。

通过这个过程,用户可以了解Hadoop的基本架构和工作原理,为后续的学习和实践打下基础。

二、Hadoop伪分布式安装Hadoop伪分布式安装是一种模拟分布式环境的方法,它可以在一台或多台机器上模拟多个节点,从而在单机上测试Hadoop的各个组件。

通过这种方式,用户可以更好地理解Hadoop 如何在多台机器上协同工作,以及如何处理大规模数据。

安装Hadoop伪分布式的主要目的如下:1. 理解Hadoop的工作原理:通过在单机上模拟多个节点,用户可以更好地理解Hadoop如何在多台机器上处理数据,以及如何使用MapReduce模型进行数据处理。

2. 练习Hadoop编程:通过在单机上模拟多个节点,用户可以编写和测试Hadoop的MapReduce程序,并理解这些程序如何在单机上运行,从而更好地理解和学习Hadoop编程模型。

3. 开发和调试Hadoop应用程序:通过在单机上模拟分布式环境,用户可以在没有真实数据的情况下开发和调试Hadoop应用程序,从而提高开发和调试效率。

4. 为真实环境做准备:一旦熟悉了Hadoop的伪分布式环境,用户就可以逐渐将知识应用到真实环境中,例如添加更多的实际节点,并开始处理实际的大规模数据。

总的来说,学习和实践Hadoop环境配置以及Hadoop伪分布式安装,对于学习和实践大数据处理和分析具有重要意义。

它可以帮助用户更好地理解和学习Hadoop的工作原理和编程模型,为将来在实际环境中应用和优化Hadoop打下坚实的基础。

Hadoop的安装与配置

Hadoop的安装与配置建立一个三台电脑的群组,操作系统均为Ubuntu,三个主机名分别为wjs1、wjs2、wjs3。

1、环境准备:所需要的软件及我使用的版本分别为:Hadoop版本为0.19.2,JDK版本为jdk-6u13-linux-i586.bin。

由于Hadoop要求所有机器上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户。

所以在三台主机上都设置一个用户名为“wjs”的账户,主目录为/home/wjs。

a、配置三台机器的网络文件分别在三台机器上执行:sudo gedit /etc/network/interfaceswjs1机器上执行:在文件尾添加:auto eth0iface eth0 inet staticaddress 192.168.137.2gateway 192.168.137.1netmask 255.255.255.0wjs2和wjs3机器上分别执行:在文件尾添加:auto eth1iface eth1 inet staticaddress 192.168.137.3(wjs3上是address 192.168.137.4)gateway 192.168.137.1netmask 255.255.255.0b、重启网络:sudo /etc/init.d/networking restart查看ip是否配置成功:ifconfig{注:为了便于“wjs”用户能够修改系统设置访问系统文件,最好把“wjs”用户设为sudoers(有root权限的用户),具体做法:用已有的sudoer登录系统,执行sudo visudo -f /etc/sudoers,并在此文件中添加以下一行:wjsALL=(ALL)ALL,保存并退出。

}c、修改三台机器的/etc/hosts,让彼此的主机名称和ip都能顺利解析,在/etc/hosts中添加:192.168.137.2 wjs1192.168.137.3 wjs2192.168.137.4 wjs3d、由于Hadoop需要通过ssh服务在各个节点之间登陆并运行服务,因此必须确保安装Hadoop的各个节点之间网络的畅通,网络畅通的标准是每台机器的主机名和IP地址能够被所有机器正确解析(包括它自己)。

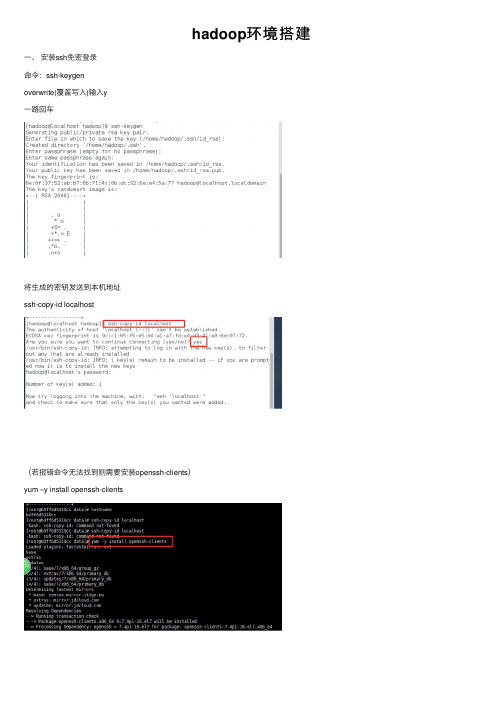

hadoop环境搭建

hadoop环境搭建⼀、安装ssh免密登录命令:ssh-keygenoverwrite(覆盖写⼊)输⼊y⼀路回车将⽣成的密钥发送到本机地址ssh-copy-id localhost(若报错命令⽆法找到则需要安装openssh-clients)yum –y install openssh-clients测试免密设置是否成功ssh localhost⼆、卸载已有java确定JDK版本rpm –qa | grep jdkrpm –qa | grep gcj切换到root⽤户,根据结果卸载javayum -y remove java-1.8.0-openjdk-headless.x86_64 yum -y remove java-1.7.0-openjdk-headless.x86_64卸载后输⼊java –version查看三、安装java切换回hadoop⽤户,命令:su hadoop查看下当前⽬标⽂件,命令:ls将桌⾯的hadoop⽂件夹中的java及hadoop安装包移动到app⽂件夹中命令:mv /home/hadoop/Desktop/hadoop/jdk-8u141-linux-x64.gz /home/hadoop/app mv /home/hadoop/Desktop/hadoop/hadoop-2.7.0.tar.gz /home/hadoop/app解压java程序包,命令:tar –zxvf jdk-7u79-linux-x64.tar.gz创建软连接ln –s jdk1.8.0_141 jdk配置jdk环境变量切换到root⽤户再输⼊vi /etc/profile输⼊export JAVA_HOME=/home/hadoop/app/jdk1.8.0_141export JAVA_JRE=JAVA_HOME/jreexport CLASSPATH=.:$JAVA_HOME/lib:$JAVA_JRE/lib export PATH=$PATH:$JAVA_HOME/bin保存退出,并使/etc/profile⽂件⽣效source /etc/profile能查询jdk版本号,说明jdk安装成功java -version四、安装hadoop切换回hadoop⽤户,解压缩hadoop-2.6.0.tar.gz安装包创建软连接,命令:ln -s hadoop-2.7.0 hadoop验证单机模式的Hadoop是否安装成功,命令:hadoop/bin/hadoop version此时可以查看到Hadoop安装版本为Hadoop2.7.0,说明单机版安装成功。

Hadoop 搭建

(与程序设计有关)

课程名称:云计算技术提高

实验题目:Hadoop搭建

Xx xx:0000000000

x x:xx

x x:

xxxx

2021年5月21日

实验目的及要求:

开源分布式计算架构Hadoop的搭建

软硬件环境:

Vmware一台计算机

算法或原理分析(实验内容):

Hadoop是Apache基金会旗下一个开源的分布式存储和分析计算平台,使用Java语言开发,具有很好的跨平台性,可以运行在商用(廉价)硬件上,用户无需了解分布式底层细节,就可以开发分布式程序,充分使用集群的高速计算和存储。

三.Hadoop的安装

1.安装并配置环境变量

进入官网进行下载hadoop-2.7.5, 将压缩包在/usr目录下解压利用tar -zxvf Hadoop-2.7.5.tar.gz命令。同样进入 vi /etc/profile 文件,设置相应的HADOOP_HOME、PATH在hadoop相应的绝对路径。

4.建立ssh无密码访问

二.JDK安装

1.下载JDK

利用yum list java-1.8*查看镜像列表;并利用yum install java-1.8.0-openjdk* -y安装

2.配置环境变量

利用vi /etc/profile文件配置环境,设置相应的JAVA_HOME、JRE_HOME、PATH、CLASSPATH的绝对路径。退出后,使用source /etc/profile使环境变量生效。利用java -version可以测试安装是否成功。

3.关闭防火墙并设置时间同步

通过命令firewall-cmd–state查看防火墙运行状态;利用systemctl stop firewalld.service关闭防火墙;最后使用systemctl disable firewalld.service禁止自启。利用yum install ntp下载相关组件,利用date命令测试

Hadoop集群配置心得(低配置集群+自动同步配置)

Hadoop集群配置⼼得(低配置集群+⾃动同步配置)本⽂为本⼈原创,⾸发到炼数成⾦。

情况是这样的,我没有⼀个⾮常强劲的电脑来搞出⼀个性能⾮常NB的服务器集群,相信很多⼈也跟我差不多,所以现在把我的低配置集群经验拿出来写⼀下好了。

我的配备:1)五六年前的赛扬单核处理器2G内存笔记本 2)公司给配的ThinkpadT420,i5双核处理器4G内存(可⽤内存只有3.4G,是因为装的是32位系统的缘故吧。

)就算是⽤公司配置的电脑,做出来三台1G内存的虚拟机也显然是不现实的。

企业笔记本运⾏的软件多啊,什么都不做空余内存也才不到3G。

所以呢,我的想法就是:⽤我⾃⼰的笔记本(简称PC1)做Master节点,⽤来跑Jobtracker,Namenode 和SecondaryNamenode;⽤公司的笔记本跑两个虚拟机(简称VM1和VM2),⽤来做Slave节点,跑Tasktracker和Datanode。

这么做的话,就需要让PC1,VM1和VM2处于同⼀个⽹段⾥,保证他们之间可以互相连通。

⽹络环境:我的两台电脑都是通过⼀个⽆线路由上⽹。

构建跟外部的电脑同⼀⽹段的虚拟机配置过程:准备⼯作:构建⼀个集群,⾸先前提条件是每台服务器都要有⼀个固定的IP地址,然后才可能进⾏后续的操作。

所以呢,先把我的两台笔记本电脑全部设置成固定IP(注意,如果像我⼀样使⽤⽆线路由上⽹,那就要把⽆线⽹卡的IP设置成固定IP)。

⽤来做Master节点的PC1:192.168.33.150,⽤来跑虚拟机的宿主笔记本:192.168.33.157。

⽬标:VM1和VM2的IP地址分别设置成192.168.33.151和152。

步骤:1)新建VM1虚拟机。

2)打开VM1的⽹卡设置界⾯,连接⽅式选Bridge。

(桥接)关于桥接的具体信息,可以百度⼀下。

我们需要知道的,就是⽤桥接的⽅式,可以让虚拟机通过本机的⽹关来上⽹,所以就可以跟本机处于同⼀个⽹段,互相之间可以进⾏通信。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

4.2配置Slave机器上的Hadoop

现在在Master机器上的Hadoop配置就结束 了,剩下的就是配置Slave机器上的Hadoop。

一种方式 是按照上面的步骤,把Hadoop的安装包在用普通用户 hadoop通过"scp"复制到其他机器的"/home/hadoop"目 录下,然后根据实际情况进行安装配置 另一种方式 是将 Master上配置好的hadoop所在文件夹 "/usr/hadoop"复制到所有的Slave的"/usr"目录下

4.4网页查看集群

用"hadoop dfsadmin -report"查看Hadoop集群的状态。

网页查看集群 访问"http:192.168.1.120:50030“ mapreduce的web页面 访问"http:192.168.1.120:50070" hdfs的web页面

5运行程序步骤

首先启动hadoop,把jar包放到指定位置 通过hadoop的命令在HDFS上创建/tmp/work 目录(本次所需) 通过copyFromLocal命令把本地的word.txt复 制到HDFS上 通过命令运行例子,主要是指定jar程序包, 需要统计的数据文件和结果存放的文件 查看运行结果

4.3Hadoop启动及验证

格式化HDFS文件系统

只需一次,下次启动不再需要格式化

启动hadoop(启动前关闭所有机器的防火墙)

可以一次全部启动所有的节点

service iptables stop start-all.sh

或是分别启动namenode、 datanode、 tasktracker 、secondarynamenode 、 jobtracker 验证hadoop

127.0.0.1 localhost 192.168.1.120 ubuntu1 192.168.1.121 ubuntu2 192.168.1.122 ubuntu3 192.168.1.123 ubuntu4

1.3hadoop的主从节点结构分解

2环境说明和安装配置SSH

2.1在所有的机器上建立相同的用户 对每个系统进行系统名和ip地址的配置

4.1配置文件

配置masters文件 第一种:修改localhost为Master.Hadoop 第二种:去掉"localhost",加入Master机器的IP: 192.168.1.121 配置slaves文件(Master主机特有)

第一种:去掉"localhost",每行只添加一个主机名, 把剩余的Slave主机名都填上。 第二种:去掉"localhost",加入集群中所有Slave 机器的IP,也是每行一个。

SSH配置

这就必须在节点之间执行指令的时候是不需要输 入密码的形式,故我们需要配置SSH运用无密码公 钥认证的形式,这样NameNode使用SSH无密码登录 并启动DataName进程,同样原理,DataNode上也 能使用SSH无密码登录到NameNode。

在用户目录下建立ssh的安装目录,之后设置权限 Master机器上生成无密码密码对,追加权限

SSH安装配置

2 .2安装配置SSH 安装和启动SSH协议

yum install ssh 安装SSH协议 yum install rsync service sshd restart 启动服务

配置Master无密码登录所有Salve Hadoop运行过程中需要管理远端Hadoop守护 进程,在Hadoop启动以后,NameNode是通的。

和Master无密码登录所有Slave原理一样,就是把 Slave的公钥追加到Master的".ssh"文件夹下的 "authorized_keys"中 这样就建立了Master和Slave之间的无密码验证相 互登录

3 jdk安装配置

安装jdk1.6.45 环境变量配置

编辑"/etc/profile"文件,在后面添加Java的"JAVA_HOME"、 "CLASSPATH"以及"PATH"内容。

注意:目录要设成700 有执行权限 authorized_keys要设成600 否则会出错 还有ssh 登陆要加入用户名的

SSH配置

用root用户登录服务器修改SSH配置文件 /etc/ssh/sshd_config,无密码登录本级已经设 置完毕,接下来的事儿是把公钥复制所有的Slave 机器上

配置所有Slave无密码登录Master

export JAVA_HOME=/usr/java/jdk1.6.0_31 export CLASSPATH=.:$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/lib export PATH=$PATH:$JAVA_HOME/bin:$JAVA_HOME/jre/bin

必须在所有的机器上建立相同的用户,设置每个系统 的ip地址。

2.2配置NameNode和DataNode 配置hosts文件

修改每台机器的/etc/hosts(包括namenode和datanode) ) 127.0.0.1 localhost 192.168.1.120 ubuntu1 192.168.1.121 ubuntu2 192.168.1.122 ubuntu3 192.168.1.123 ubuntu4

使配置生效 (重要) source /etc/profile 验证 Slave安装jdk: Master下的JDK复制到其他Slave的/home/hadoop/下面剩下 的事儿就是在其余的Slave服务器上按照步骤安装JDK。

4 Hadoop集群安装配置

首先在namenode上配置,配置后在分发到datanode上 在“/usr/hadoop”下面创建tmp文件夹

安装

把"/usr/hadoop"读权限分配给hadoop用户

配置hadoop

配置hadoop-env.sh 使得能够找到java的路径 export HADOOP_HOME=/usr/hadoop export JAVA_HOME=/usr/java/jdk1.6.0_29

4.1配置文件

配置文件也被分成了三个core-site.xml、 hdfs-site.xml、mapred-site.xml。 修改Hadoop核心配置文件core-site.xml, 这里配置的是HDFS的地址和端口号。 修改Hadoop中HDFS的配置hdfs-site.xml。 (就是Slave的台数默认3个) 修改Hadoop中MapReduce的配置文件mapredsite.xml, 配置的是JobTracker的地址和端口。

基于Hadoop平台 的并行编程实践

李东秀

内容介绍

熟悉hadoop配置环境 搭建实验 平台 编写 (矩阵相乘)运算的 map, reduce函数 在hadoop实验 平台上实现 配置计算环境: 1个Master、3个Slave的 Hadoop集群

1.1 Hadoop简介

Apache软件基金会下的一个开源分布式计算平台 以Hadoop的HDFS和MapReduce为核心的Hadoop为用 户提供了系统底层细节透明的分布式基础架构。 对于Hadoop的集群来讲,可以分成两大类角色: Master和Salve。 一个HDFS集群是由一个NameNode和若干个 DataNode组成的。 MapReduce框架是由一个单独运行在主节点上的 JobTracker和运行在每个集群从节点的TaskTracker 共同组成的。

1.2环境说明

HDFS在MapReduce任务处理过程中提供了文件操作 和存储等支持,MapReduce在HDFS的基础上实现了任务 的分发、跟踪、执行等工作,并收集结果,二者相互 作用,完成了Hadoop分布式集群的主要任务。 集群中包括4个节点:1个Master,3个Salve,节点IP 地址分布如下: