斯坦福大学机器学习公开课课件 Lecture7

斯坦福大学机器学习第七讲Lecture7.

The problem ofoverfittingMachine LearningExample: Linear regression (housing pricesOverfitting:If we have too many features, the learned hypothesis to generalize to new examples (predict prices on new examples.P r i c eSize P r i c eSize P r i c eSizeExample: Logistic regression( = sigmoid function x1x2x1x2x1x2PriceSize size of houseno. of bedroomsno. of floorsage of houseaverage income in neighborhoodkitchen sizeOptions:1.Reduce number of features.―Manually select which features to keep.―Model selection algorithm (later in course.2.Regularization.―Keep all the features, but reduce magnitude/values of parameters .―Works well when we have a lot of features, each of which contributes a bit to predicting .Cost functionMachine LearningIntuitionSuppose we penalize and make , really small. P r i c e Size of house P r i c eSize of houseSmall values for parameters―“Simpler” hypothesis―Less prone to overfitting Housing:―Features:―P arameters:P r i ce Size of houseWhat if is set to an extremely large value (perhaps for too large for our problem, say ? -Algorithm works fine; setting to be very large can’t hurt it-Algortihm fails to eliminate overfitting.-Algorithm results in underfitting. (Fails to fit even training data well.-Gradient descent will fail to converge.What if is set to an extremely large value (perhaps for too large for our problem, say ? P r i c eSize of houseRegularized linearregressionMachine LearningRegularized linear regressionGradient descentRepeatNormal equationSuppose ,Non-invertibility(optional/advanced.(#examples(#featuresIf ,Regularizedlogistic regressionMachine LearningRegularized logistic regression. x2 x1 Cost function: Andrew NgGradient descent Repeat Andrew NgAdvanced optimization function [jVal, gradient] = costFunction(theta jVal = [ code to compute ]; ]; gradient(1 = [ code to compute gradient(2 = [code to compute ]; gradient(3 = [code to compute ]; gradient(n+1 = [ code to compute ]; Andrew Ng。

机器学习7周志华ppt课件.ppt

1

1

贝叶斯决策论 (Bayesian decision theory)

概率框架下实施决策的基本理论 给定 N 个类别,令 λij 代表将第 j 类样本误分类为第 i 类所产生的 损失,则基于后验概率将样本 x 分到第 i 类的条件风险为:

贝叶斯判定准则 (Bayes decision rule) :

10

xi 的“父属性”

关键是如何确定父属性

10

两种常见方法

? SPODE (Super-Parent ODE): 假设所有属性都依赖于同一属性,称为“超父” (Super-Parent), 然后通过交叉验证等模型选择方法来确定超父属性

? TAN (Tree Augmented na?ve Bayes): 以属性间的条件 ”互信息 ”(mutual information)为边的权重,构建完 全图,再利用最大带权生成树算法,仅保留强相关属性间的依赖性

20

EM算法

如何处理“未观测到的”变量?

例如,西瓜已经脱落的根蒂,无法看出是“蜷缩”还是“坚挺”, 则训练样本的“根蒂”属性变量值未知 未观测变量 ? 隐变量(latent variable)

EM(Expectation-Maximization) 算法是估计隐变量的利器

令 X 表示已观测变量集, Z 表示隐变量集,欲对模型参数21 做 极大似然估计,则应最大化对数似然函数

13

? 训练样本非常充分 ? 性能可能提升

? 有限训练样本 ? 高阶联合概率估计困难

考虑属性间的高阶依赖,需要其他办法

13

贝叶斯网 (Bayesian network; Bayes network)

亦称“信念网” (brief network )

2024年度机器学习课件

04

神经网络与深NN基本概念

介绍前馈神经网络的基本结构、工作 原理及特点。

感知机模型

详细解释感知机模型的原理、算法及 实现过程。

2024/3/24

多层感知机(MLP)

阐述多层感知机的结构、激活函数选 择及训练过程。

参数优化方法

探讨梯度下降、反向传播等参数优化 方法在FNN中的应用。

外部指标

基于已知的真实类别信息来评估聚类的效果,如调整兰德 系数(Adjusted Rand Index, ARI)、标准化互信息( Normalized Mutual Information, NMI)等。

使用场景

内部指标适用于没有真实类别信息的情况,而外部指标适 用于有真实类别信息的情况。

16

2024/3/24

06

机器学习实践与应用

27

数据预处理与特征工程

数据转换

归一化、标准化、离散化 等

特征选择

过滤法、包装法、嵌入法 等

数据清洗

去除重复、缺失、异常值 等

特征构造

基于领域知识、特征组合 、特征交叉等

2024/3/24

28

模型调参与性能评估

超参数调整

网格搜索、随机搜索、贝叶斯优 化等

模型评估指标

准确率、精确率、召回率、F1值 等

机器学习课件

2024/3/24

1

2024/3/24

CONTENTS

• 机器学习概述 • 监督学习算法 • 非监督学习算法 • 神经网络与深度学习 • 强化学习与迁移学习 • 机器学习实践与应用

2

2024/3/24

01

机器学习概述

3

定义与发展历程

2024/3/24

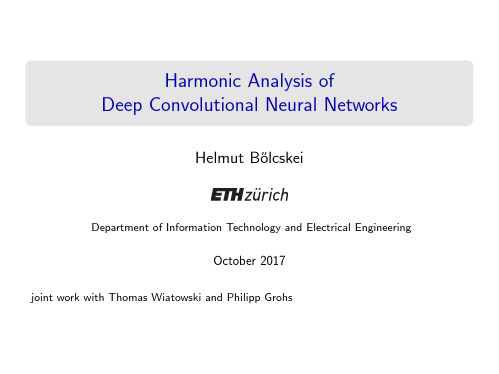

斯坦福2017机器学习 人工智能教程课程讲义 bolcskei-stats385-slides

Φ(f ) =

f 1

1

: w, f > 0 : w, f < 0

not possible!

: w, Φ(f ) > 0 : w, Φ(f ) < 0

possible with w =

Why non-linear feature extractors?

Task: Separate two categories of data through a linear classifier

1

: w, f > 0 : w, f < 0 not possible!

Why non-linear feature extractors?

ImageNet

ImageNet

ski rock

plant coffee

ImageNet

ski rock

plant coffee

CNNs win the ImageNet 2015 challenge [He et al., 2015 ]

Describing the content of an image

Translation invariance

Handwritten digits from the MNIST database [LeCun & Cortes, 1998 ] Feature vector should be invariant to spatial location ⇒ translation invariance

1 −1

Why non-linear feature extractors?

斯坦福大学公开课:机器学习学习课程

斯坦福大学公开课:机器学习学习课程————————————————————————————————作者:————————————————————————————————日期:斯坦福大学公开课:机器学习课程-机械制造论文斯坦福大学公开课:机器学习课程随着“智能制造”概念的普及,人工智能技术的研究与应用变的越来越被人们关注。

人工智能在制造中的运用已经成为实现制造的知识化、自动化、柔性化以实现对市场的快速响应的关键。

机器学习无疑是最有希望实现这个“智能”的研究方向之一。

斯坦福大学的“StanfordEngineering Everywhere ”免费提供学校里最受欢迎的工科课程给全世界的学生和教育工作者。

得益于这个项目,我们有机会和全世界站在同一个数量级的知识起跑线上。

课程共20 集,网易公开课已经全部翻译完成。

讲师:Andrew Ng。

[ 第1 集] 机器学习的动机与应用简介:机器学习的动机与应用、Logistic 类、机器学习的定义、监督学习概观、学习理论概述、非监督学习概述和强化学习概述。

[ 第2 集] 监督学习应用简介:监督学习应用——自主推导,ALVINN 系统,线性回归,梯度下降,组梯度下降,随机梯度下降,标准方程推导。

[ 第3 集] 欠拟合与过拟合的概念简介:欠拟合与过拟合的概念,参数化及非参数化算法概念,局部加权回归,对于线性模型的概率解释,Logistic 回归,感知器。

[ 第4 集] 牛顿方法简介:介绍了牛顿方法,可以代替梯度上升算法用来计算函数的最大值;之后以高斯分布和伯努利分布为例介绍了指数分布函数族;最后以指数分布函数族为基础,引出了广义线性模型,可以通过指定概率分布直接推导出模型。

[ 第5 集] 生成学习算法简介:一类新的学习算法——生成学习算法,并详细地讲解了该算法的一个例子:高斯判别分析;之后对生成学习算法与之前的判别学习算法进行了对比;最后介绍了一个适合对文本进行分类的算法——朴素贝叶斯算法,并结合该算法讲述了一种常用的平滑技术——Laplace 平滑。

机器学习斯坦福大学讲义

机器学习——斯坦福大学讲义第一课机器学习的动机与应用定义(Arthur Samuel 1959):在不直接针对问题进行编程的情况下,赋予计算机学习能力的研究领域。

例:Arthur的下棋程序,计算走每一步获胜的概率,最终打败程序作者本人。

(感觉使用决策树思想)定义2(Tom Mitchell 1998):一个合理的学习问题应该这样定义:对一个计算机程序来说,给它一个任务T和一个性能测量方法P,如果在经验E的影响下,P对T的测量结果得到了改进,那么就说改程序从E中学习了。

如上例:E:程序不断和自己下棋的经历,T:下棋,P:和人类选手对弈的胜率课程的四大部分:1、有监督学习(1)回归问题例:收集某地房屋价格统计、房屋大小和价格对应情况:画出一条拟合曲线,就可以通过房屋大小估计价格。

-有监督学习即给出一个数据集(正确的房屋价格及对应大小)-此例为回归问题。

回归意味着需要预测的变量是连续的(2)分类问题分类问题中需要处理的变量是离散的例:判断肿瘤是恶性还是两性-收集肿瘤大小和恶性/良性数据,大小为横轴,是否是恶性为纵轴(只有0,1)画图-肿瘤可能由多个因素导致,引入年龄,大小为横轴,年龄为纵轴,恶性以叉表示,良性以圆圈表示画图,分析患肿瘤的区域-还可引入更多属性,画在多维空间中-无限维空间如何处理?将无限维映射到内存的算法?2、学习理论学习理论即解释学习型算法有效的原因(学习算法的理论基础)寻找什么样的算法能很好地近似不同的函数,训练集的规模是否合适3、无监督学习例:如上述肿瘤例子,图中的点不知道正确答案,而是由你从中找去一定的结构,即聚类。

应用于生物基因工程,图像处理,计算机视觉等领域例:鸡尾酒会问题在嘈杂的鸡尾酒会中,将你感兴趣的声音提取出来运用两个不同位置的麦克分开来自不同位置的声音还能应用于文本处理等领域使用ICA算法,Matlab一行代码即可解决4、强化学习通过决策产生的结论或对或错,故产生一系列的决策。

机器学习7周志华ppt课件

• h* 称为 贝叶斯最优分类器(Bayes optimal classifier),其总体风险称为 贝叶斯 风险 (Bayes risk)

• 反映了 学习性能的理论上限

精选ppt

2

判别式 vs. 生成式

在现实中通常难以直接获得

从这个角度来看,机器学习所要实现的是基于有限的训练样本 尽可能准确地估计出后验概率

给定父结点集,贝叶斯网假设每个属性与其非后裔属性 独立

父结点集

精选ppt

15

三变量间的典型依赖关系

条件独立性

边际独立性

条件独立性

• 给定 x4, x1 与 x2 必不独立 • 若 x4 未知,则 x1 与 x2 独立

精选ppt

16

分析条件独立性

“有向分离”( D-separation)

先将有向图转变为无向图

两种基本策略:

判别式 (discriminative)

模型

思路:直接对

建模

代表: • 决策树 • BP 神经网络

• SVM

生成式 (generative) 模型 思路:先对联合概率分布 建模,再由此获得

代表:贝叶斯分类器

精选ppt

注意:贝叶斯分类器 ≠ 贝叶斯学习 (Bayesian learning)

组合爆炸;样本稀疏

基本思路:假定属性相互独立?

d 为属性数, xi 为 x 在第 i 个属性上的取值

对所有类别相同,于是

精选ppt

6

朴素贝叶斯分类器

估计 P(c):

估计 P(x|c):

• 对离散属性,令

表示 Dc 中在第 i 个属性上取值为

xi 的样本组成的集合,则

• 对连续属性,考虑概率密度函数,假定

机器学习演示文稿

ቤተ መጻሕፍቲ ባይዱ

7.4.1 归纳推理

1. 枚举归纳

例如,设有如下已知事例: 张三是足球运动员,他的体格健壮。 李四是足球运动员,他的体格健壮。

……

……

刘六是足球运动员,他的体格健壮。

事例足够多时,可归纳出一般性知识:

凡是足球运动员,他的体格一定健壮。(0.9)

27 第27页,共70页。

7.4.1 归纳推理

3. 按推理方式分类:

基于演绎的学习(解释学习)。 基于归纳的学习 (示例学习、发现学习等 )。

4. 按综合属性分类: 归纳学习、分析学习、连接学习等。

15

第15页,共70页。

第7章 机器学习

7.1 机器学习的基本概念

✓ 7.2 机械式学习

7.3 指导式学习 7.4 归纳学习 7.5 类比学习 7.6 基于解释的学习 7.7 学习方法的比较与展望

机器学习演示文稿

第1页,共70页。

(优选)第机器学习

第2页,共70页。

第7章 机器学习

✓ 7.1 机器学习的基本概念

7.2 机械式学习 7.3 指导式学习 7.4 归纳学习 7.5 类比学习 7.6 基于解释的学习 7.7 学习方法的比较与展望

3 第3页,共70页。

7.1 机器学习的基本概念

规则1: 花色(c1,x) 花色(c2,x) 花色(c3,x) 花色(c4,x)

同花(c1 , c2 , c3 , c4)

37

第37页,共70页。

7.4.2 示例学习

2. 形成知识的方法

(3)增加操作

§ 前件析取法 §例如关于“脸牌” 示例:

示例1: 示例2: 示例3:

得到知识:

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Example: Logis*c regression

x2 x2 x2

x1

x1

x1

( = sigmoid func*on)

Andrew Ng

Regulariza*on

The problem of overfi6ng

Machine Learning

Example: Linear regression (housing prices)

Price Price Price Size

Addressing overfi&ng: size of house no. of bedrooms no. of floors age of house average income in neighborhood kitchen size

Suppose we penalize and make , really small.

Andrew Ng

Regulariza3on. Small values for parameters ― “Simpler” hypothesis ― Less prone to overfi6ng Housing: ― Features: ― Parameters:

Advanced op3miza3on

function [jVal, gradient] = costFunction(theta) jVal = [ code to compute ]; ]; ]; ];

gradient(1) = [code to compute gradient(2) = [code to compute gradient(3) = [code to compute gradient(n+1) = [ code to compute

];

Andrew Ng

Price Size of house

Andrew Ng

Regulariza*on

Regularized linear regression

Machine Learning

Regularized linear regression

(#examples) (#features)

If ,

Andrew Ng

Regulariza*on

Regularized logis*c regression

Machine Learning

Regularized logis3c regression.

x2

x1

Cost func*on:

Andrew Ng

Gradient descent Repeat

Andrew Ng

What if is set to an extremely large value (perhaps for too large for our problem, say )?

Size

Size

Overfi&ng: If we have too many features, the learned hypothesis may fit the training set very well ( ), but fail to generalize to new examples (predict prices on new

Gradient descent Repeat

Andrew Ng

Normal equa3on

Andrew Ng

Non-‐inver3bility (op3onal/advanced). Suppose Cost func*on

Machine Learning

Intui3on

Price Price Size of house Size of house

Price

Size

Andrew Ng

Addressing overfi&ng: Op*ons: 1. Reduce number of features. ― Manually select which features to keep. ― Model selec*on algorithm (later in course). 2. Regulariza*on. ― Keep all the features, but reduce magnitude/values of parameters . ― Works well when we have a lot of features, each of which contributes a bit to predic*ng .

Andrew Ng

Regulariza3on.

Price

Size of house

Andrew Ng

In regularized linear regression, we choose to minimize