大数据采集工具如何使用

大数据采集软件的使用流程

大数据采集软件的使用流程1. 下载和安装1.访问大数据采集软件官方网站,找到软件下载页面。

2.点击下载按钮,选择适合您操作系统的版本。

3.下载完成后,双击安装程序进行安装。

4.根据安装向导的提示,选择安装路径和其他选项,点击“下一步”继续安装。

5.安装完成后,点击“完成”退出安装程序。

2. 启动软件1.在桌面或开始菜单找到大数据采集软件的图标。

2.双击图标启动软件。

3.如果是首次启动软件,可能需要输入许可证信息或进行注册。

3. 创建项目1.在软件主界面,点击“新建项目”按钮。

2.输入项目名称和描述,点击“下一步”。

3.根据需要选择要采集的数据源类型,如网页、数据库、API等。

4.配置数据源参数,如URL、用户名、密码等。

5.点击“完成”按钮创建项目。

4. 配置采集规则1.在项目列表中选择需要配置采集规则的项目。

2.点击“配置采集规则”按钮进入规则配置界面。

3.根据需求,选择相应的采集规则类型,如网页抓取、数据提取、数据清洗等。

4.配置规则参数,如选择要抓取的网页元素、设置提取规则、定义清洗操作等。

5.点击“保存”按钮保存规则配置。

5. 执行采集任务1.在项目列表中选择已配置好采集规则的项目。

2.点击“执行采集任务”按钮。

3.根据需要选择采集任务的执行方式,如单次执行、定时执行等。

4.设置任务执行参数,如采集深度、抓取间隔、并发数等。

5.点击“开始执行”按钮,启动采集任务。

6. 监控和管理任务1.在软件主界面,点击“任务监控”按钮。

2.在任务监控页面,可以查看当前正在执行的采集任务的状态和进度。

3.可以对任务进行管理操作,如暂停、继续、取消等。

7. 导出和保存数据1.采集任务完成后,在软件主界面选择相应的项目。

2.点击“导出数据”按钮,选择导出数据的格式,如CSV、Excel等。

3.选择导出数据的保存路径,点击“导出”按钮。

4.数据导出完成后,可以在保存路径中找到导出的数据文件。

8. 分析和可视化数据1.使用数据分析工具,如Excel、Python等,打开导出的数据文件。

大数据分析师如何进行数据采集和数据存储

大数据分析师如何进行数据采集和数据存储在当今数字化时代,大数据逐渐成为企业决策和创新的基石。

大数据分析师作为数据驱动决策的专家,需要掌握一系列的数据采集和数据存储的技巧。

本文将介绍大数据分析师在数据采集和数据存储方面的工作方法和技术。

一、数据采集数据采集是大数据分析的第一步,它决定了分析师所获得的数据是否准确、全面和可靠。

以下是大数据分析师进行数据采集的一般步骤:1.明确需求:在进行数据采集之前,分析师需要与业务部门或决策者沟通,明确他们的数据需求和分析目标。

只有明确需求,才能有针对性地进行数据采集。

2.确定数据源:根据需求的不同,数据源可能包括数据库、网站、API接口、传感器等。

大数据分析师需要了解业务领域的数据来源,并选择最合适的数据源。

3.制定采集计划:根据数据源的特点和采集需求,分析师需要制定详细的采集计划。

计划应包括采集频率、采集时间段、采集的字段等。

4.编写采集脚本:对于规模较大或需要频繁采集的数据,分析师可以使用编程语言编写采集脚本。

脚本可以自动化采集过程,提高效率。

5.数据校验和清洗:采集到的数据可能存在错误、缺失或冗余。

在进行后续分析之前,分析师需要对数据进行校验和清洗,确保数据的准确性和一致性。

二、数据存储数据存储是大数据分析师在获取数据后的下一步工作。

合理的数据存储方案可以提高数据的可用性和处理效率。

以下是一些常见的数据存储方式:1.数据库存储:数据库是最常见的数据存储方式,它可以结构化地存储数据,并提供高效的数据检索和查询功能。

常用的数据库包括MySQL、Oracle和MongoDB等。

2.数据仓库:数据仓库是一种面向分析的数据存储系统,它将来自不同数据源的数据集成起来,方便分析师进行复杂的数据查询和分析。

常见的数据仓库包括Hadoop和Spark等。

3.云存储:随着云计算技术的发展,越来越多的企业选择将数据存储在云平台上。

云存储提供可扩展的存储空间和高可靠性,同时也降低了数据存储的成本。

大数据采集技术工具及应用场景

大数据采集技术工具及应用场景Big Data Collection Technology Tools and Their Application ScenariosWith the explosive growth of data in today's digital era, big data collection technology tools have become increasingly important. These tools enable organizations to efficiently gather, process, and analyze vast amounts of data, providing valuable insights that drive decision-making and strategic planning.在当今数字化时代,数据呈现爆炸式增长,大数据采集技术工具变得日益重要。

这些工具使组织能够高效地收集、处理和分析大量数据,提供有价值的见解,推动决策制定和战略规划。

One key aspect of big data collection is the use of various tools and techniques to capture data from diverse sources. These tools can range from traditional databases and data warehouses to more modern solutions like Hadoop and NoSQL databases. Each tool has its unique strengths and is suitable for different types of data and use cases.大数据采集的一个关键方面是使用各种工具和技术从各种来源捕获数据。

大数据分析中的数据采集与清洗自动化工具介绍(Ⅰ)

随着信息技术的不断发展,大数据分析已经成为了企业决策和发展的重要工具。

而在大数据分析的过程中,数据的采集和清洗是至关重要的环节。

本文将介绍几种常用的数据采集与清洗自动化工具,帮助读者更好地理解大数据分析中的关键环节。

一、数据采集工具1. Apache NutchApache Nutch 是一个开源的网络搜索引擎。

它可以帮助用户获取网页信息,并将其转换为结构化的数据,方便后续的分析和处理。

Nutch 支持多种数据存储格式,包括文本、HTML、XML 等,并且可以通过定制插件来扩展其功能。

它的分布式架构和高性能使得它成为了大规模数据采集的首选工具之一。

2. ScrapyScrapy 是一个基于 Python 的开源网络爬虫框架。

它提供了简洁的 API 和强大的选择器功能,可以帮助用户快速高效地获取网页信息。

Scrapy 支持异步网络请求和自定义中间件,同时还提供了丰富的插件和扩展机制。

这使得它成为了一款非常灵活和易用的数据采集工具。

二、数据清洗工具1. OpenRefineOpenRefine(前身为 Google Refine)是一款开源的数据清洗工具。

它支持导入多种数据格式,包括 CSV、JSON、XML 等,同时还提供了强大的数据转换和整合功能。

OpenRefine 还支持实时预览和撤销操作,为用户提供了非常便利的数据清洗环境。

另外,它还支持自定义插件和扩展,使得用户可以根据实际需求定制功能。

2. Trifacta WranglerTrifacta Wrangler 是一款专注于数据清洗和转换的商业工具。

它提供了直观的用户界面和丰富的数据处理操作,可以帮助用户快速高效地清洗数据。

Trifacta Wrangler 还支持数据质量分析和自动化建模,为用户提供了一站式的数据清洗解决方案。

值得一提的是,它还支持与 Hadoop 和 Spark 等大数据处理平台的集成,为用户提供了更加便捷的数据处理流程。

大数据分析师如何进行数据采集和数据存储

大数据分析师如何进行数据采集和数据存储在大数据时代,数据分析师的角色变得愈发重要。

大数据分析师负责收集、分析和存储海量数据,并从中提取有价值的信息和见解。

本文将介绍大数据分析师如何进行数据采集和数据存储的方法和技巧。

一、数据采集方法数据采集是整个数据分析流程的第一步,它包括从各种不同的数据源中收集数据。

以下是几种常见的数据采集方法。

1. 网络爬虫网络爬虫是一种自动化数据采集技术,通过程序自动访问网页,并从中提取所需的数据。

大数据分析师可以编写爬虫程序,根据特定的需求来采集网页上的相关数据。

网络爬虫的优点是高效快捷,但也需要注意合法合规,遵循网站的规则和法律法规。

2. 数据库查询大多数组织和企业都使用数据库来存储和管理数据。

作为一个数据分析师,你可以通过数据库查询语言(如SQL)来获取需要的数据。

这种方式适用于从结构化数据中提取信息,但对于非结构化数据可能不太适用。

3. API接口许多公司和平台提供API接口,允许开发者访问和获取其数据。

大数据分析师可以通过调用API接口来获取目标数据。

这种方式可以提供实时数据,并且数据格式较为统一。

4. 日志文件分析许多系统和应用程序会生成日志文件,记录了各种操作和事件的详细信息。

大数据分析师可以通过分析这些日志文件来获取有关系统性能、用户行为等方面的数据。

二、数据存储方法数据采集后,大数据分析师需要将数据进行存储,以备后续分析和处理。

以下是几种常见的数据存储方法。

1. 数据库数据库是最常用的数据存储方式之一,可以使用关系型数据库(如MySQL、Oracle)或非关系型数据库(如MongoDB、Redis)。

关系型数据库适用于结构化数据的存储,而非关系型数据库则更适合存储半结构化和非结构化数据。

2. 数据仓库数据仓库是一种集成的、面向主题的、相对稳定的数据存储和管理系统。

它可以将来自不同数据源的数据进行整合,并提供一致的数据视图和分析能力。

数据仓库常用于大规模数据存储和数据分析场景。

大数据采集技术的方法

大数据采集技术的方法大数据采集技术是指利用各种方法和工具收集和获取大规模数据的过程。

在当今信息爆炸的时代,大数据采集技术的重要性不言而喻。

本文将介绍几种常用的大数据采集技术方法。

一、网络爬虫技术网络爬虫是一种自动化的数据采集工具,通过模拟人的行为,自动访问网页并抓取其中的数据。

网络爬虫技术可以按照预定的规则和策略,自动从互联网上抓取数据,并进行处理和存储。

爬虫技术可以通过解析HTML页面、使用正则表达式、XPath或CSS选择器等方法,提取出所需的数据。

网络爬虫技术广泛应用于搜索引擎、电商价格比较、舆情监测等领域。

二、日志分析技术日志是各种系统、应用和设备在运行过程中产生的记录。

日志记录了系统的运行状态、用户的访问行为、错误信息等数据。

利用日志分析技术,可以对这些数据进行提取、清洗和分析,从中获取有价值的信息。

日志分析技术可以帮助企业监控系统运行状况、分析用户行为、发现潜在问题等。

三、社交媒体数据采集技术社交媒体是人们日常生活中重要的信息来源,其中蕴含着丰富的数据。

社交媒体数据采集技术可以通过API接口、爬虫等方式,获取用户在社交媒体平台上发布的文字、图片、视频等数据。

这些数据可以用于舆情分析、用户画像构建、广告精准投放等领域。

四、传感器数据采集技术传感器是一种能够感知和测量物理量的设备,如温度、湿度、压力、光照等。

传感器数据采集技术可以利用传感器设备采集现实世界中的各种数据,并进行处理和分析。

传感器数据采集技术广泛应用于物联网、智能城市、工业自动化等领域。

五、数据挖掘技术数据挖掘是从大规模数据中发现潜在模式、规律和关联的过程。

数据挖掘技术可以通过统计学、机器学习、人工智能等方法,对大数据进行分析和挖掘,提取出有价值的信息。

数据挖掘技术可以应用于市场分析、风险评估、个性化推荐等领域。

六、云计算技术云计算是一种基于互联网的计算模式,通过将数据存储和处理任务分布在多台计算机上,实现对大数据的高效处理和存储。

大数据分析师如何进行数据采集与整合

大数据分析师如何进行数据采集与整合数据采集和整合是大数据分析工作中的重要环节,它涉及到从各种来源收集数据并将其整合到一个统一的数据集中。

这些数据集可以用于深入分析、洞察业务趋势和制定决策。

在本文中,将探讨大数据分析师如何进行数据采集与整合的步骤,并分享一些有效的技巧和注意事项。

一、明确数据需求在进行数据采集和整合之前,大数据分析师需要明确他们的数据需求。

这意味着他们要明确他们需要哪些类型的数据以及这些数据用于什么目的。

例如,他们可能需要采集销售数据、用户行为数据或市场趋势数据等。

明确了数据需求后,才能有针对性地进行后续的数据采集和整合工作。

二、确定数据采集来源一旦明确了数据需求,大数据分析师需要确定从哪些来源采集数据。

这些数据来源可以包括内部系统、外部数据供应商、社交媒体平台、网页爬虫等。

根据需求,选择适合的数据来源是确保数据采集工作的关键一步。

三、制定数据采集计划在进行数据采集之前,制定一个详细的数据采集计划非常重要。

这个计划应包括数据采集的时间、频率、采集的数据字段和数据格式等。

此外,还需要确保采集的数据的可靠性和准确性,以及处理故障和错误数据的方法。

四、使用合适的工具和技术进行数据采集根据数据采集的需求和来源,大数据分析师需要选择合适的工具和技术来进行数据采集。

例如,他们可以使用数据抓取工具或API来从网页或应用程序中获取数据。

对于结构化数据,可以使用数据库查询语言来提取数据。

此外,也可以使用数据集成工具来将来自不同来源的数据进行整合。

五、数据整合与清洗在采集到数据后,大数据分析师需要进行数据整合和清洗的工作。

数据整合是将来自不同来源的数据合并到一个统一的数据集中,以便进行后续的分析。

数据清洗是指对数据进行去重、去误、去噪等操作,以确保数据的质量和准确性。

在进行数据整合和清洗时,应该遵循一系列的数据处理规范和标准,以保证整合后的数据的一致性和可靠性。

六、数据质量和安全性保障对于数据分析师来说,保证数据质量和安全性非常重要。

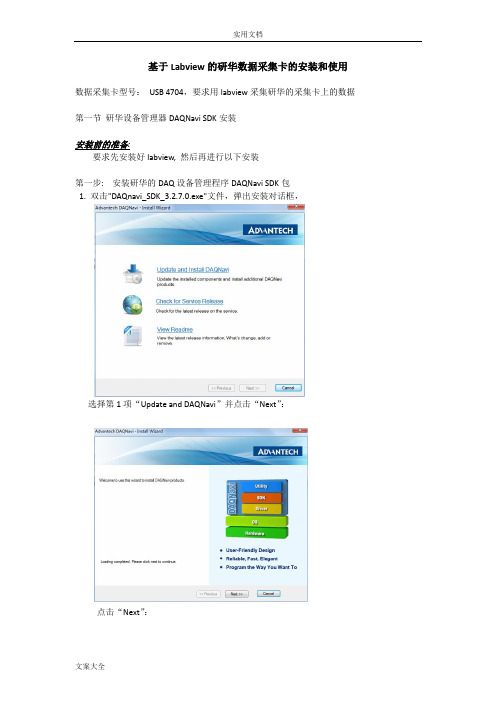

研华大数据采集卡USB4704地安装和使用

基于Labview的研华数据采集卡的安装和使用数据采集卡型号:USB 4704,要求用labview采集研华的采集卡上的数据第一节研华设备管理器DAQNavi SDK安装安装前的准备:要求先安装好labview, 然后再进行以下安装第一步: 安装研华的DAQ设备管理程序DAQNavi SDK包1. 双击"DAQnavi_SDK_3.2.7.0.exe"文件,弹出安装对话框,选择第1项“Update and DAQNavi”并点击“Next”:点击“Next”:如左上所示勾选,并点击“Next”:点击“Next”,得如下图所示对话框,表示正在安装,请耐心等待。

耐心等待安装结束。

安装结束后,选择操作系统上的“程序”,在程序列表中应该有“Advantech Automation”选项,点击该选项展开应有“DAQNavi”,如下图所示:单击上图中的“Advantech Nagigator”选项,即可打开研华的设备管理器对话框,如下图所示,在这里,左侧的“Device”栏中列出了本机上连接的所有采集卡,可以对这些卡进行管理和测试,具体如何测试,请参照帮助文档。

第三二步.usb4704采集卡驱动安装1. 双击“DAQNavi_USB4702_USB4704_3.1.7.0.exe”进行安装;2. 安装完毕后,将采集卡与PC机相连(将usb数据线一端连上采集卡,另外一端连到计算机的USB口上),系统将自动安装采集卡的驱动,并识别采集卡。

3. 检查采集卡安装成功否首先查看插在PC机上的采集卡上的灯是否呈绿色;其次,打开“DAQNavi”,如下图所示,观察设备列表中是否显示出了“USB-4704”第三步:在研华的设备列表中添加模拟卡(Demo Device)若没有实际的采集卡,可以添加模拟卡进行模拟测试和数据采集编程练习那么如何添加模拟卡呢?如下图所示,点击“Advantech Automation”——〉DAQNavi ——〉Add Demo Device模拟卡添加好后,在“Advantech Navigator”的设备列表中就能看到该卡信息,如下图所示,没有实际采集卡的同学,可以用这张模拟卡进行相关的采集卡测试及编程练习:第四步: 安装Labview Driver经过以上三步,研华的采集卡就安装完毕了,那么如果要用Labview对采集卡编程,实现数据采集,则还需要安装labview针对研华的数据采集卡的驱动。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

大数据采集工具如何使用

在商业活动,大数据已然成为必不可少的参考依据,通过对大数据的挖掘分析处理能为商业决策、战略部署、企业发展提供准确的指导。

特别是电子商务,即时采集商品的价格、销量、评价等大量信息进行处理分析,形成反馈结果应用到实际中,能为商业活动带来巨大的经济价值。

因而,掌握大数据采集工具如何使用是必须的。

对于某些用户来说,直接自定义规则可能有难度,所以在这种情况下,我们提供了网页简易模式,网页简易模式下存放了国内一些主流网站爬虫采集规则,在你需要采集相关网站时可以直接调用,节省了制作规则的时间以及精力。

天猫商品数据采集下来有很多作用,比如可以分析天猫商品价格变化趋势情况,评价数量,竞品销量和价格,竞争店铺分析等,快速掌握市场行情,帮助企业决策。

所以本次介绍八爪鱼简易采集模式下“天猫数据抓取”的使用教程以及注意要点。

步骤一、下载八爪鱼软件并登陆

1、打开/download,即八爪鱼软件官方下载页面,点击图中的下载按钮。

2、软件下载好了之后,双击安装,安装完毕之后打开软件,输入八爪鱼用户名密码,然后点击登陆。

步骤二、设置天猫商品列表抓取规则

1、进入登陆界面之后就可以看到主页上的网站简易采集了,选择立即使用即可。

2、进去之后便可以看到目前网页简易模式里面内置的所有主流网站了,需要采集京东内容的,这里选择天猫即可。

3、找到天猫商品列表采集这条爬虫规则,点击即可使用。

4、天猫商品列表简易采集模式任务界面介绍

查看详情:点开可以看到示例网址

任务名:自定义任务名,默认为天猫-商品列表采集

任务组:给任务划分一个保存任务的组,如果不设置会有一个默认组商品名称:自定义输入商品名称即可,如“拖布”

示例数据:这个规则采集的所有字段信息

5、天猫商品列表抓取规则设置示例

例如要采集商品名称为“拖布”的商品列表信息。

在设置里如下图所示:

任务名:自定义任务名,也可以不设置按照默认的就行

任务组:自定义任务组,也可以不设置按照默认的就行

商品名称:输入“拖布”

步骤三、保存并运行天猫商品列表采集规则

1、设置好爬虫规则之后点击保存。

2、保存之后,点击会出现开始采集的按钮。

3、选择开始采集之后系统将会弹出运行任务的界面,可以选择启动本地采集(本地执行采集流程)或者启动云采集(由云服务器执行采集流程),这里以启动本地采集为例,我们选择启动本地采集按钮。

4、选择本地采集按钮之后,系统将会在本地执行这个采集流程来采集数据,下图为本地采集的效果(示例中商品列表数据较多,为方便展示故先行停止采集,诸位可以根据需求决定是否采集完。

)

5、采集完毕之后选择导出数据按钮即可,这里以导出excel2007为例,选择这个选项之后点击确定。

6、然后选择文件存放在电脑上的路径,路径选择好之后选择保存。

7、这样天猫商品列表数据就被完整的采集导出到自己的电脑上来了。

相关采集教程:

网页数据爬取教程:

/tutorial/hottutorial

淘宝数据采集:

/tutorial/hottutorial/dianshang/taobao

阿里巴巴数据采集:

/tutorial/hottutorial/dianshang/alibaba

金融数据采集:

/tutorial/hottutorial/jrzx

网易彩票数据采集:

/tutorial/hottutorial/jrzx/wycaipiao

平安车险数据采集:

/tutorial/hottutorial/jrzx/pingancx

114黄页企业数据采集:

/tutorial/hottutorial/qyxx/114huangye

地图数据采集:

/tutorial/hottutorial/shfw/ditu

点评数据采集:

/tutorial/hottutorial/shfw/xfdp

八爪鱼——90万用户选择的网页数据采集器。

1、操作简单,任何人都可以用:无需技术背景,会上网就能采集。

完全可视化流程,点击鼠标完成操作,2分钟即可快速入门。

2、功能强大,任何网站都可以采:对于点击、登陆、翻页、识别验证码、瀑布流、Ajax脚本异步加载数据的网页,均可经过简单设置进行采集。

3、云采集,关机也可以。

配置好采集任务后可关机,任务可在云端执行。

庞大云采集集群24*7不间断运行,不用担心IP被封,网络中断。

4、功能免费+增值服务,可按需选择。

免费版具备所有功能,能够满足用户的基本采集需求。

同时设置了一些增值服务(如私有云),满足高端付费企业用户的需要。