机器学习 深度学习 笔记 (6)

周志华 机器学习 西瓜书 全书16章 ppt Chap06支持向量机

的梯度往区域

外发散,如下

图红色箭头。

显然,走到极

小值点的时候,

g(x)的梯度和

f(x)的负梯度

同向。因为极

小值点在边界

上,这个时候

g(x)等于0

总结

极小值点落在可行域内(不包含边界):这个时 候可行域的限制不起作用,相当于没有约束,直 接f(x)的梯度等于0求解,这个时候g(x极小值 点)<0(因为落在可行域内)。 极小值点落在可行域外(包含边界):可行域的 限制起作用,极小值点应该落在可行域边界上即 g(x)=0,类似于等值约束,此时有g(x)的梯度和f(x) 的负梯度同向。

0

-A:应选择”正中间”, 容忍性好, 鲁棒性高, 泛化能力最强.

间隔与支持向量

超平面方程:

间隔

支持向量

0

支持向量机基本型

最大间隔: 寻找参数 和 , 使得 最大.

带有约束的优化问题s.t.

gi

min xD (x) 0,i

f (x) 1,2,,

q

hj

(x)

0,

j

q

1,,

m

其中f(x)是目标函数,g(x)为不等式约束,h(x)为等式约束。

若f(x),h(x),g(x)三个函数都是线性函数,则该优化问题称为线性规划。 若任意一个是非线性函数,则称为非线性规划。

若目标函数为二次函数,约束全为线性函数,称为二次规划。

若f(x)为凸函数,g(x)为凸函数,h(x)为线性函数,则该问题称为凸优化。 注意这里不等式约束g(x)<=0则要求g(x)为凸函数,若g(x)>=0则要求g(x)为凹函 数。

对偶问题

1 wT w

深度学习知识点总结

深度学习知识点总结深度学习是一种人工智能(AI)的子领域,它的目标是让计算机系统像人类一样具有分析、理解和解释数据的能力。

通过模拟人脑中神经元的工作原理,深度学习算法可以学习和理解数据中的复杂模式,并进行非常准确的分类和预测。

本文将系统地总结深度学习的基本概念和常见技术,帮助读者全面了解深度学习的核心知识点。

一、基本概念1. 神经网络神经网络是深度学习的基础,它模拟了人脑中神经元之间的连接关系。

一个神经网络由许多神经元组成,并通过神经元之间的连接来传递信息。

通常,神经网络被组织成多个层次,包括输入层、隐藏层和输出层。

每个神经元接收来自上一层神经元的输入,通过加权求和和激活函数的处理后产生输出。

神经网络可以通过训练来学习适应不同的数据模式和特征。

2. 深度学习深度学习是一种使用多层神经网络进行学习的机器学习技术。

与传统的浅层神经网络相比,深度学习能够更好地处理大规模高维度的数据,并学习到更加复杂的特征和模式。

深度学习已经广泛应用在图像识别、语音识别、自然语言处理等领域,取得了显著的成果。

3. 监督学习监督学习是一种常见的机器学习方法,它通过使用有标签的数据样本来训练模型。

在监督学习中,模型通过学习输入和输出之间的关系来进行预测。

常见的监督学习算法包括:神经网络、决策树、支持向量机等。

4. 无监督学习无监督学习是一种不使用标签数据的机器学习方法,它通过学习数据之间的内在结构和模式来进行数据分析和分类。

无监督学习常用的算法包括聚类、关联规则、降维等。

5. 强化学习强化学习是一种通过与环境交互来学习最优决策策略的机器学习方法。

在强化学习中,智能体通过观察环境的反馈和奖励来调整自身的行为,并不断优化决策策略。

强化学习在机器人控制、游戏AI等领域有着广泛应用。

6. 深度学习框架深度学习框架是一种方便开发者进行深度学习模型搭建和训练的软件工具。

常见的深度学习框架包括:TensorFlow、PyTorch、Keras、Caffe等。

机器学习总结

sklearn 1.17. Neural network models (supervised)神经网络模型(监督学习)Warning :This implementation is not intended for large-scale applications. In particular, scikit-learn offers no GPU support. For much faster, GPU-based implementations, as well as frameworks offering much more flexibility to build deep learning architectures, see Related Projects.警告:此实现不适用于大规模应用。

特别是scikit-learn 不提供图形处 理器支持。

有关更快、基于GPU 的实现,以及为构建深度学习架构 提供更大灵活性的框架,请参见相关项目。

Deep neural networks etc.深度神经网络pylearn2: A deep learning and neural network library build on theano with scikit-learn like interface.pylearn2: 一个深度学习和神经网络库建立在具有scikit- learn 类接口的theano 之上。

sklearn_theano: scikit-learn compatible estimators, transformers, and datasets which use Theano internallysklearn_theano: sklearn 在内部使用theano 的兼容估计 器、转换器和数据集.nolearn: A number of wrappers and abstractions around existing neural network librariesnolearn:围绕现有神经网络库的许多包装器和抽象keras : Deep Learning library capable of running on top of either TensorFlow or Theano.keras :能够在tensorflow 或thetano 上运行的深度学习库。

机器学习的知识重点

机器学习的知识重点机器学习是一门涵盖统计学、人工智能和计算机科学等多个领域的交叉学科,它研究如何设计和开发能够自动学习和改进的算法和模型。

在机器学习中,有一些重要的知识点需要特别关注和掌握。

本文将介绍机器学习的知识重点,帮助读者更好地理解和应用机器学习。

一、数据预处理在机器学习中,数据预处理是一个非常重要的步骤。

它包括数据清洗、特征选择、特征变换和数据集划分等过程。

数据清洗主要是处理缺失值、异常值和重复值等问题,确保数据的质量和完整性。

特征选择是从原始数据中选择最具代表性的特征,以提高模型的性能和泛化能力。

特征变换是将原始数据转化为适合模型输入的形式,如标准化、归一化和离散化等。

数据集划分是将数据集划分为训练集、验证集和测试集,用于模型的训练、调优和评估。

二、监督学习监督学习是机器学习中最常用的一种学习方式,它通过已有的标记数据来训练模型,然后对未知数据进行预测或分类。

在监督学习中,有一些重要的算法需要了解,如线性回归、逻辑回归、决策树、支持向量机和朴素贝叶斯等。

线性回归用于建立连续型变量之间的线性关系模型,逻辑回归用于建立二分类模型,决策树用于建立基于特征划分的分类模型,支持向量机用于建立最优间隔分类模型,朴素贝叶斯用于建立基于贝叶斯定理的分类模型。

三、无监督学习无监督学习是机器学习中另一种常用的学习方式,它通过未标记的数据来学习数据的结构和模式。

在无监督学习中,有一些重要的算法需要了解,如聚类、关联规则和降维等。

聚类是将相似的样本归为一类,不相似的样本归为不同类别,常用的聚类算法有K均值聚类和层次聚类等。

关联规则是挖掘数据集中的频繁项集和关联规则,常用的关联规则算法有Apriori算法和FP-growth算法等。

降维是将高维数据映射到低维空间,常用的降维算法有主成分分析和线性判别分析等。

四、模型评估与选择在机器学习中,模型的评估和选择是非常重要的,它决定了模型的性能和泛化能力。

常用的评估指标有准确率、精确率、召回率、F1值和ROC曲线等。

《机器学习》(周志华)西瓜书读书笔记(完结)

《机器学习》(周志华)西⽠书读书笔记(完结)⼤部分基础概念知识已经在这篇博客中罗列,因此本⽂仅对感觉重要或不曾了解的知识点做摘记第1章绪论对于⼀个学习算法a,若它在某问题上⽐学习算法b好,则必然存在另⼀些问题,在那⾥b⽐a好.即"没有免费的午餐"定理(No FreeLunch Theorem,NFL).因此要谈论算法的相对优劣,必须要针对具体的学习问题第2章模型评估与选择m次n折交叉验证实际上进⾏了m*n次训练和测试可以⽤F1度量的⼀般形式Fβ来表达对查准率/查全率的偏好:偏差度量了学习算法的期望预测与真实结果的偏离程度,即学习算法本⾝的拟合能⼒,⽅差度量了同样⼤⼩的训练集的变动所导致的学习性能的变化,即数据扰动造成的影响.噪声表达了当前任务上任何学习算法所能达到的期望泛化误差的下界,即学习问题本⾝的难度.第3章线性模型线性判别分析(LDA)是⼀种经典的监督线性降维⽅法:设法将训练样例投影到⼀条直线上,使同类样例的投影点尽可能接近,异类样例的投影点尽可能远离.对新样本分类时根据投影点的位置来确定类别.多分类学习的分类器⼀般有以下三种策略:1. ⼀对⼀(OvO),N个类别产⽣N * (N - 1) / 2种分类器2. ⼀对多(OvR或称OvA),N个类别产⽣N - 1种分类器3. 多对多(MvM),如纠错输出码技术解决类别不平衡问题的三种⽅法:1. 过采样法,增加正例使正负例数⽬接近,如SMOTE:思想是合成新的少数类样本,合成的策略是对每个少数类样本a,从它的最近邻中随机选⼀个样本b,然后在a、b之间的连线上随机选⼀点作为新合成的少数类样本.2. ⽋采样法,减少负例使正负例数⽬接近,如EasyEnsemble:每次从⼤多数类中抽取和少数类数⽬差不多的重新组合,总共构成n个新的训练集,基于每个训练集训练出⼀个AdaBoost分类器(带阈值),最后结合之前训练分类器结果加权求和减去阈值确定最终分类类别.3. 再缩放法第4章决策树ID3决策树选择信息增益最⼤的属性来划分:1. 信息熵:2. 信息增益:C4.5决策树选择增益率⼤的属性来划分,因为信息增益准则对可取值数⽬较多的属性有所偏好.但增益率会偏好于可取值数⽬较少的属性,因此C4.5算法先找出信息增益⾼于平均⽔平的属性,再从中选择增益率最⾼的.另外,C4.5决策树采⽤⼆分法对连续值进⾏处理,使⽤时将划分阈值t作为参数,选择使信息增益最⼤的t划分属性.采⽤样本权值对缺失值进⾏处理,含有缺失值的样本同时划⼊所有结点中,但相应调整权重.1. 增益率:2. a的固有值:CART决策树则选择基尼指数最⼩的属性来划分,基尼系数反映了从数据集中随机抽取的两个样本类别不⼀致的概率,注意CART是⼆叉树,其余两种都为多叉树.1. 基尼值衡量的纯度:2. 基尼指数:剪枝是决策树对付过拟合的主要⼿段,分为预剪枝和后剪枝.1. 预剪枝对每个结点在划分前先进⾏估计,若该结点的划分不能带来决策树泛化性能提升,则停⽌划分.预剪枝基于"贪⼼"本质,所以有⽋拟合的风险.2. 后剪枝是先⽣成⼀棵完整的决策树,然后⾃底向上对⾮叶结点考察,若该结点替换为叶结点能带来决策树泛化性能提升,则将⼦树替换为叶结点.缺点是时间开销⼤.决策树所形成的分类边界是轴平⾏的,多变量决策树(斜决策树)的每⼀个⾮叶结点都是⼀个线性分类器,因此可以产⽣斜的划分边界.第5章神经⽹络误差逆传播算法(BP算法)是迄今为⽌最成功的神经⽹络学习算法.关键点在于通过计算误差不断逆向调整隐层神经元的连接权和阈值.标准BP算法每次仅针对⼀个训练样例更新,累积BP算法则根据训练集上的累积误差更新.缓解BP神经⽹络过拟合有两种常见策略:1. 早停:若训练集误差降低但验证集误差升⾼则停⽌训练.2. 正则化:在误差⽬标函数中增加⼀个描述⽹络复杂度的部分(较⼩的连接权和阈值将使神经⽹络较为平滑).跳出局部最⼩,寻找全局最⼩的常⽤⽅法:1. 以多组不同参数初始化多个神经⽹络,选择最接近全局最⼩的2. 模拟退⽕3. 随机梯度下降典型的深度学习模型就是很深层的神经⽹络.但是多隐层神经⽹络难以直接⽤经典算法进⾏训练,因为误差在多隐层内逆传播时往往会发散.⽆监督逐层训练(如深层信念⽹络,DBN)和权共享(如卷积神经⽹络,CNN)是常⽤的节省训练开销的策略.第6章⽀持向量机⽀持向量机中的原始样本空间不⼀定存在符合条件的超平⾯,但是如果原始空间是有限维,则总存在⼀个⾼维特征空间使样本线性可分.核函数就是⽤来简化计算⾼维特征空间中的内积的⼀种⽅法.核函数选择是⽀持向量机的最⼤变数.常⽤的核函数有线性核,多项式核,⾼斯核(RBF核),拉普拉斯核,Sigmoid核.对⽂本数据常⽤线性核,情况不明时可先尝试⾼斯核.软间隔是缓解⽀持向量机过拟合的主要⼿段,软间隔允许某些样本不满⾜约束.⽀持向量回归可以容忍预测输出f(x)和真实输出y之间存在ε的偏差,仅当偏差绝对值⼤于ε时才计算损失.⽀持向量机中许多规划问题都使⽤拉格朗⽇对偶算法求解,原因在于改变了算法复杂度.原问题的算法复杂度与样本维度有关,对偶问题的样本复杂度与样本数量有关.如果使⽤了升维的⽅法,则此时样本维度会远⼤于样本数量,在对偶问题下求解会更好.第7章贝叶斯分类基于贝叶斯公式来估计后验概率的困难在于类条件概率是所有属性上的联合概率,难以从有限的训练样本直接估计⽽得.因此朴素贝叶斯分类器采⽤了"属性条件独⽴性假设"来避开这个障碍.朴素贝叶斯分类器中为了避免其他属性携带的信息被训练集中未出现的属性值"抹去",在估计概率值时通常要进⾏"平滑",常⽤拉普拉斯修正.属性条件独⽴性假设在现实中往往很难成⽴,于是半朴素贝叶斯分类器采⽤"独依赖估计(ODE)",即假设每个属性在类别之外最多仅依赖于⼀个其他属性.在此基础上有SPODE,TAN,AODE等算法.贝叶斯⽹⼜称信念⽹,借助有向⽆环图来刻画属性之间的依赖关系,并⽤条件概率表来描述属性的联合概率分布.半朴素贝叶斯分类器是贝叶斯⽹的⼀种特例.EM(Expectation-Maximization)算法是常⽤的估计参数隐变量的⽅法.基本思想是:若参数θ已知,则可根据训练数据推断出最优隐变量Z的值(E);若Z的值已知,则可⽅便地对参数θ做极⼤似然估计(M).第8章集成学习集成学习先产⽣⼀组个体学习器,再⽤某种策略将它们结合起来.如果集成中只包含同种类型的个体学习器则叫同质集成,其中的个体学习器称为基学习器,相应的学习算法称为基学习算法.如果包含不同类型的个体学习器则叫异质集成,其中的学习器常称为组件学习器.要获得好的集成,个体学习器应"好⽽不同".即要有⼀定的准确性,并且要有多样性.⽬前的集成学习⽅法⼤致分为两⼤类:1. 序列化⽅法:个体学习器间存在强依赖关系,必须串⾏⽣成.2. 并⾏化⽅法:个体学习器间不存在强依赖关系,可同时⽣成.Boosting先从初始训练集训练出⼀个基学习器,再根据基学习器的表现对训练样本分布进⾏调整,使做错的训练样本在后续受到更多关注(给予更⼤的权重或重采样).然后基于调整后的样本分布来训练下⼀个基学习器;直到基学习器的数⽬达到指定值T之后,将这T个基学习器加权结合.Boosting主要关注降低偏差,因此能基于泛化性能相当弱的学习器构建出很强的集成.代表算法有AdaBoost.Bagging是并⾏式集成学习⽅法最著名的代表.它基于⾃助采样法,采样出T个含m个训练样本的采样集,基于每个采样集训练出⼀个基学习器,再将这些基学习器进⾏简单结合.在对预测输出进⾏结合时,常对分类任务使⽤投票法,对回归任务使⽤平均法.Bagging主要关注降低⽅差,因此在不剪枝决策树,神经⽹络等易受样本扰动的学习器上效⽤更明显.代表算法有随机森林.随机森林在以决策树为基学习器构建Bagging的基础上,进⼀步引⼊了随机属性选择.即先从属性集合(假定有d个属性)中随机选择⼀个包含k个属性的⼦集,再从这个⼦集中选择⼀个最优属性进⾏划分.当k=d时,基决策树与传统决策树相同.当k=1时,则随机选择⼀个属性⽤于划分.⼀般推荐k=log2d.学习器结合可能会从三个⽅⾯带来好处:1. 统计:可能有多个假设在训练集上达到同等性能,单学习器可能因误选⽽导致泛化性能不佳,结合多个学习器会减⼩这⼀风险.2. 计算:通过多次运⾏之后进⾏结合,降低陷⼊糟糕局部极⼩点的风险.3. 表⽰:结合多个学习器,相应的假设空间有所扩⼤,有可能学得更好的近似.结合策略:1. 平均法:对数值型输出,最常见的策略是平均法.⼀般⽽⾔,在个体学习器性能相差较⼤时使⽤加权平均法,性能相近时使⽤简单平均法.权重⼀般也是从训练数据中学习⽽得.2. 投票法:对分类任务来说,最常见的策略是投票法.⼜可细分为绝对多数投票法,相对多数投票法,加权投票法.绝对多数投票法允许"拒绝预测",若必须提供预测结果则退化为相对多数投票法.若基学习器的类型不同,则类概率值不能直接⽐较,需要将类概率输出转化为类标记输出后再投票.3. 学习法:当训练数据很多时,⼀种更强⼤的策略是通过另⼀个学习器来结合.Stacking是学习法的典型代表.我们把个体学习器称为初级学习器,⽤于结合的学习器称为次级学习器或元学习器.Stacking⽤初级学习器的输出作为样例输⼊特征,⽤初始样本的标记作为样例标记,然后⽤这个新数据集来训练次级学习器.⼀般⽤初级学习器的输出类概率作为次级学习器的输⼊属性,⽤多响应线性回归(Multi-response Linear Regression,MLR)作为次级学习算法效果较好.多样性增强常⽤的⽅法有:数据样本扰动,输⼊属性扰动,输出表⽰扰动,算法参数扰动.第9章聚类聚类既能作为⼀个找寻数据内在分布结构的单独过程,也可以作为其他学习任务的前驱过程.我们希望"物以类聚",也就是聚类结果的"簇内相似度"⾼且"簇间相似度"低.聚类性能度量⼤致有两类.⼀类是将聚类结果与参考模型进⾏⽐较,称为外部指标,常⽤的有JC,FMI,RI;另⼀类是直接考察聚类结果,称为内部指标,常⽤的有DBI,DI.有序属性距离计算最常⽤的是闵可夫斯基距离,当p=2时即欧⽒距离,当p=1时即曼哈顿距离.对⽆序属性可采⽤VDM(Value Difference Metric),将闵可夫斯基距离和VDM结合即可处理混合属性,当不同属性的重要性不同时可使⽤加权距离.我们基于某种形式的距离来定义相似度度量,但是⽤于相似度度量的距离未必⼀定要满⾜距离度量的基本性质,尤其是直递性.在现实任务中有必要通过距离度量学习来基于数据样本确定合适的距离计算式.原型聚类假设聚类结构能通过⼀组原型刻画.通常算法先对原型进⾏初始化,然后对原型进⾏迭代更新求解.常⽤的原型聚类算法有k均值算法,学习向量量化,⾼斯混合聚类.密度聚类假设聚类结构能通过样本分布的紧密程度确定.通常从样本密度的⾓度来考察样本之间的可连接性,并基于可连接样本不断扩展聚类簇.常⽤算法有DBSCAN层次聚类试图在不同层次对数据集进⾏划分,从⽽形成树形的聚类结构.代表算法有AGNES.第10章降维与度量学习懒惰学习在训练阶段只把样本保存起来,训练时间开销为零,待收到测试样本后再进⾏处理,如k近邻学习(kNN).急切学习则在训练阶段就对样本进⾏学习处理.若任意测试样本x附近任意⼩的δ距离范围内总能找到⼀个训练样本,即训练样本的采样密度⾜够⼤,或称为密采样,则最近邻分类器(1NN)的泛化错误率不超过贝叶斯最优分类器的错误率的两倍.在⾼维情形下出现的数据样本稀疏,距离计算困难等问题称为"维数灾难".处理⾼维数据的两⼤主流技术是降维和特征选择.降维亦称维数约简,即通过某种数学变换将原始⾼维属性空间转变为⼀个低维⼦空间.能进⾏降维的原因是与学习任务密切相关的或许仅仅是数据样本的某个低维分布,⽽不是原始⾼维空间的样本点.多维缩放是⼀种经典的降维⽅法.它使原始空间中样本之间的距离在低维空间中得以保持.主成分分析(PCA)是最常⽤的⼀种降维⽅法.如果要⽤⼀个超平⾯对所有样本进⾏恰当的表达,这个超平⾯应该具有最近重构性和最⼤可分性两种性质.基于这两种性质可以得到主成分分析的等价推导.PCA可以使样本的采样密度增⼤,同时在⼀定程度上起到去噪的效果.线性降维⽅法有可能丢失低维结构,因此要引⼊⾮线性降维.⼀种常⽤⽅法是基于核技巧对线性降维⽅法进⾏核化.如核主成分分析(KPCA).流形学习(manifold learning)是⼀类借鉴了拓扑流形概念的降维⽅法.流形在局部具有欧⽒空间性质.将低维流形嵌⼊到⾼维空间中,可以容易地在局部建⽴降维映射关系,再设法将局部映射关系推⼴到全局.常⽤的流形学习⽅法有等度量映射和局部线性嵌⼊等.对⾼维数据进⾏降维的主要⽬的是找到⼀个合适的低维空间.事实上,每个空间对应了在样本属性上定义的⼀个距离度量,度量学习直接尝试学习出⼀个合适的距离度量.常⽤⽅法有近邻成分分析(NCA).第11章特征选择与稀疏学习对当前学习任务有⽤的属性称为相关特征,没什么⽤的属性称为⽆关特征.从给定特征集合中选择出相关特征⼦集的过程称为特征选择.特征选择是⼀个重要的数据预处理过程.冗余特征是指包含的信息可以从其他特征中推演出来的特征.冗余特征在很多时候不起作⽤,但若某个冗余特征恰好对应了完成学习任务所需的中间概念,则该冗余特征反⽽是有益的.⼦集搜索:可以采⽤逐渐增加相关特征的前向搜索,每次在候选⼦集中加⼊⼀个特征,选取最优候选⼦集.也可以采⽤每次去掉⼀个⽆关特征的后向搜索.这些策略是贪⼼的,但是避免了穷举搜索产⽣的计算问题.⼦集评价:特征⼦集A确定了对数据集D的⼀个划分,样本标记信息Y对应着对D的真实划分,通过估算这两个划分的差异就能对A进⾏评价.可采⽤信息熵等⽅法.过滤式选择先对数据集进⾏特征选择,然后再训练学习器,特征选择过程与后续学习器⽆关.Relief(Relevant Features)是⼀种著名的过滤式选择⽅法.该⽅法设计了⼀个相关统计量来度量特征的重要性.包裹式选择直接把最终将要使⽤的学习器的性能作为特征⼦集的评价标准.因此产⽣的最终学习器的性能较好,但训练时的计算开销也更⼤.LVW(Las Vegas Wrapper)是⼀个典型的包裹式特征选择⽅法,它在拉斯维加斯⽅法框架下使⽤随机策略来进⾏⼦集搜索,并以最终分类器的误差为特征⼦集评价准则.嵌⼊式选择是将特征选择过程与学习器训练过程融为⼀体,两者在同⼀个优化过程中完成.例如正则化.L1正则化(Lasso)是指权值向量w中各个元素的绝对值之和.L1正则化趋向选择少量的特征,使其他特征尽可能为0,可以产⽣稀疏权值矩阵,即产⽣⼀个稀疏模型,可以⽤于特征选择.L1正则化是L0正则化的最优凸近似.L2正则化(Ridge)是指权值向量w中各个元素的平⽅和然后再求平⽅根.L2正则化趋向选择更多的特征,让这些特征尽可能接近0,可以防⽌模型过拟合(L1也可以).字典学习也叫稀疏编码,指的是为普通稠密表达的样本找到合适的字典,将样本转化为合适的稀疏表达形式,从⽽使学习任务得以简化,模型复杂度得以降低的过程.压缩感知关注的是利⽤信号本⾝的稀疏性,从部分观测样本中恢复原信号.分为感知测量和重构恢复两个阶段,其中重构恢复⽐较重要.可利⽤矩阵补全等⽅法来解决推荐系统之类的协同过滤(collaborative filtering)任务.由于第⼀次阅读,12章开始的内容仅作概念性了解.第12章计算学习理论计算学习理论研究的是关于通过计算来进⾏学习的理论,⽬的是分析学习任务的困难本质,为学习算法提供理论保证,并提供分析结果指导算法设计.计算学习理论中最基本的是概率近似正确(Probably Approximately Correct,PCA)学习理论.由此可以得到PAC辨识,PAC可学习,PAC学习算法,样本复杂度等概念.有限假设空间的可分情形都是PAC可学习的.对于不可分情形,可以得到不可知PAC可学习的概念,即在假设空间的所有假设中找到最好的⼀个.对⼆分类问题来说,假设空间中的假设对数据集中⽰例赋予标记的每种可能结果称为对数据集的⼀种对分.若假设空间能实现数据集上的所有对分,则称数据集能被假设空间打散.假设空间的VC维是能被假设空间打散的最⼤数据集的⼤⼩.算法的稳定性考察的是算法在输⼊发⽣变化时,输出是否会随之发⽣较⼤的变化.第13章半监督学习主动学习是指先⽤有标记样本训练⼀个模型,通过引⼊额外的专家知识,将部分未标记样本转变为有标记样本,每次都挑出对改善模型性能帮助⼤的样本,从⽽构建出⽐较强的模型.未标记样本虽未直接包含标记信息,但若它们与有标记样本是从同样的数据源独⽴同分布采样⽽来,则它们所包含的关于数据分布的信息对建模⼤有裨益.要利⽤未标记样本,需要有⼀些基本假设,如聚类假设,流形假设.半监督学习可进⼀步划分为纯半监督学习和直推学习.前者假定训练数据中的未标记样本并⾮待预测的数据,⽽后者则假定学习过程中所考虑的未标记样本恰是待预测数据.⽣成式⽅法是直接基于⽣成式模型的⽅法.此类⽅法假设所有数据都是由同⼀个潜在的模型⽣成的.这个假设使得我们能通过潜在模型的参数将未标记数据与学习⽬标联系起来.半监督⽀持向量机(S3VM)是⽀持向量机在半监督学习上的推⼴.S3VM试图找到能将两类有标记样本分开,且穿过数据低密度区域的划分超平⾯.除此之外,还有图半监督学习,基于分歧的⽅法(如协同训练),半监督聚类等学习⽅法.第14章概率图模型机器学习最重要的任务,是根据⼀些已观察到的证据来对感兴趣的未知变量进⾏估计和推测.⽣成式模型考虑联合分布P(Y,R,O),判别式模型考虑条件分布P(Y,R|O).概率图模型是⼀类⽤图来表达变量相关关系的概率模型.若变量间存在显式的因果关系,常使⽤贝叶斯⽹.若变量间存在相关性但难以获取显式的因果关系,常使⽤马尔可夫⽹.隐马尔可夫模型(Hidden Markov Model,HMM)是结构最简单的动态贝叶斯⽹.主要⽤于时序数据建模,在语⾳识别,⾃然语⾔处理等领域有⼴泛应⽤.隐马尔可夫模型中有状态变量(隐变量)和观测变量两组变量.马尔可夫链:系统下⼀时刻的状态仅有当前状态决定,不依赖于以往的任何状态.马尔可夫随机场(Markov Random Field,MRF)是典型的马尔可夫⽹.每⼀个结点表⽰⼀个或⼀组变量,结点之间的边表⽰两个变量之间的依赖关系.条件随机场是判别式模型,可看作给定观测值的马尔可夫随机场.概率图模型的推断⽅法⼤致分为两类.第⼀类是精确推断,代表性⽅法有变量消去和信念传播.第⼆类是近似推断,可⼤致分为采样(如MCMC采样)和使⽤确定性近似完成近似推断(如变分推断).第15章规则学习规则学习是指从训练数据中学习出⼀组能⽤于对未见⽰例进⾏判别的规则.规则学习具有较好的可解释性,能使⽤户直观地对判别过程有所了解.规则学习的⽬标是产⽣⼀个能覆盖尽可能多的样例的规则集,最直接的做法是序贯覆盖,即逐条归纳:每学到⼀条规则,就将该规则覆盖的训练样例去除.常采⽤⾃顶向下的⽣成-测试法.规则学习缓解过拟合的常见做法是剪枝,例如CN2,REP,IREP等算法.著名的规则学习算法RIPPER就是将剪枝与后处理优化相结合.命题规则难以处理对象之间的关系,因此要⽤⼀阶逻辑表⽰,并且要使⽤⼀阶规则学习.它能更容易地引⼊领域知识.著名算法有FOIL(First-Order Inductive Learner)等.第16章强化学习强化学习的⽬的是要找到能使长期累积奖赏最⼤化的策略.在某种意义上可看作具有"延迟标记信息"的监督学习问题.每个动作的奖赏值往往来⾃于⼀个概率分布,因此强化学习会⾯临"探索-利⽤窘境",因此要在探索和利⽤中达成较好的折中.ε-贪⼼法在每次尝试时以ε的概率进⾏探索,以均匀概率随机选取⼀个动作.以1-ε的概率进⾏利⽤,选择当前平均奖赏最⾼的动作.Softmax算法则以较⾼的概率选取平均奖赏较⾼的动作.强化学习任务对应的马尔可夫决策过程四元组已知的情形称为模型已知.在已知模型的环境中学习称为"有模型学习".反之称为"免模型学习".从⼈类专家的决策过程范例中学习的过程称为模仿学习.。

[鱼书笔记]深度学习入门:基于Python的理论与实现个人笔记分享

![[鱼书笔记]深度学习入门:基于Python的理论与实现个人笔记分享](https://img.taocdn.com/s3/m/0157d41d77c66137ee06eff9aef8941ea76e4be7.png)

[鱼书笔记]深度学习⼊门:基于Python的理论与实现个⼈笔记分享为了完成毕设, 最近开始⼊门深度学习.在此和⼤家分享⼀下本⼈阅读鱼书时的笔记,若有遗漏,欢迎斧正!若转载请注明出处!⼀、感知机感知机(perceptron)接收多个输⼊信号,输出⼀个信号。

如图感知机,其接受两个输⼊信号。

其中θ为阈值,超过阈值神经元就会被激活。

感知机的局限性在于,它只能表⽰由⼀条直线分割的空间,即线性空间。

多层感知机可以实现复杂功能。

⼆、神经⽹络神经⽹络由三部分组成:输⼊层、隐藏层、输出层1. 激活函数激活函数将输⼊信号的总和转换为输出信号,相当于对计算结果进⾏简单筛选和处理。

如图所⽰的激活函数为阶跃函数。

1) sigmoid 函数sigmoid函数是常⽤的神经⽹络激活函数。

其公式为:h(x)=11+e−x如图所⽰,其输出值在 0到 1 之间。

2) ReLU 函数ReLU(Rectified Linear Unit)函数是最近常⽤的激活函数。

3) tanh 函数2. 三层神经⽹络的实现该神经⽹络包括:输⼊层、2 个隐藏层和输出层。

def forward(network, x): # x为输⼊数据# 第1个隐藏层的处理,点乘加上偏置后传⾄激活函数a1 = np.dot(x, W1) + b1z1 = sigmoid(a1)# 第2个隐藏层的处理a2 = np.dot(z1, W2) + b2z2 = sigmoid(a2)#输出层处理 identidy_function原模原样输出a3a3 = np.dot(z2, W3) + b3y = identify_function(a3)return y # y为最终结果3. 输出层激活函数⼀般来说,回归问题选择恒等函数,分类问题选择softmax函数。

softmax函数的公式:y k=e a k ∑n i=1e a i假设输出层有n个神经元,计算第k个神经元的输出y k。

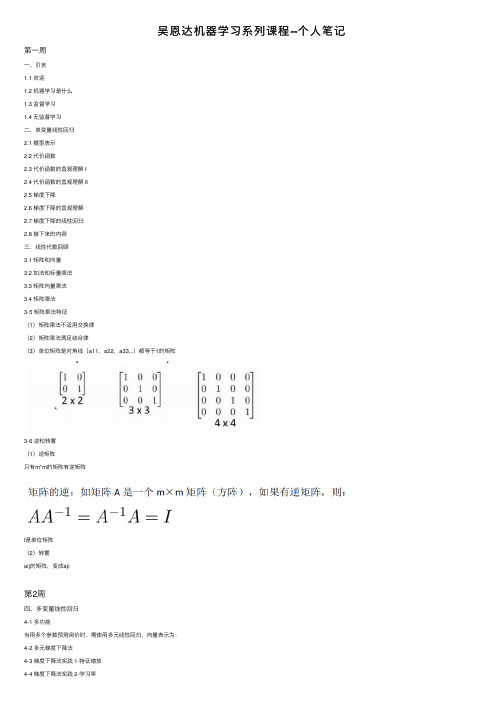

吴恩达机器学习系列课程--个人笔记

吴恩达机器学习系列课程--个⼈笔记第⼀周⼀、引⾔1.1 欢迎1.2 机器学习是什么1.3 监督学习1.4 ⽆监督学习⼆、单变量线性回归2.1 模型表⽰2.2 代价函数2.3 代价函数的直观理解 I2.4 代价函数的直观理解 II2.5 梯度下降2.6 梯度下降的直观理解2.7 梯度下降的线性回归2.8 接下来的内容三、线性代数回顾3.1 矩阵和向量3.2 加法和标量乘法3.3 矩阵向量乘法3.4 矩阵乘法3-5 矩阵乘法特征(1)矩阵乘法不适⽤交换律(2)矩阵乘法满⾜结合律(3)单位矩阵是对⾓线(a11,a22,a33...)都等于1的矩阵3-6 逆和转置(1)逆矩阵只有m*m的矩阵有逆矩阵I是单位矩阵(2)转置aij的矩阵,变成aji第2周四、多变量线性回归4-1 多功能当⽤多个参数预测房价时,需使⽤多元线性回归,向量表⽰为:4-2 多元梯度下降法4-3 梯度下降法实践 1-特征缩放4-4 梯度下降法实践 2-学习率4-5 特征和多项式回归4-6 正规⽅程4-7 正规⽅程及不可逆性(可选)五、Octave教程5-1 基本操作~= 表⽰逻辑不等于5-2 移动数据5-3 计算数据5-4 数据绘制5-5 控制语句:for while if 语句5-6 ⽮量(没太看懂)第三周六、逻辑回归6-1 分类逻辑回归算法(logistics regression)——逻辑回归算法是个分类算法,它适⽤于y值取离散值得情况。

⼆元分类(0,1分类)6-2 假设陈述6-3 决策界限6-4 代价函数6-5 简化代价函数与梯度下降6-6 ⾼级优化学完本章需要实现:写⼀个函数,它能返回代价函数值、梯度值,因此要把这个应⽤到逻辑回归或者甚⾄线性回归中,你也可以把这些优化算法⽤于线性回归,你需要做的就是输⼊合适的代码来计算这⾥的这些东西。

6-7 多元分类——⼀对多y值是多个分类值七、正则化7-1 过拟合问题什么是过拟合正则化7-2 代价函数7-3 线性回归的正则化7-4 逻辑回归的正则化---------------------------------------⽬前⼤家对机器学习算法可能还只是略懂,但是⼀旦你精通了线性回归、⾼级优化算法和正则化技术,坦率地说,你对机器学习的理解可能已经⽐许多⼯程师深⼊了。

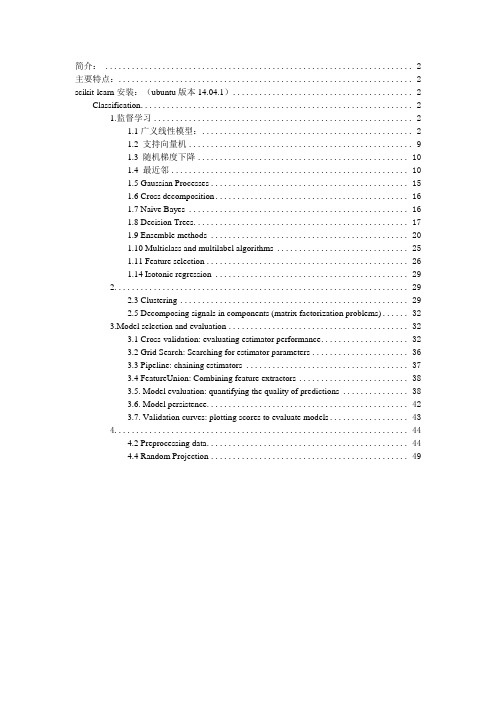

scikit-learn学习笔记

简介: (2)主要特点: (2)scikit-learn安装:(ubuntu版本14.04.1) (2)Classification (2)1.监督学习 (2)1.1广义线性模型: (2)1.2 支持向量机 (9)1.3 随机梯度下降 (10)1.4 最近邻 (10)1.5 Gaussian Processes (15)1.6 Cross decomposition (16)1.7 Naive Bayes (16)1.8 Decision Trees (17)1.9 Ensemble methods (20)1.10 Multiclass and multilabel algorithms (25)1.11 Feature selection (26)1.14 Isotonic regression (29)2 (29)2.3 Clustering (29)2.5 Decomposing signals in components (matrix factorization problems) (32)3.Model selection and evaluation (32)3.1 Cross-validation: evaluating estimator performance (32)3.2 Grid Search: Searching for estimator parameters (36)3.3 Pipeline: chaining estimators (37)3.4 FeatureUnion: Combining feature extractors (38)3.5. Model evaluation: quantifying the quality of predictions (38)3.6. Model persistence (42)3.7. Validation curves: plotting scores to evaluate models (43)4 (44)4.2 Preprocessing data (44)4.4 Random Projection (49)简介:scikit-learn是一个用于机器学习的Python模块,建立在SciPy基础之上。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2

the i-th row of W , so that

W

Байду номын сангаас

=

—

w...1T

—

.

— wdT —

Thus, wi ∈ Rd, and the j-th source can be recovered as s(ji) = wjT x(i).

1 ICA ambiguities

To what degree can W = A−1 be recovered? If we have no prior knowledge about the sources and the mixing matrix, it is easy to see that there are some inherent ambiguities in A that are impossible to recover, given only the x(i)’s.

Now, suppose we observe some x = As, where A is our mixing matrix. Then, the distribution of x will be Gaussian, x ∼ N (0, AAT ), since

Es∼N (0,I)[x] = E[As] = AE[s] = 0 Cov[x] = Es∼N (0,I)[xxT ] = E[AssT AT ] = AE[ssT ]AT = A · Cov[s] · AT = AAT

Let W = A−1 be the unmixing matrix. Our goal is to find W , so that given our microphone recordings x(i), we can recover the sources by computing s(i) = W x(i). For notational convenience, we also let wiT denote

To formalize this problem, we imagine that there is some data s ∈ Rd that is generated via d independent sources. What we observe is

x = As,

where A is an unknown square matrix called the mixing matrix. Repeated observations gives us a dataset {x(i); i = 1, . . . , n}, and our goal is to recover the sources s(i) that had generated our data (x(i) = As(i)).

3

same factor; but this usually does not matter. (These comments also apply to ICA for the brain/MEG data that we talked about in class.)

Are these the only sources of ambiguity in ICA? It turns out that they are, so long as the sources si are non-Gaussian. To see what the difficulty is with Gaussian data, consider an example in which n = 2, and s ∼ N (0, I). Here, I is the 2x2 identity matrix. Note that the contours of the density of the standard normal distribution N (0, I) are circles centered on the origin, and the density is rotationally symmetric.

0 1 0 P = 1 0 0 ;

001

P=

01 10

;

P=

10 01

.

If z is a vector, then P z is another vector that contains a permuted version of z’s coordinates. Given only the x(i)’s, there will be no way to distinguish

if a single column of A were scaled by a factor of α, and the corresponding

source were scaled by a factor of 1/α, then there is again no way to determine that this had happened given only the x(i)’s. Thus, we cannot recover the

Our argument above was based on the fact that the multivariate standard normal distribution is rotationally symmetric. Despite the bleak picture that this paints for ICA on Gaussian data, it turns out that, so long as the data is not Gaussian, it is possible, given enough data, to recover the d independent sources.

Further, there is no way to recover the correct scaling of the wi’s. For instance, if A were replaced with 2A, and every s(i) were replaced with (0.5)s(i), then our observed x(i) = 2A · (0.5)s(i) would still be the same. More broadly,

In our cocktail party problem, s(i) is an d-dimensional vector, and s(ji) is the sound that speaker j was uttering at time i. Also, x(i) in an d-dimensional vector, and x(ji) is the acoustic reading recorded by microphone j at time i.

CS229 Lecture notes

Andrew Ng

Part XII

Independent Components Analysis

Our next topic is Independent Components Analysis (ICA). Similar to PCA, this will find a new basis in which to represent our data. However, the goal is very different.

between W and P W . Specifically, the permutation of the original sources is

ambiguous, which should be no surprise. Fortunately, this does not matter

for most applications.

As a motivating example, consider the “cocktail party problem.” Here, d speakers are speaking simultaneously at a party, and any microphone placed in the room records only an overlapping combination of the d speakers’ voices. But lets say we have d different microphones placed in the room, and because each microphone is a different distance from each of the speakers, it records a different combination of the speakers’ voices. Using these microphone recordings, can we separate out the original d speakers’ speech signals?

Specifically, let P be any d-by-d permutation matrix. This means that each row and each column of P has exactly one “1.” Here are some examples of permutation matrices:

Now, let R be an arbitrary orthogonal (less formally, a rotation/reflection) matrix, so that RRT = RT R = I, and let A′ = AR. Then if the data had been mixed according to A′ instead of A, we would have instead observed x′ = A′s. The distribution of x′ is also Gaussian, x′ ∼ N (0, AAT ), since Es∼N (0,I)[x′(x′)T ] = E[A′ssT (A′)T ] = E[ARssT (AR)T ] = ARRT AT = AAT . Hence, whether the mixing matrix is A or A′, we would observe data from a N (0, AAT ) distribution. Thus, there is no way to tell if the sources were mixed using A and A′. There is an arbitrary rotational component in the mixing matrix that cannot be determined from the data, and we cannot recover the original sources.