人工智能选股之stacking集成学习

深度学习中的模型融合与集成学习方法(Ⅱ)

深度学习中的模型融合与集成学习方法深度学习是一种基于人工神经网络的机器学习方法,它通过构建多层神经网络模拟人脑进行学习和预测。

在深度学习中,模型融合和集成学习方法被广泛应用于提高预测准确性和模型泛化能力。

本文将从模型融合的概念入手,深入探讨深度学习中的模型融合与集成学习方法。

模型融合的概念模型融合是指将多个模型的预测结果进行整合,以提高模型的准确性和鲁棒性。

在深度学习中,由于神经网络模型的复杂性和不稳定性,单一模型往往难以达到理想的性能。

因此,模型融合成为提高深度学习模型性能的重要手段之一。

集成学习方法集成学习是一种通过结合多个模型来改善预测性能的机器学习方法。

常见的集成学习方法包括Bagging、Boosting、Stacking等。

在深度学习中,这些集成学习方法也得到了广泛的应用。

BaggingBagging(Bootstrap Aggregating)是一种基于自助采样(Bootstrap Sampling)的集成学习方法。

在深度学习中,Bagging通常通过训练多个独立的神经网络模型,并将它们的预测结果进行平均或投票来得到最终的预测结果。

由于每个模型都是在不同的训练数据集上训练得到的,因此可以有效减少模型的方差,提高泛化能力。

BoostingBoosting是一种通过迭代训练来提升模型性能的集成学习方法。

常见的Boosting算法包括AdaBoost、Gradient Boosting等。

在深度学习中,Boosting 方法可以通过顺序训练多个神经网络模型,并根据前一个模型的预测结果来调整后一个模型的训练目标,从而逐步提升整体模型的性能。

StackingStacking是一种通过将多个基础模型的预测结果作为特征,然后训练一个元模型(Meta Model)来得到最终预测结果的集成学习方法。

在深度学习中,Stacking方法可以通过将多个神经网络模型的隐层输出或预测结果作为特征,然后训练一个额外的神经网络模型来得到最终的预测结果。

211189560_基于多因子融合和Stacking集成学习的大坝变形组合预测模型

2023年4月水 利 学 报SHUILI XUEBAO第54卷 第4期文章编号:0559-9350(2023)04-0497-10收稿日期:2022-09-13;网络首发日期:2023-03-31网络首发地址:https:??kns.cnki.net?kcms?detail?11.1882.TV.20230331.1519.001.html基金项目:国家自然科学基金项目(U2243223,51739003)作者简介:王瑞婕(1998-),硕士生,主要从事水工结构安全监控研究。

E-mail:wangrj@hhu.edu.cn通讯作者:包腾飞(1974-),博士,教授,主要从事水工结构及岩土工程的安全监控、光纤传感器在结构健康监测中的应用研究。

E-mail:baotf@hhu.edu.cn基于多因子融合和Stacking集成学习的大坝变形组合预测模型王瑞婕1,包腾飞1,2,3,李扬涛1,宋宝钢1,向镇洋1(1.河海大学水利水电学院,江苏南京 210098;2.河海大学水文水资源与水利工程科学国家重点实验室,江苏南京 210098;3.三峡大学水利与环境学院,湖北宜昌 443002)摘要:变形是反映大坝服役形态变化的直观表征,构建高效准确的变形预测模型对于大坝结构安全控制十分重要。

传统单因子及单算法变形预测模型存在泛化能力不足、鲁棒性差等问题,易出现预测偏差甚至误判。

针对这一问题,本文选取不同变形解释因子及回归算法,构建多种单因子单算法预测模型,结合Stacking集成学习思想,对上述模型进行组合,提出了大坝变形组合预测模型。

该组合模型以Stacking集成学习为核心,采用高斯过程回归作为元学习器,从算法、因子两方面对单因子单算法预测模型进行集成,并通过k折交叉验证减小模型过拟合风险。

以某混凝土拱坝变形监测数据为例,通过多模型构建与性能比较,对所提出模型的准确性与有效性进行评估。

结果表明:单因子单算法预测模型具备准确性和多样性的特征;通过算法、因子集成,组合模型的预测精度和鲁棒性得到了显著提高,在水位波动期的预测能力得到了有效增强。

机器学习中的模型融合与集成技术

机器学习中的模型融合与集成技术随着人工智能技术的快速发展,机器学习在各个领域取得了重大突破,成为了许多问题的解决方案。

然而,单一的机器学习模型往往难以满足复杂任务的需求,因此模型融合与集成技术应运而生。

本文将探讨机器学习中的模型融合与集成技术,介绍其原理、常见方法以及应用场景。

模型融合是指将多个不同的模型结合在一起,以获得更好的性能表现。

在机器学习领域,模型融合可以通过多种方式实现,例如bagging、boosting、stacking等。

这些方法都旨在利用多个模型的优势互补,从而提升整体性能。

Bagging是一种较为简单且常用的模型融合方法,它通过对训练数据进行有放回的采样,然后分别训练多个基模型,最后将它们的预测结果进行平均或投票。

这样做可以降低模型的方差,提高泛化能力。

随机森林就是一种基于Bagging思想的集成学习算法,它通过构建多个决策树,并将它们的结果进行平均来得到最终预测。

Boosting是另一种常见的模型融合方法,它通过反复训练模型,并根据前一轮的表现调整样本权重,从而使得模型关注于前几轮训练中表现不佳的样本。

最典型的boosting算法是Adaboost和Gradient Boosting Machine(GBM),它们在分类和回归任务上都取得了很好的效果。

除了bagging和boosting,还有一种更为复杂的模型融合方法叫做stacking。

Stacking通过将多个基模型的预测结果作为输入,再训练一个元模型来得到最终的预测结果。

这样做可以利用不同模型的优势,从而获得更好的性能。

然而,stacking也需要更多的计算资源和时间,因此在实际应用中往往需要权衡。

模型融合与集成技术在各个领域都有着广泛的应用。

在分类问题中,可以通过结合多个分类器的预测结果来提高准确率;在回归问题中,可以通过融合多个回归模型的结果来提高预测精度。

此外,在推荐系统、自然语言处理、图像识别等领域,模型融合与集成技术同样发挥着重要作用。

211202184_基于Stacking集成学习的恶意URL检测系统设计与实现

现代电子技术Modern Electronics TechniqueMay 2023Vol.46No.102023年5月15日第46卷第10期0引言近些年来,恶意URL (Malicious Uniform Resource Locator )逐渐成为网络犯罪的重要途径,恶意URL 通过作为钓鱼网页载体[1]、XSS 攻击[2]等多种方式窃取用户的隐私和财产,造成了严重的网络安全威胁,因此对恶意URL 实施有效的检测对网络安全至关重要。

传统的URL 检测方法有黑名单技术[3]、启发式技术[4]等。

黑名单技术是将已知的恶意URL 加入黑名单,当点击被加入过黑名单的恶意URL 时,系统会对比黑名单进行拦截,但对于不在黑名单内的恶意URL ,不能进行防护,所以其缺点在于不能对新的URL 进行实时DOI :10.16652/j.issn.1004⁃373x.2023.10.020引用格式:张永刚,吕鹏飞,张悦,等.基于Stacking 集成学习的恶意URL 检测系统设计与实现[J].现代电子技术,2023,46(10):105⁃109.基于Stacking 集成学习的恶意URL检测系统设计与实现张永刚1,吕鹏飞1,张悦1,姚兴博2,冯艳丽2(1.国网内蒙古东部电力有限公司,内蒙古呼和浩特010020;2.南京农业大学人工智能学院,江苏南京210095)摘要:针对传统URL 检测方法在恶意URL 检测时存在的准确率不高、实时性差等问题,提出一种基于Stacking 集成学习的算法模型。

该模型采用机器学习单一方法中的岭分类、支持向量机、朴素贝叶斯作为初级学习器,采用逻辑回归作为次级学习器,通过初级学习器和次级学习器相结合的双层结构对URL 进行检测。

使用大量的URL 数据集分别对单一方法中的模型和Stacking 集成学习方法的模型进行训练,并对每种模型进行评估。

评估结果表明,Stacking 集成学习的算法模型对恶意URL 检测的准确率可达98.75%,与其他模型相比提升0.75%以上。

集成学习方法总结

汇报人:XXX

提升集成方法:通过调整基学习器的权重,使得整个集成学习器的预测结果更加准 确。

Bagging方法:通过有放回的抽样方式,从数据集中生成多个子集,并分别训练基学 习器,最后将多个基学习器的预测结果进行平均或投票。

随机森林方法:一种基于Bagging的集成学习方法,通过构建多棵决策树,并将它们 的预测结果进行平均或投票,得到最终的预测结果。

集成学习的基本原理是利用不同学习器的优势,通过互补的方式提高整体的预测精度和泛化能 力。

集成学习的方法包括bagging、boosting、stacking等,这些方法通过不同的方式生成多个学习 器,并采用不同的融合策略将它们的结果进行融合。

平均集成方法:将多个基学习器的预测结果进行平均或投票,得到最终的预测结果。

优势:提高模型的稳定性和泛化能力

应用场景:适用于分类和回归问题

定义:通过将多个弱学习器组合成 一个强学习器来提高分类准确率的 方法

优势:能够处理噪声数据和异常值, 提高模型的鲁棒性

添加标题

添加标题

常用算法:AdaBoost、Gradient Boosting等

添加标题

添加标题

适用场景:适用于分类和回归问题

XXX,a click to unlimited possibilities

汇报人:XXX

01

03

05

02

04

集成学习是一种机器学习技术,通过结合多个学习器的预测结果来提高整体预测精度和泛化能 力。

集成学习的主要思想是将多个学习器组合起来,通过一定的策略将它们的结果进行融合,以获 得更好的预测性能。

基于Stacking集成学习的泥石流易发性评价以四川省雅江县为例

第40卷 第1期2021年2月 世 界 地 质GLOBALGEOLOGYVol 40 No 1Feb 2021 文章编号:1004—5589(2021)01—0175—10基于Stacking集成学习的泥石流易发性评价:以四川省雅江县为例苏刚,秦胜伍,乔双双,扈秀宇,陈阳,车文超吉林大学建设工程学院,长春130000摘要:为给四川省雅江县提供直观准确的泥石流易发性图,将四川省雅江县作为研究区,选用高程、坡度、坡向、地形起伏度、平面曲率、剖面曲率、年平均降雨、到河流的距离、到道路的距离、地形湿度指数、归一化差分植被指数及土壤类型12个评价因子,利用Stacking集成学习框架,结合支持向量机、神经网络和随机森林,建立了一种多模型融合的泥石流预测模型。

通过ROC曲线验证了模型的准确性,得出Stacking融合模型、随机森林、神经网络和支持向量机模型的成功率分别是98 1%、96 1%、94 5%、93 4%,预测率分别是95 5%、91 6%、90 6%、89 7%。

结果表明:Stacking融合模型精度最高,最适合用于雅江县泥石流易发性评价。

关键词:泥石流易发性;Stacking集成学习;随机森林;支持向量机;神经网络;雅江县中图分类号:TP181;P642 23 文献标识码:A doi:10 3969/j issn 1004 5589 2021 01 020收稿日期:2020 07 24;改回日期:2020 09 21基金项目:国家自然科学基金项目(41977221)与吉林省科技发展计划项目(20190303103SF)资助。

通讯作者:秦胜伍(1980—),男,教授,主要从事地质工程、地质灾害治理研究。

E mail:qinsw@jlu edu cnDebrisflowsusceptibilityevaluationbasedonStackingensemblelearning:acasestudyinYajiang,SichuanProvinceSUGang,QINSheng wu,QIAOShuang shuang,HUXiu yu,CHENYang,CHEWen chaoCollegeofConstructionEngineering,JilinUniversity,Changchun130026,ChinaAbstract:InordertoprovideanintuitiveandaccuratedebrisflowsusceptibilitymapofYajianginSichuanProvince,Yajiangistakenasthestudyareaand12evaluationfactorsincludingelevation,slope,slopedirection,topographicrelief,plancurvature,profilecurvature,averageannualrainfall,distancetorivers,distancetoroads,normalizeddifferencevegetationindex,topographicwetnessindex,andsoiltypeareselected.Amulti modelfusiondebrisflowpredictionmodelisestablishedbyusingtheStackingensemblelearningframeworkcom binedwithsupportvectormachine,neuralnetworkandrandomforest.TheaccuracyofthemodelwasverifiedbyROCcurve.ThesuccessratesoftheStackingfusionmodel,randomforest,neuralnetwork,andsupportvectormachinemodelare98 1%,96 1%,94 5%and93 4%,andthepredictionratesare95 5%,91 6%,90 6%and89 7%,respectively.TheresultsshowthattheStackingfusionmodelhasthehighestaccuracyandismostsuitablefortheevaluationofdebrisflowsusceptibilityinYajiang.Keywords:debrisflowsusceptibility;Stackingensemblelearning;randomforest;supportvectormachine;neuralnetwork;YajiangCounty0 引言泥石流是山区最容易发生的地质灾害之一,主要由于突然性的暴雨等极端天气引发。

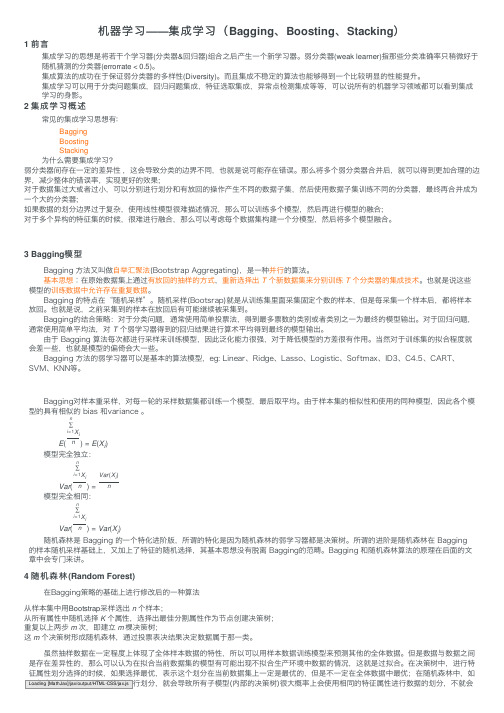

机器学习——集成学习(Bagging、Boosting、Stacking)

机器学习——集成学习(Bagging、Boosting、Stacking)1 前⾔集成学习的思想是将若⼲个学习器(分类器&回归器)组合之后产⽣⼀个新学习器。

弱分类器(weak learner)指那些分类准确率只稍微好于随机猜测的分类器(errorrate < 0.5)。

集成算法的成功在于保证弱分类器的多样性(Diversity)。

⽽且集成不稳定的算法也能够得到⼀个⽐较明显的性能提升。

集成学习可以⽤于分类问题集成,回归问题集成,特征选取集成,异常点检测集成等等,可以说所有的机器学习领域都可以看到集成学习的⾝影。

2 集成学习概述常见的集成学习思想有∶BaggingBoostingStacking为什么需要集成学习?弱分类器间存在⼀定的差异性,这会导致分类的边界不同,也就是说可能存在错误。

那么将多个弱分类器合并后,就可以得到更加合理的边界,减少整体的错误率,实现更好的效果;对于数据集过⼤或者过⼩,可以分别进⾏划分和有放回的操作产⽣不同的数据⼦集,然后使⽤数据⼦集训练不同的分类器,最终再合并成为⼀个⼤的分类器;如果数据的划分边界过于复杂,使⽤线性模型很难描述情况,那么可以训练多个模型,然后再进⾏模型的融合;对于多个异构的特征集的时候,很难进⾏融合,那么可以考虑每个数据集构建⼀个分模型,然后将多个模型融合。

3 Bagging模型 Bagging ⽅法⼜叫做⾃举汇聚法(Bootstrap Aggregating),是⼀种并⾏的算法。

基本思想︰在原始数据集上通过有放回的抽样的⽅式,重新选择出 T 个新数据集来分别训练 T 个分类器的集成技术。

也就是说这些模型的训练数据中允许存在重复数据。

Bagging 的特点在“随机采样”。

随机采样(Bootsrap)就是从训练集⾥⾯采集固定个数的样本,但是每采集⼀个样本后,都将样本放回。

也就是说,之前采集到的样本在放回后有可能继续被采集到。

Bagging的结合策略:对于分类问题,通常使⽤简单投票法,得到最多票数的类别或者类别之⼀为最终的模型输出。

深度学习中的模型融合与集成学习方法(六)

深度学习中的模型融合与集成学习方法深度学习作为近年来人工智能领域的热点之一,其应用范围越来越广,包括图像识别、语音识别、自然语言处理等领域。

随着深度学习模型的不断发展,模型融合和集成学习方法也逐渐成为研究的重点之一。

模型融合和集成学习方法能够有效提高深度学习模型的性能和鲁棒性,本文将就这一主题展开讨论。

模型融合是指将多个模型的预测结果进行整合,得到更加可靠和准确的结果。

在深度学习中,模型融合可以分为硬投票和软投票两种方式。

硬投票是指不同模型投票决定最终结果的方式,即多个模型对样本进行预测后,最终结果由多数票决定。

软投票是指将多个模型的预测概率结合起来,然后选择概率最大的结果作为最终预测结果。

模型融合的方式多种多样,包括简单平均、加权平均、投票方式等。

不同的融合方式适用于不同的场景,需要根据具体问题进行选择。

集成学习方法是通过构建多个模型,然后将它们组合起来,得到更好的性能表现。

常见的集成学习方法包括Bagging、Boosting、Stacking等。

Bagging是一种并行的集成学习方法,通过随机采样训练集,构建多个模型,再将这些模型的输出进行平均或投票。

Boosting是一种串行的集成学习方法,它通过训练多个弱分类器,并根据前一个分类器的结果调整后续分类器的训练数据,从而得到一个强分类器。

Stacking是一种多层次的集成学习方法,将多个基础模型的输出作为输入,再训练一个元模型以得到最终的输出。

在深度学习中,模型融合和集成学习方法的应用十分广泛。

一方面,由于深度学习模型常常需要大量的数据和计算资源,而且容易出现过拟合现象,因此单一的深度学习模型在某些场景下性能可能不尽如人意。

而模型融合和集成学习方法能够通过整合多个模型的结果,减小模型的方差,从而提高模型的泛化能力。

另一方面,深度学习模型本身往往具有很多超参数需要调整,而且不同的超参数组合可能会对模型性能产生显著影响。

通过集成学习方法,可以构建多个使用不同超参数组合的模型,然后通过模型融合得到更好的结果。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

人工智能选股之stacking集成学习

本文研究导读 (4)

Stacking集成学习模型简介 (5)

Stacking集成学习的原理 (5)

从传统的Stacking到改进的Stacking (6)

Stacking集成学习中基模型的对比和选取 (7)

相同训练数据,不同模型的对比 (7)

训练数据为72个月 (7)

训练数据为6个月 (7)

不同训练数据,相同模型的对比 (8)

模型预测值相关性分析和夏普比率分析 (9)

Stacking集成学习测试流程 (10)

测试流程 (10)

模型构建 (12)

Stacking模型分层回测分析 (13)

模型选股测试结果和IC值分析 (17)

对比测试1 (18)

对比测试2 (20)

对比测试3 (22)

总结和展望 (24)

附录:传统Stacking和改进Stacking的区别 (25)

传统Stacking模型的构建过程 (25)

改进Stacking模型的构建过程 (25)

风险提示 (27)

图表1: Stacking集成学习示意图 (5)

图表2:传统的Stacking集成学习 (6)

图表3:改进的Stacking集成学习 (6)

图表4:各机器学习模型相对中证500的超额收益(训练数据为72个月) (7)

图表5:各机器学习模型相对中证500的超额收益(训练数据为6个月) (8)

图表6: XGBoost各训练期长度训练所得模型相对中证500的超额收益(训练数据为6个月).. 8图表7:其他基模型预测值与XGBoost_72m预测值的相关系数 (9)

图表8:基模型夏普比率 (9)

图表9:基模型适应度指标S (9)

图表10: Stacking集成学习模型构建示意图 (10)

图表11:选股模型中涉及的全部因子及其描述 (11)

图表12: Stacking模型滚动训练过程 (12)

图表13: Stacking模型滚动测试过程 (13)

图表14:单因子分层测试法示意图 (14)

图表15: Stacking模型分层组合绩效分析(20110131~20180427) (15)

图表16: Stacking模型分层组合回测净值 (15)

图表17: Stacking模型各层组合净值除以基准组合净值示意图 (15)

图表18: Stacking模型分层组合1相对沪深300月超额收益分布图 (15)

图表19: Stacking模型多空组合月收益率及累积收益率 (15)

图表20: Stacking模型组合在不同年份的收益及排名分析(分十层) (16)

图表21:不同市值区间Stacking模型组合绩效指标对比图(分十层) (16)

图表22:不同行业Stacking模型分层组合绩效分析(分五层) (17)

图表23:对比测试1中各种模型选股指标对比(全A选股,行业中性) (18)

图表24:对比测试1中各种模型超额收益和回撤表现(全A选股,中证500行业中性,每个行业选4只个股) (19)

图表25:对比测试1中各种模型IC,IR指标 (19)

图表26:对比测试1中各种模型IC 值累积曲线 (19)

图表27:对比测试2中各种模型选股指标对比(全A选股,行业中性) (20)

图表28:对比测试2中各种模型超额收益和回撤表现(全A选股,中证500行业中性,每个行业选4只个股) (21)

图表29:对比测试2中各种模型IC,IR指标 (21)

图表30:对比测试2中各种模型IC 值累积曲线 (21)

图表31:对比测试3中各种模型选股指标对比(全A选股,行业中性) (22)

图表32:对比测试3中各种模型超额收益和回撤表现(全A选股,中证500行业中性,每个行业选4只个股) (23)

图表33:对比测试3中各种模型IC,IR指标 (23)

图表34:对比测试3中各种模型IC 值累积曲线 (23)

图表35:传统Stacking模型的构建过程 (25)

图表36:改进Stacking模型的构建过程 (26)。