perl简单爬虫教程

python爬虫神器Pyppeteer入门及使用

python爬虫神器Pyppeteer入门及使用这篇文章主要介绍了python爬虫神器Pyppeteer入门及使用,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友可以参考下前言提起selenium想必大家都不陌生,作为一款知名的Web自动化测试框架,selenium支持多款主流浏览器,提供了功能丰富的API接口,经常被我们用作爬虫工具来使用。

但是selenium的缺点也很明显,比如速度太慢、对版本配置要求严苛,最麻烦是经常要更新对应的驱动。

今天就给大家介绍另一款web自动化测试工具Pyppeteer,虽然支持的浏览器比较单一,但在安装配置的便利性和运行效率方面都要远胜selenium。

01.Pyppeteer简介介绍Pyppeteer之前先说一下Puppeteer,Puppeteer是谷歌出品的一款基于Node.js开发的一款工具,主要是用来操纵Chrome浏览器的API,通过Javascript代码来操纵Chrome浏览器,完成数据爬取、Web程序自动测试等任务。

Pyppeteer其实是Puppeteer的Python版本,下面简单介绍下Pyppeteer的两大特点,chromium浏览器和asyncio框架:1).chromiumChromium是一款独立的浏览器,是Google为发展自家的浏览器Google Chrome而开启的计划,相当于Chrome的实验版,Chromium的稳定性不如Chrome但是功能更加丰富,而且更新速度很快,通常每隔数小时就有新的开发版本发布。

Pyppeteer的web自动化是基于chromium来实现的,由于chromium中某些特性的关系,Pyppetee r的安装配置非常简单,关于这一点稍后我们会详细介绍。

2).asyncioasyncio是Python的一个异步协程库,自3.4版本引入的标准库,直接内置了对异步IO的支持,号称是Python最有野心的库,官网上有非常详细的介绍:02.安装与使用1).极简安装使用pip install pyppeteer命令就能完成pyppeteer库的安装,至于chromium浏览器,只需要一条p yppeteer-install命令就会自动下载对应的最新版本chromium浏览器到pyppeteer的默认位置。

使用Python进行网络爬虫和数据抓取

使用Python进行网络爬虫和数据抓取随着互联网的快速发展,数据已经成为当今社会的一种重要资源。

而网络爬虫和数据抓取技术则成为了获取和分析数据的重要手段。

Python作为一种简单易用且功能强大的编程语言,被广泛应用于网络爬虫和数据抓取领域。

本文将介绍如何使用Python进行网络爬虫和数据抓取,并探讨其在实际应用中的一些技巧和注意事项。

一、什么是网络爬虫和数据抓取网络爬虫是一种自动化程序,通过模拟浏览器行为,从网页中提取所需的数据。

数据抓取则是指从各种数据源中提取数据的过程。

网络爬虫和数据抓取技术可以帮助我们快速获取大量的数据,并进行进一步的分析和应用。

二、Python的网络爬虫库Python提供了许多强大的网络爬虫库,其中最常用的是BeautifulSoup和Scrapy。

BeautifulSoup是一个解析HTML和XML文档的库,它可以帮助我们方便地从网页中提取所需的数据。

而Scrapy则是一个功能强大的网络爬虫框架,它提供了更多的功能和灵活性,适用于大规模的数据抓取任务。

三、使用BeautifulSoup进行数据抓取首先,我们需要安装BeautifulSoup库。

在Python中,可以使用pip命令来安装第三方库。

安装完成后,我们可以通过导入相应的模块来开始使用BeautifulSoup。

接下来,我们需要指定要抓取的网页URL,并使用Python的requests库发送HTTP请求,获取网页的内容。

然后,我们可以使用BeautifulSoup解析网页,并通过选择器来提取所需的数据。

选择器可以是标签名、类名、ID等,根据网页的结构和需求来确定。

最后,我们可以将提取到的数据保存到本地文件或者数据库中,以便后续的分析和应用。

在保存数据时,我们可以使用Python的文件操作函数或者数据库操作函数,根据实际情况选择合适的方式。

四、使用Scrapy进行数据抓取Scrapy是一个强大的网络爬虫框架,它提供了更多的功能和灵活性,适用于大规模的数据抓取任务。

perl简单爬虫教程

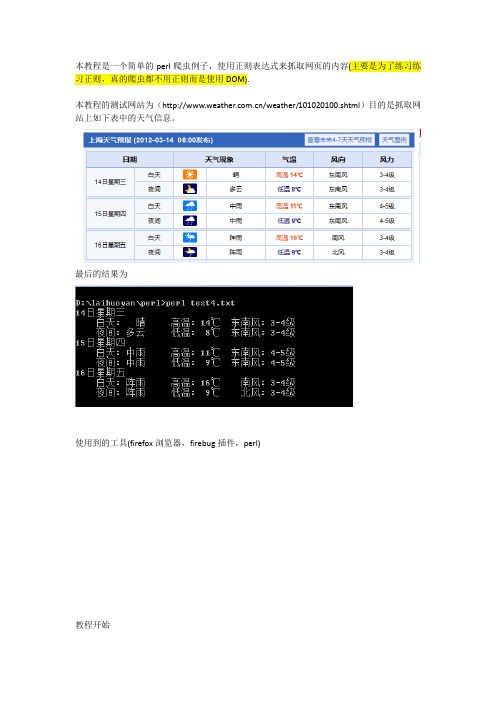

本教程是一个简单的perl爬虫例子,使用正则表达式来抓取网页的内容(主要是为了练习练习正则,真的爬虫都不用正则而是使用DOM).本教程的测试网站为(/weather/101020100.shtml)目的是抓取网站上如下表中的天气信息。

最后的结果为使用到的工具(firefox浏览器,firebug插件,perl)教程开始1:观察网页结构1.1 我们使用firebug发现我们想要抓取的表格的HTML代码结构为1.2 我们看到我们要的表格放在3个class=”yuBaoTable”的<table>标签中,所以我们用一个正则将我们要的3段<table>存到一个一个数组中。

(这里我们用perl来做)$start = '<table class="yuBaoTable" ';$end = '</table>';my @find_all = ($re =~ /$start(.*?)$end/gs);1.3 进入每段<table>我们又发现每天的白天和黑夜是放在两个<tr>标签里的1.4 所以我们又用一个正则将两个<tr>中的代码存到一个数组my @find_day = (/<tr>(.*?)<\/tr>/gs);1.5 现在我们得到的就是我们需要抓取的最小单位了(每个白天/晚上的天气情况),接着用一堆正则将我们要的信息捕获出来即可foreach my $re1(@find_day){if($re1 =~ />(\d{1,2}日星期.*?)<\/a>/s){print "$1\n";}if($re1 =~ /(白天|夜间)/s){printf "%8s:",$1;}if($re1 =~ /(晴|多云|阴|小雨|中雨|小到中雨|阵雨)/s){printf "%5s ",$1;} #30if($re1 =~ /(高温|低温).*?\<strong>(.*?)<\/strong>/s){printf "%8s:%5s",$1,$2 ;}if($re1 =~ /(西北风|北风|东北方|东风|东南风|南风|西南风|西风)/s){printf "%8s:",$1;}if($re1 =~ />.*?(\d-\d级).*?<\/a>/s){printf "%6s\n",$1;}}抓取结束。

使用编程技术实现网络爬虫的步骤和技巧

使用编程技术实现网络爬虫的步骤和技巧随着互联网的发展,我们可以轻松地获取到各种各样的数据。

然而,当我们需要大量的数据时,手动获取就显得非常繁琐和耗时。

这时,网络爬虫就成为了一个非常有用的工具。

网络爬虫是一种自动化程序,可以模拟人类在互联网上浏览和获取数据的行为。

本文将介绍使用编程技术实现网络爬虫的步骤和技巧。

第一步是确定爬取的目标。

在开始编写爬虫程序之前,我们需要明确自己的需求,确定要爬取的网站和要获取的数据类型。

例如,我们可能想要获取某个电商网站上的商品信息,或者想要获取某个新闻网站上的新闻内容。

明确目标后,我们可以更有针对性地编写爬虫程序。

第二步是选择合适的编程语言和工具。

编写网络爬虫可以使用多种编程语言,如Python、Java和Ruby等。

其中,Python是最常用的编程语言之一,因为它有丰富的库和框架,可以简化爬虫程序的编写。

在Python中,有一些非常流行的爬虫框架,如Scrapy和BeautifulSoup。

这些框架提供了一些强大的功能和工具,可以帮助我们更轻松地编写爬虫程序。

第三步是分析目标网站的结构和数据。

在编写爬虫程序之前,我们需要先了解目标网站的结构和数据的组织方式。

这可以通过查看网站的源代码、分析网页的URL和参数等方式来实现。

了解网站的结构和数据的组织方式后,我们可以更好地编写爬虫程序,并且能够更准确地定位和获取所需的数据。

第四步是编写爬虫程序。

在编写爬虫程序时,我们需要根据目标网站的结构和数据的组织方式,使用编程语言和工具来模拟人类在网站上的行为。

这包括发送HTTP请求、解析HTML、提取数据等操作。

例如,我们可以使用Python的requests库发送HTTP请求,使用BeautifulSoup库解析HTML,使用正则表达式或XPath来提取数据。

在编写爬虫程序时,我们还需要考虑一些技巧,如设置合适的请求头、处理网页的反爬机制、使用代理IP等,以确保爬虫程序的稳定性和效率。

python 简单的爬虫 源码

文章标题:探究Python简单的爬虫源码:从原理到实践1. 前言在当今信息爆炸的时代,网页上的数据成为了我们获取信息的重要来源。

而Python作为一种简单易学、功能强大的编程语言,其在网页数据爬取方面有着得天独厚的优势。

本文将探讨Python简单的爬虫源码,通过深入学习其原理和实践,来帮助读者全面了解并灵活运用Python爬虫技术。

2. Python爬虫的基本原理Python爬虫的基本原理是基于HTTP协议对网页进行访问和数据获取。

通过发送HTTP请求,获取网页的源代码,再通过解析和提取需要的信息,从而实现数据的获取和处理。

Python提供了丰富的库和工具来实现这一原理,其中最常用的是requests、BeautifulSoup和selenium等库。

3. Python爬虫的简单实现在介绍Python爬虫的源码之前,我们先来看一个简单的示例,通过Python实现一个简单的爬虫程序。

以下是一个简单的Python爬虫的源码:```pythonimport requestsfrom bs4 import BeautifulSoupurl = 'response = requests.get(url)html = response.textsoup = BeautifulSoup(html, 'html.parser')titles = soup.find_all('h2')for title in titles:print(title.get_text())```4. 深入理解爬虫源码上面的源码展示了一个简单的Python爬虫程序,它通过requests库发送HTTP请求获取网页内容,然后用BeautifulSoup库解析HTML,从中提取出所有h2标签的内容并打印出来。

这个简单的示例体现了Python爬虫的基本原理和实现方式。

5. Python爬虫的进阶应用除了上面简单示例的实现方式外,Python爬虫还有很多进阶的应用,比如可以通过selenium模拟浏览器操作实现动态页面的爬取,可以使用正则表达式进行数据的提取和匹配,还可以通过多线程和异步IO提升爬取效率等等。

scrapy爬虫流程

scrapy爬虫流程一、什么是Scrapy爬虫Scrapy是一个基于Python的开源网络爬虫框架,用于快速、高效地从网页中提取数据。

它具有强大的功能和灵活的架构,能够自动化处理网页的下载、数据提取、数据存储等任务,并支持异步处理,可以快速、稳定地爬取大规模网站的数据。

二、Scrapy爬虫流程Scrapy的爬虫流程可以分为以下几个步骤:1. 创建项目首先,我们需要在本地创建一个Scrapy项目。

可以使用命令行工具scrapy startproject来创建一个新的项目,并指定项目的名称。

命令示例:scrapy startproject myproject2. 定义Item在Scrapy中,Item用于定义待爬取的数据结构。

我们需要创建一个Item类,并在其中定义需要提取的字段。

示例代码:import scrapyclass MyItem(scrapy.Item):title = scrapy.Field()content = scrapy.Field()...3. 编写SpiderSpider是Scrapy中负责爬取网页的组件。

我们需要在项目中创建一个Spider类,并编写爬取规则。

爬取规则是通过XPath或CSS选择器来定位需要的数据。

import scrapyclass MySpider(scrapy.Spider):name = 'myspider'start_urls = ['def parse(self, response):# 解析response对象,提取数据titles = response.xpath('//h1/text()').getall()contents = response.xpath('//p/text()').getall()# 创建Item对象,保存提取的数据for i in range(len(titles)):item = MyItem()item['title'] = titles[i]item['content'] = contents[i]yield item# 提取下一页的链接,继续爬取next_page_url = response.css('a.next-page::attr(href)').get() if next_page_url is not None:yield response.follow(next_page_url, self.parse)4. 配置PipelinePipeline用于处理爬取到的数据,并进行后续的处理。

Python爬虫8个常用的爬虫技巧分析总结

Python爬虫8个常用的爬虫技巧分析总结用python也差不多一年多了,python应用最多的场景还是web快速开发、爬虫、自动化运维:写过简单网站、写过自动发帖脚本、写过收发邮件脚本、写过简单验证码识别脚本。

爬虫在开发过程中也有很多复用的过程,这里总结一下,以后也能省些事情。

1、基本抓取网页get方法import urllib2url "http://baidu"respons = urllib2.urlopen(url)print response.read()post方法import urllibimport urllib2url = "http://abcde"form = {name:abc,password:1234}form_data = urllib.urlencode(form)request = urllib2.Request(url,form_data)response = urllib2.urlopen(request)print response.read()2、使用代理IP在开发爬虫过程中经常会遇到IP被封掉的情况,这时就需要用到代理IP;在urllib2包中有ProxyHandler类,通过此类可以设置代理访问网页,如下代码片段:import urllib2proxy = urllib2.ProxyHandler({http: 127.0.0.1:8087})opener = urllib2.build_opener(proxy)urllib2.install_opener(opener)response = urllib2.urlopen(http://baidu)print response.read()3、Cookies处理cookies是某些网站为了辨别用户身份、进行session跟踪而储存在用户本地终端上的数据(通常经过加密),python提供了cookielib模块用于处理cookies,cookielib模块的主要作用是提供可存储cookie的对象,以便于与urllib2模块配合使用来访问Internet资源.代码片段:import urllib2, cookielibcookie_support= urllib2.HTTPCookieProcessor(cookielib.CookieJar())opener = urllib2.build_opener(cookie_support)urllib2.install_opener(opener)content = urllib2.urlopen(http://XXXX).read()。

最简单的爬虫代码

最简单的爬虫代码

最简单的爬虫代码通常涉及使用Python和一个网络请求库,如`requests`,来获取网页内容。

以下是一个非常简单的示例,使用Python中的`requests`库爬取一个网页:

首先,确保你已经安装了`requests`库。

你可以通过以下命令安装:

```bash

pip install requests

```

然后,使用以下代码实现一个简单的爬虫:

```python

import requests

# 目标网页的URL

url = ''

# 发送HTTP GET请求获取页面内容

response = requests.get(url)

# 检查请求是否成功

if response.status_code == 200:

# 打印页面内容

print(response.text)

else:

print('Failed to retrieve the page. Status code:', response.status_code)

```

这段代码执行以下步骤:

1. 导入`requests`库。

2. 指定目标网页的URL。

3. 使用`requests.get(url)`发送HTTP GET请求获取网页内容。

4. 检查响应的状态码,如果为200表示成功,打印页面内容;否则,打印错误信息。

请注意,这只是一个非常简单的例子。

实际的爬虫可能需要更复杂的处理,包括处理页面内容、解析HTML、处理网页链接等。

在实际应用中,你可能会考虑使用更强大的爬虫框架,如Scrapy。

手把手教会你爬取网页数据知识分享

手把手教会你爬取网页数据知识分享

爬虫就是自动猎取网页内容的程序,例如搜寻引擎,Google,Baidu 等,天天都运行着浩大的爬虫系统,从全世界的网站中爬虫数据,供用户检索时用法。

其实把网络爬虫抽象开来看,它无外乎包含如下几个步骤

模拟哀求网页。

模拟扫瞄器,打开目标网站。

猎取数据。

打开网站之后,就可以自动化的猎取我们所需要的网站数据。

保存数据。

拿到数据之后,需要持久化到本地文件或者数据库等存储设备中。

那么我们该如何用法 Python 来编写自己的爬虫程序呢,在这里我要重点介绍一个 Python 库:Requests。

Requests 库是 Python 中发起 HTTP 哀求的库,用法十分便利容易。

发送 GET 哀求

当我们用扫瞄器打开豆瓣首页时,其实发送的最原始的哀求就是 GET 哀求

可以看到,我们得到的是一个 Response 对象

假如我们要猎取网站返回的数据,可以用法 text 或者 content 属性来猎取

text:是以字符串的形式返回数据

第1页共6页。

Python爬虫速成指南让你快速的学会写一个最简单的爬虫

Python爬虫速成指南让你快速的学会写一个最简单的爬虫

本文主要内容:以最短的时间写一个最简单的爬虫,可以抓取论坛的帖子标题和帖子内容。

本文受众:没写过爬虫的萌新。

入门

0.准备工作

需要准备的东西:Python、scrapy、一个IDE或者随便什么文本编辑工具。

1.技术部已经研究决定了,你来写爬虫。

随便建一个工作目录,然后用命令行建立一个工程,工程名为miao,可以替换为你喜欢的名字。

scrapy startproject miao

随后你会得到如下的一个由scrapy创建的目录结构

在spiders文件夹中创建一个python文件,比如miao.py,来作为爬虫的脚本。

内容如下:

import scrapyclass NgaSpider(scrapy.Spider): name = "NgaSpider" host = "/" # start_urls是我们准备爬的初始页 start_urls = [ "/thread.php?fid=406", ] # 这个是解析函数,如果不特别指明的话,scrapy抓回来的页面会由这个函数进行解析。

# 对页面的处理和分析工作都在此进行,这个示例里我们只是简单地把页面内容打印出来。

def parse(self, response): print response.body

2.跑一个试试?

如果用命令行的话就这样:

cd miao scrapy crawl NgaSpider

你可以看到爬虫君已经把你坛星际区第一页打印出来了,当然由于没有任何处理,所以混杂着html标签和js脚本都一并打印出来了。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

本教程是一个简单的perl爬虫例子,使用正则表达式来抓取网页的内容(主要是为了练习练习正则,真的爬虫都不用正则而是使用DOM).

本教程的测试网站为(/weather/101020100.shtml)目的是抓取网站上如下表中的天气信息。

最后的结果为

使用到的工具(firefox浏览器,firebug插件,perl)

教程开始

1:观察网页结构

1.1 我们使用firebug发现我们想要抓取的表格的HTML代码结构为

1.2 我们看到我们要的表格放在3个class=”yuBaoTable”的<table>标签中,所以我们用一个正则将我们要的3段<table>存到一个一个数组中。

(这里我们用perl来做)$start = '<table class="yuBaoTable" ';

$end = '</table>';

my @find_all = ($re =~ /$start(.*?)$end/gs);

1.3 进入每段<table>我们又发现每天的白天和黑夜是放在两个<tr>标签里的

1.4 所以我们又用一个正则将两个<tr>中的代码存到一个数组

my @find_day = (/<tr>(.*?)<\/tr>/gs);

1.5 现在我们得到的就是我们需要抓取的最小单位了(每个白天/晚上的天气情况),接着用一堆正则将我们要的信息捕获出来即可

foreach my $re1(@find_day){

if($re1 =~ />(\d{1,2}日星期.*?)<\/a>/s){

print "$1\n";

}

if($re1 =~ /(白天|夜间)/s){

printf "%8s:",$1;

}

if($re1 =~ /(晴|多云|阴|小雨|中雨|小到中雨|阵雨)/s){

printf "%5s ",$1;

} #30

if($re1 =~ /(高温|低温).*?\<strong>(.*?)<\/strong>/s){

printf "%8s:%5s",$1,$2 ;

}

if($re1 =~ /(西北风|北风|东北方|东风|东南风|南风|西南风|西风)/s){

printf "%8s:",$1;

}

if($re1 =~ />.*?(\d-\d级).*?<\/a>/s){

printf "%6s\n",$1;

}

}

抓取结束。

贴上完整代码(perl版)

use strict;

use warnings;

use Encode; ##添加处理中文的模块

use LWP::UserAgent; ##perl中用来处理网页请求的模块

my $ua = LWP::UserAgent->new();

$ua->timeout(10);

my $r = $ua->get('/weather/101020100.shtml');

if ($r->is_success){

my $re = encode("gb2312",$r->decoded_content); ##用于处理中文乱码

my $start = '<div class="weatherYubaoBox">';

my $end = '</div>';

if($re =~ /($start.*?$end)/s){

$re = $1;

}

$start = '<table class="yuBaoTable" ';

$end = '</table>';

my @find_all = ($re =~ /$start(.*?)$end/gs); ##将每天的天气信息存在一个数组中foreach (@find_all){

my @find_day = (/<tr>(.*?)<\/tr>/gs); ##将同一天的白天和晚上的信息存在一个数组中

foreach my $re1(@find_day){

if($re1 =~ />(\d{1,2}日星期.*?)<\/a>/s){

print "$1\n";

}

if($re1 =~ /(白天|夜间)/s){

printf "%8s:",$1;

}

if($re1 =~ /(晴|多云|阴|小雨|中雨|小到中雨|阵雨)/s){

printf "%5s ",$1;

} #30

if($re1 =~ /(高温|低温).*?\<strong>(.*?)<\/strong>/s){

printf "%8s:%5s",$1,$2 ;

}

if($re1 =~ /(西北风|北风|东北方|东风|东南风|南风|西南风|西风)/s){

printf "%8s:",$1;

}

if($re1 =~ />.*?(\d-\d级).*?<\/a>/s){

printf "%6s\n",$1;

}

}

}

}。