LINUX内核TCP参数优化设置

TCP协议的性能优化与调优方法总结(三)

TCP协议的性能优化与调优方法总结一、引言TCP(Transmission Control Protocol,传输控制协议)是一种面向连接的、可靠的传输协议,在互联网通信中起到了重要的作用。

然而,随着网络的快速发展和应用需求的增加,TCP协议的性能问题也逐渐凸显出来。

本文将总结一些TCP协议的性能优化与调优方法,希望能够提供一些有益的参考。

二、拥塞控制算法优化拥塞控制是TCP协议中的一个重要机制,它通过调节数据发送速率来避免网络拥塞。

在实际应用中,可以采取以下方法优化拥塞控制算法:1. 使用更好的拥塞控制算法:目前常用的拥塞控制算法有TCP Tahoe、TCP Reno等,可以根据应用场景的具体需求选择合适的拥塞控制算法。

例如,对于延迟敏感的应用,可以选择TCP Low Latency 算法。

2. 动态调整拥塞窗口大小:通过调整拥塞窗口大小,可以有效控制数据发送速率。

可以根据网络状况实时调整拥塞窗口大小,从而提高数据传输的效率和稳定性。

三、合理设置超时与重传机制超时与重传机制是TCP协议中确保可靠性的关键机制之一。

在实际应用中,可采取以下方法进行优化:1. 设置合理的重传超时时间:过小的重传超时时间会导致过多的重传,降低网络传输效率;过大的重传超时时间会延长数据传输时间。

因此,需要根据网络环境的延迟和丢包率等情况,合理设置重传超时时间。

2. 使用快速重传机制:当接收方连续收到相同的数据段时,可以立即向发送方发送冗余的ACK,以触发发送方进行快速重传。

这样可以提前恢复丢失的数据段,减小重传延迟,提高数据传输效率。

四、优化滑动窗口机制滑动窗口机制是TCP协议中用于流量控制和传输可靠性的重要机制。

在实际应用中,可采取以下方法进行优化:1. 使用合适的窗口大小:窗口大小决定了数据发送的速率,过小的窗口大小会导致低效的传输,过大的窗口大小会导致网络拥塞。

因此,需要根据网络状况调整窗口大小,以达到最佳的传输效果。

linux kernel tcp 保活机制

Linux内核中的TCP保活机制是一种用于检测空闲连接是否仍然有效的方法。

当启用TCP保活机制后,如果一个TCP连接在一段时间内没有数据传输,系统会发送保活探测包(Keepalive Probe)给对端,以检测连接是否仍然存活。

下面是关于Linux内核中TCP保活机制的一些重要信息:

1.参数设置:

•TCP保活机制可以通过修改TCP套接字选项来启用和配置。

相关的套接字选项包括SO_KEEPALIVE、TCP_KEEPIDLE、TCP_KEEPINTVL和TCP_KEEPCNT。

•SO_KEEPALIVE用于启用或禁用TCP保活机制。

•TCP_KEEPIDLE指定了开始发送保活探测包之前的空闲时间。

•TCP_KEEPINTVL指定了连续发送保活探测包的间隔时间。

•TCP_KEEPCNT指定了在放弃连接之前尝试发送保活探测包的次数。

2.默认值:

•默认情况下,Linux内核中TCP保活机制是禁用的。

•如果需要使用TCP保活机制,需要在代码中显式地设置相应的套接字选项。

3.作用:

•TCP保活机制可以帮助检测连接断开的情况,例如对端意外崩溃或网络故障。

•通过发送保活探测包,可以在连接出现问题时及时发现并采取相应的处理措施。

4.注意事项:

•启用TCP保活机制可能会增加网络流量,因为需要定期发送保活探测包。

•需要谨慎配置TCP保活机制的参数,以避免对网络性能产生不必要的影响。

在实际应用中,根据具体的需求和场景,可以根据上述参数对TCP保活机制进行相应的调整和优化。

内核tcp参数

TCP参数是用来配置和调整TCP协议栈的内核参数,以优化网络性能和吞吐量。

下面是一些常见的内核TCP参数:

1. tcp_syncookies:启用SYN cookies防止SYN洪水攻击。

2. tcp_fin_timeout:设置TCP连接在关闭时等待FIN包的超时时间。

3. tcp_tw_reuse:允许复用TIME_W AIT状态的套接字。

4. tcp_tw_recycle:开启快速回收TIME_W AIT套接字的机制。

5. tcp_max_tw_buckets:限制TIME_W AIT套接字的最大数量。

6. tcp_keepalive_time:设置TCP连接的空闲时间,超过该时间将发送keepalive 探测包。

7. tcp_keepalive_probes:设置发送keepalive探测包的次数。

8. tcp_keepalive_intvl:设置两次发送keepalive探测包的间隔时间。

9. tcp_rmem:设置接收缓冲区大小。

10. tcp_wmem:设置发送缓冲区大小。

11. tcp_max_syn_backlog:设置SYN队列的最大长度,控制同时等待三次握手完成的连接数。

12. tcp_slow_start_after_idle:控制TCP长时间处于空闲状态后重新进入慢启动的阈值。

这只是一小部分常见的TCP参数,内核还有很多其他的TCP参数可以根据具体需求进行调整。

要注意,在修改这些参数之前,需要谨慎评估对系统性能和稳定性的影响,并确保了解每个参数的功能和作用。

1。

linux系统内核参数优化-linux快速入门教程

linux系统内核参数优化-linux快速⼊门教程内核的 shmall 和 shmmax 参数SHMMAX= 配置了最⼤的内存segment的⼤⼩ ------>这个设置的⽐SGA_MAX_SIZE⼤⽐较好。

SHMMIN= 最⼩的内存segment的⼤⼩SHMMNI= 整个系统的内存segment的总个数SHMSEG= 每个进程可以使⽤的内存segment的最⼤个数配置信号灯( semphore )的参数:SEMMSL= 每个semphore set⾥⾯的semphore数量 -----> 这个设置⼤于你的process的个数吧,否则你不得不分多个semphore set,好像有process+n之说,我忘了n是⼏了。

SEMMNI= 整个系统的semphore set总数SEMMNS=整个系统的semphore总数shmall 是全部允许使⽤的共享内存⼤⼩,shmmax 是单个段允许使⽤的⼤⼩。

这两个可以设置为内存的 90%。

例如 16G 内存,16*1024*1024*1024*90% = 15461882265,shmall 的⼤⼩为 15461882265/4k(getconf PAGESIZE可得到) = 3774873。

修改 /etc/sysctl.confkernel.shmmax=15461882265kernel.shmall=3774873kernel.msgmax=65535kernel.msgmnb=65535执⾏ sudo sysctl -p可以使⽤ ipcs -l 看结果。

ipcs -u 可以看到实际使⽤的情况========================================================================linux 内存管理⼀、前⾔本⽂档针对OOP8⽣产环境,具体优化策略需要根据实际情况进⾏调整;本⽂档将在以下⼏个⽅⾯来阐述如何针对RedHat Enterprise Linux 进⾏性能优化。

linux调优参数

在Linux系统上,可以通过调整参数来优化系统的性能和功能。

以下是一些常见的Linux调优参数:内存管理:vm.swappiness:调整交换分区的使用频率,默认值为60,建议将其设置为10或更低的值,以减少交换分区的使用。

vm.min_free_kbytes:设置系统保留的空闲内存量,默认值为64,建议根据实际情况调整。

vm.max_map_count:设置进程可以拥有的最大内存映射数量,默认值为65536,如果需要运行大量进程或使用大量内存映射,可以适当增加该值。

网络性能:net.ipv4.tcp_tw_reuse:允许重用TIME_WAIT套接字,默认值为0,建议将其设置为1以减少TIME_WAIT套接字数量。

net.ipv4.tcp_fin_timeout:设置TIME_WAIT套接字的超时时间,默认值为60秒,可以适当增加该值以减少TIME_WAIT套接字数量。

net.ipv4.tcp_keepalive_time:设置TCP keepalive探测的间隔时间,默认值为75秒,可以适当增加该值以避免因长时间不活动而断开连接。

文件系统:fs.file-max:设置系统可以同时打开的最大文件数量,默认值为1024,可以根据实际情况调整。

fs.nr_open:设置系统进程可以同时打开的文件数量上限,默认值为8192,可以根据实际情况调整。

CPU 调度:kernel.sched_min_granularity_ns:设置最小调度时间粒度,默认值为1000000纳秒(1毫秒),可以根据实际情况调整。

kernel.sched_migration_cost_ns:设置CPU调度迁移的开销时间,默认值为500000纳秒(半毫秒),可以适当增加该值以提高系统在多核处理器上的性能。

系统进程:kernel.panic:设置系统崩溃时的重启次数,默认值为1,建议将其设置为0以避免系统无限重启。

fs.inotify.max_user_instances:设置系统可以监视的文件系统实例数量上限,默认值为8192,可以根据实际情况调整。

linux tcp参数

linux tcp参数Linux TCP参数是指在Linux系统中用于控制TCP协议的一系列参数。

这些参数可以影响TCP连接的性能、稳定性和安全性。

在本文中,我们将介绍一些常见的Linux TCP参数及其作用。

1. tcp_syncookiestcp_syncookies是一种防止SYN洪水攻击的机制。

当服务器收到大量的SYN请求时,它会启用tcp_syncookies机制,将一些连接信息存储在cookie中,以便在后续的连接请求中进行验证。

这样可以防止服务器被SYN洪水攻击所瘫痪。

2. tcp_fin_timeouttcp_fin_timeout是指在TCP连接关闭后,等待多长时间才能释放连接资源。

默认情况下,它是60秒。

如果你的应用程序需要频繁地打开和关闭连接,可以将tcp_fin_timeout设置为较小的值,以便更快地释放连接资源。

3. tcp_keepalive_timetcp_keepalive_time是指在TCP连接空闲时,发送keepalive消息的时间间隔。

默认情况下,它是7200秒。

如果你的应用程序需要保持长时间的连接,可以将tcp_keepalive_time设置为较小的值,以便更快地检测到连接是否已经断开。

4. tcp_max_syn_backlogtcp_max_syn_backlog是指在SYN队列中允许的最大连接数。

默认情况下,它是128。

如果你的服务器需要处理大量的连接请求,可以将tcp_max_syn_backlog设置为较大的值,以便更好地处理连接请求。

5. tcp_tw_reusetcp_tw_reuse是指在TIME_WAIT状态下,是否允许重用端口。

默认情况下,它是关闭的。

如果你的服务器需要频繁地打开和关闭连接,可以将tcp_tw_reuse设置为开启,以便更好地利用端口资源。

Linux TCP参数可以帮助你优化TCP连接的性能、稳定性和安全性。

通过了解和调整这些参数,你可以更好地控制你的服务器和应用程序。

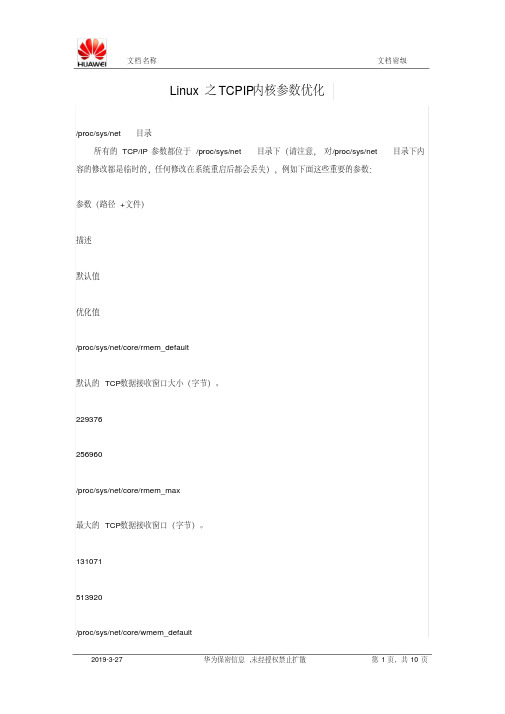

Linux之TCPIP内核全参数优化

Linux之TCPIP内核参数优化/proc/sys/net目录所有的TCP/IP参数都位于/proc/sys/net目录下(请注意,对/proc/sys/net目录下内容的修改都是临时的,任何修改在系统重启后都会丢失),例如下面这些重要的参数:参数(路径+文件)描述默认值优化值/proc/sys/net/core/rmem_default默认的TCP数据接收窗口大小(字节)。

229376256960/proc/sys/net/core/rmem_max最大的TCP数据接收窗口(字节)。

131071513920/proc/sys/net/core/wmem_default默认的TCP数据发送窗口大小(字节)。

229376256960/proc/sys/net/core/wmem_max最大的TCP数据发送窗口(字节)。

131071513920/proc/sys/net/core/netdev_max_backlog在每个网络接口接收数据包的速率比内核处理这些包的速率快时,允许送到队列的数据包的最大数目。

10002000/proc/sys/net/core/somaxconn定义了系统中每一个端口最大的监听队列的长度,这是个全局的参数。

1282048/proc/sys/net/core/optmem_max表示每个套接字所允许的最大缓冲区的大小。

2048081920/proc/sys/net/ipv4/tcp_mem确定TCP栈应该如何反映内存使用,每个值的单位都是内存页(通常是4KB)。

第一个值是内存使用的下限;第二个值是内存压力模式开始对缓冲区使用应用压力的上限;第三个值是内存使用的上限。

在这个层次上可以将报文丢弃,从而减少对内存的使用。

对于较大的BDP 可以增大这些值(注意,其单位是内存页而不是字节)。

94011 125351 188022131072 262144 524288/proc/sys/net/ipv4/tcp_rmem为自动调优定义socket使用的内存。

Linux操作系统修改内核参数的三种方法详细说明

Linux操作系统修改内核参数的三种方法详细说明linux内核的参数设置怎么弄呢,Linux 操作系统修改内核参数有以下三种方式:修改 /etc/sysctl.conf 文件;在文件中加入配置项,格式为 key = value,保存修改后的文件,执行命令 sysctl -p 加载新配置。

使用 sysctl 命令临时修改;如:sysctl -w net.ipv4.tcp_mem = “379008 505344 758016”直接修改/proc/sys/ 目录中的文件。

如:echo “379008 505344 758016” 》 /proc/sys/net/ipv4/tcp_mem 注意:第一种方式在重启操作系统后自动永久生效;第二种和第三种方式在重启后失效。

内核参数kernel.core_uses_pi d = 1core_uses_pid 可以控制 core 文件的文件名中是否添加 pid 作为扩展名。

设置为1,表示添加 pid 作为扩展名,生成的 core 文件格式为core.xxx;设置为0(默认),表示生成的 core 文件统一命名为 core。

kernel.core_pat te rn = corecore_pattern 可以控制 core 文件的保存位置和文件格式。

如:kernel.core_pattern = “/corefile/core-%e-%p-%t”,表示将core 文件统一生成到 /corefile 目录下,产生的文件名为 core-命令名-pid-时间戳。

以下是参数列表:%p - insert pid into filename 添加 pid%u - insert current uid into filename 添加当前 uid%g - insert current gid into filename 添加当前 gid%s - insert signal that caused the coredump into the filename 添加导致产生 core 的信号%t - insert UNIX ti me that the coredump occurred into filename 添加 core 文件生成时的 unix 时间%h - insert hostname where the coredump happened into filename 添加主机名%e - insert coredumping executable name into filename 添加命令名kernel.msgmax = 8192进程间的消息传递是在内核的内存中进行的。