文本挖掘模型

文本挖掘基本算法

文本挖掘基本算法

文本挖掘是一种从文本数据中提取有用信息的技术。

它涉及到大量的文本数据处理和分析,因此需要使用一些基本的算法来实现任务。

以下是文本挖掘中常用的基本算法:

1. 分词:将一段文本切分成单个的词语,是文本处理的基本步骤。

分词算法包括基于规则的方法和基于统计的方法。

2. 去除停用词:停用词是一些常见的无意义词语,如“的”“和”“是”等。

在文本处理中,需要去除这些停用词,以便更好地提取有用信息。

3. 词频统计:词频是指某个词语在文本中出现的次数。

词频统

计是文本挖掘中常用的方法之一,用来计算每个词语在文本中的重要性。

4. TF-IDF:TF-IDF是一种统计方法,用来评估一段文本中词语的重要性。

它的核心思想是,一个词语在文本中出现的次数越多,同时在整个文本集合中出现的次数越少,则该词语的重要性越高。

5. 词向量模型:词向量模型是一种将词语转换为向量的方法。

通过将每个词语表示为一个向量,可以实现对文本的语义分析和相似度计算,是文本挖掘中的重要工具之一。

6. 主题模型:主题模型是一种对文本进行主题分析的方法。

通

过对文本中的词语进行聚类,可以提取文本中的主题信息,用于文本分类、情感分析等任务。

7. 文本分类:文本分类是一种将文本分为不同类别的方法。

它

可以应用于垃圾邮件过滤、新闻分类、情感分析等领域。

在文本分类中,常用的算法包括朴素贝叶斯、支持向量机等。

以上是文本挖掘中常用的基本算法,它们为实现文本挖掘任务提供了重要的基础。

利用AI技术进行文本分类与文本挖掘的核心算法与模型

利用AI技术进行文本分类与文本挖掘的核心算法与模型AI技术在当今社会中扮演着越来越重要的角色,其中文本分类与文本挖掘是AI技术的重要应用之一。

本文将探讨文本分类与文本挖掘的核心算法与模型。

一、文本分类的核心算法与模型文本分类是将文本按照一定的标准进行分类的过程。

在实际应用中,我们常常会遇到大量的文本数据,如新闻、社交媒体上的评论等,需要对这些文本进行分类和分析。

常用的文本分类算法有朴素贝叶斯、支持向量机(SVM)和深度学习模型等。

1. 朴素贝叶斯算法朴素贝叶斯算法是一种基于概率统计的分类算法。

它假设特征之间相互独立,通过计算每个特征在给定类别下的条件概率来进行分类。

朴素贝叶斯算法在文本分类中有着广泛的应用,例如垃圾邮件过滤、情感分析等。

2. 支持向量机(SVM)支持向量机是一种常用的分类算法,它通过找到一个最优超平面来将样本分为不同的类别。

在文本分类中,SVM可以将文本表示为高维特征向量,然后通过寻找一个最优的超平面来进行分类。

SVM在文本分类中具有较好的性能和可解释性。

3. 深度学习模型深度学习模型是近年来兴起的一种强大的文本分类算法。

它通过构建多层神经网络来学习文本的表示和语义信息。

常用的深度学习模型包括卷积神经网络(CNN)、循环神经网络(RNN)和长短时记忆网络(LSTM)等。

这些模型在文本分类任务中取得了很好的效果,能够捕捉到文本中的上下文信息和语义关系。

二、文本挖掘的核心算法与模型文本挖掘是从大量的文本数据中提取有用信息和知识的过程。

它包括文本预处理、特征提取和模型训练等步骤。

常用的文本挖掘算法有词袋模型、TF-IDF、主题模型和情感分析等。

1. 词袋模型词袋模型是文本挖掘中常用的一种表示方法。

它将文本看作是一个无序的词集合,忽略了词与词之间的顺序和语法结构。

词袋模型通过统计文本中每个词的出现次数或权重来表示文本。

在文本分类和信息检索中,词袋模型被广泛应用。

2. TF-IDFTF-IDF是一种用于评估词语在文本中重要程度的方法。

文本挖掘技术及应用场景解析

文本挖掘技术及应用场景解析文本挖掘(Text Mining)是指从大量的文本数据中发掘隐藏的信息、知识和模式的一种技术手段。

随着信息时代的到来,海量的文本数据如同一个宝库,蕴含着巨大的价值。

因此,如何利用文本挖掘技术挖掘并应用这些信息对于企业和研究机构来说具有重要意义。

本文将对文本挖掘技术及其应用场景进行深入解析。

首先,我们来了解一下文本挖掘技术的基本步骤。

文本挖掘技术一般包括文本预处理、特征提取、模型构建和模型评估等步骤。

文本预处理是指将原始的文本数据通过一系列的处理方法转化成结构化或半结构化的数据以供进一步的挖掘分析。

这个过程通常包括词法分析、停用词过滤、拼写检查、词干化等。

特征提取是指从预处理后的文本中提取关键信息,常见的方法包括词袋模型、TF-IDF、词嵌入等。

模型构建是指根据特定的需求,通过训练数据构建合适的模型,常见的方法包括朴素贝叶斯、支持向量机、深度学习等。

模型评估是指对构建好的模型进行评估,以判断其效果是否满足要求。

文本挖掘技术在很多领域都有着广泛的应用。

以下将介绍几个常见的应用场景。

首先,文本分类是文本挖掘技术的主要应用之一。

通过对文本进行分类,可以帮助我们理解和管理海量的文本数据,从而快速找到感兴趣的文本。

比如在产品评论中,可以利用文本分类技术将用户的评论分为正面、负面或中性,帮助企业了解产品的市场反响。

此外,在新闻报道中,可以使用文本分类技术自动将新闻归类为政治、经济、体育等不同的类别,方便用户根据自己的兴趣进行选择。

其次,文本聚类也是文本挖掘技术的重要应用之一。

文本聚类可以把相似的文本聚集在一起,形成独立的类别,从而帮助用户快速浏览和理解大量的文本数据。

比如在社交媒体中,可以使用文本聚类技术将用户的帖子根据内容进行聚类,方便用户查找感兴趣的话题。

另外,文本聚类还可以应用于情感分析领域,通过将具有相似情感倾向的文本聚类在一起,帮助企业了解用户的情感态度。

此外,文本挖掘技术还可以应用于文本摘要、信息抽取、情感分析、知识图谱构建等领域。

自然语言处理中常见的文本挖掘技术(六)

自然语言处理(NLP)是一门涉及人类语言与计算机之间交互的技术,它涉及文本挖掘、情感分析、语音识别等多方面的技术。

在这方面,文本挖掘技术是其中一个非常重要的领域,它用于从大量的文本中提取有用的信息和知识。

本文将介绍自然语言处理中常见的文本挖掘技术,包括词频统计、文本分类、主题模型、情感分析和实体识别等方面。

一、词频统计词频统计是文本挖掘中最基本的技术之一,它用于分析文本中词语的使用频率。

通过词频统计,我们可以得到文本中每个词语出现的次数,从而了解文本中的主题和重点。

在实际应用中,词频统计常用于搜索引擎优化、文本分类和信息检索等方面。

同时,词频统计也是其他文本挖掘技术的基础,例如文本分类和情感分析都需要先进行词频统计。

二、文本分类文本分类是将文本划分为不同的类别或标签的过程,它是一种监督学习的技术。

在文本分类中,通常使用机器学习算法,例如朴素贝叶斯、支持向量机和深度学习等方法。

文本分类在实际应用中非常广泛,例如垃圾邮件过滤、新闻分类、情感分析等方面都有着重要的应用。

通过文本分类,我们可以将大量的无序文本整理成有序的类别,从而更好地理解和利用这些文本数据。

三、主题模型主题模型是一种无监督学习的技术,它用于从文本中发现隐藏在其中的主题和语义信息。

主题模型在文本挖掘中有着重要的应用,例如新闻聚类、主题分析和内容推荐等方面。

主题模型的典型代表是潜在语义分析(LSA)和隐含狄利克雷分布(LDA)等方法,它们可以帮助我们从文本中挖掘出有用的信息和知识。

四、情感分析情感分析是一种用于分析文本情感色彩的技术,它可以识别文本中的情感倾向,例如正面情感、负面情感和中性情感等。

情感分析在社交媒体分析、产品评论和舆情监控等方面有着广泛的应用。

通过情感分析,我们可以了解用户对产品和服务的态度和情感,从而更好地改进产品和服务,提升用户体验。

五、实体识别实体识别是一种用于从文本中识别出命名实体(如人名、地名、组织名等)的技术,它是信息提取和知识图谱构建的重要基础。

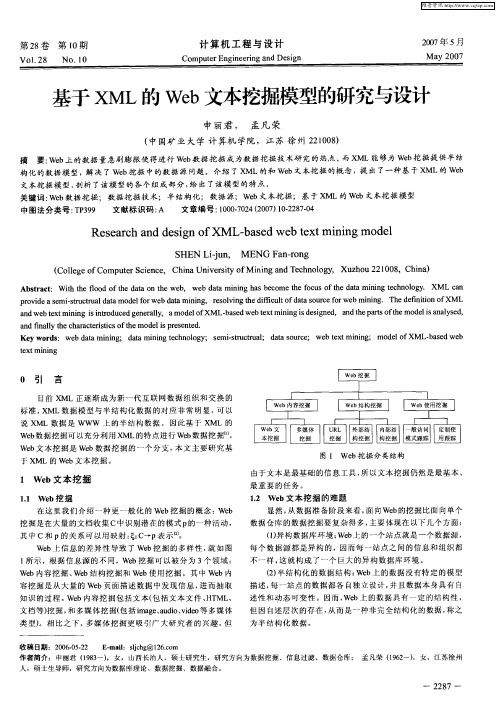

基于XML的Web文本挖掘模型的研究与设计

数据分析中的文本挖掘方法与案例分析

数据分析中的文本挖掘方法与案例分析随着数字化时代的到来,数据量的爆炸式增长给企业和组织带来了巨大的挑战和机遇。

在这个信息爆炸的时代,如何从大量的文本数据中提取有价值的信息成为了数据分析师们的重要任务之一。

而文本挖掘作为一种数据分析的方法,正在被广泛应用于各个领域。

一、文本挖掘方法文本挖掘是指通过利用自然语言处理、机器学习和统计学等技术,从大规模文本数据中自动发现、提取和推理出有用的信息。

在文本挖掘中,常用的方法包括词频统计、情感分析、主题模型和实体识别等。

1. 词频统计词频统计是文本挖掘中最基本的方法之一,它通过统计文本中每个词出现的频率来分析文本的特征。

通过对词频进行排序和筛选,可以找出文本中最常出现的词汇,从而了解文本的主题和关键词。

2. 情感分析情感分析是一种通过计算文本中的情感倾向来判断文本情感的方法。

情感分析可以帮助企业和组织了解用户对产品、服务或品牌的态度和情感倾向,从而指导市场营销和产品改进。

3. 主题模型主题模型是一种用于发现文本中隐藏主题的方法。

通过对文本进行建模和分析,主题模型可以自动识别出文本中的主题,并将文本归类到不同的主题中。

主题模型在新闻分类、社交媒体分析和舆情监测等领域有着广泛的应用。

4. 实体识别实体识别是一种从文本中识别出具有特定意义的实体的方法。

实体可以是人名、地名、组织名等。

通过实体识别,可以帮助企业和组织更好地了解市场和竞争对手的情况,从而做出更明智的决策。

二、案例分析为了更好地理解文本挖掘的应用,下面将介绍两个案例。

1. 社交媒体分析社交媒体是人们日常交流和分享信息的重要平台,其中蕴含着大量的用户意见和情感。

通过对社交媒体数据进行文本挖掘,可以帮助企业了解用户对产品和服务的评价和需求。

例如,一家电商公司可以通过分析用户在社交媒体上的评论和评分,了解用户对不同产品的喜好和购买意向,从而优化产品策划和销售策略。

2. 舆情监测舆情监测是指对公众舆论和声音进行实时监测和分析的方法。

常见的数据挖掘模型类型

常见的数据挖掘模型类型

常见的数据挖掘模型类型包括:

1. 分类模型:用于将数据分为不同的类别或标签,常见的分类模型包括决策树、支持向量机(SVM)、逻辑回归等。

2. 回归模型:用于预测数值型的目标变量,常见的回归模型包括线性回归、多项式回归、岭回归等。

3. 聚类模型:用于将数据分成不同的群组,常见的聚类模型包括K 均值聚类、层次聚类、DBSCAN等。

4. 关联规则模型:用于发现数据中的关联关系,常见的关联规则模型包括Apriori算法、FP-Growth算法等。

5. 神经网络模型:用于模拟人脑神经元之间的连接和传递信息的过程,常见的神经网络模型包括多层感知机(MLP)、卷积神经网络(CNN)、循环神经网络(RNN)等。

6. 文本挖掘模型:用于处理和分析文本数据,常见的文本挖掘模型包括词袋模型、主题模型、情感分析等。

7. 时间序列模型:用于预测未来的趋势和模式,常见的时间序列模型包括ARIMA模型、长短期记忆网络(LSTM)等。

8. 强化学习模型:通过与环境不断互动学习最优策略,常见的强化

学习模型包括Q-learning、深度强化学习等。

这些模型可以根据数据类型、问题类型和任务目标选择合适的模型进行数据挖掘。

数据分析中的文本挖掘方法

数据分析中的文本挖掘方法在当今数字化时代,海量的文本数据不断涌现,这给企业决策、市场研究、舆情分析等领域提供了宝贵的信息资源。

然而,面对如此庞大的数据量,如何从中快速准确地提取有价值的信息成为了一项具有挑战性的任务。

这就需要借助文本挖掘技术,利用计算机科学、机器学习和自然语言处理等方法来从文本数据中自动抽取、识别和理解有用的信息。

文本挖掘,又称为文本数据挖掘或知识发现于文本,指的是从无结构文本中提取出结构化的、可用于进一步分析的信息。

它包括了一系列的技术和算法,能够自动地从文本中抽取关键词、实体名称、情感倾向、主题分类等信息。

下面将介绍几种常用的文本挖掘方法及其应用领域。

1. 分词与词频统计分词是将连续的文本切分成一个个有意义的词语单元的过程。

通过分词,可以将长长的文本序列转化为一系列离散的词语,方便后续的统计和分析。

分词方法有很多种,常见的有基于规则的方法、基于统计的方法和基于机器学习的方法。

在分词之后,可以通过词频统计的方法获得每个词语在文本中出现的频率,从而发现文本中的热门关键词。

分词与词频统计常被应用于搜索引擎的关键词提取、舆情分析中的关键词识别等任务。

2. 文本分类与朴素贝叶斯算法文本分类是将文本分成若干个预定义的类别的过程,常用于垃圾邮件过滤、情感分析、主题分类等应用场景。

而朴素贝叶斯算法是一种常用的文本分类算法。

该算法基于贝叶斯定理和特征条件独立假设,能够通过统计分析训练数据集中的特征和类别之间的关系,从而进行分类。

朴素贝叶斯算法在新闻分类、情感分析等领域都有广泛的应用,可以帮助企业快速准确地判断用户对某一产品或事件的态度。

3. 实体识别与命名实体识别算法实体识别是从文本中自动识别出具有特定意义的词语,例如人名、地名、机构名等。

命名实体识别算法是一种常见的实体识别方法,它通过构建规则和模型,识别出文本中的命名实体,并进行分类,如人名、地名、组织名等。

实体识别和命名实体识别广泛应用于信息抽取、搜索引擎、智能问答系统等领域。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

文本挖掘模型:本特征提取文本挖掘模型结构示意图1. 分词分词实例:提高人民生活水平:提高、高人、人民、民生、生活、活水、水平分词基本方法:最大匹配法、最大概率法分词、最短路径分词方法1.1 最大匹配法中文分词在中文信息处理中是最最基础的,无论机器翻译亦或信息检索还是其他相关应用,如果涉及中文,都离不开中文分词,因此中文分词具有极高的地位。

正向最大匹配法算法如下图:实例:S1="计算语言学课程是三个课时",设定最大词长MaxLen= 5,S2= " "(1)S2=“”;S1不为空,从S1左边取出候选子串W="计算语言学";(2)查词表,“计算语言学”在词表中,将W加入到S2中,S2=“计算语言学/ ”,并将W从S1中去掉,此时S1="课程是三个课时";(3)S1不为空,于是从S1左边取出候选子串W="课程是三个";(4)查词表,W不在词表中,将W最右边一个字去掉,得到W="课程是三";(5)查词表,W不在词表中,将W最右边一个字去掉,得到W="课程是";(6)查词表,W不在词表中,将W最右边一个字去掉,得到W="课程"(7)查词表,W在词表中,将W加入到S2中,S2=“计算语言学/ 课程/ ”,并将W从S1中去掉,此时S1="是三个课时";(8)S1不为空,于是从S1左边取出候选子串W="是三个课时";(9)查词表,W不在词表中,将W最右边一个字去掉,得到W="是三个课";(10)查词表,W不在词表中,将W最右边一个字去掉,得到W="是三个";(11)查词表,W不在词表中,将W最右边一个字去掉,得到W="是三"(12)查词表,W不在词表中,将W最右边一个字去掉,得到W=“是”,这时W是单字,将W加入到S2中,S2=“计算语言学/ 课程/ 是/ ”,并将W从S1中去掉,此时S1="三个课时";。

(21)S2=“计算语言学/ 课程/ 是/ 三/ 个/ 课时/ ”,此时S1=""。

(22)S1为空,输出S2作为分词结果,分词过程结束。

代码如下:[cpp]view plaincopy1.#include <iostream>2.#include <string>3.#include <fstream>4.#include <sstream>5.#include <hash_map>ing namespace std;ing namespace stdext;8.9.class CDictionary10.{11.public:12. CDictionary(); //将词典文件读入并构造为一个哈希词典13. ~CDictionary();14.int FindWord(string w); //在哈希词典中查找词15.private:16. string strtmp; //读取词典的每一行17. string word; //保存每个词18. hash_map<string, int> wordhash; // 用于读取词典后的哈希19. hash_map<string, int >::iterator worditer; //20.typedef pair<string, int> sipair;21.};22.23.//将词典文件读入并构造为一个哈希词典24.CDictionary::CDictionary()25.{26. ifstream infile("wordlexicon"); // 打开词典27.if (!infile.is_open()) // 打开词典失败则退出程序28. {29. cerr << "Unable to open input file: " << "wordlexicon"30. << " -- bailing out!" << endl;31. exit(-1);32. }33.while (getline(infile, strtmp, 'n')) // 读入词典的每一行并将其添加入哈希中34. {35. istringstream istr(strtmp);36. istr >> word; //读入每行第一个词37. wordhash.insert(sipair(word, 1)); //插入到哈希中38. }39.}40.41.CDictionary::~CDictionary()42.{43.}44.45.//在哈希词典中查找词,若找到,则返回,否则返回46.int CDictionary::FindWord(string w)47.{48.if (wordhash.find(w) != wordhash.end())49. {50.return 1;51. }52.else53. {54.return 0;55. }56.}57.58.#define MaxWordLength 10 // 最大词长为个字节(即个汉字)59.#define Separator "/ " // 词界标记60.61.CDictionary WordDic; //初始化一个词典62.63.//对字符串用最大匹配法(正向或逆向)处理64.string SegmentSentence(string s1)65.{66. string s2 = ""; //用s2存放分词结果67.while(!s1.empty())68. {69.int len =(int) s1.length(); // 取输入串长度70.if (len > MaxWordLength) // 如果输入串长度大于最大词长71. {72. len = MaxWordLength; // 只在最大词长范围内进行处理73. }74.//string w = s1.substr(0, len); // (正向用)将输入串左边等于最大词长长度串取出作为候选词75. string w = s1.substr(s1.length() - len, len); //逆向用76.int n = WordDic.FindWord(w); // 在词典中查找相应的词77.while(len > 2 && n == 0) // 如果不是词78. {79. len -= 2; // 从候选词右边减掉一个汉字,将剩下的部分作为候选词80.//w = w.substr(0, len); //正向用81. w = s1.substr(s1.length() - len, len); //逆向用82. n = WordDic.FindWord(w);83. }84.//s2 += w + Separator; // (正向用)将匹配得到的词连同词界标记加到输出串末尾85. w = w + Separator; // (逆向用)86. s2 = w + s2 ; // (逆向用)87.//s1 = s1.substr(w.length(), s1.length()); //(正向用)从s1-w处开始88. s1 = s1.substr(0, s1.length() - len); // (逆向用)89. }90.return s2;91.}92.93.//对句子进行最大匹配法处理,包含对特殊字符的处理94.string SegmentSentenceMM (string s1)95.{96. string s2 = ""; //用s2存放分词结果97.int i;98.int dd;99.while(!s1.empty() )100. {101. unsigned char ch = (unsigned char)s1[0];102.if (ch < 128) // 处理西文字符103. {104. i = 1;105. dd = (int)s1.length();106.while (i < dd && ((unsigned char)s1[i] < 128) && (s1[i] != 10) && (s1[i] != 13)) // s1[i]不能是换行符或回车符107. {108. i++;109. }110.if ((ch != 32) && (ch != 10) && (ch != 13)) // 如果不是西文空格或换行或回车符111. {112. s2 += s1.substr(0,i) + Separator;113. }114.else115. {116.//if (ch == 10 || ch == 13) // 如果是换行或回车符,将它拷贝给s2输出117.if (ch == 10 || ch == 13 || ch == 32) //谢谢读者mces89的指正118. {119. s2 += s1.substr(0, i);120. }121. }122. s1 = s1.substr(i,dd);123.continue;124. }125.else126. {127.if (ch < 176) // 中文标点等非汉字字符128. {129. i = 0;130. dd = (int)s1.length();131.while(i < dd && ((unsigned char)s1[i] < 176) && ((unsigned char)s1[i] >= 161)132. && (!((unsigned char)s1[i] == 161 && ((unsigned char)s1 [i+1] >= 162 && (unsigned char)s1[i+1] <= 168)))133. && (!((unsigned char)s1[i] == 161 && ((unsigned char)s1 [i+1] >= 171 && (unsigned char)s1[i+1] <= 191)))134. && (!((unsigned char)s1[i] == 163 && ((unsigned char)s1 [i+1] == 172 || (unsigned char)s1[i+1] == 161)135. || (unsigned char)s1[i+1] == 168 || (unsigned char)s1[i +1] == 169 || (unsigned char)s1[i+1] == 186136. || (unsigned char)s1[i+1] == 187 || (unsigned char)s1[i +1] == 191)))137. {138. i = i + 2; // 假定没有半个汉字139. }140.if (i == 0)141. {142. i = i + 2;143. }144.if (!(ch == 161 && (unsigned char)s1[1] == 161)) // 不处理中文空格145. {146. s2+=s1.substr(0, i) + Separator; // 其他的非汉字双字节字符可能连续输出147. }148. s1 = s1.substr(i, dd);149.continue;150. }151. }152.// 以下处理汉字串153. i = 2;154. dd = (int)s1.length();155.while(i < dd && (unsigned char)s1[i] >= 176)156. {157. i += 2;158. }159. s2 += SegmentSentence(s1.substr(0, i));160. s1 = s1.substr(i,dd);161. }162.return s2;163.}164.165.int main(int argc, char *argv[])166.{167. string strtmp; //用于保存从语料库中读入的每一行168. string line; //用于输出每一行的结果169. ifstream infile(argv[1]); // 打开输入文件170.if (!infile.is_open()) // 打开输入文件失败则退出程序171. {172. cerr << "Unable to open input file: " << argv[1]173. << " -- bailing out!" << endl;174. exit(-1);175. }176. ofstream outfile1("SegmentResult.txt"); //确定输出文件177.if (!outfile1.is_open())178. {179. cerr << "Unable to open file:SegmentResult.txt"180. << "--bailing out!" << endl;181. exit(-1);182. }183.while (getline(infile, strtmp, 'n')) //读入语料库中的每一行并用最大匹配法处理184. {185. line = strtmp;186. line = SegmentSentenceMM(line); // 调用分词函数进行分词处理187. outfile1 << line << endl; // 将分词结果写入目标文件188. }189.return 0;190.}其它基于匹配的分词方法:最大匹配法(Maximum Matching method):匹配的方向是从左向右。