实验二、数据预处理

大数据金融实验报告(3篇)

第1篇一、实验背景随着互联网技术的飞速发展,大数据时代已经到来。

金融行业作为国家经济的重要组成部分,也面临着前所未有的机遇和挑战。

大数据技术在金融领域的应用,为金融机构提供了更加精准的风险评估、投资决策和客户服务。

本实验旨在通过实际操作,让学生深入了解大数据在金融领域的应用,提高数据分析能力和金融业务理解。

二、实验目的1. 熟悉大数据金融的基本概念和原理。

2. 掌握大数据金融数据处理和分析的方法。

3. 培养学生运用大数据技术解决实际金融问题的能力。

4. 提高学生对金融市场的洞察力和风险防范意识。

三、实验内容1. 数据采集实验数据来源于某金融机构提供的客户交易数据,包括客户基本信息、交易记录、信用评分等。

2. 数据预处理(1)数据清洗:去除重复数据、缺失值填充、异常值处理等。

(2)数据转换:将不同类型的数据转换为统一格式,如将日期字符串转换为日期类型。

(3)数据集成:将不同来源的数据进行整合,形成完整的数据集。

3. 数据分析(1)客户画像分析:通过对客户的基本信息、交易记录和信用评分进行分析,构建客户画像。

(2)风险分析:运用机器学习算法对客户信用风险进行预测,为金融机构提供风险预警。

(3)投资组合优化:根据客户画像和风险分析结果,为不同风险偏好的客户提供个性化的投资组合。

4. 实验工具(1)数据采集:Python、Java等编程语言。

(2)数据预处理:Pandas、NumPy等数据分析库。

(3)数据分析:Spark、Hadoop等大数据处理框架。

(4)机器学习:Scikit-learn、TensorFlow等机器学习库。

四、实验步骤1. 数据采集:使用Python等编程语言从金融机构获取数据。

2. 数据预处理:运用Pandas、NumPy等库进行数据清洗、转换和集成。

3. 数据分析:a. 客户画像分析:运用Spark、Hadoop等大数据处理框架进行数据挖掘,提取客户特征。

b. 风险分析:使用Scikit-learn、TensorFlow等机器学习库建立信用风险评估模型。

数据挖掘实验报告

数据挖掘实验报告数据挖掘是一门涉及发现、提取和分析大量数据的技术和过程,它可以揭示出隐藏在数据背后的模式、关系和趋势,对决策和预测具有重要的价值。

本文将介绍我在数据挖掘实验中的一些主要收获和心得体会。

实验一:数据预处理在数据挖掘的整个过程中,最重要的一环就是数据预处理。

数据预处理包括数据清洗、数据集成、数据转换和数据规约等步骤,目的是为了提高数据的质量和可用性。

首先,我对所使用的数据集进行了初步的观察和探索。

发现数据集中存在着一些缺失值和异常值。

为此,我使用了一些常见的缺失值处理方法,如均值替代、中值替代和删除等。

对于异常值,我采用了离群值检测和修正等方法,使得数据在后续的分析过程中更加真实可信。

其次,我进行了数据集成的工作。

数据集合并是为了整合多个来源的数据,从而得到更全面和综合的信息。

在这个过程中,我需要考虑数据的一致性和冗余情况。

通过采用数据压缩和去重等技术,我成功地完成了数据集成的工作。

接着,我进行了数据转换的处理。

数据转换是为了将原始的数据转换成适合数据挖掘算法处理的形式。

在这个实验中,我采用了数据标准化和归一化等方法,使得不同属性之间具备了可比性和可计算性,从而便于后续的分析过程。

最后,我进行了数据规约的操作。

数据规约的目的在于减少数据的维数和复杂度,以提高数据挖掘的效果。

在这个阶段,我采用了主成分分析和属性筛选等方法,通过压缩数据集的维度和减少冗余属性,成功地简化了数据结构,提高了挖掘效率。

实验二:关联规则挖掘关联规则挖掘是数据挖掘中常用的一种方法,它用于发现数据集中项集之间的关联关系。

在这个实验中,我使用了Apriori算法来进行关联规则的挖掘。

首先,我对数据进行了预处理,包括数据清洗和转换。

然后,我选择了适当的最小支持度和最小置信度阈值,通过对数据集的扫描和频繁项集生成,找出了数据集中的频繁项集。

接着,我使用了关联规则挖掘算法,从频繁项集中挖掘出了具有一定置信度的关联规则。

在实验过程中,我发现挖掘出的关联规则具有一定的实用性和可行性。

心理学实验中的数据分析与处理

心理学实验中的数据分析与处理心理学实验是通过科学的方法探讨人类思维和行为的过程,在这一领域,数据分析和处理是非常重要的一个环节。

数据分析和处理可以帮助研究人员发现有意义的结果,提取最有用的信息,并进行验证。

在心理学实验中,数据处理的步骤通常包括四个阶段:数据的获取、预处理、分析和解析。

这些步骤是非常相互关联的,因此,在进行实验之前,需要认真规划完善这些步骤,以确保数据处理的准确性和科学性。

第一阶段:数据的获取首先,研究人员需要收集数据,采集的数据可能来源于实验室观察、问卷调查等不同渠道。

在收集数据时,需要注意时期、地点和参与者的选择。

在数据收集的过程中,如何保证数据的可靠性和准确性是至关重要的。

其次,需要在收集数据的时候,确保数据来源的客观性和正确性,这样才能避免数据因为主观意识而带来的误差。

第二阶段:数据预处理数据预处理是指在进行实验前对数据进行系统的处理,包括数据干预和数据清洗。

数据的干预是指通过分组、操作和条件,对数据进行划分、初步的加工处理;数据清洗是为了把不必要的或者错误的数据筛选出去,以得到更加可信的数据结果。

数据预处理的过程需要根据实验设计的需求,选择合适的方法。

例如,如果需要防止实验小组之间出现变化差异,需要进行数据标准化或规范化处理;如果需要对异常值进行处理,可以通过剔除异常数据或替代处理等方式。

第三阶段:数据分析在实验数据预处理之后,需要对数据进行分析。

数据分析是进一步研究数据信息的重要方法之一。

这里需要明确一点,数据分析与处理不是一开始就有清晰的计划,而是需要根据数据的具体情况来进行决策。

常见的数据分析方法有描述性统计分析、独立样本t检验、方差分析、相关分析等。

描述性统计是把原始数据整合成一个集中性指标,用来描述数据集的特性,描述性统计方法包括中心性参数、变异性参数、斜度和峰度参数等。

独立样本t检验用于比较两组样本均值是否相等,通常检验组间的差异性。

方差分析则用于比较多组数据的均值差异性,比如说组间和组内变异度的比较。

数据挖掘实验报告-数据预处理

数据挖掘实验报告-数据预处理数据挖掘实验报告数据预处理一、实验目的本次实验的主要目的是深入了解和掌握数据预处理在数据挖掘过程中的重要性及相关技术,通过对实际数据集的处理,提高数据质量,为后续的数据挖掘和分析工作奠定良好的基础。

二、实验背景在当今数字化时代,数据的规模和复杂性不断增加,而原始数据往往存在着各种问题,如缺失值、噪声、异常值、不一致性等。

这些问题如果不加以处理,将会严重影响数据挖掘算法的性能和结果的准确性。

因此,数据预处理成为了数据挖掘过程中不可或缺的重要环节。

三、实验数据集本次实验使用了一个名为“销售数据”的数据集,该数据集包含了某公司在过去一年中不同产品的销售记录,包括产品名称、销售日期、销售数量、销售价格、客户信息等字段。

四、数据预处理技术(一)数据清洗1、处理缺失值首先,对数据集中的缺失值进行了识别和分析。

通过观察发现,“客户信息”字段存在部分缺失。

对于这些缺失值,采用了两种处理方法:一是如果缺失比例较小(小于5%),直接删除含有缺失值的记录;二是如果缺失比例较大,采用均值填充的方法进行补充。

2、处理噪声数据数据中的噪声通常表现为数据中的错误或异常值。

通过对销售数量和销售价格的观察,发现了一些明显不合理的数值,如销售数量为负数或销售价格过高或过低的情况。

对于这些噪声数据,采用了基于统计的方法进行识别和处理,将超出合理范围的数据视为噪声并进行删除。

(二)数据集成由于原始数据集可能来自多个数据源,存在着重复和不一致的问题。

在本次实验中,对“销售数据”进行了集成处理,通过对关键字段(如产品名称、销售日期)的比较和合并,消除了重复的记录,并确保了数据的一致性。

(三)数据变换1、数据标准化为了消除不同字段之间量纲的影响,对销售数量和销售价格进行了标准化处理,使其具有可比性。

2、数据离散化对于连续型的数据字段,如销售价格,采用了等宽离散化的方法将其转换为离散型数据,以便于后续的数据挖掘算法处理。

实验二、数据预处理[教材]

![实验二、数据预处理[教材]](https://img.taocdn.com/s3/m/401ebf47814d2b160b4e767f5acfa1c7aa00821f.png)

实习二、数据预处理一、预处理简介ERDAS IMAGING数据预处理模块是由一组实用的图像数据处理工具构成,包括生成单值图像(Creat New Image)、三维地形表面(Create Surface)、图像分幅裁剪(Subset Image)、图像几何校正(Image Geometric Correction)、图像拼接处理(Mosaic Images)、非监督分类(Unsupervised Classification)、以及图像投影变换(Reprojection Images)等,主要是根据工作区域的地理特征和专题信息提取的客观需要,对数据输入模块中获取的IMG图像文件进行范围调整、误差校正、坐标转换等处理,以便进一步开展图像解译、专题分类等分析研究。

数据预处理模块简称Data Preparation或DataPrep,可以通过两种途径启动:ERDAS图标面板菜单条:Main→Data Preparation→Data Preparation菜单(图2.1)ERDAS图标面板工具条:点击DataPrep图标→Data Preparation菜单(图2.1)图2.1 Data Preparation菜单从图2.1可以看出,ERDAS IMAGIMG数据预处理模块包括了7项主要功能,其中第一项功能(生成单值图像)比较简单,第六项功能(非监督分类)将在图像分类中进行说明。

下面将主要介绍其余五项功能,重点是图像几何校正和图像拼接处理,因为这两项操作是从事遥感应用研究必须开展的基本工作过程。

二、三维地形表面(3D Surfacing)三维地形表面工具允许用户在不规则空间点的基础上产生三维地形表面,所支持的输入数据类型包括:ASCII码点文件、ArcInfo的Coverage点文件和线文件,ERDAS IMAGING 的注记数据层,以及栅格图像文件IMG。

所有输入数据必须具有X、Y、Z值,三维地形表面工具所应用的TIN插值方法,所输出的是一个连续的栅格图像文件。

大数据处理实验报告

大数据处理实验报告随着信息时代的到来,大数据处理逐渐成为了各行业的重要课题。

本次实验旨在通过对大数据处理技术的探究,提高我们对大数据处理的理解和应用能力。

一、实验背景在日常生活中,我们经常会碰到各种大数据,比如网络上的海量数据、传感器采集的实时数据等。

如何高效地处理这些大数据,成为了当前亟需解决的问题。

因此,本次实验旨在研究大数据处理技术,包括数据收集、处理与分析等方面。

二、实验内容1. 数据采集:首先,我们需要选择一个合适的数据源,比如文本文件、数据库等,以便进行后续的数据处理。

2. 数据预处理:在数据采集后,我们需要对数据进行清洗、筛选、去重等处理,以确保数据的质量和完整性。

3. 数据分析:通过对数据进行统计、分析等操作,我们可以获取数据中隐藏的规律和信息,帮助我们做出决策和预测。

4. 结果展示:最后,我们需要将数据处理的结果进行可视化展示,让别人更直观地理解我们的数据分析成果。

三、实验步骤1. 选择数据源:本次实验我们选择了一份包含用户购物记录的文本文件作为数据源。

2. 数据预处理:首先,我们对数据进行了清洗,去除了其中的脏数据和异常值。

3. 数据分析:接着,我们利用Python编程语言进行了数据分析,包括用户购买偏好分析、销售额统计等。

4. 结果展示:最后,我们使用Matplotlib库将数据分析结果绘制成图表,方便其他人理解和借鉴。

四、实验结果通过本次实验,我们成功地完成了对大数据的处理与分析,获取了有关用户购物行为的一些有价值的信息。

这些信息可以帮助商家更好地了解用户需求,制定更科学有效的营销策略。

五、实验总结大数据处理是一个复杂而又重要的领域,需要我们不断地学习和实践。

通过本次实验,我们对大数据处理技术有了更深入的了解,也掌握了一些实用的数据处理方法和工具。

希望在今后的学习和工作中能够更好地运用大数据处理技术,实现更多有意义的成果。

以上就是本次大数据处理实验的报告内容,谢谢!。

数据预处理案例实验报告

一、实验背景随着大数据时代的到来,数据挖掘和数据分析成为热门的研究领域。

然而,在实际应用中,原始数据往往存在噪声、缺失值、异常值等问题,直接对数据进行挖掘和分析难以得到准确的结果。

因此,数据预处理成为数据挖掘和数据分析的重要环节。

本实验以某电商平台用户购买数据为例,进行数据预处理实验,旨在提高数据质量,为后续的数据挖掘和分析提供基础。

二、实验目的1. 了解数据预处理的流程和常用方法;2. 掌握缺失值处理、异常值处理、特征筛选等数据预处理技术;3. 提高数据质量,为后续的数据挖掘和分析提供基础。

三、实验数据本实验数据来源于某电商平台用户购买数据,包括用户ID、商品ID、购买时间、购买金额、用户性别、用户年龄、用户职业等字段。

四、实验步骤1. 数据加载与探索首先,使用Python的pandas库加载实验数据,并进行初步探索。

通过观察数据的基本统计信息,了解数据分布情况,为后续的数据预处理提供依据。

2. 缺失值处理(1)数据可视化:通过散点图、直方图等方式,观察数据中缺失值的分布情况。

(2)缺失值填充:根据缺失值的分布情况,选择合适的填充方法。

例如,对于连续型变量,可以使用均值、中位数或众数进行填充;对于分类变量,可以使用众数或根据其他变量进行填充。

3. 异常值处理(1)数据可视化:通过箱线图、散点图等方式,观察数据中异常值的分布情况。

(2)异常值处理:根据异常值的性质,选择合适的处理方法。

例如,删除异常值、对异常值进行修正或替换等。

4. 特征筛选(1)相关性分析:计算变量之间的相关系数,筛选出与目标变量高度相关的特征。

(2)信息增益分析:根据信息增益计算特征的重要性,筛选出对目标变量有较大贡献的特征。

5. 数据预处理结果经过数据预处理,数据质量得到提高,为后续的数据挖掘和分析提供了良好的基础。

五、实验结果与分析1. 缺失值处理通过对缺失值进行填充,降低了数据缺失的比例,提高了数据质量。

2. 异常值处理通过对异常值进行处理,消除了数据中的噪声,提高了数据质量。

实验二数据的预处理spass

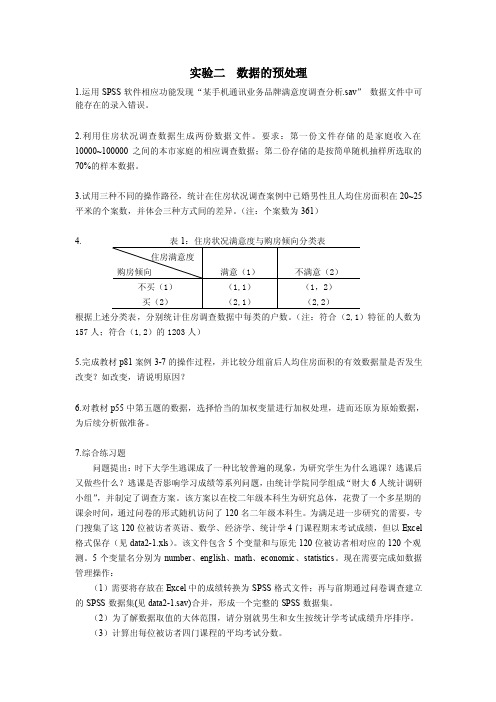

实验二数据的预处理1.运用SPSS软件相应功能发现“某手机通讯业务品牌满意度调查分析.sav”数据文件中可能存在的录入错误。

2.利用住房状况调查数据生成两份数据文件。

要求:第一份文件存储的是家庭收入在10000~100000之间的本市家庭的相应调查数据;第二份存储的是按简单随机抽样所选取的70%的样本数据。

3.试用三种不同的操作路径,统计在住房状况调查案例中已婚男性且人均住房面积在20~25平米的个案数,并体会三种方式间的差异。

(注:个案数为361)4.根据上述分类表,分别统计住房调查数据中每类的户数。

(注:符合(2,1)特征的人数为157人;符合(1,2)的1203人)5.完成教材p81案例3-7的操作过程,并比较分组前后人均住房面积的有效数据量是否发生改变?如改变,请说明原因?6.对教材p55中第五题的数据,选择恰当的加权变量进行加权处理,进而还原为原始数据,为后续分析做准备。

7.综合练习题问题提出:时下大学生逃课成了一种比较普遍的现象,为研究学生为什么逃课?逃课后又做些什么?逃课是否影响学习成绩等系列问题,由统计学院同学组成“财大6人统计调研小组”,并制定了调查方案。

该方案以在校二年级本科生为研究总体,花费了一个多星期的课余时间,通过问卷的形式随机访问了120名二年级本科生。

为满足进一步研究的需要,专门搜集了这120位被访者英语、数学、经济学、统计学4门课程期末考试成绩,但以Excel 格式保存(见data2-1.xls)。

该文件包含5个变量和与原先120位被访者相对应的120个观测。

5个变量名分别为number、english、math、economic、statistics。

现在需要完成如数据管理操作:(1)需要将存放在Excel中的成绩转换为SPSS格式文件;再与前期通过问卷调查建立的SPSS数据集(见data2-1.sav)合并,形成一个完整的SPSS数据集。

(2)为了解数据取值的大体范围,请分别就男生和女生按统计学考试成绩升序排序。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验二、数据预处理实习二、数据预处理一、预处理简介ERDAS IMAGING数据预处理模块是由一组实用的图像数据处理工具构成,包括生成单值图像(Creat New Image)、三维地形表面(Create Surface)、图像分幅裁剪(Subset Image)、图像几何校正(Image Geometric Correction)、图像拼接处理(Mosaic Images)、非监督分类(Unsupervised Classification)、以及图像投影变换(Reprojection Images)等,主要是根据工作区域的地理特征和专题信息提取的客观需要,对数据输入模块中获取的IMG图像文件进行范围调整、误差校正、坐标转换等处理,以便进一步开展图像解译、专题分类等分析研究。

数据预处理模块简称Data Preparation或DataPrep,可以通过两种途径启动:ERDAS图标面板菜单条:Main→Data Preparation→Data Preparation菜单(图2.1)ERDAS图标面板工具条:点击DataPrep 图标→Data Preparation菜单(图2.1)图2.1 DataPreparation菜单从图2.1可以看出,ERDAS IMAGIMG数据预处理模块包括了7项主要功能,其中第一项功能(生成单值图像)比较简单,第六项功能(非监督分类)将在图像分类中进行说明。

下面将主要介绍其余五项功能,重点是图像几何校正和图像拼接处理,因为这两项操作是从事遥感应用研究必须开展的基本工作过程。

二、三维地形表面(3D Surfacing)三维地形表面工具允许用户在不规则空间点的基础上产生三维地形表面,所支持的输入数据类型包括:ASCII码点文件、ArcInfo的Coverage点文件和线文件,ERDAS IMAGING 的注记数据层,以及栅格图像文件IMG。

所有输入数据必须具有X、Y、Z值,三维地形表面工具所应用的TIN插值方法,所输出的是一个连续的栅格图像文件。

每一个已知的空间点在输出的地形表面上保持Z值不变,而没有Z值的空间点,其输出表面的Z值是基于TIN 其周围的已知点插值计算获得的。

在三维地形表面工具中提供了两种TIN插值方法:线性插值(Linera)与非线性插值(non-linear)。

线性插值方法是应用一次多项式方程进行计算,输出的TIN三角面是一些有棱角的平面;非线性插值方法应用五次多项式方程进行计算,输出的是平滑表面,这种情况下,TIN 三角面不是一个平面,而是具有弹性的曲面。

线性插值方法速度快但结果简单,而非线性插值方法产生基于不规则分布数据集的非常连续的、圆滑的表面结果。

1.启动三维地形表面(Surfacing Create Surface)ERDAS 图标面板菜单条:Main→Data Preparation菜单→选择Create Surface→打开3D Surfacing对话框(图2.2)ERDAS 图标面板工具条:点击Data Pre图标,打开Data Preparation菜单→选择Create Surface→打开3D Surfacing对话框(图2.2)3D Surfacing对话框由菜单条(Menu Bar)、工具条(Tool Bar)和数据表格(Data CellArray)组成。

菜单条主要由文件操作(File)、数据表操作(Row)和表面生成(Surface)菜单组成,而工具条则由读取数据(Read Point)文件、保存数据文件(Save Point)和生成地形表面(Perform Surfacing)图标组成。

图2.2 3D Surfacing对话框(读入数据之后)2.定义地形表面参数(Defining Surface Parameters)3D Surfacing对话框菜单条:File Read 打开Read Point对话框(图2.3)图2.3 Read Point对话框在Read Point 对话框中需要定义下列参数:→数据源文件类型(Source File Type):ASCII File→数据源文件名称(Source File Name):Inpts.dat→OK(关闭Read Points对话框)→打开Import Options对话框(图2.4)在Import Options栏目,需要定义下列参数:→选择字段类型(Field Type):Delimited by Separation(分割字符)→选择分割字符(Separation Charactor):Comma(逗号分割)图2.4 Import Options 对话框(Field Definition栏目)→每行结束字符(Row Terminator Charactor):Return New Line(DOS)→确定跳过几行(Number of Rows to Skip):0(从头读)→点击Input Preview标签,进入Input Preview栏目(图2.5)从Import Options对话框显示的原始数据可知,数据文件中的数据记录方式是一行一个点,每一行数据包括点号、X坐标、Y坐标、Z 坐标(高程值)四个字段,其中点号在此处读入数据时不需要,因此,必须在Import Options 对话框的Colum Mapping中确定X、Y、Z与数据文件中字段的对应关系:→Output Column Name:X对应Input Field Number:2→Output Column Name:Y对应Input Field Number:3→Output Column Name:Z对应Input Field Number:4→OK(关闭Import Options对话框,读入数据)→数据读到3D Surfacing Data CellArray中(图2.2)图2.5 Import Options对话框(Input Preview栏目)如果需要,可以将读入的数据保存为ERDAS的Annotation Layer或ArcInfo的Coverage文件:3D Surfacing dialog菜单:File → Save as →Save as对话框(图2.6)→确定输出文件类型(Output File Type):Point Coverage确定输出文件名(Save as ArcInfo):testpoint图2.6 Save as对话框3.生成三维地形表面(Creating 3D Surface)3D Surfacing对话框菜单条:Surface →Surfacing→打开Surfacing对话框(图2.7)3D Surfacing对话框工具条:点击Perform Surfacing图标→打开Surfacing对话框(图2.7)图2.7 Surfacing对话框在Surfacing对话框中需要设置下列参数:→输出文件名称(Output File):testsurface.img→表面插值方法(Surfacing Method):Linear Rubber Sheeting→输出文件范围(Output Corners):自动读取ULX、ULY、LRX、LRY→输出像元大小(Output Cell Size):X:30/Y:30→输出像元形状:Square Cells→输出图像背景值(Background Value):0→输出统计忽略值(Ignore Zero in Output Stats):0→输出数据类型(Output Data Type):Unsigned 16 bit→OK(关闭Surfacing对话框,执行地形表面过程)2.显示三维地形表面(Display 3D Surface)由三维地形表面过程生成的图像文件,就是ERDAS系统的DEM文件,DEM文件常常用于三维图像(Image Drape)的显示或虚拟地理信息系统(Virtual GIS)操作。

所以,可以在Viewer 视窗中打开曲面所生成的地形表面文件testsurface.img文件,显示其二维平面效果或通过Image Info查看其定量信息,也可以在其上叠加对应的具有相同投影系统的图像文件,显示其三维立体效果。

三、图像分幅裁剪(Subset Image)在实际工作中,经常需要根据研究工作范围对图像进行分幅裁剪,按照ERDAS实现图像分幅裁剪的过程,可以将图像分幅裁剪分为两种类型:规则分幅和不规则分幅。

1.规则分幅裁剪(Rectangle Subset Image)规则分幅是指裁剪图像的边界范围是一个矩形,通过左上角和右下角两点的坐标,就可以确定图像的裁剪位置,整个裁剪过程比较简单。

ERDAS 图标面板菜单条:Main→Data Preparation →Data Preparation菜单(图2.1)→选择Subset Image→开Subset Image对话框(图2.8)ERDAS 图标面板工具条:点击Data Prep 图标→打开Data Preparation菜单(图2.1)→选择Subset Image→打开Subset Image对话框(图2.8)图2.8 Subset Image对话框在Subset Image对话框中需要设置下列参数:→输入文件名称(Input File):Lanier.img→输出文件名称(Output File):Lanier_sub.img→坐标类型(Coordinate Type):File→裁剪范围(Subset Definition):输入ULX、ULY、LRX、LRY→输出数据类型(Output Data Type):Unsigned 8 bit→输出统计忽略零值:Ignore Zero in Output Stats→输出像元波段(Select Layers):1:7(表示选择从第一波段到第七波段)2 ,3,2(表示选择2,3,2四个波段)→OK(关闭Subset Image对话框,执行图像裁剪)说明:①在上述图像裁剪过程中,裁剪范围是通过直接输入左上角坐标和右下角坐标定义的。

此外,还可以通过两种方式定义裁剪范围:其一是应用查询框(Inquire Box),然后在Subset Image对话框中选择From Inquire Box功能;其二是应用AOI,然后在Subset Image对话框中选择AOI功能,打开AOI对话框,并确定AOI 区域来自图像视窗即可。

②输出波段的选择:一种是用冒号表示从第几波段到第几波段,另外一种是用逗号隔开表示仅仅选择这几个波段。

2.不规则分幅裁剪(Polygon Subset Image)不规则分幅裁剪是指裁剪图像的边界范围是个任意多边形,无法通过左上角和右下角两点的坐标确定图像的裁剪位置,而必须事先生成一个完整闭合多边形区域,可以是一个AOI多边形,也可以是ArcInfo的一个Polygon Coverage。