GPFS_for_linux安装与实施文档

GPFS安装实施和维护

GPFS安装实施和维护2015.10GPFS安装实施和维护AIX下GPFS安装配置及维护邹旭⽬录1.概述 (3)1.1 IBM GPFS功能介绍 (3)1.2 GPFS体系架构介绍 (3)磁盘 (3)⽹络共享磁盘(NSD) (4)GPFS ⽂件设备 (4)连接模式:如下图 (4)1.3 GPFS的优势 (5)2.GPFS安装配置步骤 (5)2.1 GPFS安装准备 (5)2.2 GPFS软件的安装 (6)A. GPFS 软件放在⽬录 (6)B. 升级包 (6)C. 通过SMIT 安装命令进⾏安装和升级 (6)D. 成功的安装完GPFS 之后 (7)E. 添加/etc/environment 的执⾏路径 (7)3.创建GPFS ⼼跳地址 (7)4.配置GPFS集群 (8)4.1 配置节点⽂件 (8)4.2 建⽴GPFS 集群 (8)4.3 确认查看GPFS 集群 (9)4.4 激活GPFS 授权 (9)5 配置GPFS 的共享盘 (10)5.1 建⽴NSD(Network Shared Disk)⽂件 (10) 5.2 ⽣成NSD 盘 (10)5.3确认结果 (11)5.4启动GPFS 系统 (11)6 配置GPFS 的共享⽂件系统 (11)6.1 建⽴GPFS ⽂件系统 (11)6.2 确认⽂件系统 (12)6.3 装载⽂件系统 (13)6.4 建⽴⽬录 (13)7 配置GPFS 的属性 (13)7.1 配置GPFS选项属性 (13)实施结果 (15)8.GPFS管理和维护 (16)8.1主机应⽤的启动顺序 (16)8.2 GPFS的启动和关闭 (16)节点状态 (16)8.3 GPFS 的⽂件系统管理 (17)8.4 GPFS 的集群管理 (17)8.5 GPFS 的磁盘管理 (17)8.6 GPFS的⽇志和安装路径 (18)其他有⽤的GPFS操作 (18)1. 新增⼀个节点 (18)2. 更换硬盘 (18)3. 停掉节点 (19)4. 修改inode数量 (19)5. 清除GPFS (19)1.概述1.1 IBMGPFS功能介绍GPFS (General Parallel File System) 是IBM 公司第⼀个共享⽂件系统,起源于IBM SP 系统上使⽤的虚拟共享磁盘技术( VSD )。

GPFS安装、配置、管理

合用标准文档GPFS的安装、配置、管理合用标准文档目录1 GPFS安装、配置、管理和保护 (1)1.1GPFS安装 (1)1.2GPFS配置 (1)1.2.1集群节点配置 (1)1.2.2G PFS NSD磁盘配置 (1)1.2.3优化 GPFS集群配置 (3)1.2.4创立 GPFS文件系统 (4)1.2.5配置改正 (4)1.3GPFS管理和保护 (8)1GPFS安装、配置、管理和保护本局部围绕 XX公司 HPIS系统实质情况,描述 GPFS的安装、配置过程,以及 GPFS 管理和保护方法。

1.1 GPFS安装GPFS 3.3 及补丁使用 AIX 系统标准 installp方式安装,安装命令比方:#installp -agYXd . all查察安装结果 ;#lslpp -l |grep gpfsgpfs.base 3.3.0.16COMMITTED GPFS File Managergpfs.base 3.3.0.16COMMITTED GPFS File Managergpfs.docs.data 3.3.0.1 COMMITTED GPFS Server Manpages and1.2 GPFS配置1.2.1 集群节点配置准备 node 列表文件,节点属性: manager或 client,quorum或nonquorum #more /home/GPFS/nodeshpis1:manager-quorumhpis2:manager-quorum创立 RAC两节点的 GPFS集群#mcrcluster -N /home/GPFS/nodes -p hpis1 -s hpis2 -r /usr/bin/rsh -R /usr/bin/rcp -C cls_hpis-p,-s 分别表示主,辅集群管理效劳器-r /usr/bin/rsh -R /usr/bin/rcp表示rsh,rcp方式进行集群管理时使用rsh,rcp 管理方式;也可以经过配置ssh,使用 ssh,scp 方式查察集群配置#mmlscluster1.2.2 GPFS NSD磁盘配置因为 RAC只有两个 Server 节点,为保证 GPFS文件系统的高可用性,需要将两台 Server 均设为 quorum 节点,同时从两个储藏和一台Server 的当地盘中分别取一个盘作为tiebreaker quorum Disk。

IBM GPFS并行文件系统安装与配置

IBM GPFS文件系统安装与配置目录1概述 (4)1.1IBM GPFS功能介绍 (4)1.2GPFS体系架构介绍 (2)1.3GPFS的优势 (5)2GPFS安装配置步骤 (6)2.1GPFS安装准备 (6)2.2GPFS的安装软件 (6)2.3配置GPFS集群 (6)1概述1.1IBM GPFS功能介绍GPFS (General Parallel File System) 是IBM 公司第一个共享文件系统,起源于IBM SP 系统上使用的虚拟共享磁盘技术( VSD )。

作为这项技术的核心,GPFS 是一个并行的磁盘文件系统,它保证在资源组内的所有节点可以并行访问整个文件系统。

而且针对此文件系统的服务操作,可以同时安全地在使用此文件系统的多个节点上实现。

GPFS 允许客户共享文件,而这些文件可能分布在不同节点的不同硬盘上。

它提供了许多标准的UNIX 文件系统接口,允许应用不需修改或者重新编辑就可以在其上运行。

GPFS 也支持UNIX 文件系统的工具,即:用户可以像使用普通文件系统一样使用基于GPFS 的文件系统,唯一不同的在于管理GPFS 文件系统的命令。

GPFS 提供的文件系统操作服务可以支持并行应用和串行应用,它允许任何节点(这些节点属于同一个节点组)上的并行应用同时访问同一个文件或者不同的文件。

1.2GPFS体系架构介绍GPFS 文件系统基本上由三层架构组成:磁盘,网络共享磁盘(NSD),GPFS 文件设备,如下图所示。

•磁盘GPFS 文件系统最底层的是物理磁盘设备。

原则上可以采用系统上任何块设备,包括磁盘,磁盘分区,逻辑卷。

从物理连接上来看,GPFS 支持使用所有方式连接的磁盘。

包括本地IDE 磁盘,本地SCSI 磁盘,光纤SAN 磁盘,iSCSI 磁盘,等等。

•网络共享磁盘(NSD: network share disk)NSD 是由磁盘映射出来的虚拟设备,NSD 与磁盘是一一对应的关系。

LinuxNFS服务器的安装与配置

Linux NFS服务器的安装与配置cpw806@qq.网上看到一篇有关nfs服务器安装与配置的文章觉得非常不错所以就收藏了起来,鉴于有很多时候收藏的网页过段时间就会莫名的找不到了,所以决定全盘拷贝存档。

对原作者表示感谢。

本文来源.cnblogs./mchina/archive/2013/01/03/2840040.html一、NFS服务简介NFS 是Network File System的缩写,即网络文件系统。

一种使用于分散式文件系统的协定,由Sun公司开发,于1984年向外公布。

功能是通过网络让不同的机器、不同的操作系统能够彼此分享个别的数据,让应用程序在客户端通过网络访问位于服务器磁盘中的数据,是在类Unix系统间实现磁盘文件共享的一种方法。

NFS 的基本原则是“容许不同的客户端及服务端通过一组RPC分享相同的文件系统”,它是独立于操作系统,容许不同硬件及操作系统的系统共同进行文件的分享。

NFS在文件传送或信息传送过程中依赖于RPC协议。

RPC,远程过程调用(Remote Procedure Call) 是能使客户端执行其他系统中程序的一种机制。

NFS本身是没有提供信息传输的协议和功能的,但NFS却能让我们通过网络进行资料的分享,这是因为NFS使用了一些其它的传输协议。

而这些传输协议用到这个RPC功能的。

可以说NFS本身就是使用RPC 的一个程序。

或者说NFS也是一个RPC SERVER。

所以只要用到NFS的地方都要启动RPC 服务,不论是NFS SERVER或者NFS CLIENT。

这样SERVER和CLIENT才能通过RPC来实现PROGRAM PORT的对应。

可以这么理解RPC和NFS的关系:NFS是一个文件系统,而RPC 是负责负责信息的传输。

二、系统环境系统平台:CentOS release 5.6 (Final)NFS Server IP:192.168.1.108防火墙已关闭/iptables: Firewall is not running.SELINUX=disabled三、安装NFS服务NFS的安装是非常简单的,只需要两个软件包即可,而且在通常情况下,是作为系统的默认包安装的。

GPFS安装与设置

实验1 GPFS安装与设置提示:在开始之前,请登录您所在组的AIX节点,每个节点打开至少一个窗口,以便后续操作。

目标在本实验中将练习如下内容验证AIX 系统环境安装GPFS介质创建GPFS集群定义NSD(Network Shared Disks)创建GPFS文件系统第一节:环境验证A.AIX与GPFS版本验证验证每个节点AIX版本参考GPFS FAQ: /infocenter/clresctr/vxrx/index.jsp # oslevel_______________________________________________________该AIX是否支持GPFS?该AIX版本下对GPFS 是否有特定版本与patch要求?________________________________________________________AIX xlC版本?8.0以上# lslpp -l |grep xlC|grep rte___xlC.aix61.rte 10.1.0.2 COMMITTED XL C/C++ Runtime for AIX 6.1xlC.rte 10.1.0.2 COMMITTED XL C/C++ RuntimexlC.sup.aix50.rte 9.0.0.1 COMMITTED XL C/C++ Runtime for AIX_____________________________________________________IBM JDK Version? Jdk 5# cd /usr; ls java5# /usr/java5/bin/java -version__1.5_____________________________________________________B.网络配置验证各节点的hostname?node1,node2,node3PAlpar10 PAlpar11 PAlpar12________________________________________________________ 各节点是否能相互ping 通?# ping node1# ping node2# ping node3C.验证/etc/hosts文件,应包含组内给节点IP和hostname,如192.168.1.11node1192.168.1.12node2192.168.1.13node3D.ssh安装、配置与通讯验证#cd /home/soft/ssh; installp -agYXpd . all先预览是否能正常安装,输出如下表示通过:SUCCESSES---------Filesets listed in this section passed pre-installation verificationand will be installed.Selected Filesets-----------------openssh.base.client 5.0.0.5302 # Open Secure Shell Commandsopenssh.base.server 5.0.0.5302 # Open Secure Shell Serveropenssh.license 5.0.0.5302 # Open Secure Shell Licenseopenssh.man.en_US 5.0.0.5302 # Open Secure Shell Documentat... openssl.base 0.9.8.840 # Open Secure Socket Layeropenssl.license 0.9.8.840 # Open Secure Socket Licenseopenssl.man.en_US 0.9.8.840 # Open Secure Socket Layer # installp -agYXd . all安装后,如下表示正常:openssl.man.en_US 0.9.8.840 USR APPLY SUCCESS openssl.license 0.9.8.840 USR APPLY SUCCESS openssl.base 0.9.8.840 USR APPLY SUCCESS openssl.base 0.9.8.840 ROOT APPLY SUCCESS openssh.license 5.0.0.5302 USR APPLY SUCCESS openssh.base.client 5.0.0.5302 USR APPLY SUCCESS openssh.base.server 5.0.0.5302 USR APPLY SUCCESS openssh.base.client 5.0.0.5302 ROOT APPLY SUCCESS openssh.base.server 5.0.0.5302 ROOT APPLY SUCCESS openssh.man.en_US 5.0.0.5302 USR APPLY SUCCESS # ssh-keygen -t rsa在每个AIX节点生成ssh-key如下:Generating public/private rsa key pair.Enter file in which to save the key (//.ssh/id_rsa): 回车Created directory '//.ssh'.Enter passphrase (empty for no passphrase): 回车Enter same passphrase again: 回车Your identification has been saved in //.ssh/id_rsa.Your public key has been saved in //.ssh/id_rsa.pub.The key fingerprint is:db:0b:23:aa:81:a9:b2:41:33:97:8b:6b:b7:24:fc:2c root@node1在节点 node1 copy如下文件# cp /.ssh/id_rsa.pub /.ssh/authorized_keys从节点node2 copy /.ssh/id_rsa.pub 到节点1/tmp/id_rsa.pub2,需要输入节点2的root密码从节点node3 copy /.ssh/id_rsa.pub 到节点1/tmp/id_rsa.pub3,需要输入节点3的root密码# scp node2:/.ssh/id_rsa.pub /tmp/id_rsa.pub2root@node2's password:id_rsa.pub 100% 393 0.4KB/s 00:00 # scp node3:/.ssh/id_rsa.pub /tmp/id_rsa.pub3在node1将/tmp/id_rsa.pub2; /tmp/id_rsa.pub3追加到/.ssh/authorized_keys中#cat /tmp/id_rsa.pub2 >> /.ssh/authorized_keys#cat /tmp/id_rsa.pub3 >> /.ssh/authorized_keys将node1上/.ssh/authorized_keys copy到node2,node3#scp /.ssh/authorized_keys node2:/.ssh/authorized_keys#scp /.ssh/authorized_keys node3:/.ssh/authorized_keys在node1,node2,node3节点touch 一个/.hushlogin文件,以屏蔽登录回显信息# touch /.hushlogin验证node1,node2,node3节点的ssh通讯,如能显示日期验证通过on node1# ssh node2 date; ssh node3 dateon node2# ssh node1 date; ssh node3 dateon node3# ssh node1 date; ssh node2 dateE.rsh, dsh 配置创建并编辑/.rhosts文件,node1 rootnode2 rootnode3 root验证rsh通讯,如能显示日期验证通过on node1# rsh node2 date; rsh node3 dateon node2# rsh node1 date; rsh node3 dateon node3# rsh node1 date; rsh node2 date验证dsh通讯,如能显示日期验证通过on node1# dsh -n node2 date; dsh -n node3 dateon node2# dsh -n node1 date; dsh -n node3 dateon node3# dsh -n node1 date; dsh -n node2 dateF.检查各AIX系统共享disks#lsdev –Cc disk#lspv第二节:安装GPFS软件A. 在node1,node2,node3上分别预览与安装GPFS软件及其PTF(Program Temporary Fix)# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/3.2.1.0; inutoc .; installp -agYXpd . all"# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/3.2.1.0; installp -agYXd . all"# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/ptf; inutoc .; installp -agYXpd . all"# dsh -n node1,node2,node3 "cd /home/soft/gpfs3.2.1/ptf; installp -agYXd . all"B. 在node1,node2,node3上分别验证GPFS软件# dsh -n node1,node2,node3 "lslpp -L gpfs.*"Fileset Level State Type Description (Uninstaller)----------------------------------------------------------------------------gpfs.base 3.2.1.13 A F GPFS File Managergpfs.docs.data 3.2.1.1 A F GPFS Server Manpages andDocumentationgpfs.gui 3.2.1.0 C F GPFS GUIgpfs.msg.en_US 3.2.1.11 A F GPFS Server Messages - U.S.EnglishState codes:A -- Applied.B -- Broken.C -- Committed.E -- EFIX Locked.O -- Obsolete. (partially migrated to newer version)? -- Inconsistent State...Run lppchk -v.Type codes:F -- Installp FilesetP -- ProductC -- ComponentT -- FeatureR -- RPM PackageC. 在node1,node2,node3上,将gpfs执行命令路径加入PATH环境变量# echo export PATH=$PATH:/usr/lpp/mmfs/bin >>/etc/profile# . /etc/profileD. 在node1,node2,node3上,确认gpfs PATH环境变量是否已正确# env|grep PATH# mmlsclustermmlscluster: 6027-1382 This node does not belong to a GPFS cluster.mmlscluster: 6027-1639 Command failed. Examine previous error messages to determine cause.第三节:创建一个双节点的GPFS集群在本练习中,我们首先建一个单节点的GPFS CLUSTER。

gpfs安装配置说明

GPFS系统配置(1)

▪ 支持1 to 8,192 个节点(V3.2 & V3.3) V3.1可达4096个节点 可多达 3794 个Linux节点和1530个AIX节点 有些用户实际环境已安装了超过500个节点GPFS

▪ 能mount多个文件系统 V3.2以上支持256个 V3.1.0.5开始支持64个 V3.1开始支持32个

Configuration data Servers角色

– 注: 对GPFS集群做变更配置必需这些节点

mmcrcluster命令

▪ Usage:

▪ mmcrcluster -N {NodeDesc[,NodeDesc...] | NodeFile

▪

-p PrimaryServer

▪

[-s SecondaryServer]

– Installp命令安装如下安装包(前面已经介绍了dsh,我们可以dsh对 多个节点进行同步安装,在节点数非常多时,可以节省很多工作量) ▪ gpfs.base ▪ gpfs.docs.data ▪ gpfs.msg.en_US ▪ gpfs.gui

安装GPFS介质—LINUX节点(Power 服务器)

安装前准备— 存储配置

▪ 将存储LUN/disk 配置映射到GPFS集群节点

– 依据系统需求的不同,disk连接拓扑可能会有差异 ▪ SAN存储模式是将所有节点直接映射到所有节点 ▪ NSD模式只需由作为NSD Server的节点链接disk ▪ 混合模式可以是部分节点直接连接存储,部分做为NSD Client,它们通过NSD Server,通过IP网络进行IO访问 (Network Block IO)

▪

tracedev

▪

dumpconv

GPFS for linux安装与实施文档

GPFS for linux实施目录1、GPFS规划 (3)2、GPFS实施 (3)2.1、软件需求 (3)2.2软件安装 (3)2.2.1在每个节点上安装GPFS软件包 (4)2.2.2、gpfs软件编译 (4)2.2.3、在每个节点上编译.bashrc文件,建立GPFS命令环境变量 (4)2.2.4、创建节点描述文件 (5)2.2.5、创建磁盘描述文件 (5)2.2.6、创建主机信任文件 (5)2.2.7、确认连接磁盘 (5)3、GPFS安装 (6)3.1、建立集群 (6)3.1.1、创建集群文件系统node1 (6)3.1.2、显示集群文件系统 (6)3.2、创建NSD (7)3.2.、使用mmcrnsd创建NSD (7)3.2.2、显示NSD (7)3.3、启动GPFS文件系统 (7)3.4、查看GPFS文件系统状态 (7)3.5、建立文件系统 (7)3.6、检查文件系统 (8)1、GPFS规划在虚拟机上安装2台RedHat 5 linux,系统分配8G硬盘,令每台节点分配2个2G的硬盘具2、GPFS实施2.1、软件需求辅助软件:Vmvare 7.0redhat 5libstdc++compat-libstdc++-296compat-libstdc++-33libXpimakegcc-c++kernelkernel-headerskernel-develkernel-smpkernel-smp-develxorg-x11-xauthGPFS软件需求gpfs.basegpfs.msg.en_USgpfs.docsgpfs.gp2.2软件安装使用rpm –ivh将以上需求安装包在每个节点上装齐2.2.1在每个节点上安装GPFS软件包2.2.1.1Tar -zxcvf解压gpfs-3.1.0-6.x86_64.update.tar.gz生成gpfs.basegpfs.msg.en_USgpfs.docsgpfs.gp2.2.1.2使用rpm安装软件包rpm -ivh gpfs.msg.en_US-3.1.0-6.noarch.rpmrpm -ivh gpfs.docs-3.1.0-6.noarch.rpmrpm -ivh gpfs.gpl-3.1.0-6.noarch.rpmrpm -ivh ---noscripts gpfs.base-3.1.0-6.x86_64.update.rpm2.2.1.3使用rpm -qa|grep gpfs检查GPFS软件安装情况gpfs.base-3.1.0-6gpfs.msg.en_US-3.1.0-6gpfs.docs-3.1.0-6gpfs.gpl-3.1.0-62.2.2、gpfs软件编译2.2.2.1、在每个节点中准备portability layer build#echo 'Red Hat Enterprise Linux Server release 5.3 (Tikanga)' >/etc/redhat-releasecd /usr/lpp/mmfs/srcexport SHARKCLONEROOT=/usr/lpp/mmfs/srcrm config/site.mcrmake Autoconfig2.2.2.2、在每个节点上检查配置文件值与系统环境是否正确grep ^LINUX_DISTRIBUTION config/site.mcrgrep 'define LINUX_DISTRIBUTION_LEVEL' config/site.mcrgrep 'define LINUX_KERNEL_VERSION' config/site.mcr注意:"2061899" 意思是l "2.6.18-128.1.10.el5"2.2.2.3、在每个节点上编译make cleanmake Worldmake InstallImages2.2.3、在每个节点上编译.bashrc文件,建立GPFS命令环境变量On each node, edit the PATH,vi ~/.bashrc添加PATH=$PATH:/usr/lpp/mmfs/bin立即生效source ~/.bashrc2.2.4、创建节点描述文件Vi /tmp/gpfs_node10.3.164.24 node1:quorum-manager10.3.164.25 node2:quorum-manager2.2.5、创建磁盘描述文件/dev/hdb:node1:::1:GPFSNSD12.2.6、创建主机信任文件2.2.6.1、以下命令分别在node1和node2上都执行一遍#mkdir ~/.ssh#chmod 700 ~/.ssh#ssh-keygen -t rsa#ssh-keygen -t dsa2.2.6.2 、在node1上执行以下命令#cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys#cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys#ssh node2 cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys #ssh node2 cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys #scp ~/.ssh/authorized_keys node2:~/.ssh/authorized_keys 2.2.6.3、测试两个节点的连接等效性#ssh node1 date#ssh node2 date2.2.7、确认连接磁盘#fdisk –lDisk /dev/sda: 16.1 GB, 16106127360 bytes255 heads, 63 sectors/track, 1958 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 13 104391 83 Linux/dev/sda2 14 1958 15623212+ 8e Linux LVMDisk /dev/hdb: 2 GB, 2736369664 bytes64 heads, 32 sectors/track, 10239 cylindersUnits = cylinders of 2048 * 512 = 248576 bytes3、GPFS安装3.1、建立集群3.1.1、创建集群文件系统node1mmcrcluster -n /tmp/gpfs_node -p node1 -s node2 -r /usr/bin/ssh -R /usr/bin/scp命令显示:mmcrcluster: Processing node 1mmcrcluster: Processing node2mmcrcluster: Command successfully completedmmcrcluster: Propagating the cluster configuration data to all affected nodes. This is an asynchronous process.3.1.2、显示集群文件系统mmlsclusterGPFS cluster information========================GPFS cluster name: node1GPFS cluster id: 13882348004399855353GPFS UID domain: node1Remote shell command: /usr/bin/sshRemote file copy command: /usr/bin/scpGPFS cluster configuration servers:-----------------------------------Primary server: node1Secondary server:Node Daemon node name IP address Admin node name Designation1 node1 10.3.164.24 node1 quorum-manager2 node2 10.3.164.25 node2 quorum-manager3.2、创建NSD3.2.、使用mmcrnsd创建NSDmmcrnsd -F /tmp/gpfs_disk -v yes命令显示:mmcrnsd: Processing disk hdbmmcrnsd: Propagating the cluster configuration data to allaffected nodes. This is an asynchronous process.3.2.2、显示NSDmmlsnsd –mDisk name NSD volume ID Device Node name Remarks -------------------------------------------------------------------------------gpfs1nsd C0A801F54A9B3732 /dev/hdb node1 primary node gpfs1nsd C0A801F54A9B3732 /dev/hdb node23.3、启动GPFS文件系统mmstartup –aMon Aug 31 10:37:48 CST 2009: mmstartup: Starting GPFS ...3.4、查看GPFS文件系统状态mmgetstate -aNode number Node name GPFS state------------------------------------------1 node1 active2 node2 active3.5、建立文件系统#mkdir /gpfs 建立挂载点#./bin/mmcrfs /gpfs gpfsdev -F /tmp/gpfs_disk -A yes -B 1024K -v yes命令显示:The following disks of gpfsdev will be formatted on node node1:gpfs1nsd: size 2241856 KBFormatting file system ...Disks up to size 2 GB can be added to storage pool 'system'.Creating Inode FileCreating Allocation MapsClearing Inode Allocation MapClearing Block Allocation MapCompleted creation of file system /dev/gpfsdev.mmcrfs: Propagating the cluster configuration data to allaffected nodes. This is an asynchronous process.3.6、检查文件系统#cat /etc/fstab………………………/dev/gpfsdev /gpfs gpfs rw,mtime,atime,dev=gpfsdev,autostart 0 0 Df-g/dev/hdb /gpfs。

PGFS简单搭建

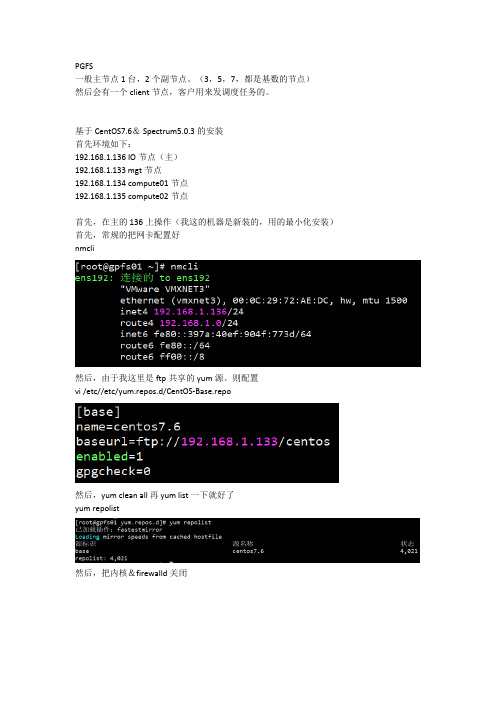

PGFS一般主节点1台,2个副节点。

(3,5,7,都是基数的节点)然后会有一个client节点,客户用来发调度任务的。

基于CentOS7.6& Spectrum5.0.3的安装首先环境如下:192.168.1.136 IO节点(主)192.168.1.133 mgt节点192.168.1.134 compute01节点192.168.1.135 compute02节点首先,在主的136上操作(我这的机器是新装的,用的最小化安装)首先,常规的把网卡配置好nmcli然后,由于我这里是ftp共享的yum源。

则配置vi /etc//etc/yum.repos.d/CentOS-Base.repo然后,yum clean all 再 yum list一下就好了yum repolist然后,把内核&firewalld关闭下面,创建一个gpfs专用的目录,把5.0.3的tar包塞进去mkdir -p /oglab/gpfscd /oglab/gpfs下面做几个域名的映射vi /etc/hosts192.168.1.133 mgt192.168.1.134 c01192.168.1.135 c02192.168.1.136 gpfs01然后,几个节点间建立互信[root@gpfs01 gpfs]# ssh-keygen -t rsa -N '' -f ~/.ssh/id_rsa[root@gpfs01 gpfs]# cat ~/.ssh/id_rsa.pub >>~/.ssh/authorized_keys [root@gpfs01 gpfs]# echo 'StrictHostKeyChecking no' > ~/.ssh/config [root@gpfs01 gpfs]# chmod 644 ~/.ssh/authorized_keys ~/.ssh/config [root@gpfs01 gpfs]# scp -rp ~/.ssh mgt:~/然后,ssh mgt可以直接登录就可以了(其余几个节点也都测试一下)下面,cd /oglab/gpfstar xvf Spectrum_Scale_DAE_503_x86_64_LNX.tar.gzls./Spectrum_Scale_Data_Access-5.0.3.0-x86_64-Linux-install这中间需要同意IBM的协议,按1 enter然后,安装一些必要的依赖包yum -y install kernel-devel cpp gcc gcc-c++ kernel-headers然后,创建一个需要的放安装包的目录/1/mkdir /1/然后,把一些安装需要的包复制到/1下cd /usr/lpp/mmfs/5.0.3.0/gpfs_rpms/然后,下面一步很重要cd /usr/lpp/mmfs/5.0.3.0/zimon_rpms/rhel7/cp .//gpfs.gss.pmcollector-5.0.3-0.el7.x86_64.rpm /1/cd /1/yum install -y gpfs.base*.rpm gpfs.gpl*rpm gpfs.gskit*rpm gpfs.ext*rpm gpfs.adv*rpm gpfs.docs*rpm然后,就可以编译了 /usr/lpp/mmfs/bin/mmbuildgpl安装pgfs完成。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

GPFS for linux实施配置文档(Red Hat linux平台)目录1、GPFS for linux实施规划 (3)1.1 规划概要 (3)1.2 网络设计规划 (4)1.3 存储设计规划 (4)2、Linux的安装及配置 (6)2.1 制作Linux Yum源 (6)2.2使用Linux Yum源安装必备rpm包 (7)2.3Linux系统中添加网络设备 (7)3、GPFS软件的安装和准备工作 (14)3.1 必须安装的Linux RPM包 (14)2.2 软件上传至目的Linux分区 (15)2.3 在每个节点上安装GPFS软件包 (15)2.3.1 GPFS基础包安装 (15)2.3.2 GPFS升级包安装 (16)2.4 GPFS软件编译 (16)2.5 GPFS环境变量设置 (17)4、GPFS环境配置文件准备 (18)4.1、创建节点描述文件 (18)4.2、创建磁盘描述文件 (18)4.3、创建主机信任---SSH (18)4.4、确认连接磁盘 (20)5、GPFS集群配置 (21)5.1、建立集群 (21)5.1.1、创建集群 (21)5.1.2、显示配置信息 (21)5.2、创建NSD (21)5.2.1、使用mmcrnsd创建NSD (21)5.2.2、显示NSD (22)5.3、启动GPFS文件系统 (22)5.4、查看GPFS文件系统状态 (22)5.5、建立文件系统 (22)5.6、检查文件系统 (22)5.7、GPFS集群调优 (22)6、GPFS文件系统测试 (24)6.1文件系统测试 (24)6.2 高可用测试 (25)1、G PFS for linux实施规划随着客户对数据越来越高的要求,现有架构的数据传输的速度可能会在将来成为系统分析性能的瓶颈,为了解决该问题,结合IBM GPFS并行文件系统在海量文件处理方面的算法优势及x86 Linux服务器的处理性能,搭建一套测试GPFS文件系统作为数据平台,来提升数据仓库平台的数据传输性能是一个不错的选择。

本文档主要针对在X86平台上实施GPFS文件系统进行介绍,可供有相关需求的客户参考。

1.1 规划概要本次实施以在10台IBM X3755主机上部署GPFS-FPO为例,安装配置一套10节点的GPFS集群,可用作数据仓库,提供共享文件系统服务。

本次实施相关系统及软件版本:RHEL OS Version:6.3GPFS Version: 3.5.0.13IBM X3755配置情况:CPU:AMD6234, 4 Core*2.4GHz内存:128GB共享存储空间:2T * 6 * 101.2 网络设计规划本次GPFS集群搭建需要两组网络,一组集群通信网络,用于GPFS节点间的信息交互及同步,建议使用高速网络,比如IB网络,可充分发挥GPFS文件系统的高性能;一组管理网络,用于服务器管理,可使用普通IP网络。

GPFS集群通信网络:192.168.0.0/24 (通常为一个单独的私有网络)BI_gpfs01 192.168.0.1BI_gpfs02 192.168.0.2BI_gpfs03 192.168.0.3BI_gpfs04 192.168.0.4BI_gpfs05 192.168.0.5BI_gpfs06 192.168.0.6BI_gpfs07 192.168.0.7BI_gpfs08 192.168.0.8BI_gpfs09 192.168.0.9BI_gpfs10 192.168.0.10服务器管理网络:192.168.1.0/24 (使用客户的生产管理网络)BI_node01 192.168.1.1BI_ node02 192.168.1.2BI_ node03 192.168.1.3BI_ node04 192.168.1.4BI_ node05 192.168.1.5BI_ node06 192.168.1.6BI_ node07 192.168.1.7BI_ node08 192.168.1.8BI_ node09 192.168.1.9BI_ node10 192.168.1.101.3 存储设计规划存储空间规划如下:每个节点使用本地盘创建NSD,节点本身为NSD server。

每个节点有6块裸盘,raid5规划后大小为近10T,规划两个LV,一个LV做metadata pool,一个LV 做data pool。

共6*10块磁盘,每块2 TB2、L inux的安装及配置Linux的安装与配置这里不做过于详细的介绍,就是安装操作系统,此处针对可能会遇到的一下问题做简单说明。

2.1 制作Linux Yum源为了防止后续使用中发现操作系统缺少安装包,此处建议安装完操作系统后将操作系统镜像上传到系统中,制作本地Linux Yum源,当然如果客户现场有配置网络Yum源也行。

下面简单介绍一个制作Yum源的方法,具体有不明白的地方可以百度一下,你就知道。

创建源文件存放的目录#mkdir /home/iso/将光盘文件复制到服务器上的源目录#cp -a /media/* /home/iso/新建一个yum源的响应文件# vi /etc/yum.repos.d/local.repo文件内容如下:[base]name=linux 6baseurl=file:///home/isogpgcheck=0enable=1修改yum源的地址# vi /usr/lib/python2.6/site-packages/yum/yumRepo.py在上面的文件中找到下面这行remote = url + '/' + relative将其改为remote = '/tmp/yum' + relative2.2使用Linux Yum源安装必备rpm包通过使用Yum安装必要的安装包很方便,只需执行yum –y install该命令的具体使用方法可自行查找。

yum -y install make perl rsh ld-linux.so libm.so.6 libc.so.6 ksh libstdc++.so.5yum -y install rsh-server rpcbind xinetd libaio cpp gcc-c++ gcc nfs-utilsyum -y install kernel-headers kernel-devel compat-libstdc++ glibc-devel libXp.so.6 imake rpm-buildyum -y install compat-libstdc*2.3Linux系统中添加网络设备在linux系统中,由于某种原因造成网络设备丢失,或者我们新添加一个网卡,系统启动后可能查看不到新加网卡的状态,此时需要人工添加新的网络设备。

以新加一个IB卡为例:方法1、可以通过setup->network configuration->device configuration->new device->添加一个网络设备。

例如我们添加了一个ib0网络设备,IP设置为192.168.0.1。

通过以下步骤:则在/etc/sysconfig/network-scripts/下会产生一个ifcfg-ib0的配置文件,文件内容如下:DEVICE=ib0BOOTPROTO=noneNETMASK=255.255.255.0TYPE=EthernetHWADDR=a0:00:01:00:fe:80:00:00:00:00:00:00:00:02:C9:03:00:57:2F:1FIPADDR=192.168.0.1ONBOOT=yesIPV6INIT=noUSERCTL=nonote:这里HWADDR需要手动更改,查看ib0的HWADDR方法可以使用ifconfig ib0 或者ifdown ib0来查看。

ONBOOT=yes代表开机该设备会自动挂起,否则需要手动挂起。

2.4Linux系统中用户与组的操作Linux 系统中添加用户及组,删除用户及组,以及修改用户或组的属性,使用命令如下:useradd使用时可使用man查看用法,比如:-u 设置uid,-g 设置gid等,在集群环境中,uid和gid需保持一致。

groupaddusermod -n (更改用户名)-u (更改uid)-g (更改gid)usernamegroupmod -n (更改组名)-g(更改gid)groupname最好是在创建用户或组之前做好规划,uid,gid,名称,home目录等,以免造成后来有冲突。

特别是在集群环境中。

2.5Linux系统中ACL简单介绍在安全管理日益重要的今天,传统的Unix 文件系统的UGO 权限管理方式已经无法满足日常系统管理工作的需要。

而ACL 机制逐渐成为主流的权限管理方式。

通常情况下,UGO可以满足权限要求,特殊情况下才需要通过ACL进行扩展管理,所谓ACL,就是Access Control List,一个文件/目录的访问控制列表,可以针对任意指定的用户/组分配RWX权限。

现在主流的商业Unix系统都支持ACL。

下面举一个简单的例子,来学习一下ACL的使用方法:1、ACL的基本操作:添加和修改首先新建一个文件作为实施ACL的对象:[root@BI_gpfs01 gpfs]# touch testacl[root@BI_gpfs01 gpfs]# lltotal 0-rw-r--r-- 1 root root 0 Mar 20 13:18 testacl然后看一下这个文件缺省的ACL,这时这个文件除了通常的UGO的权限之外,并没有ACL:[root@BI_gpfs01 gpfs]# getfacl testacl# file: testacl# owner: root# group: rootuser::rw-group::r--other::r--通过setfacl命令可以设置文件的ACL,如下:setfacl -m u:testu1:rw testacl这条命令就给testacl文件增加了一条ACL,是的用户testu1对该文件具有读写权限。

此时再查看testacl的ACL,可观察到如下显示:[root@BI_gpfs01 gpfs]#getfacl testacl# file: testacl# owner: root# group: rootuser::rw-user:testu1:rw-group::r--mask::rw-other::r-此时我们使用ls命令查看会发现:[root@BI_gpfs01 gpfs]#ls -l testacl-rw-rw-r--+ 1 root root 0 Mar 20 13:32 testacl可以看到那个"+"了么?就在通常我们看到的权限位的旁边。