大数据实验分析报告

大数据日志分析实验报告

大数据日志分析实验报告大数据实验报告一、实验目的和要求(1)掌握Oracle数据库效劳器的安装与配置。

(2)了解如何检查安装后的数据库效劳器产品,验证安装是否成功。

(3)掌握Oracle数据库效劳器安装过程中出现的问题的解决方法。

(4)完成Oracle 11g数据库客户端网路效劳名的配置。

(5)检查安装后的数据库效劳器产品可用性。

(6)解决Oracle数据库效劳器安装过程中出现的问题。

二、实验设备、环境设备:奔腾IV或奔腾IV以上计算机环境:WINDOWS、7 ORACLE 11g中文版三、实验步骤(1)从Oracle官方下载与操作系统匹配的Oracle 11g数据库效劳器和客户机安装程序。

(2)解压Oracle 11g数据库效劳器安装程序,进展数据库效劳器软件的安装。

(3)在安装数据库效劳器的同时,创立一个名为BOOKSALES数据库。

(4)安装完数据库效劳器程序后,解压客户机程序,并进展客户机的安装。

(5)安装完客户机程序后,启动客户机的“Net Configuration Assistant",进展本地NET效劳名配置,将数据库效劳器中的BOOKSALES 数据库配置到客户端。

(6)启动OEM管理工具,登录、查看、操作BOOKSALES数据库。

(7)启动SQL Plus工具,分别以SYS用户和SYSTEM用户登录BOOKSALES数据库。

三、实验步骤(1)向BOOKSALES数据库的USERS表空间添加一个大小为10MB的数据文件users02(2)向BOOKSALES数据库的TEMP表空间添加一个大小为10MB的临时数据文件temp02.(3)向BOOKSALES数据库的间中添加一个可以自动扩展的数据文件user03大小5M,每次扩展IM,最大容量为100M.(4)取消BOOKSALES数据库数据文件user03.的自动扩展。

(5)将BOOKSALES数据库数据文件users02.更名为users002.(6)查询BOOKSALES数据库当前所有的数据文件的详细信息。

DEEP大数据分析实验报告

DEEP大数据分析实验报告2022 年9 月12 日专业电子商务班级学号姓名成绩实验DEEP大数据分析实验项目DEEP大数据分析指导教师名称一、实验目的培养数据思维,建立基本的数据能力。

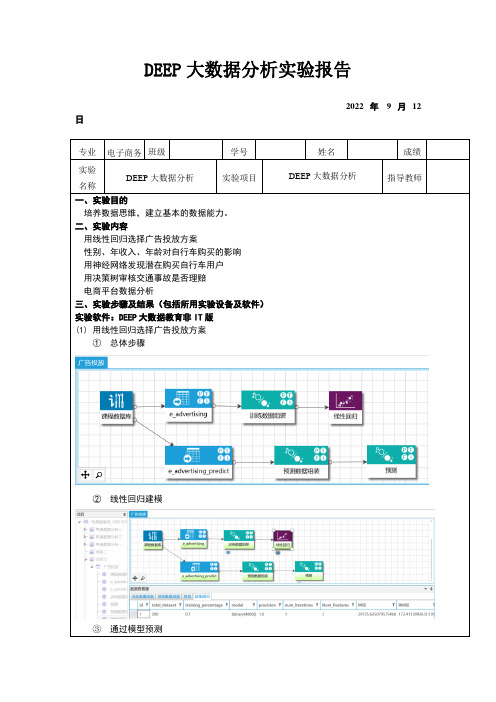

二、实验内容用线性回归选择广告投放方案性别、年收入、年龄对自行车购买的影响用神经网络发现潜在购买自行车用户用决策树审核交通事故是否理赔电商平台数据分析三、实验步骤及结果(包括所用实验设备及软件)实验软件:DEEP大数据教育非IT版(1)用线性回归选择广告投放方案①总体步骤②线性回归建模③通过模型预测(2)性别、年收入、年龄对自行车购买的影响①性别、年收入是否影响购买可以看出,男性和女性购买自行车的数量都没要显著差异,因此可以任务性别这个因素基本上对购买自行车的行为不产生影响。

②客户年龄离散化③年龄是否影响购买从图中可以看出,各个年龄段的总人数和购买者有着明显的差异,33岁到63岁之间人群是购买自行车的主力。

(3)用神经网络发现潜在购买自行车用户在图中,predict列的1表示需要购买自行车。

这样,可以对需要购买自行车的人员进行精准营销。

(4)用决策树审核交通事故是否理赔①计算相关系数②使用决策树审核其中“col_1”是预测结果,0表示理赔,1表示不理赔。

(5)电商平台数据分析母婴电商数据分析可视化仪表盘用户行为分析四、问题讨论及实验心得大数据全链路处理工作流程一般包括六个步骤:数据源、数据汇集、数据湖、数据加工、分析挖掘、数据可视化。

数据源是指原始数据的最初来源,它存贮在企业不同业务部门之间的。

数据汇集是指根据业务目标,把这些不同部门之间原始数据进行整合,转化为容易分析的统一存储格式进行存储的过程。

数据湖是指把数据汇集结果集中存贮起来,以便后续分析挖掘。

这种方式极大的方便用户对数据进行分析和利用。

数据加工是指对数据湖中的数据进行诸如去重、处理空值、数据降维、数据标准化等数据预处理过程,其工作量一般占整个流程的大约60%。

数据分析及优化实验报告(3篇)

第1篇一、实验背景随着大数据时代的到来,数据分析已成为各个行业提高效率、优化决策的重要手段。

本实验旨在通过实际案例分析,运用数据分析方法对某一特定数据集进行深入挖掘,并提出相应的优化策略。

本实验选取了一个典型的电商数据集,通过对用户行为数据的分析,旨在提高用户满意度、提升销售业绩。

二、实验目的1. 熟练掌握数据分析的基本流程和方法。

2. 深入挖掘用户行为数据,发现潜在问题和机会。

3. 提出针对性的优化策略,提升用户满意度和销售业绩。

三、实验内容1. 数据收集与预处理实验数据来源于某电商平台,包含用户购买行为、浏览记录、产品信息等数据。

首先,对数据进行清洗,去除缺失值、异常值,确保数据质量。

2. 数据探索与分析(1)用户画像分析通过对用户性别、年龄、地域、职业等人口统计学特征的统计分析,绘制用户画像,了解目标用户群体特征。

(2)用户行为分析分析用户浏览、购买、退货等行为,探究用户行为模式,挖掘用户需求。

(3)产品分析分析产品销量、评价、评分等数据,了解产品受欢迎程度,识别潜力产品。

3. 数据可视化运用图表、地图等可视化工具,将数据分析结果直观展示,便于理解。

四、实验结果与分析1. 用户画像分析通过分析,发现目标用户群体以年轻女性为主,集中在二线城市,职业以学生和白领为主。

2. 用户行为分析(1)浏览行为分析用户浏览产品主要集中在首页、分类页和搜索页,其中搜索页占比最高。

(2)购买行为分析用户购买产品主要集中在促销期间,购买产品类型以服饰、化妆品为主。

(3)退货行为分析退货率较高的产品主要集中在服饰类,主要原因是尺码不合适。

3. 产品分析(1)销量分析销量较高的产品主要集中在服饰、化妆品、家居用品等类别。

(2)评价分析用户对产品质量、服务、物流等方面的评价较好。

五、优化策略1. 提升用户体验(1)优化搜索功能,提高搜索准确度。

(2)针对用户浏览行为,推荐个性化产品。

(3)加强客服团队建设,提高用户满意度。

思问实验数据分析报告(3篇)

第1篇一、实验背景与目的随着大数据时代的到来,数据分析已经成为科学研究、商业决策、社会管理等领域不可或缺的工具。

本实验旨在通过实际操作,使学生掌握数据分析的基本方法,提高数据挖掘和分析能力。

本次实验以“思问”平台上的用户数据为例,通过对数据的清洗、探索、建模和分析,探讨用户行为特征,为平台优化和个性化推荐提供数据支持。

二、实验数据来源与预处理1. 数据来源本次实验数据来源于“思问”平台,包括用户的基本信息(如性别、年龄、地区)、用户行为数据(如浏览记录、提问记录、回答记录)以及用户评价数据。

2. 数据预处理(1)数据清洗:对原始数据进行检查,去除重复、缺失、异常值等无效数据。

(2)数据转换:将部分数据转换为适合分析的格式,如将性别、地区等分类变量转换为数值型变量。

(3)数据归一化:对数值型变量进行归一化处理,消除量纲影响。

三、数据分析方法1. 描述性统计对用户的基本信息、行为数据以及评价数据进行描述性统计,包括均值、标准差、最大值、最小值等,以了解数据的基本特征。

2. 探索性数据分析(1)用户行为分析:分析用户浏览、提问、回答等行为特征,如浏览时长、提问频率、回答质量等。

(2)用户评价分析:分析用户对平台、内容、其他用户的评价,如满意度、好评率等。

3. 相关性分析分析用户基本信息、行为数据以及评价数据之间的相关性,如年龄与提问频率、浏览时长与回答质量等。

4. 聚类分析将用户按照行为特征进行聚类,以发现不同用户群体,为个性化推荐提供依据。

5. 关联规则挖掘挖掘用户行为数据中的关联规则,如“浏览了A内容,通常也会浏览B内容”。

四、实验结果与分析1. 描述性统计(1)用户基本信息:男性用户占比65%,女性用户占比35%;用户年龄主要集中在18-35岁;用户地区分布较为均匀。

(2)用户行为数据:平均浏览时长为15分钟,平均提问频率为3次/月,平均回答质量为4.5分(满分5分)。

(3)用户评价数据:用户满意度为85%,好评率为90%。

大数据基础实验报告 -回复

大数据基础实验报告-回复一、实验目的本实验旨在通过探索大数据基础知识,并在实际操作中理解和应用这些知识,提高对大数据的理解和应用能力。

二、实验背景随着信息时代的到来,大数据成为一个热门的话题。

大数据是指规模巨大、高速流动且多样的数据集合,对于传统的数据处理方法和工具来说,无法处理和分析这些数据。

因此,为了能够更好地利用大数据,我们需要掌握大数据的基础知识。

三、实验过程及结果1. 了解大数据的概念首先,我们需要了解什么是大数据。

大数据通常具备以下特点:数据量大、数据速度快、数据类型多样。

了解了大数据的概念后,我们可以进一步探索大数据的发展和应用领域。

2. 学习大数据的基础技术在学习大数据的基础技术之前,我们需要了解大数据处理的挑战和难点。

由于大数据的规模巨大和数据类型多样,传统的数据处理方法和工具无法快速高效地处理这些数据。

因此,我们需要学习一些适用于大数据处理的技术,如分布式计算、并行计算、数据挖掘等。

3. 掌握大数据处理工具为了能够处理大数据,我们需要掌握一些大数据处理工具。

常见的大数据处理工具包括Hadoop、Spark、Flink等。

通过学习和实践,我们可以理解这些工具的原理和使用方法,并在实际操作中应用这些工具进行大数据处理和分析。

4. 进行大数据实验为了更好地理解和应用大数据知识,我们需要进行一些实验。

可以选择一些实际的大数据场景,如电商数据分析、社交媒体数据分析等,并使用所学的大数据处理工具进行数据处理和分析。

通过实验,我们可以进一步加深对大数据的理解和应用能力。

五、实验总结通过这次实验,我掌握了大数据的基础知识,并学习了大数据处理的基础技术和工具。

在实际的操作中,我运用所学的知识进行了大数据处理和分析,并解决了实际问题。

通过这个实验,我深刻理解了大数据对于传统的数据处理方法和工具的挑战,也认识到了大数据的巨大潜力和应用前景。

希望在未来的学习和工作中,我能够进一步深入研究和应用大数据,为社会和经济发展做出更大的贡献。

大数据统计实践实训报告(2篇)

第1篇一、实训背景与目的随着信息技术的飞速发展,大数据时代已经到来。

大数据以其海量、多样、快速、复杂等特点,对各个行业产生了深远的影响。

为了使我国高校学生更好地适应这一发展趋势,提高学生的数据分析能力,我校特开设了大数据统计实践实训课程。

本次实训旨在通过实际操作,让学生掌握大数据处理的基本方法,提高数据统计分析能力,为今后从事相关领域工作打下坚实基础。

二、实训内容与方法本次实训主要包括以下内容:1. 数据采集与预处理:学习如何从各种渠道获取数据,了解数据预处理的基本方法,包括数据清洗、数据整合等。

2. 数据存储与管理:学习使用Hadoop、Spark等大数据存储与管理工具,了解分布式存储架构。

3. 数据挖掘与分析:学习使用Python、R等编程语言进行数据挖掘与分析,掌握常用的数据挖掘算法。

4. 可视化展示:学习使用Tableau、ECharts等工具进行数据可视化展示,提高数据表达效果。

实训过程中,我们采用了以下方法:1. 理论教学与实践操作相结合:在理论教学的基础上,通过实际操作使学生更好地理解和掌握相关知识。

2. 小组合作学习:将学生分为若干小组,共同完成实训项目,培养学生的团队协作能力。

3. 案例分析与实战演练:通过分析实际案例,使学生了解大数据在各个领域的应用,提高解决实际问题的能力。

三、实训过程与成果1. 数据采集与预处理:我们选取了电商、社交网络等领域的公开数据集,通过数据清洗、整合等方法,为后续分析做好准备。

2. 数据存储与管理:我们使用Hadoop分布式文件系统(HDFS)存储数据,并利用Hive进行数据查询与分析。

3. 数据挖掘与分析:我们使用Python进行数据挖掘与分析,实现了用户行为分析、商品推荐等应用。

4. 可视化展示:我们使用Tableau进行数据可视化展示,将分析结果以图表形式呈现,便于理解和传播。

经过一段时间的实训,我们取得了以下成果:1. 掌握了大数据处理的基本方法:通过实训,我们熟悉了Hadoop、Spark等大数据存储与管理工具,掌握了数据清洗、整合、挖掘等基本方法。

大数据导论实验报告

大数据导论实验报告1. 实验目的本次实验旨在通过使用大数据处理框架,掌握大数据处理的基本概念和技术。

2. 实验环境- 操作系统:Ubuntu 18.04- 处理器:Intel Core i5 2GHz- 内存:8GB- 大数据处理框架:Apache Hadoop3. 实验过程3.1 数据准备我们选择了一个包含一百万条学生信息的数据集,数据集中包含学生的姓名、年龄、性别和成绩等信息。

这个数据集被存储在一个文本文件中,文件大小约为200MB。

3.2 Hadoop集群搭建为了进行大数据处理,我们需要先搭建一个Hadoop集群。

在我们的实验环境中,我们使用了3台虚拟机来搭建一个Hadoop集群。

其中一台作为主节点,另外两台作为从节点。

在搭建集群之前,我们需要确保每台虚拟机之间可以互相访问,并且已经正确配置了SSH免密登录。

开始搭建Hadoop集群之前,我们需要先下载并解压Hadoop的安装包,并进行配置。

我们修改了Hadoop的配置文件,设置了主节点和从节点的IP地址,并指定了数据存储的路径。

之后,我们在主节点上启动Hadoop集群,通过命令行输入以下命令:start-dfs.sh 启动分布式文件系统start-yarn.sh 启动资源管理器3.3 数据处理在搭建好Hadoop集群之后,我们可以开始进行数据处理了。

我们的目标是统计学生的平均成绩。

首先,我们需要将数据文件上传到Hadoop集群的文件系统中。

我们使用以下命令将文件复制到Hadoop集群中:hdfs dfs -copyFromLocal /path/to/students.txt /input/students.txt接下来,我们使用Hadoop提供的MapReduce框架来进行数据处理。

我们编写了两个Java类,分别是`StudentMapper`和`AverageReducer`。

`StudentMapper`用于将学生信息进行映射,而`AverageReducer`用于计算平均成绩。

大数据分析实验报告(3篇)

第1篇一、实验背景随着互联网技术的飞速发展,数据已经成为现代社会的重要资源。

大数据分析作为一种新兴的技术手段,通过对海量数据的挖掘和分析,为企业、政府和研究机构提供了决策支持。

本实验旨在通过实际操作,掌握大数据分析的基本流程和方法,提高对大数据技术的理解和应用能力。

二、实验目的1. 熟悉大数据分析的基本流程。

2. 掌握常用的数据预处理方法。

3. 熟悉大数据分析工具的使用。

4. 能够对实际数据进行有效的分析和解读。

三、实验环境1. 操作系统:Windows 102. 数据库:MySQL 5.73. 编程语言:Python 3.74. 大数据分析工具:Pandas、NumPy、Matplotlib、Scikit-learn5. 云计算平台:阿里云四、实验内容(一)数据采集本实验选取某电商平台的用户购买数据作为分析对象,数据包含用户ID、购买时间、商品ID、商品类别、购买金额等字段。

(二)数据预处理1. 数据清洗:去除重复数据、处理缺失值、修正错误数据。

2. 数据转换:将时间戳转换为日期格式,对金额进行归一化处理。

3. 特征工程:提取用户购买行为特征,如购买频率、购买金额等。

(三)数据分析1. 用户画像:分析用户购买偏好、购买频率等特征。

2. 商品分析:分析商品销量、商品类别分布等特征。

3. 购买行为分析:分析用户购买时间分布、购买金额分布等特征。

(四)实验结果与分析1. 用户画像分析根据用户购买数据,我们可以得出以下结论:(1)年轻用户购买频率较高,偏好时尚、电子产品等商品。

(2)中年用户购买金额较高,偏好家居、家电等商品。

(3)老年用户购买频率较低,偏好健康、养生等商品。

2. 商品分析根据商品购买数据,我们可以得出以下结论:(1)电子产品销量最高,其次是家居、家电等商品。

(2)商品类别分布较为均匀,但电子产品、家居、家电等类别占比相对较高。

3. 购买行为分析根据购买时间、购买金额等数据,我们可以得出以下结论:(1)用户购买时间主要集中在上午10点到下午6点。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

大数据实验报告————————————————————————————————作者:————————————————————————————————日期:课程实验报告专业年级14级软件工程课程名称大数据技术原理与应用指导教师李均涛学生姓名吴勇学号20142205042026 实验日期2017.05.04实验地点笃行楼B栋301实验成绩教务处制2017年03月09日实验项目名称Liunx基本操作实验目的及要求1.了解Liunx操作系统发展历史。

2.学习Liunx操作系统基本概念及操作。

3.学习Liunx操作系统用户及文件权限管理。

4.Linux 目录结构及文件基本操作。

实验内容1.实验楼环境介绍,常用 Shell 命令及快捷键,Linux 使用小技巧。

2.Linux 中创建、删除用户,及用户组等操作。

Linux 中的文件权限设置。

3.Linux 的文件组织目录结构,相对路径和绝对路径,对文件的移动、复制、重命名、编辑等操作。

实验步骤1.Liunx输入输出命令。

2.使用touch命令创建文件夹,后缀都为txt。

3.学会在命令行中获取帮助。

4.输出图形字符。

5.查看用户。

6.创建新用户。

7.删除用户。

8.查看文件权限。

9.用ls –A/Al/dl/AsSh查看文件。

10.变更文件所有者。

11.修改文件权限。

12.目录路径。

13.新建空白文件。

14.文件的复制、删除、移动、重命名。

实验环境Liunx 操作系统实验结果与分析通过学习Liunx操作系统的发展历史、基本操作、用户及文件权限管理以及Linux 目录结构及文件基本操作。

是得我大致了解Liunx操作系统的使用,并且能够完成相应的练习。

教师评语注:可根据实际情况加页课程实验报告专业年级14级软件工程课程名称大数据技术原理与应用指导教师李均涛学生姓名吴勇学号20142205042026 实验日期2017.05.04实验地点笃行楼B栋301实验成绩教务处制2017年03月09日实验项目名称Hadoop的基本操作实验目的及要求1.Hadoop单机模式安装.2.Hadoop伪分布模式配置部署.3.Hadoop介绍及1.X伪分布式安装.4.adoop2.X 64位编译.5.Hadoop2.X 64位环境搭建.实验内容1.hadoop三种安装模式介绍,hadoop单机模式安装,测试安装2.hadoop配置文件介绍及修改,hdfs格式化,启动hadoop进程,验证安装.3.Hadoop1.X伪分布安装, Hadoop介绍,Hadoop变量配置.4.Hadoop2.X 64位编译, 编译Hadoop2.X 64位, 编译Hadoop.5.搭建环境,部署Hadooop2.X,启动Hadoop.实验步骤1.用户及用户组,添加用户及用户组,添加sudo权限.2.安装及配置依赖的软件包,安装openssh-server、java、rsync等,配置ssh免密码登录.3.下载并安装Hadoop, 下载Hadoop 2.6.0, 解压并安装, 配置Hadoop.4.测试验证.5.相关配置文件修改:修改core-site.xml:6.格式化HDFS文件系统.7.Hadoop集群启动.8.测试验证.9.设置Host映射文件.10.下载并解压hadoop安装包11.在Hadoop-1.1.2目录下创建子目录.12.启动hadoop.13. 编译Hadoop2.X 64位.14.使用yum安装sun.15. 部署Hadooop2.X.与Hadoop1.X类似。

实验环境hadoop Xfce终端实验结果与分析通过本次实验,让我对Hadoop有所了解,但是在实验过程中出现许多问题。

例如,不知道该如何下载java jdk,甚至如何创建文件夹目录下的文件,以及Hadoop的环境配置原理以及编译原理和方法。

这些都是实验中出现的问题,但是通过自己查询,问同学,部分问题已经得到解决,但是还存在一部分就只能通过课后自学进行解决!!!通过上述的学习,让我对Hadoop的基本操作有了基础的掌握,包括Hadoop介绍及1.X伪分布式安装,adoop2.X 64位编译,Hadoop2.X 64位环境搭建等。

教师评语注:可根据实际情况加页课程实验报告专业年级14级软件工程课程名称大数据技术原理与应用指导教师李均涛学生姓名吴勇学号20142205042026 实验日期2017.06.01实验地点笃行楼B栋301实验成绩教务处制2017年03月09日实验项目名称HDFS和MapReduce实验目的及要求1.HDFS原理及操作。

2.MapReduce原理及操作。

实验内容1.HDFS原理及操作。

环境说明,HDFS原理,HDFS架构,HDFS读操作,HDFS写操作,测试例子2.MapReduce原理及操作。

环境说明,MapReduce原理,Map过程,Reduce过程,测试例子实验步骤1.HDFS原理及操作。

1.1 环境说明。

虚拟机操作系统: CentOS6.6 64位,单核,1G内存JDK:1.7.0_55 64位Hadoop:1.1.21.2HDFS原理。

HDFS(Hadoop Distributed File System)是一个分布式文件系统,是谷歌的GFS山寨版本。

它具有高容错性并提供了高吞吐量的数据访问,非常适合大规模数据集上的应用,它提供了一个高度容错性和高吞吐量的海量数据存储解决方案。

1.3HDFS架构。

HDFS是Master和Slave的结构,分为NameNode、Secondary NameNode和DataNode三种角色。

1.4HDFS读操作。

客户端通过调用FileSystem对象的open()方法来打开希望读取的文件。

1.5HDFS写操作。

客户端通过调用DistributedFileSystem的create()方法创建新文件。

1.6测试例子1。

1.创建代码目录2. 建立例子文件上传到HDFS中3.配置本地环境4.编写代码5.编译代码6.使用编译代码读取HDFS文件2. MapReduce原理及操作。

2.1环境说明。

虚拟机操作系统: CentOS6.6 64位,单核,1G内存JDK:1.7.0_55 64位Hadoop:1.1.22.2MapReduce原理。

Map 和Reduce。

当你向MapReduce 框架提交一个计算作业时,它会首先把计算作业拆分成若干个Map 任务,然后分配到不同的节点上去执行,每一个Map 任务处理输入数据中的一部分,当Map 任务完成后,它会生成一些中间文件,这些中间文件将会作为Reduce 任务的输入数据。

Reduce 任务的主要目标就是把前面若干个Map 的输出汇总到一起并输出。

2.3Map过程。

每个输入分片会让一个map任务来处理,默认情况下,以HDFS的一个块的大小(默认为64M)为一个分片,当然我们也可以设置块的大小。

map输出的结果会暂且放在一个环形内存缓冲区中(该缓冲区的大小默认为100M,由io.sort.mb属性控制),当该缓冲区快要溢出时(默认为缓冲区大小的80%,由io.sort.spill.percent属性控制),会在本地文件系统中创建一个溢出文件,将该缓冲区中的数据写入这个文件。

2.4Reduce过程。

Reduce会接收到不同map任务传来的数据,并且每个map传来的数据都是有序的。

如果reduce端接受的数据量相当小,则直接存储在内存中(缓冲区大小由mapred.job.shuffle.input.buffer.percent属性控制,表示用作此用途的堆空间的百分比),如果数据量超过了该缓冲区大小的一定比例(由mapred.job.shuffle.merge.percent决定),则对数据合并后溢写到磁盘中。

2.5测试例子。

1.编写代码。

2.编译代码。

3.打包编译文件。

4.解压气象数据并上传到HDFS中。

5. 运行程序。

6. 查看结果。

实验环境虚拟机操作系统: CentOS6.6 64位,单核,1G内存JDK:1.7.0_55 64位Hadoop:1.1.2实验结果与分析实验分析:通过学习HDFS和MapReduce,了解其原理及操作,但是在实验过程中遇到很多问题,例如无法启动Hadoop、无法连接到Hadoop等问题,通过自己请教老师、同学以及网上自己动手查阅资料得以解决。

明白其工作原理,从而进一步了解到Hadoop的运行机制与操作,更加了解大数据。

教师评语注:可根据实际情况加页。