信息论与编码技术思考题与习题(1-2)

信息论与编码习题解答

信息论与编码习题解答信息论与编码习题解答第⼀章1.⼀位朋友很不赞成“通信的⽬的是传送信息”及“消息中未知的成分才算是信息”这些说法。

他举例说:我多遍地欣赏梅兰芳⼤师的同⼀段表演,百看不厌,⼤师正在唱的正在表演的使我愉快,将要唱的和表演的我都知道,照你们的说法电视⾥没给我任何信息,怎么能让我接受呢?请从信息论的⾓度对此做出解释。

(主要从狭义信息论与⼴义信息论研究的内容去理解和解释)答:从狭义信息论⾓度,虽然将要表演的内容观众已知,但是每⼀次演出不可能完全相同。

⽽观众在欣赏的同时也在接受着新的感官和视听享受。

从这⼀⾓度来说,观众还是可以得到新的信息的。

另⼀种解释可以从⼴义信息论的⾓度来分析,它涉及了信息的社会性、实⽤性等主观因素,同时受知识⽔平、⽂化素质的影响。

京剧朋友们在欣赏京剧时也因为主观因素⽽获得了享受,因此属于⼴义信息论的范畴。

2.利⽤下图(图1.2)所⽰的通信系统分别传送同样时间(例如⼗分钟)的重⼤新闻公告和轻⾳乐,它们在接收端各⽅框的输⼊中所含的信息是否相同,为什么?图1.2 通信系统的⼀般框图答:重⼤新闻是语⾔,频率为300~3400Hz,⽽轻⾳乐的频率为20~20000Hz。

同样的时间内轻⾳乐的采样编码的数据要⽐语⾳的数据量⼤,按码元熵值,⾳乐的信息量要⽐新闻⼤。

但是在信宿端,按信息的不确定度,信息量就应分别对待,对于新闻与⾳乐的信息量⼤⼩在⼴义上说,因⼈⽽异。

第⼆章1.⼀珍珠养殖场收获240颗外观及重量完全相同的特⼤珍珠,但不幸被⼈⽤外观相同但重量仅有微⼩差异的假珠换掉1颗。

(1)⼀⼈随⼿取出3颗,经测量恰好找出了假珠,问这⼀事件⼤约给出了多少⽐特的信息量;(2)不巧假珠⼜滑落进去,那⼈找了许久却未找到,但另⼀⼈说他⽤天平最多6次能找出,结果确是如此,问后⼀事件给出多少信息量;(3)对上述结果作出解释。

解:(1)从240颗珍珠中取3颗,其中恰好有1颗假珠的概率为:22393240239!2!237!240!3!237!11/80240/3C P C====所以,此事件给出的信息量为:I = – log 2P = log 280=6.32 (bit)(2)240颗中含1颗假珠,⽤天平等分法最多6次即可找到假珠,这是⼀个必然事件,因此信息量为0。

《信息论与编码》部分课后习题参考答案

若知道是星期几,则从别人的答案中获得的信息量为 0。 2.3 每帧电视图像可以认为是 3*10^5 个像素构成,所有像素均独立变化,且每一像素又取 128 个不同的亮度电平,并设亮度电平等概率出现。问每帧图像喊多少信息量?如果一个广 播员在约 10000 个汉字的字汇中选取 1000 个字来口述此电视图像,试问广播员描述此图像 所广播的信息量是多少(假设汉字字汇是等概率分布,并且彼此独立)?若要恰当地描述此 图像,广播员在口述中至少需用多少汉字? 答:由于每一象素取 128 个不同的亮度电平,各个亮度电平等概率出现。因此每个亮度电平 包含的信息量为 I(X) = – lb(1/128)=lb128=7 bit/像素 每帧图像中像素均是独立变化的, 因此每帧图像信源就是离散亮度电平信源的无记忆 N 次扩展。由此,每帧图像包含的信息量为 I(XN) = NI(X)= 3×105×7 =2.1×106 bit/帧 广播员在约 10000 个汉字中选取字汇来口述此电视图像, 各个汉字等概分布, 因此每个 汉字包含的信息量为 I(Y) = – lb(1/10000)=lb1000=13.29 bit/ 字 广播员述电视图像是从这个汉字字汇信源中独立地选取 1000 个字进行描述,因此广播 员描述此图像所广播的信息量是 I(YN) = NI(Y)= 1000×13.29 =1.329 ×104 bit/字 由于口述一个汉字所包含的信息量为 I(Y),而一帧电视图像包含的信息量是 I(XN),因此 广播员要恰当地描述此图像,需要的汉字数量为:

《信息论与编码》

部分课后习题参考答案

1.1 怎样理解消息、信号和信息三者之间的区别与联系。 答:信号是一种载体,是消息的物理体现,它使无形的消息具体化。通信系统中传输的是 信号。 消息是信息的载体, 信息是指消息中包含的有意义的内容, 是消息中的未知成分。 1.2 信息论的研究范畴可以分成哪几种,它们之间是如何区分的? 答:信息论的研究范畴可分为三种:狭义信息论、一般信息论、广义信息论。 1.3 有同学不同意“消息中未知的成分才算是信息”的说法。他举例说,他从三岁就开始背 诵李白诗句“床前明月光,疑是地上霜。举头望明月,低头思故乡。 ” ,随着年龄的增长, 离家求学、远赴重洋,每次读到、听到这首诗都会带给他新的不同的感受,怎么能说这 些已知的诗句没有带给他任何信息呢?请从广义信心论的角度对此现象作出解释。 答:从广义信息论的角度来分析,它涉及了信息的社会性、实用性等主观因素,同时受知识 水平、文化素质的影响。这位同学在欣赏京剧时也因为主观因素而获得了享受,因此属于广 义信息论的范畴。

信息论与编码习题参考答案(全)

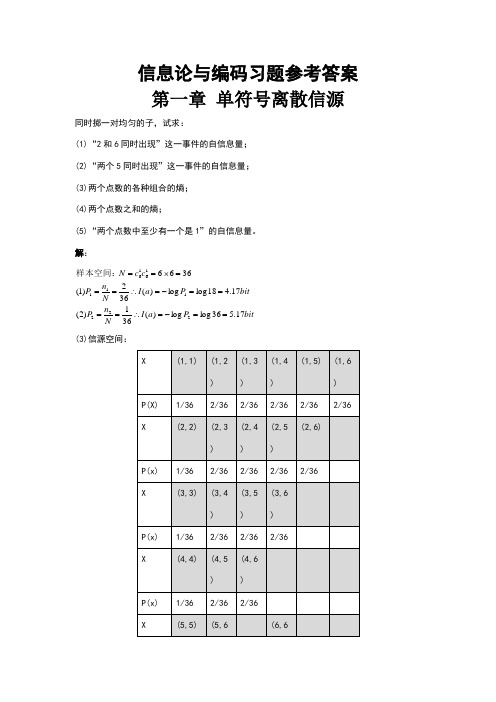

信息论与编码习题参考答案 第一章 单符号离散信源同时掷一对均匀的子,试求:(1)“2和6同时出现”这一事件的自信息量; (2)“两个5同时出现”这一事件的自信息量; (3)两个点数的各种组合的熵; (4)两个点数之和的熵;(5)“两个点数中至少有一个是1”的自信息量。

解:bitP a I N n P bit P a I N n P c c N 17.536log log )(361)2(17.418log log )(362)1(36662221111616==-=∴====-=∴===⨯==样本空间:(3)信源空间:bit x H 32.436log 3616236log 36215)(=⨯⨯+⨯⨯=∴ (4)信源空间:bitx H 71.3636log 366536log 3610 436log 368336log 366236log 36436log 362)(=⨯⨯+⨯+⨯+⨯⨯=∴++ (5) bit P a I N n P 17.11136log log )(3611333==-=∴==如有6行、8列的棋型方格,若有两个质点A 和B ,分别以等概落入任一方格内,且它们的坐标分别为(Xa ,Ya ), (Xb ,Yb ),但A ,B 不能同时落入同一方格内。

(1) 若仅有质点A ,求A 落入任一方格的平均信息量; (2) 若已知A 已落入,求B 落入的平均信息量; (3) 若A ,B 是可辨认的,求A ,B 落入的平均信息量。

解:bita P a P a a P a I a P A i 58.548log )(log )()(H 48log )(log )(481)(:)1(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率bitb P b P b b P b I b P A i 55.547log )(log )()(H 47log )(log )(471)(:B ,)2(481i i i i i ==-=∴=-=∴=∑=落入任一格的概率是落入任一格的情况下在已知bitAB P AB P AB H AB P AB I AB P AB i i i i i i i 14.11)4748log()(log )()()(log )(471481)()3(47481=⨯=-=-=∴⨯=∑⨯=是同时落入某两格的概率从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为%.如果你问一位男士:“你是否是红绿色盲”他的回答可能是:“是”,也可能“不是”。

信息论与编码第二章(1、2节)

第二章:信源与信源熵

2.1 信源的描述与分类

信源的统计特性

1)什么是信源?

信源是信息的来源,实际通信中常见的信源有:语音、 文字、图像、数据…。在信息论中,信源是产生消息 (符号)、消息(符号)序列以及连续消息的来源, 数学上,信源是产生 随机变量 U, 随机序列 U和 随机 过程U(t,ω)的源。

联合熵、条件熵的关系:

H(XY) = H(X) + H(Y / X) = H(Y) + H(X / Y)

当X,Y相互独立时,有:

p(ak , bj ) = p(ak ) p(bj )

p a | bj ) = p a ) ( k ( k p bj | a ) = p bj ) ( ( k

于是有:

H( X ) = H( X) + H( ) Y Y H( X | Y) = H(X) H( Y | X) = H( ) Y

1 [np(x1)I (x1) + np(x2 )I(x2 )] = −∑p(xi ) log p(xi ) n i

信源熵是在平均意义上来表征信源的总体特性。

1、离散信源熵 H(X) = −∑p(xi ) log p(xi )

i

例: 试验前:

X = P(x)

1

2

3 1/6

4 1/6

5 1/6

6 1/6

2)信源的主要特性

信Hale Waihona Puke 的最基本的特性是具有统计不确定性,它可用概 率统计特性来描述。

信息论与编码课后习题答案

1. 有一个马尔可夫信源,已知p(x 1|x 1)=2/3,p(x 2|x 1)=1/3,p(x 1|x 2)=1,p(x 2|x 2)=0,试画出该信源的香农线图,并求出信源熵。

解:该信源的香农线图为:1/3○ ○2/3 (x 1) 1 (x 2)在计算信源熵之前,先用转移概率求稳固状态下二个状态x 1和 x 2 的概率)(1x p 和)(2x p 立方程:)()()(1111x p x x p x p =+)()(221x p x x p=)()(2132x p x p +)()()(1122x p x x p x p =+)()(222x p x x p =)(0)(2131x p x p + )()(21x p x p +=1 得431)(=x p 412)(=x p马尔可夫信源熵H = ∑∑-IJi j i jix x p x xp x p )(log )()( 得 H=0.689bit/符号2.设有一个无经历信源发出符号A 和B ,已知4341)(.)(==B p A p 。

求:①计算该信源熵;②设该信源改成发出二重符号序列消息的信源,采纳费诺编码方式,求其平均信息传输速度; ③又设该信源改成发三重序列消息的信源,采纳霍夫曼编码方式,求其平均信息传输速度。

解:①∑-=Xiix p x p X H )(log )()( =0.812 bit/符号②发出二重符号序列消息的信源,发出四种消息的概率别离为1614141)(=⨯=AA p 1634341)(=⨯=AB p1634143)(=⨯=BA p 1694343)(=⨯=BB p用费诺编码方式 代码组 b i BB 0 1 BA 10 2 AB 110 3 AA 111 3无经历信源 624.1)(2)(2==X H X H bit/双符号 平均代码组长度 2B =1.687 bit/双符号BX H R )(22==0.963 bit/码元时刻③三重符号序列消息有8个,它们的概率别离为641)(=AAA p 643)(=AAB p 643)(=BAA p 643)(=ABA p 649)(=BBA p 649)(=BAB p 649)(=ABB p 6427)(=BBB p用霍夫曼编码方式 代码组 b iBBB 6427 0 0 1 BBA 649 0 )(6419 1 110 3BAB 649 1 )(6418 )(644 1 101 3ABB 649 0 0 100 3AAB 6431 )(6461 11111 5 BAA 643 0 1 11110 5ABA6431 )(6440 11101 5 AAA641 0 11100 5)(3)(3X H X H ==2.436 bit/三重符号序列 3B =2.469码元/三重符号序列3R =BX H )(3=0.987 bit/码元时刻3.已知符号集合{ 321,,x x x }为无穷离散消息集合,它们的显现概率别离为 211)(=x p ,412)(=x p 813)(=x p ···ii x p 21)(=···求: ① 用香农编码方式写出各个符号消息的码字(代码组); ② 计算码字的平均信息传输速度; ③ 计算信源编码效率。

《信息论与编码》习题集

第二章习题:补充题:掷色子,(1)若各面出现概率相同(2)若各面出现概率与点数成正比试求该信源的数学模型 解: (1)根据61()1ii p a ==∑,且16()()p a p a ==,得161()()6p a p a ===,所以信源概率空间为123456111111666666⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦P (2)根据61()1i i p a ==∑,且126(),()2,()6p a k p a k p a k ===,得121k =。

123456123456212121212121⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦P 2-2 由符号集{}0,1组成的二阶马尔可夫链,其转移概率为P(0/00)=0.8,P(0/11)=0.2,P(1/00)=0.2, P(1/11)=0.8,P(0/01)=0.5,P(0/10)=0.5,P(1/01)=0.5,P(1/10)=0.5。

画出状态图,并计算各状态的稳态概率。

解:由二阶马氏链的符号转移概率可得二阶马氏链的状态转移概率为: P(00/00)=0.8 P(10/11)=0.2 P(01/00)=0.2 P(11/11)=0.8 P(10/01)=0.5 P(00/10)=0.5 P(11/01)=0.5 P(01/10)=0.5二进制二阶马氏链的状态集S={,1S 432,,S S S }={00,01,10,11}0.80.20.50.50.50.50.20.8⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦P 状态转移图各状态稳定概率计算:⎪⎪⎩⎪⎪⎨⎧==∑∑==41411i jij i j j WP W W 即 ⎪⎪⎪⎩⎪⎪⎪⎨⎧=++++++=+++=+++=+++=143214443432421414434333232131342432322212124143132121111W W W W P W P W P W P W W P W P W P W P W W P W P W P W P W w P W P W P W P W W0.80.8得:14541==W W 14232==W W 即:P(00)=P(11)=145 P(01)=P(10)=1422-6掷两粒骰子,当其向上的面的小圆点数之和是3时,该消息所包含的信息量是多少?当小圆点数之和是7时,该消息所包含的信息量又是多少? 解:2211111(3)(1)(2)(2)(1)666618(3)log (3)log 18()P P P P P I p ⎧=⋅+⋅=⨯+⨯=⎪⎨⎪=-=⎩比特 226(7)(1)(6)(2)(5)(3)(4)(4)(3)(5)(2)(6)(1)36(7)log (7)log 6()P P P P P P P P P P P P P I p ⎧=⋅+⋅+⋅+⋅+⋅+⋅=⎪⎨⎪=-=⎩比特2-72-7设有一离散无记忆信源,其概率空间为⎥⎥⎦⎤⎢⎢⎣⎡=====⎥⎦⎤⎢⎣⎡81,41,41,833,2,1,04321x x x x P X该信源发出的消息符号序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210),求此消息的自信息量是多少及平均每个符号携带的信息量?解:消息序列中,“0”个数为1n =14,“1”个数为2n =13,“2”个数为3n =12,“3”个数为4n =6. 消息序列总长为N =1n +2n +3n +4n =45(个符号)(1) 消息序列的自信息量: =I ∑==41)(i iix I n -)(log 412i i ix p n∑== 比特81.87)3(log 6)2(log 12)1(log 13)0(log 142222=----p p p p(2) 平均每个符号携带的信息量为:)/(95.14571.87符号比特==N I 2-14 在一个二进制信道中,信息源消息集X={0,1},且P(1)=P(0),信宿的消息集Y={0,1},信道传输概率P (1/0)=1/4,P (0/1)=1/8。

《信息论与编码》课后习题答案

《信息论与编码》课后习题答案1、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。

2、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

4、按照信息的地位,可以把信息分成客观信息和主观信息。

5、人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

6、信息的可度量性是建立信息论的基础。

7、统计度量是信息度量最常用的方法。

8、熵是香农信息论最基本最重要的概念。

9、事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有比特、奈特和哈特。

13、必然事件的自信息是 0 。

14、不可能事件的自信息量是∞ 。

15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。

17、离散平稳无记忆信源X 的N 次扩展信源的熵等于离散信源X 的熵的 N 倍。

18、离散平稳有记忆信源的极限熵,。

19、对于n 元m 阶马尔可夫信源,其状态空间共有 n m 个不同的状态。

20、一维连续随即变量X 在[a ,b]区间内均匀分布时,其信源熵为 log 2(b-a )。

21、平均功率为P 的高斯分布的连续信源,其信源熵,H c (X )=。

22、对于限峰值功率的N 维连续信源,当概率密度均匀分布时连续信源熵具有最大值。

23、对于限平均功率的一维连续信源,当概率密度高斯分布时,信源熵有最大值。

24、对于均值为0,平均功率受限的连续信源,信源的冗余度决定于平均功率的限定值P 和信源的熵功率之比。

25、若一离散无记忆信源的信源熵H (X )等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为 3 。

信息论与编码 课后习题答案

信息论与编码课后习题答案信息论与编码课后习题答案[信息论与编码]课后习题答案1、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。

2、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、按照信息的性质,可以把信息分为语法信息、语义信息和语用信息。

4、按照信息的地位,可以把信息分成客观信息和主观信息。

5、人们研究信息论的目的就是为了高效率、可信、安全地互换和利用各种各样的信息。

6、信息的是建立信息论的基础。

8、就是香农信息论最基本最重要的概念。

9、事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号线性信源通常用随机变量叙述,而多符号线性信源通常用随机矢量叙述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位通常存有比特、奈特和哈特。

13、必然事件的自信息是。

14、不可能将事件的自信息量就是15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。

16、数据处理定理:当消息经过多级处置后,随着处理器数目的激增,输出消息与输入消息之间的平均值互信息量趋向变大。

17、离散平稳无记忆信源x的n次扩展信源的熵等于离散信源x的熵的。

limh(xn/x1x2xn1)h n18、线性稳定存有记忆信源的音速熵,。

19、对于n元m阶马尔可夫信源,其状态空间共有m个不同的状态。

20、一维已连续随即变量x在[a,b]。

1log22ep21、平均功率为p的高斯分布的已连续信源,其信源熵,hc(x)=2。

22、对于限峰值功率的n维连续信源,当概率密度均匀分布时连续信源熵具有最大值。

23、对于减半平均功率的一维已连续信源,当概率密度24、对于均值为0,平均功率受限的连续信源,信源的冗余度决定于平均功率的限定值p和信源的熵功率p25、若一线性并无记忆信源的信源熵h(x)等同于2.5,对信源展开相切的并无杂讯二进制编码,则编码长度至少为。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Chap1思考题与习题参考答案1.1 信息论与编码技术研究的主要内容是什么?信息论是一门应用概率论、随机过程、数理统计和近代代数的方法,来研究广义的信息传输、提取和处理系统中一般学科。

编码技术研究的主要内容是如何既可靠又有效地传输信息。

1.2 简述信息理论与编码技术的发展简史。

1948年香农在贝尔系统技术杂志上发表了两篇有关“通信的数学理论”的文章。

在这两篇论文中,他用概率论测度和数理统计的方法系统地讨论了通信的基本问题,得出了及格重要而带有普遍意义的结论,并由此奠定了现代信息论的基础。

从1948年开始,信息论的出现引起了一些有名的数学家如柯尔洛夫、A.Feinstein、J.Wolfowitz等人的兴趣,他们将香农已得到的数学结论做了进一步的严格论证和推广,使这一理论具有更为坚实的数学基础。

在研究香农信源编码定理的同时,另外一部分科学家从事寻找最佳编码(纠错码)的研究工作,并形成一门独立的分支——纠错码理论。

1959年香农发表了“保真度准则下的离散信源编码定理”,首先提出了率失真函数及率失真信源编码定理。

从此,发展成为信息率失真编码理论。

香农1961年的论文“双路通信信道”开拓了网络信息论的研究。

现在,信息理论不仅在通信、计算机以及自动控制等电子学领域中得到直接的应用,而且还广泛地渗透到生物学、医学、生理学、语言学、社会学、和经济学等领域。

1.3 简述信息与消息、信号的定义以及三者之间的关系。

信息就是事物运动的状态和方式,就是关于事物运动的千差万别的状态和方式的知识。

用文字、符号、数据、语言、音符、图像等能够被人们感觉器官所感知的形式,把客观物质运动和主观思维活动的状态表达出来成为消息。

把消息变换成适合信道传输的物理量,这种物理量称为信号。

它们之间的关系是:消息中包含信息,是信息的载体;信号携带消息,是消息的运载工具。

1.4 简述一个通信系统包括的各主要功能模块及其作用。

通信系统主要分成下列五个部分:(1)信息源。

信源是产生消息和消息序列的源。

(2)编码器。

编码是把消息变换成信号的措施。

(3)信道。

信道是指通信系统把载荷消息的信号从甲地传到乙地的媒介。

(4)译码器。

译码就是把信道输出的编码信号(已叠加了干扰)进行反变换。

(5)信宿。

信宿是消息传送的对象,即接收消息的人或机器。

1.5 你有没有接触与考虑过信息与信息的测度问题,你如何理解这些问题?略。

1.6 什么是事物的不确定性?不确定性如何与信息的测度发生关系?由于主、客观事物运动状态或存在状态是千变万化的、不规则的、随机的。

所以在通信以前,收信者存在“疑义”和“不知”,即不确定性。

用数学的语言来讲,不确定就是随机性,具有不确定性的事件就是随机事件。

因此,可运用研究随机事件的数学工具——概率论和随机过程来测度不确定性的大小。

1.7 试从你的实际生活中列举出三种不同类型的通信系统模型,并说明它们的信源、信道结构,写出它们的消息字母表、输入与输出字母表及它们的概率分布与条件概率分布。

略。

1.8 在你日常生活中出现过哪些编码问题?能否用编码函数给以描述?略。

Chap2 思考题与习题 参考答案2.1 同时扔一对均匀的骰子,当得知“两骰子面朝上点数之和为2”或“两骰子面朝上点数之和为8”或“两骰子面朝上点数是3和4”时,试问这三种情况分别获得多少信息量?解:同时扔一对均匀的骰子,可能呈现的状态数有36种,各面呈现的概率为1/6,所以36种中任何一种状态出现的概率都是相等,为1/36。

(1)设 “两骰子面朝上点数之和为2”为事件A 。

在36种情况中,只有一种情况,即1+1。

则2()1/36()log ()log 36 5.17(P A I A P A ==−=≈比特)(2)设 “两骰子面朝上点数之和为8”为事件B 。

在36种情况中,有六种情况,即5+3,3+5,2+6,6+2,4+4。

则2()5/3636()log ()log 2.85(5P B I B P B ==−=≈比特) (3)设 “两骰子面朝上点数是3和4”为事件C 。

在36种情况中,有两种情况,即3+4和4+3。

则2()2/36()log ()log 18 4.17(P C I C P C ==−=≈比特)2.2 同时掷两个均匀的骰子,也就是各面呈现的概率都是1/6,求:(1) 事件“3和5同时出现”的自信息量;(2) 事件“两个l 同时出现”的自信息量;(3) 两个点数之和(即2,3,…,12构成的子集)的熵;(4) 事件“两个骰子点数中至少有一个是1”的自信息量。

解:同时掷两个均匀的骰子,也就是各面呈现的概率都是1/6,总共有36种可能的状态,每 种状态出现的概率都是1/36。

(1)设“3和5同时出现”为事件A 。

则在36种状态中,有两种可能的情况,即5+3和3+5。

则2()2/36()log ()log 18 4.17(P A I A P A ==−=≈比特)(2)设“两个l 同时出现”为事件B 。

则在36种状态中,只有一种可能情况,即1+1。

则:2()1/36()log ()log 36 5.17(P B I B P B ==−=≈比特)(3)设两个点数之和构成信源Z,它是由两个骰子的点数之和组合,即Z=Y+X.得:23456789101112()1/362/363/364/365/366/365/364/363/362/361/36()1Z P z P z ⎡⎤⎡=⎢⎥⎢⎣⎦⎣=∑⎤⎥⎦22222222()()log ()468106log 36[log 2log 3log 4log 5log 6]3636363636261210log 36[log 3log 5]3636365.17 1.896 3.274(ZH Z P z P z =−=−++++=−++≈−≈∑比特)2(4)在这36种状态中,至少有一个是1的状态共有11种,每种状态都是独立出现的,每种状态初点的概率都是1/36。

设“两个点数中至少有一个是1”为事件C 。

则:2()11/3611()log ()log 1.71(36P C I C P C ==−=−≈比特)2.3 设离散无记忆信源1234012()3/81/41/41/8X a a a a p x ====3⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦,其发出的消息为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210),求:(1) 此消息的自信息是多少?(2) 在此消息中平均每个符号携带的信息量是多少?解:(1)因为离散信源是无记忆的,所以它发出的消息序列中各个符号是无依赖的,统计独立的。

因此,此消息的自信息就等于各个符号的自信息之和。

则可得: 11222233244233(0)log ()log log 1.45(881(1)log ()log log 4=2(41(2)log ()log log 4=2(41(3)log ()log log 8=3(8I a P a I a P a I a P a I a P a ==−=−=≈==−=−===−=−===−=−=比特)比特)比特)比特) 此消息中共有14个符号“0”,13个符号“1”,12个符号“2”和6个符号“3”,则此消息的自信息是12314(0)13(1)12(2)6(3)14 1.4151321226387.71(I I a I a I a I a ==+=+=+=≈×+×+×+×≈比特)4⎤⎥⎦(2)此消息中共有45个信源符号,携带了87.81比特信息量,因此,此消息中平均每个符号携带的信息量为287.81/45 1.95(I =≈比特)2.4 有一个二元信源,计算该信源的熵。

01()0.90.1X p x ⎡⎤⎡=⎢⎥⎢⎣⎦⎣解:根据公式得该信源的熵为:22()(0)log (0)(1)log (1)0.9log 0.90.1log 0.10.4689(H X P x P x P x P x =−==−===−×−×≈比特/符号)2.5 设信源123456()0.20.190.180.170.160.17X a a a a a a p x ⎡⎤⎡=⎢⎥⎢⎣⎦⎣⎤⎥⎦,求该信源的熵,并解释为什么在本题中H(X)>log6,不满足信源熵的极值性。

解:根据公式得信源熵为:()()log ()log 0.2log 0.20.19log 0.190.18log 0.180.17log 0.170.16log 0.160.17log 0.172.65(/xi iiH X P x P x P P =−=−=−−−−−−≈∑∑比特符号)由离散信源熵的特性可知,其有一个最大值,等概分布时达到最大值,最大值为log q=log 6=2.58比特/符号。

现在H (X )>log 6,不满足信源熵的极值性,这是因为,我们讨论的信源的概率空间应该是一个完备集,即611i i P ==∑,而在本题当中,61 1.071i i P ==≠∑,不是完备集,所以不满足信源熵的极值性。

2.6 每帧电视图像可以认为是由3×105 个像素组成,每个像素均是独立变化,若每个像素可取128个不同的亮度电平,并设亮度电平等概率出现。

问每帧图像含有多少信息量?若有一广播员在约10000个汉字的字汇中选1000个字来口述此电视图像,试问广播员描述此图像所广播的信息量是多少(假设汉字字汇是等概率分布,并彼此无依赖)?若要恰当地描述此图像,广播员在口述中至少需用多少汉字?解:(1)亮度电平等概出现,即每个像素亮度信源为:128121281...()1()1/1281/128...1/128i i i X a a a P a P a =⎡⎤⎡⎤==⎢⎥⎢⎥⎣⎦⎣⎦∑ 则每个像素亮度含有的信息量为:2()log 1287()H X ==比特/符号 一帧图像每个像素均是独立变化的,则每帧图像信源就是离散亮度信源的无记忆N 次扩展信源,得到每帧图像含有的信息量为:56()()310() 2.110N H X NH X H X ==××=×(比特/每帧)(2)同(1)中,汉字字汇信源为: 1000012100001...()1()1/100001/10000...1/10000i i i X b b b P b P b =⎡⎤⎡⎤==⎢⎥⎢⎥⎣⎦⎣⎦∑ 则每个汉字含有的信息量为:2()log 1000013.29()H Y =≈比特/字广播员口述电视图像是从此汉字字汇信源中独立的选取1000个字来描述的,所以广播员描述此帧图像所广播的信息量为:442()()1000log 10 1.32910N H Y NH Y ==≈×(比特/千字)(3)若广播员仍从此汉字字汇信源Y 中独立选取汉字来描述电视图像,每次口述一次汉字含有的信息量是H(Y),每帧电视图像含有的信息量是,则广播员口述次图像至少需要使用的汉字数为: ()NH Y 65() 2.110 1.5810158000(()13.29N H X H Y ×≈≈×≈字)2.7 为了传输一个由字母A 、B 、C 、D 组成的符号集,把每个字母编码成两个二元码脉冲序列,以“00”代表A ,“01”代表B ,“10”代表C ,“11”代表D 。