哈夫曼编码

哈夫曼编码代码

哈夫曼编码代码哈夫曼编码代码 1因为哈夫曼树的特点是:叶子结点权值越大的,离根越近。

又因为构造不等长编码的原则是:字符使用频率越高,编码越短,故采用哈夫曼树进行编码可以得到最优前缀编码。

约定左分支标记为0, 右分支标记为 1哈夫曼编码代码 2为不浪费存储空间,动态分配一个长度为n(字符编码长度一定小于n) 的一维数组cd, 用来临时存放当前正在求解的第i 个字符的编码,当第i个字符的编码求解完毕后,根据数组cd的字符串长度分配HC[i]的空间,然后将数组cd中的编码复制到HC[i]中。

依照上一篇文章的哈夫曼树:哈夫曼编码表HC:注意:由于哈夫曼树不唯一,故哈夫曼编码也不唯一。

代码如下:#include<stdio.h>#include<iostream>typedefstruct{int weight;int parent, lchild,rchild;}HTNode,*HuffmanTree;voidSelect(HuffmanTree&HT,int n,int&s1,int&s2){int min;for(int i =1; i <= n; i++){if(HT[i].parent ==0){min = i;break;}}for(int i =1; i <= n;i++){if(HT[i].parent ==0){if(HT[i].weight <HT[min].weight){min = i;}}}s1 = min;for(int i =1; i <= n;i++){if(HT[i].parent ==0&& i != s1){min = i;break;}}for(int i =1; i <= n;i++){if(HT[i].parent ==0&& i != s1){if(HT[i].weight < HT[min].weight){min = i;}}}s2 = min;}voidprintln(HuffmanTree &HT,intm){printf("==============================\n");for(inti =1; i <= m; i++){printf("%d, ", i);printf("%d ", HT[i].weight);printf("%d ", HT[i].parent);printf("%d ", HT[i].lchild);printf("%d \n",HT[i].rchild);printf("---------------------------\n");}}voidCreateHuffmanTree(HuffmanTree &HT,intn,int*ht){int i, m =2* n -1, s1, s2;if(n <=1)return;HT =new HTNode[m +1];for(i =1; i <= m;++i){HT[i].parent =0;HT[i].lchild =0;HT[i].rchild =0;}for(i =1; i <= n;++i){HT[i].weight = ht[i -1];}printf("\nHT的初态\n");println(HT, m);for(int i = n +1; i <=m;++i){Select(HT, i -1, s1, s2);HT[s1].parent = i;HT[s2].parent = i;HT[i].lchild = s1;HT[i].rchild = s2;HT[i].weight = HT[s1].weight +HT[s2].weight;}printf("\nHT的终态\n");println(HT, m);}typedefchar**HuffmanCode;char*cd;intstart;voidCreatHuffmanCode(HuffmanTree HT, HuffmanCode &HC,int n){int i, c, f;HC =newchar*[n +1];cd =newchar[n];cd[n -1]='\0';for(i =1; i <= n;++i){start = n -1;c = i;f = HT[i].parent;while(f !=0){if(HT[f].lchild == c) cd[--start]='0';else cd[--start]='1';c = f;f = HT[f].parent;}HC[i]=newchar[n -start];strcpy(HC[i],&cd[start]);printf("第%d组--->", i);for(int j = start; j <= n -1;++j){printf("%c ",cd[j]);}printf("\n");}delete cd;}intmain(){HuffmanTree HT;HuffmanCode HC;int n =8;intht[8]={5,29,7,8,14,23,3,11};CreateHuffmanTree(HT, n, ht);CreatHuffmanCode(HT, HC, n);}运行结果:。

哈夫曼编码名词解释

哈夫曼编码名词解释哈夫曼编码是一种用于数据压缩的编码方式。

由于它可以减小文件的体积,并且在传输文件时速度更快,因此在实际应用中非常重要。

哈夫曼编码一些重要的名词解释如下:一、频率频率是指特定字符在文本中出现的次数。

在哈夫曼编码中,频率用于计算每个字符的权重,权重越高的字符,使用的编码位数越少。

二、前缀码前缀码是指没有任何码字是其它码字的前缀的编码方式。

哈夫曼编码就是一种前缀码,没有任何哈夫曼编码的码字是其它码字的前缀,这是保证哈夫曼编码解码准确性的关键所在。

三、码树码树是一种包含权重、编码、二进制位数的树形数据结构。

在哈夫曼编码中,码树由文本中出现的字符的频率构成,每个字符用一个叶节点代表,叶节点和中间节点通过一个编码连接起来。

四、权重权重是指字符在文本中出现的频率,在哈夫曼编码中,它用于计算每个字符在编码中的位数,权重越高的字符使用的编码位数越少。

五、码字码字是指表示一个字符的二进制编码,长度不同的码字代表着不同权重的字符。

六、编码编码是将字符或数据转化为码字的过程,在哈夫曼编码中,通过经过计算得出的权重来生成码字。

七、解码解码是将码字转化为字符或数据的过程,在哈夫曼编码中,根据每个字符的码字和频率生成码树,在树中查找出对应的字符,从而将码字还原为原始的字符。

八、二进制二进制是计算机中表示数字的一种方式,它只包含0和1两种数值,在哈夫曼编码中,使用二进制来表示每个字符的码字。

总之,哈夫曼编码在很多领域都有着重要的应用,了解这些关键名词的含义将更好的理解和掌握它的原理,也会帮助你更好的使用它。

哈夫曼编码计算

哈夫曼编码是一种根据字符出现频率创建的编码方式,其中频率高的字符使用较短的编码,频率低的字符使用较长的编码。

以下是计算哈夫曼编码的步骤:

1. 创建一个森林,每个字符出现频率作为一棵树的权值,每个树只有一个节点。

2. 从森林中取出两棵权值最小的树,合并它们,生成一棵新的树。

新树的权值是这两棵树的权值之和,左子树是原来的左树,右子树是原来的右树。

3. 将新生成的树放回森林中。

4. 重复步骤2和3,直到森林中只剩下一棵树为止,这棵树就是哈夫曼树。

5. 哈夫曼编码是从哈夫曼树的根节点到叶节点的路径,按照从左到右的顺序,用0和1表示路径的方向。

举个例子,假设我们有4个字符(a、b、c、d),它们的出现频率分别为1、2、3、4。

根据这些频率,我们可以建立以下森林:

1. a -> 1

2. b -> 2

3. c -> 3

4. d -> 4

然后,我们按照上述步骤合并权值最小的两个节点,生成新的节点,并反复进行这个过程,直到得到一棵只有根节点的树。

最后,从根节点到每个叶节点的路径就是每个字符的哈夫曼编码。

需要注意的是,哈夫曼编码是一种无损压缩算法,它不会丢失原始数据的信息。

但是,它并不适用于所有情况,特别是当字符出现频率相差很大时,哈夫曼编码的效果可能会受到影响。

哈夫曼编码原理及方法

哈夫曼编码原理及方法哈夫曼编码(Huffman Coding)是一种变长编码(Variable Length Code)的压缩算法。

它的原理是将频率较高的字符用较短的编码,频率较低的字符用较长的编码,以此降低数据的传输成本。

下面将详细介绍哈夫曼编码的原理及方法。

一、哈夫曼编码的原理哈夫曼编码的原理基于贪心算法(Greedy Algorithm),即对每个要编码的字符进行评估,按照字符在文本中出现的频率多少,将频率高的字符赋予较短的编码,频率低的字符赋予较长的编码。

这样在实际使用中,字符出现频率越高的编码长度越短,从而达到压缩数据的目的。

二、哈夫曼编码的方法1. 构建哈夫曼树(Huffman Tree)构建哈夫曼树的过程首先要确定每个字符在文本中出现的频率,然后将每个字符看作一个节点,并按照其频率大小建立一个小根堆(Min Heap)。

接下来,选取频率最小的两个节点,将它们合并到一起作为一个新的节点,并更新频率值,然后继续重复以上步骤,直到堆中只剩下一个节点,即为哈夫曼树的根节点。

2. 生成哈夫曼编码生成哈夫曼编码可以采用递归的方式,从根节点开始向左遍历时,将标记为 0,向右遍历时,将标记为 1,直到叶节点为止,然后向上回溯,将遍历的结果保存下来,得到该叶节点的哈夫曼编码。

遍历完所有的叶子节点后,即可得到所有字符的哈夫曼编码。

3. 压缩数据在使用哈夫曼编码进行数据压缩时,将字符替换为其对应的哈夫曼编码,这样可以将原始数据压缩为更小的数据量,达到压缩数据的目的。

在解压数据时,需要根据已生成的哈夫曼树,将压缩后的数据转换为原始数据,即将哈夫曼编码转换为对应的字符。

三、哈夫曼编码的优缺点哈夫曼编码的优点是具有压缩比高、压缩速度快、压缩后的数据无损还原等特点,可以广泛用于图像、音频、视频等多种数据类型的压缩。

同时,由于哈夫曼编码采用变长编码方式,所以可以使用相对较短的编码表示经常出现的字符,从而达到更好的压缩效果。

哈夫曼编码

哈夫曼编码一、概述哈夫曼编码(Huffman Coding)是一种编码方式,哈夫曼编码是可变字长编码(VL C)的一种。

Huffman于1952年提出一种编码方法,该方法完全依据字符出现概率来构造异字头的平均长度最短的码字,有时称之为最佳编码,一般就叫作Huffman编码。

以哈夫曼树─即最优二叉树,带权路径长度最小的二叉树,经常应用于数据压缩。

在计算机信息处理中,“哈夫曼编码”是一种一致性编码法(又称"熵编码法"),用于数据的无损耗压缩。

这一术语是指使用一张特殊的编码表将源字符(例如某文件中的一个符号)进行编码。

这张编码表的特殊之处在于,它是根据每一个源字符出现的估算概率而建立起来的(出现概率高的字符使用较短的编码,反之出现概率低的则使用较长的编码,这便使编码之后的字符串的平均期望长度降低,从而达到无损压缩数据的目的)。

这种方法是由David.A.Huffman发展起来的。

例如,在英文中,e的出现概率很高,而z的出现概率则最低。

当利用哈夫曼编码对一篇英文进行压缩时,e极有可能用一个位(bit)来表示,而z则可能花去25个位(不是26)。

用普通的表示方法时,每个英文字母均占用一个字节(byte),即8个位。

二者相比,e使用了一般编码的1/8的长度,z则使用了3倍多。

倘若我们能实现对于英文中各个字母出现概率的较准确的估算,就可以大幅度提高无损压缩的比例。

哈夫曼压缩是个无损的压缩算法,一般用来压缩文本和程序文件。

哈夫曼压缩属于可变代码长度算法一族。

意思是个体符号(例如,文本文件中的字符)用一个特定长度的位序列替代。

因此,在文件中出现频率高的符号,使用短的位序列,而那些很少出现的符号,则用较长的位序列。

二、C语言程序实现文件的huffman编码#include <stdio.h>#define MAX 1000#define MAXSYMBS 30#define MAXNODE 59typedef struct{int weight;int flag;int parent;int lchild;int rchild;}huffnode;typedef struct{int bits[MAXSYMBS];int start;}huffcode;void main(){huffnode huff_node[MAXNODE];huffcode huff_code[MAXSYMBS],cd;int i,j,m1,m2,x1,x2,n,c,p; /*char symbs[MAXSYMBS],symb;*//*数组buff_node初始化*/printf("please input the leaf num of tree:\n");scanf("%d",&n);for(i=0;i<2*n-1;i++){huff_node[i].weight=0;huff_node[i].parent=0;huff_node[i].flag=0;huff_node[i].lchild=-1;huff_node[i].rchild=-1;}printf("please input the weight of every leaf\n");for(i=0;i<n-1;i++)scanf("%d",&huff_node[i].weight);/*构造哈弗曼树*/for(i=0;i<n-1;i++){m1=m2=MAX;x1=x2=0;for(j=0;j<n+i;j++){if(huff_node[j].weight <m1&&huff_node[j].flag ==0){m2=m1;x2=x1;m1=huff_node[j].weight ;x1=j;}else if (huff_node[j].weight <m2&&huff_node[j].flag ==0) {m2=huff_node[j].weight;x2=j;}}huff_node[x1].parent=n+i;huff_node[x2].parent=n+i;huff_node[x1].flag =1;huff_node[x2].flag =1;huff_node[n+i].weight =huff_node[x1].weight +huff_node[x2].weight ; huff_node[n+i].lchild =x1;huff_node[n+i].rchild =x2;}/*求字符的哈弗曼编码*/for(i=0;i<n;i++){cd.start =n;c=i;p=huff_node[c].parent ;while(p!=0){if(huff_node[p].lchild ==c)cd.bits [cd.start ]=0;elsecd.bits [cd.start ]=1;cd.start=cd.start -1;c=p;p=huff_node[p].parent ;}cd.start ++;for(j=cd.start ;j<=n;j++)huff_code[i].bits[j]=cd.bits [j];huff_code[i].start =cd.start ;}/*输出字符的哈弗曼编码*/puts("the hafman code are:");for(i=0;i<n;i++){for(j=huff_code[i].start;j<=n;j++)printf("%10d",huff_code[i].bits [j]);printf("/n");}puts("press any key to quit...");}三、运行界面please input the leaf num of tree:8please input the weight of every leaf 1 2 3 4 5 6 7 1输出:11010 1100 100 101 1110001 11011。

哈夫曼编码算法详解

哈夫曼编码算法详解在计算机科学中,哈夫曼编码是一种压缩算法,也叫做霍夫曼编码,是由霍夫曼(Huffman)在1952年首创的。

霍夫曼编码是一种无损压缩算法,可以对文本文件、音频文件、图像文件等各种类型的文件进行压缩。

1. 哈夫曼编码的原理哈夫曼编码是基于频率统计的思想,通过统计每个字符在文件中出现的频率,选择出现频率最高的字符,将其映射为一组比特位,出现频率较低的字符则映射为比高的比特位,从而实现对文件的压缩。

通过哈夫曼编码,可以将文件压缩到原始大小的一半甚至更小。

2. 哈夫曼编码的实现哈夫曼编码的实现需要进行几个步骤:2.1 统计字符的出现频率从文件中读取字符,统计每个字符在文件中出现的次数,可以使用一个数组或字典来保存每个字符的出现次数。

对于英文文本来说,出现频率最高的字符是空格,其次是字母“e”。

2.2 构建哈夫曼树将所有的字符按照出现频率从小到大排序,选出出现频率最小的两个字符作为左右子节点,其父节点的出现频率为左右子节点出现频率之和。

重复这个过程,直到节点数为1,这样就得到了一棵哈夫曼树。

2.3 生成哈夫曼编码从哈夫曼树的根节点开始,遍历所有的节点,将左子节点标记为0,将右子节点标记为1,将所有的叶子节点的字符和对应的哈夫曼编码保存到一个字典中。

最终得到了每个字符对应的哈夫曼编码。

2.4 进行压缩将文件中每个字符替换为对应的哈夫曼编码,然后将所有的哈夫曼编码拼接成一个二进制数,在最后不足8位的位置补零,将其存储到文件中。

这样就完成了文件的压缩。

3. 哈夫曼编码的优点哈夫曼编码具有以下优点:3.1 压缩率高由于哈夫曼编码是根据不同字符的出现频率来进行编码的,出现频率高的字符用较短的编码表示,出现频率低的字符用较长的编码表示,能够最大限度地减少文件的大小,从而达到高的压缩率。

3.2 唯一解哈夫曼编码是通过构建哈夫曼树来得到每个字符对应的编码,哈夫曼树的构建是唯一的,因此哈夫曼编码也是唯一的。

《信息论与编码》第5章哈夫曼编码

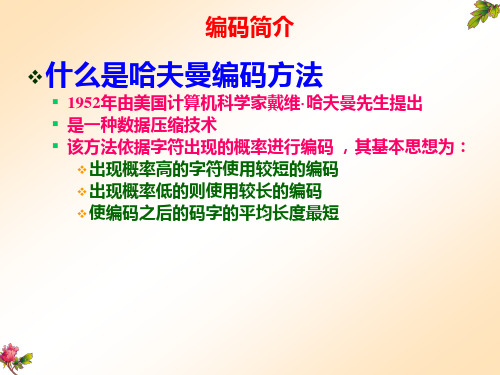

什么是哈夫曼编码方法

1952年由美国计算机科学家戴维· 哈夫曼先生提出 是一种数据压缩技术 该方法依据字符出现的概率进行编码 ,其基本思想为: 出现概率高的字符使用较短的编码 出现概率低的则使用较长的编码 使编码之后的码字的平均长度最短

哈夫曼编码方法

哈夫曼编码方法包含两个过程

哈夫曼编码方法包含两个过程

编码过程和译码过程

编码过程 译码过程

构建哈夫曼树 CreatHT(W,&HT)

输入是字符频度表W

表中记录的是原码报文中出现的不同符号个数和频率

输出是哈夫曼树HT

进行哈夫曼译码 HuffmanDecod(HT,CC,W,&OC)

输入的是哈夫曼树HT、代码报文CC和字符频度表W 输出的是原码报文OC

OC

输出OC 到哈夫曼译码系统之外 返回开头

字母a的编码为110 字母n的编码为111

1

4 n

因此,在电文中出现频率 高的字母的编码相对短, 而出现频率低的字母的编 码相对长

111 字符编码表HC=((d,0),(i,10),(a,110),(n,111))

哈夫曼编码过程演示

编码 A1 A2 A3 0.23 0.21 0.18

1

0 1 0 1 0.10 0

编码过程和译码过程

编码过程

构建哈夫曼树 CreatHT(W,&HT)

输入是字符频度表W

表中记录的是原码报文中出现的不同符号个数和频率

输出是哈夫曼树HT

进行哈夫曼编码 HuffmanCoding(HT,&HC)

输入是哈夫曼树HT 输出是字符编码表HC

哈夫曼编码资料讲解

P

0.22 0.20 0.18 0.15 0.10 0.08 0.05 0.02

码字 1 2 3 00 01 02 030 031

例•5-信9 源输出2个符号,概率分布为P=(0.9,0.1),信 源熵H(X)=H(0.9)=0.469。采用二进制哈夫曼编 码。 L=1, 1=1bit/符号; L=2,P’=(0.81,0.09,0.09,0.01), 2=0.645bit/符号; L=3, K 3=0.533bit/符号; L=4, 4=0.493bit/符号。 随着序K列长度L的增加,平均码长迅速降低,接近 信息源熵值,K 编码效率接近于1.

K

一般情况下,信源符号以恒速输出,信道也是恒速传 输的。通过编码后,会造成编码输出每秒的比特数 不是常量,因而不能直接由信道来传送。为了适应 信道,必须增加缓冲寄存器。将编码输出暂存在缓 冲器中,然后再由信道传输,使输入和输出的速率 保持平衡。

溢出:当信源连续输出低概率符号时,因为码长较长, 有可能使缓冲器存不下而溢出。

0110 4

0111 4

该哈夫曼编码的平均码长

7

K p(ai)Ki 2.72码元/符号 i1

信息传输速率

RH(X)2.610.96Bit/码元 K 2.72

哈夫曼编码方法得到的码并非唯一的

1 每次对信源缩减时,赋予信源最后两个概率最小的符号, 用0和1是可以任意的,所以可以得到不同的哈夫曼码,但 不会影响码字的长度。

编码过程

0.4

0.4

0.6 0 1.0

0.2

0.4 0 0.4 1

0.2 0

0.2 1

0.2 1

码字 码长

1

1

01 2

000 3

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

单个字母编码时编码效率不高

信源字母集大时不易实现(香农-费诺码可解决)

硬件实现时需要缓冲寄存器(变长码固有的缺陷) 差错扩散(可增加信道校验码) 必须知道信源的统计特性(通用信源编码不需要)

School of Information and Mathematics

谢谢各位老师!

结论

结论:在哈夫曼编码过程中,对缩减信源符号按概率 由大到小的顺序重新排列时,应使合并后的新符号尽 可能排在靠前的位置,这样可使合并后的新符号重复

编码次数减少,使短码得到充分利用。

School of Information and Mathematics

结论

定理:在变长编码中,若各码字长度严格按照所对应符号

引例—色子游戏

点数出现 的频率

School of Information and Mathematics

引例—色子游戏

按概率编码

School of Information and Mathematics

引例—莫尔斯电报码

莫尔斯电报码:按照英文字母出现的概率编码,

在英文中,e的出现概率很高,而z的出现概率则最低。

例题

可见:第二种编码方法的码长方差要小许多。意味着第 二种编码方法的码长变化较小,比较接近于平均码长。

第一种方法编出的5个码字有4种不同的码长;

第二种方法编出的码长只有两种不同的码长;

显然,第二种编码方法更简单、更容易实现,所以

更好。

School of Information and Mathematics

哈夫曼编码

哈夫曼编码算法: (1) 信源符号按概率分布大小,以递减次序排列; (2) 取两个最小的概率,分别赋以“0”,“1”; 然后把这两个概率值相加,作为新概率值与其他概率重新排序 (3) 按重排概率值,重复(2)…,

直到概率和达到1为止

(4) 由后向前排列码序,即得哈夫曼编码

School of Information and Mathematics

x2 0.2 000 x3 0.2 0010 x4 0.1 0011 x5 0.1

School of Information and Mathema上放

0.4 0 0.2 0 0.6 0 1

1.0

00 x1 0.4

10 x2 0.2 11 x3 0.2 1 010 x4 0.1 0 011 x5 0.1 1 *两法平均码长相同,故信 息率R、冗余度相同;

哈夫曼编码

邹健

School of Information and Mathematics

回顾:通信系统模型

信源 干扰 源 信宿

信源编码器 调 制 器

信源译码器 解 调 器

信道编码器

信道 编码信道

信道译码器

信源:产生消息和消息序列的来源。 信源编码器:将信源的输出进行适当的变换,以提高 信息传输的有效性。

i 1

码方差

E[(li L ) ] P( si )(li L ) 2

2 2 i 1

q

P(si )(li L1 )2 1.36

2 1 i 1

5

P(si )(li L2 )2 0.16

2 2 i 1

5

School of Information and Mathematics

符出现的估算概率而建立起来的(出现概率高的字符使用较短

的编码,反之出现概率低的则使用较长的编码,这便使编码之 后的字符串的平均期望长度降低,从而达到无损压缩数据的目 的)。实际上,哈夫曼编码是传真图像的压缩标准。

School of Information and Mathematics

哈夫曼编码的缺点

思考:国际求救信号SOS

School of Information and Mathematics

哈夫曼编码 哈夫曼编码(Huffman Coding)

1952年,David A. Huffman在麻省理工攻读博士时发表了

《一种构建极小多余编码的方法》(A Method for the

Construction of Minimum-Redundancy Codes)一文, 提出Huffman编码算法。 是可变长编码(VLC)的一种

School of Information and Mathematics

哈夫曼编码 哈夫曼编码(Huffman Coding)

基本思想 • 完全依据字符出现概率进行编码 • 出现概率高的字符使用较短的编码 • 出现概率低的字符使用较长的编码 • 编码后平均码字长最短

School of Information and Mathematics

最优码的存在性

如何构造最优码?

School of Information and Mathematics

回顾:最优码的构造

等长码:每个码字的码长相等

变长编码:每个码字的码长可以不相等

School of Information and Mathematics

引例—色子游戏

顺序编码

是否最优?

School of Information and Mathematics

School of Information and Mathematics

回顾:信源编码定理

信源编码定理(定理2.4.1) 设X1,X2…为无记忆信源,服从共同分布p(x) ,则 当码率 R log M H ( X ) 时,存在码率为R 的编码,使得当

1 n

n→∞ 时,误差码率Pe→0.

1

School of Information and Mathematics

例题 两种方法的比较

平均码长

L1 P(si )li 0.4 1 0.2 2 0.2 3 0.1 4 0.1 4 2.2

i 1 5 5

L2 P(si )li 0.4 2 0.2 2 0.2 2 0.1 3 0.1 3 2.2

例题

例题: 设一个信源变量X 服从以下概率分布

X:p(x)~(0.4,0.2,0.2,0.1,0.1)

设计二进哈夫曼编码

School of Information and Mathematics

例题

方法一:

1 01

合并后概率下放

0.6

0 1 0.4 1.0

x1 0.4

0

1 0 0 1 0.2 1

出现概率的大小逆序排列,则其平均长度为最小。

结论:哈夫曼编码方法,它完全依据字符出现概率来构造

平均长度最短的异字头码字,有时称之为最佳编码。

School of Information and Mathematics

哈夫曼编码的应用

无损压缩 在计算机信息处理中,“哈夫曼编码”是一种一致性编码法 (又称“熵编码法”),用于数据的无损耗压缩。这一术语是 指使用一张特殊的编码表将源字符(例如某文件中的一个符号) 进行编码。这张编码表的特殊之处在于,它是根据每一个源字