答案~信息论与编码练习题

信息论与编码试卷及答案

一、(11’)填空题(1)1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

(2)必然事件的自信息是0 。

(3)离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的N倍。

(4)对于离散无记忆信源,当信源熵有最大值时,满足条件为__信源符号等概分布_。

(5)若一离散无记忆信源的信源熵H(X)等于,对信源进行等长的无失真二进制编码,则编码长度至少为3 。

(6)对于香农编码、费诺编码和霍夫曼编码,编码方法惟一的是香农编码。

(7)已知某线性分组码的最小汉明距离为3,那么这组码最多能检测出_2_______个码元错误,最多能纠正___1__个码元错误。

(8)设有一离散无记忆平稳信道,其信道容量为C,只要待传送的信息传输率R__小于___C(大于、小于或者等于),则存在一种编码,当输入序列长度n足够大,使译码错误概率任意小。

(9)平均错误概率不仅与信道本身的统计特性有关,还与___译码规则____________和___编码方法___有关二、(9')判断题(1)信息就是一种消息。

(⨯)(2)信息论研究的主要问题是在通信系统设计中如何实现信息传输、存储和处理的有效性和可靠性。

(√)(3)概率大的事件自信息量大。

(⨯)(4)互信息量可正、可负亦可为零。

(√)(5)信源剩余度用来衡量信源的相关性程度,信源剩余度大说明信源符号间的依赖关系较小。

(⨯)(6)对于固定的信源分布,平均互信息量是信道传递概率的下凸函数。

(√)(7) 非奇异码一定是唯一可译码,唯一可译码不一定是非奇异码。

( ⨯ ) (8) 信源变长编码的核心问题是寻找紧致码(或最佳码),霍夫曼编码方法构造的是最佳码。

( √ )(9)信息率失真函数R(D)是关于平均失真度D 的上凸函数. ( ⨯ )三、(5')居住在某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。

信息论与编码试题与答案

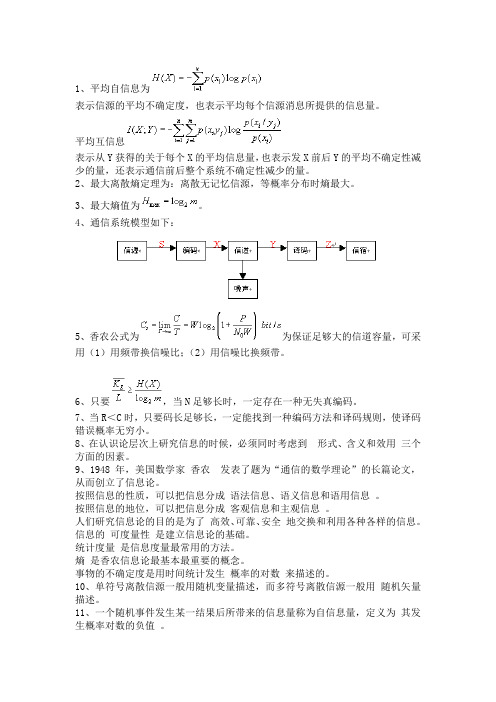

1、平均自信息为表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。

平均互信息表示从Y获得的关于每个X的平均信息量,也表示发X前后Y的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。

2、最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。

3、最大熵值为。

4、通信系统模型如下:5、香农公式为为保证足够大的信道容量,可采用(1)用频带换信噪比;(2)用信噪比换频带。

6、只要,当N足够长时,一定存在一种无失真编码。

7、当R<C时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。

8、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。

9、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。

按照信息的地位,可以把信息分成客观信息和主观信息。

人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。

信息的可度量性是建立信息论的基础。

统计度量是信息度量最常用的方法。

熵是香农信息论最基本最重要的概念。

事物的不确定度是用时间统计发生概率的对数来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。

12、自信息量的单位一般有 比特、奈特和哈特 。

13、必然事件的自信息是 0 。

14、不可能事件的自信息量是 ∞ 。

15、两个相互独立的随机变量的联合自信息量等于 两个自信息量之和 。

16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量 趋于变小 。

17、离散平稳无记忆信源X 的N 次扩展信源的熵等于离散信源X 的熵的 N 倍 。

18、离散平稳有记忆信源的极限熵,=∞H )/(lim 121-∞→N N N X X X X H 。

信息论与编码理论习题答案

第二章 信息量和熵2.2八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的信息速率.解:同步信息均相同,不含信息,因此 每个码字的信息量为 2⨯8log =2⨯3=6 bit因此,信息速率为 6⨯1000=6000 bit/s2。

3 掷一对无偏骰子,告诉你得到的总的点数为:(a ) 7; (b) 12。

问各得到多少信息量.解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1})(a p =366=61得到的信息量 =)(1loga p =6log =2。

585 bit (2) 可能的唯一,为 {6,6})(b p =361得到的信息量=)(1logb p =36log =5。

17 bit2.4 经过充分洗牌后的一副扑克(52张),问:(a) 任何一种特定的排列所给出的信息量是多少?(b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量?解:(a ) )(a p =!521信息量=)(1loga p =!52log =225.58 bit (b) ⎩⎨⎧⋯⋯⋯⋯花色任选种点数任意排列13413!13)(b p =1352134!13A ⨯=1352134C 信息量=1313524log log -C =13。

208 bit2.9随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的点数之和,Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。

解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立,则1x X =,21x x Y +=,321x x x Z ++=)|(Y Z H =)(3x H =log 6=2.585 bit )|(X Z H =)(32x x H +=)(Y H=2⨯(361log 36+362log 18+363log 12+364log 9+365log 536)+366log 6 =3。

信息论与编码考试题(附答案版)

1.按发出符号之间的关系来分,信源可以分为(有记忆信源)和(无记忆信源)2.连续信源的熵是(无穷大),不再具有熵的物理含义。

3.对于有记忆离散序列信源,需引入(条件熵)描述信源发出的符号序列内各个符号之间的统计关联特性3.连续信源X,平均功率被限定为P时,符合(正态)分布才具有最大熵,最大熵是(1/2ln(2 ⅇ 2))。

4.数据处理过程中信息具有(不增性)。

5.信源冗余度产生的原因包括(信源符号之间的相关性)和(信源符号分布的不均匀性)。

6.单符号连续信道的信道容量取决于(信噪比)。

7.香农信息极限的含义是(当带宽不受限制时,传送1bit信息,信噪比最低只需-1.6ch3)。

8.对于无失真信源编码,平均码长越小,说明压缩效率(越高)。

9.对于限失真信源编码,保证D的前提下,尽量减少(R(D))。

10.立即码指的是(接收端收到一个完整的码字后可立即译码)。

11.算术编码是(非)分组码。

12.游程编码是(无)失真信源编码。

13.线性分组码的(校验矩阵)就是该码空间的对偶空间的生成矩阵。

14.若(n,k)线性分组码为MDC码,那么它的最小码距为(n-k+1)。

15.完备码的特点是(围绕2k个码字、汉明矩d=[(d min-1)/2]的球都是不相交的每一个接受吗字都落在这些球中之一,因此接收码离发码的距离至多为t,这时所有重量≤t的差错图案都能用最佳译码器得到纠正,而所有重量≤t+1的差错图案都不能纠正)。

16.卷积码的自由距离决定了其(检错和纠错能力)。

(对)1、信息是指各个事物运动的状态及状态变化的方式。

(对)2、信息就是信息,既不是物质也不是能量。

(错)3、马尔可夫信源是离散无记忆信源。

(错)4、不可约的马尔可夫链一定是遍历的。

(对)5、单符号连续信源的绝对熵为无穷大。

(错)6、序列信源的极限熵是这样定义的:H(X)=H(XL|X1,X2,…,XL-1)。

(对)7、平均互信息量I(X;Y)是接收端所获取的关于发送端信源X的信息量。

信息论与编码考题标准答案

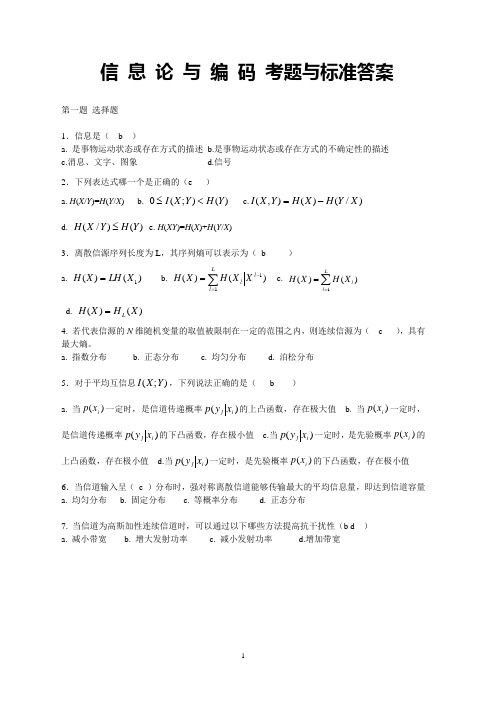

信 息 论 与 编 码 考题与标准答案第一题 选择题1.信息是( b )a. 是事物运动状态或存在方式的描述b.是事物运动状态或存在方式的不确定性的描述c.消息、文字、图象d.信号 2.下列表达式哪一个是正确的(e )a. H (X /Y )=H (Y /X )b. )();(0Y H Y X I <≤c.)/()(),(X Y H X H Y X I -=d. )()/(Y H Y X H ≤e. H (XY )=H (X )+H (Y /X )3.离散信源序列长度为L ,其序列熵可以表示为( b )a. )()(1X LH X H =b.c. ∑==Ll lXH X H 1)()(d. )()(X H X H L =4.若代表信源的N 维随机变量的取值被限制在一定的范围之内,则连续信源为( c ),具有最大熵。

a. 指数分布b. 正态分布c. 均匀分布d. 泊松分布 5.对于平均互信息);(Y X I ,下列说法正确的是( b )a. 当)(i x p 一定时,是信道传递概率)(i j x y p 的上凸函数,存在极大值b. 当)(i x p 一定时,是信道传递概率)(i j x y p 的下凸函数,存在极小值c.当)(i j x y p 一定时,是先验概率)(i x p 的上凸函数,存在极小值d.当)(i j x y p 一定时,是先验概率)(i x p 的下凸函数,存在极小值 6.当信道输入呈( c )分布时,强对称离散信道能够传输最大的平均信息量,即达到信道容量 a. 均匀分布 b. 固定分布 c. 等概率分布 d. 正态分布7.当信道为高斯加性连续信道时,可以通过以下哪些方法提高抗干扰性(b d ) a. 减小带宽 b. 增大发射功率 c. 减小发射功率 d.增加带宽第二题 设信源 ⎥⎦⎤⎢⎣⎡=⎥⎦⎤⎢⎣⎡6.04.0)(21x x X p X 通过一干扰信道,接收符号为Y={y 1,y 2},信道传递矩阵为⎥⎦⎤⎢⎣⎡43416165 求:(1) 信源 X 中事件 x 1 和 x 2 分别含有的自信息量。

信息论与编码理论习题答案

第二章 信息量和熵2.2八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的信息速率.解:同步信息均相同,不含信息,因此 每个码字的信息量为 2⨯8log =2⨯3=6 bit因此,信息速率为 6⨯1000=6000 bit/s2。

3 掷一对无偏骰子,告诉你得到的总的点数为:(a ) 7; (b) 12。

问各得到多少信息量.解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1})(a p =366=61得到的信息量 =)(1loga p =6log =2。

585 bit (2) 可能的唯一,为 {6,6})(b p =361得到的信息量=)(1logb p =36log =5。

17 bit2.4 经过充分洗牌后的一副扑克(52张),问:(a) 任何一种特定的排列所给出的信息量是多少?(b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量?解:(a ) )(a p =!521信息量=)(1loga p =!52log =225.58 bit (b) ⎩⎨⎧⋯⋯⋯⋯花色任选种点数任意排列13413!13)(b p =1352134!13A ⨯=1352134C 信息量=1313524log log -C =13。

208 bit2.9随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的点数之和,Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。

解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立,则1x X =,21x x Y +=,321x x x Z ++=)|(Y Z H =)(3x H =log 6=2.585 bit )|(X Z H =)(32x x H +=)(Y H=2⨯(361log 36+362log 18+363log 12+364log 9+365log 536)+366log 6 =3。

信息论与编码试卷_信息论与编码试卷题目及答案

最大熵值为组成一个马尔可夫链,且有,。

说明经数据处理后,一般只会增加信息的损失。

,它是高斯加性白噪声信道在单位时间内的信道容量,其值取决于由得,则解释无失真变长信源编码定理。

只要,当什么是保真度准则?对二元信源,其失真矩阵,求和?答:,所以有,而。

息出现前后没有关联,求熵;)假设黑白消息出现前后有关联,其依赖关系为:,,,,求其熵;)信源模型为)由得则)若,,求和;)),最佳输入概率分布为等概率分布。

信源空间为答:1)二元码的码字依序为:10,11,010,011,1010,1011,1000,1001。

平均码长,编码效率2)三元码的码字依序为:1,00,02,20,21,22,010,011。

平均码长,编码效率4.设有一离散信道,其信道传递矩阵为,并设,试分别按最小错误概率准则与最大似然译码准则确定译码规则,并计算相应的平均错误概率。

答:1)最小似然译码准则下,有,2)最大错误概率准则下,有,5.已知一(8,5)线性分组码的生成矩阵为。

求:1)输入为全00011和10100时该码的码字;2)最小码距。

6.设某一信号的信息传输率为5.6kbit/s,在带宽为4kHz的高斯信道中传输,噪声功率谱NO=5×10-6mw/Hz。

试求:(1)无差错传输需要的最小输入功率是多少?(2)此时输入信号的最大连续熵是多少?写出对应的输入概率密度函数的形式。

7.答:1)无错传输时,有即则2)在时,最大熵对应的输入概率密度函数为2)最大错误概率准则下,有,6.答:1)无错传输时,有即则2)在时,最大熵对应的输入概率密度函数为。

信息论与编码试卷及答案

信息论与编码试卷及答案⼀、概念简答题(每题5分,共40分)1.什么是平均⾃信息量与平均互信息,⽐较⼀下这两个概念的异同?2.简述最⼤离散熵定理。

对于⼀个有m个符号的离散信源,其最⼤熵是多少?3.解释信息传输率、信道容量、最佳输⼊分布的概念,说明平均互信息与信源的概率分布、信道的传递概率间分别是什么关系?4.对于⼀个⼀般的通信系统,试给出其系统模型框图,并结合此图,解释数据处理定理。

5.写出⾹农公式,并说明其物理意义。

当信道带宽为5000Hz,信噪⽐为30dB时求信道容量。

6.解释⽆失真变长信源编码定理。

7.解释有噪信道编码定理。

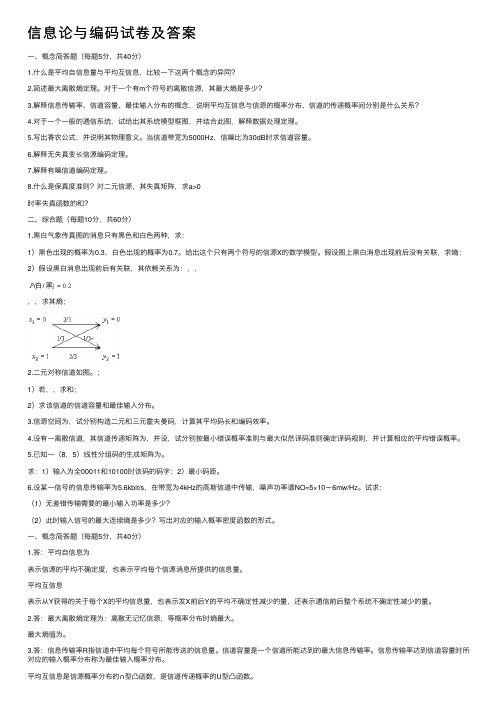

8.什么是保真度准则?对⼆元信源,其失真矩阵,求a>0时率失真函数的和?⼆、综合题(每题10分,共60分)1.⿊⽩⽓象传真图的消息只有⿊⾊和⽩⾊两种,求:1)⿊⾊出现的概率为0.3,⽩⾊出现的概率为0.7。

给出这个只有两个符号的信源X的数学模型。

假设图上⿊⽩消息出现前后没有关联,求熵;2)假设⿊⽩消息出现前后有关联,其依赖关系为:,,,,求其熵;2.⼆元对称信道如图。

;1)若,,求和;2)求该信道的信道容量和最佳输⼊分布。

3.信源空间为,试分别构造⼆元和三元霍夫曼码,计算其平均码长和编码效率。

4.设有⼀离散信道,其信道传递矩阵为,并设,试分别按最⼩错误概率准则与最⼤似然译码准则确定译码规则,并计算相应的平均错误概率。

5.已知⼀(8,5)线性分组码的⽣成矩阵为。

求:1)输⼊为全00011和10100时该码的码字;2)最⼩码距。

6.设某⼀信号的信息传输率为5.6kbit/s,在带宽为4kHz的⾼斯信道中传输,噪声功率谱NO=5×10-6mw/Hz。

试求:(1)⽆差错传输需要的最⼩输⼊功率是多少?(2)此时输⼊信号的最⼤连续熵是多少?写出对应的输⼊概率密度函数的形式。

⼀、概念简答题(每题5分,共40分)1.答:平均⾃信息为表⽰信源的平均不确定度,也表⽰平均每个信源消息所提供的信息量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1有一个二元对称信道,其信道矩阵如下图所示。

设该信道以 1500个二元符号/秒的速度传输输入符号。

现有一消息序列共有 14000个二元符号,并设在这消息中 P(0)=P(1)=1/2 。

问从信息传输的角度来考虑,10秒钟能否将这消息序列无失真地传送完?0.980.02____________ •10.98解答:消息是一个二元序列 ,且为等 概率分布,H(X)=1(bit/symbol)。

则该消息序列含有的信息量=下面计算该二元对称信道能传输的最大的信息传输速率: 信道传递矩阵为:0 98 0 02P0.02 0.98信道容量(最大信息传输率)为:C=1-H(P)=1-H(0.98)~ 0.8586bit/symbol得最大信息传输速率为:Rt疋1500符号/秒X 0.8586比特/符号〜1287.9比特/秒 沁1.288 X 103比特/秒此信道10秒钟能无失真传输得最大信息量= 10X Rt 疋1.288 X 104比特可见,此信道10秒能无失真传输得最大信息量小于这消息序列所含有的信息量,故从信息传输的角度来考虑,不可能在10秒钟将这消息无失真的传送完。

2、若已知信道输入分布为等概率分布,且有如下两个信道, 其转移概率矩阵分别为:12 1 2 0 01 2 1 20 0 0 0 0 00 1 2120 0 1 2 1 20 0 0 0 P 1 21 2 P 21 2 1 210 0 0 0 0 0 01 20 01 20 0 0 0 0 0 1 2 12试求这两个信道的信道容量,并问这两个信道是否有噪声?解答:(1) 由信道1的信道矩阵可知为对称信道 故 G log 2 4 H (舟 舟 0 0) 1bit / symbol H (X ) log 2 4 2bit / symbol C 1有熵损失,有噪声。

(2) 为对称信道,输入为等概率分布时达到信道容量 C 2 log 2 8 H (2 f 0 0 0 0 0 0) 2bit / symbolH (X ) C 2,无噪声3、已知随即变量 X 和Y 的联合分布如下所示:1即P(0)=P(1)=1/2 ,故信源 的熵为14000(bit/symbol)。

H( X HY H XY)H( X/Y H( Y/X )、I (X ; Y )4、有一个可以旋转的圆盘,盘面上被均匀的分成38份,用1,2,3 ,……,38数字标示,其中有2份涂绿色,18份涂黑色,圆盘停转后,盘面上指针指向某一数字和颜色。

(1、若仅对颜色感兴趣,计算平均不确定度; (2、若对颜色和数字都感兴趣,计算平均不确定度; (3、如果颜色已知,计算条件熵。

解:(1) H(色)=(2) P( 色数)=H(色数)= (3) H(数/ 色)=H(色数)-H(色)=5、在一个二进制信道中,信源消息集X={0,1},且P(0)=P(1),信宿的消息集 丫={0,1},信道传输概率 P (1/2 ) =1/4, P(0/1)=1/8 。

求:(1、在接收端收到y=0后,所提供的关于传输消息X 的平均条件互信息量l(X ; y=0).(2)该情况所能提供的平均互信息量l(X;Y).解:(1)P(ij)= P(i/j)=(2) 方法1:=6某一无记忆信源的符号集为 {0,1},已知p0=1/4, p 仁3/4(1) 求符号的平均熵(2、由100个符号构成的序列,求某一特定序列(例如有 m 个“0”和(100-m 、个“ 1 ”))的自信息量的表达式。

(3、计算(2)中的序列的熵。

解:(1) H(X)=s 2m H - (100 - -Log [扌⑶ I •:.:.1 ::.■ : ■ , 1 I :1 :| -I TI. -7、 一阶马氏链信源有三个符号 {u1,u2,u3},转移概率为:P(u1/u2)=1/2,P(u2/u2)=1/2,P(u3/u1)=0,P(u1/u2)=1/3,P(u2/u2)=0,解:(1)⑵ ⑶ ⑷H( X/Y ) = H (XY ) -- H (Y ) =1.811-1=0.811 H( Y/X ) = H (XY ) -- H (X ) =1.811-1=0.8118、设有一信源,它在开始时以p(a)=0.6,p(b)=0.3,P(c)=0.1的概率发出X1,如果X1为a时则X2为a,b,c 的概率为1/3;如果X1为b 时则X2为a,b,c 的概率为1/3;如果X1为c 时 则X2为a,b 的概率为1/2,而为c 的概率是0;而且后面发出X 的概率只与X -1有关。

又p(X i / X -i )=p(X2/ X1),i >3。

试利用马儿可夫信源的图示法画出状态转移图,并求出状态转移矩 阵和信源熵比P(j/i)=解方程组 得到 W 仁,W2= , W3=Lo/3 = 1.5&5H(X2/b)= Logi?) = 1J 劭/沪 Log© = 1H®(X)=W 1H(X2/^+W 2HCX2/b)+W 3H(X3/c)= 瞋①十-Log(3)十-LoO = 1.439S g49某信源符号有8个符号{u1,…u8},概率分别是1/2 , 1/4 , 1/8. ,1/16 ,1/32,1/64,1/128,1/128,编成这样的码: 000,001,010,011,100,101,110,111 。

求(1) 信源的符号熵H(U)(2) 出现一个“ 1”或一个“ 0”的概率; (3) 这样码的编码效率; (4) 相应的香农码和费诺玛; (5) 该码的编码效率?解:(1)H(U)=1111 1 1 1 1Log (2) Log(4) Log(8) Log(16) Log (32) Log(64)Log (128)Log(128)2 4 8 163264128128(2)每个信源使用3个二进制符号,出现0的次数为P(j/i)=1.984P(u3/u2)=2/3,P(u1/u3)=1/3, P(u2/u3)=2/3, P(u3/u3)=0,画出状态图并求出各符号稳定概率。

解:出现1的次数为1 - + 1-- -P 3■—+ 1- —4 1-—■+2 —+3 —= 0.5264 ®16 32 (54 J2S 128P(0)=P(1)=⑶(4)(5)香农码和费诺码相同平均码长为空--1 + --2 + --2+ --4 + —3+ — 6 + —7 + —— -了= 1.晁42 4 S 16 32 64 12S 12S编码效率为:10已知符号集{x1,x2,x3,…}为无限离散集合,他们出现的概率分别是p(x1)=1/2,p(x2)=1/4,p(x3)=1/8,p(xi)=1/2 1 '…。

(1)用香农编码方法写出各个符号的码字;(2)计算码字的平均信息传输率。

(3)计算信源编码效率。

3 解:(1) pi=累加概率为P i= 累加概率分别为累加概率0 0.5 0.75 0.875 0.938 0.969 0.984 0.992码长 1 2 3 4 5 6 7 8元码0 10 110 1110 11110 111110 1111110 11111110(2— 1 1 1 1 1 f A Hp<)= - Log® 十一L»g(4)十一LogfS)十一L«g(16)十“”心..十一1■礎*2 十2 4 S ]C .,iR = bit/ 码(3)编码效率R= 100 %2/3 1/311该二进制对称信道的概率转移矩阵为1/3 2/3(1 )若p(x0)=3/4,p(x1)=1/4, 求H(X),H(X/Y),H(Y/X) 和l(X;Y)(2)求该信道的信道容量及其达到信道容量时的输入概率分布。

H(XY)=HOZT)=HP<V)-H(Y> 1.73- 0.PS -0.75H(¥/X)=H(XV)-H(X)= 1.73- 0.SU = 0i510I(X:Y)^H^H(X/YJ P0.S11 -073 = O L OSI2O i /1 \® C=bgQ)坷ijLagWi沪L■翻+ -Log^-J + -叫亍丿-0.082 嗣=呛1” I12、某信源发送端有2个符号,xi,i=1,2,p(xi)=a, 每秒发出一个符号。

接收端有yj,j=1,2,3, 转移概率矩阵如下:(1> p(x0)=3/4 p(x1 )=1/43种符号平均码长为:码字的平均信息传输率为L? “呵+;#応L谊⑵讥“晌二1.731/2 1/2 0 1/2 1/4 1/4(1 )计算接收端的平均不确定度; (2 )计算由于噪声产生的不确定度 H(Y/X);(3)计算信道容量解:(1)—OL弘宀沖如亠pfy2> -C 十 1(1 一 e) T L(x.十丄 P(y3>-(l -a)2 A 4 44接收端的不确定度为:<1 —(X & 5血十韵- 4(1 1■Ct + - \4 4Log[l -韵 4(1 - Gt) LogR 十 ' (1 一曙)Lt 目凹 4- — (1 - (X)Lpg(4)4 A⑶叭¥FH°)-H 的二-1±±1■□謝 + R -L 总1 —韵]—-LJ U 44 J \22 J3 1 + alog[l 十 aj 1 - cz log(j - a,)=0得到得13发送端有3种等概率符号(x1,x2,x3 ) ,p(xi)=1/3,接收端收到3种符号(y1,y2,y3)信道转移概率矩阵如下:(1) 求接收端收到一个符号后得到的信息量H(Y);(2)计算噪声熵H(Y/X);⑶计算当接收到端收到一个符号y2的错误率;(4) 计算从接收端看的平均错误率; (5)计算从发送端看的平均错误率;1-——=a)2丿LIp(yD=H(Y)=十购-=32+ — l-Log—H(Y/X)=—Lr'Qg^T) + —CCrLogZ)十 0十一扣-X)4logt254 1 口创?)(6)从转移矩阵中你能看出信道的好坏吗:(7)计算发送端的 H(X)和H(X/Y)。

解:(1)条件概率,联合概率,后验概率(2)H(Y/X)=1 MoA 1 (i3 / io Ad -- Log — d ------ Log — +—LxigflO) -------- Lod — ■ 1175 10 I M 丿 10 \ 3) 30 10 \ 9 )(3)当接收为y2,发为x1时正确,如果发的是x1和x3为错误,各自的概率为:P(x1/y2)= ,P(x2/y2)= ,P(x3/y2)=其中错误概率为:Pe=P(x1/y2)+P(x3/y2)=(3)平均错误概率为 (4) 仍为 0.733 (5)此信道不好原因是信源等概率分布,从转移信道来看正确发送的概率x1-y1的概率0.5有一半失真 x2-y2 的概率0.3有失真严重x3-y3的概率0完全失真(7)若某信源输出两个等该消息 X 1, X 2,现在用信道输入符号集对 X 1, X 2进行编码,W=00, W=11代表x i ,X 2。