计算机视觉与单视测量

基于单目视觉的实时测距方法研究论文

基于单目视觉的实时测距方法研究论文摘要:测距是计算机视觉领域中的重要问题之一,在许多应用中都有广泛的应用。

本文提出了一种基于单目视觉的实时测距方法。

该方法利用单目相机拍摄到的图像进行目标的距离估计,不需要额外的传感器或设备。

首先,通过标定相机获取相机的内参数矩阵和畸变参数。

然后,使用特征点匹配算法对图像中的特征进行提取和匹配,得到特征点的对应关系。

接下来,利用三角测量原理计算出目标特征点在相机坐标系下的深度值。

最后,通过相机的内参数矩阵和深度值可以得到目标物体在相机坐标系下的三维坐标,从而实现了测距。

实验结果表明,该方法能够在实时场景中实现准确的测距,具有很大的应用潜力。

关键词:单目视觉,测距,内参数矩阵,特征点匹配,三角测量1. 引言随着计算机视觉技术的发展,测距问题在很多领域中得到了广泛的研究和应用。

利用视觉传感器进行测距是一种常见的方法,它可以在没有额外传感器的情况下实现目标的距离估计。

单目视觉是一种简单且成本相对较低的测距方式,因此在实际应用中具有重要的意义。

2. 方法本文提出的实时测距方法基于单目视觉,核心原理是利用特征点匹配和三角测量。

首先,通过标定相机获取相机的内参数矩阵和畸变参数。

内参数矩阵包括焦距和像素尺寸等参数,畸变参数用于修正图像的畸变。

然后,利用特征点匹配算法对图像中的特征进行提取和匹配。

特征点的提取可以使用SIFT、SURF等算法,匹配可以使用最近邻算法或RANSAC算法。

在特征点匹配完成后,可以得到特征点的对应关系。

接下来,根据三角测量原理计算出目标特征点在相机坐标系下的深度值。

三角测量原理利用目标在不同视角下的投影关系,通过三角形的边长比例计算出目标的深度。

最后,通过相机的内参数矩阵和深度值可以得到目标物体在相机坐标系下的三维坐标,从而实现了测距。

3. 实验结果对于本方法的实验结果进行了验证。

选取了不同距离的目标物体进行测距实验,并与实际距离进行比较。

结果表明,本方法能够在实时场景中实现准确的测距,与实际距离具有较小的误差。

对计算机视觉的理解

对计算机视觉的理解什么是计算机视觉计算机视觉是人工智能领域的一个重要分支,简单来说,它要解决的问题就是:让计算机看懂图像或者视频里的内容。

比如:图片里的宠物是猫还是狗?图片里的人是老张还是老王?视频里的人在做什么事情?更进一步地说,计算机视觉就是指用摄影机和电脑代替人眼对目标进行识别、跟踪和测量等,并进一步做图形处理,得到更适合人眼观察或传送给仪器检测的图像。

作为一个科学学科,计算机视觉研究相关的理论和技术,试图建立能够从图像或者多维数据中获取高层次信息的人工智能系统。

从工程的角度来看,它寻求利用自动化系统模仿人类视觉系统来完成任务。

计算机视觉的最终目标是使计算机能像人那样通过视觉观察和理解世界,具有自主适应环境的能力。

但能真正实现计算机能够通过摄像机感知这个世界却是非常之难,因为虽然摄像机拍摄的图像和我们平时所见是一样的,但对于计算机来说,任何图像都只是像素值的排列组合,是一堆死板的数字。

如何让计算机从这些死板的数字里面读取到有意义的视觉线索,是计算机视觉应该解决的问题。

计算机视觉的基本原理用过相机或手机的都知道,计算机擅长拍出有惊人保真度和细节的照片,从某种程度上来说,计算机的人工“视觉”比人类与生自来的视觉能力强多了。

但正像我们平日所说的“听见不等于听懂”一样,“看见”也不等于“看懂”,要想让计算机真正地“看懂”图像,那就不是一件简单的事情了。

图像是一个大像素网格,每个像素有颜色,颜色是三种基色的组合:红,绿,蓝。

通过组合三种颜色的强度——即叫做RGB值,我们可以得到任何颜色。

最简单的、最适合拿来入门的计算机视觉算法是:跟踪一个有颜色的物体,比如一个粉色的球,我们首先记下球的颜色,保存最中心像素的RGB值,然后给程序喂入图像,让程序找最接近这个颜色的像素。

算法可以从左上角开始,检查每个像素,计算和目标颜色的差异。

检查了每个像素后,最贴近的一部分像素,很可能就是球所在的像素。

这个算法并不限制于在这单张图片上运行,我们可以把算法运行在视频的每一帧图像上,跟踪球的位置。

基于计算机视觉的精密测量技术

ห้องสมุดไป่ตู้

机 电 产 品 开笈 与刨 斩

Development& Innovation of Machinery & Electrical Products

维普资讯

Vo1.21,No.1 Jan..2008

基 于计算机视 觉的精密测量技术

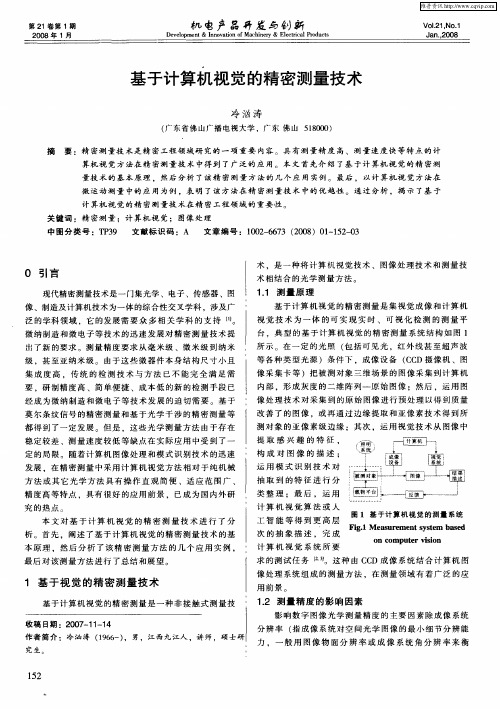

1.1 测 量 原 理 基 于计算 机视 觉 的精密 测量 是集 视觉 成像 和计 算机

视 觉 技 术 为 一 体 的 可 实 现 实 时 、 可 视 化 检 测 的 测 量 平 台 。典 型 的 基 于 计 算 机 视 觉 的 精 密 测 量 系 统 结 构 如 图 1 所 示 。在 一 定 的 光 照 (包 括 可 见 光 ,红 外 线 甚 至 超 声 波 等 各种 类型 光源 )条件 下 ,成像设 备 (CCD摄像 机 、图

基于计 算机 视觉 的精密 测量 是一 种非 接触 式测 量技 1.2 测 量 精 度 的 影 响 因 素

影 响 数 字 图像 光 学 测 量 精 度 的 主 要 因 素 除 成 像 系 统

收 稿 日期 :2007—11—14

分 辨 率 (指 成 像 系 统 对 空 间 光 学 图 像 的 最 小 细 节 分 辨 能

运 用 模 式 识 别 技 术 对

抽 取 到 的 特 征 进 行 分

类 整 理 :最 后 , 运 用

计 算 机 视 觉 算 法 或 人

图 1 基 于计 算机 视觉 的测量 系统 工 智 能 等 得 到 更 高 层

Fig.1 M easurem ent system bas ed

次 的 抽 象 描 述 , 完 成

冷 汹 涛

计算机视觉

计算机视觉计算机视觉是一门研究如何使机器“看”的科学,更进一步的说,就是是指用摄影机和电脑代替人眼对目标进行识别、跟踪和测量等机器视觉,并进一步做图形处理,用电脑处理成为更适合人眼观察或传送给仪器检测的图像。

作为一个科学学科,计算机视觉研究相关的理论和技术,试图建立能够从图像或者多维数据中获取‘信息’的人工智能系统。

这里所指的信息指Shannon定义的,可以用来帮助做一个“决定”的信息。

因为感知可以看作是从感官信号中提取信息,所以计算机视觉也可以看作是研究如何使人工系统从图像或多维数据中“感知”的科学。

目录1定义2解析3原理4相关5现状6用途7异同8问题9系统10要件11会议12期刊1定义计算机视觉是使用计算机及相关设备对生物视觉的一种模拟。

它的主要任务就是通过对采集的图片或视频进行处理以获得相应场景的三维信息,就像人类和许多其他类生物每天所做的那样。

计算机视觉是一门关于如何运用照相机和计算机来获取我们所需的,被拍摄对象的数据与信息的学问。

形象地说,就是给计算机安装上眼睛(照相机)和大脑(算法),让计算机能够感知环境。

我们中国人的成语"眼见为实"和西方人常说的"One picture is worth ten thousand words"表达了视觉对人类的重要性。

不难想象,具有视觉的机器的应用前景能有多么地宽广。

计算机视觉既是工程领域,也是科学领域中的一个富有挑战性重要研究领域。

计算机视觉是一门综合性的学科,它已经吸引了来自各个学科的研究者参加到对它的研究之中。

其中包括计算机科学和工程、信号处理、物理学、应用数学和统计学,神经生理学和认知科学等。

2解析视觉是各个应用领域,如制造业、检验、文档分析、医疗诊断,和军事等领域中各种智能/自主系统中不可分割的一部分。

由于它的重要性,一些先进国家,例如美国把对计算机视觉的计算机视觉与其他领域的关系研究列为对经济和科学有广泛影响的科学和工程中的重大基本问题,即所谓的重大挑战(grand challenge)。

视觉测量流程及原理

视觉测量流程及原理

视觉测量是一种基于计算机视觉技术的高精度测量方法,可以在不接触被测对象的情况下实现对其尺寸、形状、位置等参数的测量。

视觉测量在制造、质检、医疗、安防等领域具有广泛应用。

视觉测量的流程主要包括图像采集、图像处理、特征提取、测量计算等步骤。

首先通过相机将被测对象的图像采集下来,然后进行图像处理,包括去噪、增强、分割等步骤,以便更好地提取出被测对象的特征。

接下来进行特征提取,通过算法提取出被测对象的边缘、角点、圆心等特征点。

最后进行测量计算,将提取到的特征点输入到测量算法中,计算出被测对象的尺寸、形状、位置等参数。

视觉测量的原理主要是利用相机成像原理和数字图像处理技术。

相机拍摄被测对象的图像,将图像转换成数字信号,传输到计算机上进行处理。

通过数字图像处理技术对图像进行预处理、特征提取和测量计算,实现了对被测对象的高精度测量。

总之,视觉测量是一种高精度、无接触的测量方法,具有广泛的应用前景。

了解视觉测量的流程和原理,可以更好地应用该技术,提高测量效率和精度。

- 1 -。

非接触测距法

相关文献:基于Matlab的轮胎花纹图像反求设计系统

文献中通过一张灰度层次不同的图片,采用由图像明暗度恢复形状的方式,还原轮胎的3D模型

算法不同,精度不同,并且对环境光照要求较高

采用机器识别的方式,相对来说影响因素较少,发展前景较大;如果只采用拍照的方式,操作简单;与计算机技术相结合,测量更为精确

只采用拍照方式高精度测量时,对算法要求非常高,目前算法质量很难达到所要求的程度;一般来说,通常采用激光传感器和计算机配合的方式,成本增加

应用于倒车提醒、建筑工地、工业现场等的距离测量。

超声波测距迅速、方便,且不受光线等因素影响,价格低廉,一般价格从几十元到几百元不等。

由于超声波受周围环境影响较大,当障碍物较多时,反射回来的声波较多,干扰较多,易报错,所以一般测量距离比较短(80m左右),测量精度比较低。测量精度cm。

激光测距法

激光测距(laser distance measuring)是以激光器作为光源进行测距。根据激光工作的方式分为连续激光器和脉冲激光器;气体激光器工作于连续输出状态,用于相位式激光测距;半导体激光器,用于红外测距;固体激光器,用于脉冲式激光测距。

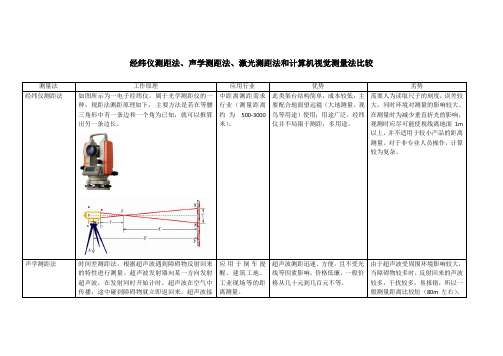

经纬仪测距法、声学测距法、激光测距法和计算机视觉测量法比较

测量法

工作原理

应用行业

优势

劣势

经纬仪测距法

如图所示为一电子经纬仪,属于光学测距仪的一种;视距法测距原理如下,主要方法是若在等腰三角形中有一条边和一个角为已知,就可以推算出另一条边长。

中距离测距需求行业(测量距离约为500-3000米)。

此类架台结构简单,成本较低,主要配合地面望远镜(大地测量、观鸟等用途)使用;用途广泛,经纬仪并不局限于测距,多用途。

单目摄像头测距原理

单目摄像头测距原理一、背景介绍单目摄像头是一种常用的视觉传感器,可以通过图像处理来获取物体的距离信息。

本文将详细介绍单目摄像头测距的原理以及相关技术。

二、单目摄像头测距的原理单目摄像头测距主要基于三角测距原理,通过获取物体在图像中的像素变化或视差来计算物体的距离。

以下是单目摄像头测距的基本原理:1. 视差原理视差是通过观察物体在两个不同位置下的图像差异来测量物体距离的方法之一。

当我们用一只眼睛观察距离较近的物体时,可以观察到物体在两个眼睛之间的位置差异。

单个摄像头可以模拟这个过程,通过分析图像中的像素差异来计算物体的距离。

2. 相机标定在进行单目摄像头测距之前,首先需要进行相机标定。

相机标定是通过确定相机的内外参数来建立摄像头与真实世界之间的转换关系。

通过相机标定可以得到相机的焦距、畸变参数等信息,为后续的测距工作提供基础。

3. 物体特征提取在进行测距之前,需要首先对物体进行特征提取。

常用的物体特征包括角点、边缘等。

通过提取物体的特征点,可以提高测距的准确性。

4. 视差计算视差计算是单目摄像头测距的关键步骤。

通过对特征点的像素坐标进行计算,可以得到物体在图像中的视差值。

视差值与物体的距离成反比,即视差越大,物体距离越近。

5. 距离计算在计算得到视差值之后,可以通过已知的相机参数和三角测量原理来计算物体的距离。

根据视差与物体距离的关系,可以建立视差与实际距离之间的映射关系。

根据此映射关系,可以通过视差值计算出物体的实际距离。

三、单目摄像头测距的应用单目摄像头测距技术在许多领域都有广泛的应用。

以下是几个常见的应用场景:1. 智能驾驶在自动驾驶领域,单目摄像头常用于车辆和行人的距离测量。

通过测量前方物体的距离,可以帮助车辆做出相应的决策,如避障、跟车等。

2. 工业自动化在工业自动化中,单目摄像头可以用于测量物体的距离和尺寸。

通过测量物体的距离,可以实现自动化生产线上的物料识别和定位,提高生产效率和质量。

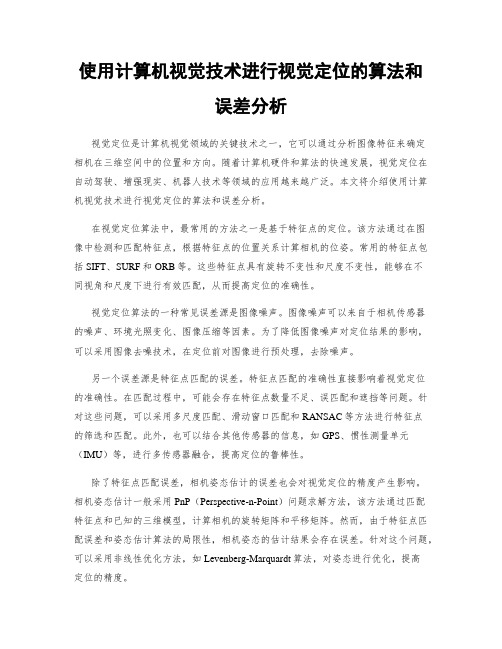

使用计算机视觉技术进行视觉定位的算法和误差分析

使用计算机视觉技术进行视觉定位的算法和误差分析视觉定位是计算机视觉领域的关键技术之一,它可以通过分析图像特征来确定相机在三维空间中的位置和方向。

随着计算机硬件和算法的快速发展,视觉定位在自动驾驶、增强现实、机器人技术等领域的应用越来越广泛。

本文将介绍使用计算机视觉技术进行视觉定位的算法和误差分析。

在视觉定位算法中,最常用的方法之一是基于特征点的定位。

该方法通过在图像中检测和匹配特征点,根据特征点的位置关系计算相机的位姿。

常用的特征点包括SIFT、SURF和ORB等。

这些特征点具有旋转不变性和尺度不变性,能够在不同视角和尺度下进行有效匹配,从而提高定位的准确性。

视觉定位算法的一种常见误差源是图像噪声。

图像噪声可以来自于相机传感器的噪声、环境光照变化、图像压缩等因素。

为了降低图像噪声对定位结果的影响,可以采用图像去噪技术,在定位前对图像进行预处理,去除噪声。

另一个误差源是特征点匹配的误差。

特征点匹配的准确性直接影响着视觉定位的准确性。

在匹配过程中,可能会存在特征点数量不足、误匹配和遮挡等问题。

针对这些问题,可以采用多尺度匹配、滑动窗口匹配和RANSAC等方法进行特征点的筛选和匹配。

此外,也可以结合其他传感器的信息,如GPS、惯性测量单元(IMU)等,进行多传感器融合,提高定位的鲁棒性。

除了特征点匹配误差,相机姿态估计的误差也会对视觉定位的精度产生影响。

相机姿态估计一般采用PnP(Perspective-n-Point)问题求解方法,该方法通过匹配特征点和已知的三维模型,计算相机的旋转矩阵和平移矩阵。

然而,由于特征点匹配误差和姿态估计算法的局限性,相机姿态的估计结果会存在误差。

针对这个问题,可以采用非线性优化方法,如Levenberg-Marquardt算法,对姿态进行优化,提高定位的精度。

此外,还有其他一些误差源需要考虑。

例如,图像畸变会对特征点的位置计算产生影响,可以通过相机校准和去畸变技术来解决。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2012年11月3日星期六来自32. 计算机视觉发展

• 20世纪50年代归入模式识别----主要集中在二维图像分析和识 别上,如,光学字符识别,工件表面、显微图片和航空图片的 分析和解释等. •60年代MIT 的Roberts通过计算机程序从数字图像中提取出诸如 立方体、楔形体、棱柱体等多面体的三维结构,并对物体形状 及物体的空间关系进行描述.Roberts 的研究工作开创了以理解 三维场景为目的的三维计算机视觉的研究.Roberts对积木世界 的创造性研究给人们以极大的启发,许多人相信,一旦由白色 积木玩具组成的三维世界可以被理解,则可以推广到理解更复 杂的三维场景. •70年代,已经出现了一些视觉应用系统.70年代中期,麻省理 工学院(MIT)人工智能(AI)实验室正式开设“计算机视觉” ( Machine Vision) 课程,由B.K.P.Horn教授讲授.

2012年11月3日星期六

8

3.1 信息处理三个层次

表 1-1 计算理论

表示和算法

硬件实现

计算的目的是什么? 为什么这一计算是合适的? 执行计算的策略是什么?

如何实现这个计算理论? 在物理上如何实现 输入、输出的表示是什么? 这些表示和算法? 表示与表示之间的变换是什么?

2012年11月3日星期六

2012年11月3日星期六

10

表1-2 由图像恢复形状信息的表示框架

名 称 图像 光强表示 目 的 基 元 图像中每一点的强度值

基元图

表示二维图像中的重要信息, 零交叉,斑点,端点和不连续 主要是图像中的强度变化位置 点,边缘片断,有效线段,组 及其几何分布和组织结构 合群,曲线组织,边界

在以观测者为中心的坐标系中 局部表面朝向(“针”基元) ,表示可见表面的方向、深度 离观测者的距离 值和不连续的轮廓 深度上的不连续点 表面朝向的不连续点 在以物体为中心的坐标系中, 用由体积基元和面积基元构成 的模块化多层次表示,描述形 状及其空间组织形式. 分层次组成若干三维模型,每 个三维模型都是在几个轴线空 间的基础上构成的,所有体积 基元或面积形状基元都附着在 轴线上.

9

3.2 视觉表示框架

第一阶段(也称为早期阶段)是将输入的原始图像进行处理, 抽取图像中诸如角点、边缘、纹理、线条、边界等基本特 征,这些特征的集合称为基元图(primitive sketch); 第二阶段(中期阶段)是指在以观测者为中心的坐标系中, 由输入图像和基元图恢复场景可见部分的深度、法线方向、 轮廓等,这些信息的包含了深度信息,但不是真正的物体 三维表示,因此,称为二维半图(2.5 dimensional sketch); 第三阶段(后期阶段)是在以物体为中心的坐标系中,由输 入图像、基元图、二维半图来恢复、表示和识别三维物体。

2012年11月3日星期六

28

5. 计算机视觉的研究内容

一、输入设备(input device) 包括成像设备和数 字化设备.成象设备是指通过光学摄像机或红外、激光、 超声、X射线对周围场景或物体进行探测成象,得到关 于场景或物体的二维或三维数字化图像. 二、低层视觉(low level) 主要是对输入的原始 图像进行处理.这一过程借用了大量的图像处理技术 和算法,如图像滤波、图像增强、边缘检测等,以便 从图像中抽取诸如角点、边缘、线条、边界以及色彩 等关于场景的基本特征;这一过程还包含了各种图像 变换(如校正)、图像纹理检测、图像运动检测等.

2.5维图

3维模型表示

2012年11月3日星期六

11

3.3 Marr 视觉理论的不足

Marr理论是计算机视觉研究领域的划时代成就,但该 理论不是十分完善的,许多方面还有争议.比如:

视觉处理框架基本上是自下而上,没有反馈;

没有足够地重视知识的应用.

Marr理论给了我们研究计算机视觉许多珍贵的哲学思 想和研究方法,同时也给计算机视觉研究领域创造了 许多研究起点。

2012年11月3日星期六

23

具有立体视觉的机器人

2012年11月3日星期六

24

人头部跟踪演示

2012年11月3日星期六

25

MIT Media Lab ,与虚拟生物交互演示

2012年11月3日星期六

26

基于恢复图象序列的五角大楼三维重建

2012年11月3日星期六

27

基于图象序列的三维人脸恢复

计算机视觉的单视测量

主讲教师:种衍文 apollobest@ 武汉大学测绘遥感国家重点实验室

2012年11月3日星期六

1

课程教材

参考教材: 贾云得 《机器视觉》科学出版社,2000 参考书目: 1、《图像处理、分析与机器视觉》(第二版) M.Sonka,V.Hlavac,R.Boyle著,艾海舟等译, 人民邮电出版社,2003 2、《机器视觉教程》W.E.Snyder,H.Qi著

2012年11月3日星期六

5

研究热潮是从 20世纪80年代开始的,到了80 年代中期,计算机视觉获得了蓬勃发展,新 概念、新方法、新理论不断涌现,比如,基 于感知特征群的物体识别理论框架,主动视 觉理论框架,视觉集成理论框架等. Marr的计算理论

2012年11月3日星期六

6

许多会议论文集都反应了该领域的最新进展,比如:

2012年11月3日星期六

31

7. 计算机视觉与其它学科领域的关系

(1)图像处理:图像处理通常是把一幅图像变换成另外一幅 图像,也就是说,图像处理系统的输入是图像,输出仍然是 图像,信息恢复任务则留给人来完成 (2)计算机图形学:通过几何基元,如线、圆和自由曲面, 来生成图像,它在可视化(Visualization)和虚拟现实(Virtual Reality)中起着很重要的作用.计算机视觉正好是解决相反的 问题,即从图像中估计几何基元和其它特征.因此,计算机 图形学属于图像综合,计算机视觉属于图像分析. (3)模式识别:用于识别各种符号、图画等平面图形.模式 一般指一类事物区别于其它事物所具有的共同特征。模式识 别方法有统计方法和句法方法两种,统计方法是指从模式抽 取一组特征值,并以划分特征空间的方法来识别每一个模式

2012年11月3日星期六

12

计算机视觉应用系统 照明

成像装置

计算机视觉

场景

图象

描述

应用反馈

2012年11月3日星期六

13

4. 计算机视觉的应用

• • • • • • • • 零件识别与定位 (工业生产线) 产品检验 (纺织工业棉花质量检验) 移动机器人导航(星球机器人) 遥感图像分析(植被分析) 医学图像分析(骨骼定位) 安全鉴别、监视与跟踪(门禁系统) 国防系统(目标自动识别ATR与目标跟踪) 其它(动画、体育、考古)

四、高层视觉(high level)

主要任务是在以物体 为中心的坐标系中,在原始输入图像、图像基本特征、 2.5维图的基础上,恢复物体的完整三维图,建立物体三 维描述,识别三维物体并确定物体的位置和方向.

2012年11月3日星期六

30

6. 计算机视觉研究面临的困难

(1) 图像多义性: 三维场景被投影为二维图像,深度和 不可见部分的信息被丢失,因而会出现不同形状的三维物 体投影在图像平面上产生相同图像的问题.另外,在不同 角度获取同一物体的图像会有很大的差异. (2)环境因素影响:场景中的诸多因素,包括照明、物体 形状、表面颜色、摄像机以及空间关系变化都会对成像有 影响, (3)知识导引: 同样的图像在不同的知识导引下,将会 产生不同的识别结果.. (4)大量数据: 灰度图像,彩色图像,深度图像的信息 量十分巨大,巨大的数据量需要很大的存贮空间,同时不 易实现快速处理.

还有许多学术期刊也包含了这一领域的最新研究成果, 如:

IEEE Trans. on Pattern Analysis and Machine Intelligence(PAMI); Computer Vision, Graphics, and Image Processing(CVGIP); IEEE Trans. on Image Processing; IEEE Trans. on Systems, Man, and Cybernetics(SMC); Machine Vision and Applications; Int. J on Computer Vision(IJCV); Image and Vision Computing; Pattern Recognition.

2012年11月3日星期六

32

(4)人工智能(AI):涉及到智能系统的设计和智能计算的 研究.在经过图像处理和图像特征提取过程后,接下来要用 人工智能方法对场景特征进行表示,并分析和理解场景.人 工智能有三个过程:感知、认知和行动.. (5)人工神经网络(ANNs):是一种信息处理系统,它是 由大量简单的处理单元(称为神经元)通过具有强度的连接 相互联系起来,实现并行分布式处理(PDP).人工神经网 络的最大特点是可以通过改变连接强度来调整系统,使之适 应复杂的环境,实现类似人的学习、归纳和分类等功能. (6)神经物理学与认知科学:将人类视觉作为主要的研究对 象.计算机视觉中已有的许多方法与人类视觉极为相似.许 多计算机视觉研究者对研究人类视觉计算模型比研究计算机 视觉系统更感兴趣,希望计算机视觉更加自然化,更加接近 生物视觉

障碍物探测示意图

Rocky7 视觉系统对场景的深度恢复

2012年11月3日星期六

19

CMU月球探测实验车Nomad漫游者

2012年11月3日星期六

20

月球探测实验车Nomad漫游者

2012年11月3日星期六

21

足球机器人

昆虫机器人

足球机器人

2012年11月3日星期六

22

日本

Honda

仿人机器人

2012年11月3日星期六

4