用乘幂法求解A的特征值和特征向量

数值分析--第四章--特征值特征向量计算(乘幂法)

数值分析--第四章--特征值特征向量计算(乘幂法)

摘要:n阶⽅阵A满⾜AX=λx,λ为矩阵A的特征值,x为特征值对应的特征向量。

⼀.乘幂法(求模最⼤特征值及对应特征向量)

设矩阵A有n个相性⽆关的特征向量x1,x2,x3,.....xn,相应的特征值λ1,λ2,λ3,.....λn(由⼤到⼩排列)。

迭代法引⼊:上⼀章学了迭代法求解线性⽅程组Ax=b的解,给定任⼀的初始值v0,不断迭代可以得到Ax=b的解。

同理,给定任⼀⾮零的n维向量v0,不断迭代可以 得到矩阵A的特征向量,

对于初始向量v0可以由A的n个线性⽆关的特征向量表⽰:

带⼊迭代⽅程中:

当迭代次数k趋近于⽆穷⼤时,可得到最⼤特征值λ1对应的特征向量a1x1(与x1线性相关)

同理,当迭代次数趋近于⽆穷⼤时,可得到绝对值最⼤的特征值,λ1

其中,m表⽰向量中的绝对值最⼤的那个元素值

如何利⽤迭代法求解按模最⼤特征值和特征向量

说明:

1.初始值:我们给定初始值x0=[1,1,1]^T,取特征值1

2.第⼀次迭代:

对应的近似特征值取:

3.第⼆次迭代:

⼆.改进乘幂法

这个规范化处理的⽬的:防⽌数据溢出或是数据消失

从上⾯可以看出,改进乘幂法即是每次迭代出的特征向量都进⾏⼀次规范化处理 。

幂法求特征值和特征向量

幂法求特征值和特征向量

幂法是一种用于求解特征值和特征向量的迭代算法。

它可以应用于任何具有特征值和特征向量的方阵,并且在实际应用中被广泛使用。

首先,我们需要了解什么是特征值和特征向量。

对于一个n阶方阵A,如果存在一个非零向量x,使得Ax = λx,其中λ是一个实数,那么λ称为A的特征值,x称为对应于特征值λ的特征向量。

幂法的基本思想是通过迭代过程得到一个向量序列,使得每一次迭代后的向量越来越接近于所需的特征向量。

具体步骤如下:

1. 选择一个非零向量b作为初始向量。

2. 迭代计算b的下一个近似向量b' = Ab,即将初始向量乘以

矩阵A。

3. 归一化向量b',即将b'除以其模长,得到新的向量b。

4. 重复步骤2和步骤3,直到向量b的变化趋于稳定。

在每次迭代过程中,向量b的模长会越来越接近于最大的特征值。

此外,向量b也收敛到与最大特征值对应的特征向量。

需要注意的是,幂法只能找到矩阵A的最大特征值和对应的特征向量。

如果需要找到其他特征值和特征向量,可以通过将矩阵A进行位移变换,使得所需的特征值成为矩阵A的最大特征值。

幂法的收敛速度取决于矩阵A的特征值的大小差异。

如果特征值之间的差异很大,那么幂法将很快收敛。

然而,如果特征值之间的差异很小,那么幂法的收敛速度将较慢。

总之,幂法是一种简单而有效的方法,用于求解矩阵的特征值和

特征向量。

它在很多实际问题中都得到了广泛的应用,例如在机器学习、信号处理和物理学等领域。

哈尔滨工业大学2013秋数值分析试题及答案

xi

f xi

-1 1

0 0

2 16

-1 , 2 1)试求 f ( x) 在 上的 Hermite 插值多项式 H ( x) ,使之满足下列条件:

H ( xi ) f ( xi ), i 0,1, 2

,

H ( x1 ) 0

R( x) f ( x) H ( x ) f ( 4 )( ) ( x 1) x 2 ( x 2) 4! ,

(1)求出该格式的局部截断误差首项和首项系数; (2)分析该格式的收敛性; (3)讨论该格式的绝对稳定性,指出绝对稳定区间。

Cr

(在局部截断误差中 (参考定理: 设

p p 1 r r 1 1 [ (i) ai r (i) bi ] , r 2,3, r! i 0 i 1

(1) 0, (0) 0, (2) 0, '(0) 0, ( x) 0

故 (t ) 有 5 个零点, (4) (t ) 至少有一个零点 :

(4) ( ) f (4) ( ) 4!k ( x) 0

所以 k ( x)

f (4) ( ) ,余项表达式为 4!

0.15625 0.15625 x0 [1.6,1.2] , H 0 F '[ x 0 ]1 0.208333 0.208333

x1 [1.58125,1.225] y 0 [0.000976562, 0.120273] r 0 [0.01875, 0.025] 0.154345 0.154345 H1 0.206428 0.210238 x 2 [1.58114,1.22474] y1 [0.000977866, 0.000291477] r1 [0.000108524, 0.000259077] 0.150145 0.150145 H2 0.202228 0.214438

计算方法第七章(特征值与特征向量)

( j p, q) i 1, 2, , n

最后,雅可比方法的计算步骤可以归纳为: (1)确定非对角绝对值最大元位置(p,q),并计算sin和 cos的值; (2)计算迭代矩阵的元素;

(3)计算特征向量;

(4)与计算精度进行比较,以决定第三节 QR 分解方法 3.1 QR 分解 设 u 为n维实单位向量,称下面矩阵为Householder矩阵:

则

(2) (3) 1 a12 a13 (3) a 2 23 (3) Q2 A1 Q2Q1 A a33 (3) 0 a 3n

埃特金加速: 可以证明:乘幂法线性收敛

mk 1 1

2 mk 1 1

2 1

[ zk 1 10 ] i [ zk 10 ] i

2 1

称为收敛率

由于

zk

线性收敛于 x1 ,于是可以对之进行埃特金加速,

( zk )i ( zk 2 )i ( zk 1 )i2 Wi ( zk )i 2( zk 1 )i ( zk 2 )i

, a

(k) pq

0

第 k 步迭代矩阵的元素为:

a a a

(k ) pj

a a

( k 1) pj

cos a

2

( k 1) qj

sin a

(k ) jp

(k ) k 1) ( k 1) k) aqj a (pj sin aqj cos a (jq ( j p, q ) (k ) pp ( k 1) pp

cos 2a a

( k 1) pp

(k 1) pq

sin cos a

( k 1) pq

(k 1) qq

4.2乘幂法和反乘幂法

2

k 2

rj cos( (k 2) )

再利用三角函数运算性质以及 1 , 2 复数表示,不难验证

xj

令

( k 2)

(1 2 ) x j

( k 1)

12 x j

(k )

0

p (1 2 )

q 12

由方程组

xj

( k 2)

k 1 k

(k )

[1v1 (1) 2v2 ]

(k ) k 1 1 1 1 k 1 k 1 1

x 1 x 2 v ( k 1) (k ) x 1 x 2 (1) 2v2

( k 1)

x( k 1) 1 x( k ) 当k无穷大时,可以用

n

必有

故只要k充分大,

(k )

x

[1v1 k ] 1v1

k 1 k 1

(k )

可把x 作为与1相应的特征向量 的近似。

由x

(k )

(1v1 k )

k 1

k

及 lim k 0

lim

k

x

(k ) k 1

1v1

即表明序列

x

(k ) k 1

越来越接近A的对应于

1的特征向量,也即当k 时

x

(k )

1 v1

k 1

主 特 征 值

1 ?(如何算)

由 x

( k 1)

v , 及 x

k 1 1 1 1

(k )

1v1

k 1

x 1 x

xi

(k )

( k 1) i (k ) i

(i 1, 2,...n)

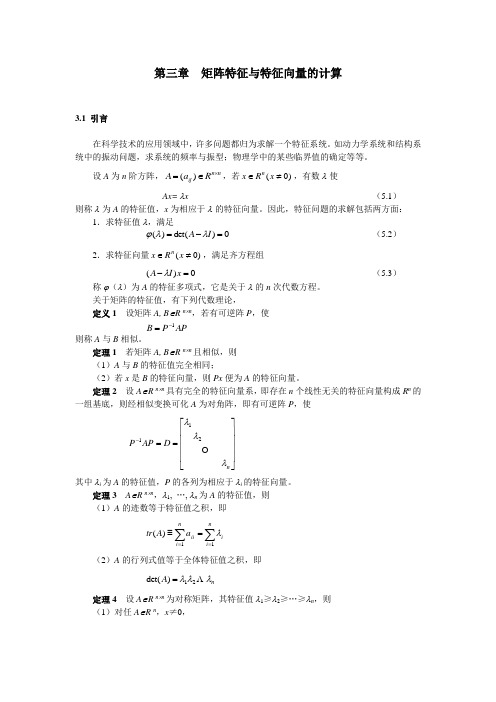

矩阵特征与特征向量的计算

第三章 矩阵特征与特征向量的计算3.1 引言在科学技术的应用领域中,许多问题都归为求解一个特征系统。

如动力学系统和结构系统中的振动问题,求系统的频率与振型;物理学中的某些临界值的确定等等。

设A 为n 阶方阵,n n ij R a A ⨯∈=)(,若)0(≠∈x R x n ,有数λ使Ax= λx(5.1)则称λ为A 的特征值,x 为相应于λ的特征向量。

因此,特征问题的求解包括两方面:1.求特征值λ,满足 0)det()(=-=I A λλϕ(5.2)2.求特征向量)0(≠∈x R x n ,满足齐方程组0)(=-x I A λ(5.3)称ϕ(λ)为A 的特征多项式,它是关于λ的n 次代数方程。

关于矩阵的特征值,有下列代数理论,定义1 设矩阵A, B ∈Rn ⨯n,若有可逆阵P ,使AP P B 1-= 则称A 与B 相似。

定理1 若矩阵A, B ∈R n ⨯n 且相似,则 (1)A 与B 的特征值完全相同;(2)若x 是B 的特征向量,则Px 便为A 的特征向量。

定理2 设A ∈R n ⨯n 具有完全的特征向量系,即存在n 个线性无关的特征向量构成R n 的一组基底,则经相似变换可化A 为对角阵,即有可逆阵P ,使⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡==-n D AP P λλλ 211其中λi 为A 的特征值,P 的各列为相应于λi 的特征向量。

定理3 A ∈R n ⨯n ,λ1, …, λn 为A 的特征值,则 (1)A 的迹数等于特征值之积,即∑∑===≡ni ini iiaA tr 11)(λ(2)A 的行列式值等于全体特征值之积,即n A λλλ 21)det(=定理4 设A ∈R n ⨯n 为对称矩阵,其特征值λ1≥λ2≥…≥λn ,则(1)对任A ∈R n ,x ≠0,1),(),(λλ≤≤x x x Ax n(2)),(),(minx x x Ax x n ≠=λ(3)),(),(max1x x x Ax x ≠=λ定理5 (Gerschgorin 圆盘定理) 设A ∈R n ⨯n ,则 (1)A 的每一个特征值必属于下述某个圆盘之中,n i aa z nij j ijii ,,2,1,1 =≤-∑≠= (5.4)(5.4)式表示以a ii 为中心,以半径为∑≠=nij j ij a 1的复平面上的n 个圆盘。

七、矩阵特征值的乘幂方法和反乘幂方法

1、用幂法计算矩阵A的主特征值和对应的特征向量。

function [k,lambda,Vk,Wc]=mifa(A,V0,jd,max1)lambda=0;k=1;Wc=1;jd=jd*0.1;state=1;V=V0;while((k<=max1)&(state==1))Vk=A*V;[m j]=max(abs(Vk));mk=m*sign(Vk(j));tzw=abs(lambda-mk);Vk=(1/mk)*Vk;txw=norm(V-Vk);Wc=max(txw,tzw);V=Vk;lambda=mk;state=0;if(Wc>jd)state=1;endk=k+1;endif(Wc<=jd)disp('迭代次数k,主特征值的近似值lambda,主特征向量的近似向量Vk,相邻两次迭代的误差Wc如下:')elsedisp('迭代次数k已经达到最大迭代次数max1,主特征值的迭代值lambda,主特征向量的迭代向量Vk,相邻两次迭代的误差Wc如下:')endVk=V;k=k-1;Wc;>> A=[1 -1;2 4];>> V0=[1,1]';>> [k,lambda,Vk,Wc]=mifa(A,V0,0.00001,100)迭代次数k,主特征值的近似值lambda,主特征向量的近似向量Vk,相邻两次迭代的误差Wc如下:k =33lambda =3.0000Vk =-0.50001.0000Wc =8.6919e-007>> [V,D]=eig(A)V =-0.7071 0.44720.7071 -0.8944D =2 00 3>> Dzd=max(diag(D))Dzd =3>> wuD=abs(Dzd-lambda)wuD =1.7384e-006>> wuV=V(:,2)./VkwuV =-0.8944-0.8944>> A=[1 2 3;2 1 3;3 3 6];>> V0=[1 1 1]';>> [k,lambda,Vk,Wc]=mifa(A,V0,0.00001,100)迭代次数k,主特征值的近似值lambda,主特征向量的近似向量Vk,相邻两次迭代的误差Wc如下:k =3lambda =9Vk =0.50000.50001.0000Wc =>> [V,D]=eig(A)V =0.7071 0.5774 0.4082-0.7071 0.5774 0.40820 -0.5774 0.8165D =-1.0000 0 00 -0.0000 00 0 9.0000>> Dzd=max(diag(D))Dzd =9>> wuD=abs(Dzd-lambda)wuD =>> wuV=V(:,2)./VkwuV =1.15471.1547-0.5774>> A=[1 2 2;1 -1 1;4 -12 1];>> V0=[1 1 1]';>> [k,lambda,Vk,Wc]=mifa(A,V0,0.00001,100)迭代次数k已经达到最大迭代次数max1,主特征值的迭代值lambda,主特征向量的迭代向量Vk,相邻两次迭代的误差Wc如下:k =100lambda =-0.0909Vk =1.00001.00001.0000Wc =1.9582>> [V,D]=eig(A)V =0.9045 -0.7255 -0.72550.3015 -0.2176 - 0.0725i -0.2176 + 0.0725i-0.3015 0.5804 - 0.2902i 0.5804 + 0.2902iD =1.0000 0 00 -0.0000 + 1.0000i 00 0 -0.0000 - 1.0000i>> Dzd=max(diag(D))Dzd =1.0000>> wuD=abs(Dzd-lambda)wuD =1.0909>> wuV=V(:,2)./VkwuV =-0.7255-0.2176 - 0.0725i0.5804 - 0.2902i(4)>> A=[-4 14 0;-5 13 0;-1 0 2];>> V0=[1 1 1]';>> [k,lambda,Vk,Wc]=mifa(A,V0,0.00001,100)迭代次数k,主特征值的近似值lambda,主特征向量的近似向量Vk,相邻两次迭代的误差Wc如下:k =22lambda =6.0000Vk =1.00000.7143-0.2500Wc =8.1744e-007>> [V,D]=eig(A)V =0 0.7974 0.66670 0.5696 0.33331.0000 -0.1994 -0.6667D =2.0000 0 00 6.0000 00 0 3.0000>> Dzd=max(diag(D))Dzd =6.0000>> wuD=abs(Dzd-lambda)wuD =8.1744e-007>> wuV=V(:,2)./VkwuV =0.79740.79740.79742、用原点位移反幂法计算矩阵A的特征值和对应的特征向量。

特征值和特征向量计算的数值方法

特征值和特征向量计算的数值方法在数学和计算机科学领域中,特征值和特征向量是非常重要的概念。

特征值和特征向量的计算有许多不同的数值方法,本文将介绍其中一些常见的数值方法,并分析它们的优劣和适用范围。

一、特征值和特征向量的定义在矩阵理论中,给定一个n×n的矩阵A,如果存在一个非零向量v和一个标量λ,使得Av=λv,那么称v为矩阵A的特征向量,λ为矩阵A的特征值。

特征值和特征向量的计算可以帮助我们理解矩阵的性质以及解决一些实际问题。

二、幂法幂法是计算特征值和特征向量的常用数值方法之一。

幂法的基本思想是通过多次迭代,逐渐逼近矩阵的特征值和特征向量。

具体操作如下:1. 初始化一个非零向量b0;2. 进行迭代计算:bi+1 = A * bi / ||A * bi||;3. 取出近似特征向量的最后一列:v = bn;4. 进行迭代计算特征值:λ = (Av)T * v / (vT * v)。

幂法的主要优点是简单易懂,且只需要进行矩阵向量乘法和内积计算。

然而,幂法仅能求取具有最大特征值的特征向量,而且对于存在多个特征值相等的情况并不适用。

三、反幂法反幂法是幂法的一种改进方法,用于求取矩阵A的最小特征值和对应的特征向量。

反幂法的基本步骤如下:1. 初始化一个非零向量b0;2. 进行迭代计算:bi+1 = (A - μI)^-1 * bi / ||(A - μI)^-1 * bi||;3. 取出近似特征向量的最后一列:v = bn;4. 进行迭代计算特征值:λ = (Av)T * v / (vT * v)。

反幂法的改进之处在于引入了矩阵的逆运算,通过使用矩阵A减去一个合适的常数μ乘以单位矩阵来实现。

反幂法适用于矩阵A的特征值接近于μ的情况。

四、QR方法QR方法也是一种常用的特征值计算方法,它适用于求解所有特征值以及对应的特征向量。

QR方法的基本思想是将一个矩阵分解为正交矩阵Q和上三角矩阵R的乘积,然后迭代地将矩阵A转化为更接近上三角形的形式。