第八章 人工神经网络与深度学习(下)

《人工神经网络》课件

动量法:在梯度下降法的基础上,引入动量项,加速收敛速 度

添加项标题

RMSProp:在AdaGrad的基础上,引入指数加权移动平 均,提高了算法的稳定性和收敛速度

添加项标题

随机梯度下降法:在梯度下降法的基础上,每次只使用一个 样本进行更新,提高了训练速度

添加项标题

AdaGrad:自适应学习率算法,根据历史梯度的平方和来 调整学习率,解决了学习率衰减的问题

情感分析:分析文本中的情感 倾向,如正面评价、负面评价 等

推荐系统

推荐系统是一种基于用户历史行为 和偏好的个性化推荐服务

推荐算法:协同过滤、深度学习、 矩阵分解等

添加标题

添加标题

添加标题

添加标题

应用场景:电商、社交媒体、视频 网站等

应用效果:提高用户满意度、增加 用户粘性、提高转化率等

Part Six

类型:Sigmoid、 Tanh、ReLU等

特点:非线性、可 微分

应用:深度学习、 机器学习等领域

权重调整

权重调整的目的:优化神经网络的性能 权重调整的方法:梯度下降法、随机梯度下降法等 权重调整的步骤:计算损失函数、计算梯度、更新权重 权重调整的影响因素:学习率、批次大小、优化器等

Part Four

《人工神经网络》PPT 课件

,

汇报人:

目录

01 添 加 目 录 项 标 题 03 神 经 网 络 基 础 知 识 05 神 经 网 络 应 用 案 例 07 未 来 发 展 趋 势 与 挑 战

02 人 工 神 经 网 络 概 述 04 人 工 神 经 网 络 算 法 06 神 经 网 络 优 化 与 改 进

深度学习算法

卷积神经网络(CNN):用于图像处理和识别 循环神经网络(RNN):用于处理序列数据,如语音识别和自然语言处理 长短期记忆网络(LSTM):改进的RNN,用于处理长序列数据 生成对抗网络(GAN):用于生成新数据,如图像生成和文本生成

人工神经网络与深度学习的区别

人工神经网络与深度学习的区别从某种程度上来说,人工神经网络和深度学习是紧密相关的概念。

然而在现实应用中,人们往往会将这两个概念混淆起来,难以理解它们之间的差别和联系。

那么,人工神经网络和深度学习真的是同一个东西吗?接下来,我们将详细讨论这两个概念。

人工神经网络人工神经网络通常被称为ANN,它是一种仿照人脑神经系统构建的计算机模型。

与人脑中的神经元相似,人工神经元也可以接受输入信号,并对这些信号进行处理和传递。

在人工神经网络中,神经元通常被分为输入层、隐藏层和输出层三个部分。

输入层负责接受外部输入的信号,例如图像或语音信号等;隐藏层是网络的核心部分,可以用于处理和传递信息;输出层则将最终的处理结果转化为相应的输出。

人工神经网络的训练过程可以通过反向传播算法来实现。

这个算法可以使网络学习和优化参数,以便最大程度地提高网络的预测和分类能力。

这种方法被广泛应用于人脸识别、语音识别、机器翻译、人类运动学习等领域。

深度学习深度学习是一种特定类型的机器学习,通常是基于人工神经网络构建的。

与传统机器学习方法不同的是,深度学习最大的特点是使用多层神经网络来处理和分类数据。

尤其是对于大规模数据集,深度学习可以有效地提高分类和判别的准确度,使得机器可以更好地模仿人类思维的过程。

深度学习的最早应用可以追溯到20世纪80年代末。

然而,由于当时计算机性能的限制,深度学习并没有得到广泛的认可和应用。

直到近些年来,随着计算能力的提高和大规模数据集的出现,深度学习才得以广泛推广和应用。

如今,深度学习已经被成功应用于语音识别、自然语言处理、图像识别、自动驾驶、医疗诊断等多个领域。

区别与联系从定义上来看,深度学习是一种特殊的人工神经网络。

深度学习通常是指在神经网络中使用多层结构,以更好地处理大数据集和更复杂的任务。

而人工神经网络则是广义上神经网络的一个具体实现方法,它可以是深度网络,也可以是浅层网络,甚至是单一人工神经元。

简单来说,深度学习是人工神经网络的一种特殊实现方式。

45. 深度学习与人工神经网络的联系是什么?

45. 深度学习与人工神经网络的联系是什么?关键信息项:1、深度学习的定义与特点2、人工神经网络的概念与结构3、深度学习中人工神经网络的应用领域4、两者在算法和模型方面的相似性5、两者在数据处理和特征提取上的关联6、深度学习对人工神经网络发展的推动作用7、人工神经网络为深度学习提供的基础和启示1、引言深度学习和人工神经网络是当今人工智能领域中备受关注的重要概念。

它们之间存在着密切的联系,相互促进和影响。

深入理解两者之间的关系对于推动人工智能技术的发展和应用具有重要意义。

11 深度学习的背景和发展深度学习是一种基于多层神经网络的机器学习方法,近年来在图像识别、语音处理、自然语言处理等领域取得了显著的成果。

111 深度学习的技术突破介绍一些关键的技术突破,如大规模数据的利用、更强大的计算能力以及优化算法的改进。

112 深度学习的应用实例列举一些具体的应用场景,如自动驾驶、医疗诊断、智能推荐等,以展示其实际影响力。

12 人工神经网络的起源与演进人工神经网络的概念可以追溯到上世纪,经过多年的发展,其结构和算法不断完善。

121 早期的理论基础阐述一些早期的理论研究和实验成果。

122 现代人工神经网络的主要类型如前馈神经网络、反馈神经网络、卷积神经网络等。

2、深度学习与人工神经网络的概念解析21 深度学习的定义和核心思想详细解释深度学习如何通过多层的神经网络进行特征学习和模式识别。

211 深度学习中的层次结构说明不同层次在信息处理和特征抽象方面的作用。

212 深度学习的训练过程包括数据准备、模型构建、参数调整和优化等步骤。

22 人工神经网络的基本原理介绍神经元的工作机制、网络的连接方式以及信号传播和处理的过程。

221 人工神经网络的学习规则如误差反向传播算法、随机梯度下降等。

222 人工神经网络的拓扑结构分析不同拓扑结构对网络性能和功能的影响。

3、两者在算法和模型方面的相似性31 共同的数学基础例如线性代数、概率论、微积分等在两者中的应用。

神经网络与深度学习的区别

神经网络与深度学习的区别神经网络与深度学习是机器学习领域内的两个重要概念。

对于非专业人士来说,这两个概念可能会混淆。

虽然两者密不可分,但仍然有着显著的区别。

在本文中,我们将探讨神经网络与深度学习的这些区别。

神经网络是一种模仿人类神经系统结构与功能的计算机系统。

它由互相连接的节点组成,节点分别代表着人类大脑中的神经元。

神经网络的基本思想是,通过一系列大量的计算处理、模型迭代,使得神经网络学习到具有普遍性的规律,并能够推广至新的数据集中。

一个神经网络通常跨越多个层次,每层子节点都有许多不同的变化方式,从而使得神经网络具有拟合复杂数据的能力。

深度学习是一种机器学习的技巧,名称来源于其使用的深度神经网络。

深度学习与传统的机器学习技术不同,传统的机器学习技术(如支持向量机(SVM)或K-最近邻(KNN))通常需要手动选择特征。

而深度学习技术不需要人为干预,它能够自动地从数据中学习到可以产生更好结果的特征,并利用这些特征来进行分类或回归等任务,从而完成复杂的数据分析。

深度学习的核心思路是“层次化”,将网络的计算过程组织为不同的抽象层,每一层的输出作为下一层的输入,满足多次非线性叠加的传递过程,从而提高模型的分类准确率。

因此,神经网络和深度学习并非等同,而是具有某些联系和区别。

首先,神经网络包含浅层、深层和反馈神经网络(如循环神经网络),而深度学习则是针对深度神经网络的。

其次,在数据特征和处理方面,神经网络一般需要人工提取特征,而深度学习则是在大量数据训练中自我提取特征,使得模型具有更强的泛化能力。

最后,在使用方面,神经网络着重于分类、回归和聚类问题,而深度学习则对模式识别、语音识别、图像识别和自然语言处理等方面有很好的应用。

综上所述,神经网络和深度学习的区别在于深度学习是特别针对深度神经网络而言的,并且不需要人工手动提取特征,具有强大的模型泛化能力,能够应用于多种领域的数据分析和分类。

神经网络则更加重视数据的预处理和手动选择特征,适用于分类、回归和聚类等方面的问题。

神经网络与深度学习(PPT31页)

图像的特征

计算机图像是由一定数量的点阵像素构成的。如上所示,我们看到的 是一辆车,但实际上计算机理解的是一个由各像素点的灰度值组成的 矩阵,它并不能直接理解“这是一辆车”。

我们需要将“这是一辆车”这个事实用完全逻辑化的语言描述出来, 让计算机建立一个函数,这个矩阵自变量 x 所对应的结果因变量 y 就 是“车”。难度可想而知。

不仅是房子这个整体,房子里的门、窗户等元素我们都能发现,而原因自然也 是颜色突变。

思考:人能看见绝对透明(100% 透明)的玻璃吗?

我们定义一个形状的时候,本质 上就是在定义其产生颜色突变的 像素点的大致相对位置。比如圆, 在一个直角坐标系的图象上上, 存在所有满足 (x-a)2+(y-b)2=r2 条件的坐标点的某个小邻域内有 较大的颜色突变,那么这幅图像 上就有一个圆的形状。左上方是 一幅色盲测试图,不色盲的朋友 都能看到左下角有一个蓝色的圆, 而且是一个空心圆。

特征:用来描述一个对象具体表现形式的逻辑语言。

如前页所述,“上半部分是圆,下半部分是靠右的一撇” 就是数字 9 的形状特征。

特征是构成一个对象的必要但不充分条件,因为一个对象 是由无数个特征组成的,在有限数量的特征里,我们永远 只能预估该对象,而不能 100% 确定该对象究竟是什么。

经典的图像特征之——Haar 特征

思考:我们一眼就能看出来这幅图像上有一栋房子。但任何一幅图像 都是由一定数量的像素点组成的,我们是怎么从这些单纯的像素点里 发现了房子的呢?

这个问题还可以换一种问法:我们怎么知道一幅图像中是有前景对象 的,对于一张纯色画布,我们为什么无法发现任何对象?

这涉及到一个现象:颜色突变。上图所圈出的区域中,都是颜色变化较大的区 域。而我们就会自然地认为,这是物体的边缘,而由封闭边缘构成的区域就是 物体。

神经网络与深度学习知识点整理

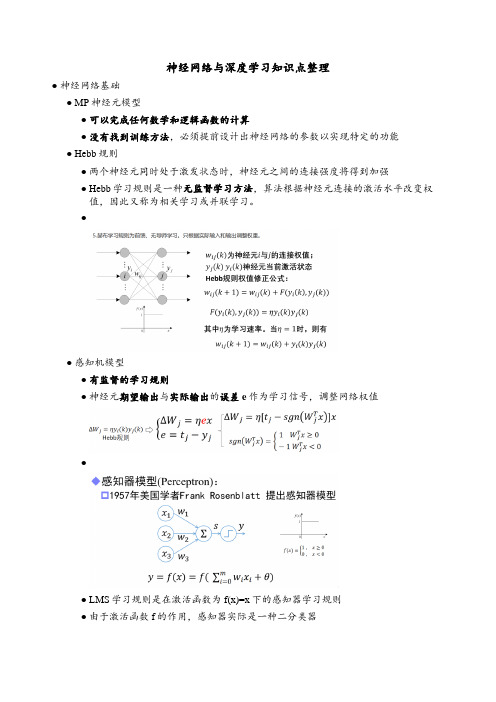

神经网络与深度学习知识点整理●神经网络基础●MP神经元模型●可以完成任何数学和逻辑函数的计算●没有找到训练方法,必须提前设计出神经网络的参数以实现特定的功能●Hebb规则●两个神经元同时处于激发状态时,神经元之间的连接强度将得到加强●Hebb学习规则是一种无监督学习方法,算法根据神经元连接的激活水平改变权值,因此又称为相关学习或并联学习。

●●感知机模型●有监督的学习规则●神经元期望输出与实际输出的误差e作为学习信号,调整网络权值●●LMS学习规则是在激活函数为f(x)=x下的感知器学习规则●由于激活函数f的作用,感知器实际是一种二分类器●感知器调整权值步骤●单层感知器不能解决异或问题●BP网络●特点:●同层神经网络无连接●不允许跨层连接●无反馈连接●BP学习算法由正向传播和反向传播组成●BP网络的激活函数必须处处可导——BP权值的调整采用 Gradient Descent 公式ΔW=-η(偏E/偏w),这个公式要求网络期望输出和单次训练差值(误差E)求导。

所以要求输出值处处可导。

s函数正好满足处处可导。

●运算实例(ppt)●Delta( δ )学习规则●误差纠正式学习——神经元的有监督δ学习规则,用于解决输入输出已知情况下神经元权值学习问题●δ学习规则又称误差修正规则,根据E/w负梯度方向调整神经元间的连接权值,能够使误差函数E达到最小值。

●δ学习规则通过输出与期望值的平方误差最小化,实现权值调整●●1●自动微分●BP神经网络原理:看书●超参数的确定,并没有理论方法指导,根据经验来选择●BP算法已提出,已可实现多隐含层的神经网络,但实际只使用单隐层节点的浅层模型●计算能力的限制●梯度弥散问题●自编码器●●自编码器(Auto-Encoder)作为一种无监督学习方法网络●将输入“编码”为一个中间代码●然后从中间表示“译码”出输入●通过重构误差和误差反传算法训练网络参数●编码器不关心输出(只复现输入),只关心中间层的编码————ℎ=σ(WX+b)●编码ℎ已经承载原始数据信息,但以一种不同的形式表达!●1●正则编码器——损失函数中加入正则项,常用的正则化有L1正则和L2正则●稀疏自编码器——在能量函数中增加对隐含神经元激活的稀疏性约束,以使大部分隐含神经元处于非激活状态●去噪自编码器——训练数据加入噪声,自动编码器学习去除噪声获得无噪声污染的输入,迫使编码器学习输入信号更加鲁棒的表达●堆叠自编码器●自编码器训练结束后,输出层即可去掉,网络关心的是x到ℎ的变换●将ℎ作为原始信息,训练新的自编码器,得到新的特征表达.●逐层贪婪预训练●1●深度神经网络初始化●●卷积神经网络●全连接不适合图像任务●参数数量太多●没有利用像素之间的位置信息●全连接很难传递超过三层●卷积神经网络是一种前馈神经网络,其输出神经元可以响应部分区域内的输入信息,适宜处理图像类信息●1●1●Zero Padding:在原始图像周围补0数量●卷积尺寸缩小,边缘像素点在卷积中被计算的次数少,边缘信息容易丢失●●卷积神经网络架构发展●1●深度发展●LeNet●具备卷积、激活、池化和全连接等基本组件●但GPU未出现,CPU的性能又极其低下●LetNet只使用在手写识别等简单场景,未得到重视●LeNet主要有2个卷积层(5*5)、2个下抽样层(池化层)、3个全连接层●通过sigmoid激活●全连接层输出:共有10个节点分别代表数字0到9,采用径向基函数作为分类器●AlexNet●第一次采用了ReLU,dropout,GPU加速等技巧●AlexNet网络共有:卷积层 5个(1111,55,3*3),池化层 3个,全连接层3个●首次采用了双GPU并行计算加速模式●第一卷积模块:96通道的特征图被分配到2个GPU中,每个GPU上48个特征图;2组48通道的特征图分别在对应的GPU中进行ReLU激活●第一层全连接:同时采用了概率为0.5的Dropout策略●VGG●通过反复堆叠3x3卷积和2x2的池化,得到了最大19层的深度●卷积-ReLU-池化的基本结构●串联多个小卷积,相当于一个大卷积的思想●使用两个串联的3x3卷积,达到5x5的效果,但参数量却只有之前的18/25●串联多个小卷积,增加ReLU非线性激活使用概率,从而增加模型的非线性特征●VGG16网络包含了13个卷积层,5个池化层和3个全连接层。

《人工神经网络》课件

拟牛顿法

改进牛顿法的不足,使用正定矩阵近 似Hessian矩阵,提高优化效率。

共轭梯度法

结合梯度下降法和共轭方向的思想, 在每一步迭代中选择合适的共轭方向 进行搜索。

遗传算法

模拟生物进化过程的优化算法,通过 选择、交叉、变异等操作寻找最优解 。

正则化技术

L1正则化

对权重参数的绝对值进行惩罚总结词

自然语言处理是利用人工神经网络对自然语言文本进行分析和处理的技术。

详细描述

自然语言处理是实现人机文本交互的关键技术之一,通过训练神经网络对大量文本数据进 行学习,可以实现对文本的自动分类、情感分析、机器翻译等功能。

具体应用

在社交媒体领域,自然语言处理技术可以用于情感分析和舆情监控;在新闻媒体领域,可 以用于新闻分类和摘要生成;在机器翻译领域,可以用于实现多语言之间的自动翻译。

06

人工神经网络的未 来展望

新型神经网络模型的研究

持续探索新型神经网络模型

随着技术的不断发展,新型神经网络模型的研究将不断涌现,以解决传统模型无法处理 的复杂问题。这些新型模型可能包括更复杂的拓扑结构、更高效的参数优化方法等。

结合领域知识进行模型设计

未来的神经网络模型将更加注重与领域知识的结合,以提高模型的针对性和实用性。例 如,在医疗领域,结合医学影像和病理学知识的神经网络模型能够更准确地辅助医生进

THANKS

感谢您的观看

文字、人脸等目标的技术。

02 03

详细描述

图像识别是人工神经网络应用的重要领域之一,通过训练神经网络对大 量图像数据进行学习,可以实现对图像的自动分类、目标检测、人脸识 别等功能。

具体应用

在安防领域,图像识别技术可以用于人脸识别和视频监控;在医疗领域 ,可以用于医学影像分析;在电商领域,可以用于商品图片的自动分类 和检索。

《人工智能概论》课程笔记

《人工智能概论》课程笔记第一章人工智能概述1.1 人工智能的概念人工智能(Artificial Intelligence,简称AI)是指使计算机具有智能行为的技术。

智能行为包括视觉、听觉、语言、学习、推理等多种能力。

人工智能的研究目标是让计算机能够模拟人类智能的某些方面,从而实现自主感知、自主决策和自主行动。

人工智能的研究领域非常广泛,包括机器学习、计算机视觉、自然语言处理、知识表示与推理等。

1.2 人工智能的产生与发展人工智能的概念最早可以追溯到上世纪50 年代。

1950 年,Alan Turing 发表了著名的论文《计算机器与智能》,提出了“图灵测试”来衡量计算机是否具有智能。

1956 年,在达特茅斯会议上,John McCarthy 等人首次提出了“人工智能”这个术语,并确立了人工智能作为一个独立的研究领域。

人工智能的发展可以分为几个阶段:(1)推理期(1956-1969):主要研究基于逻辑的符号操作和自动推理。

代表性成果包括逻辑推理、专家系统等。

(2)知识期(1970-1980):研究重点转向知识表示和知识工程,出现了专家系统。

代表性成果包括产生式系统、框架等。

(3)机器学习期(1980-1990):机器学习成为人工智能的重要分支,研究如何让计算机从数据中学习。

代表性成果包括决策树、神经网络等。

(4)深度学习期(2006-至今):深度学习技术的出现,推动了计算机视觉、自然语言处理等领域的发展。

代表性成果包括卷积神经网络、循环神经网络等。

1.3 人工智能的三大学派人工智能的研究可以分为三大学派:(1)符号主义学派:认为智能行为的基础是符号操作和逻辑推理。

符号主义学派的研究方法包括逻辑推理、知识表示、专家系统等。

(2)连接主义学派:认为智能行为的基础是神经网络和机器学习。

连接主义学派的研究方法包括人工神经网络、深度学习、强化学习等。

(3)行为主义学派:认为智能行为的基础是感知和行动。

行为主义学派的研究方法包括遗传算法、蚁群算法、粒子群算法等。