深度学习中的卷积神经网络技术研究

深度学习中的卷积神经网络与循环神经网络

深度学习中的卷积神经网络与循环神经网络深度学习是目前人工智能领域最为炙手可热的技术之一,它在图像识别、语音识别、自然语言处理等领域都取得了显著的成就。

而在深度学习领域中,卷积神经网络和循环神经网络是两个重要的模型,它们在不同的任务中展现出了卓越的性能。

本文将重点介绍卷积神经网络和循环神经网络的原理、结构和应用,旨在帮助读者更好地理解这两种神经网络模型。

一、卷积神经网络(Convolutional Neural Network,CNN)1.1原理卷积神经网络是受到生物视觉系统的启发而提出的一种深度学习模型,它模拟了人类视觉皮层的工作原理。

在卷积神经网络中,包含了卷积层、池化层和全连接层等组件。

卷积层是卷积神经网络的核心组件,它通过卷积操作从输入数据中提取特征。

卷积操作可以有效地减少参数数量,并且能够捕捉数据中的局部特征。

此外,卷积操作还具有平移不变性,能够识别特征在不同位置的模式。

池化层通常紧跟在卷积层后面,它的作用是降低特征图的尺寸,并减少模型对位置的敏感度。

常见的池化操作有最大池化和平均池化,它们分别选择特征图中的最大值和平均值作为输出。

全连接层是卷积神经网络中的最后一层,它将特征图展平成一维向量,并通过全连接操作将提取的特征进行分类或回归。

1.2结构卷积神经网络通常由多个卷积层、池化层和全连接层构成,其中卷积层和池化层交替出现,而全连接层通常出现在网络的最后一部分。

卷积神经网络的结构可以根据具体的任务进行调整,以达到更好的性能。

1.3应用卷积神经网络在图像识别、物体检测、人脸识别等领域取得了巨大的成功。

以ImageNet图像识别比赛为例,卷积神经网络模型始终是各种比赛的最佳选择,它在复杂的图像数据上展现了出色的识别性能。

此外,卷积神经网络还被广泛应用于医学影像识别、自动驾驶、智能安防等领域。

二、循环神经网络(Recurrent Neural Network,RNN)2.1原理循环神经网络是一种能够处理时序数据的神经网络模型,它具有记忆能力,能够对序列数据进行建模。

基于深度学习卷积神经网络图像识别技术的研究与应用

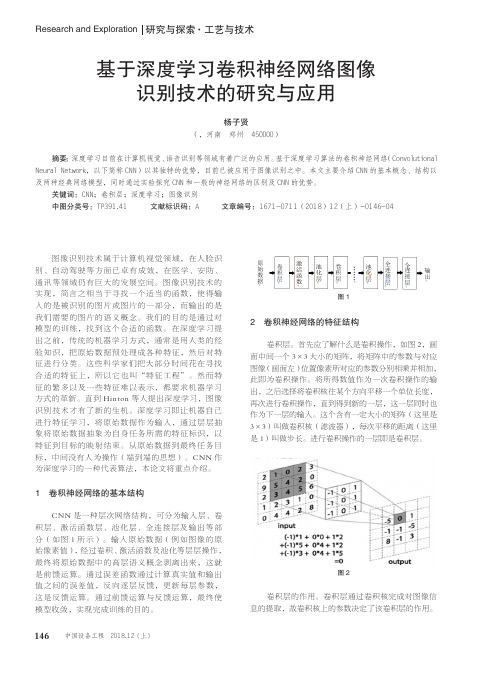

CNN 是一种层次网络结构,可分为输入层、卷 积层、激活函数层、池化层、全连接层及输出等部 分(如图 1 所示)。输入原始数据(例如图像的原 始 像 素 值 ),经 过 卷 积 、激 活 函 数 及 池 化 等 层 层 操 作 , 最终将原始数据中的高层语义概念剥离出来,这就 是前馈运算。通过误差函数通过计算真实值和输出 值之间的误差值,反向逐层反馈,更新每层参数, 这是反馈运算。通过前馈运算与反馈运算,最终使 模型收敛,实现完成训练的目的。

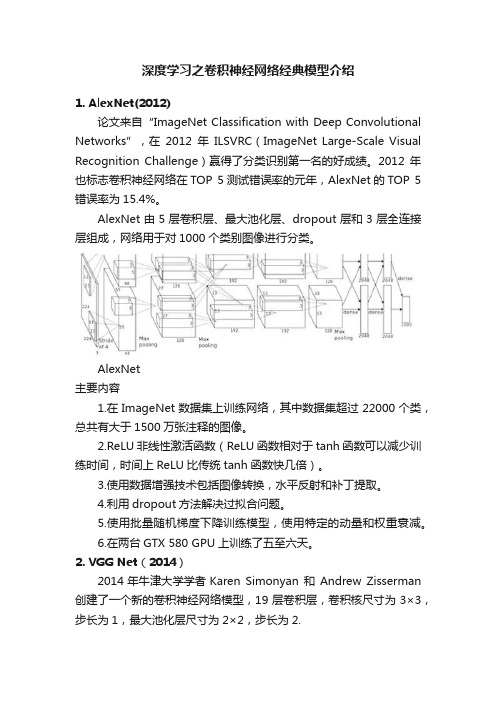

图2 卷积层的作用。卷积层通过卷积核完成对图像信 息的提取,故卷积核上的参数决定了该卷积层的作用。

China 中国 Plant 设备

Engineering 工程

例如有一种边缘滤波器

,当该滤波器作

用于图片中物体的边缘时,那么边缘和其四周的像素值

差异应比较大。如果作用该滤波器,那么边缘四周像素

值差异小的部分就会被消除,而差异较大的部分就被凸

146 中国设备工程 2018.12 ( 上 )

图1

2 卷积神经网络的特征结构

卷积层。首先应了解什么是卷积操作,如图 2,画 面中间一个 3×3 大小的矩阵,将矩阵中的参数与对应 图像(画面左)位置像素所对应的参数分别相乘并相加, 此即为卷积操作。将所得数值作为一次卷积操作的输 出,之后选择将卷积核往某个方向平移一个单位长度, 再次进行卷积操作,直到得到新的一层,这一层同时也 作为下一层的输入。这个含有一定大小的矩阵(这里是 3×3)叫做卷积核(滤波器),每次平移的距离(这里 是 1)叫做步长。进行卷积操作的一层即是卷积层。

Research and Exploration 研究与探索·工艺与技术

基于深度学习卷积神经网络图像 识别技术的研究与应用

卷积神经网络研究综述

卷积神经网络研究综述一、引言卷积神经网络(Convolutional Neural Network,简称CNN)是深度学习领域中的一类重要算法,它在计算机视觉、自然语言处理等多个领域中都取得了显著的成果。

CNN的设计灵感来源于生物视觉神经系统的结构,尤其是视觉皮层的组织方式,它通过模拟视觉皮层的层级结构来实现对输入数据的层次化特征提取。

在引言部分,我们首先要介绍CNN的研究背景。

随着信息技术的飞速发展,大数据和人工智能逐渐成为研究的热点。

在这个过程中,如何有效地处理和分析海量的图像、视频等数据成为了一个亟待解决的问题。

传统的机器学习方法在处理这类数据时往往面临着特征提取困难、模型复杂度高等问题。

而CNN的出现,为解决这些问题提供了新的思路。

接着,我们要阐述CNN的研究意义。

CNN通过其独特的卷积操作和层次化结构,能够自动学习并提取输入数据中的特征,从而避免了繁琐的特征工程。

同时,CNN还具有良好的泛化能力和鲁棒性,能够处理各种复杂的数据类型和场景。

因此,CNN在计算机视觉、自然语言处理等领域中都得到了广泛的应用,并取得了显著的成果。

最后,我们要介绍本文的研究目的和结构安排。

本文旨在对CNN 的基本原理、发展历程和改进优化方法进行系统的综述,以便读者能够全面了解CNN的相关知识和技术。

为了达到这个目的,我们将按照CNN的基本原理、发展历程和改进优化方法的顺序进行论述,并在最后对全文进行总结和展望。

二、卷积神经网络基本原理卷积神经网络的基本原理主要包括卷积操作、池化操作和全连接操作。

这些操作共同构成了CNN的基本框架,并使其具有强大的特征学习和分类能力。

首先,卷积操作是CNN的核心操作之一。

它通过一个可学习的卷积核在输入数据上进行滑动窗口式的计算,从而提取出输入数据中的局部特征。

卷积操作具有两个重要的特点:局部连接和权值共享。

局部连接意味着每个神经元只与输入数据的一个局部区域相连,这大大降低了模型的复杂度;权值共享则意味着同一卷积层内的所有神经元共享同一组权值参数,这进一步减少了模型的参数数量并提高了计算效率。

深度学习之卷积神经网络经典模型介绍

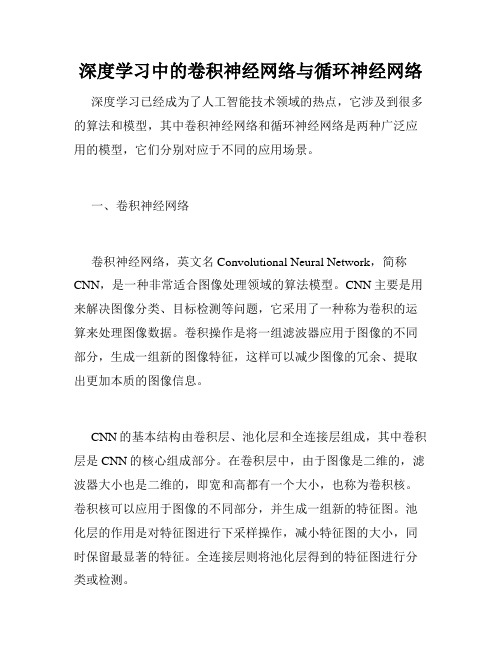

深度学习之卷积神经网络经典模型介绍1. AlexNet(2012)论文来自“ImageNet Classification with Deep Convolutional Networks”,在2012年ILSVRC(ImageNet Large-Scale Visual Recognition Challenge)赢得了分类识别第一名的好成绩。

2012年也标志卷积神经网络在TOP 5测试错误率的元年,AlexNet的TOP 5错误率为15.4%。

AlexNet由5层卷积层、最大池化层、dropout层和3层全连接层组成,网络用于对1000个类别图像进行分类。

AlexNet主要内容1.在ImageNet数据集上训练网络,其中数据集超过22000个类,总共有大于1500万张注释的图像。

2.ReLU非线性激活函数(ReLU函数相对于tanh函数可以减少训练时间,时间上ReLU比传统tanh函数快几倍)。

3.使用数据增强技术包括图像转换,水平反射和补丁提取。

4.利用dropout方法解决过拟合问题。

5.使用批量随机梯度下降训练模型,使用特定的动量和权重衰减。

6.在两台GTX 580 GPU上训练了五至六天。

2. VGG Net(2014)2014年牛津大学学者Karen Simonyan 和Andrew Zisserman 创建了一个新的卷积神经网络模型,19层卷积层,卷积核尺寸为3×3,步长为1,最大池化层尺寸为2×2,步长为2.VGG Net主要内容1.相对于AlexNet模型中卷积核尺寸11×11,VGG Net的卷积核为3×3。

作者的两个3×3的conv层相当于一个5×5的有效感受野。

这也就可以用较小的卷积核尺寸模拟更大尺寸的卷积核。

这样的好处是可以减少卷积核参数数量。

2.三个3×3的conv层拥有7×7的有效感受野。

卷积神经网络的优化和改进

卷积神经网络的优化和改进卷积神经网络(Convolutional Neural Networks,CNN)是一种在图像识别、语音识别、自然语言处理等领域取得巨大成功的深度学习模型。

然而,随着网络的深度和规模的增加,CNN也面临着一些挑战和问题。

为了进一步提高CNN的性能和效果,研究者们提出了许多优化和改进的方法。

本文将对卷积神经网络的优化和改进进行探讨。

首先,我们将介绍一些常见的卷积神经网络优化方法。

首先是梯度下降算法及其变种。

梯度下降算法是训练神经网络最常用的优化算法之一,其通过不断调整网络参数来最小化损失函数。

然而,在大规模深层网络中使用传统梯度下降算法存在着收敛速度慢、易陷入局部最优等问题。

为了解决这些问题,研究者们提出了各种改进方法,如随机梯度下降(Stochastic Gradient Descent, SGD)、动量法(Momentum)、自适应学习率(Adaptive Learning Rate)等。

其次是正则化方法。

正则化在机器学习中被广泛应用于防止过拟合。

在卷积神经网络中,过拟合问题同样存在。

为了解决过拟合问题,研究者们提出了多种正则化方法,如L1正则化、L2正则化、Dropout 等。

L1正则化通过在损失函数中加入网络参数的绝对值之和来限制参数的大小,从而达到特征选择的效果。

L2正则化通过在损失函数中加入网络参数的平方和来限制参数的大小,从而使得网络更加平滑。

Dropout是一种随机失活技术,通过随机将一部分神经元置为0来减少神经元之间的依赖关系,从而减少过拟合。

接下来是卷积神经网络架构的改进方法。

传统卷积神经网络采用简单的卷积层、池化层和全连接层构成。

然而,在实际应用中发现传统架构存在一些问题,如容易丢失细节信息、对位置敏感等。

为了解决这些问题,研究者们提出了一系列改进方法。

其中之一是引入残差连接(Residual Connection)。

残差连接通过将前一层的输出与后面层输入相加,在梯度反向传播时能够更好地传递梯度信息,从而加速网络的训练速度,提高网络的性能。

卷积神经网络结构的改进及其在语音识别中的应用研究

卷积神经网络结构的改进及其在语音识别中的应用研究随着人工智能技术的不断发展,深度学习作为其中的一种重要方法,已经得到广泛应用。

其中,卷积神经网络(Convolutional Neural Networks, CNN)作为一种特殊的神经网络模型,拥有许多优秀的特性,在语音识别等领域的应用也取得了一系列的成功。

本文将介绍卷积神经网络结构的改进及其在语音识别中的应用研究。

一、卷积神经网络结构的改进1.1 基础卷积神经网络结构卷积神经网络是一种高效的深度前馈神经网络,由输入层,卷积层,激活层,池化层,全连接层和输出层组成。

其中,卷积层是卷积神经网络的重要组成部分,卷积核负责对输入数据进行卷积运算,提取出它们之间的特征。

池化层可以减小特征映射的大小和数量。

为了增强模型的鲁棒性,常常会对网络结构进行一些改进。

1.2 递归卷积神经网络结构递归卷积神经网络(Recurrent Convolutional Neural Network, RCNN)是在传统卷积神经网络的基础上进行改进的。

在语音识别领域,往往需要序列建模,而传统卷积神经网络在处理时序数据时不能直接处理变长的序列。

递归卷积神经网络引入了循环神经网络(RNN)的概念,并通过共享卷积核的方式,建立对于当前时刻输入和前一个时刻参数的依赖关系,使网络可以捕捉到序列的上下文信息。

1.3 带注意力机制卷积神经网络结构带注意力机制的卷积神经网络(Attention-based Convolutional Neural Networks, ACNN)是在RCNN的基础上进一步改进的,它引入了注意力机制,可以集中注意力在网络的某些部分上,从而提高特定信息的重要性并抑制其他的信息。

在语音识别领域,ACNN可以通过注意输入音频的重要部分,进而提高模型在噪声等复杂环境下的识别能力。

二、卷积神经网络在语音识别中的应用研究针对语音合成、语音识别等语音信号领域的特点,有很多研究者将卷积神经网络应用于这些任务中,并取得了不错的效果。

深度学习中的卷积神经网络与循环神经网络

深度学习中的卷积神经网络与循环神经网络深度学习已经成为了人工智能技术领域的热点,它涉及到很多的算法和模型,其中卷积神经网络和循环神经网络是两种广泛应用的模型,它们分别对应于不同的应用场景。

一、卷积神经网络卷积神经网络,英文名Convolutional Neural Network,简称CNN,是一种非常适合图像处理领域的算法模型。

CNN主要是用来解决图像分类、目标检测等问题,它采用了一种称为卷积的运算来处理图像数据。

卷积操作是将一组滤波器应用于图像的不同部分,生成一组新的图像特征,这样可以减少图像的冗余、提取出更加本质的图像信息。

CNN的基本结构由卷积层、池化层和全连接层组成,其中卷积层是CNN的核心组成部分。

在卷积层中,由于图像是二维的,滤波器大小也是二维的,即宽和高都有一个大小,也称为卷积核。

卷积核可以应用于图像的不同部分,并生成一组新的特征图。

池化层的作用是对特征图进行下采样操作,减小特征图的大小,同时保留最显著的特征。

全连接层则将池化层得到的特征图进行分类或检测。

CNN与传统的神经网络相比,最大的优点就是能够处理局部图像信息,提取出图像中的特征。

而其在处理图像数据方面的卓越表现,也使其被广泛应用于自然语言处理和语音处理等领域。

二、循环神经网络与CNN不同,循环神经网络(Recurrent Neural Network,RNN)主要用于解决序列数据方面的问题,例如语音识别、文本生成、机器翻译等。

与CNNS的卷积核对图像进行局部处理不同,RNN是对序列数据进行处理,通过对前几个时刻的输入进行处理,得出当前时刻的输出结果,同时还可以利用当前时刻的结果影响后续的输出结果。

RNN由一系列的时间步组成,每个时间步都会产生一个输出和一个隐藏状态。

其中隐藏状态会被传递到下一个时间步,从而实现信息的传递。

RNN中最常用的模型是长短时记忆网络(Long Short-Term Memory,LSTM),它可以在长时间序列上保存和传递信息,解决了传统RNN存在的“梯度消失”和“梯度爆炸”问题。

基于卷积神经网络图像分类的研究

基于卷积神经网络图像分类的研究近年来,随着深度学习的发展和计算机性能的提升,基于卷积神经网络(Convolutional Neural Networks,CNN)的图像分类技术得以快速发展。

CNN在图像分类、目标检测等领域展现出了令人惊异的性能,成为了计算机视觉领域最具代表性的技术之一。

为了探究基于CNN的图像分类技术,本文将从卷积神经网络的结构、训练技巧、数据增强策略及实际应用等方面进行探讨。

一、卷积神经网络的结构卷积神经网络是一种深度神经网络,其设计思想源于生物学中视觉皮层中神经元对视觉刺激的响应特性。

卷积神经网络主要由卷积层(Convolutional Layer)、池化层(Pooling Layer)、全连接层(Fully Connected Layer)和输出层(Output Layer)组成。

卷积层是CNN的核心,其主要用于提取图像特征。

卷积层的核心操作是卷积运算,该运算通过定义一组卷积核对输入的图像进行卷积操作,从而提取出对应的特征图。

其中每个卷积核的大小可以自定义,选择不同大小的卷积核能够导出不同尺度的特征。

池化层用于缩小特征图尺寸,减少网络计算量。

常见的池化操作包括最大池化和平均池化,它们分别选取局部特征图中最大值和平均值作为池化后的值。

全连接层是CNN的最后一层,用于将特征图映射到类别分数。

输出层通常是一个softmax函数,用于将类别分数转换成各个类别的概率。

二、卷积神经网络的训练技巧CNN的训练通常采用反向传播算法(Back Propagation,BP)和随机梯度下降算法(Stochastic Gradient Descent,SGD)。

其中,反向传播算法用于计算每层神经元的误差,随机梯度下降算法用于更新每个权重参数。

除此之外,还有一些有效的训练技巧,如批量归一化(Batch Normalization,BN)、dropout、学习率调整策略等。

批量归一化是一种在每个小批量数据内对特征进行标准化的技术,能够有效地加速训练和提高模型的泛化能力。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

深度学习中的卷积神经网络技术研究

随着计算机技术的不断发展,人工智能技术逐渐成为了各行各业的焦点。

而卷

积神经网络技术作为其中的一个重要方向,已经成为了众多研究者的研究对象。

在深度学习技术的应用中,卷积神经网络技术可以有效地对复杂的图像类型的数据进行分类和识别,成为了当今人工智能领域的热门技术之一。

本文将就卷积神经网络技术的基本结构和相关研究成果进行探讨。

1.卷积神经网络的基本结构和发展历程

卷积神经网络是一种神经网络算法,其基本结构为多层卷积层、池化层、全连

接层等模块的组合。

在卷积神经网络中,各层都采用卷积操作和非线性激活函数进行特征提取,最终输出预测结果。

在整个网络中,输入的特征图通过不断的卷积、池化等操作,不断提取出高阶的抽象特征,从而实现对输入数据的有效处理和分类。

卷积神经网络的这种结构设计和实现方式,被广泛应用于图像和视频等领域中。

早在20世纪80年代,卷积神经网络就被提出并应用于字符识别领域。

而直到LeNet-5模型的提出,卷积神经网络才开始在学界和工业实践中得到广泛应用。

LeNet-5是一种基于卷积神经网络的手写数字识别模型,可分别处理手写数字图像

的不同区域,从而实现对手写数字的识别。

这个模型的出现标志着卷积神经网络的进入正式应用阶段,而这种网络结构的基本形式,如今已经成为了各种深度学习网络的基础。

2.卷积神经网络的优势和应用现状

卷积神经网络的优势主要体现在以下几个方面:

- 强大的特征提取能力:卷积神经网络在处理图像、视频等领域数据时,可以

有效地提取出复杂的抽象特征,从而大大提高了数据的分类和识别能力。

- 减少过拟合现象:卷积神经网络可以通过池化、以及dropout等手段,有效地减少神经网络的过拟合现象,提高网络的泛化能力。

- 并行计算效率高:由于卷积神经网络中的卷积操作是可以并行计算的,因此在进行大量数据处理时,卷积神经网络也可以具有高效的计算能力。

在现实应用中,卷积神经网络已经得到了广泛的应用。

除了字符识别之外,卷积神经网络在图像和视频识别、自然语言处理、语音识别等多个领域中都有着广泛的应用。

例如,在图像识别领域中,卷积神经网络已经可以达到超越人类识别能力的水平,且在无监督学习等领域也有着广泛的研究。

此外,卷积神经网络的应用也逐渐涉及到了大数据分析、智慧城市建设等各个领域。

3.卷积神经网络的研究进展和未来展望

随着计算机能力的不断提升和数据量的不断增加,卷积神经网络的研究领域也在不断拓展。

目前,卷积神经网络的研究方向主要涉及到如下几个方面:- 网络结构优化:通过设计不同的网络结构和超参数组合,来提高网络的训练和分类性能。

- 迁移学习研究:利用已经训练好的卷积神经网络来进行其他任务的特征提取和分类。

- 多模态融合:将图像、视频、语音和文字等多模态数据进行融合,从而提高网络的分类和识别能力。

未来,卷积神经网络的研究方向也将逐渐拓宽。

例如,在自然语言处理领域,利用卷积神经网络对文本进行处理和推理,是近期研究热点之一。

同时,卷积神经网络在医疗诊断、智慧农业、智能安防等应用领域中也有着广泛的应用前景。

总结

卷积神经网络作为当前人工智能技术的研究热点之一,其优化和应用研究也在

不断发展。

本文探讨了卷积神经网络的基本结构和发展历程,以及其在图像、视频、语音、自然语言处理等各个领域中的优势和应用现状。

同时,我们也对卷积神经网络的未来研究方向进行了预测和展望。

希望这些内容能够对读者有所启发,为当前人工智能技术的相关研究提供一些参考和借鉴。