大数据经典算法c4.5讲解

c4.5算法的基本原理

c4.5算法的基本原理

C4.5算法是一种经典的决策树学习算法,它的基本原理是基于信息论的概念来构建决策树。

该算法使用信息增益作为选择最佳划分属性的标准,信息增益是指在得知一个属性的取值后,对分类的不确定性减少的程度。

具体来说,C4.5算法通过计算每个属性的信息增益,选择信息增益最大的属性作为当前节点的划分属性,然后递归地对每个子节点进行相同的操作,直到满足停止条件为止。

另外,C4.5算法在构建决策树的过程中使用了剪枝技术,以避免过拟合的问题。

剪枝是指对已生成的决策树进行修剪,去除一些不必要的节点,从而提高决策树的泛化能力。

此外,C4.5算法还支持处理缺失值和连续值属性,并可以处理多分类问题。

总的来说,C4.5算法的基本原理是基于信息论的概念,通过计算信息增益来选择最佳划分属性,并利用剪枝技术来构建泛化能力强的决策树模型。

C4.5算法

设样本集S按离散属性F的V个不同的取值划分为,共V个子 集 定义分割信息量Split(S, F):

那么信息增益率为:

| Sv | | Sv | Split ( S , F ) *log 2 ( ) |S| vV | S |

Gain( S , F ) Split ( S , F )

i 1 C

vVofF

pi log 2 ( pi )

i 1

vVofF

p(v) pvj log 2 ( pvj )

j 1

C

说明:设样本集S 按离散属性F的V 个不同的取值划分为, S1 ,...SV 共V 个子集 其中,pvj 表示Sv中第j类的概率

信息增益率

与ID3不同,C4.5采用基于信息增益率(information Gain Ratio)的方法选择测试属性,信息增益率等于 信息增益对分割信息量的比值。 GainRatio(S,A)=Gain(S,A)/SplitInformation(S,A)

将连续型的属性变量进行离散化处理形成决策树的训练集把需要处理的样本对应根节点或样本子集对应子树按照连续变量的大小从小到大进行排序假设该属性对应的不同的属性值一共有n个那么总共有n1个可能的候选分割阈值点每个候选的分割阈值点的值为上述排序后的属性值中两两前后连续元素的中点用信息增益率选择最佳划分c45属性值缺失缺失值

C4.5算法

1993年由Quilan提出的C4.5算法(对ID3的改

进失值的处理

信息增益率

信息熵 1948年,香农提出了“信息熵”的概念,解决了对系统信 息的量化度量问题。 香农认为信息的准确信息量可以用下面的信息熵公式计算:

Entropy ( S ) pi log 2 ( pi )

C4.5算法的分析和实现

基于决策树技术的数据挖掘方法分析和研究——C4.5算法的分析和实现摘要大数据时代已经到来,对数据的处理越来越受到人们的关注,人们迫切需要海量数据背后的重要信息和知识,发现数据中存在的关系和规则,获取有用的知识,并且根据现有数据对未来的发展做出预测。

决策树分类算法C4.5算法是数据挖掘中最常用、最经典的分类算法,能够以图形化的形式表现挖掘的结果,从而方便于使用者快速做出决定或预测。

决策树实际在各行业应用非常广泛,如客户资源管理(CRM)系统等。

本报告从决策树的各个方面对决策树进行分析,理解C4.5算法相对于ID3算法的改进,并对C4.5算法加以实现。

同时也指出C4.5算法还存在不足。

一、具体应用场景和意义决策树(Decision Tree)是用于分类和预测的主要技术,它着眼于从一组无规则的样例推理出决策树表示形式的分类规则,采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较,并根据不同属性判断从该节点向下分支,在决策树的叶节点得到结论。

因此,从根节点到叶节点就对应着一条合理规则,整棵树就对应着一组表达式规则。

基于决策树算法的一个最大的优点是它在学习过程中不需要使用者了解很多背景知识,只要训练样例能够用属性-值对的方式表示出来,就能使用该算法进行学习。

决策树算法在很多方面都有应用,如决策树算法在医学、制造和生产、金融分析、天文学、遥感影像分类和分子生物学、机器学习和知识发现等领域得到了广泛应用。

决策树技术是一种对海量数据集进行分类的非常有效的方法。

通过构造决策树模型,提取有价值的分类规则,帮助决策者做出准确的预测已经应用在很多领域。

决策树算法是一种逼近离散函数值的方法。

它是一种典型的分类方法,首先对数据进行处理,利用归纳算法生成可读的规则和决策树,然后对新数据进行分析。

本质上决策树是通过一系列规则对数据进行分类的过程。

决策树的典型算法有ID3、C4.5和CART等,基于决策树的分类模型有如下几个特点:(1)决策树方法结构简单,便于理解;(2)决策树模型效率高,对训练集较大的情况较为适合;(3)决策树方法通常不需要接受训练集数据外的知识;(4)决策树方法具有较高的分类精确度。

C45算法

精选可编辑ppt

12

(2)能够完成对连续属性的离散化处理

离散化处理过程中,C4.5算法是对节点上的每个 属性都要计算其信息增益率,然后从中选择信息增益率 最大的属性断点。由于在信息增益率计算过程中涉及 到对数函数的计算,在计算程序中就得调用库函数,同 时随着数据量的增大,计算量也随之增大。这样就增 加了计算量时间。因此,在改进的C4.5算法中采用了 “Fayyad 边界点判定定理”

信息增益(Gain) :

G a ( V ) i H n ( C ) H ( C |V ) io n ( T ) i fo n v ( T )f

属性V的信息熵:

n

H(V) p(vi)log2(p(vi)) i1

n

i1

|Ti | |T|

log2||TTi ||

spli_t info(V)

精选可编辑ppt

88 - 20log2 20

44 - 20log2 20

=1. 9464393

然后计算每个决策属性的期望信息量(即熵值) ,以决策属 性“政治成绩”为例,分别计算它为优、良、中三个类别 时的期望信息量,最终得出它的信息增益率。

精选可编辑ppt

20

三、C4.5算法应用举例

(1) 当“ 政治成绩 ” 为优时,

19 85. 67 86. 67 94. 29 87. 94

20 79. 33 79. 17 87. 83 80. 72

智育成绩 329. 50 343. 71 344. 22 342. 53 337. 93 338. 42 342. 92 330. 17 354. 57 327. 05

精选可编辑ppt

精选可编辑ppt

10

二、C4.5算法的具体实现

C4.5算法的源代码全解

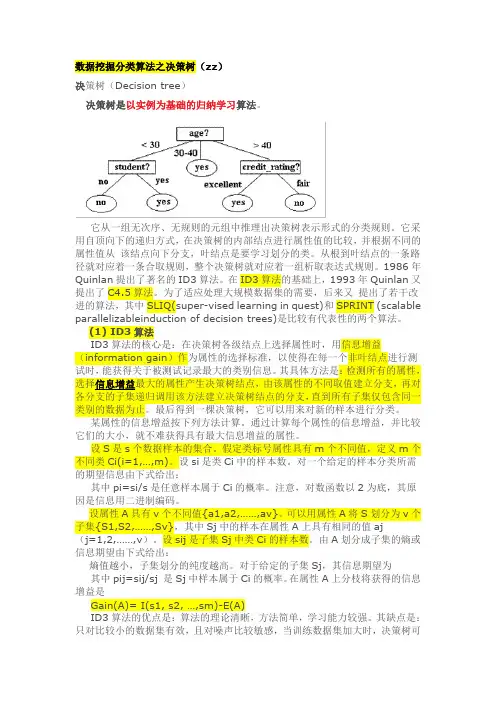

数据挖掘分类算法之决策树(zz)决策树(Decision tree)决策树是以实例为基础的归纳学习算法。

它从一组无次序、无规则的元组中推理出决策树表示形式的分类规则。

它采用自顶向下的递归方式,在决策树的内部结点进行属性值的比较,并根据不同的属性值从该结点向下分支,叶结点是要学习划分的类。

从根到叶结点的一条路径就对应着一条合取规则,整个决策树就对应着一组析取表达式规则。

1986年Quinlan提出了著名的ID3算法。

在ID3算法的基础上,1993年Quinlan又提出了C4.5算法。

为了适应处理大规模数据集的需要,后来又提出了若干改进的算法,其中SLIQ(super-vised learning in quest)和SPRINT (scalable parallelizableinduction of decision trees)是比较有代表性的两个算法。

(1) ID3算法ID3算法的核心是:在决策树各级结点上选择属性时,用信息增益(information gain)作为属性的选择标准,以使得在每一个非叶结点进行测试时,能获得关于被测试记录最大的类别信息。

其具体方法是:检测所有的属性,选择信息增益最大的属性产生决策树结点,由该属性的不同取值建立分支,再对各分支的子集递归调用该方法建立决策树结点的分支,直到所有子集仅包含同一类别的数据为止。

最后得到一棵决策树,它可以用来对新的样本进行分类。

某属性的信息增益按下列方法计算。

通过计算每个属性的信息增益,并比较它们的大小,就不难获得具有最大信息增益的属性。

设S是s个数据样本的集合。

假定类标号属性具有m个不同值,定义m个不同类Ci(i=1,…,m)。

设si是类Ci中的样本数。

对一个给定的样本分类所需的期望信息由下式给出:其中pi=si/s是任意样本属于Ci的概率。

注意,对数函数以2为底,其原因是信息用二进制编码。

设属性A具有v个不同值{a1,a2,……,av}。

c4.5决策树算法原理

c4.5决策树算法原理决策树是一种常用的机器学习算法,用于分类和回归问题。

C4.5算法是决策树算法中的一种改进型,相较于其他决策树算法,C4.5在生成决策树的过程中进行了优化,使其具有更高的分类准确率和性能。

**一、决策树算法简介**决策树是一种基于树形结构的分类模型,通过递归地将数据集划分为若干个子集,直到满足某种终止条件(如空子集或达到预设的停止条件)为止。

在每个划分节点处,根据数据特征进行分类或回归,并计算每个分支的代价和信息增益,以确定最优划分方式。

**二、C4.5算法原理**C4.5算法是对传统决策树算法的改进,主要包括以下几点:1. 剪枝策略:C4.5算法引入了剪枝策略,对生成的决策树进行优化,避免过拟合现象的发生。

通过设置停止条件和剪枝比例,可以控制决策树的复杂度,提高模型的泛化能力。

2. 适应度函数优化:C4.5算法在生成决策树的过程中,优化了适应度函数,使其更适用于连续值和离散值的分类问题。

通过对不同类型的数据进行不同的处理方式,可以提高分类准确率。

3. 考虑噪声和离群点:C4.5算法在生成决策树的过程中,会考虑噪声和离群点的存在。

通过对噪声进行平滑处理,对离群点进行特殊处理,可以提高决策树的鲁棒性。

4. 特征选择:C4.5算法在生成决策树的过程中,引入了特征选择机制,通过计算特征重要性得分,选择对分类影响最大的特征,以提高决策树的性能。

**三、应用场景**C4.5算法适用于各种分类和回归问题,尤其适用于数据量大、非线性可分的数据集。

在金融、医疗、保险、生物信息学等领域都有广泛的应用。

**四、总结**C4.5算法通过引入剪枝策略、优化适应度函数、考虑噪声和离群点以及特征选择等机制,对传统决策树算法进行了改进,提高了模型的分类准确率和性能。

在实际应用中,可以根据具体问题选择合适的算法和参数,以达到最佳的分类效果。

C4.5算法详解(非常仔细)...

C4.5算法详解(非常仔细)...首先,C4.5是决策树算法的一种。

决策树算法作为一种分类算法,目标就是将具有p维特征的n个样本分到c个类别中去。

相当于做一个投影,c=f(n),将样本经过一种变换赋予一种类别标签。

决策树为了达到这一目的,可以把分类的过程表示成一棵树,每次通过选择一个特征pi来进行分叉。

那么怎样选择分叉的特征呢?每一次分叉选择哪个特征对样本进行划分可以最快最准确的对样本分类呢?不同的决策树算法有着不同的特征选择方案。

ID3用信息增益,C4.5用信息增益率,CART用gini系数。

下面主要针对C4.5算法,我们用一个例子来计算一下。

上述数据集有四个属性,属性集合A={ 天气,温度,湿度,风速},类别标签有两个,类别集合L={进行,取消}。

1. 计算类别信息熵类别信息熵表示的是所有样本中各种类别出现的不确定性之和。

根据熵的概念,熵越大,不确定性就越大,把事情搞清楚所需要的信息量就越多。

2. 计算每个属性的信息熵每个属性的信息熵相当于一种条件熵。

他表示的是在某种属性的条件下,各种类别出现的不确定性之和。

属性的信息熵越大,表示这个属性中拥有的样本类别越不“纯”。

3. 计算信息增益信息增益的 = 熵 - 条件熵,在这里就是类别信息熵 - 属性信息熵,它表示的是信息不确定性减少的程度。

如果一个属性的信息增益越大,就表示用这个属性进行样本划分可以更好的减少划分后样本的不确定性,当然,选择该属性就可以更快更好地完成我们的分类目标。

信息增益就是ID3算法的特征选择指标。

但是我们假设这样的情况,每个属性中每种类别都只有一个样本,那这样属性信息熵就等于零,根据信息增益就无法选择出有效分类特征。

所以,C4.5选择使用信息增益率对ID3进行改进。

4.计算属性分裂信息度量用分裂信息度量来考虑某种属性进行分裂时分支的数量信息和尺寸信息,我们把这些信息称为属性的内在信息(instrisic information)。

C4.5算法学习

C4.5算法学习C4.5属于决策树算法的分类树决策树更是常见的机器学习⽅法,可以帮助我们解决分类与回归两类问题。

以决策树作为起点的原因很简单,因为它⾮常符合我们⼈类处理问题的⽅法,⽽且逻辑清晰,可解释性好。

从婴⼉到长者,我们每天都使⽤⽆数次!决策树的总体流程;总体流程分⽽治之(devide and conquer)⾃根结点的递归过程从每⼀个中间结点寻找⼀个划分(split and test)的属性三种停⽌条件:当前结点包含的样本属于同⼀类别,⽆需划分当前属性集为空,或是所有样本在所有属性值上取值相同,⽆法划分当前结点包含的样本集合为空,不能划分核⼼数学概念:熵信息熵(entropy)是度量样本集合“纯度”最常⽤的⼀种指标C4.5算法流程C4.5算法优缺点分析优点:(1)通过信息增益率选择分裂属性,克服了ID3算法中通过信息增益倾向于选择拥有多个属性值的属性作为分裂属性的不⾜;(2)能够处理离散型和连续型的属性类型,即将连续型的属性进⾏离散化处理;(3)构造决策树之后进⾏剪枝操作;(4)能够处理具有缺失属性值的训练数据。

缺点:(1)算法的计算效率较低,特别是针对含有连续属性值的训练样本时表现的尤为突出。

(2)算法在选择分裂属性时没有考虑到条件属性间的相关性,只计算数据集中每⼀个条件属性与决策属性之间的期望信息,有可能影响到属性选择的正确性。

算法详解:算法程序while(当前节点不纯)1.计算当前节点的类别熵Info(D)(以类别取值计算)2.计算当前节点的属性熵info(Ai)(按照当前属性取值下的类别取值计算)3.计算各个属性的信息增益Gain(Ai) = Info(D)-info(Ai)4.计算各个属性的分类信息度量H(Ai)(按照属性取值计算)5.计算各个属性的信息增益率 IGR = Gain(Ai)/H(Ai)and while当前节点设置为叶⼦节点。

C4.5算法的分析和实现

基于决策树技术的数据挖掘方法分析和研究——C4.5算法的分析和实现摘要大数据时代已经到来,对数据的处理越来越受到人们的关注,人们迫切需要海量数据背后的重要信息和知识,发现数据中存在的关系和规则,获取有用的知识,并且根据现有数据对未来的发展做出预测。

决策树分类算法C4.5算法是数据挖掘中最常用、最经典的分类算法,能够以图形化的形式表现挖掘的结果,从而方便于使用者快速做出决定或预测。

决策树实际在各行业应用非常广泛,如客户资源管理(CRM)系统等。

本报告从决策树的各个方面对决策树进行分析,理解C4.5算法相对于ID3算法的改进,并对C4.5算法加以实现。

同时也指出C4.5算法还存在不足。

一、具体应用场景和意义决策树(Decision Tree)是用于分类和预测的主要技术,它着眼于从一组无规则的样例推理出决策树表示形式的分类规则,采用自顶向下的递归方式,在决策树的内部节点进行属性值的比较,并根据不同属性判断从该节点向下分支,在决策树的叶节点得到结论。

因此,从根节点到叶节点就对应着一条合理规则,整棵树就对应着一组表达式规则。

基于决策树算法的一个最大的优点是它在学习过程中不需要使用者了解很多背景知识,只要训练样例能够用属性-值对的方式表示出来,就能使用该算法进行学习。

决策树算法在很多方面都有应用,如决策树算法在医学、制造和生产、金融分析、天文学、遥感影像分类和分子生物学、机器学习和知识发现等领域得到了广泛应用。

决策树技术是一种对海量数据集进行分类的非常有效的方法。

通过构造决策树模型,提取有价值的分类规则,帮助决策者做出准确的预测已经应用在很多领域。

决策树算法是一种逼近离散函数值的方法。

它是一种典型的分类方法,首先对数据进行处理,利用归纳算法生成可读的规则和决策树,然后对新数据进行分析。

本质上决策树是通过一系列规则对数据进行分类的过程。

决策树的典型算法有ID3、C4.5和CART等,基于决策树的分类模型有如下几个特点:(1)决策树方法结构简单,便于理解;(2)决策树模型效率高,对训练集较大的情况较为适合;(3)决策树方法通常不需要接受训练集数据外的知识;(4)决策树方法具有较高的分类精确度。

C4.5算法的实现

C4.5算法的实现一.C4.5算法介绍C4.5算法是机器学习算法中的一种分类决策树算法,其核心算法是ID3算法.C4.5算法继承了ID3算法的优点,并在以下几方面对ID3算法进行了改进:1) 用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足;2) 在树构造过程中进行剪枝;3) 能够完成对连续属性的离散化处理;4) 能够对不完整数据进行处理。

C4.5算法有如下优点:产生的分类规则易于理解,准确率较高。

其缺点是:在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。

二. 算法实现// C4.5_test.cpp : Defines the entry point for the console application.//#include "stdafx.h"#include <stdio.h>#include <math.h>#include "malloc.h"#include <stdlib.h>const int MAX = 10;int** iInput;int i = 0;//列数int j = 0;//行数void build_tree(FILE *fp, int* iSamples, int* iAttribute,int ilevel);//输出规则int choose_attribute(int* iSamples, int* iAttribute);//通过计算信息增益率选出test_attribute double info(double dTrue,double dFalse);//计算期望信息double entropy(double dTrue, double dFalse, double dAll);//求熵double splitinfo(int* list,double dAll);int check_samples(int *iSamples);//检查samples是否都在同一个类里int check_ordinary(int *iSamples);//检查最普通的类int check_attribute_null(int *iAttribute);//检查attribute是否为空void get_attributes(int *iSamples,int*iAttributeValue,int iAttribute);int _tmain(int argc, _TCHAR* argv[]){FILE *fp;FILE *fp1;char iGet;int a = 0;int b = 0;//a,b是循环变量int* iSamples;int* iAttribute;fp = fopen("c:\\input.txt","r");if (NULL == fp){printf("error\n");return 0;}iGet = getc(fp);while (('\n' != iGet)&&(EOF != iGet)) {if (',' == iGet){i++; }iGet = getc(fp); }i++;iAttribute = (int *)malloc(sizeof(int)*i); for (int k = 0; k<i; k++){iAttribute[k] = (int)malloc(sizeof(int)); iAttribute[k] = 1; }while (EOF != iGet){ if ('\n' == iGet){j++; }iGet = getc(fp); }j++;iInput = (int **)malloc(sizeof(int*)*j);iSamples = (int *)malloc(sizeof(int)*j);for (a = 0;a < j;a++){ iInput[a] = (int *)malloc(sizeof(int)*i); iSamples[a] = (int)malloc(sizeof(int));iSamples[a] = a; }a = 0;fclose(fp);fp=fopen("c:\\input.txt","r");iGet = getc(fp);while(EOF != iGet){ if ((',' != iGet)&&('\n' != iGet)){ iInput[a][b] = iGet - 48;b++; }if (b == i){ a++;b = 0;}iGet = getc(fp); }fp1 = fopen("d:\\output.txt","w");build_tree(fp1,iSamples,iAttribute,0);fclose(fp);return 0;}void build_tree(FILE * fp, int* iSamples, int* iAttribute,int level)//{ int iTest_Attribute = 0;int iAttributeValue[MAX];int k = 0;int l = 0;int m = 0;int *iSamples1;for (k = 0; k<MAX; k++){ iAttributeValue[k] = -1; }if (0 == check_samples(iSamples)){fprintf(fp,"result: %d\n",iInput[iSamples[0]][i-1];return; }if (1 == check_attribute_null(iAttribute)) {fprintf(fp,"result: %d\n",check_ordinary(iSamples));return; }iTest_Attribute = choose_attribute(iSamples,iAttribute);iAttribute[iTest_Attribute] = -1;get_attributes(iSamples,iAttributeValue,iTest_Attribute);k = 0;while ((-1 != iAttributeValue[k])&&(k < MAX)){ l = 0;m = 0;while ((-1 != iSamples[l])&&(l < j)){if(iInput[iSamples[l]][iTest_Attribute]==iAttributeValue[k]){ m++; }l++; }iSamples1 = (int *)malloc(sizeof(int)*(m+1));l = 0;m = 0;while ((-1 != iSamples[l])&&(l < j)){if(iInput[iSamples[l]][iTest_Attribute]==iAttributeValue[k]){ iSamples1[m] = iSamples[l];m++; }l++; }iSamples1[m] = -1;if (-1 == iSamples1[0]){fprintf(fp,"result: %d\n",check_ordinary(iSamples));return; }fprintf(fp,"level%d: %d = %d\n",level,iTest_Attribute,iAttributeValue[k]);build_tree(fp,iSamples1,iAttribute,level+1);k++; }}int choose_attribute(int* iSamples, int* iAttribute){ int iTestAttribute = -1;int k = 0;int l = 0;int m = 0;int n = 0;int iTrue = 0;int iFalse = 0;int iTrue1 = 0;int iFalse1 = 0;int iDepart[MAX];int iRecord[MAX];double dEntropy = 0.0;double dGainratio = 0.0;double test = 0.0;for (k = 0;k<MAX;k++){ iDepart[k] = -1;iRecord[k] = 0; }k = 0;while ((l!=2)&&(k<(i - 1))){ if (iAttribute[k] == -1){ l++; }k++; }if (l == 1){ for (k = 0;k<(k-1);k++){ if (iAttribute[k] == -1){ return iAttribute[k]; } } }for (k = 0;k < (i-1);k++){ l = 0;iTrue = 0;iFalse = 0;if (iAttribute[k] != -1){ while ((-1 != iSamples[l])&&(l < j)){ if (0 == iInput[iSamples[l]][i-1]){ iFalse++; }if (1 == iInput[iSamples[l]][i-1]){ iTrue++; }l++; }for (n = 0;n<l;n++)//计算该属性有多少不同的值并记录 { m = 0;while((iDepart[m]!=-1)&&(m!=MAX)){ if (iInput[iSamples[n]][iAttribute[k]] == iDepart[m]) {break; }m++; }if (-1 == iDepart[m]){ iDepart[m] = iInput[iSamples[n]][iAttribute[k]]; } } while ((iDepart[m] != -1)&&(m!=MAX)){ for (n = 0;n<l;n++){if (iInput[iSamples[n]][iAttribute[k]] == iDepart[m]) {if (1 == iInput[iSamples[n]][i-1]){ iTrue1++; }if (0 == iInput[iSamples[n]][i-1]){ iFalse1++; }iRecord[m]++; } }dEntropy += entropy((double)iTrue1,(double)iFalse1,(double)l);iTrue1 = 0;iFalse1 = 0;m++; }double dSplitinfo = splitinfo(iRecord,(double)l);if (-1 == iTestAttribute){iTestAttribute = k;dGainratio=(info((double)iTrue,(double)iFalse)-dEntropy)/dSplitinfo;} else{test=(info((double)iTrue,(double)iFalse)-dEntro py)/dSplitinfo;if (dGainratio < test){ iTestAttribute = k;dGainratio = test; }}} }return iTestAttribute;}double info(double dTrue,double dFalse){ double dInfo = 0.0;dInfo = ((dTrue/(dTrue+dFalse))*(log(dTrue/(dTrue+dFalse))/log(2 .0))+(dFalse/(dTrue+dFalse))*(log(dFalse/(dTrue+dFalse)) /log(2.0)))*(-1);return dInfo;}double entropy(double dTrue, double dFalse, double dAll) { double dEntropy = 0.0;dEntropy = (dTrue + dFalse)*info(dTrue,dFalse)/dAll;return dEntropy;}double splitinfo(int* list,double dAll){ int k = 0;double dSplitinfo = 0.0;while (0!=list[k]){dSplitinfo-=((double)list[k]/(double)dAll)*(log((double)li st[k]/(double)dAll));k++; }return dSplitinfo;}int check_samples(int *iSamples){ int k = 0;int b = 0;while ((-1 != iSamples[k])&&(k < j-1)){ if (iInput[k][i-1] != iInput[k+1][i-1]){b = 1;break; }k++; }return b;}11int check_ordinary(int *iSamples){ int k = 0;int iTrue = 0;int iFalse = 0;while ((-1 != iSamples[k])&&(k < i)){ if (0 == iInput[iSamples[k]][i-1]){iFalse++; }else{ iTrue++; }k++;}if (iTrue >= iFalse){ return 1;}else{ return 0; }}int check_attribute_null(int *iAttribute){ int k = 0;while (k < (i-1)){if (-1 != iAttribute[k]){ return 0;}k++; }return 1;}void get_attributes(int *iSamples,int12*iAttributeValue,int iAttribute){int k = 0;int l = 0;while ((-1 != iSamples[k])&&(k < j)){l = 0;while (-1 != iAttributeValue[l]){if (iInput[iSamples[k]][iAttribute] == iAttributeValue[l]) { break; }l++; }if (-1 == iAttributeValue[l]){iAttributeValue[l] = iInput[iSamples[k]][iAttribute];}k++;}}13。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

组长:赵庆杰 报告人:赵庆杰 成员:潘志舟 朱鹏 刘纯 汪光炼 漆学志

提纲

• 必备概念知识 • 算法背景简介 • 算法描述

必备概念知识

• • • • • 数据挖掘 分类和聚类 决策树 ID3算法 C4.5算法

•

•

数据挖掘

Data mining is the computational process of discovering patterns in large data sets involving methods at the intersection of artificial intelligence, machine learning, statistics, and database systems.The overall goal of the data mining process is to extract information from a data set and transform it into an understandable structure for further use.(Wikipedia) 数据挖掘一般是指从大量的数据中自动搜索隐3几何表示 • 4基元(链码)表示 • 条件属性和决策属性

ID3算法介绍

• 一个离散型属性样本实例——PlayTennis数据库片段:

ID3算法介绍

• 关于PlayTennis的决策树:

Outlook Sunny Overcast Humidity High Normal Yes Strong No Wind Weak Yes Rain

vValues A

Sv S

E Sv

回顾ID3算法

• ID3算法每一步选择具有最大信息增益的属性作为测试属 性来长树。直到最大的信息增益为也零为止。(两个问题 的解决) • ID3算法存在的主要不足: –过度拟合问题(tree prunning) – 处理连续属性值问题(discretization) – 处理缺少属性值问题(replacement) – 属性选择的度量标准问题(heuristic measure)

• 其中,S1到Sc是c个不同值的属性A分割S而形成的c个样本子集。如 按照属性A把S集(含30个用例)分成了10个用例和20个用例两个集 合则SplitInfo(S,A)=-1/3*log(1/3)-2/3*log(2/3)

对于连续变量决策树中的测试是怎样的?

• 很明显,我们看到这个例子中对于连续变量,所有连续变量的测试分 支都是2条,因此在C4.5算法中,连续变量的分支总是两条,分支其 测试分支分别对应着{<=θ ,>θ },θ 对应着分支阈值,但是这个θ 怎么 确定呢? • 很简单,把需要处理的样本(对应根节点)或样本子集(对应子树) 按照连续变量的大小从小到大进行排序,假设该属性对应的不同的属 性值一共有N个,那么总共有N-1个可能的候选分割阈值点,每个候 选的分割阈值点的值为上述排序后的属性值链表中两两前后连续元素 的中点,那么我们的任务就是从这个N-1个候选分割阈值点中选出一 个,使得前面提到的信息论标准最大。举个例子,对于Golf数据集, 我们来处理温度属性,来选择合适的阈值。首先按照温度大小对对应 样本进行排序如下

No

Yes

ID3算法介绍

• 1986年,Quinlan提出了著名的ID3算法。 • 用ID3算法长树的基本思想: – 分类能力最好的属性被测试并创建树的根结点 – 测试属性每个可能的值产生一个分支 – 训练样本划分到适当的分支形成儿子结点 – 重复上面的过程,直到所有的结点都是叶子结点

优先选择哪 些属性测试

C4.5算法应该解决的问题

• • • • • 如何选择测试属性构造决策树? 对于连续变量决策树中的测试是怎样的? 如何选择处理连续变量(阀值)? 如何终止树的增长? 如何确定叶子节点的类?

决策树

• 关于PlayGolf的决策树:

如何选择测试属性构造决策树?

• 用信息增益率来选择属性

• 这个指标实际上就等于增益/熵,之所以采用这个指标是为了克服采 用增益作为衡量标准的缺点,采用增益作为衡量标准会导致分类树倾 向于优先选择那些具有比较多的分支的测试,也就是选择取值较多的 属性,这种倾向需要被抑制

期望熵(Expected Entropy)

• 属性A划分样本集S导致的期望熵E(S, A)为:

E S , A

其中,Values(A)为属性A取值的集合;Sv为S中A取值为v的样本子集,Sv={sS A(s)=v};E(Sv)为将Sv中的样本 划分为c个类的信息熵。|Sv|/|S|为Sv和S中的样本个数之比。 条件属性outlook共有sunny/overcast/rain三个取值 sunny的取值为5个,其中YES和NO的比例是2/3, I(sunny)=-(2/5)log2(2/5)-(3/5)log2(3/5)=0.976 I(overcast)=-(4/4)log2(4/4)=0.000 I(rain)=-(3/5)log2(3/5)-(2/5)log2(2/5)=0.976 E(S,outlook)=(5/14)*0.976+(4/14)*0.000+(5/14)*0.976=0.694 E(S,windy)=0.892 …. Gain(Outlook)=0.940-0.694=0.246, Gain(Windy)=0.940-0.892=0.048 ….

如何终止树的增长?

• 前面提到树的增长实际上是一个递归过程,那么这个递归什 么时候到达终止条件退出递归呢?有两种方式,第一种方式 是如果某一节点的分支所覆盖的样本都属于同一类的时候, 那么递归就可以终止,该分支就会产生一个叶子节点.还有 一种方式就是,如果某一分支覆盖的样本的个数如果小于 一个阈值,那么也可产生叶子节点,从而终止树的增长

• 那么可以看到有13个可能的候选阈值点,比如 middle[64,65], middle[65,68]….,middle[83,85]。那么 最优的阈值该选多少呢?应该是middle[71,72],如上图 中红线所示。为什么呢?如下计算:

• 通过上述计算方式,0.939是最大的,因此测试的增益是 最小的。(测试的增益和测试后的熵是成反比的,这个从 后面的公式可以很清楚的看到)。根据上面的描述,我们 需要对每个候选分割阈值进行增益或熵的计算才能得到最 优的阈值,我们需要算N-1次增益或熵(对应温度这个变 量而言就是13次计算)。能否有所改进呢?少算几次,加 快速度。答案是可以该进

如何确定叶子节点的类?

• Tree-Growth终止的方式有2种,对于第一种方式,叶子 节点覆盖的样本都属于同一类,那么这种情况下叶子节点 的类自然不必多言。对于第二种方式,叶子节点覆盖的样 本未必属于同一类,直接一点的方法就是,该叶子节点所 覆盖的样本哪个类占大多数,那么该叶子节点的类别就是 那个占大多数的类。

熵(Entropy)

• 划分样本集S为c个类的熵E(S) 为:

E S

p log

i pi =ni /n,为S中的样本属于第i类Ci的概率,n为S 中样本的个数。 决策属性分为YES/NO两类,S1(YES)=9,S2(NO)=5, S=S1+S2=14 • E(S)=-(9/14)log2(9/14)-(5/14)log2(5/14)=0.940

决策树算法增长树的每一个分支的深度,直到恰好能对训练样例比较完美地分类。实际应用中,当数据中 有噪声或训练样例的数量太少以至于不能产生目标函数的有代表性的采样时,该策略可能会遇到困难。

• 针对这些不足, Quinlan做了一系列的改进,并于1993 年形成了C4.5算法。

C4.5算法介绍

• 一个含有连续型属性样本实例——PlayGolf数据库片段:

• •

ID3算法 C4.5算法

ID3算法介绍

• 样本的表示方法 1. 向量表示 : 假设一个样本有n个变量(特征) Ⅹ= (X1,X2,…,Xn)T 2. 矩阵表示: N个样本,n个变量(特征)

变量 样本 X1 X2 … XN x1 X11 X21 … XN1 x2 X12 X22 … XN2 … … … … … xn X1n X2n … XNn

两个问题:什么属性最好?什么结点才是叶子结点?

什么时候结 束树的增长

信息增益(Information Gain)

• 属性A划分样本集S的信息增益Gain(S, A)为: Gain(S, A)=E(S)–E(S, A) 其中,E(S )为划分样本集S为c个类的熵; E(S, A)为属性A 划分样本集S导致的期望熵。 • 所谓增益,就是指在应用了某一测试之后,其对应的可能 性丰富程度下降,不确定性减小,这个减小的幅度就是增 益,其实质上对应着分类带来的好处

•

•

• •

分类和聚类

分类(Classification)就是按照某种标准给对象贴标签,再根据标签来区分归类,类别数不变。 聚类(clustering)是指根据“物以类聚”的原理,将本身没有类别的样本聚集成不同的组,这样的一组数据对象的集 合叫做簇,并且对每一个这样的簇进行描述的过程。

•

决策树

决策树是一种典型的分类方法,首先对数据进行处理,利用归纳算法生成可读的规则和决策树,然 后使用决策对新数据进行分析。本质上决策树是通过一系列规则对数据进行分类的过程。由于这种 决策分支画成图形很像一棵树的枝干,故称决策树。

致谢

欢迎提问