回归方程的系数的相关系数矩阵

应用回归分析,第3章课后习题参考答案

第3章 多元线性回归思考与练习参考答案3.2 讨论样本容量n 与自变量个数p 的关系,它们对模型的参数估计有何影响?答:在多元线性回归模型中,样本容量n 与自变量个数p 的关系是:n>>p 。

如果n<=p 对模型的参数估计会带来很严重的影响。

因为: 1. 在多元线性回归模型中,有p+1个待估参数β,所以样本容量的个数应该大于解释变量的个数,否则参数无法估计。

2. 解释变量X 是确定性变量,要求()1rank p n =+<X ,表明设计矩阵X 中的自变量列之间不相关,即矩阵X 是一个满秩矩阵。

若()1rank p <+X ,则解释变量之间线性相关,1()X X -'是奇异阵,则β的估计不稳定。

3.3证明随机误差项ε的方差σ2的无偏估计。

证明:22122222111112221111ˆ(),111()()(1)(1)()(1)1ˆ()()1n i i n n nnnii ii iiii i i i i i ni i SSE e e e n p n p n p E e D e h h n h n p E E e n p σσσσσσσ======='===------∴==-=-=-=--∴==--∑∑∑∑∑∑∑3.4 一个回归方程的复相关系数R=0.99,样本决定系数R 2=0.9801,我们能判断这个回归方程就很理想吗? 答:不能断定这个回归方程理想。

因为:1. 在样本容量较少,变量个数较大时,决定系数的值容易接近1,而此时可能F 检验或者关于回归系数的t 检验,所建立的回归方()1ˆ2--=p n SSE σ程都没能通过。

2. 样本决定系数和复相关系数接近于1只能说明Y 与自变量X1,X2,…,Xp 整体上的线性关系成立,而不能判断回归方程和每个自变量是显著的,还需进行F 检验和t 检验。

3. 在应用过程中发现,在样本容量一定的情况下,如果在模型中增加解释变量必定使得自由度减少,使得 R 2往往增大,因此增加解释变量(尤其是不显著的解释变量)个数引起的R 2的增大与拟合好坏无关。

回归方程的相关系数公式(一)

回归方程的相关系数公式(一)回归方程的相关系数公式在统计学中,回归分析是一种用于探索变量之间关系的方法。

回归分析可用于预测和解释因变量与一个或多个自变量之间的关系。

相关系数是回归分析中常用的指标,用于衡量自变量与因变量之间的关联程度。

下面是回归方程的相关系数公式及其解释说明。

简单线性回归的相关系数公式在简单线性回归中,只有一个自变量和一个因变量。

相关系数(也称为皮尔逊相关系数)表示自变量和因变量之间的线性关系强度。

相关系数公式如下:r=∑(x−x)(y−y)i i其中,r为相关系数,x i和y i分别表示第i个观测值的自变量和因变量值,x和y分别为自变量和因变量的均值。

多元线性回归的相关系数公式多元线性回归中,有多个自变量和一个因变量。

相关系数矩阵可以用来衡量每个自变量与因变量之间的关联程度。

相关系数矩阵公式如下:R=(X T X)−1(X T Y)其中,R为相关系数矩阵,X为自变量矩阵,Y为因变量矩阵。

示例说明假设我们想要研究某个城市的房价与以下两个因素的关系:房屋面积和距离市中心的距离。

我们收集了10个房屋的数据,如下所示:房屋编号 | 面积(平方米) | 距离市中心(公里) | 房价(万元) || | | |1 | 80 | 5 | 200 |2 | 90 | 4 | 220 |3 | 95 | 7 | 230 |4 | 100 | 6 | 250 |5 | 110 | 3 | 270 |6 | 120 | 8 | 290 |7 | 130 | 2 | 310 |8 | 140 | 9 | 330 |9 | 150 | 1 | 350 |10 | 160 | 10 | 370 |我们可以使用多元线性回归模型来分析房屋面积和距离市中心与房价之间的关系。

根据相关系数矩阵公式,我们可以计算出相关系数矩阵R:R=(X T X)−1(X T Y)其中,X是由房屋面积和距离市中心组成的自变量矩阵,Y是房价的因变量矩阵。

线性回归中的相关系数

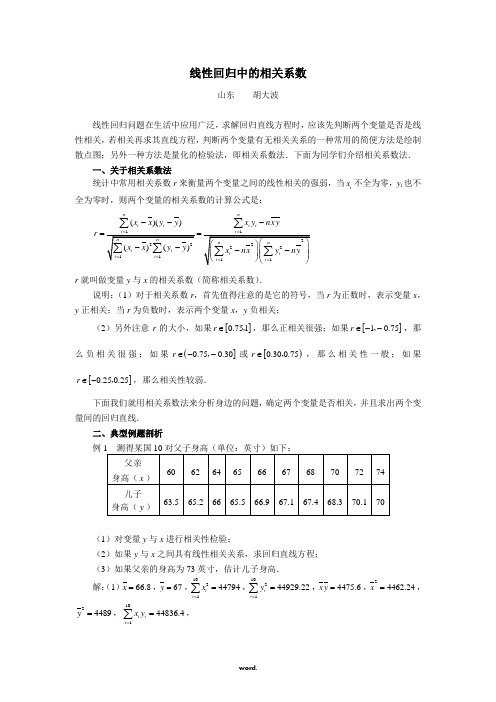

线性回归中的相关系数山东 胡大波线性回归问题在生活中应用广泛,求解回归直线方程时,应该先判断两个变量就是否就是线性相关,若相关再求其直线方程,判断两个变量有无相关关系的一种常用的简便方法就是绘制散点图;另外一种方法就是量化的检验法,即相关系数法.下面为同学们介绍相关系数法. 一、关于相关系数法统计中常用相关系数r 来衡量两个变量之间的线性相关的强弱,当i x 不全为零,y i 也不全为零时,则两个变量的相关系数的计算公式就是:()()nnii i ixx y y x ynx yr ---==∑∑r 就叫做变量y 与x 的相关系数(简称相关系数).说明:(1)对于相关系数r ,首先值得注意的就是它的符号,当r 为正数时,表示变量x ,y 正相关;当r 为负数时,表示两个变量x ,y 负相关;(2)另外注意r 的大小,如果[]0.751r ∈,,那么正相关很强;如果[]10.75r ∈--,,那么负相关很强;如果(]0.750.30r ∈--,或[)0.300.75r ∈,,那么相关性一般;如果[]0.250.25r ∈-,,那么相关性较弱.下面我们就用相关系数法来分析身边的问题,确定两个变量就是否相关,并且求出两个变量间的回归直线. 二、典型例题剖析(1)对变量y 与x 进行相关性检验;(2)如果y 与x 之间具有线性相关关系,求回归直线方程; (3)如果父亲的身高为73英寸,估计儿子身高.解:(1)66.8x =,67y =,102144794i i x ==∑,102144929.22i i y ==∑,4475.6x y =,24462.24x =,24489y =,10144836.4i i i x y ==∑,所以10i ix ynx yr -∑44836.4104475.6(4479444622.4)(44929.2244890)-⨯=--80.40.9882.04≈≈, 所以y 与x 之间具有线性相关关系. (2)设回归直线方程为y a bx =+,则101102211010i ii i i x yxyb x x==-=-∑∑44836.4447560.46854479444622.4-=≈-,670.468566.835.7042a y bx =-=-⨯=.故所求的回归直线方程为0.468535.7042y x =+. (3)当73x =英寸时,0.46857335.704269.9047y =⨯+=, 所以当父亲身高为73英寸时,估计儿子的身高约为69、9英寸.点评:回归直线就是对两个变量线性相关关系的定量描述,利用回归直线,可以对一些实际问题进行分析、预测,由一个变量的变化可以推测出另一个变量的变化.这就是此类问题常见题型.例2 10其中x 为高一数学成绩,y 为高二数学成绩. (1)y 与x 就是否具有相关关系;(2)如果y 与x 就是相关关系,求回归直线方程. 解:(1)由已知表格中的数据,利用计算器进行计算得 101710ii x==∑,101723i i y ==∑,71x =,72.3y =,10151467i i i x y ==∑.102150520ii x==∑,102152541i i y ==∑.1010i ix yx yr -=∑0.78=≈.由于0.78r ≈,由0.780.75>知,有很大的把握认为x 与y 之间具有线性相关关系. (2)y 与x 具有线性相关关系,设回归直线方程为y a bx =+,则1011022211051467107172.31.2250520107110i ii i i x yx yb x x==--⨯⨯==≈-⨯-∑∑,72.3 1.227114.32a y bx =-=-⨯=-.所以y 关于x 的回归直线方程为 1.2214.32y x =-.点评:通过以上两例可以瞧出,回归方程在生活中应用广泛,要明确这类问题的计算公式、解题步骤,并会通过计算确定两个变量就是否具有相关关系.。

应用回归分析整理课后习题参考答案

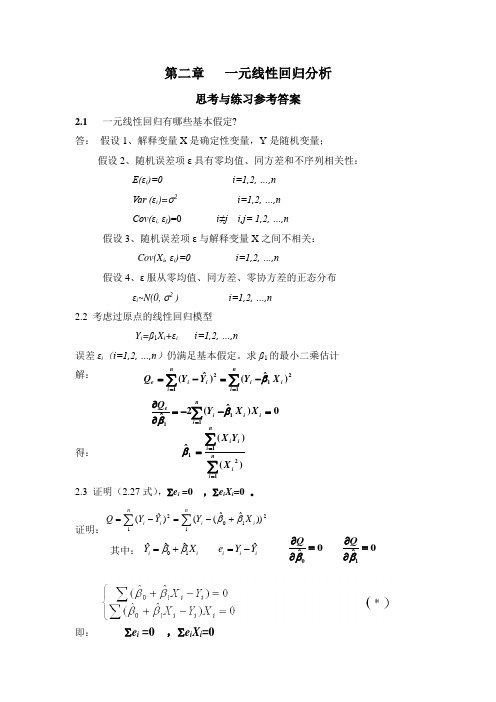

第二章 一元线性回归分析思考与练习参考答案2.1 一元线性回归有哪些基本假定?答: 假设1、解释变量X 是确定性变量,Y 是随机变量;假设2、随机误差项ε具有零均值、同方差和不序列相关性: E(εi )=0 i=1,2, …,n Var (εi )=σ2 i=1,2, …,n Cov(εi, εj )=0 i≠j i,j= 1,2, …,n 假设3、随机误差项ε与解释变量X 之间不相关: Cov(X i , εi )=0 i=1,2, …,n假设4、ε服从零均值、同方差、零协方差的正态分布 εi ~N(0, σ2 ) i=1,2, …,n 2.2 考虑过原点的线性回归模型 Y i =β1X i +εi i=1,2, …,n误差εi (i=1,2, …,n )仍满足基本假定。

求β1的最小二乘估计 解: 得:2.3 证明(2.27式),∑e i =0 ,∑e i X i =0 。

证明:∑∑+-=-=nii i ni X Y Y Y Q 121021))ˆˆ(()ˆ(ββ其中:即: ∑e i =0 ,∑e i X i =021112)ˆ()ˆ(ini i ni i i e X Y Y Y Q β∑∑==-=-=0)ˆ(2ˆ111=--=∂∂∑=ii ni i eX X Y Q ββ)()(ˆ1211∑∑===ni i ni ii X Y X β01ˆˆˆˆi ii i iY X e Y Y ββ=+=-0100ˆˆQQββ∂∂==∂∂2.4回归方程E (Y )=β0+β1X 的参数β0,β1的最小二乘估计与最大似然估计在什么条件下等价?给出证明。

答:由于εi ~N(0, σ2 ) i=1,2, …,n所以Y i =β0 + β1X i + εi ~N (β0+β1X i , σ2 ) 最大似然函数:使得Ln (L )最大的0ˆβ,1ˆβ就是β0,β1的最大似然估计值。

同时发现使得Ln (L )最大就是使得下式最小,∑∑+-=-=nii i n i X Y Y Y Q 121021))ˆˆ(()ˆ(ββ上式恰好就是最小二乘估计的目标函数相同。

线性回归中的相关系数

线性回归中的相关系数文档编制序号:[KKIDT-LLE0828-LLETD298-POI08]线性回归中的相关系数山东胡大波线性回归问题在生活中应用广泛,求解回归直线方程时,应该先判断两个变量是否是线性相关,若相关再求其直线方程,判断两个变量有无相关关系的一种常用的简便方法是绘制散点图;另外一种方法是量化的检验法,即相关系数法.下面为同学们介绍相关系数法.一、关于相关系数法统计中常用相关系数r来衡量两个变量之间的线性相关的强弱,当x不全为零,y ii也不全为零时,则两个变量的相关系数的计算公式是:r就叫做变量y与x的相关系数(简称相关系数).说明:(1)对于相关系数r,首先值得注意的是它的符号,当r为正数时,表示变量x,y正相关;当r为负数时,表示两个变量x,y负相关;(2)另外注意r的大小,如果[]r∈,,那么正相关很强;如果[]0.751r∈--,,那10.75么负相关很强;如果(],或[)r∈,,那么相关性一般;如果0.300.75r∈--0.750.30[]r∈-,,那么相关性较弱.0.250.25下面我们就用相关系数法来分析身边的问题,确定两个变量是否相关,并且求出两个变量间的回归直线.二、典型例题剖析例1测得某国10对父子身高(单位:英寸)如下:(1)对变量y 与x 进行相关性检验;(2)如果y 与x 之间具有线性相关关系,求回归直线方程; (3)如果父亲的身高为73英寸,估计儿子身高.解:(1)66.8x =,67y =,102144794i i x ==∑,102144929.22i i y ==∑,4475.6x y =,24462.24x =,24489y =,10144836.4i i i x y ==∑,所以10i ix ynx yr -=∑80.40.9882.04≈≈, 所以y 与x 之间具有线性相关关系.(2)设回归直线方程为y a bx =+,则101102211010i ii i i x yxyb x x==-=-∑∑44836.4447560.46854479444622.4-=≈-,670.468566.835.7042a y bx =-=-⨯=.故所求的回归直线方程为0.468535.7042y x =+. (3)当73x =英寸时,0.46857335.704269.9047y =⨯+=, 所以当父亲身高为73英寸时,估计儿子的身高约为英寸.点评:回归直线是对两个变量线性相关关系的定量描述,利用回归直线,可以对一些实际问题进行分析、预测,由一个变量的变化可以推测出另一个变量的变化.这是此类问题常见题型.例2 10名同学在高一和高二的数学成绩如下表:其中x 为高一数学成绩,y 为高二数学成绩. (1)y 与x 是否具有相关关系;(2)如果y 与x 是相关关系,求回归直线方程. 解:(1)由已知表格中的数据,利用计算器进行计算得 101710i i x ==∑,101723i i y ==∑,71x =,72.3y =,10151467i i i x y ==∑.102150520ii x==∑,102152541i i y ==∑.0.78=≈.由于0.78r ≈,由0.780.75>知,有很大的把握认为x 与y 之间具有线性相关关系. (2)y 与x 具有线性相关关系,设回归直线方程为y a bx =+,则1011022211051467107172.31.2250520107110i ii i i x yx yb x x==--⨯⨯==≈-⨯-∑∑,72.3 1.227114.32a y bx =-=-⨯=-.所以y 关于x 的回归直线方程为 1.2214.32y x =-.点评:通过以上两例可以看出,回归方程在生活中应用广泛,要明确这类问题的计算公式、解题步骤,并会通过计算确定两个变量是否具有相关关系.。

相关系数与回归系数

相关系数与回归系数

一、相关系数和回归系数的区别

1、含义不同

相关系数:是研究变量之间线性相关程度的量。

回归系数:在回归方程中表示自变量x 对因变量y 影响大小的参数。

2、应用不同

相关系数:说明两变量间的相关关系。

回归系数:说明两变量间依存变化的数量关系。

3、单位不同

相关系数:一般用字母r表示,r没有单位。

回归系数:一般用斜率b表示,b有单位。

二、回归系数与相关系数的联系:

1、回归系数大于零则相关系数大于零

2、回归系数小于零则相关系数小于零。

线性回归中的相关系数(精.选)

山东胡大波

线性回归问题在生活中应用广泛,求解回归直线方程时,应该先判断两个变量是否是线性相关,若相关再求其直线方程,判断两个变量有无相关关系的一种常用的简便方法是绘制散点图;另外一种方法是量化的检验法,即相关系数法.下面为同学们介绍相关系数法.

一、关于相关系数法

统计中常用相关系数r来衡量两个变量之间的线性相关的强弱,当 不全为零,yi也不全为零时,则两个变量的相关系数的计算公式是:

(2)如果y与x之间具有线性相关关系,求回归直线方程;

(3)如果父亲的身高为73英寸,估计儿子身高.

解:(1) , , , , , ,

, ,

所以

,

所以y与x之间具有线性相关关系.

(2)设回归直线方程为 ,则 ,

.

故所求的回归直线方程为 .

(3)当 英寸时, ,

所以当父亲身高为73英寸时,估计儿子的身高约为69.9英寸.

r就叫做变量y与x的相关系数(简称相关系数).

说明:(1)对于相关系数r,首先值得注意的是它的符号,当r为正数时,表示变量x,y正相关;当r为负数时,表示两个变量x,y负相关;

(2)另外注意r的大小,如果 ,那么正相关很强;如果 ,那么负相关很强;如果 或 ,那么相关性一般;如果 ,那么相关性较弱.

下面我们就用相关系数法来分析身边的问题,确定两个变量是否相关,并且求出两个变量间的回归直线.

二、典型例题剖析

例1测得某国10对父子身高(单位:英寸)如下:

父亲

身高( )

60

62

64

65

66

67

68

70

72

74

儿子

身高( )

63.5

65.2

回归方程的相关系数公式

回归方程的相关系数公式

摘要:

一、回归方程的相关系数公式简介

二、相关系数的计算方法

三、相关系数的应用场景

四、相关系数与回归系数的关系

正文:

一、回归方程的相关系数公式简介

在回归分析中,相关系数是一个非常重要的概念,用于衡量两个变量之间的线性关系的强度和方向。

相关系数的公式为:r = ∑((x_i-平均x)*(y_i-平均y)) / (√∑(x_i-平均x)^2 * ∑(y_i-平均y)^2)。

其中,x_i和y_i分别表示样本中的每个数据点的x值和y值,平均x和平均y分别表示x值和y值的平均值。

二、相关系数的计算方法

相关系数的计算方法主要有两种:一种是基于样本数据的方法,另一种是基于总体数据的方法。

基于样本数据的方法又分为两种:一种是简单平均法,另一种是加权平均法。

基于总体数据的方法也有两种:一种是基于总体均值和总体协方差的方法,另一种是基于总体方差和总体协方差的方法。

三、相关系数的应用场景

相关系数在回归分析中有很多应用场景,比如:判断两个变量之间是否存在线性关系;判断两个变量之间的线性关系的强度和方向;预测一个变量的值,给定另一个变量的值;评估一个回归模型的拟合优度等。

四、相关系数与回归系数的关系

相关系数和回归系数是两个不同的概念,但它们之间有一定的关系。

相关系数表示的是两个变量之间的线性关系的强度和方向,而回归系数表示的是当一个变量增加一个单位时,另一个变量的预期变化量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

回归方程的系数的相关系数矩阵

clc % 清屏

clear all; % 删除workplace变量

close all; % 关掉显示图形窗口

format long

pz=[1913650516260

1893752211060

193385812101101

16235621210537

18935461315558

1823656410142

2113856810138

1673460612540

17631741520040

154335617251250

16934501712038

166335213210115

154346414215105

247465015050

193364667031

202376212210120

176375446025

15732521123080 15633541522573 1383368211043];

mu=mean(pz); %求均值

sig=std(pz); %求标准差

rr=corrcoef(pz); %求相关系数矩阵

data=zscore(pz); %数据标准化

n=3; % n 是自变量的个数

m=3; % m 是因变量的个数

x0=pz(:,1:n);y0=pz(:,n+1:end);

e0=data(:,1:n);f0=data(:,n+1:end);

num=size(e0,1);%求样本点的个数

chg=eye(n); % w 到w* 变换矩阵的初始化

for i=1:n

%计算w,w* 和t 的得分向量,

matrix=e0'*f0*f0'*e0;

[vec,val]=eig(matrix); %求特征值和特征向量val=diag(val); %提出对角线元素

[val,ind]=sort(val,'descend');%降序排列

w(:,i)=vec(:,ind(1)); %提出最大特征值对应的特征向量

w_star(:,i)=chg*w(:,i); %计算w*的取值

t(:,i)=e0*w(:,i); %计算成分ti 的得分

alpha=e0'*t(:,i)/(t(:,i)'*t(:,i)); %计算alpha_i

chg=chg*(eye(n)-w(:,i)*alpha'); %计算w 到w*的变换矩阵

e=e0-t(:,i)*alpha'; %计算残差矩阵

e0=e;

%计算ss(i)的值

beta=[t(:,1:i),ones(num,1)]\f0; %求回归方程的系数

beta(end,:)=[]; %删除回归分析的常数项

cancha=f0-t(:,1:i)*beta; %求残差矩阵

ss(i)=sum(sum(cancha.^2)); %求误差平方和

%计算p(i)

for j=1:num

t1=t(:,1:i);f1=f0;

she_t=t1(j,:);she_f=f1(j,:); %把舍去的第j 个样本点保存起来t1(j,:)=[];f1(j,:)=[]; %删除第j 个观测值

beta1=[t1,ones(num-1,1)]\f1; %求回归分析的系数

beta1(end,:)=[]; %删除回归分析的常数项

cancha=she_f-she_t*beta1; %求残差向量

p_i(j)=sum(cancha.^2);

end

p(i)=sum(p_i);

if i>1

Q_h2(i)=1-p(i)/ss(i-1);

else

Q_h2(1)=1;

end

if Q_h2(i)<0.0975

fprintf('提出的成分个数r=%d',i);

r=i;

break

end

end

beta_z=[t(:,1:r),ones(num,1)]\f0; %求Y 关于t 的回归系数

beta_z(end,:)=[]; %删除常数项

xishu=w_star(:,1:r)*beta_z; %求Y 关于X 的回归系数,且是针对标准数据的回归系数,

%每一列是一个回归方程

mu_x=mu(1:n);mu_y=mu(n+1:end);

sig_x=sig(1:n);sig_y=sig(n+1:end);

for i=1:m

ch0(i)=mu_y(i)-mu_x./sig_x*sig_y(i)*xishu(:,i); %计算原始数据的回归方程的常数项

end

for i=1:m

xish(:,i)=xishu(:,i)./sig_x'*sig_y(i); %计算原始数据的回归方程的系数,每一列是一个回归方程

end

sol=[ch0;xish] %显示回归方程的系数,每一列是一个方程,每一列的第一个数是常项

w1=w(:,1)

w2=w(:,2)

wx1=w_star(:,1)

wx2=w_star(:,2)

tx1=t(:,1)'

tx2=t(:,2)'

beta_z %回归系数。