11G ASM

华为公司Oracle11g常见故障处理

Oracle 11g 数据库常见故障处理TSD配套产品服务部2009年6月27日目标通过本课程的学习,您将了解以下内容:Oracle 11g数据库常见故障及处理安装和配置类问题实例管理类问题数据管理类管理数据库恢复类问题管理工具类问题ORA-00600介绍和案例分析ORA-07445介绍和案例分析目录安装配置类实例管理类数据管理类数据恢复类管理工具类ORA-00600ORA-07445目标通过本章节的学习,您将了解以下内容:ORACLE 11g常见的安装类问题这些问题的分析和解决如何在客户端启动图形界面问题用客户端连接到Unix或者Linux平台上安装数据库软件时,常常无法启动图形界面,因此无法进行安装解决以root用户执行:xhost +客户端需要安装xmanager,并且通过Xbrowser登陆到主机以oracle用户执行:export DISPLAY=客户端IP:0.0xclock (测试能否显示图形界面)如果图形界面还出不来,可以尝试export DISPLAY=客户端IP:1.0如何在服务器端启动图形界面问题如果直接在服务器上安装数据库软件时,有时也会碰到不能启动图形界面的问题解决以root用户执行:xhost +以oracle用户执行:export DISPLAY=:0.0xclock (测试能否显示图形界面)安装CRS时,无法添加节点故障现象AIX或HPUX上安装CRS的过程中,有一步是添加节点,正常情况下,应该可以添加本地节点和远程节点,但添加远程节点时失败。

解决方法如果要安装的CRS需要依赖操作系统双机管理共享文件,那么安装CRS时,必须保证操作系统双机服务启动如果不需要操作系统双机软件,而只需要ASM管理共享存储,那么必须在操作系统上删除双机软件,对于HACMP,要保证没有安装rsct.basic.hacmp包,对于HPUX,要保证没有安装Serviceguard包AIX上安装CRS时提示bos.cifs_fs.rte检查不通过故障现象在AIX5L上安装CRS时,当安装程序自动检查操作系统补丁时,提示bos.cifs_fs_rte未安装解决办法安装所需AIX程序包smitty installp重启操作系统shutdown -FrCRS安装最后阶段在第二个节点运行root.sh报错故障现象安装CRS最后阶段,在第二个节点执行root.sh时,报错:The given interface(s), "eth2" is not public.Public interfaces should be used to configure virtual IPs解决办法以root身份手工在第二个节点执行vipcacd /<CRS安装目录>/bin./vipca安装RAC时报ORA-00603,ORA-29702故障现象在安装RAC时,出现下列错误:ORA-00603:ORACLE server session terminated by fatal error或ORA-29702:error occurred in Cluster Group Service operation原因分析RAC的节点名出现在了/etc/hosts文件中的回送地址中xxxx解决方法如果机器名出现在回送地址条目中,如下所示:127.0.0.1 rac1 localhost.localdomain localhost需要灾回送地址中删除掉机器名,如下:127.0.0.1 localhost.localdomain localhost无法连接数据库ORA-12521,ORA-12505故障现象连接数据库时报错:原因分析客户端tnsnames.ora配置的连接串中,关于instance_name的设置不正确,这个错误类似ORA-12505: TNS:listener could not resolve SID given in connectdescriptor解决方法检查数据库的instance_name:select instance_name from v$instance;修改客户端tnsnames.ora文件,设置正确的instance_name或SID无法连接数据库ORA-12541故障现象连接数据库时报错:ERROR:ORA-12541: TNS:no listener原因分析可能原因一:客户端tnsnames.ora配置的连接串中,监听端口号设置不正确可能原因二:数据库服务器监听没有启动解决方法检查客户端tnsnames.ora文件,设置正确的监听端口号检查服务器上的监听是否正常启动无法连接数据库ORA-12535故障现象连接数据库时报错:ERROR:ORA-12535: TNS:operation timed out原因分析可能原因:客户端tnsnames.ora中,服务器IP地址设置错误可能原因:防火墙阻断了连接解决方法正确配置tnsnames.ora中的服务器IP地址利用Tnsping connectstring,测试配置是否正确,如果不通,检查网络。

oracle11g_ASM_归档日志闪回区目录空间使用率100%的解决办法

XX项目故障解决库——VER 1.02012年6月文挡名称初稿审核建立日期作者文档修订记录章节编号章节名称修订内容简述修订日期修订前版本号目录1.总统架构 (4)2.故障解决库 (4)3.详细解决方法 (5)3.1.序号1 (5)3.1.1.解决方法 (5)1.总统架构架构图:2.故障解决库序号发生时间故障现象故障原因解决方法详见3.详细解决方法前期预防详见3.详细解决方法解决人联系方式1 2012年10月9日上午11时数据库系统宕机,应用系统停用。

自动备份脚本中,删除归档日志的命令没有添加noprompt参数,需要人工输入YES确认,不能自动执1、备份最近3天的归档日志。

2、删除最近2天归档日志。

3、正常关闭数据库。

4、正常开启数据库。

5、开启相关应用系统。

6、做数据库完全备份。

7、更改自动备份脚本,添监控归档目录空间使用百分比,一旦超过80%开始告警。

select file_type,percent_space_usedasused,percent_space_reclaimable asreclaimable,number_of_files as行,造成存放归档日志的闪回区目录空间使用率积累到100%,引起数据库系统宕机。

加noprompt参数。

测试自动备份脚本。

"number" fromv$flash_recovery_area_usage;3.详细解决方法3.1.序号13.1.1.解决方法1、备份最近3天的归档日志。

# cd /home/db/oracle_backup# mkdir 2012_10_07# mkdir 2012_10_08# mkdir 2012_10_09# su - grider$ asmcmdASMCMD> lsARCVG/DBVG/ASMCMD> cd ARCVGASMCMD> lsJXPAEA/ASMCMD> cd JXPAEAASMCMD> lsARCHIVELOG/CONTROLFILE/ONLINELOG/ASMCMD> cd ARCHIVELOGASMCMD> cd 2012_10_07ASMCMD> cp thread_1_seq_14696.9677.796359843 /home/db/oracle_backup/2012_10_07/ ……2、删除最近2天归档日志。

EXADATA维护系列之ASM管理与维护

EXADATA维护系列之ASM管理与维护1.ASM的概况ASM(Automatic Storage Management)是oracle 10g推出来的新功能,可以直接管理OS 层的磁盘,比如对盘进行条带和镜像,提供一个高可用的存储架构!使用ASM时,强烈建议打开OS层的ASYNC I/O,提高I/O的性能!比如,在EXADATA上,就完全采用ASM的技术对storage servers上的磁盘进行条带话和镜像处理,为上层的database servers提共高可用的shared存储空间ASM 实例与 ORACLE 实例差不多,都是由 sga 和一堆后台进程组成,从功能上来看,区别在于oracle实例管理的是数据库,而asm实例只是管理asm盘阵。

2. connect/startup/shutdown ASM 实例(11g环境)(1)连接asm instance并打开export ORACLE_SID=+ASM1$GRID_HOME/bin/sqlplus /nologconn / as sysasmstartup mount(2)关闭asm instanceshutdown immediate或者使用srvctl命令来管理asm instancesrvctl start asmsrvctl stop asm3.ASM instance里相关的init参数ASM_POWER_LIMIT :指定磁盘rebalance的程度,有0-11个级别,默认值为1,指定的级别越高,则rebalance的操作就会越快被完成(当然这也意味着这个时间段内将占用更多的资源),指定级别较低的话,虽然rebalance操作会耗时更久,但对当前系统的IO及负载影响会更少,这中间的度需要DBA根据实际情况衡量。

另外,这个参数指定的只是一个默认值,在操作过程中,即可以随便动态修改,也可以在语句级命令行时指定power,覆盖该默认值。

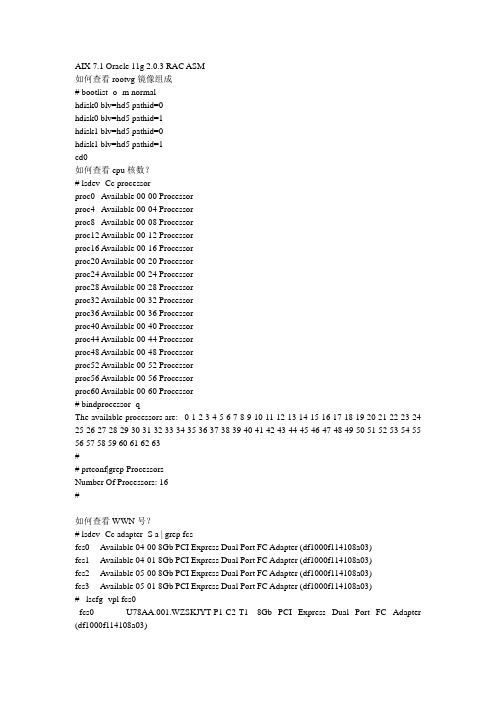

aix7 install oracle11g rac asm

AIX 7.1 Oracle 11g 2.0.3 RAC ASM如何查看rootvg镜像组成# bootlist -o -m normalhdisk0 blv=hd5 pathid=0hdisk0 blv=hd5 pathid=1hdisk1 blv=hd5 pathid=0hdisk1 blv=hd5 pathid=1cd0如何查看cpu核数?# lsdev -Cc processorproc0 Available 00-00 Processorproc4 Available 00-04 Processorproc8 Available 00-08 Processorproc12 Available 00-12 Processorproc16 Available 00-16 Processorproc20 Available 00-20 Processorproc24 Available 00-24 Processorproc28 Available 00-28 Processorproc32 Available 00-32 Processorproc36 Available 00-36 Processorproc40 Available 00-40 Processorproc44 Available 00-44 Processorproc48 Available 00-48 Processorproc52 Available 00-52 Processorproc56 Available 00-56 Processorproc60 Available 00-60 Processor# bindprocessor -qThe available processors are: 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63## prtconf|grep ProcessorsNumber Of Processors: 16#如何查看WWN号?# lsdev -Cc adapter -S a | grep fcsfcs0 Available 04-00 8Gb PCI Express Dual Port FC Adapter (df1000f114108a03)fcs1 Available 04-01 8Gb PCI Express Dual Port FC Adapter (df1000f114108a03)fcs2 Available 05-00 8Gb PCI Express Dual Port FC Adapter (df1000f114108a03)fcs3 Available 05-01 8Gb PCI Express Dual Port FC Adapter (df1000f114108a03)# lscfg -vpl fcs0fcs0 U78AA.001.WZSKJYT-P1-C2-T1 8Gb PCI Express Dual Port FC Adapter (df1000f114108a03)Part Number.................00E0806Serial Number...............1A4080061CManufacturer................001AEC Level.................... D77161Customer Card ID Number.....577DFRU Number..................00E0806Device Specific.(ZM) (3)Network Address.............10000090FA67C1CAROS Level and ID............027820B7Device Specific.(Z0) (31004549)Device Specific.(Z1) (00000000)Device Specific.(Z2) (00000000)Device Specific.(Z3) (09030909)Device Specific.(Z4)........FF781150Device Specific.(Z5)........027820B7Device Specific.(Z6)........077320B7Device Specific.(Z7)........0B7C20B7Device Specific.(Z8)........20000120FA67C1CADevice Specific.(Z9)2.02X7Device Specific.(ZA)........U2D2.02X7Device Specific.(ZB)........U3K2.02X7Device Specific.(ZC) (00000000)Hardware Location Code......U78AA.001.WZSKJYT-P1-C2-T1PLATFORM SPECIFICName: fibre-channelModel: 00E0806Node: fibre-channel@0Device Type: fcpPhysical Location: U78AA.001.WZSKJYT-P1-C2-T1# lscfg -vpl fcs1fcs1 U78AA.001.WZSKJYT-P1-C2-T2 8Gb PCI Express Dual Port FC Adapter (df1000f114108a03)Part Number.................00E0806Serial Number...............1A4080061CManufacturer................001AEC Level.................... D77161Customer Card ID Number.....577DFRU Number..................00E0806Device Specific.(ZM) (3)Network Address.............10000090FA67C1CBROS Level and ID............027820B7Device Specific.(Z0) (31004549)Device Specific.(Z1) (00000000)Device Specific.(Z2) (00000000)Device Specific.(Z3) (09030909)Device Specific.(Z4)........FF781150Device Specific.(Z5)........027820B7Device Specific.(Z6)........077320B7Device Specific.(Z7)........0B7C20B7Device Specific.(Z8)........20000120FA67C1CBDevice Specific.(Z9)2.02X7Device Specific.(ZA)........U2D2.02X7Device Specific.(ZB)........U3K2.02X7Device Specific.(ZC) (00000000)Hardware Location Code......U78AA.001.WZSKJYT-P1-C2-T2PLATFORM SPECIFICName: fibre-channelModel: 00E0806Node: fibre-channel@0,1Device Type: fcpPhysical Location: U78AA.001.WZSKJYT-P1-C2-T2#查看内存大小:# lsattr -El mem0ent_mem_cap I/O memory entitlement in Kbytes Falsegoodsize 63232 Amount of usable physical memory in Mbytes Falsemem_exp_factor Memory expansion factor Falsesize 63232 Total amount of physical memory in Mbytes Falsevar_mem_weight Variable memory capacity weight False#lsdev -Cc memoryselect GROUP_NUMBER,DISK_NUMBER,TOTAL_MB,FREE_MB,path from V$ASM_DISK; GROUP_NUMBER DISK_NUMBER TOTAL_MB FREE_MB PATH------------ ----------- ---------- --------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------1 0 112640 108634 /dev/rhdiskpower11 1 153600 148149 /dev/rhdiskpower101 2 163840 158019 /dev/rhdiskpower111 3 174080 167900 /dev/rhdiskpower121 4 184320 177772 /dev/rhdiskpower131 5 194560 187652 /dev/rhdiskpower141 6 204800 197531 /dev/rhdiskpower151 7 225280 217274 /dev/rhdiskpower161 8 235520 227154 /dev/rhdiskpower171 9 143360 138261 /dev/rhdiskpower21 10 215040 207395 /dev/rhdiskpower32 0 5120 4724 /dev/rhdiskpower51 11 102400 98761 /dev/rhdiskpower71 12 122880 118515 /dev/rhdiskpower81 13 133120 128382 /dev/rhdiskpower9选定了17 行powermt display dev=all# powermt display dev=all# powermt display dev=allPseudo name=hdiskpower0VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF038007138E28678FEE311 [CRS2]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk4 SP A1 active alive 0 01 fscsi2 hdisk28 SP B1 active alive 0 0Pseudo name=hdiskpower1VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF03800EA9BE11779FEE311 [DATA2]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk5 SP A1 active alive 0 01 fscsi2 hdisk29 SP B1 active alive 0 0Pseudo name=hdiskpower2VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF0380008A51F3079FEE311 [DATA5]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk6 SP A1 active alive 0 01 fscsi2 hdisk30 SP B1 active alive 0 0Pseudo name=hdiskpower3VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF0380080A25E6779FEE311 [DATA12]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk7 SP A1 active alive 0 01 fscsi2 hdisk31 SP B1 active alive 0 0Pseudo name=hdiskpower4VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF03800FA516CC278FEE311 [ARCH2]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk8 SP A1 active alive 0 01 fscsi2 hdisk32 SP B1 active alive 0 0Pseudo name=hdiskpower5VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF038007038E28678FEE311 [CRS1]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk9 SP A1 active alive 0 01 fscsi2 hdisk33 SP B1 active alive 0 0Pseudo name=hdiskpower6VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF038007238E28678FEE311 [CRS3]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4==============================================================================--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk10 SP A1 active alive 0 01 fscsi2 hdisk34 SP B1 active alive 0 0Pseudo name=hdiskpower7VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF038004A0E320E79FEE311 [DATA1]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk11 SP A1 active alive 0 01 fscsi2 hdisk35 SP B1 active alive 0 0Pseudo name=hdiskpower8VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF03800A64A6E2079FEE311 [DATA3]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk12 SP A1 active alive 0 01 fscsi2 hdisk36 SP B1 active alive 0 0Pseudo name=hdiskpower9VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF03800F601412879FEE311 [DA TA4]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk13 SP A1 active alive 0 01 fscsi2 hdisk37 SP B1 active alive 0 0Pseudo name=hdiskpower10VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF038004C99743979FEE311 [DA TA6]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk14 SP A1 active alive 0 01 fscsi2 hdisk38 SP B1 active alive 0 0Pseudo name=hdiskpower11VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF03800228CE84279FEE311 [DATA7]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk15 SP A1 active alive 0 01 fscsi2 hdisk39 SP B1 active alive 0 0Pseudo name=hdiskpower12VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF0380024FE984B79FEE311 [DATA8]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors==============================================================================0 fscsi0 hdisk16 SP A1 active alive 0 01 fscsi2 hdisk40 SP B1 active alive 0 0Pseudo name=hdiskpower13VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF038001A53695379FEE311 [DATA9]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk17 SP A1 active alive 0 01 fscsi2 hdisk41 SP B1 active alive 0 0Pseudo name=hdiskpower14VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF038003C27765A79FEE311 [DATA10]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk18 SP A1 active alive 0 01 fscsi2 hdisk42 SP B1 active alive 0 0Pseudo name=hdiskpower15VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF03800F203C96079FEE311 [DATA11]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk19 SP A1 active alive 0 01 fscsi2 hdisk43 SP B1 active alive 0 0Pseudo name=hdiskpower16VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF0380010784C6E79FEE311 [DATA13]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk20 SP A1 active alive 0 01 fscsi2 hdisk44 SP B1 active alive 0 0Pseudo name=hdiskpower17VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=600601607BF038006A15A77679FEE311 [DATA14]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk21 SP A1 active alive 0 01 fscsi2 hdisk45 SP B1 active alive 0 0Pseudo name=hdiskpower19VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=6006016090B03800484C45D6C5FEE311 [ARCH1]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk3 SP A1 active alive 0 01 fscsi2 hdisk27 SP B1 active alive 0 0Pseudo name=hdiskpower20VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=6006016090B0380076D3B562F300E411 [Backup1]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk46 SP A1 active alive 0 01 fscsi2 hdisk48 SP B1 active alive 0 0Pseudo name=hdiskpower21VNX ID=FCN00141200036 [IBM POWER740]Logical device ID=6006016090B038002EC8566FF300E411 [Backup2]state=alive; policy=CLAROpt; queued-IOs=0Owner: default=SP A, current=SP A Array failover mode: 4====================================================================== ========--------------- Host --------------- - Stor - -- I/O Path -- -- Stats ---### HW Path I/O Paths Interf. Mode State Q-IOs Errors====================================================================== ========0 fscsi0 hdisk47 SP A1 active alive 0 01 fscsi2 hdisk49 SP B1 active alive 0 0#crs1 hdiskpower5crs2 hdiskpower0crs3 hdiskpower6data1 hdiskpower7data2 hdiskpower1data3 hdiskpower8data4 hdiskpower9data5 hdiskpower2data6 hdiskpower10data7 hdiskpower11data8 hdiskpower12data9 hdiskpower13data10 hdiskpower14data11 hdiskpower15data12 hdiskpower3data13 hdiskpower16data14 hdiskpower17arch1 hdiskpower19arch2 hdiskpower4backup1 hdiskpower20backup2 hdiskpower21lsattr -E -l hdiskpower0rmdev -dl hdiskpower19chdev -l hdiskpower0 -a pv=yes chdev -l hdiskpower1 -a pv=yes chdev -l hdiskpower2 -a pv=yes chdev -l hdiskpower3 -a pv=yes chdev -l hdiskpower4 -a pv=yes chdev -l hdiskpower5 -a pv=yes chdev -l hdiskpower6 -a pv=yes chdev -l hdiskpower7 -a pv=yes chdev -l hdiskpower8 -a pv=yes chdev -l hdiskpower9 -a pv=yes chdev -l hdiskpower10 -a pv=yes chdev -l hdiskpower11 -a pv=yes chdev -l hdiskpower12 -a pv=yes chdev -l hdiskpower13 -a pv=yes chdev -l hdiskpower14 -a pv=yes chdev -l hdiskpower15 -a pv=yes chdev -l hdiskpower16 -a pv=yes chdev -l hdiskpower17 -a pv=yes chdev -l hdiskpower19 -a pv=yes chdev -l hdiskpower20 -a pv=yes chdev -l hdiskpower21 -a pv=yeschdev -l hdiskpower19 -a pv=yeschdev -l hdiskpower19 -a pv=clearchdev -l hdiskpower0 -a reserve_policy=no_reserve chdev -l hdiskpower1 -a reserve_policy=no_reserve chdev -l hdiskpower2 -a reserve_policy=no_reserve chdev -l hdiskpower3 -a reserve_policy=no_reserve chdev -l hdiskpower4 -a reserve_policy=no_reserve chdev -l hdiskpower5 -a reserve_policy=no_reserve chdev -l hdiskpower6 -a reserve_policy=no_reserve chdev -l hdiskpower7 -a reserve_policy=no_reserve chdev -l hdiskpower8 -a reserve_policy=no_reserve chdev -l hdiskpower9 -a reserve_policy=no_reserve chdev -l hdiskpower10 -a reserve_policy=no_reserve chdev -l hdiskpower11 -a reserve_policy=no_reserve chdev -l hdiskpower12 -a reserve_policy=no_reserve chdev -l hdiskpower13 -a reserve_policy=no_reserve chdev -l hdiskpower14 -a reserve_policy=no_reserve chdev -l hdiskpower15 -a reserve_policy=no_reserve chdev -l hdiskpower16 -a reserve_policy=no_reserve chdev -l hdiskpower17 -a reserve_policy=no_reserve chdev -l hdiskpower19 -a reserve_policy=no_reserve chdev -l hdiskpower20 -a reserve_policy=no_reserve chdev -l hdiskpower21 -a reserve_policy=no_reservechown grid:asmadmin /dev/rhdiskpower0chown grid:asmadmin /dev/rhdiskpower1chown grid:asmadmin /dev/rhdiskpower2chown grid:asmadmin /dev/rhdiskpower3chown grid:asmadmin /dev/rhdiskpower5chown grid:asmadmin /dev/rhdiskpower6chown grid:asmadmin /dev/rhdiskpower7chown grid:asmadmin /dev/rhdiskpower8chown grid:asmadmin /dev/rhdiskpower9chown grid:asmadmin /dev/rhdiskpower10chown grid:asmadmin /dev/rhdiskpower11chown grid:asmadmin /dev/rhdiskpower12chown grid:asmadmin /dev/rhdiskpower13chown grid:asmadmin /dev/rhdiskpower14chown grid:asmadmin /dev/rhdiskpower15chown grid:asmadmin /dev/rhdiskpower16chown grid:asmadmin /dev/rhdiskpower17chmod 660 /dev/rhdiskpower0chmod 660 /dev/rhdiskpower2chmod 660 /dev/rhdiskpower3chmod 660 /dev/rhdiskpower5chmod 660 /dev/rhdiskpower6chmod 660 /dev/rhdiskpower7chmod 660 /dev/rhdiskpower8chmod 660 /dev/rhdiskpower9chmod 660 /dev/rhdiskpower10chmod 660 /dev/rhdiskpower11chmod 660 /dev/rhdiskpower12chmod 660 /dev/rhdiskpower13chmod 660 /dev/rhdiskpower14chmod 660 /dev/rhdiskpower15chmod 660 /dev/rhdiskpower16chmod 660 /dev/rhdiskpower17chdev -l hdiskpower5 -a reserve_policy=no_reserve/usr/sbin/lsattr -E -l hdiskpower5# /usr/sbin/lsattr -E -l hdiskpower5PR_key_value none Reserve Key. Trueclr_q no Clear Queue (RS/6000) Truelocation Location Truelun_id 0x6000000000000 LUN ID Falselun_reset_spt yes FC Forced Open LUN Truemax_coalesce 0x100000 Maximum coalesce size Truemax_retries 5 Maximum Retries Truemax_transfer 0x100000 Maximum transfer size Truepvid 00f933f9c497fa560000000000000000 Physical volume identifier False pvid_takeover yes Takeover PVIDs from hdisks Trueq_err yes Use QERR bit Trueq_type simple Queue TYPE Falsequeue_depth 32 Queue DEPTH Truereassign_to 120 REASSIGN time out value Truereserve_policy no_reserve Reserve Policy used to reserve device on open. True reset_delay 2 Reset Delay Truerw_timeout 30 READ/WRITE time out Truescsi_id 0x10600 SCSI ID Falsestart_timeout 60 START unit time out Trueww_name 0x500601693ee0648b World Wide Name False reserve_policy no_reservelsattr -E -l /dev/rhdisk3查看:lsattr -E -l rhdiskpower0|grep reservelsattr -El sys0 -a realmem# lsattr -El sys0 -a realmemrealmem 64749568 Amount of usable physical memory in Kbytes False# lsps -aPage Space Physical V olume V olume Group Size %Used Active Auto Type Chksumhd6 hdisk0 rootvg 65536MB 0 yes yes lv 0### lsvg rootvgVOLUME GROUP: rootvg VG IDENTIFIER: 00f933f900004c0000000146e2225531VG STA TE: active PP SIZE: 512 megabyte(s)VG PERMISSION: read/write TOTAL PPs: 1116 (571392 megabytes)MAX LVs: 256 FREE PPs: 808 (413696 megabytes)LVs: 13 USED PPs: 308 (157696 megabytes)OPEN LVs: 12 QUORUM: 1 (Disabled)TOTAL PVs: 2 VG DESCRIPTORS: 3STALE PVs: 0 STALE PPs: 0ACTIVE PVs: 2 AUTO ON: yesMAX PPs per VG: 32512MAX PPs per PV: 1016 MAX PVs: 32LTG size (Dynamic): 1024 kilobyte(s) AUTO SYNC: noHOT SPARE: no BB POLICY: relocatablePV RESTRICTION: none INFINITE RETRY: noDISK BLOCK SIZE: 512# lsvg -l rootvgrootvg:LV NAME TYPE LPs PPs PVs LV STA TE MOUNT POINThd5 boot 1 2 2 closed/syncd N/Ahd6 paging 128 256 2 open/syncd N/Ahd8 jfs2log 1 2 2 open/syncd N/Ahd4 jfs2 2 4 2 open/syncd /hd2 jfs2 6 12 2 open/syncd /usrhd9var jfs2 1 2 2 open/syncd /varhd3 jfs2 4 8 2 open/syncd /tmphd1 jfs2 1 2 2 open/syncd /homehd10opt jfs2 1 2 2 open/syncd /opthd11admin jfs2 1 2 2 open/syncd /adminfwdump jfs2 3 6 2 open/syncd /var/adm/ras/platform lg_dumplv sysdump 8 8 1 open/syncd N/Alivedump jfs2 1 2 2 open/syncd /var/adm/ras/livedump #chps -s 32 hdisk0chfs -a size=30G /tmpchfs -a size=10G /homechfs -a size=5G /chfs -a size=+10G /u01mklv -t jfs2 -y u01lv rootvg 200crfs -v jfs2 -d /dev/u01lv -m /u01mount /u01lsattr -El /dev/hdiskpower0lsattr -El /dev/rhdiskpower0ioo -o aio_maxreqsvmo -p -o minperm%=3vmo -p -o maxperm%=90vmo -p -o maxclient%=90vmo -p -o lru_file_repage=0vmo -p -o strict_maxclient=1vmo -p -o strict_maxperm=0lru_file_repagevmo -p -o lru_file_repage=0vi + /etc/security/limitsfsize = -1core = 2097151cpu = -1data = -1rss = -1stack = -1nofiles = -1no -r -o ipqmaxlen=521no -p -o rfc1323=1no -p -o sb_max=1500000no -p -o tcp_recvspace=65536no -p -o tcp_sendspace=65536no -p -o udp_recvspace=1351680no -p -o udp_sendspace=13516/usr/sbin/no -r -o ipqmaxlen=512/usr/sbin/no -po rfc1323=1/usr/sbin/no -po sb_max=131072/usr/sbin/no -po tcp_recvspace=65536/usr/sbin/no -po tcp_sendspace=65536/usr/sbin/no -po udp_recvspace=65530/usr/sbin/no -po udp_sendspace=65536#public ip192.168.100.103 sqwsjdb01192.168.100.104 sqwsjdb02#Private ip10.10.10.1 sqwsjdb01-priv10.10.10.2 sqwsjdb02-priv#Virtual ip192.168.100.101 sqwsjdb01-vip192.168.100.102 sqwsjdb02-vip#Scan ip192.168.100.100 rac-scanlsdev -Cc adapter查看ssh服务状态# lssrc -s sshdSubsystem Group PID Status sshd ssh 3866742 active停止和启动ssh 服务# stopsrc -s sshd# startsrc -s sshd建议通过console连接,不然停止ssh后网络连接就断开连不上了。

Oracle-11g日常维护手册

Oracle 11g 日常维护手册目录第1章文档说明 (5)第2章CRS的管理 (5)2.1 RAC状态检查 (5)检查守护进程状态 (5)检查资源状态 (5)2.2 手工启动与关闭RAC (6)2.3 OCR的管理 (6)2.4 VOTING DISK的管理 (8)2.5 CSS管理 (9)2.6 管理工具SRVCTL (9)管理实例 (9)管理监听程序 (9)管理ASM (10)管理service (10)2.7 修改RAC的IP及VIP (11)修改外网IP及心跳IP (11)修改VIP (11)查看与删除IP (12)第3章ASM的管理 (13)3.1 管理DG (13)建立与扩充disk group (13)mount与unmount的吩咐 (14)删除disk group (14)增加DISK的total_mb (14)DG的属性-AU大小 (14)DG的属性-离线删除时间 (15)DG的属性-兼容版本 (15)向ASM中添加disk的完整步骤 (16)3.2 ASMCMD (17)ASMCMD常用吩咐 (17)复制ASM文件 (18)吩咐lsdg (18)元数据备份与复原 (18)3.3 ASM磁盘头信息备份与复原 (19)3.4 ASM常用视图 (20)视图V$ASM_DISKGROUP (20)视图V$ASM_DISK (21)3.5 常用方法 (22)如何确定ASM实例的编号 (22)查询DG-RAW-磁盘的对应关系 (22)第4章数据库管理 (24)4.1 参数文件管理 (24)4.2 表空间管理 (25)表空间自动扩张 (25)表空间更名 (26)表空间的数据文件更名 (26)缺省表空间 (26)表空间删除 (27)UNDO表空间 (27)TEMP表空间 (27)4.3 重做日志文件管理 (27)增加REDO日志组 (27)删除日志组 (28)日志切换 (28)日志清理 (28)重做日志切换次数查询 (28)4.4 归档模式 (29)单实例数据库修改为归档模式的方法 (29)RAC数据库修改为归档模式的方法 (29)归档路径 (30)4.5 重建限制文件 (31)4.6 内存参数管理 (32)Oracle内存管理发展阶段 (32)自动内存管理AMM (32)自动共享内存管理ASMM (33)自动PGA管理 (33)4.7 其他管理内容 (33)数据库版本查看 (33)字符集 (34)创建密码文件 (34)关闭审计功能 (34)帐号管理 (34)profile管理 (35)第1章文档说明本文档描述了Oracle11g中常见的维护和管理方法,包括CRS、ASM、数据库等。

整理分析-ASM

1)启动和关闭ASM实例

2)安装或者卸载磁盘组

3)将磁盘组的状态改为ONLINE或者OFFLINE

4)调整磁盘组负载平衡

5)对磁盘组进行完整性检查。

6)访问V$ASM_*动态性能视图

asm实例重要的参数

3 failgroup fdisk2 disk '//./orcldiskdisk14' name disk14

4 failgroup fdisk3 disk '//./orcldiskdisk15' name disk15;

磁盘组已创建。

2. 删除磁盘组

首先确认数据库是否使用磁盘组

如何配置asm磁盘组

asm磁盘组是多个可管理的磁盘设备的逻辑集合,组成足够大的磁盘组,当磁盘组采用数据数据冗余时,可以实现数据的镜像和数据的分散存储,创建磁盘组时要考虑众多因素,如磁盘的块数,控制器及冗余级别,数据库的性能和可恢复性

1. asm的磁盘组中的磁盘大小及型号要相同,如果是不同型号,可以创建不同的磁盘组

instance_type

db_unique_name

asm_power_limit

asm_diskstring

asm_diskgroups

ASM有一些专用的初始化参数,而有些则是针对ASM实例而扩展了新的值。

1)INSTANCE_TYPE

对于ASM实例而言,这个参数值是ASM。对于传统的Oracle实例,值是RDBMS

SQL> select * from v$asm_client;

oracle 11g数据库ASM磁盘组存储空间扩容实施

oracle 11g数据库ASM磁盘组存储空间扩容实施任务概述XX系统存放oracle数据文件的DATA磁盘组空间因为开发方新上线业务,造成原有数据库表空间较为紧张,应业务开发方要求,为了适应未来的数据增长要求,需要扩容。

此方案为数据库扩容常规标准步骤,无需专门测试,但是,在数据库存储扩容前,为防止变更操作带来的风险,需要对数据库数据作备份,以防万一出现问题时做回退恢复。

在实施存储扩容变更操作时,由于是底层磁盘阵列和操作系统的标准化操作,为了防止操作失误,必须一人操作,另一人在旁监督检查,并且分步确认,步步把关,确保万无一失。

1.1. 实施任务DATA磁盘组扩容:在DS5300存储RAID10组中划分新的2个300G的LUN并添加到DATA 磁盘组给XX集群数据库使用,RAID10组剩余的空间可以留给以后扩容或其他用途使用。

1.2. 环境简介系统名称:XX系统;主机:两台IBM P750小型机;操作系统:AIX 6.1;存储:1套IBM DS5300;数据库:ORACLE RAC 11.2.0.3.0;1.3. 实施时间2014年11月。

1.4. 实施人员略2. 实施方案2.1. 实施内容原有数据库需要作数据作RMAN备份;连接到存储DS5300划分LUN,并加载到主机;主机扫描识别,修改属性及权限;ASM存储DATA磁盘组增加disk扩容;检查数据库和应用。

2.2. 实施步骤2.3. 实施风险控制在数据库存储扩容前,为防止变更操作风险,需要对数据库数据作备份,以防万一。

在实施存储扩容变更操作时,由于是底层磁盘阵列和操作系统的标准化操作,为了防止操作失误,必须一人操作,另一人在旁监督检查,并且分步确认,步步把关,确保万无一失。

3. 详细实施步骤3.1. RMAN备份在数据库服务器节点2上通过RMAN对数据库做全备份,历时约60分钟。

具体步骤如下:以root用户创建备份用的目录,并更改所有者等;#mkdir -p /backup/20131122#chown -R oracle:dba /backup/以oracle用户创建rman备份用的脚本,并赋权限:#su - oracle$cd /backup/20131122$vi rmanbackup.sh$chmod 744 rmanbackup.shRMAN全备份脚本rmanbackup.sh内容:run{allocate channel ch1 device type disk;allocate channel ch2 device type disk;allocate channel ch3 device type disk;backup as compressed backupset full database format'/backup/20131122/db_%U_%d' tag="full" spfile include current controlfile;sql 'alter system archive log current';change archivelog all crosscheck;backup as compressed backupset archivelog all format'/backup/20131122/arch_%t_%s' tag="archivelog";release channel ch1;release channel ch2;release channel ch3;}使用脚本做RMAN备份,通过参数cmdfile指定命令文件,使用log指定日志文件:nohup rman target / cmdfile=/backup/20131122/rmanbackup.shlog=/backup/20131122/rmanbackup.log &3.2. 连接到存储将本机设置为192.168.128.XX(不要跟存储控制器的管理ip有冲突),通过集线器,连接到IBM DS5300存储的两个控制器的管理口,SPA(192.168.128.101)和SPB(192.168.128.102),在本机ping两个管理口地址,是否能ping通。

探索ORACLE之ASM概念(完整版)

探索ORACLE之ASM概念(完整版)⼀、 ASM(⾃动存储管理)的来由:ASM是Oracle 10g R2中为了简化Oracle数据库的管理⽽推出来的⼀项新功能,这是Oracle⾃⼰提供的卷管理器,主要⽤于替代操作系统所提供的LVM,它不仅⽀持单实例,同时对RAC的⽀持也是⾮常好。

ASM可以⾃动管理磁盘组并提供有效的数据冗余功能。

使⽤ASM(⾃动存储管理)后,数据库管理员不再需要对ORACLE中成千上万的数据⽂件进⾏管理和分类,从⽽简化了DBA的⼯作量,可以使得⼯作效率⼤⼤提⾼。

⼆、什么是ASMASM它提供了以平台⽆关的⽂件系统、逻辑卷管理以及软RAID服务。

ASM可以⽀持条带化和磁盘镜像,从⽽实现了在数据库被加载的情况下添加或移除磁盘以及⾃动平衡I/O以删除“热点”。

它还⽀持直接和异步的I/O并使⽤Oracle9i中引⼊的Oracle数据管理器API(简化的I/O系统调⽤接⼝)。

ASM是做为单独的Oracle实例实施和部署,并且它只需要有参数⽂件,不需要其它的任何物理⽂件,就可以启动ASM实例,只有它在运⾏的时候,才能被其它数据访问。

在Linux平台上,只有运⾏了OCSSD服务(Oracle安装程序默认安装)了才能和访问ASM。

三、使⽤ASM的好处:1、将I/O平均分部到所有可⽤磁盘驱动器上以防⽌产⽣热点,并且最⼤化性能。

2、配置更简单,并且最⼤化推动数据库合并的存储资源利⽤。

3、内在的⽀持⼤⽂件4、在增量增加或删除存储容量后执⾏⾃动联系重分配5、维护数据的冗余副本以提⾼可⽤性。

6、⽀持10g,11g的数据存储及RAC的共享存储管理7、⽀持第三⽅的多路径软件8、使⽤OMF⽅式来管理⽂件四、 ASM冗余:ASM使⽤独特的镜像算法:不镜像磁盘,⽽是镜像盘区。

作为结果,为了在产⽣故障时提供连续的保护,只需要磁盘组中的空间容量,⽽不需要预备⼀个热备(hot spare)磁盘。

不建议⽤户创建不同尺⼨的故障组,因为这将会导致在分配辅助盘区时产⽣问题。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

ORACLE ASM(11.2)概念和管理目录一、11G asm新特性 (3)11.1的新特性 (3)11.2的新特性 (4)二、使用ASM存储前的考虑 (5)三、管理ASM 实例 (6)ASM实例介绍 (6)ASM实例参数管理 (6)ASM实例启动和关闭 (7)四、管理ASM 磁盘组 (8)ASM磁盘组的属性 (8)ASM镜像和失败组 (9)创建磁盘组 (10)ALTER 磁盘组 (12)Oracle ASM Disk Discovery (14)管理ASM容量 (15)磁盘组性能 (16)ASM文件访问控制 (16)磁盘组mount and dismount (17)磁盘组一致性检查 (17)drop 磁盘组 (18)一、11G asm新特性11.1的新特性Oracle ASM Fast Mirror Resync当一个磁盘从transient failure中恢复后,oracle会重新同步磁盘组中的数据,同步的时间一般比重建磁盘组要快的多;任何导致磁盘暂时性不可用的问题都被称为transient failure,例如:磁盘路径不可访问、电路故障、主机BUS适配器或控制器故障、磁盘供电故障。

Oracle ASM Rolling Upgrad e滚动升级只支持11g以后的cluster ASM,不支持10g到11g的升级。

New SYSASM Privil ege and OSASM os group for Oracle ASM Administration新增ASM的管理员权限SYSASM和操作系统组OSASM,使ASM的管理可以与DB分开可以在ASM实例中创建用户,并授予SYSASM权限。

Oracle ASM Scalability and Performance EnhancementsASM优化了ASM文件的extent空间分配方式,即当文件达到固定大小时,extent的大小会变大,对于超过20G的文件,性能有较明显提高。

另外在创建磁盘组时,可以指定AU的大小,分别是1、2、4、8、16、32、64M。

ASMCMD新增4条命令ASMCMD新增4个命令:lsdsk、md_backup、md_restore、remapLsdsk:列出磁盘信息Md_backup:将磁盘组的metadata备份到某个文件中。

md_restore:restore磁盘组metadata备份。

remap:标记一些blocks为unusable,并迁移那些blocks。

管理磁盘组的SQL语句增强在语法上增强了管理磁盘组的语句,例如:检查磁盘组、磁盘、文件的一致性;Offline磁盘组,修复后再online;New Attributes for Disk Group CompatibilityOracle ASM Preferred Read Failure Groups配置一个磁盘组为Preferred Read Failure Group,可以让新增的节点从这个磁盘组同步数据。

Restricted Mode and Oracle ASM Fast Rebalance设置一个ASM实例以Restricted模式启动或者设置一个磁盘组为Restricted Mode,会阻止数据库实例对该ASM实例或磁盘组的访问。

并且在进行rebalance时,会排除掉与其他ASM 实例的有关extent lock和unlock的消息传送,增大吞吐量,加快rebalance速度。

11.2的新特性Oracle Automatic Storage Management Cluster Fil e System (Oracl e ACFS)ORACLE ACFS是ASM技术的扩展,支持存储非数据库文件。

ACFS还支持快照功能,最多可以保留63个快照。

Oracle ASM Dynamic Volume ManagerOracle提供的一种卷管理器,使用ADVM创建虚拟磁盘,这些虚拟磁盘包含的文件系统可以支持非数据库文件,例如trace文件、alert文件、其他应用程序的文件等。

ADVM不支持NFS。

ASMCMD Enhancements11.2的ASMCMD支持所有sql语句的功能。

Intelligent Data Placement允许你干预ASM中得数据分布,比如将访问比较多的数据放在速度更快的磁盘上。

Disk Group Rename可以rename一个克隆的磁盘组,不过需要dismount这个磁盘组。

最简单的语法:renamedg dgname=oldname newdgname=newnameOracle Cluster Registry (OCR) and Voting Fil es stored in Oracle ASM11.2开始,OCR和voting file可以放在ASM磁盘组中。

Oracle RestartOracle restart可以通过安装在一个单实例服务器上得CRS启动或自动重启这个单实例数据库。

ASMCA单独的ASMCA图形界面,可以支持创建和配置ASM实例、磁盘组、卷、文件系统。

二、使用ASM存储前的考虑Storage Resources for Disk Groups可以使用以下几种存储创建ASM磁盘组:磁盘和磁盘分区、LUN、Lv、Nfs一般在创建ASM实例前需要注意两点:1、存储设备的路径,例如/dev/…2、存储设备的权限,一般是grid:asmadminOracle ASM and Multipathing1、配置正确的 ASM_DISKSTRING,保证ASM根据ASM_DISKSTRING只能找到多路径盘(pseudo-device name),而不能找到同一块盘的多个设备名。

Recommendations for Storage Preparation1、在准备磁盘组时,应该考虑分别为ocr and voting files、data files、recover files创建各自的磁盘组。

2、建议为每个磁盘组准备至少4个相同大小的LUN3、建议为每个磁盘组配置的磁盘有相同的性能4、确保每个磁盘组中得磁盘有相同的容量5、如果使用了磁盘RAID阵列,建议配置磁盘组时选择external冗余级别。

6、建议为ASM选择专用的磁盘,减少与其他应用程序的IO竞争。

7、oracle建议在linux使用ASMLIB管理ASM磁盘。

三、管理ASM 实例ASM实例介绍ASM实例结构与数据库实例相似,包括内存结构SGA和后台进程,只不过sga比数据库要小,且对服务器的性能影响也较小。

一个ASM实例可以用于同一节点上得多个数据库实例。

ASM实例主要管理以下信息:磁盘信息;磁盘组容量;数据文件名称;数据文件extents在磁盘组中得位置;记录源数据块改变的redo log信息;ADVM卷信息。

ASM实例参数管理参数文件的位置11.2的grid使用gpnp profile记录spfile的位置Gpnp profile:<grid的$ORACLE_HOME>/gpnp/<hostname>/profiles/peer/profile.xml可以使用asmcmd命令spget获取Gpnp profile中记录的spfile的位置,如:ASMCMD> spget+OCRVOTE/s1-11g-cluster/asmparameterfile/registry.253.815070625可以使用asmcmd命令spset设置Gpnp profile中记录的spfile的位置。

参数文件的一般位置:磁盘组、grid的$ORACLE_HOME/dbs建议将SPFILE放在磁盘组中。

参数文件的创建、备份、复制、移动登陆ASM实例,使用create spfile语句创建ASM的spfile。

使用asmcmd命令spcopy对参数文件进行copy。

使用asmcmd命令spmove对参数文件进行移动,并自动更新gpnp profle,不能移动正在被ASM实例使用的spfile。

使用asmcmd的命令spbackup对参数文件进行备份,备份出的文件不是spfile,不能使用spcopy对备份文件进行复制。

Spcopy、spmove、spbackup生成的文件如果不是放在共享磁盘上,那么只在本地磁盘生成。

ASM实例启动和关闭ASM实例启动设置ASM的ORACLE_SID;以SYSASM权限连接;ASM的参数文件必须包含INSTANCE_TYPE=ASM;Startup命令就是mount磁盘组;Startup force 会abort ASM实例然后重启ASM;Startup RESTRICT 启动限制访问模式,不允许其他实例mount该ASM下的磁盘组;ASM实例启动时mount的磁盘组ASM_DISKGROUPS定义下得磁盘组;CSS使用的存储voting file的磁盘组;CRS使用的存储OCR的磁盘组;ASM实例使用的存储ASM SPFILE的磁盘组;ASM实例关闭注意配置正确的ORACLE_HOME,ORACLE_SID;以SYSASM权限连接;需要先关闭数据库;Rac环境下OCR位于磁盘组时,需要先关闭本节点的CRS,如果想正常关闭一个节点的ASM,可以使用crs_stop -c <nodename> 停止这个节点的所有资源,包括ASM。

四、管理ASM 磁盘组ASM磁盘组的属性ASM磁盘组是有属性的,有些属性是不能修改的,有些属性是可以修改的。

以下语句查询出DATA磁盘组的非template属性:SQL> SELECT AS diskgroup, SUBSTR(,1,18) AS name,2 SUBSTR(a.value,1,24) AS value, read_only FROM V$ASM_DISKGROUP dg,3 V$ASM_ATTRIBUTE a WHERE = 'DATA' and not like 'template%'4 AND dg.group_number = a.group_number;compatible.rdbms:对oracle数据库的兼容性,可修改,不过需要compatible.asm大于11.1 compatible.asm:对ASM的兼容性,可以修改sector_size:扇区大小,不可修改au_size:allocation unit大小,不可修改disk_repair_time:允许的transient failure时间,在该时间内不会自动drop磁盘,可以修改access_control.enabled:是否打开访问控制,可以修改access_control.umask:打开访问控制后用来控制文件的读写权限,可以修改alter diskgroup XUE1 set ATTRIBUTE 'compatible.asm'= '11.2';alter diskgroup XUE1 set ATTRIBUTE 'disk_repair_time'= '5';ASM镜像和失败组Asm 镜像1、ASM的镜像功能分为三个冗余级别:EXTERNAL、NORMAL、HIGHEXTERNAL级别就是零冗余,即文件的extent没有任何copy。