vmware VSAN配置手册

VMware虚拟SAN(vSAN)技术白皮书说明书

Ready NodesVMWare Virtual SANVMware's Virtual SAN (vSAN) brings performance, low cost and scalability to virtual cloud deployments running on HPE hardware. An issue the cloud deployment model raises is the problem of adequate storage performance to virtual instances. Spinning disks and limited bandwidth networks lower IO rates over local drives. VMware’s solution to this is vSAN, which adds a temporary local storage “instance” in the form of a solid-state drive to each server. vSAN extends the concept of local instance storage to a shareable storage unit in each HPE server, where additionally, the data can be accessed by other servers over a LAN. The benefits of VSAN include:• Increased performance due to local server access to Flash storage• Lower infrastructure cost by removing the need for networked storage appliances • Highly scalable --simply add more servers to increase storage • Eliminate boot storms since data is stored locally• Unified management --no storage silo versus server silo separation problemsMellanox 10/25G Ethernet interconnect solutions enable unmatched competitive advantages in VMware environments by increase efficiency of overall server utilization and eliminating I/O bottleneck to enable more virtual machines per server, faster migrations and speed access to storage. Explore this reference guide to learn more about how Mellanox key technologies can help improve efficiencies in your vSAN environment. Higher Efficiency RoCE CertifiedWithout Offloads With Mellanox Offloads Efficient Hardware OffloadsA variety of new workloads and technologies areincreasing the load on CPU utilization. Overlay networks protocols, OVS processing, access to storage and others are placing a strain on VMware environments. High performance workloads require intensiveprocessing which can waste CPU cycles, and choke networks. The end result is that application efficiency is limited and virtual environments as a whole become inefficient. Because of these challenges, data center administrators now look to alleviate CPU loads by implementing intelligent network components that can ease CPU strain, increase network bandwidth and enable scale and efficiency in virtual environments.Mellanox interconnects can reduce the burden byoffloading many networking tasks, thereby freeing CPU resources to serve more VMs and process more data. Side-by-side comparison shows over a 70% reduction in CPU resources and a 40% improvement in bandwidth.Reduce CPU OverheadvSphere 6.5, introduced Remote Direct Memory Access over Converged Ethernet (RoCE). RoCE allows direct memory access from one computer to another without involving the operating system or CPU. The transfer of data is offloaded to a RoCE-capable adapter, freeing the CPU from the data transfer process and reducing latencies. For virtual machines a PVRDMA (para-virtualized RDMA) network adapter is used tocommunicate with other virtual machines. Mellanox adapters are certified for both in vSphere.Without Offloads With OffloadsRoCE dramatically accelerates communication between two network endpoints but also requires a switch that is configured for lossless traffic. RoCE v1 operates overlossless layer 2 and RoCE v2 supports layer 2 and layer 3. To ensure a lossless environment, you must be able to control the traffic flows. Mellanox Spectrum switchessupport Priority Flow Control (PFC) and Explicit Congestion Notification (ECN) which enables a global pause across the network to support RDMA. Once RoCE is setup onvSphere close-to-local, predictable latency can be gained from networked storage along with line-rate throughput and linear scalability. This helps to accommodate dynamic, agile data movement between nodes.HPE StoreFabric M-series and Mellanox ConnectX adapter solutions for VMWareProven PerformanceRDMA for vSAN and Ne x t-Gen StorageRDMA (Remote Direct Memory Access) allows two system to connect sub-OS directly to memory without requiring CPU cycles. This enables high bandwidth, increased IOPS, and low latencyconnectivity, which accelerates workloads running on parallel systems better than traditional TCP/IP connectivity.RDMA benefits to vSAN clusters include:•Improved app performance•Improved resync/rebuild/rebalance time •NVMe-oF technology enablement •Better VM consolidation•Improves cloning and vMotion operations times •Faster metadata updates across vSAN hostsMellanox End-to-End vSAN SolutionHyperconvergedReduce CapExHypeconverged deployments, like HPE SimpliVity and HPESynergy, are a demandingenvironment for networkinginterconnects. These consist ofthree software components: compute virtualization, storage virtualization and management, in which all three require an agile and responsive network.Deploying on 25G networks, like offered with Mellanox ConnectX adapters, assists with offload capabilities to optimizeperformance and availability of synchronization and replication ofvirtualized workloads .CapEx Analysis: 10G vs 25G Mellanox adapters and switchesaccelerate VM resources to improveperformance, enhance efficiency and provide high-availability and are a must-have feature for any VMware and hyperconverged environment. Deployment ConfigsEthernet AdaptersNetwork ManagementHPE vSAN Ready node AF-86x HPE 640FLR-SFP2810/25 2p ConnectX-4Lx(included in ReadyNode bundle)Just Add HPE StoreFabric M-series ToR 2x HPE StoreFabric SN2010M18 x 10/25G SFP + 4 x 40/100G QSFP up ½ width ToR switch means Full HA in 1UvSAN vSphere VMVMVMVMVMVM VM3x HPE DL380 Gen10 with SAS Exp.36x 32GB DDR415x HPE 1.6TB SAS WI SFF SSD 75x HPE 3.2TB SAS MU SFF SSD3x HPE Smart Array P816-a Gen10 12G 3c Dual 8GB microSD USB kitSKU: DL380Gen10_Expander_SAS_AF8-1HPE vSAN ReadyNode RAUp to 80TB in 7U including ToR▪Enable near-native performance for VMs thru stateless offloads▪Extend hardware resources w/ ROCE (RDMA over converged Ethernet)▪Accelerate virtualized networks with VXLAN, GENEVE & NVGRE▪Align network services with compute services for multitenant network supportHPE 640SFP282p 10/25G Ethernet HPE 842QSFP281p 100G EthernetHPE Smart Fabric Orchestrator ▪Visibility –topology view + in-band activity monitoring▪Automation –template based deployment and self healing▪Compliance –Interop validation with HPE SPOCK▪Reports –Fabric Reports + Ad-hoc reportingMonitoring▪Performance monitoring ▪Health monitoring ▪Detailed telemetry ▪Alerts and notificationsThere are over 20 HPE vSAN ReadyNodes with Mellanox Adapters, including:RDMARDMAVMWare vSAN works BEST on Mellanox RDMA enabled adapters and switches•DL380Gen10_All_NVMe_AF4 –1•DL380Gen10_All_NVMe_AF4 –2•DL360Gen10_SAS_AF4 –1•DL380Gen10_SAS_AF4 –1•DL380Gen10_All_NVMe_AF6 –1•DL380Gen10_All_NVMe_AF6 -2•DL360Gen10_SAS_AF6 -1•DL380Gen10_SAS_AF6 –1•DL360Gen10_SAS_AF8 –1•DL380Gen10_All_NVMe_AF8 –1•DL380Gen10_All_NVMe_AF8 –2•DL380Gen10_Expander_SAS_AF8 -1•DL360Gen10_SAS_HY2-1•DL380Gen10_SAS_HY2 -1。

VSAN配置手册

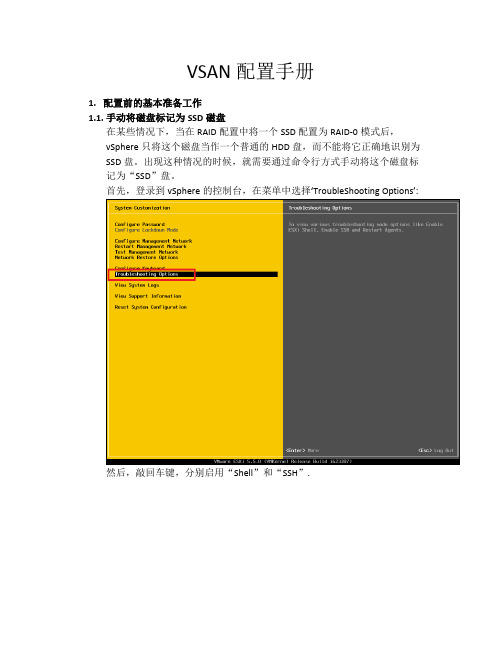

VSAN配置手册1.配置前的基本准备工作1.1.手动将磁盘标记为SSD磁盘在某些情况下,当在RAID配置中将一个SSD配置为RAID-0模式后,vSphere只将这个磁盘当作一个普通的HDD盘,而不能将它正确地识别为SSD盘。

出现这种情况的时候,就需要通过命令行方式手动将这个磁盘标记为“SSD”盘。

首先,登录到vSphere的控制台,在菜单中选择‘TroubleShooting Options’:然后,敲回车键,分别启用“Shell”和“SSH”.这个时候,就可以通过SSH连接到这台ESXi主机。

# ssh***********.x.x成功登录以后,运行以下命令。

# esxcli storage core device list以上这个命令将会列出这台ESXi主机上的所有磁盘列表,将SSD盘找出来,并且将这个SSD盘的ID复制下来,后面会用到。

(一般来说,SSD盘的容量比普通硬盘小很多,所以可以根据容量轻易地将SSD盘找出来。

)然后,运行以下命令,将命令中的ID(红色部分)替换成刚刚复制下来的ID。

# esxcli storage nmp satp rule add -s VMW_SATP_LOCAL -d (如果标记失败重做阵列0)naa.6b8ca3a0e81e03001a4e539c08862b30 -o enable_ssd# esxcli storage core claiming reclaim -dnaa.6b8ca3a0e81e03001a4e539c08862b30下面这个命令可以验证SSD盘是否已经被成功地标记成”SSD”了:# esxcli storage core device list -d naa.6b8ca3a0e81e03001a4e539c08862b30 1.2.为vCenter, vSphere, VSAN添加许可证在vCenter网页客户端里,依次点击主页->主机和群集,然后选择vCenter 目录,再选管理->设置->许可,点“分配许可证密钥”:在新窗口里,选择“分配新的许可证密钥”,输入新密钥后,依次点击解码->确定。

(完整版)VMwareVSAN配置手册

VSAN配置手册1.配置前的基本准备工作1.1.手动将磁盘标记为SSD磁盘在某些情况下,当在RAID配置中将一个SSD配置为RAID-0模式后,vSphere只将这个磁盘当作一个普通的HDD盘,而不能将它正确地识别为SSD盘。

出现这种情况的时候,就需要通过命令行方式手动将这个磁盘标记为“SSD”盘。

首先,登录到vSphere的控制台,在菜单中选择‘TroubleShooting Options’:然后,敲回车键,分别启用“Shell”和“SSH”.这个时候,就可以通过SSH连接到这台ESXi主机。

# ssh ***********.x.x成功登录以后,运行以下命令。

# esxcli storage core device list以上这个命令将会列出这台ESXi主机上的所有磁盘列表,将SSD盘找出来,并且将这个SSD盘的ID复制下来,后面会用到。

(一般来说,SSD盘的容量比普通硬盘小很多,所以可以根据容量轻易地将SSD盘找出来。

)然后,运行以下命令,将命令中的ID(红色部分)替换成刚刚复制下来的ID。

# esxcli storage nmp satp rule add -s VMW_SATP_LOCAL -dnaa.6b8ca3a0e81e03001a4e539c08862b30 -o enable_ssd# esxcli storage core claiming reclaim -dnaa.6b8ca3a0e81e03001a4e539c08862b30下面这个命令可以验证SSD盘是否已经被成功地标记成”SSD”了:# esxcli storage core device list -d naa.6b8ca3a0e81e03001a4e539c08862b30 1.2.为vCenter, vSphere, VSAN添加许可证在vCenter网页客户端里,依次点击主页->主机和群集,然后选择vCenter 目录,再选管理->设置->许可,点“分配许可证密钥”:在新窗口里,选择“分配新的许可证密钥”,输入新密钥后,依次点击解码->确定。

VMWare vSAN运维管理指南

VMware vSAN运维管理指南VMware vSphere 7.0VMware vSAN 7.0目录关于管理 VMware vSAN61vSAN简介72配置和管理 vSAN 群集8使用 vSphere Client 配置 vSAN 群集8在现有群集上启用 vSAN10禁用 vSAN11编辑 vSAN 设置11查看 vSAN数据存储12将文件或文件夹上载到 vSAN 数据存储13从 vSAN 数据存储下载文件和文件夹143使用 vSAN 策略15关于 vSAN 策略15查看 vSAN 存储提供程序18关于 vSAN 默认存储策略19更改 vSAN 数据存储的默认存储策略20使用 vSphere Client 定义 vSAN 的存储策略214扩展和管理 vSAN 群集23扩展 vSAN 群集23扩展 vSAN 群集容量和性能24使用快速入门功能将主机添加到 vSAN 群集24将主机添加到 vSAN 群集25使用主机配置文件配置主机26使用维护模式27检查成员的数据迁移功能29将 vSAN 群集的成员置于维护模式30管理 vSAN 群集中的故障域31在 vSAN 群集中创建新的故障域31将主机移至选定的故障域32将主机移出故障域32重命名故障域33移除选定的故障域33使用 vSANiSCSI 目标服务34启用 iSCSI 目标服务34创建 iSCSI 目标35向 iSCSI 目标添加 LUN35调整 iSCSI 目标上的 LUN 的大小36创建 iSCSI 启动器组36向 iSCSI 启动器组分配目标37监控 vSAN iSCSI 目标服务37将混合 vSAN 群集迁移到全闪存群集38关闭 vSAN 群集的电源38vSAN 文件服务39配置文件服务40创建文件共享43查看文件共享44访问文件共享44编辑文件共享44删除文件共享45升级文件服务45监控性能45监控容量46监控运行状况465vSAN 群集中的设备管理48管理磁盘组和设备48在 vSAN 主机上创建磁盘组49为 vSAN 群集声明存储设备49使用单独的设备50将设备添加到磁盘组51从 vSAN 移除磁盘组或设备51重新创建磁盘组52使用定位符 LED52将设备标记为闪存53将设备标记为 HDD54将设备标记为本地54将设备标记为远程55添加容量设备55从设备移除分区566提高 vSAN 群集中的空间效率57 vSAN 空间效率简介57使用 SCSI UNMAP 回收空间57使用去重和压缩58去重和压缩设计注意事项59在新 vSAN 群集中启用去重和压缩59在现有 vSAN 群集中启用去重和压缩60禁用去重和压缩60减少 vSAN 群集的虚拟机冗余61在启用去重和压缩的情况下添加或移除磁盘61使用 RAID 5 或 RAID 6 删除编码62RAID 5 或 RAID 6 设计注意事项627在 vSAN群集上使用加密63vSAN加密的工作原理63vSAN 加密的设计注意事项64设置标准密钥提供程序64将 KMS 添加到 vCenter Server64设置默认密钥提供程序68完成标准密钥提供程序的信任设置69在新的 vSAN 群集上启用加密69生成新的加密密钥70在现有 vSAN 群集上启用 vSAN 加密71vSAN 加密和核心转储72收集加密 vSAN 群集中 ESXi 主机的 vm-support 软件包72解密或重新加密已加密核心转储738升级 vSAN群集75升级 vSAN 之前75升级 vCenter Server。

VMware_VSAN配置手册

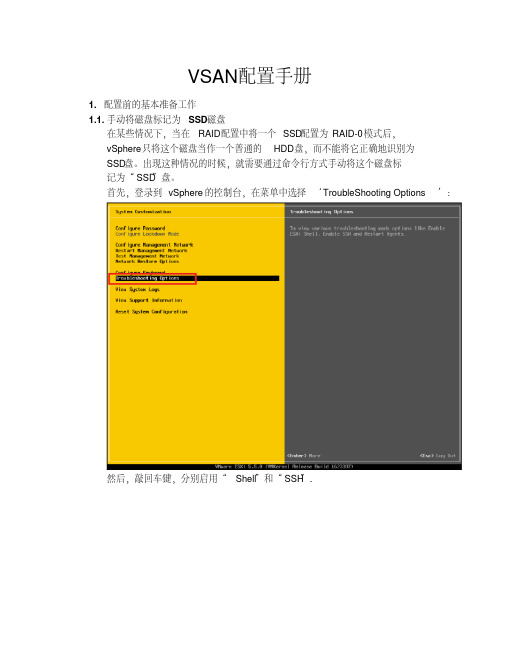

VSAN配置手册1.配置前的基本准备工作1.1.手动将磁盘标记为SSD磁盘在某些情况下,当在RAID配置中将一个SSD配置为RAID-0模式后,vSphere只将这个磁盘当作一个普通的HDD盘,而不能将它正确地识别为SSD盘。

出现这种情况的时候,就需要通过命令行方式手动将这个磁盘标记为“SSD”盘。

首先,登录到vSphere的控制台,在菜单中选择‘TroubleShooting Options’:然后,敲回车键,分别启用“Shell”和“SSH”.这个时候,就可以通过SSH连接到这台ESXi主机。

# ssh root@10.110.x.x成功登录以后,运行以下命令。

# esxcli storage core device list以上这个命令将会列出这台ESXi主机上的所有磁盘列表,将SSD盘找出来,并且将这个SSD盘的ID复制下来,后面会用到。

(一般来说,SSD盘的容量比普通硬盘小很多,所以可以根据容量轻易地将SSD盘找出来。

)然后,运行以下命令,将命令中的ID(红色部分)替换成刚刚复制下来的ID。

# esxcli storage nmpsatp rule add -s VMW_SATP_LOCAL -dnaa.6b8ca3a0e81e03001a4e539c08862b30 -o enable_ssd# esxcli storage core claiming reclaim -dnaa.6b8ca3a0e81e03001a4e539c08862b30下面这个命令可以验证SSD盘是否已经被成功地标记成”SSD”了:# esxcli storage core device list -d naa.6b8ca3a0e81e03001a4e539c08862b30 1.2.为vCenter, vSphere, VSAN添加许可证在vCenter网页客户端里,依次点击主页->主机和群集,然后选择vCenter 目录,再选管理->设置->许可,点“分配许可证密钥”:在新窗口里,选择“分配新的许可证密钥”,输入新密钥后,依次点击解码->确定。

VMware VSAN配置手册

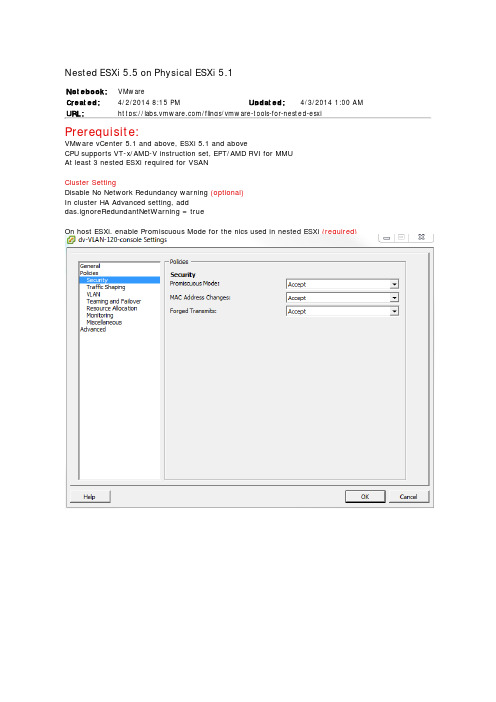

Nested ESXi 5.5 on Physical ESXi 5.1No t e bo o k:VMwareCre at e d:4/2/20148:15 PM Updat e d:4/3/20141:00AM URL:https:///flings/vmware-tools-for-nested-esxi Prerequisite:VMware vCenter 5.1 and above, ESXi 5.1 and aboveCPU supports VT-x/AMD-V instruction set, EPT/AMD RVI for MMUAt least 3 nested ESXi required for VSANCluster SettingDisable No Network Redundancy warning (optional)In cluster HA Advanced setting, adddas.ignoreRedundantNetWarning = trueOn host ESXi, enable Promiscuous Mode for the nics used in nested ESXi (required)1. Build nested ESXi 5.5U1Remove the nicChange Guest Operating System to VMware ESXi 5.xAdd another 2 disks, 20G and 120GAdd a few nics, choose type E1000E (to support jumbo frame) Tag disk as SSDDisk 0:0 is OS disk, disk 0:1 is SSD, disk 0:2 is data diskInstall ESXi to disk 1 (8Gb)Verify disk 2 is tagged as SSDInstall VMware ToolsReference - https:///flings/vmware-tools-for-nested-esxiesxcli software vib install -v /software/vmw-tools/esxi_tools_for_guests/esx-tools-for-esxi-9.7.1-0.0.00000.i386.vib -fConfigure Distributed Virtual SwitchAdd VM Kernel nic for VMotion, NFS and VSANset MTU=9000 (optional depending on network equipment)2. Configure VSANUse Web ClientSelect the vmk nic to be used for VSAN and edit properties, select Virtual SAN trafficN ow Turn off HA in cluster and move ESXi to clusterTurn on VSAN, if you only have disks for VSAN, select Add disks to storage Automatically. Otherwise,select ManualYou will see warning because disks are not added yet.Now go to Disk Management under Virtual SAN and click Claim DisksClick Select all eligible disksNow the VSAN datastore is available3. Create VSAN Storage PolicyGo to web client HomeI create a policy called VSAN RedundancyDefault Number of failures tolerate: 1 (N+1). If you want N+2, set it to 2 Number of disk striptes per object: VMDK can be split to multiple stripesNow turn on vSphere HA on the clusterSet vSphere HA Virtual Machine Options -> Host Isolation repose: Power off。

VMware vSAN设计与规模设定指南

VMware vSAN 设计与规模设定指南目录1.简介1.1.概述2.vSAN 设计概述2.1.遵守VMware 兼容性指南(VCG)2.2.均衡配置2.3.vSAN 集群的生命周期2.4.针对容量维护和可用性的规模设定2.5.运行状况服务2.6.使用受支持的vSphere 软件版本2.7.全闪存注意事项2.8.设计概述注意事项摘要3.vSAN 限制3.1.ESXi 主机和虚拟机限制3.2.虚拟机存储策略最大值3.3.最大VMDK 大小3.4.vSAN 限制设计注意事项摘要4.网络设计注意事项4.1.网络连接性和带宽4.2.使用网卡绑定实现冗余4.3.MTU 和巨型帧注意事项4.4.多播注意事项4.5.通过Network I/O Control 实现网络服务质量4.6.网络设计注意事项摘要5.存储设计注意事项5.1.硬盘组5.2.缓存规模设定概述5.3.vSAN 中的闪存设备5.4.缓存算法5.5.混合配置的闪存缓存大小设定5.6.全闪存配置的闪存缓存规模设定5.7.闪存耐久性注意事项5.8.纵向扩展容量,确保足够缓存5.9.SATA、SAS、PCI-E 和NVMe 闪存设备5.10.磁盘5.11.我需要多少容量?5.12.我应当保留多少空闲空间?5.13.格式化开销注意事项5.14.快照缓存规模设定注意事项5.15.选择存储I/O 控制器5.16.硬盘组设计5.17.小型硬盘驱动器容量注意事项5.18.非常大的VMDK 注意事项5.19.硬盘更换/升级的人体工程学5.20.存储设计注意事项摘要6.虚拟机存储策略设计注意事项6.1.概述6.2.对象和组件6.3.见证和副本6.4.虚拟机快照注意事项6.5.从UI 中查看对象布局6.6.策略设计决策6.7.虚拟机命名空间和交换文件注意事项6.8.动态更改虚拟机存储策略6.9.调配无法实施的策略6.10.使用默认策略调配6.11.存储策略设计注意事项摘要7.主机设计注意事项7.1.CPU 注意事项7.2.内存注意事项7.3.主机存储要求7.4.引导设备注意事项7.5.仅限计算的主机的注意事项7.6.维护模式注意事项7.7.刀片系统注意事项7.8.外部存储柜注意事项7.9.处理器电源管理注意事项8.集群设计注意事项8.1.3 节点配置8.2.vSphere HA 注意事项8.3.故障域8.4.重复数据消除和压缩注意事项9.确定工作负载是否适用于vSAN9.1.概述9.2.使用View Planner 进行vSAN 规模设定9.3.VMware Infrastructure Planner –VIP10.设计和规模设定示例10.1.容量大小设定示例I10.2.容量大小设定示例II11.概述11.1.概述12.更多信息12.1.VMware 就绪节点12.2.VMware 兼容性指南12.3.vSAN规模设定工具12.4.vSphere 社区页面12.5.vSAN 资源链接12.6.VMware 技术支持12.7.附加阅读13.旧版本13.1.版本 6.51. 简介VMware® vSAN™ 是超融合的软件定义的存储平台,与VMware vSphere® 全面集成。

VMware6.5与VSAN部署手册

VMware 6.5使用配置手册1.部署概述1.1 部署环境本次测试使用TC4600重融合一体机进行测试。

每个节点机器配置如下:CPU 2 * Intel(R) Xeon(R) CPU E5-2630 v3 @ 2.40GHz内存256GB系统盘1*1T SATA缓存盘2*480GB SSD数据盘4*4T SATA网卡1*双口千兆1*双口万兆实际部署中,创建了两个虚拟机,分别为windows2008,vCenter。

具体信息如下:机器名称操作系统功能IP DNSAD windows2008 AD/DNS/NTP 10.0.51.220/24 10.0.51.220 vCenter - vCenter服务10.0.51.221/24 10.0.51.2201.2 部署流程流程如下:a)安装ESXib)安装windows2008c)Windows2008起AD/DNS/NTP服务d)导入安装vCentere)配置vCenterf)配置vSAN2.安装ESXi1.1 光盘启动安装选择从光盘启动,安装ESXi 选择安装的位置:输入管理员密码重启1.2 设置管理网3.部署AD/DNS/NTP 安装windows2008上传镜像安装windows2008略安装AD/DNS略4.安装vCenter(VCSA)3.1 导入安装OVF模板打开已经下载的vsca文件:导航至I:\vcsa 如下:使用浏览器登录到单台ESXi并且登录:创建vCenter虚拟机3.2 配置vCenter(VCSA)浏览器登录https://10.0.51.221:54803.3 配置数据中心如果没有做DNS解析,请在host文件中修改好主机名和IP对应关系:浏览器中输入:https://10.0.51.221/创建数据中心:创建集群:添加主机:依次完成所有节点的添加,具体如下所示:5.配置vSAN4.1 配置vSAN网络新建分布树交换机配置分布式交换机:分别为4个主机分配上行链路分别为4个主机配置vmkernel口4.2 配置vSAN存储为各个主机上申明磁盘:划分故障域配置好存储后,可以看到vSAN存储系统:。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

VSAN配置手册1.配置前的基本准备工作1.1.手动将磁盘标记为SSD磁盘在某些情况下,当在RAID配置中将一个SSD配置为RAID-0模式后,vSphere只将这个磁盘当作一个普通的HDD盘,而不能将它正确地识别为SSD盘。

出现这种情况的时候,就需要通过命令行方式手动将这个磁盘标记为“SSD”盘。

首先,登录到vSphere的控制台,在菜单中选择‘TroubleShooting Options’:然后,敲回车键,分别启用“Shell”和“SSH”.这个时候,就可以通过SSH连接到这台ESXi主机。

# ssh root@10.110.x.x成功登录以后,运行以下命令。

# esxcli storage core device list以上这个命令将会列出这台ESXi主机上的所有磁盘列表,将SSD盘找出来,并且将这个SSD盘的ID复制下来,后面会用到。

(一般来说,SSD盘的容量比普通硬盘小很多,所以可以根据容量轻易地将SSD盘找出来。

)然后,运行以下命令,将命令中的ID(红色部分)替换成刚刚复制下来的ID。

# esxcli storage nmp satp rule add -s VMW_SATP_LOCAL -dnaa.6b8ca3a0e81e03001a4e539c08862b30 -o enable_ssd# esxcli storage core claiming reclaim -dnaa.6b8ca3a0e81e03001a4e539c08862b30下面这个命令可以验证SSD盘是否已经被成功地标记成”SSD”了:# esxcli storage core device list -d naa.6b8ca3a0e81e03001a4e539c08862b30 1.2.为vCenter, vSphere, VSAN添加许可证在vCenter网页客户端里,依次点击主页->主机和群集,然后选择vCenter 目录,再选管理->设置->许可,点“分配许可证密钥”:在新窗口里,选择“分配新的许可证密钥”,输入新密钥后,依次点击解码->确定。

下面给每一台ESXi主机添加许可证。

如下图所示,选择每一个需要添加许可证的主机,在右边窗口里依次选择管理->设置->许可,点“分配许可证密钥”:下面添加VSAN许可证,VSAN许可证是针对于某一个群集添加的。

选中需要添加许可证的VSAN群集,依次点击管理->设置->虚拟SAN许可->分配许可证密钥:1.3.删除磁盘原有的分区如果一台ESXi主机的某个磁盘,在升级vSphere之前用作为一个存储器(datastore),那么,如果这个磁盘没有被格式化过,它上面就仍然保持着原来的分区。

而VSAN要求每个被添加到VSAN磁盘组里的磁盘都必须是一块“干净”的磁盘,也就是说,磁盘上面不能有任何分区表。

所以,在这种情况下,就需要将磁盘上原来的分区表删除。

为了删除分区表,利用的是Linux系统下常用的”GPT parted”工具,在许多Linux发行版里,这个工具的名字叫做”parted”。

在ESXi主机命令行,这个工具叫做“partedUtil”.首先,在vCenter页面客户端里,选中VSAN群集,选择“添加磁盘组”,确认有哪些磁盘已经被识别出来:从截图中可以看到,当前只有一个SSD盘和一个HDD硬盘被识别出来,记录下图中红框部分的这两个磁盘名。

然后,通过SSH连接到这台ESXi主机。

(连接方法与1.1节相同)在命令行界面,运行以下命令,这个命令会列出所有磁盘的详细信息:# esxcli storage core device list查看所有磁盘的磁盘名,把它们摘录出来,例如,总共有4块盘,如下所示:→naa.6b8ca3a0e81e29001ac40ec147ca070e→naa.6b8ca3a0e81e29001ac40e3b3fd36bb2→naa.6b8ca3a0e81e29001ac40e834416a708→naa.6b8ca3a0e81e29001ac40d7f349ab358比较前面的截图和这个列表,可以发现有两个磁盘没有被VSAN识别出来。

它们是→naa.6b8ca3a0e81e29001ac40ec147ca070e→naa.6b8ca3a0e81e29001ac40d7f349ab358这两个磁盘没有被VSAN识别出来,可能有两个原因。

一是这个盘上安装了ESXi操作系统,所以它不能再被VSAN使用了。

另一个原因是这块盘虽然现在没有被使用,但是它以前曾经被作为datastore,所以还有遗留的分区表。

所以,现在需要找出哪个磁盘是用来安装ESXi操作系统的。

切换到存储器界面,找到这台主机的默认存储器,查看其信息:可以看出,磁盘‘naa.6b8ca3a0e81e29001ac40d7f349ab358’是这台ESXi主机的启动盘,所以这个磁盘不能被VSAN使用。

综合以上的所有分析,结论就是:‘naa.6b8ca3a0e81e29001ac40ec147ca070e’这个磁盘当前未被使用,但是上面有遗留的分区,所以也不能被VSAN识别出来。

下面的操作就是来删除这个分区。

运行以下命令,获取这块磁盘的详细信息:# partedUtil get /vmfs/devices/disks/naa.6b8ca3a0e81e29001ac40ec147ca070e 这个命令会输出一个信息表,示例如下:243133 255 63 39059456001 2048 3905945566 0 0第二行的第1个数字(红色数字)代表有几个分区,在这个例子中是只有一个分区。

然后运行以下命令直接删除这个分区:# partedUtil delete/vmfs/devices/disks/naa.6b8ca3a0e81e29001ac40ec147ca070e 1删除完成后,现在返回vCenter网页客户端,再尝试添加VSAN磁盘组,现在发现这个磁盘盘被删除分区后已经能够被VSAN利用了:2.创建vSphere标准交换机或分布式交换机VSAN网络可以使用vSphere标准交换机(vSphere Standard Switch,简称vSS)或者分布式交换机(vSphere Distributed Switch,简称vDS)。

如果需要创建标准交换机,可查看2.1节。

如果需要创建分布式交换机,可查看2.2节。

这两节是并列的关系,根据需要查看其中一节即可。

2.1.使用vSphere标准交换机在vCenter主页面,点击“主机和群集”。

选择需要创建标准交换机的某一台主机,点击管理->网络->虚拟交换机。

然后点击右边的带“+”的按钮,创建VSAN网络:在下个页面,选择“VMkernel 网络适配器”:然后,选择一个现有交换机(当然,这个时候也可以选择新建一个标准交换机,但是,创建新标准交换机时,必须保证有一个未被使用的网卡做的这个新交换机的上连链路):输入一个自定义的名称,然后必须勾选“虚拟SAN流量”输入一个可用的IP地址和子网掩码,点击下一步,再点击完成。

注意:标准交换机需要在每一个ESXi主机都分别添加,添加过程相同,只需要在每一台ESXi主机上重复以上过程即可。

2.2.使用vSphere分布式交换机在vCenter主页,选中网络,再点击“操作” ->“新建Distributed Switch”,如图所示:然后,在弹出的页面中,输入一个分布式交换机名称:保持交换机的版本为默认的5.5.0:下一步,需要选择“上行链路数”。

一般来说,每个ESXi主机需要使用一块网卡作为上行链路,所以,VSAN群集中有多少个ESXi主机,这台的上行链路数就应该设定为多少。

这个数值与VSAN群集包含的主机数量完全相关。

然后,也可勾选“创建默认端口组”,输入一个自定义的名称。

这样,分布式交换机就创建好了。

3.打开VSAN如何在vCenter中创建群集不再赘述,这与传统创建群集的方式完全相同。

假设一个群集已经创建成功,并且已经有主机添加进来,现在需要做的就是在这个群集上打开VSAN功能。

如图所示,选中群集名称,点击管理->虚拟SAN->常规,在右上角点编辑,再在弹出的对话框中点“打开虚拟SAN”即可,向存储中添加磁盘的模式可以设置为“手动”。

4.添加新的ESXi主机到VSAN群集注意:以下的步骤展示如何在一台新添加的主机上启用分布式交换机。

如果需要使用标准交换机,请参考2.1节,并且以下关于添加分布式交换机的相关步骤可以省略。

在vCenter网页客户端主页,选择网络:然后选择上面步骤中创建好的分布式交换机“VSAN vDS”,在右边菜单中,选择“入门”->“添加和管理主机”:选择“添加主机”:点击“+新主机”按钮:在新对话框选择新加入的主机(这个主机已经被添加到群集中,只是还没有配置VSAN网络而已)勾选下面两个对话框:选择一个网卡来作为上行链路,点击“Assign uplink”:在下一步,点击“+新建适配器”:选择一个分布式交换机端口组,就是刚刚创建的“VSAN Network”:勾选“虚拟SAN流量” :输入可用的IP地址和相应的子网掩码:确认状态:现在回到主页,选择“主机和群集”:然后进入到群集的管理页面,确认这个ESXi主机已经加入到了这个VSAN组中,但是,它的磁盘还没有被添加进来。

所以,选中这个新主机,手动创建一个磁盘组:选择一个SSD盘和最多7个HDD硬盘:然后确认这个磁盘组已经被成功地创建了:5.创建虚拟机存储策略当启用VSAN以后,我们就可以利用VSAN提供的功能来创建一些虚拟机存储策略。

例如:我们可以创建一个策略,这个策略忍受一台主机故障。

执行以下步骤:在主页中,选择“规则和配置文件”:选择虚拟机存储策略:点击“添加”按钮:先输入一个自定义的名称,在下一步,“基于供应商特定功能的规则”中,选择“VSAN”。

在“添加功能”中,选择“Number of failures of tolerate”:保持默认值为1:然后点击结束完成存储策略的创建。

接着按着“创建虚拟机”的常规流程创建一个虚拟机。

直到接下来这一步,在“虚拟机存储策略”选项栏选项刚刚创建好的策略,在下面的存储中,选择兼容的“vsanDatastore”:出于测试的目的,只创建5GB的硬盘:当虚拟机创建完成后,就可以在虚拟机的管理页面,看到虚拟机的虚拟磁盘在物理主机上的放置情况,其中包含两个“组件”(Component)和一个“证明”(Witness):。