最大熵算法在汉语拼音标注中的研究与实现

基于最大熵的汉语篇章结构自动分析方法

国家自然科学基金(61003160)、863计划(2011AA01A207)和中国科学院西部行动计划项目(KGZD-EW-501)资助收稿日期: 2013-06-15; 修回日期: 2013-09-25; 网络出版时间:北京大学学报(自然科学版)Acta Scientiarum Naturalium Universitatis Pekinensisdoi: 10.13209/j.0479-8023.2014.021基于最大熵的汉语篇章结构自动分析方法涂眉† 周玉 宗成庆中国科学院自动化研究所模式识别国家重点实验室, 北京100190; † 通信作者, E-mail: mtu@摘要 在标有复句逻辑语义关系的清华汉语树库上, 研究汉语篇章语义片段自动切分以及篇章关系的自动标图1 汉语中逻辑关系的例子Fig.1 An example of Chinese rhetorical relationship2013-11-08 09:26网络出版地址:/kcms/detail/11.2442.N.20131108.0926.001.html北京大学学报(自然科学版)2的片段之间形成转折关系, 然后它们连接起来再与跨度3形成连贯关系。

最近20年, 随着互联网和计算机技术的高速发展, 依赖于篇章分析和理解的应用不断涌现, 如基于篇章的自动文摘、自动问答以及自动翻译等, 日益凸显出研究篇章分析的重要性和急迫性。

以汉英机器翻译为例, 输入图1中的汉语文本, 由Google在线翻译系统得到的翻译结果为: 1) Although thepopulation ofFijiare very differentbet- ween the two countries; 2) but have much in common;3) with good conditions forthe development of frien- dlycooperationand infrastructure。

平滑的最大熵模型在汉语词性自动标注中的应用

1 最 大 熵 模 型

最大熵 的主 要 思想 是 , 只 掌握 关 于 未 知分 在 布 的部分 知识 时 , 该 选 取 符 合 这些 知识 且 熵值 应

( ) 尔科 夫的关 于 独立 性 假设 ( 定第 + 3马 假

1 个符号出现这个事件的概率 只跟其前 的 个符

收 稿 日期 : 0 60 —8 2 0 —71 基金项 目:吉林 省科技厅平 台建设 基金资助项 目( 吉科合字 2 0 0 1 0 3 0 6号) 作者简介 :  ̄ I ( 9 5 )男 , 17 - , 汉族, 山东荷 泽人 , 长春工 业大 学硕 士研究 生 , 要从 事人 工智 能方 向研 究. *联 系人 : 主 赵 伟 (9 7 ) 男 , 1 6 - , 汉族 , 吉林长 春人, 春工业大学 副教授 , 学硕士 , 长 工 主要从 事人 工智 能、 Agn 多 et系统 、 软件 自动化 与程 序 分 析 研 究 ,E malpic10 @ 13 t m. - i rne 2 5 6. o :

另一个 优点 是 , 以 有 效 地 利用 自然 语 言 中存 在 可

的一些 非 连续 特 征 。 由于最 大熵 的 这 些优 点 , 使

其成 ) 元 模 型 处 理 的 文 本 , 个 单 词 只 能 2由 某

跟前 几个 词有关 ;

ZHA O — i g, ZHA O e Faxn W i

( c o fC S h olo omp t rAp iain Te h oo y,Ch n c u ie st fTe hn l g u e pl to c n lg c a g h n Un v riy o c oo y,Cha c u 3 0 2,Chia ng h n 1 0 1 n)

基于深度学习方法的中文分词和词性标注研究

基于深度学习方法的中文分词和词性标注研究中文分词和词性标注是自然语言处理中的重要任务,其目的是将输入的连续文字序列切分成若干个有意义的词语,并为每个词语赋予其对应的语法属性。

本文将基于深度学习方法对中文分词和词性标注进行研究。

一、深度学习方法介绍深度学习是一种基于神经网络的机器学习方法,在自然语言处理领域中应用广泛。

经典的深度学习模型包括卷积神经网络(Convolutional Neural Network,CNN)、循环神经网络(Recurrent Neural Network,RNN)、长短时记忆网络(LongShort-Term Memory, LSTM)和门控循环单元(Gated Recurrent Unit, GRU)等。

在对中文分词和词性标注任务的研究中,CNN、RNN以及LSTM均被采用。

CNN主要用于序列标注任务中的特征提取,RNN及LSTM则用于序列建模任务中。

GRU是LSTM的一种简化版本,在应对大规模文本序列的过程中更为高效。

二、中文分词中文分词是将一段连续的汉字序列切分成有意义的词语。

传统的中文分词方法主要包括基于词典匹配的分词和基于统计模型的分词。

基于词典匹配的分词方法基于预先构建的词典,将待切分文本与词典进行匹配。

该方法精度较高,但需要较为完整的词典。

基于统计模型的分词方法则通过学习汉字之间的概率关系来进行分词。

该方法不依赖于完整的词典,但存在歧义问题。

深度学习方法在中文分词任务中也有较好的表现,通常采用基于序列标注的方法。

具体步骤如下:1. 以汉字为单位对输入文本进行编码;2. 使用深度学习模型进行序列标注,即对每个汉字进行标注,标记为B(词的开头)、M(词的中间)或E(词的结尾),以及S(单字成词);3. 将标注后的序列按照词语切分。

其中,深度学习模型可以采用CNN、RNN、LSTM或GRU等模型。

三、中文词性标注中文词性标注是为每个词语赋予其对应的语法属性,通常使用含有标注数据的语料库进行训练。

基于最大熵模型的中文词与句情感分析研究pdf

基于最大熵模型的中文词与句情感分析研究*董喜双,关毅,李本阳,陈志杰,李生哈尔滨工业大学,哈尔滨,150001dongxishuang@, guanyi@, libenyang012566@, ruoyu_928@,lisheng@摘要:本文将研究焦点对准喜、怒、哀、惧四类情感分析问题,重点解决中文词、句的情感分析问题。

将词的情感分析处理为候选词情感分类问题。

首先通过词性过滤获得候选词,进而根据特征模板获取候选词情感特征,然后应用最大熵模型判断候选词情感类别,最后应用中性词典、倾向性词典、复句词表、否定词表过滤候选情感词分类错误得到情感词集合。

句的情感分析首先根据情感词典和倾向词典提取词特征,并采用规则提取词序列特征,然后采用最大熵模型对句子进行情感分类。

在COAE2009评测中词与句情感分析取得较好结果。

关键词:情感分析;情感极性;最大熵;分类;Sentiment Analysis on Chinese Words and Sentences Based on Maximum Entropy ModelDong Xi-Shuang, Guan Yi, Li Ben-Yang, Chen Zhi-Jie, Li ShengHarbin Institute of Technology, Harbin 150001dongxishuang@, guanyi@, libenyang012566@, ruoyu_928@,lisheng@Abstract: This paper presents a method to analyze sentiments on Chinese words and sentences, where the sentiments include happy, angry, sad, and fear. In the case of words, sentiment analysis was processed as the sentiment classification of candidate words. The candidate words were firstly obtained by POS filtering, then Maximum Entropy (ME) model was adopted to judge sentiment categories of the words, which sentiment features were gained with feature templates. Finally, errors in the word classification would be removed through filtering with a neutral lexicon, a sentiment polarity lexicon, a connective word list of complex sentences, and a negative word list. In the case of sentences, word features in sentences were extracted on the basic of the sentiment lexicon and the sentiment polarity lexicon, and word sequence features were extracted by rules while processing sentiment analysis on sentences, then ME model was used to classify the sentences. Good performance of sentiment analysis was gained in COAE 2009.Keywords: Sentiment Analysis, Sentiment Polarity, Maximum Entropy, Classification1 引言情感分析的主要任务为识别文本对某一事物的观点[1]。

基于最大熵模型的汉语词性标注研究的开题报告

基于最大熵模型的汉语词性标注研究的开题报告一、课题背景和意义随着自然语言处理技术的不断发展和应用,对汉语的语言分析需求也日益增长,其中词性标注是其中一个重要的语言分析任务。

词性是指词语所具有的语法范畴和语义类别,词性标注是指给定一个句子,将句子中的每个词语标记出其所属的词性类别,是文本处理、信息检索、语音识别等领域的基础技术之一。

目前,汉语词性标注已经成为NLP领域中的研究热点之一,常常作为其他任务的前置处理,如命名实体识别、文本分类、信息抽取等。

而最大熵模型由于其高效性、准确性和较好的可解释性,已被广泛应用于自然语言处理中,包括词性标注、命名实体识别、文本分类等任务。

无论是在学术界还是工业界,最大熵模型都是自然语言处理中的重要技术之一。

本研究旨在探究基于最大熵模型的汉语词性标注算法,提高该算法的标注准确率,为汉语自然语言处理的研究和应用提供技术支持。

二、研究内容和方法本研究将采用最大熵模型对汉语句子进行词性标注,具体研究内容包括:1. 研究最大熵模型的基本原理及其在词性标注中的应用。

2. 研究汉语词性标注中的特征选取方法和特征模板设计,探究不同特征组合对词性标注效果的影响。

3. 实现基于最大熵模型的汉语词性标注算法,并与其他词性标注算法在不同数据集上进行比较和分析。

具体的研究方法包括:1. 阅读汉语词性标注相关文献,并了解最大熵模型的基本原理和应用情况。

2. 针对汉语词性标注中的特征选取和特征模板设计问题,分析现有算法中采用的特征和模板,结合最大熵模型特性,提出适用于汉语词性标注的特征选取和特征模板设计方法。

3. 根据上述方法,开发基于最大熵模型的汉语词性标注算法,并使用不同数据集进行测试和评估。

三、预期成果和意义本研究的预期成果包括:1. 提出适用于汉语词性标注的特征选取和特征模板设计方法,用以改进现有的词性标注算法,并提高算法的准确率和鲁棒性。

2. 实现基于最大熵模型的汉语词性标注算法,并通过实验验证其效果。

汉字信息熵

汉字信息熵汉字信息熵是衡量汉字信息量的一种指标,它是通过对汉字出现的频率进行统计和计算得出的。

汉字信息熵的大小反映了汉字的信息丰富程度,也是汉字在信息传递中的重要性的体现。

汉字信息熵的计算方法是基于信息论的原理。

信息论是由克劳德·香农于1948年提出的一种研究信息传递和处理的数学理论。

在信息论中,熵是衡量信息量的一种度量,它表示信息的不确定性。

而汉字信息熵则是对汉字出现的频率进行统计和计算得出的信息熵。

汉字信息熵的计算公式如下:H(X) = -∑(P(xi) * log2P(xi))其中,H(X)表示汉字信息熵,P(xi)表示汉字xi出现的概率。

通过对大量文本进行分析和统计,可以得出汉字的出现频率以及对应的概率。

根据这些数据,就可以计算出每个汉字的信息熵。

汉字信息熵的大小与汉字的常用程度相关。

常用的汉字出现的频率较高,信息熵较低;而不常用的汉字出现的频率较低,信息熵较高。

因此,汉字信息熵可以用来衡量汉字的重要性和使用频率。

在实际应用中,汉字信息熵有着广泛的应用。

比如,在信息检索中,可以根据汉字的信息熵来确定检索关键词的重要性和权重,从而提高检索的准确性和效率。

在自然语言处理中,可以根据汉字的信息熵来进行文本分类和语义分析,从而实现智能化的文本处理和理解。

汉字信息熵还可以用来研究汉字的演化和变异规律。

通过对不同时期和不同地域的汉字信息熵进行比较,可以了解汉字的变化和发展规律,从而推测汉字的起源和演化过程。

汉字信息熵是衡量汉字信息量的一种重要指标,它可以用来衡量汉字的重要性和使用频率,也可以用来进行文本处理和语义分析。

汉字信息熵的研究对于汉字的保护、发展和应用都具有重要的意义。

通过对汉字信息熵的深入研究,可以更好地理解和利用汉字这一独特的文化符号。

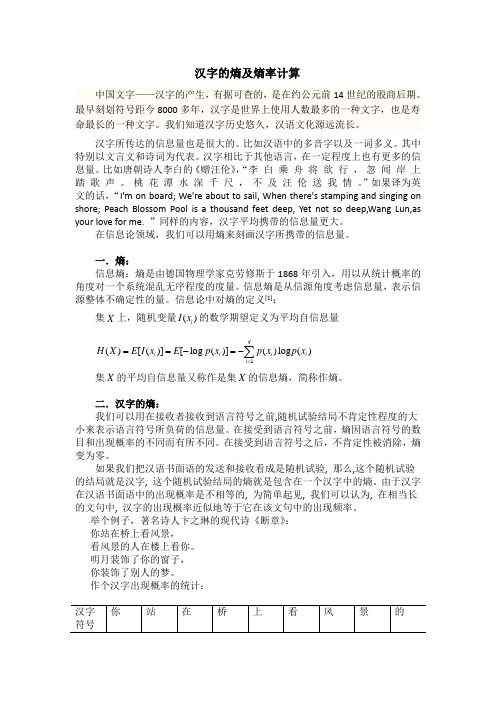

汉字的熵及熵率计算(信息论课堂论文)

汉字的熵及熵率计算中国文字——汉字的产生,有据可查的,是在约公元前14世纪的殷商后期。

最早刻划符号距今8000多年,汉字是世界上使用人数最多的一种文字,也是寿命最长的一种文字。

我们知道汉字历史悠久,汉语文化源远流长。

汉字所传达的信息量也是很大的。

比如汉语中的多音字以及一词多义。

其中特别以文言文和诗词为代表。

汉字相比于其他语言,在一定程度上也有更多的信息量。

比如唐朝诗人李白的《赠汪伦》,“李 白 乘 舟 将 欲 行 , 忽 闻 岸 上 踏 歌 声 。

桃 花 潭 水 深 千 尺 , 不 及 汪 伦 送 我 情 。

”如果译为英文的话,“I'm on board; We're about to sail, When there's stamping and singing on shore; Peach Blossom Pool is a thousand feet deep, Yet not so deep,Wang Lun,as your love for me. ”同样的内容,汉字平均携带的信息量更大。

在信息论领域,我们可以用熵来刻画汉字所携带的信息量。

一.熵:信息熵:熵是由德国物理学家克劳修斯于1868年引入,用以从统计概率的角度对一个系统混乱无序程度的度量。

信息熵是从信源角度考虑信息量,表示信源整体不确定性的量。

信息论中对熵的定义[1]:集X 上,随机变量()i I x 的数学期望定义为平均自信息量1()[()][log ()]()log ()qi i i i i H X E I x E p x p x p x ===-=-∑集X 的平均自信息量又称作是集X 的信息熵,简称作熵。

二.汉字的熵:我们可以用在接收者接收到语言符号之前,随机试验结局不肯定性程度的大小来表示语言符号所负荷的信息量。

在接受到语言符号之前,熵因语言符号的数目和出现概率的不同而有所不同。

在接受到语言符号之后,不肯定性被消除,熵变为零。

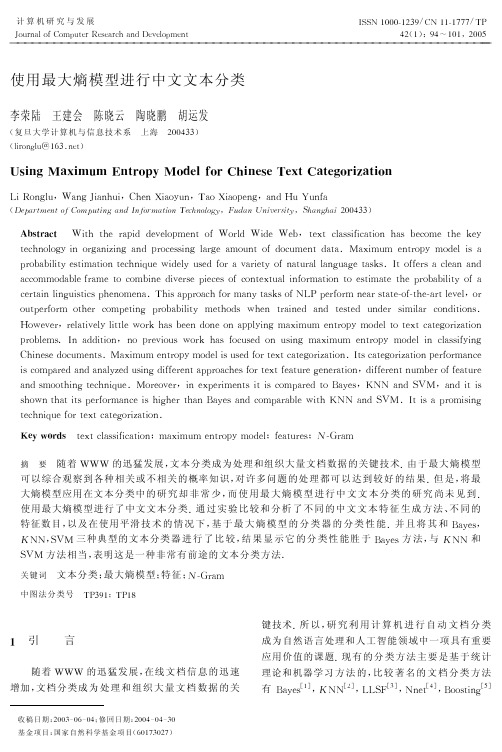

使用最大熵模型进行中文文本分类

! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! ! !

使用最大熵模型进行中文文本分类

李荣陆 王建会 陈晓云 陶晓鹏 胡运发

关键词

文本分类; 最大熵模型; 特征; ; & X 1 3 6

, ( ) $; , $ Y

中图法分类号

> 引

言

键技术 研究利用计算机进行自动文档分类 G 所 以, 成为自然语言处理和人工智能领域中一项具有重要 应用价值的课题 G现 有 的 分 类 方 法 主 要 是 基 于 统 计 理论和机器学习 方 法 的, 比较著名的文档分类方法

9 : " , ’ ; ,

, I E 8 =8 = 91 3 E >> 9 @ 9 4 / 6 9 2 8/ 5I / 1 4 >I E > 9I 9 N 8 9 O 8< 4 3 ; ; E 5 E < 3 8 E / 2= 3 ;N 9 < / 6 98 = 9P 9 7 7 K

8 9 < = 2 / 4 / E 2/ 1 3 2 E Q E 2 2 >7 1 / < 9 ; ; E 2 3 1 93 6 / 0 2 8/ 5> / < 0 6 9 2 8> 3 8 3 GR 3 O E 6 0 69 2 8 1 / / > 9 4E ;3 F K F F3 F4 F 7 K6 1 / N 3 N E 4 E 8 ; 8 E 6 3 8 E / 28 9 < = 2 E 0 9T E > 9 4 ; 9 >5 / 13@ 3 1 E 9 8 52 3 8 0 1 3 4 4 3 2 0 3 98 3 ; P ; G! 8/ 5 5 9 1 ;3< 4 9 3 23 2 > 7 K9 S K0 K/ F F 3 < < / 66 / > 3 N 4 9 5 1 3 6 98 /< / 6 N E 2 9> E @ 9 1 ; 97 E 9 < 9 ;/ 5< / 2 8 9 O 8 0 3 4 E 2 5 / 1 6 3 8 E / 28 /9 ; 8 E 6 3 8 98 = 97 1 / N 3 N E 4 E 8 53 K/ , / 1 < 9 1 8 3 E 2 4 E 2 0 E ; 8 E < ;7 = 9 2 / 6 9 2 3 G, = E ; 3 1 / 3 < = 5 / 16 3 2 8 3 ; P ; / 5# H -7 9 1 5 / 1 62 9 3 1 ; 8 3 8 9 & / 5 & 8 = 9 & 3 1 8 4 9 @ 9 4 F 7 7 K / 0 8 9 1 5 / 1 6/ 8 = 9 1< / 6 9 8 E 2 1 / N 3 N E 4 E 8 9 8 = / > ;T = 9 28 1 3 E 2 9 >3 2 >8 9 ; 8 9 >0 2 > 9 1; E 6 E 4 3 1< / 2 > E 8 E / 2 ; G 7 7 F7 K6 , L / T 9 @ 9 11 9 4 3 8 E @ 9 4 4 E 8 8 4 9T / 1 P= 3 ;N 9 9 2> / 2 9/ 23 4 E 2 3 O E 6 0 69 2 8 1 / / > 9 4 8 /8 9 O 8< 3 8 9 / 1 E Q 3 8 E / 2 K 7 7 K F6 7 K6 F ,2 1 / N 4 9 6 ; G! 23 > > E 8 E / 2 /7 1 9 @ E / 0 ;T / 1 P= 3 ;5 / < 0 ; 9 >/ 20 ; E 2 3 O E 6 0 69 2 8 1 / / > 9 4E 2< 4 3 ; ; E 5 E 2 7 F6 7 K6 K F * = E 2 9 ; 9> / < 0 6 9 2 8 ; GR 3 O E 6 0 69 2 8 1 / / > 9 4 E ; 0 ; 9 > 5 / 1 8 9 O 8 < 3 8 9 / 1 E Q 3 8 E / 2 G! 8 ; < 3 8 9 / 1 E Q 3 8 E / 27 9 1 5 / 1 6 3 2 < 9 7 K6 F F , E ; < / 6 3 1 9 >3 2 >3 2 3 4 Q 9 >0 ; E 2 E 5 5 9 1 9 2 8 3 1 / 3 < = 9 ; 5 / 1 8 9 O 8 5 9 3 8 0 1 9F 9 2 9 1 3 8 E / 2 > E 5 5 9 1 9 2 8 2 0 6 N 9 1 / 5 5 9 3 8 0 1 9 7 K F> 7 7 , ,V##3 3 2 >; 6 / / 8 = E 2 9 < = 2 E 0 9 GR / 1 9 / @ 9 1 E 29 O 9 1 E 6 9 2 8 ; E 8 E ;< / 6 3 1 9 >8 /U 3 9 ; 2 >" WR, 3 2 >E 8 E ; F8 S 7 7 K ; = / T 2 8 = 3 8 E 8 ;7 9 1 5 / 1 6 3 2 < 9 E ;= E = 9 18 = 3 2U 3 9 ;3 2 >< / 6 3 1 3 N 4 9T E 8 = V##3 2 >" WR G! 8 E ;37 1 / 6 E ; E 2 F K 7 F 8 9 < = 2 E 0 9 5 / 1 8 9 O 8 < 3 8 9 / 1 E Q 3 8 E / 2 G S F ;6 ; ;; < 2 . 1 " 8 9 O 8 < 4 3 ; ; E 5 E < 3 8 E / 2 3 O E 6 0 69 2 8 1 / / > 9 4 5 9 3 8 0 1 9 ; & X 1 3 6 7 K6 0=

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

{ f(x,y)= 1if y =luo'∧ next(x)='在' 0 x 表示上下 文 环 境,上 面 的 公 式 表 达 一 个 含 有 “落”字的句子,y 表 示 输 出,对 应 着 “落”字 的 发 音, 可看作是上下文环境x 的 一 个 函 数.表 示 x 中 跟 在 “落”字后面的一个 字 是 “在”.我 们 称 这 一 函 数 是 一 个特征函数 ,简 [8-10] 称特征. 根 据 以 上 关 于 特 征 函 数 的 概 念,在 文 本 中 需 要

The Research and Implementation of Maximum Entropy Algorithm in Phonetic Annotation

ZHANG Li-qing,SHOU Yong-xi,MA Zhi-qiang

(College of Information Engineering,Inner Mongolia University of Technology,Huhhot 010080,China)

最大熵方法是目前解决分词算法中一种比较有 效 的 算 法[6].最 大 熵 模 型 是 一 种 广 泛 应 用 于 自 然 语 言处理中的概率估 计 方 法,可 以 综 合 观 察 各 种 相 关 或不相关的概率知 识,对 许 多 问 题 的 处 理 结 果 都 达 到或 者 超 过 了 其 他 方 法 的 最 好 结 果.贾 丽 洁 对 [7] 最 大熵模型在分词中 的 技 术 进 行 了 研 究.构 建 了 一 个 中 文 分 词 系 统 ,使 用 语 料 库 进 行 最 大 熵 模 型 的 训 练 , 并 对 文 本 进 行 词 性 标 注 ,最 终 得 到 文 本 的 分 词 结 果 .

词算法.要对文本分 词 的 地 方 只 关 心 含 有 多 音 字 的 部 分 ,即 一 切 的 分 词 行 为 都 是 围 绕 着 多 音 字 展 开 的 . 其他非多音字不进 行 分 词 处 理.为 了 建 立 一 个 最 大 熵 模 型 ,需 要 有 大 量 的 实 例 文 本 来 训 练 我 们 的 模 型 , 目的是在实例中寻 找 多 音 字 及 其 上 下 文 信 息,建 立 一 个 特 征 集 合 ,然 后 把 不 满 足 约 束 条 件 的 特 征 去 掉 , 计算满足约束条件 下 的 概 率 分 布,最 后 形 成 具 有 最 大熵模型的特征库.

H(p)=- ∑p(x)p(y|x)logp(y|x) x,y

其 中 0≤H (p)≤log|y| 所以 最 大 熵 模 型 可 以 描 述 为:若 在 允 许 的 概 率 分布C 中选择模型,具有最大熵的模型p· ∈C 就认 为是所选模型, p =arg max H(p).

3 算 法 描 述

要利用最大熵原理实现一个适合拼音标注的分

1 引 言

当今使用计算机来实现汉语拼音标注的方法主 要 有 两 类 :(1)直 接 给 汉 字 标 注 拼 音 ;(2)分 词 后 标 注 拼音.直接给汉字标 注 拼 音 很 难 解 决 一 字 多 音 的 问 题 .如 果 没 有 上 下 文 关 系 ,我 们 在 拼 音 标 注 的 时 候 是 无法确定读音的.而 如 果 先 分 词 就 可 以 以 词 为 单 位 解决多音字读音的 问 题 了.但 是 这 样 的 标 注 依 然 有 其 局 限 性 ,因 为 很 多 词 是 以 单 字 为 词 的 ,或 者 很 难 给 予 拼 音 标 注 有 利 的 分 词 结 果 .缺 失 了 上 下 文 关 系 ,就 无法拼音标注了.

2920卷12 年第88月期

微电子学与计算机 MICROELECTRONICS & COMPUTER

Vol.29 No.8 August 2012

最大熵算法在汉语拼音标注中的研究与实现

张丽青,寿永熙,马志强

(内蒙古工业大学 信息工程学院,内蒙古自治区 呼和浩特 010080)

摘 要 :经 过 对 最 大 熵 模 型 的 研 究 ,找 到 一 种 适 合 汉 语 拼 音 标 注 的 最 大 熵 模 型 算 法 .利 用 该 算 法 解 决 了 多 音 字 单 字 成词的情况,从而使得所有包含多音字的词都是两字 或 多 字 词.使 用 该 算 法 随 机 抽 取 “读 者 文 摘”中 的 一 篇 文 章 进 行 标 注 实 验 ,实 验 表 明 拼 音 标 注 正 确 率 达 到 了 96.6% 以 上 . 关 键 词 :最 大 熵 模 型 ;多 音 字 ;拼 音 标 注 ;统 计 ;特 征 ;分 词 中 图 分 类 号 :TP391 文 献 标 识 码 :A 文 章 编 号 :1000-7180(2012)08-0120-03

为 了 解 决 上 述 方 法 标 注 拼 音 时 出 现 的 问 题.本 文提出了一种改进的适合于拼音标注的分词算法.

2 最 大 熵 算 法 原 理

பைடு நூலகம்

新 组 合 成 词 序 列 的 过 程 .在 英 文 中 ,单 词 之 间 是 以 空 格 作 为 自 然 界 符 的 ,而 中 文 只 是 字 、句 和 段 能 通 过 明 显的分界符来简单 划 界,唯 独 词 没 有 一 个 形 式 上 的 分 界 符 .由 于 中 文 在 基 本 文 法 上 有 其 特 殊 性 ,因 此 引 入分词技术.

汉语 分 词 是 文 本 挖 掘 的 基 础,对 于 输 入 一 段 中 文 ,将 其 成 功 进 行 分 词 ,可 以 达 到 电 脑 自 动 识 别 语 句 含义的效果.如 何 让 电 脑 自 动 识 别 语 句 含 义? 其 处 理过程就需要分词算法.

分 词 算 法 本 质 上 可 以 划 分 三 类 :(1)基 于 规 则 的 分 词 方 法 ;(2)基 于 统 计 的 分 词 方 法 ;(3)人 工 智 能 的 分 词 方 法 . [1-5]

Abstract:Through maximum entropy model study,a algorithm for maximum entropy model that is for pinyin marked must be founded.Using the algorithm put an end to the situation that polyphone word is considered to be a word,so that all words with multiple pronunciations are two or more words.Using the algorithm mark the article in Reader's Digest,the results show that pinyin marked rate has reached 96.6percent or more. Key words:maximum entropy model;polyphony;phonetic annotation;statistics;features;segmentation

其中基于统计的分词方法得到了越来越多的应 用 ,最 终 分 词 的 效 果 也 是 很 明 显 的 .它 是 一 种 通 过 统 计计算字与字之间相邻共现频率或概率来反映两个

汉语分词是将一个汉字序列切分成一个个单独 的词.分词就是将连 续 的 字 序 列 按 照 一 定 的 规 范 重

字之间成为词的可 信 度 的 方 法.这 其 实 就 是 分 析 一 个字上下文关系的 方 法.而 且 统 计 来 源 于 现 实 世 界

标注的字w 和在w 周围出现的字都可以作为一个 特征,但 是 这 并 不 是 说 只 考 虑 w 后 面 的 一 个 字,我 们考虑的也可能是 w 前面或后面的一个 字 或 者n 个字.

在实际应用中发现符合这样的特征集合会非常

大 .而 我 们 需 要 的 特 征 只 是 有 用 的 特 征 .所 以 必 须 再 引 入 一 种 约 束 ,使 得 有 用 的 特 征 保 留 下 来 ,无 用 的 特 征去除.约束的相关 概 念 如 下:假 设 有n 个 特 征,则 模 型 属 于 约 束 产 生 的 模 型 集 合 ,即

下面结合一个例子来说明本文如何在汉语拼音 标注中使用和建立 最 大 熵 模 型.例 如 在 汉 语 中 “落” 这个字有四个读音,分别是luò 、là 、lào 、luō.

(1)他 在 有 了 生 活 体 验 后 才 落 笔 画 画.落 字 读 luò.

(2)我忙着出来,把票落在家里了.落字读là . (3)他 因 睡 觉 时 受 寒 或 枕 枕 头 的 姿 势 不 合 适 ,以 致脖子疼痛.落枕了.落字读lào . (4)她 大 大 落 落 走 上 讲 台 .落 字 读luō. 我们看到“落”字 的 发 音 有 四 个,想 要 正 确 标 注 起 来 很 困 难 .我 们 已 知 的 落 的 发 音 只 有 以 上 四 种 .那 么就假设这四种发音存在如下关系. P(S1|w)+P(S2|w)+P(S3|w)+P(S4|w)=1 P(Si|w)(1≤i≤4)表 示 “落”在 汉 语 句 子 中 标 注为Si 的概率.在这种情况下我 们 认 为 每 个 发 音 的 概 率 是 相 同 的 ,也 就 是 均 等 一 致 的 概 率 分 布 .但 在 实 际 过 程 中 ,发 现 这 四 种 发 音 出 现 的 概 率 是 不 相 同 的 , luò的发音最多.也就 是 说 根 据 这 个 现 象,我 们 在 标 注拼音的时候 标 注 为luò 时 正 确 率 会 大 一 些,可 这 样 标 注 的 效 果 并 不 好 ,因 为 其 他 发 音 总 是 会 出 现 的 , 一 旦 出 现 就 会 标 注 出 错 .为 了 能 更 好 地 标 注 ,我 们 继 续对句子观察研究后 发 现,当“落”字 后 面 是 “在”字 的 时 候 发là 字 的 概 率 要 比 其 他 时 候 大 很 多 .这 说 明 该随机过程是受到 上 下 文 信 息 的 影 响 的,出 于 这 种 现象就可以引入一个二元函数来表达这种现象: