分布式流式数据处理框架:功能对比以及性能评估

大数据分布式计算框架比较

大数据分布式计算框架的比较可以从多个方面进行,例如性能、易用性、资源消耗、社区支持等。

以下是一些常见的分布式计算框架以及它们的比较:1. Hadoop:Apache Hadoop是一个分布式计算框架,用于存储和处理大规模数据集。

它具有可靠的数据存储和分布式计算能力,可以处理大量数据,支持并行处理和流处理。

在性能方面,Hadoop表现稳定,处理速度快,而且可以与其他开源项目集成。

易用性方面,Hadoop 具有简单易用的API和命令行工具,社区支持广泛。

然而,资源消耗较大,需要大量的内存和CPU资源。

2. Spark:Apache Spark是一个开源的分布式计算框架,主要用于快速处理大规模数据集。

它具有高效的数据处理能力,支持迭代式算法和流处理,并且可以与Hadoop和其他系统集成。

在性能方面,Spark表现优异,处理速度快,而且具有高效的内存使用和分布式调度能力。

易用性方面,Spark提供了丰富的API和工具,社区支持广泛。

然而,Spark的资源消耗较大,需要大量的内存和CPU资源。

3. Flink:Apache Flink是一个开源的流处理平台,用于实时处理大规模数据流和批量数据。

它具有高效的分布式计算能力,支持实时数据流和批处理的统一处理。

在性能方面,Flink 表现稳定,处理速度快,而且具有高效的资源管理和故障恢复能力。

易用性方面,Flink提供了丰富的API和工具,社区支持广泛。

然而,Flink的资源消耗较大,需要大量的内存和CPU资源。

4. Storm:Apache Storm是一个开源的分布式实时计算系统,用于处理大规模数据流。

它具有可靠的数据传输和分布式计算能力,可以实时处理数据流并输出结果。

在性能方面,Storm 表现稳定,处理速度快,而且具有高效的资源管理和故障恢复能力。

易用性方面,Storm提供了简单的API和命令行工具,社区支持广泛。

然而,Storm的资源消耗较大,需要大量的内存和CPU资源。

大数据处理框架分析

大数据处理框架分析随着互联网技术的迅猛发展,大数据已经成为当今社会中不可忽视的宝贵资源。

然而,面对庞大而复杂的数据集,如何高效地进行处理和分析成为一项巨大的挑战。

为了解决这一问题,大数据处理框架应运而生。

本文将对几种主要的大数据处理框架进行分析和比较,以期对读者们有所启发。

一、HadoopHadoop被认为是大数据处理的开山鼻祖,它是一个开源的分布式存储与计算框架。

它的核心是Hadoop分布式文件系统(HDFS)和MapReduce计算模型。

Hadoop的优势在于其高可靠性、高扩展性和容错性,可以运行在低端廉价硬件上,并能够处理PB级别的数据集。

然而,Hadoop也存在着较高的学习成本和较低的实时性,适合一些批量处理的任务。

二、SparkSpark是一种快速、通用且容错的大数据处理引擎,它提供了比Hadoop更高级别的API,支持多种编程语言,如Java、Scala和Python。

与Hadoop相比,Spark在处理迭代算法和交互式查询等需要频繁的数据访问场景中表现出更好的性能。

此外,Spark还拥有丰富的生态系统和灵活的部署方式,例如可以与Hadoop、Mesos和Kubernetes等平台进行集成。

然而,Spark的资源管理和调度仍然需要进一步改进。

三、FlinkFlink是一种分布式数据处理框架,具备低延迟、高吞吐和高性能的特点。

相比于Hadoop和Spark,Flink在流式数据处理方面更为擅长,支持事件时间语义,并具备状态管理和容错恢复的能力。

Flink还提供了基于流处理和批处理的统一API,使得开发人员可以更加方便地编写复杂的数据处理逻辑。

然而,Flink的生态系统还不及Hadoop和Spark成熟,社区支持相对较少。

四、StormStorm是一种分布式实时数据处理框架,它主要用于流式数据的处理和分析。

Storm具有高可靠性、可扩展性和容错性,能够处理快速变化的实时数据流。

它提供了强大的消息传递和分布式计算模型,并且能够提供低延迟的数据处理结果。

分布式数据库的性能监测与评估

分布式数据库的性能监测与评估随着信息时代的到来,数据的规模和复杂性日益增长,传统的集中式数据库已经无法满足大规模数据处理的需求。

为了提高数据存储和访问的效率,分布式数据库应运而生。

分布式数据库通过在多台服务器上储存和处理数据,可以实现高性能和高可扩展性。

然而,随着服务器数量的增加和数据规模的扩大,分布式数据库的性能监测与评估变得尤为重要。

分布式数据库的性能监测旨在及时监测数据库在各个节点上的性能指标,包括响应时间、并发处理能力、负载均衡以及系统资源利用率等。

这些指标反映了分布式数据库的运行状态以及处理能力,对于保证数据库的稳定性和健壮性至关重要。

为了进行性能监测,可以采取以下几种方法:首先,利用监控工具对分布式数据库进行实时监测。

监控工具可以收集分布式数据库的性能指标数据,并实时展现在监控平台上。

通过对数据进行分析,管理员可以及时了解数据库的运行状态,发现并解决出现的性能瓶颈和故障,确保数据库的高效稳定运行。

其次,使用性能测试工具对分布式数据库进行负载测试。

通过模拟真实业务场景,性能测试工具可以模拟大量用户请求并对分布式数据库的性能进行评估。

通过测试可以获得分布式数据库的各项指标,包括响应时间、吞吐量、并发处理能力等。

管理员可以根据测试结果进行优化,提高分布式数据库的性能和稳定性。

另外,利用日志分析工具对分布式数据库的日志进行分析,了解数据库的运行情况。

日志分析可以发现数据库中的潜在问题,并提供相应的解决方案。

通过对日志的持续分析,可以发现数据库的性能瓶颈和故障,为后续的优化工作提供参考。

在进行分布式数据库的性能评估时,需要采用一系列指标进行评估,从而得出准确的评估结果。

除了上述所提到的指标,还应该考虑数据库的扩展性、容错性、数据一致性以及高可用性等方面。

以下是一些常用的性能评估指标:1. 响应时间:数据库在接收请求后的响应时间。

较低的响应时间代表数据库响应速度快,可以更好地满足用户需求。

2. 吞吐量:数据库在单位时间内能够处理的请求数量。

分布式数据处理 流式计算架构

分布式数据处理流式计算架构

分布式数据处理是现代数据处理的核心,而流式计算架构则是分布式数据处理的重要组成部分。

流式计算架构采用流式数据处理的方式,实现了数据的实时处理和分析,为企业提供了高效、可靠、可扩展的数据处理服务。

流式计算架构主要由以下三个组件构成:流式数据源、流式处理引擎和数据存储。

流式数据源主要包括消息队列、流式数据库、网络流式数据等,用于将数据源中的数据进行实时采集和传输。

流式处理引擎则是流式计算架构的核心组件,它采用流式计算模型,实现了数据的实时处理和分析。

流式处理引擎主要有Storm、Spark Streaming、Flink等。

数据存储则是流式计算架构的重要组成部分,它用于存储处理后的数据结果,一般包括分布式文件系统、分布式数据库等。

采用流式计算架构的企业可以实现实时数据处理、实时监控等功能,提升企业的数据处理效率和应对市场变化的能力。

同时,流式计算架构具有高可靠性、高扩展性等优点,能够满足企业不断增长的数据处理需求。

- 1 -。

大数据处理中的分布式计算框架

大数据处理中的分布式计算框架近年来,随着互联网和智能化技术的不断进步,数据已经成为我们生活工作中必不可少的资源。

在各个领域中,数据的处理和分析是不可避免的问题,因为只有通过对数据加以利用,才能真正地为我们带来价值,实现各种业务的顺利发展。

而在大数据环境下,要高效地处理海量的数据,分布式计算框架已经成为了一种不可缺少的技术。

什么是分布式计算框架?所谓分布式计算框架,指的是一种能够将计算任务分发到多个计算节点上,并通过网络进行协作的计算系统框架。

这种框架之所以能够在各种大规模应用场景中得到广泛应用,主要是因为其能够有效地解决扩展性和性能问题。

在实际应用中,分布式计算框架已经成为了处理大数据的基本工具。

分布式计算框架的优势分布式计算框架有很多优势,比如具有高性能、高可靠性和高可扩展性等特点。

在分布式计算框架中,应用程序可以利用多个计算节点进行并行计算,从而提高计算速度和系统性能。

而且,在节点之间的数据交换和任务分发方面,分布式计算框架也具有灵活性和可靠性,比如可以实现按需重新部署、动态负载均衡和故障转移等功能,从而保证了系统的高可用性和高可靠性。

常见的分布式计算框架目前,常见的分布式计算框架主要包括Hadoop、Spark和Flink 等。

Hadoop是一个开源的分布式计算框架,最初是由Apache基金会开发的。

它主要包括HDFS(Hadoop分布式文件系统)和MapReduce两个部分。

其中,HDFS是一种分布式文件系统,可以存储海量数据;而MapReduce则是一种分布式数据处理编程模型,可以将计算任务分解为若干个小任务,并将其分发到不同的计算节点上进行并行计算。

Spark是一个快速、通用的分布式计算框架,最初是由University of California, Berkeley的AMPLab开发的。

与Hadoop相比,Spark具有更快的处理速度和更灵活的编程模型。

它支持多种编程语言,包括Java、Scala和Python等。

主流流处理框架比较

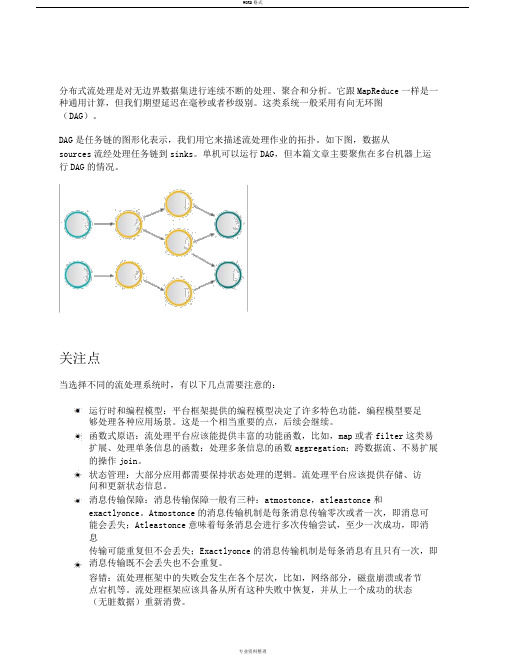

分布式流处理是对无边界数据集进行连续不断的处理、聚合和分析。

它跟MapReduce一样是一种通用计算,但我们期望延迟在毫秒或者秒级别。

这类系统一般采用有向无环图(DAG)。

DAG是任务链的图形化表示,我们用它来描述流处理作业的拓扑。

如下图,数据从sources流经处理任务链到sinks。

单机可以运行DAG,但本篇文章主要聚焦在多台机器上运行DAG的情况。

关注点当选择不同的流处理系统时,有以下几点需要注意的:运行时和编程模型:平台框架提供的编程模型决定了许多特色功能,编程模型要足够处理各种应用场景。

这是一个相当重要的点,后续会继续。

函数式原语:流处理平台应该能提供丰富的功能函数,比如,map或者filter这类易扩展、处理单条信息的函数;处理多条信息的函数aggregation;跨数据流、不易扩展的操作join。

状态管理:大部分应用都需要保持状态处理的逻辑。

流处理平台应该提供存储、访问和更新状态信息。

消息传输保障:消息传输保障一般有三种:atmostonce,atleastonce和exactlyonce。

Atmostonce的消息传输机制是每条消息传输零次或者一次,即消息可能会丢失;Atleastonce意味着每条消息会进行多次传输尝试,至少一次成功,即消息传输可能重复但不会丢失;Exactlyonce的消息传输机制是每条消息有且只有一次,即消息传输既不会丢失也不会重复。

容错:流处理框架中的失败会发生在各个层次,比如,网络部分,磁盘崩溃或者节点宕机等。

流处理框架应该具备从所有这种失败中恢复,并从上一个成功的状态(无脏数据)重新消费。

性能:延迟时间(Latency),吞吐量(Throughput)和扩展性(Scalability)是流处理应用中极其重要的指标。

平台的成熟度和接受度:成熟的流处理框架可以提供潜在的支持,可用的库,甚至开发问答帮助。

选择正确的平台会在这方面提供很大的帮助。

运行时和编程模型运行时和编程模型是一个系统最重要的特质,因为它们定义了表达方式、可能的操作和将来的局限性。

实时数据流处理中的流处理引擎研究与性能比较

实时数据流处理中的流处理引擎研究与性能比较引言随着大数据技术的快速发展,实时数据处理变得越来越重要。

实时数据流处理引擎作为实时数据处理的核心组件,具有快速、可靠和高效的特点。

本文将对常见的流处理引擎进行研究,分析其特性和性能,并进行比较。

一、流处理引擎概述实时数据流处理引擎是处理源源不断的数据流的关键组件。

它能够实时地处理从不同数据源产生的数据,并将处理结果传输到不同的目的地。

流处理引擎通常采用流式计算模型,通过对数据流进行实时处理,快速提取有价值的信息。

二、常见的流处理引擎1. Apache FlinkApache Flink是一个开源的分布式流处理引擎,具有低延迟、高吞吐量和容错性。

它提供了丰富的API和表达能力,可以处理多种类型的数据流。

Flink采用了一种称为“流式表”的抽象概念,可以简化数据处理的逻辑。

此外,Flink还支持事件时间和处理时间的处理,并且具有灵活的窗口操作和状态管理机制。

2. Apache StormApache Storm是另一个流处理引擎,拥有广泛的用户群体。

它采用了分布式、容错的数据流处理模型,并能够以毫秒级的延迟处理数据。

Storm提供了高度可扩展的架构,并且支持多种编程语言。

它还具有可靠消息传递和可靠性保证的机制,确保数据处理的准确性和稳定性。

3. Spark StreamingSpark Streaming是Apache Spark生态系统中的一个模块,用于实时数据处理。

它基于微批处理的概念,将实时数据流划分为一系列小的批处理作业进行处理。

Spark Streaming支持多种数据源和数据处理操作,可以方便地与批处理和机器学习等任务进行集成。

它具有高吞吐量和低延迟的特性,并且能够实现数据的弹性分布和高效处理。

三、性能比较在性能比较方面,我们将从以下几个方面进行评估:1. 延迟:延迟是流处理引擎的关键指标之一。

它代表了处理数据所需的时间。

在这方面,Apache Storm和Spark Streaming表现较好,可以达到毫秒级的延迟。

流式大数据处理的三种框架:Storm,Spark和Samza

流式⼤数据处理的三种框架:Storm,Spark和Samza很多分布式计算系统都能够实时或接近实时地处理⼤数据流。

本⽂将对三种Apache框架分别进⾏简介。

然后尝试⾼速、⾼度概述其异同。

Apache Storm在中,先要设计⼀个⽤于实时计算的图状结构,我们称之为拓扑(topology)。

这个拓扑将会被提交给集群。

由集群中的主控节点(master node)分发代码,将任务分配给⼯作节点(worker node)运⾏。

⼀个拓扑中包含spout和bolt两种⾓⾊,当中spout发送消息,负责将数据流以tuple元组的形式发送出去;⽽bolt则负责转换这些数据流,在bolt中能够完毕计算、过滤等操作。

bolt⾃⾝也能够随机将数据发送给其它bolt。

由spout发射出的tuple是不可变数组,相应着固定的键值对。

Apache Spark是核⼼Spark API的⼀个扩展,它并不会像Storm那样⼀次⼀个地处理数据流。

⽽是在处理前按时间间隔预先将其切分为⼀段⼀段的批处理作业。

Spark针对持续性数据流的抽象称为DStream(DiscretizedStream),⼀个DStream是⼀个微批处理(micro-batching)的RDD(弹性分布式数据集)。

⽽RDD则是⼀种分布式数据集,可以以两种⽅式并⾏运作。

各⾃是随意函数和滑动窗体数据的转换。

Apache Samza处理数据流时。

会分别按次处理每条收到的消息。

Samza的流单位既不是元组。

也不是Dstream。

⽽是⼀条条消息。

在Samza中,数据流被切分开来,每⼀个部分都由⼀组仅仅读消息的有序数列构成,⽽这些消息每条都有⼀个特定的ID(offset)。

该系统还⽀持批处理,即逐次处理同⼀个数据流分区的多条消息。

Samza的运⾏与数据流模块都是可插拔式的。

虽然Samza的特⾊是依赖Hadoop的Yarn(还有⼀种资源调度器)和Apache Kafka。

共同之处以上三种实时计算系统都是开源的分布式系统,具有低延迟、可扩展和容错性诸多长处,它们的共同特⾊在于:同意你在执⾏数据流代码时。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Continuous Streaming

Micro-Batch

Apache Storm*

Twitter Heron*

Aapche Flink*

Apache Gearpump*

Apache Spark Streaming*

Apache Storm Trident*

Source Operator Sink

Storage

Micro-Batch

Checkpoint per Batch

Apache Spark Streaming*

Apache Storm Trident*

Storage

Source Operator

Sink Source

Operator

Sink Source Operator

Sink

id

id

Apache Storm Trident*

Low Latency High Overhead Low Throughput

High Latency Low Overhead High Throughput

6

*

Delivery Guarantee

Apache Storm*

Twitter Heron*

Apache Gearpump*

Apache Spark Streaming*

Apache Storm Trident*

Exactly once

• State is persisted in durable storage

• Checkpoint is linked with state storage per Batch

Aapche Flink*

At least once

• Ackers know about if a record is processed successfully or not. If it failed, replay it.

• There is no state consistency guarantee.

Ack per Record

Apache Storm*

Twitter Heron*

Continuous Streaming

Checkpoint “per Batch”

Aapche Flink*

Apache Gearpump*

Micro-Batch

Checkpoint per Batch

Apache Spark Streaming*

Acker

offset

state str ack

JobManager/ HDFS

offset state str job status

Driver

HDFS

critical This is the

part, as it affects many features

5

Continuous Streaming

Apache Storm*

Twitter Heron* Apache Gearpump*

TopologyBuilder builder = new TopologyBuilder(); builder.setSpout(“input", new RandomSentenceSpout(), 1); builder.setBolt("split", new SplitSentence(), 3).shuffleGrouping("spout"); builder.setBolt("count", new WordCount(), 2).fieldsGrouping("split", new Fields("word"));

• Flink ScalaAPI: ✓ mapWithState

• Gearpump ✓ persistState

Apache Spark Streaming*

Apache Storm Trident*

Yes

• Spark 1.5: ✓ updateStateByKey

• Spark 1.6: ✓ mapWithState

Source Operator

Sink

4

Contr Record

Apache Storm*

Twitter Heron*

Storage

Continuous Streaming

Checkpoint “per Batch”

Aapche Flink*

Apache Gearpump*

Apache Spark Streaming*

Apache Storm Trident* Aapche Flink* Apache

Gearpump*

DataStream<String> text = env.readTextFile(params.get("input")); DataStream<Tuple2<String, Integer>> counts = text.flatMap(new Tokenizer()).keyBy(0).sum(1);

Functional Comparison and Performance Evaluation

Overview

➢ Streaming Core ➢ MISC ➢ Performance Benchmark

Choose your weapon!

2

Execution Model + Fault Tolerance Mechanism

“foo, foo, bar”

“foo”, “foo”, “bar”

{“foo”:2, “bar”: 1}

Spout

Bolt

Bolt

10

*

Declarative

• Higher order function as operators (filter, mapWithState…) • Logical plan optimization

• Trident: ✓ persistentAggregate ✓ State

8

*

API

Compositional

• Highly customizable operator based on basic building blocks • Manual topology definition and optimization

7

*

Native State Operator

Apache Storm*

Twitter Heron*

Yes*

• Storm: ✓ KeyValueState

• Heron: X User Maintain

Aapche Flink*

Apache Gearpump*

Yes

• Flink JavaAPI: ✓ ValueState ✓ ListState ✓ ReduceState