多核软件开发技术第六讲: OpenMP多线程编程及性能优化

OpenMP (6)

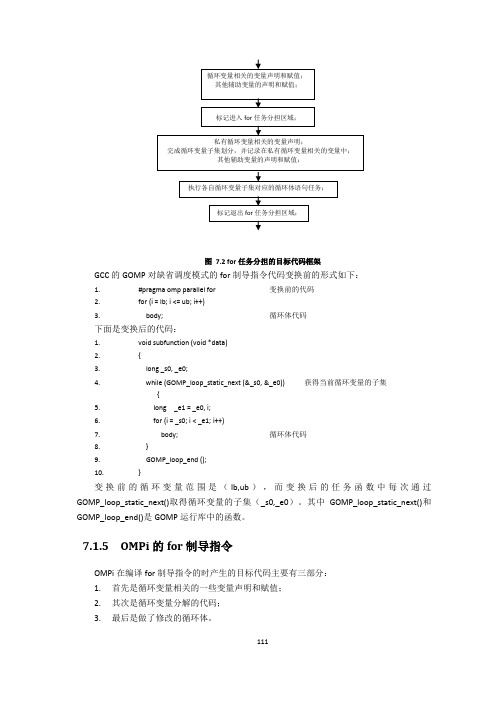

图7.2 for任务分担的目标代码框架GCC的GOMP对缺省调度模式的for制导指令代码变换前的形式如下:1. #pragma omp parallel for 变换前的代码2. for (i = lb; i <= ub; i++)3. body; 循环体代码下面是变换后的代码:1. void subfunction (void *data)2. {3. long _s0, _e0;4. while (GOMP_loop_static_next (&_s0, &_e0)) 获得当前循环变量的子集{5. long _e1 = _e0, i;6. for (i = _s0; i < _e1; i++)7. body; 循环体代码8. }9. GOMP_loop_end ();10. }变换前的循环变量范围是(lb,ub),而变换后的任务函数中每次通过GOMP_loop_static_next()取得循环变量的子集(_s0,_e0)。

其中GOMP_loop_static_next()和GOMP_loop_end()是GOMP运行库中的函数。

7.1.5 OMPi的for制导指令OMPi在编译for制导指令的时产生的目标代码主要有三部分:1. 首先是循环变量相关的一些变量声明和赋值;2. 其次是循环变量分解的代码;3. 最后是做了修改的循环体。

下面先给出OMPi编译器对for制导指令的编译处理输出的目标代码样例,分析OMPi在不同调度机制下的循环变量分解方法,然后再讲述其代码变换和相应的运行库函数功能。

根据OpenMP标准,调度方式有三种,分别是static静态、dynamic动态、guided指导和runtime运行时调度四种。

但是作为编译器,它应该处理五种情况:缺省(不带任何调度子句)、静态、动态/指导和运行时调度。

缺省调度虽然是一种特殊的静态调度,但是由于缺省调度没有指定chunk大小,需要系统给出一个缺省的chunksize,所以它实际上等效于不带chunksize 的静态调度。

在C++中使用openmp进行多线程编程

在C++中使⽤openmp进⾏多线程编程在C++中使⽤openmp进⾏多线程编程⼀、前⾔多线程在实际的编程中的重要性不⾔⽽喻。

对于C++⽽⾔,当我们需要使⽤多线程时,可以使⽤boost::thread库或者⾃从C++ 11开始⽀持的std::thread,也可以使⽤操作系统相关的线程API,如在Linux上,可以使⽤pthread库。

除此之外,还可以使⽤omp来使⽤多线程。

它的好处是跨平台,使⽤简单。

在Linux平台上,如果需要使⽤omp,只需在编译时使⽤"-fopenmp"指令。

在Windows的visual studio开发环境中,开启omp⽀持的步骤为“项⽬属性 -> C/C++ -> 所有选项 -> openmp⽀持 -> 是(/openmp)”。

本⽂我们就介绍omp在C++中的使⽤⽅法。

⼆、c++ openmp⼊门简介openmp是由⼀系列#paragma指令组成,这些指令控制如何多线程的执⾏程序。

另外,即使编译器不⽀持omp,程序也也能够正常运⾏,只是程序不会多线程并⾏运⾏。

以下为使⽤omp的简单的例⼦:int main(){vector<int> vecInt(100);#pragma omp parallel forfor (int i = 0; i < vecInt.size(); ++i){vecInt[i] = i*i;}return 0;}12345678910以上代码会⾃动以多线程的⽅式运⾏for循环中的内容。

如果你删除"#pragma omp parallel for"这⾏,程序依然能够正常运⾏,唯⼀的区别在于程序是在单线程中执⾏。

由于C和C++的标准规定,当编译器遇到⽆法识别的"#pragma"指令时,编译器⾃动忽略这条指令。

所以即使编译器不⽀持omp,也不会影响程序的编译和运⾏。

OpenMP简介

OpenMP提供了schedule子句来实现任务的调度。

schedule子句

schedule(type, size), 参数type是指调度的类型,可以取值为static,dynamic,guided三种值。 参数size表示每次调度的迭代数量,必须是整数。该参数是可选的。 2. 3. 动态调度 启发式调度 dynamic guided 1. 静态调度 static 采用启发式调度方法进行调度,每次分配给线程迭代次数不同,开始比较大, 动态调度依赖于运行时的状态动态确定线程所执行的迭代,也就是线程执行完 static在编译的时候就已经确定了,那些循环由哪些线程执行。 以后逐渐减小。 已经分配的任务后,会去领取还有的任务。由于线程启动和执行完的时间不确 当不使用size 时,将给每个线程分配┌N/t┐个迭代。当使用size时,将每 size 表示每次分配的迭代次数的最小值,由于每次分配的迭代次数会逐渐减少, 定,所以迭代被分配到哪个线程是无法事先知道的。 次给线程分配size次迭代。 少到 size时,将不再减少。如果不知道 size的大小,那么默认size 为1 ,即一直减少 当不使用 size 时,是将迭代逐个地分配到各个线程。当使用 size 时,逐个 到1 。具体采用哪一种启发式算法,需要参考具体的编译器和相关手册的信息。 分配 size 个迭代给各个线程。

用for语句来分摊是由系统自动进行,只要每次循环间没有时间 上的差距,那么分摊是很均匀的,使用section来划分线程是一种手 工划分线程的方式,最终并行性的好坏得依赖于程序员。

OpenMP中的线程任务调度

OpenMP中任务调度主要针对并行的for循环,当循环中每次迭代的计算量 不相等时,如果简单地给各个线程分配相同次数的迭代,则可能会造成各个线 程计算负载的不平衡,影响程序的整体性能。

多核构架下OpenMP多线程应用运行性能的研究_徐磊

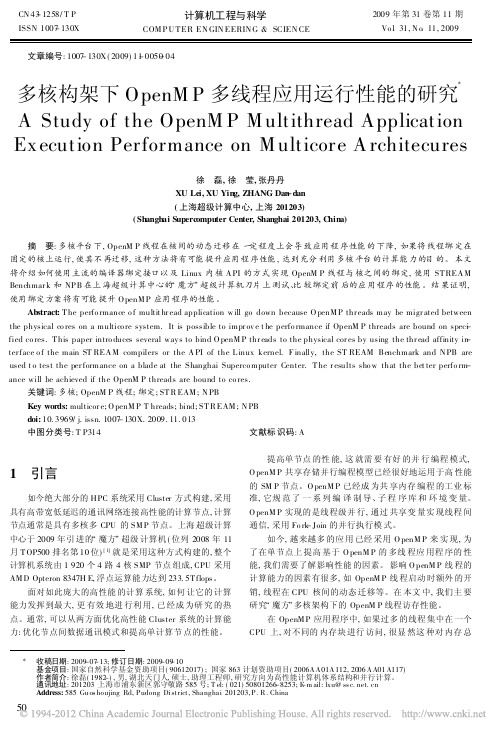

CN43-1258/T P ISSN1007-130X计算机工程与科学COM P U T ER EN GIN EERIN G&SCIEN CE2009年第31卷第11期Vo l131,N o111,2009文章编号:1007-130X(2009)11-0050-04多核构架下OpenM P多线程应用运行性能的研究* A Study of the OpenM P M ultithread Application Ex ecution Performance on M ulticore A rchitecures徐磊,徐莹,张丹丹XU Lei,XU Ying,ZHANG Dan-dan(上海超级计算中心,上海201203)(Shanghai Supercomputer Center,Shanghai201203,C hina)摘要:多核平台下,OpenM P线程在核间的动态迁移在一定程度上会导致应用程序性能的下降,如果将线程绑定在固定的核上运行,使其不再迁移,这种方法将有可能提升应用程序性能,达到充分利用多核平台的计算能力的目的。

本文将介绍如何使用主流的编译器绑定接口以及Linux内核A PI的方式实现OpenM P线程与核之间的绑定,使用ST REA M Benchmar k和NP B在上海超级计算中心的/魔方0超级计算机刀片上测试、比较绑定前后的应用程序的性能。

结果证明,使用绑定方案将有可能提升O penM P应用程序的性能。

Abstract:T he perfo rmance o f multit hr ead application w ill go down because O penM P thr eads may be migr ated between the physical co res on a multico re system.It is possible to impr ov e t he perfo rmance if OpenM P threads are bound on spec-i fied co res.T his paper intro duces several way s to bind O penM P thr eads to the physical cor es by using the thr ead affinity in-ter face o f the main ST REA M compilers or the A PI of the L inux kernel.F inally,the ST REAM Benchmark and N PB are used t o test the per formance on a blade at the Shanghai Superco mputer Center.T he r esults sho w that the bet ter perfo rm-ance will be achieved if the OpenM P threads are bound to co res.关键词:多核;OpenM P线程;绑定;ST R EAM;N PBKey words:multicor e;O penM P T hreads;bind;ST R EAM;N PBdoi:10.3969/j.issn.1007-130X.2009.11.013中图分类号:T P314文献标识码:A1引言如今绝大部分的HPC系统采用Cluster方式构建,采用具有高带宽低延迟的通讯网络连接高性能的计算节点,计算节点通常是具有多核多CPU的SM P节点。

多核程序设计

浙

江 使用Visual Studio 2005编写OpenMP程序(续2)

大

学

英 特

OpenMP程序使用到的环境变量OMP_NUM_THREADS设置为4

尔 三次执行的结果

技

术

中

心

浙 江

OpenMP编程技术——循环并行化

大

学

英 特

循环并行化编译指导语句的格式

技 术

{

中

#pragma omp section

心

printf("section 1 thread=%d\n",omp_get_thread_num());

#pragma omp section

printf("section 2 thread=%d\n",omp_get_thread_num());

英 特

编译指导语句

尔 技 术

在编译器编译程序的时候,会识别特定的注释,而这些特定的注 释就包含着OpenMP程序的一些语义。

中

#pragma omp <directive> [clause[ [,] clause]…]

心

其中directive部分就包含了具体的编译指导语句,包括parallel, for,

#pragma omp section

printf("sectino 3 thread=%d\n",omp_get_thread_num());

}

程序运行结果为:

section 1 thread=0

section 2 thread=1

sectino 3 thread=0

#pragma omp atomic x <binop>=expr

多核程序设计_教案_ch8OpenMP程序设计

#pragma omp <directive> [clause[ [,] clause]…] 其中directive部分就包含了具体的编译制导语句,包括 parallel, for, parallel for, section, sections, single, master, critical, flush, ordered和atomic。

[clause]= Schedule(type [,chunk]) ordered private (list) firstprivate (list) lastprivate (list) shared (list) reduction (operator: list) nowait

copyin(list)

reduction(operator: list) num_threads(integer-expression)

共享任务结构

共享任务结构将它所包含的代码划分给线 程组的各成员来执行

并行for循环

并行sections

串行执行

主线程

主线程

主线程

FORK

F O 主线程 R K J O I N F O R K J O I N

并行域

并行域

Fork-Join执行模型

主线程(Master Thread) 其他线程 通过栅栏同步

同步

同步 同步

Master Thread Parallel Regions

OpenMP应用程序的组成部分

包含编译制导(Compiler Directive)、运行库例 程(Runtime Library)和环境变量(Environment Variables) 通过环境变量的方式灵活控制程序的运行

OpenMP与C++:事半功倍地获得多线程的好处

OpenMP与C++:事半功倍地获得多线程的好处Kang Su Gatlin & Pete Isensee 著赖勇浩译在并行计算领域有一个广为流传的笑话——并行计算是未来之事并且永远都是。

这个小笑话几十年来一直都是对的。

一种类似的观点在计算机架构社区中流传,处理器时钟速度的极限似乎近在眼前,但时钟速度却一直在加快。

多核革命是并行社区的乐观和架构社区的悲观的冲突。

现在主流的CPU厂商开始从追求时钟频率转移到通过多核处理器来增加并行支持。

原因很简单:把多个CPU内核封装在一个芯片里可以让双核单处理器系统就像双处理器系统一样、四核单处理器系统像四处理器系统一样。

这一实用方法让CPU厂商在能够提供更强大的处理器的同时规避了加速频率的诸多障碍。

到此为止这听起来是一个好消息,但事实上如果你的程序没有从多核里获取优势的话,它并不会运行得更快。

这就是OpenMP的用武之地了。

OpenMP可以帮助C++开发者更快地开发出多线程应用程序。

在这短小的篇幅里完整讲述OpenMP这个大而强的API库的相关内容是不可能的。

因此,本文仅作一些初始介绍,通过示例让你能够快速地应用OpenMP的诸多特性编写多线程应用程序。

如果你希望阅读更深入的内容,我们建议你去OpenMP的网站看看。

在Visual C++中使用OpenMPOpenMP标准作为一个用以编写可移植的多线程应用程序的API库,规划于1997年。

它一开始是一个基于Fortran的标准,但很快就支持C和C++了。

当前的版本是OpenMP 2.0(译者注:最新版本已经是2.5版), Visual C++ 2005和XBox360平台都完全支持这一标准。

在我们开始编码之前,你需要知道如何让编译器支持OpenMP。

Visual C++ 2005提供了一个新的/openmp开关来使能编译器支持OpenMP指令。

(你也可以通过项目属性页来使能OpenMP指令。

点击配置属性页,然后[C/C++],然后[语言],选中OpenMP支持。

基于OpenMP技术的多核处理器程序的开发实现

基于OpenMP技术的多核处理器程序的开发实现孙洪迪;高柱【摘要】随着多核处理器的日益普及,应用程序能够充分地利用多核处理器的处理能力成为编程的重点.介绍了OpenMP技术的实现机制、使用方法、编程过程中常遇到的问题以及OpenMP技术的优点和缺陷.【期刊名称】《北京工业职业技术学院学报》【年(卷),期】2010(009)001【总页数】4页(P19-22)【关键词】多核处理器;并行化;OpenMP技术【作者】孙洪迪;高柱【作者单位】北京工业职业技术学院,北京100042;目标软件(北京)有限公司,北京100083【正文语种】中文【中图分类】TP311.110 引言近年来,CPU(中央处理器)在飞速的发展,不断的有主频更高、处理能力更强的新产品问世,而如今主频之路已经走到了拐点。

控制 CPU电压和发热量成为限制提高CPU主频从而提高 CPU计算能力的最大障碍。

面对主频之路走到尽头,最具实际意义的方式是增加 CPU内处理核心的数量。

多核 CPU目前市场上已经比较普及了,如何让我们写的程序最大限度的在多核CPU上得到性能的提升,本文将介绍一种解决方案,即 OpenMP技术。

通过OpenMP技术,只需要在原有程序代码上稍加修改,就可以得到多核 CPU强大的并行处理能力。

1 OpenMP原理OpenMP技术是多家计算机供应商联合开发的、针对共享内存多处理器体系结构的可移植并行编程模型。

它采用分叉 -合并的并行执行模式。

当线程遇到并行构造时,就会创建由其自身及其他一些额外线程组成的线程组。

遇到并行构造的线程成为新组中的主线程,组中的其他线程称为组的从属线程。

所有组成员都执行并行构造内的代码。

如果某个线程完成了其在并行构造内的工作,它就会在并行构造末尾的隐式屏障处等待。

当所有组成员都到达该屏障时,这些线程就可以离开该屏障了。

主线程继续执行并行构造之后的用户代码,而从属线程则等待被召集加入到其他组。

因此,大部分的OpenMP线程都在第一次使用线程的时候将其创建,并在整个程序中重复的被使用。

面向高性能计算的OpenMP并行编程技术研究

面向高性能计算的OpenMP并行编程技术研究OpenMP是一种用于共享内存计算机体系结构中的并行编程接口,它可以大大提高程序的性能和并发处理能力。

在高性能计算领域,OpenMP并行编程技术已成为一个必备的技能。

本文将探讨面向高性能计算的OpenMP并行编程技术研究。

1. OpenMP简介OpenMP全称为Open Multi-Processing,是一种围绕共享内存体系结构的并行编程接口,它提供了一种简单而高效的方法,使程序能够利用具有多个处理器和内存共享的计算机体系结构。

OpenMP的优点在于其易用性和高效性。

由于OpenMP是基于共享内存的并行模型,程序员可以使用简单的指令和指令集,轻松地将程序中的特定部分并行化。

同时,OpenMP的高效性使其成为开发高性能计算应用程序的理想工具。

2. 面向高性能计算的OpenMP并行编程技术在高性能计算领域,OpenMP并行编程技术通常用于提高应用程序的性能和并发处理能力。

以下是面向高性能计算的OpenMP并行编程技术的一些主要方面:2.1 并行循环在OpenMP中,最常见的并行化技术是并行循环。

程序员可以简单地将循环指令指定为OpenMP中的并行循环指令,并利用多个处理器同时执行循环的不同迭代。

这种技术可用于提高程序的性能,特别是在涉及大量迭代的程序中。

2.2 数据分区在高性能计算领域,数据分区是一种将数据分成多个块的技术。

在OpenMP中,程序员可以使用指令集将数据分成多个块,并将每个块分配给不同的处理器。

这种技术被用于处理具有大量数据的应用,以提高处理速度和效率。

2.3 核函数性能优化在OpenMP中,核函数指的是程序中由许多线程并行执行的代码段。

在高性能计算领域,核函数是非常重要的,因为它们占用了整个程序中大量的计算时间。

因此,优化核函数的性能是提高程序性能的一项关键技术。

2.4 内存管理高性能计算应用程序需要使用大量的内存。

在OpenMP中,程序员可以使用指令集来管理一个线程使用的内存。

第4章 OpenMP 多线程编程

隐式栅障 主线程

2019/2/12

3.2 parallel for ——并行执行for

#pragma omp parallel for for(i=0;i<numPixels;i++) { psum[i]= (pRed[i]*0.2+pBlue[i]*0.3+pYellow[i]*0.5);

}

说明: •for结构使用任务分配机制(work-sharing),循环的各次迭代 将被分配到多个线程上。

2019/2/12

5.2 共享化

shared(variable_name,…) float dot_prod(float* a, float* b, int N) { float sum = 0.0; #pragma omp parallel for shared(sum) for (int i=0; i<N; i++) { sum+ = a[i] * b[i]; } return sum; }

2019/2/12

存在的问题

• private(x,y) • 在并行段外的x,y的值不会被传到并行段内。

2019/2/12

练习:

将下面代码用OpenMP语句并行化 for(k=0;k<80;k++) { x=sin(k*2.0)*100+1; if(x>60) x=x%60+1; printf(“x %d =%d\n”,k,x); }

2019/2/12

练习:

将下面代码用OpenMP语句并行化 for(k=0;k<100;k++) { x=sin(k*2.0)*100+1; if(x>60) x=x%60+1; y=array[k]; array[k] = do_work(y); }

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

OpenMP多线程应用程序性能分析

影响性能的主要因素

• • • • • 程序并行部分的比率 OpenMP本身的开销 负载均衡 局部性 线程同步带来的开销

}

循环并行化中的顺序语句(ordered)

• 对于循环并行化中的某些处理需要规定执行 的顺序 • 典型的情况:在一次循环的过程中

– 一大部分的工作是可以并行执行的,而其余的工 作需要等到前面的工作全部完成之后才能够执行

• 在循环并行化的过程中,可以使用ordered子 句使得顺序执行的语句直到前面的循环都执 行完毕之后再执行

规约操作并行化的限制

• 并不是所有的操作都能够使用规约操作 • 所有能够在OpenMP的C/C++语言中出现的规约操作

运算符 + * & | ^ && || 数据类型 整数,浮点 整数,浮点 整数,浮点 整数 整数 整数 整数 整数 默认初始值 0 1 0 所有位都开启,~0 0 0 1 0

数据相关性与并行化操作

使用作用域子句的一些规则

• 作用域子句作用的变量是已经申明的有名变量

• 作用域子句在作用到类或者结构的时候,只能作 用到类或者结构的整体,而不能只作用域类或者 结构的一个部分 • 一个编译指导语句能够包含多个数据作用域子句

• 作用域子句只能作用在出现在编译指导语句起作 用的语句变量部分

规约操作的并行化

原子操作

• 现代体系结构的多处理计算机提供了原子更 新一个单一内存单元的方法 • 通过单一一条指令就能够完成数据的读取与 更新操作 • 通过这种方式就能够完成对单一内存单元的 更新,提供了一种更高效率的互斥锁机制 • #pragma omp atomic x <binop>=expr

运行时库函数的互斥锁支持

循环并行化编译指导语句的子句

• 循环并行化子句可以包含一个或者多个子句来控 制循环并行化的实际执行 • 常见子句有:

– 作用域子句 – 控制线程的调度(schedule )子句 – 动态控制是否并行化(if )子句 – 进行同步的子句(ordered )子句 – 控制变量在串行部分与并行部分传递(copyin )子句

• 循环并行化实际上是并行区域编程的一个特 例 • 并行区域简单的说就是通过循环并行化编译 指导语句使得一段代码能够在多个线程内部 同时执行 • 在C/C++语言中,并行区域编写的格式如下: #pragma omp parallel [clause[clause]…] block

parallel编译指导语句的执行过程

• 当程序遇到parallel编译指导语句的时候,就 会生成相应数目(根据环境变量)的线程组 成一个线程组,并将代码重复地在各个线程 内部执行 • parallel的末尾有一个隐含的同步屏障 (barrier),所有线程完成所需的重复任务 有,在这个同步屏障出会和(join)

工作队列

工作队列的基本工作过程: • 为维持一个工作的队列,线程在并行执行的 时候,不断从这个队列中取出相应的工作完 成,直到队列为空为止

函数名称

void omp_init_lock(omp_lock_t *)

描述

初始化一个互斥锁

void omp_destroy_lock(omp_lock_t*) 结束一个互斥锁的使用并释放内存 void omp_set_lock(omp_lock_t *) 获得一个互斥锁 释放一个互斥锁

void omp_unset_lock(omp_lock_t *)

• 在规约操作中,会反复将一个二元运算符应用在一 个变量和另外一个值上,并把结果保存在原变量中 • 在使用规约操作时,只需在变量前指明规约操作的 类型以及规约的变量 • # pragma omp parallel for private(arx,ary,n) reduction(+:a,b) • for(i=0;i<n;i++){ • a=a+arx[i]; • b=b+ary[i]; • }

明确的同步屏障语句

• 在有些情况下,隐含的同步屏障并不能提供有效的 同步措施 • 程序员可以在需要的地方插入明确的同步屏障语句 #pragma omp barrier • 在并行区域的执行过程中,所有的执行线程都会在 同步屏障语句上进行同步

• #pragma omp parallel

{

initialization(); #pragma omp barrier process();

循环并行化语句的限制

• 并不是所有的循环语句都能够在其前面加上 #pragma omp parallel来实现并行化 • 并行化的语句必须是for循环语句并具有规范格式 • 能够推测出循环的次数 • for (index = start ; index < end ; increment_expr) • 在循环过程中不能使用break语句 • 不能使用goto和return语句从循环中跳出 • 可以使用continue语句

根据线程号分配任务

• 每一个线程在执行的过程中的线程标识号是 不同的 • 可以根据这个线程标识号来分配不同的任务 #pragma omp parallel private(myid) { nthreads=omp_get_num_threads(); myid=omp_get_thread_num(); get_my_work_done(myid,nthreads); }

Master Thread

Parallel Region

Nested Parallel Region

OpenMP应用程序运行时的Fork-Join模型

编译指导语句

• 在编译器编译程序的时候,会识别特定的注 释,而这些注释就包含着OpenMP程序的一 些语义 • 在一个无法识别OpenMP语意的普通编译器 中,这些注释会被当作普通的注释而被忽略 • 在C/C++程序中,OpenMP所有编译指导语句 以#pragma omp开始,后面跟具体功能指令

int omp_test_lock(omp_lock_t *)

试图获得一个互斥锁,并在成功是 返回真(true),失败是返回假 (false)

事件同步机制

• 用来控制代码的执行顺序,使得某一部分代 码必须在其它的代码执行完毕之后才能执行 • OpenMP中的事件同步主要包括:

– 同步屏障(barrier) – 定序区段(ordered sections) – 主线程执行(master)

• 并不是所有的循环都能够使用#pragma omp parallel for来进行并行化 • 必须要保证数据两次循环之间不存在数据相 关性 • 数据相关性又被称为数据竞争(Data Race) • 当两个线程对同一个变量进行操作,并且有 一个操作为写操作的时候,就说明这两个线 程存在数据竞争

并行区域编程

循环嵌套

• 可以将嵌套循环的任意一个循环体进行并行化 • 循环并行化编译指导语句可以加在任意一个循 环之前 • 对应的最近的循环语句被并行化,其它部分保 持不变

控制数据的共享属性

• OpenMP程序在同一个共享内存空间上执行 • 可以任意使用这个共享内存空间上的变量进 行线程间的数据传递 • OpenMP还允许线程保留自己的私有变量不 能让其它线程访问到

– 临界区(critical) – 原子操作(atomic) – 由库函数来提供同步操作

临界区(critical)

• 临界区通过编译指导语句对产生数据竞争的 内存变量进行保护 • 在程序需要访问可能产生竞争的内存数据的 时候,都需要插入相应的临界区代码 • #pragma omp critical [(name)] block • 在执行上述的程序块block之前,必须首先要 获得临界区的控制权

建ቤተ መጻሕፍቲ ባይዱ一个新的项目

配置项目属性

设置环境变量

OpenMP多线程应用程序编程技术

循环并行化

• 循环并行化是使用OpenMP来并行化程序的最重 要的部分 • 在C/C++语言中,循环并行化语句的编译指导语 句格式如下: #pragma omp parallel for [clause[clause…]] for( index = first ; test_expr ; increment_expr) { body of the loop; }

运行时库函数

• OpenMP运行时函数库主要用以设置和获取 执行环境相关的信息 • 它们当中也包含一系列用以同步的API

编译指导语 句

运行时函数库

环境变量

使用VS 2005编写OpenMP程序

• 当前的Visual Studio .Net 2005完全支持 OpenMP 2.0标准 • 通过新的编译器选项 /openmp来支持 OpenMP程序的编译和链接

隐含的同步屏障(barrier)

• 在每一个并行区域都会有一个隐含的同步屏障 • 一个同步屏障要求所有的线程执行到此屏障, 然后才能够继续执行下面的代码 • #pragma omp for,#pragma omp single, #pragma omp sections程序块都包含自己的隐 含的同步屏障 • 为了避免在循环过程中不必要的同步屏障,可 以增加nowait子句到相应的编译指导语句中

– 支持多种编程语言 – 支持多种平台

OpenMP多线程编程基础

• • • • OpenMP的编程模型以线程为基础 通过编译指导语句来显示地指导并行化 OpenMP的执行模型采用Fork-Join的形式 在开始时,只有一个叫做主线程的运行线程 存在 • 在运行过程中,当遇到需要进行并行计算的 时候,派生出(Fork)线程来执行并行任务 • 在并行代码结束执行,派生线程退出或挂起, 控制流程回到单独的主线程中(Join)

线程同步