很好的存储性能测试文档

数据存储的性能测试与评估指标(一)

数据存储的性能测试与评估指标随着信息时代的到来,大量数据需要被存储和处理。

无论是企业数据中心还是个人电脑,高效的数据存储系统对于良好的用户体验至关重要。

因此,对于存储设备的性能测试和评估变得愈发重要。

本文将就数据存储的性能测试和评估指标展开讨论,以帮助读者更好地了解这一领域。

1. 数据存储性能测试的意义数据存储性能测试可以帮助我们衡量存储设备的速度和效率。

在处理大规模数据的场景下,如果存储设备的性能不佳,可能导致数据读取和写入的耗时明显增加,进而影响计算任务的效率。

通过性能测试,我们可以找到瓶颈所在,了解数据存储系统的优缺点,从而进行合理的优化与改进。

2. 常用的性能测试指标(1)带宽:带宽是衡量存储设备传输速度的重要指标。

在数据存储领域,我们通常使用吞吐量作为带宽的度量单位,表示在一定时间内传输的数据量。

较高的带宽意味着存储设备能够更快地处理和传输数据。

(2)响应时间:响应时间指的是从发送请求到获得响应的时间间隔。

低延迟的存储设备能够更快地响应读取和写入请求,提高系统的响应速度。

(3)IOPS:IOPS(Input/Output Operations Per Second)是衡量存储设备输入输出操作能力的指标。

它反映了存储设备单位时间内能够执行的读写操作次数。

对于一些需要随机读取和写入的场景,较高的IOPS值意味着存储设备能够更高效地处理IO请求。

3. 性能测试的方法(1)顺序读写测试:该测试方法通过按顺序读取或写入大块数据,以评估存储设备的顺序读写性能。

测试时需要记录数据传输速度(带宽)和响应时间,以此判断设备的性能优劣。

(2)随机读写测试:该测试方法模拟随机读写场景,通过在随机位置读写小块数据来评估存储设备的随机读写性能。

同样,需记录IOPS和响应时间,并与顺序读写测试的结果进行对比。

(3)混合工作负载测试:该测试方法模拟实际应用场景,通过同时进行读取和写入操作,评估存储设备在负载较重时的性能表现。

EMC存储最佳实践

1.2.1 A. 为顺序或者随机 I/O 的优化 1.2.2 B. I/O 的大小 1.2.3 C. 暂时的模式和峰值的表现(temporal patterns and peak activities)

1.3 3.主机文件系统影响

1.3.1 A.文件系统的缓冲和组合(coalesce) 1.3.2 B.最小化 I/O 的大小:文件系统的 request size 1.3.3 C.最大化的 I/O 大小 1.3.4 D.文件系统的 fragmentation 1.3.5 F.校正对齐问题 1.3.6 G.Linux 的 I/O fragementing

3.1.3 C. 校验或者镜像的保护

3.2 2. 性能计划

3.2.1 A. 单凭经验的的方法途径 3.2.2 B. 解决性能和容量的需要

3.3 3. sizing 例子 4 四. 结论 [编辑] 一.关于性能的探讨 性能调优有多重要呢?在一个 Raid 5 的阵列组中使用 5-9 块硬盘和使用默认的设置,CLARiiON 光纤储系统 能发挥极好的性能----这是 EMC 在性能测试实验室里测试自己的 CLARiiON 系统得出来的。 CLARiiON 存储系统默认的设置是为实际环境中遇到的大部分工作情形所设计的。但是,有一些工作情景还是 需要调优来实现存储系统的最佳配置。 为什么在阵列组里用 5 到 9 块硬盘?这个设置并没有任何神奇的地方,也不是因为这个配置有什么特殊的优 化。然而,Raid 5 使用这个数量的硬盘确实是最有效的利用了校验,同时也能在合理的时间能重建数据。更 小的阵列组会有更高的校验开销,而大的阵列组则会花更长的时间来重建数据。 这份白皮书探讨了在设计优化系统方面的时设计到的许多要素。请注意这里提供的信息是非常有帮助的,尤其 当你充分理解了你的阵列的工作情形。因此,EMC 推荐你使用 Navisphere Analyzer 来分析你的阵列的工作 情形,并且要定期的复习和回顾相关文档的基础知识。同时,请记住在配置一个阵列的时候很少有显而易见的 选择,所以在有疑问的时候最好是按照默认的配置和保守的评估。 [编辑] 1.性能的定义 以下的名词在整个白皮书当中都会用到。如果你对他们不熟悉,请回顾一下 EMC CLARiiON Fibre Channel Storage Fundamentals 带宽 校验 读取 随机 响应时间 要求数据大小 Request size 顺序 条带

性能测试文档课件

非功能需求

分析系统性能指标,如响 应时间、吞吐量、资源利 用率等。

功能需求

梳理性能测试需验证的系 统功能点,如接口调用、 数据处理等。

测试目标设定

性能指标

根据需求分析结果,制定具体的性能 指标,如响应时间不超过2秒等。

测试场景

设计覆盖不同业务场景、功能点和性 能指标的测试场景,确保测试全面有

效。

测试数据

08

总结与展望

项目成果总结

测试目标达成

成功完成了各项性能测试任务,验证了系统的 性能表现和瓶颈。

数据准确性保障

通过多轮测试与校验,确保了测试数据的准确 性和可靠性。

问题发现与解决

在测试过程中发现并解决了若干性能问题,提升了系统稳定性和响应速度。

经验教训分享

测试环境准备

提前搭建和维护好测试环境,确保与真实生产环境一致,有助于 提升测试效果。

改进建议提出与跟踪

持续改进意识

强化团队成员对系统性能的持续关注,培养发现问题、解决问题的 主动性,形成持续改进的文化氛围。

定期审查与分享

定期组织性能审查会议,分享最佳实践和技术动态,对系统性能进 行持续优化。

工具与技术更新

关注性能测试与优化领域的新工具、新技术,及时引入适合团队的工 具和方法,提高性能测试和优化的效率。

拓展测试范围

在后续项目中,进一步拓展性能测试的范围 ,覆盖更多业务场景和用户需求。

测试需求,设计不同的测试场景,包括正 常负载、峰值负载、异常处理等。

脚本编写与调试

按照测试场景设计,编写性能测试脚本,并 进行调试和优化,确保脚本能够准确模拟实 际业务操作。

测试数据准备与导入

数据来源

确定测试数据的来源,可以是实际生产环境的备份数 据、脱敏数据或根据业务规则生成的模拟数据。

Isilon集群存储测试报告

名称 网络交换 HP 计算节点 HPI/O 节点 ISILON

说明

配置

单

位

NetGear24 口非全线速

千兆以太网交换机

NetGear

个

HP 刀片节点

Intel(R)Xeon(R)CPUE5410 2.33GHz; 台 8GB; 6144KB cache;

HP 刀片节点

Intel(R)Xeon(R)CPUE5405 2.00GHz; 台 4GB; 6144KB cache;

305169.44 350248.66 370019.66 393231.02 411283.97 110430.42 94968.20 92596.23 142035.95 83708.29

307233.31 354984.41 366508.90 391975.35 418329.04 110425.61 95787.36 90325.20 142847.89 81262.63

ISILON

Isilon 集群存储

中海油湛江分公司测试报告

yangfeng 2008‐5‐28

[Isilon 与中海油湛江分公司共享文档]

1.目的

Isilon 集群存储中海油湛江公司测试报告

2008 年 5 月 26 日至 2008 年 5 月 28 日,在佳君鸿运公司的安排下,Isilon 公司工程师携 带 10 台 Isilon 集群存储 IQ6000 节点进行了存储性能的测试。 本次测试分别在特普公司和西部公司分别搭建的两套测试环境,对存储进行了通用的 IOZONE 测试,并且对客户进行了 Isilon 集群存储的技术交流,同时对可用的其它存储进 行了性能对比。 本测试报告针对两个环境的测试数据,进行了分析,希望对湛江中海油设备选型提供参考。

存储测试方案

存储测试方案1. 引言存储是计算机系统中非常重要的组成部分。

在现代计算机系统中,存储扮演着保存和检索数据的重要角色。

因此,对存储进行适当的测试是确保存储系统的稳定性和可靠性的关键。

本文档将介绍存储测试的目的、测试策略和测试方法,以帮助开发团队制定有效的存储测试方案。

2. 目的存储测试的主要目的是评估存储系统的功能和性能。

通过存储测试,可以发现和解决存储系统中的潜在问题,确保其在实际使用中的稳定性和可靠性。

存储测试的具体目标包括:•确保存储系统能够正确地读取和写入数据。

•评估存储系统的数据完整性和一致性。

•测试存储系统的容量和性能。

•提高存储系统的性能和扩展性。

•发现和解决存储系统中的性能瓶颈。

存储测试策略是指测试的范围、测试目标和测试方法的定义。

以下是一些常见的存储测试策略:3.1 黑盒测试黑盒测试是一种基于存储系统的输入和输出进行测试的方法。

在黑盒测试中,测试人员不考虑存储系统的内部结构和实现细节,只关注其对外部输入的响应。

通过输入不同类型和大小的数据,测试人员可以评估存储系统的功能和性能。

3.2 白盒测试白盒测试是一种基于存储系统的内部结构和实现细节进行测试的方法。

在白盒测试中,测试人员可以访问存储系统的源代码,并对其进行评估。

通过分析代码和设计,测试人员可以发现和解决存储系统中的潜在问题。

3.3 性能测试性能测试是一种评估存储系统性能的方法。

通过模拟实际的负载和并发请求,测试人员可以评估存储系统的响应时间、吞吐量和并发能力。

性能测试可以帮助开发团队调整存储系统的配置和优化算法,以提高其性能和扩展性。

3.4 容量测试容量测试是一种评估存储系统容量和可扩展性的方法。

通过向存储系统中添加大量数据,测试人员可以评估其所能处理的最大数据量。

容量测试可以帮助开发团队评估存储系统的扩展性,并在需要时采取相应的措施。

存储测试的方法取决于具体的存储系统和测试策略。

以下是一些常见的存储测试方法:4.1 功能测试功能测试是一种评估存储系统功能的方法。

存储系统测试方案

存储系统测试方案简介存储系统是计算机系统中负责数据存储和检索的一部分,它能够提供高效且可靠的数据存储和访问服务。

针对存储系统的测试是确保系统性能和稳定性的关键步骤。

本文档将介绍存储系统测试的方案和流程。

测试目标存储系统测试的目标是发现系统在压力和异常情况下的性能、可靠性和稳定性问题,以及确保系统在正常工作负载下的良好性能和可用性。

以下是存储系统测试的主要目标:1.测试各种负载情况下的系统性能,包括读取和写入速度、响应时间等指标。

2.测试系统的可靠性,例如测试系统在断电、网络故障等异常情况下的行为。

3.测试系统的稳定性,例如测试系统在长时间高负载下的表现和资源利用率。

测试环境为了有效进行存储系统的测试,需要在合适的环境下模拟真实的使用场景。

以下是测试环境的要求:1.硬件环境:需要有足够的计算和存储资源来模拟真实的使用场景。

硬件环境可以包括服务器、存储设备和网络设备等。

2.软件环境:需要在测试环境中部署存储系统的相关软件,包括操作系统、数据库和存储管理软件等。

3.工具与框架:需要选择合适的测试工具和框架,例如性能测试工具JMeter、自动化测试框架Selenium等。

测试流程存储系统的测试流程应该包括以下步骤:1.确定测试目标:根据实际需求和预期目标,明确测试的具体目标和范围。

2.设计测试用例:根据测试目标,设计一系列符合实际使用场景的测试用例,覆盖各种读写操作、负载和异常情况。

3.准备测试环境:构建合适的测试环境,包括部署所需的硬件和软件,并配置相应的网络和安全设置。

4.执行测试用例:按照设计好的测试用例,进行测试执行,并记录测试结果和相关指标。

5.分析测试结果:对测试结果进行统计和分析,找出系统中存在的性能瓶颈和问题点。

6.优化和改进:根据测试结果和分析,进行系统的优化和改进,以提高系统的性能和可靠性。

7.重复测试:根据优化和改进后的系统,重新执行测试用例,以验证系统性能和可靠性的改进效果。

测试指标存储系统的测试指标可以根据实际需求和测试目标进行选择。

设备性能测试方案三篇

设备性能测试方案三篇引言本文档旨在提供三篇设备性能测试方案,分别针对不同的设备性能指标进行测试,以评估设备的性能表现。

方案一:CPU性能测试测试目标测试设备的CPU性能,包括计算速度、多任务处理和功耗等指标。

测试方法1. 使用专业的CPU性能测试软件,记录设备在计算速度方面的成绩,例如PCMark和Geekbench等。

2. 运行多个具有不同计算复杂度的任务,并记录设备在多任务处理方面的表现。

3. 通过监测设备的电池消耗情况,评估设备在处理任务时的功耗水平。

数据分析根据测试结果,比较不同设备的CPU性能,包括计算速度、多任务处理和功耗等方面的表现,从而评估设备的整体性能。

方案二:存储性能测试测试目标测试设备的存储性能,包括读写速度、数据传输稳定性和存储容量等指标。

测试方法1. 使用专业的存储性能测试软件,记录设备的读写速度和数据传输稳定性。

2. 对设备进行存储容量测试,以确定设备可以容纳的数据量。

数据分析根据测试结果,比较不同设备的存储性能,包括读写速度、数据传输稳定性和存储容量等方面的表现,从而评估设备的整体性能。

方案三:网络性能测试测试目标测试设备的网络性能,包括网络连接速度、数据传输速度和稳定性等指标。

测试方法1. 使用专业的网络性能测试工具,测试设备的网络连接速度,例如Speedtest和PingPlotter等。

3. 对设备进行长时间的网络稳定性测试,以评估设备在长时间使用时的网络表现。

数据分析根据测试结果,比较不同设备的网络性能,包括网络连接速度、数据传输速度和稳定性等方面的表现,从而评估设备的整体性能。

结论通过对设备进行CPU性能测试、存储性能测试和网络性能测试,可以综合评估设备的性能表现,并为用户提供参考,以选择合适的设备。

测试结果可以作为设备生产厂商改进产品性能和用户选择设备的参考依据。

以上为设备性能测试方案三篇。

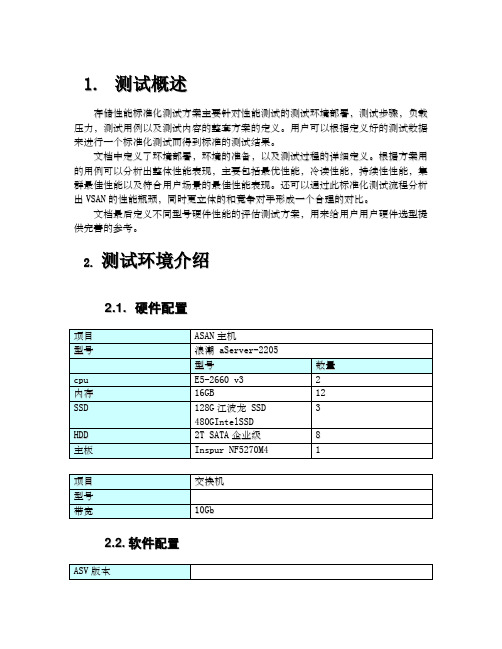

存储性能标准化测试方案

1.测试概述存储性能标准化测试方案主要针对性能测试的测试环境部署,测试步骤,负载压力,测试用例以及测试内容的整套方案的定义。

用户可以根据定义好的测试数据来进行一个标准化测试而得到标准的测试结果。

文档中定义了环境部署,环境的准备,以及测试过程的详细定义。

根据方案用的用例可以分析出整体性能表现,主要包括最优性能,冷读性能,持续性性能,集群最佳性能以及符合用户场景的最佳性能表现。

还可以通过此标准化测试流程分析出V S A N的性能瓶颈,同时更立体的和竞争对手形成一个合理的对比。

文档最后定义不同型号硬件性能的评估测试方案,用来给用户用户硬件选型提供完善的参考。

2.测试环境介绍2.1.硬件配置2.2.软件配置V S版本测试工具I o m e t e r,f i o,s m o n 虚拟机操作系统c e n t o s性能优化工具是2.3.环境部署拓扑图3.测试内容和用例3.1.测试内容概述整个标准化测试主要包括6个测试阶段,分别是硬件基础性能和底层存储基础性能测试阶段,冷读测试阶段、基本最优性能测试阶段,持续测试阶段,快照和故障场景性能测试和不同硬件评估测试。

以下为各个测试阶段的概述:1)硬件和底层V S存储基础性能测试阶段用于评估硬件的性能以及V S A N不经过K V M时的存储性能。

用于纵向比较性能瓶颈有重要意义。

2)冷读测试阶段主要是测试在读缓存不命中,第一次开机读取数据的性能表现。

主要是基于竞争对手与我们的存储设计架构的差异优势来设计的测试阶段。

可以更好的评估我们方案改进后的冷读性能特性,便于和竞争对手进行比较。

3)基本最优性能指标测试主要是测试在标准化配置下我们的最优性能。

以及各个块大小的最优性能表现。

同时可以与第一阶段的性能测试形成纵向对比。

4)持续性能测试测试A S A N在长时间不同应用场景下的性能表现。

主要的场景包括O L T P,O L A P,数据导入等性能场景的模拟测试。

可以更准确的评估出用户场景下的性能表现。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

EMC存储性能测试

存储性能好坏无非看三个参数,存储性能直接影响主机的性能好坏与否

Bandwidth (MB/s)

•Important for backups, DSS operations, rich media access

Throughput (IOPS)

•Important for filesystem access, RDBMS; small requests (2-16KB)

Response time

•A key measurement of quality of ser vice; an array can offer a high max IOPS figure, but deliver consistently slow response time

Bandwidth (MB/s)

测试linux下的性能一般就用dd了,taobao就这么做。

如果dd的性能都不行,其他就免谈了。

上海linktone测试时候用了vmstat看包的数量,然后用bonnie++测。

最快的dd速度有160MB。

(CX700+SUN 10K)

此类测试常在流媒体点播,或者大块文件备份。

Raid种类有讲究。

Throughput (IOPS)

如果是小块随机,比较麻烦,10K的硬盘120 IOPS,15K的就180 IOPS。

可以估算个大概。

以前一直疑惑,为什么flarecode升级时候,前面5个盘必须小于100 IOPS,原来留了20 IOPS给升级的用了。

注意,host IO必须转换到storage IO,两者有区别,读写比例和Raid种类有讲究。

Response time

结果可以从Clariion的analyzer里面读到存储的响应时间。

超过200 IOPS也是有可能的,因为FC硬盘是支持queuing,老的ATA不支持。

但是response time会超长。

cache里面响应大约是0.5ms,一般FC磁盘I/O是6-8ms,但看到taobao的CX700实测是

4ms,10K盘。

另外,EMC有cache的优化方案,比如prefetch, coalescing, read/write cache merge.

其他:

EMC有专门的IO触发机制,装在异构平台主机端。

Open Systems I/O Driver and Measurement Tool

[url]ftp:///pub/elab/iorate/[/url] 有机会看看。

看看EMC的best practise R19,是性能调整的最好文章。

要熟练背诵。

H519_6_CLARiiON_Best_Prac_Fibre_ldv.pdf

MetaLUN今年出了新的更新,值得关注。

H1024.1_clariion_metaluns_cncpt_wp_ldv.pdf

区分ATA和FC硬盘差异,看下面文章

Understanding the CLARiiON™ Advanced Technol ogy Attachment (ATA) Drive Implementation C-SPEED Report, v. 1.2

H2207_A_look_CLARiiON_W_CXseries_ldv.pdf

EMC官方认可的测试工具

H1714.1_consid_bnchmrk_mdrange_wp_ldv.pdf

单个硬盘的性能,值得记住其中的参数,出去跟客户吹牛时候派用场。

H519_6_CLARiiON_Best_Prac_Fibre_ldv.pdf

EMC有个CSPEED组织,很牛叉的测试组织。

那些见不得人,但非常真实的测试报告就是他们干的。

Extensive test data available to the CSPEED (CLARiiON SPEED) engineers

-----------------------------------------

EMC的性能调整的确是把存储相关的技术用到极致,

从主机硬件到存储硬件,从主机应用软件,OS ,firmware,到EMC的flarecode,涵盖所有的知识点。

===================================================

经验:

Raid5 建议使用5个 or 9个 disks 理由:0s(win/unix) 一般是64K/io

256K:用4个disk操作,则64K*4=256K, Raid5一次完成

384K:256一个io,剩余的一个io

-----------------------------------------

Check ESM to follow the proper firmware, driver and Powerpath version for the installation Check Pamail6 for the HBA path

Change LUN22-29 “Auto Assign” to “Disable”

Monitor the SP logs for “soft media warning”

Distribute the large IO to the different RG. 15K FC HDD has better throughput. (IOPS) Change the Raid type according to the different application characterized. Raid 1/0 is best for random write. Raid5 has high bandwidth.

Use “diskpar” for the sector alignment

与其他组件相比,更多时候会涉及硬盘优化,因此首先讨论该主题。

通常,以下最佳做法适用于硬盘优化:·容量规划是存储规划的重要方面。

为了优化 Exchange 服务器性能,应该购买很多快速硬盘(更高的磁盘访问速度)。

·对于事务日志卷(顺序磁盘访问),请使用转速更快的磁盘。

对于数据库驱动器(随机磁盘访问),请使用寻道更快的磁盘。

·使用能够检测即将出现的故障以及可以抢救或重定位受影响数据的磁盘系统。

大多数磁盘驱动器都具备此功能。

·根据所使用的具体硬件 RAID 配置,对 I/O 限制进行规划。

通常,对于每个写入请求,硬件 RAID 生成以下 I/O:

· RAID-0 = 1 次写入

· RAID-1 或 RAID-10 = 2 次写入

· RAID-5 = 4 次写入

使用以下公式计算 I/O 限制:

(IOPS/邮箱×读取比率) + ((IOPS/邮箱×写入比率) ×RAID 限制)

例如,如果每个邮箱有 1,500 IOPS(使用本指南前面介绍的步骤计算得到),读取比率是 66%/33%(每三个请求中有两个是读取请求,另一个是写入请求),并且使用 RAID-1 或 RAID-10 阵列,则实际硬件IOPS 是:

(1,500 × 2/3) + ((1,500 × 1/3) × 2) = 2,000

对 RAID-5 阵列应用相同情形,实际硬件 IOPS 是:

(1,500 × 2/3) + ((1,500 × 1/3) × 4) = 3,000

如果所有驱动器都是 10,000 RPM,则至少需要 30 个驱动器才能在 RAID-5 配置中获得必需的 IOPS。

如果实现 RAID-1 或 RAID-10,则需要至少 20 个驱动器(在 RAID-1 或 RAID-10 解决方案中,磁盘数不能为奇数)。

·大多数情况下,应使用 DiskPar 来使硬盘磁道与物理磁盘分区对齐。

由于 Windows 2000 和 Windows Server 2003 将最大隐藏扇区数限制为 63,因此,对于每个磁道具有 63 个以上扇区的磁盘,其默认启动扇区是第 64 个扇区。

Windows 2000 和 Windows Server 2003 所创建的所有分区都从第 64 个扇区开始,这使得写入磁盘的每八个数据块中有一个数据块会跨越两个磁道。

要使用 DiskPar 来对齐硬盘,请执行以下步骤。

a. 备份硬盘上的所有数据,然后删除所有分区。

b. 在命令提示符处,键入 diskpar -s <驱动器号>,然后确认您要对磁盘分区。

c. 键入该硬盘的新起始偏移量和分区大小。

由于 Exchange 以 4 KB 数据块为单位写入数据,因此所键入的起始偏移量的值必须是 4 KB 的倍数。

d. DiskPar 对齐磁盘之后,在命令提示符处,键入 diskpar -i <驱动器号>,以验证磁盘已正确对齐。

e. 使用磁盘管理器对硬盘进行分区。

将分区配置为使用 NTFS,并使用 4096 (4 KB) 作为分配单位大小。

f. 使用 DiskPar 提高磁盘性能并格式化磁盘分区。

使用 DiskPar 之前,务必备份想要保留的所有数据。

DiskPar 是 Windows 2000 资源工具包的一部分。

有关使用 Diskpar.exe 的详细信息,请参阅 Microsoft Windows 2000 资源工具包的帮助。