第2章 深度学习的数学基础

新版深度学习.pdf

第一章深度学习概念1.1 机器学习的定义(machine Learning ML ):机器学习是涉及多门复杂理论的学科,包括了概率统计、数值分析、算法复杂理论等多门学科。

是专门研究计算机怎样模拟人类行为,以人类行为研究来赋予机器独自拥有自主学习和思考的技术方法,使机器拥有自己组织已有的知识架构,使自身性能不断完善的技术理论。

1.2 深度学习:源于人工神经网络的研究,含多隐层的多层感知就是一种深度学习的结构,深度学习通过组合底层特征形成的更加抽象的高层属性类别或特征,一发现数据分布式特征表示。

1.4 深度学习、机器学习、AI 之间的关系如右图示1-1所示。

1.5 一个事实和一个道理:事实:这几年深度学习的发展并不完全得益于机器学习理论研究的新突破,主要是因为支撑理论的外部条件有了很大的提升。

道理:机器学习理论十年没有本质的变化,从某种意义上来说是一种好事,说明这个思维框架经得住时间的考验,也就是说他有被学习的价值。

1.6 描述意见事物可以多角度,是一对多的映射过程,机器学习得懂如何去观察一个对机器深度学习AI图示1-1象的特征,懂得不同角度对同一事物做不同的描述(看事物的方法千千万,就看你是从那个角度去看待这个问题)。

1.7 被计算机使用的描述信息,这个信息在机器学习中一般被称作特征(Feature)。

1.8 特征描述举例中文词语的编码(One Hot编码)One Hot Endcoding:假设有N个词语待编码方法:1、建立N维空间;2、确定词语之间的距离;(有排列组合相关知识知道,N个不同的词语间有N N种组合方式,即可以映射到N维空间中去,在N维空间中的每个单元存放1和0两种状态,和真假对应)1.9 同一件事物可以从不同的细致程度被描述。

1.10 机器模型雏形:获得特征模型期望结果【注:其中模型相当于数学中的函数;】绝大多数的机器学习都遵循这个模式,拥有输入和输出,剩下的工作就是确定这个中间的映射,也就是这个模型。

深度学习基础总结(附完整思维导图)

深度学习基础总结(附完整思维导图)来源:Python与算法社区本文为读者详细总结了深度学习的基础知识。

1 线型回归预测气温、预测销售额、预测商品价格等模型:权重,偏差模型训练:feed 数据学习模型参数值,使得误差尽可能小训练集、测试集、验证集、样本、标签、特征损失函数:回归常用平方误差函数;优化算法:小批量随机梯度下降(每次选一小批样本训练参数),每批样本大小叫做 batch size学习率:正数超参数:不是通过训练学出的,如学习率,批量大小网络输出层只有一个神经元节点全连接层:输出层中的神经元和输入层中各个输入完全连接基本要素:模型、训练数据、损失函数和优化算法2 softmax 回归图像分类、垃圾邮件识别、交易诈骗识别、恶意软件识别等softmax运算符将输出值变换成值为正,且和为1的概率分布交叉熵损失函数:更适合衡量两个概率分布差异softmax 回归是一个单层神经网络,输出个数等于类别个数3 多层神经网络激活函数:一种非线性函数ReLU函数:只保留正数元素,负数元素清零sigmoid函数:将元素值变换到0到1tanh(双曲正切):元素值变换到-1到14 模型选择模型在训练集上更准确时,不代表在测试集上就一定准确训练误差:训练数据集上表现出的误差;泛化误差:模型在测试集上表现的误差期望机器学习需要关注降低泛化误差模型选择:评估若干候选模型的表现并从中选择模型候选模型可以是有着不同超参数的同类模型验证集:预留训练和测试集之外的数据;折交叉验证:训练集分成份,共次轮询训练集欠拟合:模型无法得到较低的训练误差过拟合:模型的训练误差远小于测试集上的误差模型复杂度:低,容易欠拟合;高,容易过拟合数据集大小:训练样本少,尤其少于学习参数数时,容易过拟合;层数多时尽量数据大些5 必知技巧过拟合解决措施之一:权重衰减,常用L2正则L2惩罚系数越大,惩罚项在损失函数中比重就越大丢弃法(dropout):一定概率丢弃神经元正向传播:沿着输入层到输出层的顺序,依次计算并存储模型的中间变量反向传播:从输出层到输入层参数调整过程训练深度学习模型时,正向传播和反向传播间相互依赖数值稳定性的问题:衰减和爆炸层数较多时容易暴露,如每层都是一个神经元的30层网络,如果权重参数为0.2,会出现衰减;如果权重参数为2,会出现爆炸权重参数初始化方法:正态分布的随机初始化;Xavier 随机初始化。

Python深度学习02:神经网络的数学基础

Python深度学习02:神经网络的数学基础2.1 初始神经网络MNIST数据集:手写数字的灰度图像(28 像素×28 像素),包含 60 000 张训练图像和 10 000 张测试图像。

类:分类问题中的某个类别叫作类(class)样本:数据点叫作样本(sample)标签:某个样本对应的类叫作标签(label)损失函数(loss function):网络如何衡量在训练数据上的性能,即网络如何朝着正确的方向前进。

优化器(optimizer):基于训练数据和损失函数来更新网络的机制。

在训练和测试过程中需要监控的指标(metric):本例只关心精度,即正确分类的图像所占的比例使用 Keras 库,加载数据集,代码如下:1 from keras.datasets import mnist2 from keras import models3 from keras import layers4 from keras.utils import to_categorical56 # 加载 Keras 中的 MNIST 数据集7 (train_images, train_labels), (test_images, test_labels) = mnist.load_data()89 #标签10 train_labels = to_categorical(train_labels)11 test_labels = to_categorical(test_labels)1213 #准备图像数据14 train_images = train_images.reshape((60000, 28 * 28))15 train_images = train_images.astype('float32') / 25516 test_images = test_images.reshape((10000, 28 * 28))17 test_images = test_images.astype('float32') / 2551819 #构建网络模型20 network = models.Sequential()21 network.add(layers.Dense(512, activation='relu', input_shape=(28 * 28,)))22 network.add(layers.Dense(10, activation='softmax'))2324 #编译的三个参数25 pile(optimizer='rmsprop',26 loss='categorical_crossentropy',27 metrics=['accuracy'])2829 #拟合模型30 network.fit(train_images, train_labels, epochs=5, batch_size=128)3132 #查看测试集性能33 test_loss, test_acc = network.evaluate(test_images, test_labels)2.2 神经网络的数据表示张量:当前所有机器学习系统都使用张量作为基本数据结构,张量的维度(dimension)通常叫作轴(axis)。

深度学习的数学基础

深度学习的数学基础微积分o无穷小在17世纪下半叶,数学史上出现了无穷小的概念,而后发展处极限的概念o极限o数列的极限o函数的极限导数微分积分o不定积分也称为原函数或反导数o定积分o定积分中值定理牛顿-莱布尼茨公式偏导数概率统计样本空间定义:随机试验E 的所有结果构成的集合称为E 的样本空间,记为S={e} 称S 中的元素e 为样本点,一个元素的单点集称为基本事件.概率条件概率/后验概率P(A|B)边缘概率/先验概率A的边缘概率表示为P(A),B的边缘概率表示为P(B)联合概率全概率公式贝叶斯公式随机变量离散型随机变量对离散随机变量用求和得全概率定义(0-1)分布/两点分布/伯努利分布二项分布泊松分布(Poisson分布)连续型随机变量对连续随机变量用积分得全概率概率分布函数F(x)概率密度函数f(x)均匀分布X~U(a,b)指数分布正态分布/高斯分布是研究误差分布的一个理论期望离散型随机变量的期望连续型随机变量的期望方差(Variance)一个随机变量的方差(Variance )描述的是它的离散程度,也就是该变量离其期望值的距离标准差(Standard Deviation)方差的算术平方根称为该随机变量的标准差。

样本标准差协方差相关系数(Correlation coefficient)协方差矩阵主成分分析(PCA)在统计学中被称为主成分分析(principal components analysis ,简称PCA) ,在图像处理中称为Karhunen-Loève 变换(KL- 变换) 。

大数定律大数定律负责给出估计——期望中心极限定理中心极限定理负责给出大数定律的估计的误差——标准差乘以标准正态分布大量相互独立的随机变量,其均值(或者和)的分布以正态分布为极限(意思就是当满足某些条件的时候,比如Sample Size 比较大,采样次数区域无穷大的时候,就越接近正态分布)。

而这个定理amazing 的地方在于,无论是什么分布的随机变量,都满足这个定理。

深度学习入门数学基础之线性代数篇

深度学习入门数学基础之线性代数篇线性代数的概念对理解机器学习背后的理论至关重要,特别是对于深度学习。

它让你更直观地了解算法如何在真正的工作环境下工作,从而使你能够做出更好的决策。

所以如果你真的想成为这个领域的专业人士,你就不会掌握它的一些概念。

本文将介绍线性代数最重要的概念,这些概念用于机器学习。

线性代数是一种连续的数学形式,它在整个科学和工程中得到应用,因为它允许你对自然现象建模并有效计算它们。

因为它是一种连续的而不是离散的数学形式,很多计算机科学家并没有太多的经验。

线性代数也是数学几乎所有领域的核心,如几何和功能分析。

它的概念是理解机器学习背后的理论的一个重要先决条件,尤其是在你使用深度学习算法的情况下。

在开始使用机器学习之前,你不需要了解线性代数,但是在某些时候,希望更好地理解不同的机器学习算法如何真正在底层工作。

这将有助于你在机器学习系统的开发过程中做出更好的决策。

所以如果你真的想成为这个领域的专业人士,那么你不会掌握对机器学习很重要的零件线性代数。

在线性代数中,数据由线性方程表示,以矩阵和向量的形式表示。

因此,你主要处理的是矩阵和向量,而不是标量(我们将在下一节介绍这些术语)。

如果你的建议中有像Numpy这样的正确库,则只需几行代码即可轻松计算复杂的矩阵乘法。

这篇文章会忽略对机器学习不重要的线性代数的概念。

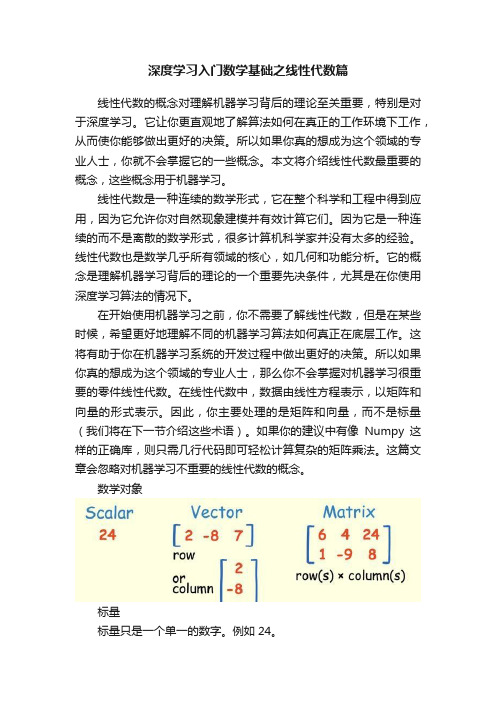

数学对象标量标量只是一个单一的数字。

例如24。

向量向量是一个有序的数字数组,可以在一行或一列中。

它只有一个索引,可以指向矢量中的特定值。

例如,V2代表向量的第二个值,在上面的黄色图片中为“-8”。

矩阵矩阵是一个有序的二维数组,它有两个索引。

第一个指向该行,第二个指向该列。

例如,M23表示第二行和第三列的值,在上面的黄色图片中为“8”。

矩阵可以有多个行和列。

请注意,向量也是一个矩阵,但只有一行或一列。

在黄色图片的例子中的矩阵也是2×3维的矩阵(行*列)。

下面你可以看到矩阵的另一个例子及其符号:张量张量是一组数字,排列在一个规则的网格上,具有不同数量的轴。

深度学习:数学基础、算法模型与实战

深度学习的核心是神经网络,包括前馈神经网络、卷积神经网络、循环神经 网络等。在《深度学习:数学基础、算法模型与实战》中,作者详细介绍了这些 神经网络的原理、结构和训练方法,让读者能够深入了解深度学习的核心算法。

பைடு நூலகம்

深度学习的应用范围非常广泛,包括计算机视觉、自然语言处理、语音识别、 推荐系统等。在《深度学习:数学基础、算法模型与实战》中,作者通过多个实 战案例,展示了深度学习的应用效果和潜力。

这本书的数学基础部分非常详细,对于想要深入了解深度学习算法原理的人 来说,这是一本非常不错的入门教材。作者通过对各种数学概念和理论的讲解, 帮助读者建立起坚实的数学基础,为后续的算法学习打下良好的基础。

这本书的算法模型部分非常全面,涵盖了深度学习中常用的各种算法和模型。 从基本的神经网络到复杂的深度学习模型,从监督学习到无监督学习,这本书都 有详细的介绍。通过阅读这本书,读者可以了解到深度学习的各种算法和模型, 并了解它们的应用场景和优缺点。

目录分析

深度学习是当前领域最热门的话题之一,而《深度学习:数学基础、算法模 型与实战》这本书则是深度学习领域的一本经典著作。这本书的内容涵盖了深度 学习的各个方面,包括数学基础、算法模型以及实战应用,对于想要深入了解深 度学习的人来说是一本非常值得阅读的书籍。

这本书的目录结构非常清晰,每一章都有明确的主题和内容。从目录中可以 看出,这本书的内容是按照深度学习的层次结构来组织的,从最基础的数学原理 到算法模型的实现,再到实战应用,逐步深入。这样的目录结构使得读者可以按 照自己的兴趣和需求选择阅读的内容,同时也方便了读者对深度学习的整体把握。

内容摘要

本书还介绍了如何使用深度学习技术解决实际问题,如图像分类、文本生成等。 《深度学习:数学基础、算法模型与实战》是一本全面而深入的深度学习书籍。它不仅介绍了深 度学习的数学基础和算法模型,还提供了丰富的实战应用案例。对于想要深入了解深度学习领域 的读者来说,这本书是一本非常有价值的参考书籍。

深度学习课件-第2讲:深度学习基础

=

1

exp

2 2

1

− 2

2

−

2

由精度参数化(Parametrized by precision):

; , −1

=

exp

2

1

−

2

−

2

高斯分布

多元高斯分布

由协方差矩阵参数化(Parametrized by covariance

matrix):

1

exp

(2) det(σ)

摩尔-彭若斯广义逆

+

=

• 方程组解的情况包括:

― 仅有一个解:此时摩尔-彭若斯广义逆矩阵与逆矩阵相

同

― 无解:此时会给出解的最小误差 −

― 多个解:此时会给出范数最小的解

2

迹(Trace)

= ,

矩阵的迹的性质:

+ = +

自信息:

= −log ()

信息熵:

H = ~

= ~ log ()

KL散度:

∥ = ~

= ~ − ()

KL散度是不对称的

∗ = ∥

∗ = ∥

1979 – deep neocognitron, convolution, Fukushima

1987 – autoencoder, Ballard

1989 – convolutional neural networks (CNN), Lecun

1991 – deep recurrent neural networks (RNN), Schmidhuber

深度学习的数学基础

3 of 44

2.1线性代数

第二章 深度学习的数学基础

2.1.1向量空间

给定一个非空集合是������和数域集合������,在������中定义了加法运算 +,在������与������之间定义了数乘运算∙,������, ������, ������ ∈ ������, ������, ������ ∈ ������ ,如 果该加法运算+和数乘运算∙同时满足下面所有规则,则称������ 是������ 上的向量空间或线性空间。 (1)规则1:若������, ������ ∈ ������ ,则������ + ������ ∈ ������ (2)规则2:若������, ������ ∈ ������ ,则������ + ������ = ������ + ������ (3)规则3:若������, ������, ������ ∈ ������ ,则(������ + ������) + ������ = ������ + (������ + ������) (4)规则4:存在零元素0 ∈ ������对 都有0 + ������ = ������ (5)规则5:对任意向量������ ∈ ������都存在负元素−������ ∈ ������使得 ������ + (−������) = 0

4 of 44

2.1线性代数

第二章 深度学习的数学基础

2.1.1向量空间

(6)规则6:若������ ∈ ������, ������ ∈ ������ ,则������ ∙ ������ ∈ ������, (7)规则7:若������, ������ ∈ ������, ������ ∈ ������ ,则 ������ ∙ ������ + ������ = ������ ∙ ������ + ������ ∙ ������ (8)规则8:若������ ∈ ������, ������, ������ ∈ ������ ,则 ������ + ������ ∙ ������ = ������ ∙ ������ + ������ ∙ ������ (9)规则9:若������ ∈ ������, ������, ������ ∈ ������ ,则������ ∙ ������ ∙ ������ = (������������) ∙ ������ (10)规则10:若������ ∈ ������ ,则存在一个单位元素1 ∈ ������使得 1 ∙ ������ = ������