opencv简单代码

opencv mat 乘常数

一、介绍opencv mat乘常数的意义及作用在使用opencv进行图像处理时,经常会遇到需要对图像的每个像素点进行一定的数学运算,例如加减乘除等。

其中,乘以常数是一种常见的操作,它可以用来对图像进行亮度调整、对比度增强等。

通过对图像矩阵(mat)进行乘法运算,可以快速有效地对图像进行相应的处理。

二、opencv mat乘常数的代码示例在opencv中,可以通过以下代码来实现对图像矩阵的乘法运算:```cpp#include <opencv2/opencv.hpp>int m本人n() {// 读取图像cv::Mat image = cv::imread("image.jpg");// 将图像矩阵中的每个像素乘以2image *= 2;// 显示处理后的图像cv::imshow("Processed Image", image);cv::w本人tKey(0);return 0;}```上述代码通过将图像矩阵中的每个像素乘以2来实现图像的亮度调整。

可以通过改变乘数来实现不同程度的亮度调整。

三、opencv mat乘常数的使用场景1. 亮度调整:通过将图像矩阵中的每个像素乘以一个常数,可以实现对图像亮度的快速调整,使图像变得更明亮或更暗。

2. 对比度增强:通过对图像矩阵进行乘法运算,可以增强图像的对比度,使得图像中的细节更加清晰。

这在图像处理和分析中非常常见。

3. 图像滤波:图像滤波是图像处理中的一种重要操作,通过对图像矩阵进行乘法运算,可以实现一些简单的图像滤波效果,例如均值滤波、高斯滤波等。

四、opencv mat乘常数的注意事项在使用opencv进行图像处理时,对图像矩阵进行乘法运算需要注意以下几点:1. 数据类型:图像矩阵的数据类型需要和常数的数据类型匹配,否则会导致运算错误。

2. 越界处理:在进行乘法运算时,需要注意处理可能导致图像像素值越界的情况,可以使用饱和运算或者手动处理来避免越界。

c++opencv实现计算两条直线或线段角度方法详解

c++opencv实现计算两条直线或线段角度方法详解引言在计算机视觉和图像处理领域,两条直线或线段的相互角度是一个重要的参数,它涉及到诸如线条的匹配、形状识别、三维重建等诸多应用。

OpenCV是一个广泛使用的计算机视觉库,提供了许多功能强大的图像处理和分析工具。

其中,利用OpenCV进行直线或线段角度的计算是一个常见的需求。

本文将详细介绍如何使用C++和OpenCV实现计算两条直线或线段的角度。

一、直线或线段表示在计算机视觉中,通常使用向量或点来描述直线或线段。

对于一条直线,我们可以将其表示为一个起点和一个方向向量。

对于一条线段,我们可以将其表示为两个端点。

为了方便计算,通常将方向向量归一化,使其长度为1。

二、角度计算公式计算两条直线或线段的角度,可以使用三角函数或向量叉积的方法。

其中,向量叉积的方法更为准确,但计算过程相对复杂。

常见的角度计算公式如下:θ = arccos((A × B) · n) / |n|,其中A和B分别为两条直线的方向向量或线段的端点向量,n为另一条直线的方向向量或线段的起点向量。

三、OpenCV实现在使用OpenCV进行角度计算时,需要使用其提供的函数和算法。

以下是一个简单的示例代码,演示如何使用OpenCV计算两条直线或线段的角度:```c++#include <opencv2/opencv.hpp>#include <iostream>using namespace cv;using namespace std;int main() {// 读取两张图像,获取它们的特征点Mat img1 = imread("image1.jpg");Mat img2 = imread("image2.jpg");vector<Point2f> points1, points2;featureDetector::detect(img1, points1);featureDetector::detect(img2, points2);// 获取第一条直线的方向向量和第二条直线的起点向量Vec3f normal = keypoints::klinear(points1, img1, TermCriteria(TermCriteria::EPS + TermCriteria::COUNT, 10, 1));Point2f pt = points2[0]; // 第二条直线的起点Vec3f n2 = normalize(Vec3f(pt - points1[0])); // 第二条直线的方向向量// 计算两条直线之间的角度double angle = acos((normal * n2) / norm(normal)) * 180 / CV_PI; // 将角度转换为度数并四舍五入到最接近的整数 cout << "Angle between lines: " << angle << " degrees" << endl;// 获取线段的角度(如果需要)// ...return 0;}```在上述代码中,我们首先使用OpenCV的图像特征检测器从两张图像中提取特征点。

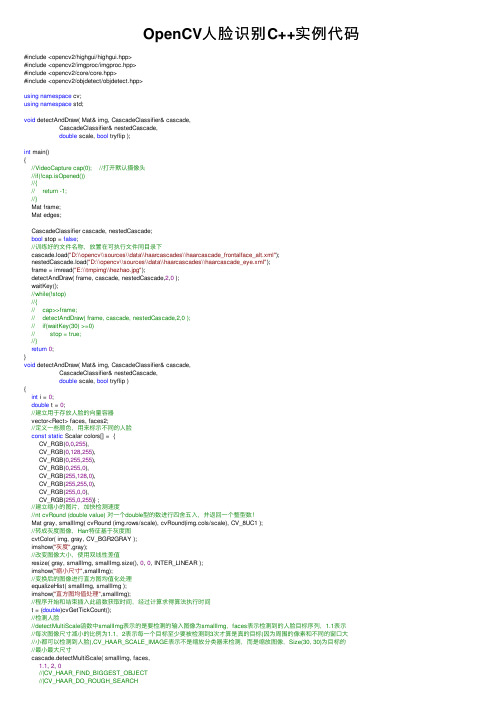

OpenCV人脸识别C++实例代码

OpenCV⼈脸识别C++实例代码#include <opencv2/highgui/highgui.hpp>#include <opencv2/imgproc/imgproc.hpp>#include <opencv2/core/core.hpp>#include <opencv2/objdetect/objdetect.hpp>using namespace cv;using namespace std;void detectAndDraw( Mat& img, CascadeClassifier& cascade,CascadeClassifier& nestedCascade,double scale, bool tryflip );int main(){//VideoCapture cap(0); //打开默认摄像头//if(!cap.isOpened())//{// return -1;//}Mat frame;Mat edges;CascadeClassifier cascade, nestedCascade;bool stop = false;//训练好的⽂件名称,放置在可执⾏⽂件同⽬录下cascade.load("D:\\opencv\\sources\\data\\haarcascades\\haarcascade_frontalface_alt.xml");nestedCascade.load("D:\\opencv\\sources\\data\\haarcascades\\haarcascade_eye.xml");frame = imread("E:\\tmpimg\\hezhao.jpg");detectAndDraw( frame, cascade, nestedCascade,2,0 );waitKey();//while(!stop)//{// cap>>frame;// detectAndDraw( frame, cascade, nestedCascade,2,0 );// if(waitKey(30) >=0)// stop = true;//}return0;}void detectAndDraw( Mat& img, CascadeClassifier& cascade,CascadeClassifier& nestedCascade,double scale, bool tryflip ){int i = 0;double t = 0;//建⽴⽤于存放⼈脸的向量容器vector<Rect> faces, faces2;//定义⼀些颜⾊,⽤来标⽰不同的⼈脸const static Scalar colors[] = {CV_RGB(0,0,255),CV_RGB(0,128,255),CV_RGB(0,255,255),CV_RGB(0,255,0),CV_RGB(255,128,0),CV_RGB(255,255,0),CV_RGB(255,0,0),CV_RGB(255,0,255)} ;//建⽴缩⼩的图⽚,加快检测速度//nt cvRound (double value) 对⼀个double型的数进⾏四舍五⼊,并返回⼀个整型数!Mat gray, smallImg( cvRound (img.rows/scale), cvRound(img.cols/scale), CV_8UC1 );//转成灰度图像,Harr特征基于灰度图cvtColor( img, gray, CV_BGR2GRAY );imshow("灰度",gray);//改变图像⼤⼩,使⽤双线性差值resize( gray, smallImg, smallImg.size(), 0, 0, INTER_LINEAR );imshow("缩⼩尺⼨",smallImg);//变换后的图像进⾏直⽅图均值化处理equalizeHist( smallImg, smallImg );imshow("直⽅图均值处理",smallImg);//程序开始和结束插⼊此函数获取时间,经过计算求得算法执⾏时间t = (double)cvGetTickCount();//检测⼈脸//detectMultiScale函数中smallImg表⽰的是要检测的输⼊图像为smallImg,faces表⽰检测到的⼈脸⽬标序列,1.1表⽰//每次图像尺⼨减⼩的⽐例为1.1,2表⽰每⼀个⽬标⾄少要被检测到3次才算是真的⽬标(因为周围的像素和不同的窗⼝⼤//⼩都可以检测到⼈脸),CV_HAAR_SCALE_IMAGE表⽰不是缩放分类器来检测,⽽是缩放图像,Size(30, 30)为⽬标的//最⼩最⼤尺⼨cascade.detectMultiScale( smallImg, faces,1.1, 2, 0//|CV_HAAR_FIND_BIGGEST_OBJECT//|CV_HAAR_DO_ROUGH_SEARCH|CV_HAAR_SCALE_IMAGE,Size(30, 30));//如果使能,翻转图像继续检测if( tryflip ){flip(smallImg, smallImg, 1);imshow("反转图像",smallImg);cascade.detectMultiScale( smallImg, faces2,1.1, 2, 0//|CV_HAAR_FIND_BIGGEST_OBJECT//|CV_HAAR_DO_ROUGH_SEARCH|CV_HAAR_SCALE_IMAGE,Size(30, 30) );for( vector<Rect>::const_iterator r = faces2.begin(); r != faces2.end(); r++ ){faces.push_back(Rect(smallImg.cols - r->x - r->width, r->y, r->width, r->height));}}t = (double)cvGetTickCount() - t;// qDebug( "detection time = %g ms\n", t/((double)cvGetTickFrequency()*1000.) );for( vector<Rect>::const_iterator r = faces.begin(); r != faces.end(); r++, i++ ){Mat smallImgROI;vector<Rect> nestedObjects;Point center;Scalar color = colors[i%8];int radius;double aspect_ratio = (double)r->width/r->height;if( 0.75 < aspect_ratio && aspect_ratio < 1.3 ){//标⽰⼈脸时在缩⼩之前的图像上标⽰,所以这⾥根据缩放⽐例换算回去center.x = cvRound((r->x + r->width*0.5)*scale);center.y = cvRound((r->y + r->height*0.5)*scale);radius = cvRound((r->width + r->height)*0.25*scale);circle( img, center, radius, color, 3, 8, 0 );}elserectangle( img, cvPoint(cvRound(r->x*scale), cvRound(r->y*scale)),cvPoint(cvRound((r->x + r->width-1)*scale), cvRound((r->y + r->height-1)*scale)),color, 3, 8, 0);if( nestedCascade.empty() )continue;smallImgROI = smallImg(*r);//同样⽅法检测⼈眼nestedCascade.detectMultiScale( smallImgROI, nestedObjects,1.1, 2, 0//|CV_HAAR_FIND_BIGGEST_OBJECT//|CV_HAAR_DO_ROUGH_SEARCH//|CV_HAAR_DO_CANNY_PRUNING|CV_HAAR_SCALE_IMAGE,Size(30, 30) );for( vector<Rect>::const_iterator nr = nestedObjects.begin(); nr != nestedObjects.end(); nr++ ) {center.x = cvRound((r->x + nr->x + nr->width*0.5)*scale);center.y = cvRound((r->y + nr->y + nr->height*0.5)*scale);radius = cvRound((nr->width + nr->height)*0.25*scale);circle( img, center, radius, color, 3, 8, 0 );}}imshow( "识别结果", img );}opencv 连接器配置[debug]opencv_ml2413d.libopencv_calib3d2413d.libopencv_contrib2413d.libopencv_core2413d.libopencv_features2d2413d.lib opencv_flann2413d.libopencv_gpu2413d.libopencv_highgui2413d.libopencv_imgproc2413d.libopencv_legacy2413d.libopencv_objdetect2413d.lib opencv_ts2413d.libopencv_video2413d.libopencv_nonfree2413d.libopencv_ocl2413d.libopencv_photo2413d.libopencv_stitching2413d.lib opencv_superres2413d.lib opencv_videostab2413d.lib [release]opencv_ml2413.libopencv_calib3d2413.libopencv_contrib2413.libopencv_core2413.libopencv_features2d2413.lib opencv_flann2413.libopencv_gpu2413.libopencv_highgui2413.libopencv_imgproc2413.libopencv_legacy2413.libopencv_objdetect2413.libopencv_ts2413.libopencv_video2413.libopencv_nonfree2413.libopencv_ocl2413.libopencv_photo2413.libopencv_stitching2413.libopencv_superres2413.libopencv_videostab2413.lib// 根据你的版本批量替换2413版本号。

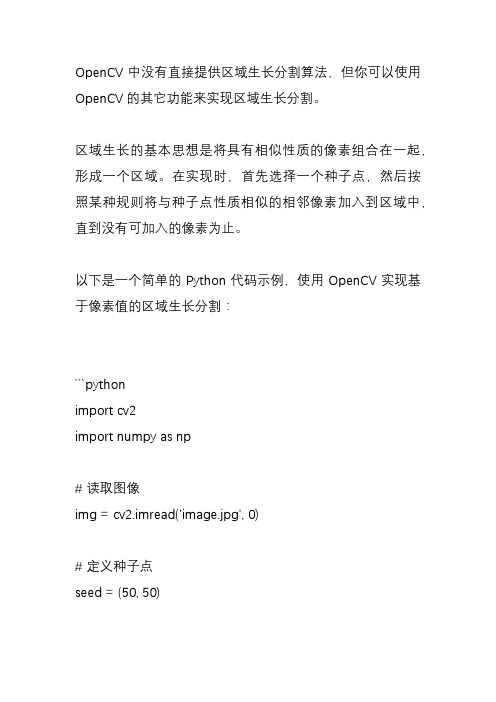

opencv 区域生长分割算法

OpenCV中没有直接提供区域生长分割算法,但你可以使用OpenCV的其它功能来实现区域生长分割。

区域生长的基本思想是将具有相似性质的像素组合在一起,形成一个区域。

在实现时,首先选择一个种子点,然后按照某种规则将与种子点性质相似的相邻像素加入到区域中,直到没有可加入的像素为止。

以下是一个简单的Python代码示例,使用OpenCV实现基于像素值的区域生长分割:```pythonimport cv2import numpy as np# 读取图像img = cv2.imread('image.jpg', 0)# 定义种子点seed = (50, 50)# 定义生长规则,这里使用像素值criteria = (cv2.TERM_CRITERIA_EPS + cv2.TERM_CRITERIA_MAX_ITER, 100, 0.2)# 执行区域生长分割_, label, stats, centroid = cv2.connectedComponentsWithStats(img, connectivity=8, ltype=cv2.CV_32S, seedPoint=seed)# 将结果二值化label = label.astype(np.uint8)ret, label = cv2.threshold(label, 0, 255, cv2.THRESH_BINARY + cv2.THRESH_OTSU)# 显示结果cv2.imshow('segmented image', label)cv2.waitKey(0)cv2.destroyAllWindows()```在这个示例中,我们首先读取图像,然后定义一个种子点。

接下来,我们使用`cv2.connectedComponentsWithStats()`函数执行区域生长分割,该函数返回每个连通组件的标签、连通组件的统计信息(包括连通组件的尺寸、边界矩形等)和连通组件的中心点。

【python】opencv教程CV2模块——简单画图

【python】opencv教程CV2模块——简单画图opencv教程CV2模块系列——简单画图import numpy as npimport cv2# 创建⼀个宽512⾼512的⿊⾊画布,RGB(0,0,0)即⿊⾊img=np.zeros((512,512,3),np.uint8)# 画直线,图⽚对象,起始坐标(x轴,y轴),结束坐标,颜⾊,宽度cv2.line(img,(0,0),(311,511),(255,0,0),10)# 画矩形,图⽚对象,左上⾓坐标,右下⾓坐标,颜⾊,宽度cv2.rectangle(img,(30,166),(130,266),(0,255,0),3)# 画圆形,图⽚对象,中⼼点坐标,半径⼤⼩,颜⾊,宽度cv2.circle(img,(222,222),50,(255.111,111),-1)# 画椭圆形,图⽚对象,中⼼点坐标,长短轴,顺时针旋转度数,开始⾓度(右长轴表0度,上短轴表270度),颜⾊,宽度cv2.ellipse(img,(333,333),(50,20),0,0,150,(255,222,222),-1)# 画多边形,指定各个点坐标,array必须是int32类型pts=np.array([[10,5],[20,30],[70,20],[50,10]], np.int32)# -1表⽰该纬度靠后⾯的纬度⾃动计算出来,实际上是4pts = pts.reshape((-1,1,2,))# print(pts)# 画多条线,False表不闭合,True表⽰闭合,闭合即多边形cv2.polylines(img,[pts],True,(255,255,0),5)#写字,字体选择font=cv2.FONT_HERSHEY_SCRIPT_COMPLEX# 图⽚对象,要写的内容,左边距,字的底部到画布上端的距离,字体,⼤⼩,颜⾊,粗细cv2.putText(img,"OpenCV",(10,400),font,3.5,(255,255,255),2)a=cv2.imwrite("./out/picture.jpg",img)cv2.imshow("picture",img)cv2.waitKey(0)cv2.destroyAllWindows()。

minmaxloc opencv代码实例

minmaxloc opencv代码实例全文共四篇示例,供读者参考第一篇示例:MinMaxLoc是OpenCV中一个常用的函数,用于查找矩阵中的最小值、最大值以及它们对应的位置。

MinMaxLoc函数有多种重载形式,可以根据具体需求选择合适的使用方式。

下面我们通过一个简单的代码示例来展示MinMaxLoc函数的用法。

我们需要在代码中引入OpenCV库。

```cpp#include <opencv2/opencv.hpp>```接下来,我们创建一个简单的示例函数,该函数会生成一个随机的矩阵,并使用MinMaxLoc函数找到矩阵中的最小值、最大值以及它们的位置。

```cppvoid minMaxLocExample(){// 生成一个3x3的随机矩阵cv::Mat matrix = cv::Mat::ones(3, 3, CV_8UC1);cv::randu(matrix, cv::Scalar(0), cv::Scalar(255));// 打印矩阵内容std::cout << "Matrix:" << std::endl;std::cout << matrix << std::endl;MinMaxLoc函数通常用于在图像处理中定位图像中的最亮点和最暗点,或者在特征匹配算法中用于找到最相似的特征点。

需要注意的是,MinMaxLoc函数在处理多通道矩阵时需要指定通道索引。

还可以通过使用掩模来限定MinMaxLoc函数的搜索范围。

第二篇示例:MinMaxLoc是OpenCV库中的一个函数,用于查找矩阵或图像中的最小值或最大值,并返回它们的位置。

这一功能在图像处理和计算机视觉中非常有用,可以帮助我们找到图像中的特定区域或物体。

在本文中,我们将介绍如何在OpenCV中使用MinMaxLoc函数,以及如何实现一个简单的示例来演示其用法。

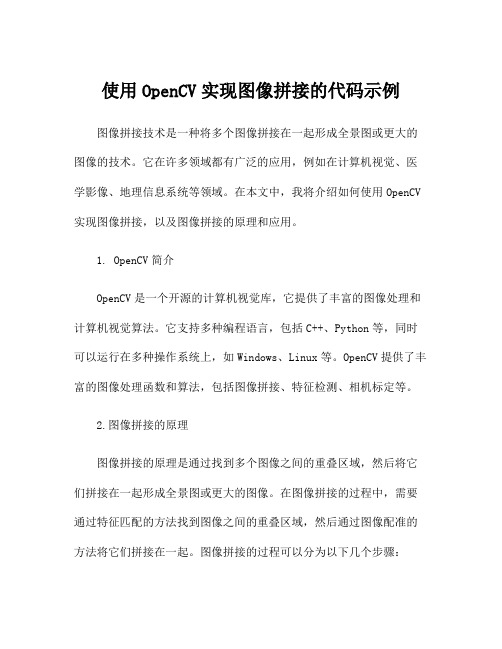

使用OpenCV实现图像拼接的代码示例

使用OpenCV实现图像拼接的代码示例图像拼接技术是一种将多个图像拼接在一起形成全景图或更大的图像的技术。

它在许多领域都有广泛的应用,例如在计算机视觉、医学影像、地理信息系统等领域。

在本文中,我将介绍如何使用OpenCV 实现图像拼接,以及图像拼接的原理和应用。

1. OpenCV简介OpenCV是一个开源的计算机视觉库,它提供了丰富的图像处理和计算机视觉算法。

它支持多种编程语言,包括C++、Python等,同时可以运行在多种操作系统上,如Windows、Linux等。

OpenCV提供了丰富的图像处理函数和算法,包括图像拼接、特征检测、相机标定等。

2.图像拼接的原理图像拼接的原理是通过找到多个图像之间的重叠区域,然后将它们拼接在一起形成全景图或更大的图像。

在图像拼接的过程中,需要通过特征匹配的方法找到图像之间的重叠区域,然后通过图像配准的方法将它们拼接在一起。

图像拼接的过程可以分为以下几个步骤:2.1特征提取在图像拼接的过程中,需要首先从每个图像中提取特征点,这些特征点可以是角点、边缘点等。

常用的特征提取算法包括Harris角点检测、SIFT、SURF等。

2.2特征匹配在提取了特征点之后,需要对这些特征点进行匹配,找到图像之间的重叠区域。

匹配的过程可以使用欧几里德距离、汉明距离等来度量两个特征点之间的相似度。

2.3图像配准一旦找到了图像之间的重叠区域,就可以使用图像配准的方法将它们拼接在一起。

图像配准的方法可以是通过图像的平移、旋转、缩放等变换将它们对齐。

2.4图像融合最后,需要对拼接在一起的图像进行融合,使得拼接后的图像看起来更加自然。

3.使用OpenCV实现图像拼接接下来,我将介绍如何使用OpenCV来实现图像拼接。

在OpenCV 中,有一个名为Stitcher的类可以用来实现图像拼接。

3.1导入OpenCV库首先需要导入OpenCV库,可以使用以下Python代码来实现:```pythonimport cv2```3.2读入图像使用cv2.imread()函数可以读入图像,例如:```pythonimage1 = cv2.imread('image1.jpg')image2 = cv2.imread('image2.jpg')```3.3创建Stitcher对象接下来,可以创建一个Stitcher对象来实现图像拼接:```pythonstitcher = cv2.Stitcher_create()```3.4图像拼接最后,可以使用stitcher.stitch()函数来实现图像拼接:```python(result, pano) = stitcher.stitch([image1, image2])```其中,result是一个整数,表示图像拼接的状态,如果result为0,表示图像拼接成功。

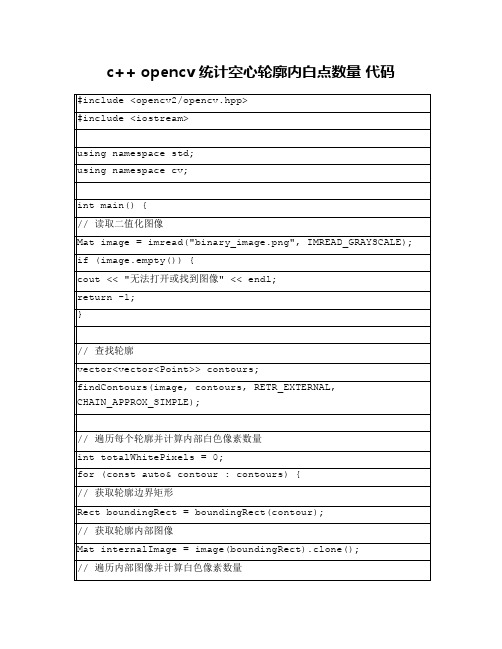

c++ opencv 统计空心轮廓内白点数量 代码

for (int y = 0; y < internalImage.rows; ++y) {

for (int x = 0; x < internalImage.cols; ++x) {

if (internalImage.at<uchar>(y, x) == 255) {

++totalWhitePixels;

}

}

}

}

//输出结果

cout << "总共找到" << contours.size() << "个轮廓" << endl;

cout << "总共" << totalWhitePixels << "个内部白色像素" << endl;

return 0;

}

该代码首先读取一个二值化图像,然后使用findContours函数查找轮廓。接下来,它遍历每个轮廓并使用boundingRect函数获取每个轮廓的边界矩形。然后,它复制边界矩形内的图像并遍历内部图像以计算白色像素数量。最后,它输出找到的轮廓数量和内部白色像素数量。

//遍历每个轮廓并计算内部白色像素数量

int totalWhitePixels = 0;

for (const auto& contour : contours) {

//获取轮廓边界矩形

Rect boundingRect = boundingRect(contour);

//获取轮廓内部图像

Mat internalImage = image(boundingRect).clone();

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(1)分配内存给一幅新图像

IplImage*

cvCreateImage(CvSizesize, int depth, int channels);

size: cvSize(width,height);

depth: 像素深度: IPL_DEPTH_8U, IPL_DEPTH_8S, IPL_DEPTH_16U, channels: 像素通道数. Can be 1, 2, 3 or 4.

示例:

// Allocate a1-channel byte image

IplImage*

img1=cvCreateIm

age(cvSize(640,480),IPL_DEPTH_8U,1);

(2)释放图像

IplImage*

img=cvCreateIma

ge(cvSize(640,480),IPL_DEPTH_8U,1);

cvReleaseImage(&img);

(3)复制图像

IplImage*

img1=cvCreateIm

age(cvSize(640,480),IPL_DEPTH_8U,1);

IplImage* img2;

img2=cvCloneImage(img1);

(4)从文件中读入图像

IplImage*

img=0;

img=cvLoadImage

(fileName);

if(!img)

printf("Couldnot load imagefile:%s\n",fileName);

(5)头文件:

#include <cv.h>

#include <cvaux.h>

#include <highgui.h>

#include <cxcore.h> // 不必要- 该头文件已在cv.h 文件中包含(6)响应键盘事件:

直接获取键盘操作:

int key;

key=cvWaitKey(10); // 输入等待10ms

等待按键并获取键盘操作:

int key;

key=cvWaitKey(0); // 无限等待键盘输入

键盘输入循环:

while(1){key=cvWaitKey(10);if(key==27) break;

switch(key){

case 'h':

...

break;

case 'i':

...

break;

}

}

(7)图像转换

转为灰度或彩色字节图像:

cvConvertImage(src, dst, flags=0);

src = float/byte grayscale/color image

dst = byte grayscale/color image

flags = CV_CVTIMG_FLIP (flip vertically)

CV_CVTIMG_SWAP_RB (swap the R and B channels)

转换彩色图像为灰度图像:

使用OpenCV转换函数:

cvCvtColor(cimg,gimg,CV_BGR2GRAY); // cimg -> gimg

直接转换:

for(i=0;i<cimg->height;i++) for(j=0;j<cimg->width;j++)

gimgA[i][j]=(uchar)(cimgA[i][j].b*0.114+cimgA[i][j].g*0.587+cimgA[i][j].r*0.29;

颜色空间转换:

cvCvtColor(src,dst,code); // src -> dst

code = CV_<X>2<Y>

<X>/<Y> = RGB, BGR, GRAY, HSV, YCrCb, XYZ, Lab, Luv, HLS e.g.: CV_BGR2GRAY, CV_BGR2HSV, CV_BGR2Lab

(8)作业三的代码

#include<string>

#include<sstream>

#include<cv.h>

#include<highgui.h>

using namespace std;

using namespace cv;

int main ()

{

Mat second_pic;

Mat result;

String buffer;

cout << "Input First Pic filename :";

cin >> buffer;

result = imread(buffer);

cout << "Input Second Pic filename :";

cin >> buffer;

second_pic = imread(buffer);

Mat mask(result.rows, result.cols, CV_32F);

for(int i = 0 ; i < result.rows ; i++)

{

for(int j = 0 ; j < result.cols ; j++)

{

mask.at<float>(i, j) = fastAtan2(result.rows / 2 - i, j - result.cols / 2);

}

}

int result_number;

stringstream temp;

cout << "How many results you want?";

cin >> buffer;

temp << buffer;

temp >> result_number;

for(int i = 0 ; i <= result_number ; ++i )

{

second_pic.copyTo(result, mask < i * 360.0 / result_number);

imshow("Result", result);

imshow("Mask", mask < i * 360.0 / result_number);

cvWaitKey(0);

temp.clear();

temp << i;

temp >> buffer;

string temp_string = "result" + buffer + ".jpg";

imwrite(temp_string, result);

}

}。