hadoop面试题

hadoop面试题总结

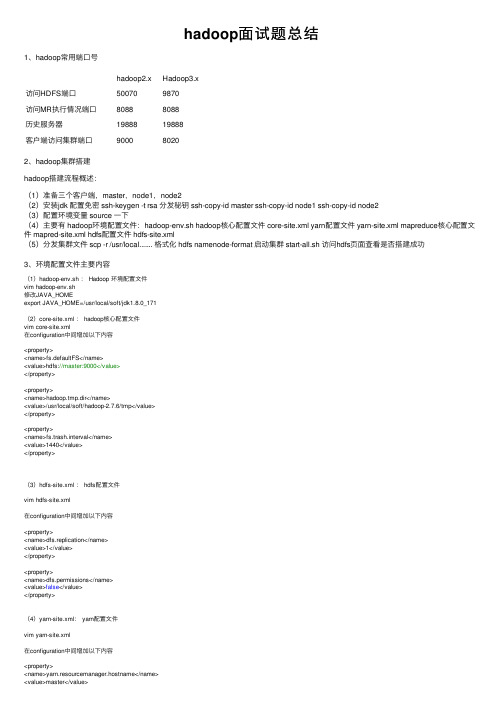

hadoop⾯试题总结1、hadoop常⽤端⼝号hadoop2.x Hadoop3.x访问HDFS端⼝50070 9870访问MR执⾏情况端⼝8088 8088历史服务器19888 19888客户端访问集群端⼝9000 80202、hadoop集群搭建hadoop搭建流程概述:(1)准备三个客户端,master,node1,node2(2)安装jdk 配置免密 ssh-keygen -t rsa 分发秘钥 ssh-copy-id master ssh-copy-id node1 ssh-copy-id node2(3)配置环境变量 source ⼀下(4)主要有 hadoop环境配置⽂件:hadoop-env.sh hadoop核⼼配置⽂件 core-site.xml yarn配置⽂件 yarn-site.xml mapreduce核⼼配置⽂件 mapred-site.xml hdfs配置⽂件 hdfs-site.xml(5)分发集群⽂件 scp -r /usr/local....... 格式化 hdfs namenode-format 启动集群 start-all.sh 访问hdfs页⾯查看是否搭建成功3、环境配置⽂件主要内容(1)hadoop-env.sh : Hadoop 环境配置⽂件vim hadoop-env.sh修改JAVA_HOMEexport JAVA_HOME=/usr/local/soft/jdk1.8.0_171(2)core-site.xml : hadoop核⼼配置⽂件vim core-site.xml在configuration中间增加以下内容<property><name>fs.defaultFS</name><value>hdfs://master:9000</value></property><property><name>hadoop.tmp.dir</name><value>/usr/local/soft/hadoop-2.7.6/tmp</value></property><property><name>fs.trash.interval</name><value>1440</value></property>(3)hdfs-site.xml : hdfs配置⽂件vim hdfs-site.xml在configuration中间增加以下内容<property><name>dfs.replication</name><value>1</value></property><property><name>dfs.permissions</name><value>false</value></property>(4)yarn-site.xml: yarn配置⽂件vim yarn-site.xml在configuration中间增加以下内容<property><name>yarn.resourcemanager.hostname</name><value>master</value></property><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.log-aggregation-enable</name><value>true</value></property><property><name>yarn.log-aggregation.retain-seconds</name><value>604800</value></property><property><name>yarn.nodemanager.resource.memory-mb</name><value>20480</value></property><property><name>yarn.scheduler.minimum-allocation-mb</name><value>2048</value></property><property><name>yarn.nodemanager.vmem-pmem-ratio</name><value>2.1</value></property>(5)mapred-site.xml: mapreduce配置⽂件重命名mv mapred-site.xml.template mapred-site.xmlvim mapred-site.xml在configuration中间增加以下内容<property><name></name><value>yarn</value></property><property><name>mapreduce.jobhistory.address</name><value>master:10020</value></property><property><name>mapreduce.jobhistory.webapp.address</name><value>master:19888</value></property>3、hdfs读写流程写流程:1)客户端向namenode请求上传⽂件,namenode检查⽬标⽂件是否已存在,⽗⽬录是否存在。

hadoop常见面试问题

hadoop常见面试问题

以下是一些Hadoop常见的面试问题:

1. Hadoop是什么?它在大数据领域中的作用是什么?

2. Hadoop的核心组件有哪些?它们各自的作用是什么?

3. HDFS是什么?它有哪些特点和优势?

4. MapReduce是什么?它是如何工作的?

5. YARN是什么?它在Hadoop中的作用是什么?

6. 在Hadoop中如何处理数据倾斜?有哪些常见的数据倾斜问题需要避免?

7. Hadoop集群的部署和配置需要注意哪些问题?

8. 如何优化Hadoop集群的性能?有哪些常见的性能调优方法?

9. 在Hadoop中如何进行数据迁移?有哪些常见的迁移策略?

10. 如何进行Hadoop的安全性配置和管理?有哪些常见的安全措施需要采取?

11. Hadoop和Spark的区别和联系是什么?在什么情况下应该选择Hadoop或Spark?

12. 在Hadoop中如何进行数据清洗和预处理?有哪些常用的工具和库可以使用?

13. 如何使用Hadoop进行机器学习和数据挖掘?有哪些常见的算法和应用场景?

14. Hadoop的版本演进和兼容性问题需要注意哪些方面?

15. 你如何在Hadoop上进行大数据实时流处理?有哪些常用的流处理框架可以选择和使用?。

Hadoop最全面试题整理(附目录)

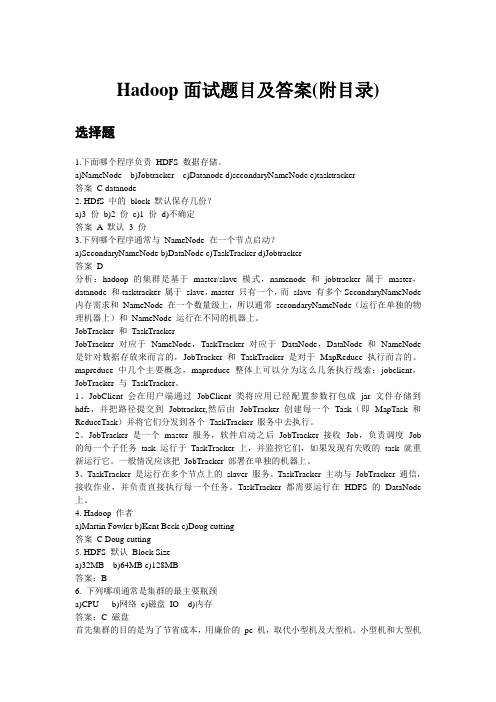

Hadoop面试题目及答案(附目录)选择题1.下面哪个程序负责HDFS 数据存储。

a)NameNode b)Jobtracker c)Datanode d)secondaryNameNode e)tasktracker答案C datanode2. HDfS 中的block 默认保存几份?a)3 份b)2 份c)1 份d)不确定答案A 默认3 份3.下列哪个程序通常与NameNode 在一个节点启动?a)SecondaryNameNode b)DataNode c)TaskTracker d)Jobtracker答案D分析:hadoop 的集群是基于master/slave 模式,namenode 和jobtracker 属于master,datanode 和tasktracker 属于slave,master 只有一个,而slave 有多个SecondaryNameNode 内存需求和NameNode 在一个数量级上,所以通常secondaryNameNode(运行在单独的物理机器上)和NameNode 运行在不同的机器上。

JobTracker 和TaskTrackerJobTracker 对应于NameNode,TaskTracker 对应于DataNode,DataNode 和NameNode 是针对数据存放来而言的,JobTracker 和TaskTracker 是对于MapReduce 执行而言的。

mapreduce 中几个主要概念,mapreduce 整体上可以分为这么几条执行线索:jobclient,JobTracker 与TaskTracker。

1、JobClient 会在用户端通过JobClient 类将应用已经配置参数打包成jar 文件存储到hdfs,并把路径提交到Jobtracker,然后由JobTracker 创建每一个Task(即MapTask 和ReduceTask)并将它们分发到各个TaskTracker 服务中去执行。

Hadoop 100道面试题及答案解析

3.6误)3.7Hadoop支持数据的随机读写。

(错) (8)NameNode负责管理metadata,client端每次读写请求,它都会从磁盘中3.8读取或则会写入metadata信息并反馈client端。

(错误) (8)NameNode本地磁盘保存了Block的位置信息。

(个人认为正确,欢迎提出其它意见) (9)3.93.10 3.11DataNode通过长连接与NameNode保持通信。

(有分歧) (9)Hadoop自身具有严格的权限管理和安全措施保障集群正常运行。

(错误)93.12 3.13 3.14Slave节点要存储数据,所以它的磁盘越大越好。

(错误) (9)hadoop dfsadmin–report命令用于检测HDFS损坏块。

(错误) (9)Hadoop默认调度器策略为FIFO(正确) (9)100道常见Hadoop面试题及答案解析目录1单选题 (5)1.1 1.2 1.3 1.4 1.5 1.6 1.7下面哪个程序负责HDFS数据存储。

(5)HDfS中的block默认保存几份? (5)下列哪个程序通常与NameNode在一个节点启动? (5)Hadoop作者 (6)HDFS默认Block Size (6)下列哪项通常是集群的最主要瓶颈: (6)关于SecondaryNameNode哪项是正确的? (6)2 3多选题 (7)2.12.22.32.42.5下列哪项可以作为集群的管理? (7)配置机架感知的下面哪项正确: (7)Client端上传文件的时候下列哪项正确? (7)下列哪个是Hadoop运行的模式: (7)Cloudera提供哪几种安装CDH的方法? (7)判断题 (8)3.13.23.3Ganglia不仅可以进行监控,也可以进行告警。

(正确) (8)Block Size是不可以修改的。

(错误) (8)Nagios不可以监控Hadoop集群,因为它不提供Hadoop支持。

Hadoop常见面试笔试题目与参考答案小结

Hadoop常见⾯试笔试题⽬与参考答案⼩结1. namenode的重要性是什么?namenode的作⽤在Hadoop中⾮常重要。

它是Hadoop的⼤脑,主要负责管理系统上的分配块,还为客户提出请求时的数据提供特定地址2. 当NameNode关闭时会发⽣什么?如果NameNode关闭,⽂件系统将脱机。

3. 是否可以在不同集群之间复制⽂件?如果是的话,怎么能做到这⼀点?是的,可以在多个Hadoop集群之间复制⽂件,这可以使⽤分布式复制来完成。

Distcp是⼀个Hadoop复制⼯具,主要⽤于执⾏MapReduce作业来复制数据。

Hadoop环境中的主要挑战是在各集群之间复制数据,distcp也将提供多个datanode来并⾏复制数据。

4. 什么是检查点?对⽂件数据的修改不是直接写回到磁盘的,很多操作是先缓存到内存的Buffer中,当遇到⼀个检查点Checkpoint时,系统会强制将内存中的数据写回磁盘,当然此时才会记录⽇志,从⽽产⽣持久的修改状态。

因此,不⽤重放⼀个编辑⽇志,NameNode可以直接从FsImage加载到最终的内存状态,这肯定会降低NameNode启动时间5. 什么是机架感知?这是⼀种决定如何根据机架定义放置块的⽅法。

Hadoop将尝试限制存在于同⼀机架中的datanode之间的⽹络流量。

为了提⾼容错能⼒,名称节点会尽可能把数据块的副本放到多个机架上。

综合考虑这两点的基础上Hadoop设计了机架感知功能。

6. 投机性执⾏如果⼀个节点正在执⾏⽐主节点慢的任务。

那么就需要在另⼀个节点上冗余地执⾏同⼀个任务的⼀个实例。

所以⾸先完成的任务会被接受,另⼀个可能会被杀死。

这个过程被称为“投机执⾏”。

7. 是否可以在Windows上运⾏Hadoop?可以,但是最好不要这么做,Red Hat Linux或者是Ubuntu才是Hadoop的最佳操作系统。

在Hadoop安装中,Windows通常不会被使⽤,因为会出现各种各样的问题。

大数据工程师面试题及答案

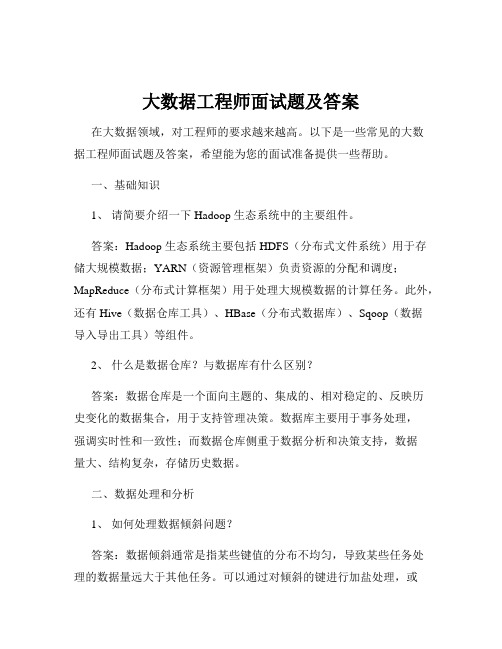

大数据工程师面试题及答案在大数据领域,对工程师的要求越来越高。

以下是一些常见的大数据工程师面试题及答案,希望能为您的面试准备提供一些帮助。

一、基础知识1、请简要介绍一下 Hadoop 生态系统中的主要组件。

答案:Hadoop 生态系统主要包括 HDFS(分布式文件系统)用于存储大规模数据;YARN(资源管理框架)负责资源的分配和调度;MapReduce(分布式计算框架)用于处理大规模数据的计算任务。

此外,还有 Hive(数据仓库工具)、HBase(分布式数据库)、Sqoop(数据导入导出工具)等组件。

2、什么是数据仓库?与数据库有什么区别?答案:数据仓库是一个面向主题的、集成的、相对稳定的、反映历史变化的数据集合,用于支持管理决策。

数据库主要用于事务处理,强调实时性和一致性;而数据仓库侧重于数据分析和决策支持,数据量大、结构复杂,存储历史数据。

二、数据处理和分析1、如何处理数据倾斜问题?答案:数据倾斜通常是指某些键值的分布不均匀,导致某些任务处理的数据量远大于其他任务。

可以通过对倾斜的键进行加盐处理,或者使用 Combiner 函数在 Map 端进行局部聚合来缓解。

还可以对数据进行重新分区,或者调整并行度等方式来解决。

2、请介绍一下 Spark 的核心概念,如 RDD、DataFrame 和 Dataset。

答案:RDD(弹性分布式数据集)是 Spark 的基础数据结构,具有不可变、可分区、可并行操作等特点。

DataFrame 类似于关系型数据库中的表,具有列名和数据类型。

Dataset 是 DataFrame 的扩展,提供了类型安全和面向对象的编程接口。

三、数据存储1、介绍一下 HBase 的架构和工作原理。

答案:HBase 基于 Hadoop 的 HDFS 存储数据,采用主从架构。

HMaster 负责管理表的元数据,HRegionServer 负责存储和管理实际的数据。

数据按照行键进行排序和存储,通过 Region 进行划分和管理。

大数据方向_面试题目(3篇)

第1篇一、基础知识与理论1. 请简述大数据的概念及其与传统数据处理的区别。

2. 请解释什么是Hadoop,并简要说明其组成部分。

3. 请简述MapReduce的核心思想及其在Hadoop中的应用。

4. 请描述HDFS(Hadoop分布式文件系统)的工作原理及其优势。

5. 请说明YARN(Yet Another Resource Negotiator)的作用及其在Hadoop中的地位。

6. 请解释什么是Spark,以及它与传统的大数据处理技术相比有哪些优势。

7. 请描述Spark的架构及其核心组件。

8. 请说明什么是Hive,并简要介绍其作用。

9. 请解释什么是HBase,以及它在大数据中的应用场景。

10. 请说明什么是NoSQL,并列举几种常见的NoSQL数据库及其特点。

二、Hadoop生态系统1. 请介绍Hadoop生态系统中常用的数据处理工具,如Hive、Pig、Spark等。

2. 请说明Hadoop生态系统中常用的数据分析工具,如Elasticsearch、Kafka、Flume等。

3. 请解释Hadoop生态系统中数据存储解决方案,如HDFS、HBase、Cassandra等。

4. 请描述Hadoop生态系统中常用的数据仓库解决方案,如Apache Hudi、Delta Lake等。

5. 请说明Hadoop生态系统中常用的数据可视化工具,如Tableau、Power BI、D3.js等。

三、大数据技术1. 请简述大数据技术中的数据清洗、数据集成、数据存储、数据挖掘等基本概念。

2. 请介绍大数据技术中的数据挖掘算法,如聚类、分类、关联规则等。

3. 请说明大数据技术中的数据可视化方法及其在数据分析中的应用。

4. 请描述大数据技术中的实时数据处理技术,如流处理、事件驱动等。

5. 请介绍大数据技术中的机器学习算法及其在数据分析中的应用。

四、大数据应用案例1. 请列举大数据技术在金融、医疗、电商、物联网等领域的应用案例。

史上最全的大数据面试题,大数据开发者必看

史上最全的大数据面试题,大数据开发者必看在大数据领域,面试常常是求职者获取工作机会的重要环节。

面试官会针对各个方面提问,从技术知识到项目经验,从算法能力到数据处理能力,全方位考察候选人的综合素质。

为了帮助大数据开发者准备面试,本文整理了一份史上最全的大数据面试题,供参考使用。

一、Hadoop基础知识1·Hadoop的核心组件有哪些?分别简要介绍。

2·HDFS的特点和工作原理是什么?3·MapReduce的工作原理是什么?举例说明MapReduce的运行流程。

4·Hadoop集群的搭建步骤和注意事项是什么?5·Hadoop环境中如何进行数据备份和恢复操作?二、Hadoop生态系统1·Hive和HBase有什么区别?适用场景分别是什么?2·Pig和Hive的功能和使用场景有何异同?3·Sqoop和Flume的作用及使用场景有哪些?4·ZooKeeper的作用是什么?简要介绍其应用场景。

5·Spark和Hadoop的区别是什么?它们之间如何共同工作?三、大数据处理技术1·数据采集的方法有哪些?请简要说明每种方法的原理和适用场景。

2·数据清洗的过程和步骤有哪些?如何处理用户输入的脏数据?3·数据存储有哪些方式?请简要介绍每种方式的特点和适用场景。

4·数据挖掘常用的算法有哪些?请简要说明每种算法的原理和适用场景。

5·数据可视化的方法和工具都有哪些?请简要介绍每种方法和工具的特点和适用场景。

四、大数据实战项目1·请简要介绍你参与过的大数据项目,包括项目背景、使用的技术和取得的成果。

2·在项目中如何解决数据倾斜的问题?请具体描述解决方案。

3·在项目中如何保证数据的安全性和隐私性?4·在处理大规模数据时,如何优化性能和提高效率?5·请描述一个你在项目中遇到的难题,并介绍你是如何解决的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop就业面试宝典1.0简要描述如何安装配置apache的一个开源hadoop,只描述即可,无需列出具体步骤,列出具体步骤更好。

答:1使用root账户登录2 修改IP3 修改host主机名4 配置SSH免密码登录5 关闭防火墙6 安装JDK7 解压hadoop安装包8 配置hadoop的核心文件hadoop-env.sh,core-site.xml , mapred-site.xml ,hdfs-site.xml9 配置hadoop环境变量10 格式化hadoop namenode-format11 启动节点start-all.sh2.0 请;列出正常的hadoop集群中hadoop都分别需要启动哪些进程,他们的作用分别都是什么,请尽量列的详细一些。

答:namenode:管理集群,存储数据的原信息,并管理记录datanode中的文件信息。

Secondname:可以做冷备,对一定范围内数据做快照性备份。

Datanode:存储数据Jobtracker :管理任务,并将任务分配给tasktracker。

Tasktracker: 执行JobTracker分配的任务。

3.0请写出以下的shell命令(1)杀死一个job(2)删除hdfs上的/tmp/aaa目录(3)加入一个新的存储节点和删除一个节点需要执行的命令答:(1)hadoop job –list 得到job的id,然后执行hadoop job -kill jobId就可以杀死一个指定jobId的job工作了。

(2)hadoop fs -rmr /tmp/aaa(3) 增加一个新的节点在新的几点上执行Hadoop daemon.sh start datanodeHadooop daemon.sh start tasktracker然后在主节点中执行hadoop dfsadmin -refreshnodes删除一个节点的时候,只需要在主节点执行hadoop mradmin -refreshnodes4.0请列出你所知道的hadoop调度器,并简要说明其工作方法答:Fifo schedular :默认,先进先出的原则Capacity schedular :计算能力调度器,选择占用最小、优先级高的先执行,依此类推。

Fair schedular:公平调度,所有的job 具有相同的资源。

5.0请列出你在工作中使用过的开发mapreduce的语言答:java,hive6.0当前日志采样格式为a ,b ,c , db , b , f , ea , a , c , f请你用最熟悉的语言编写mapreduce,计算第四列每个元素出现的个数Static final String答:public class WordCount1 {public static final String INPUT_PA TH = "hdfs://hadoop0:9000/in";public static final String OUT_PATH = "hdfs://hadoop0:9000/out";public static void main(String[] args) throws Exception {Configuration conf = new Configuration();FileSystem fileSystem = FileSystem.get(conf);if(fileSystem.exists(new Path(OUT_PA TH))){}fileSystem.delete(new Path(OUT_PA TH),true);Job job = new Job(conf,WordCount1.class.getSimpleName());//1.0读取文件,解析成key,value对FileInputFormat.setInputPaths(job,new Path(INPUT_PA TH));//2.0写上自己的逻辑,对输入的可以,value进行处理,转换成新的key,value对进行输出job.setMapperClass(MyMapper.class);job.setMapOutputKeyClass(Text.class);job.setMapOutputValueClass(LongWritable.class);//3.0对输出后的数据进行分区//4.0对分区后的数据进行排序,分组,相同key的value放到一个集合中//5.0对分组后的数据进行规约//6.0对通过网络将map输出的数据拷贝到reduce节点//7.0 写上自己的reduce函数逻辑,对map输出的数据进行处理job.setReducerClass(MyReducer.class);job.setOutputKeyClass(Text.class);job.setOutputValueClass(LongWritable.class);FileOutputFormat.setOutputPath(job, new Path(OUT_PA TH));job.waitForCompletion(true);}static class MyMapper extends Mapper<LongWritable, Text, Text, LongWritable>{ @Overrideprotected void map(LongWritable k1, Text v1,org.apache.hadoop.mapreduce.Mapper.Context context)throws IOException, InterruptedException {String[] split = v1.toString().split("\t");for(String words :split){context.write(split[3], 1);}}}static class MyReducer extends Reducer<Text, LongWritable, Text, LongWritable>{protected void reduce(Text k2, Iterable<LongWritable> v2,org.apache.hadoop.mapreduce.Reducer.Context context)throws IOException, InterruptedException {Long count = 0L;for(LongWritable time : v2){count += time.get();}context.write(v2, new LongWritable(count));}}}7.0你认为用java ,streaming ,pipe方式开发map/reduce ,各有哪些优点就用过java 和hiveQL。

Java 写mapreduce 可以实现复杂的逻辑,如果需求简单,则显得繁琐。

HiveQL 基本都是针对hive 中的表数据进行编写,但对复杂的逻辑很难进行实现。

写起来简单。

8.0 hive有哪些方式保存元数据,各有哪些优点三种:内存数据库derby,挺小,不常用。

本地mysql。

常用远程端mysql。

不常用上网上找了下专业名称:single user mode..multi user mode...remote user mode9.0 请简述hadoop怎样实现二级排序第一种方法是,Reducer将给定key的所有值都缓存起来,然后对它们再做一个Reducer 内排序。

但是,由于Reducer需要保存给定key的所有值,可能会导致出现内存耗尽的错误。

第二种方法是,将值的一部分或整个值加入原始key,生成一个合成key。

这两种方法各有优势,第一种方法可能会更快一些(但有内存耗尽的危险),第二种方法则是将排序的任务交给MapReduce框架,更符合Hadoop/Reduce的设计思想。

这篇文章里选择的是第二种。

我们将编写一个Partitioner,确保拥有相同key(原始key,不包括添加的部分)的所有数据被发往同一个Reducer,还将编写一个Comparator,以便数据到达Reducer后即按原始key分组。

10.简述hadoop实现jion的几种方法利用dataJoin来实现mapreduce的jion问题。

11.0 请用java实现非递归二分查询1.public class BinarySearchClass2.{3.4. public static int binary_search(int[] array, int value)5. {6. int beginIndex = 0;// 低位下标7. int endIndex = array.length - 1;// 高位下标8. int midIndex = -1;9. while (beginIndex <= endIndex) {10.midIndex = beginIndex + (endIndex - beginIndex) / 2;//防止溢出11. if (value == array[midIndex]) {12. return midIndex;13. } else if (value <array[midIndex]) {14.endIndex = midIndex - 1;15. } else {16.beginIndex = midIndex + 1;17. }18. }19. return -1;20. //找到了,返回找到的数值的下标,没找到,返回-121. }22.23.24. //start 提示:自动阅卷起始唯一标识,请勿删除或增加。

25. public static void main(String[] args)26. {27. System.out.println("Start...");28. int[] myArray = new int[] { 1, 2, 3, 5, 6, 7, 8, 9 };29. System.out.println("查找数字8的下标:");30. System.out.println(binary_search(myArray, 8));31. }32. //end //提示:自动阅卷结束唯一标识,请勿删除或增加。