基于新浪微博的用户信息爬虫及分析

基于Python的新浪微博用户信息爬取与分析

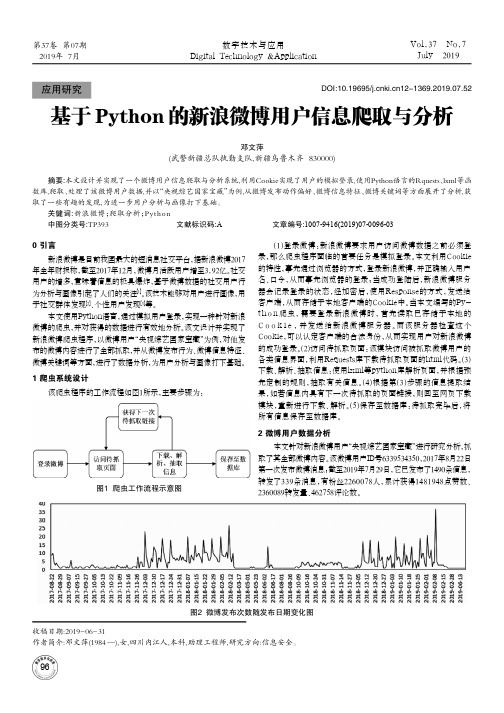

该爬虫程序的工作流程如图1所示,主要步骤为:

(1)登录微博:新浪微博要求用户访问微博数据之前必须登 录,那么爬虫程序面临的首要任务是模拟登录。本文利用Cookie 的特性,事先通过浏览器的方式,登录新浪微博,并正确输入用户 名、口令,从而事先浏览器的登录;当成功登陆后,新浪微博服务 器会记录登录的状态,经加密后,使用Response的方式,发送给 客户端,从而存储于本地客户端的Cookie中。当本文编写的Pyth o n 爬虫, 需要登录新浪微博时, 首先读取已存储于本地的 C o o k i e , 并发送 给新 浪微 博服 务器。而该 服务 器检 查这个 Cookie,可以认定客户端的合法身份,从而实现用户对新浪微博 的成功登录。(2)访问待抓取页面:该模块访问被抓取微博用户的 各类信息界面,利用Requests库下载待抓取页面的html代码。(3) 下载、解析、抽取信息:使用lxml等python库解析页面,并根据预 先定制的规则,抽取有关信息。(4)根据第(3)步骤的信息提取结 果,如若信息内具有下一次待抓取的页面链接,则回至网页下载 模块,重新进行下载、解析。(5)保存至数据库:待抓取完毕后,将 所有信息保存至数据库。

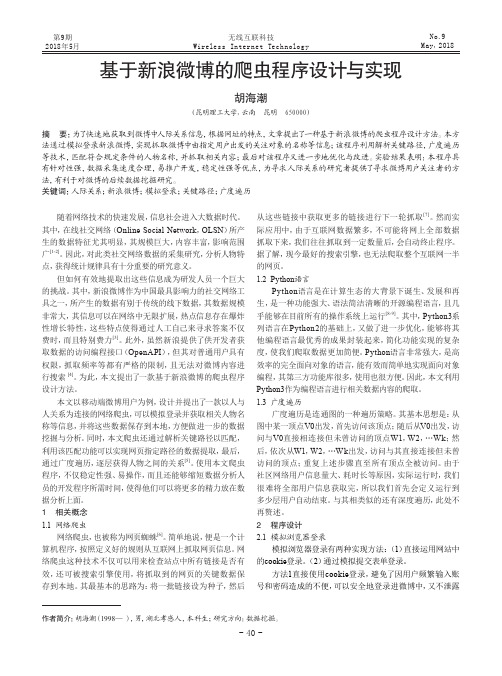

本文使用Python语言,通过模拟用户登录,实现一种针对新浪 微博的爬虫,并对获得的数据进行有效地分析。该文设计并实现了 新浪微博爬虫程序,以微博用户“央视综艺国家宝藏”为例,对他发 布的微博内容进行了全部抓取,并从微博发布行为、微博信息特征、 微博关键词等方面,进行了数据分析,为用户分析与画像打下基础。

本文设计并实现了一个微博用户信息爬取与分析系统利用cookie实现了用户的模拟登录使用python语言的rquestslxml等函数库爬取处理了该微博用户数据并以央视综艺国家宝藏为例从微博发布动作偏好微博信息特征微博关键词等方面展开了分析获取了一些有趣的发现为进一步用户分析与画像打下基础

基于新浪微博的爬虫程序设计与实现

第9期2018年5月No.9May,2018无线互联科技Wireless Internet Technology随着网络技术的快速发展,信息社会进入大数据时代。

其中,在线社交网络(Online Social Network ,OLSN )所产生的数据特征尤其明显,其规模巨大,内容丰富,影响范围广[1-2]。

因此,对此类社交网络数据的采集研究,分析人物特点,获得统计规律具有十分重要的研究意义。

但如何有效地提取出这些信息成为研发人员一个巨大的挑战。

其中,新浪微博作为中国最具影响力的社交网络工具之一,所产生的数据有别于传统的线下数据,其数据规模非常大,其信息可以在网络中无限扩展,热点信息存在爆炸性增长特性,这些特点使得通过人工自己来寻求答案不仅费时,而且特别费力[3]。

此外,虽然新浪提供了供开发者获取数据的访问编程接口(OpenAPI ),但其对普通用户具有权限,抓取频率等都有严格的限制,且无法对微博内容进行搜索 [4]。

为此,本文提出了一款基于新浪微博的爬虫程序设计方法。

本文以移动端微博用户为例,设计并提出了一款以人与人关系为连接的网络爬虫,可以模拟登录并获取相关人物名称等信息,并将这些数据保存到本地,方便做进一步的数据挖掘与分析。

同时,本文爬虫还通过解析关键路径以匹配,利用该匹配功能可以实现网页指定路径的数据提取,最后,通过广度遍历,逐层获得人物之间的关系[5]。

使用本文爬虫程序,不仅稳定性强、易操作,而且还能够缩短数据分析人员的开发程序所需时间,使得他们可以将更多的精力放在数据分析上面。

1 相关概念1.1 网络爬虫网络爬虫,也被称为网页蜘蛛[6]。

简单地说,便是一个计算机程序,按照定义好的规则从互联网上抓取网页信息。

网络爬虫这种技术不仅可以用来检查站点中所有链接是否有效,还可被搜索引擎使用,将抓取到的网页的关键数据保存到本地。

其最基本的思路为:将一批链接设为种子,然后从这些链接中获取更多的链接进行下一轮抓取[7]。

微博爬虫采集数据详细方法

新浪微博上有很多用户发布的社交信息数据,对于做营销或者运营行业的朋友来说,这些数据都非常的具有价值,比如做营销的同学可以根据微博的阅读量、转化量以及评论数等数据可以大致的判断这个人是否具有影响力,从而找到自身行业中的KOL。

另外像微博的评论数据,能反应出自身产品对于用户的口碑如何,利用爬虫采集数据,可以第一时间找到自身产品的缺点,从而进行改进。

那么,说了这么多,应该如何利用微博爬虫去采集数据呢。

步骤1:创建采集任务1)进入主界面,选择“自定义模式”2)将要采集的网址复制粘贴到网站输入框中,点击“保存网址”步骤2:创建翻页循环1)系统自动打开网页,进入微博页面。

在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。

将当前微博页面下拉至底部,出现“正在加载中,请稍后”的字样。

等待约2秒,页面会有新的数据加载出来。

经过2次下拉加载,页面达到最底部,出现“下一页”按钮微博爬虫采集数据方法图3“打开网页”步骤涉及Ajax下拉加载。

打开“高级选项”,勾选“页面加载完成后向下滚动”,设置滚动次数为“4次”,每次间隔“3秒”,滚动方式为“直接滚动到底部”,最后点击“确定”微博爬虫采集数据方法图4注意,这里的滚动次数、间隔时间,需要针对网站进行设置,可根据相关功能点教程进行学习:八爪鱼7.0教程——AJAX滚动教程八爪鱼7.0教程——AJAX点击和翻页教程/tutorial/ajaxdjfy_7.aspx?t=12)将页面下拉到底部,点击“下一页”按钮,在右侧的操作提示框中,选择“循环点击下一页”微博爬虫采集数据方法图5此步骤同样涉及了Ajax下拉加载。

打开“高级选项”,勾选“页面加载完成后向下滚动”,设置滚动次数为“4次”,每次间隔“3秒”,滚动方式为“直接滚动到底部”,最后点击“确定”微博爬虫采集数据方法图6步骤3:创建列表循环1)移动鼠标,选中页面里的第一条微博链接。

选中后,系统会自动识别页面里的其他相似链接。

基于网络爬虫的新浪微博数据分析网站的建立

2018年2月基于网络爬虫的新浪微博数据分析网站的建立赖敬之(东南大学信息科学与工程学院,江苏南京211189)【摘要】新浪微博作为国内最大的社交网站,蕴含着丰富的信息。

本文实现了一个微博数据分析网站,该网站的后端利用爬虫实时抓取数据并存储到redis 数据库中,前端利用ajax 轮询技术和数据可视化技术将统计分析后的数据展示到网页。

相对于直接调用新浪微博的API ,网络爬虫获取数据的方式有更大的灵活性,可以获取到的数据也相对较多,但是也存在一些限制,其中最大的阻碍就是新浪微博的反爬虫技术,本文也将对如何突破反爬虫限制进行探讨。

【关键词】新浪;爬虫;数据分析【中图分类号】TP391.3【文献标识码】A 【文章编号】1006-4222(2018)02-0073-021引言新浪微博,是一种以关注分享为模式的新兴社交媒体,其内容少、发布快、形式多样正好迎合了人们对信息实时的、准确的、多样的分享交流需求,因此受到广大用户的欢迎与喜爱,而微博本身一跃成为当代互联网领域新兴、火热的明星。

人们热衷在微博上获取最新资讯,表达自己观点,分享喜爱的事物。

因此,微博上蕴含了丰富的数据,具有重要的数据挖掘意义。

网络爬虫,是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。

使用爬虫,可以方便、自动的获取海量数据,灵活性高。

本文首先介绍了新浪微博数据分析网站的整体思路,然后介绍如何使用爬虫获取新浪微博的数据,其中也对使用的反爬虫技术进行了介绍,最后本文探讨了如何将数据实时展示到前端,并对可视化的方法逐一进行了展示。

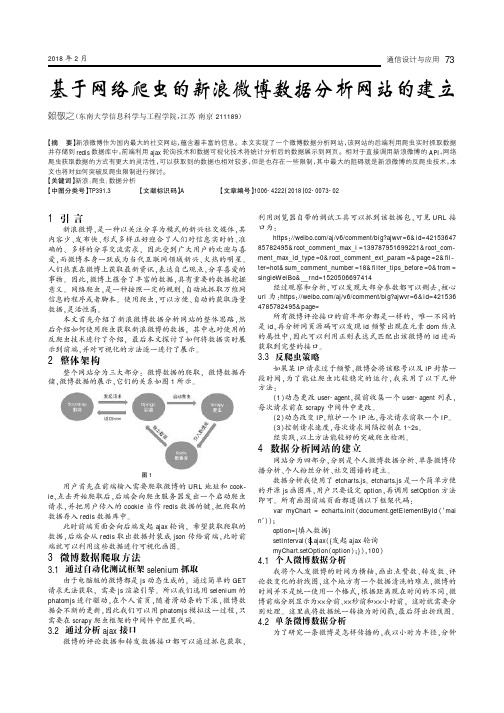

2整体架构整个网站分为三大部分:微博数据的爬取,微博数据存储,微博数据的展示,它们的关系如图1所示。

用户首先在前端输入需要爬取微博的URL 地址和cook ⁃ie ,点击开始爬取后,后端会向爬虫服务器发出一个启动爬虫请求,并把用户传入的cookie 当作redis 数据的键,把爬取的数据存入redis 数据库中。

微博爬虫抓取方法

微博爬虫一天可以抓取多少条数据微博是一个基于用户关系信息分享、传播以及获取的平台。

用户可以通过WEB、WAP等各种客户端组建个人社区,以140字(包括标点符号)的文字更新信息,并实现即时分享。

微博作为一种分享和交流平台,十分更注重时效性和随意性。

微博平台上产生了大量的数据。

而在数据抓取领域,不同的爬虫工具能够抓取微博数据的效率是质量都是不一样的。

本文以八爪鱼这款爬虫工具为例,具体分析其抓取微博数据的效率和质量。

微博主要有三大类数据一、博主信息抓取采集网址:/1087030002_2975_2024_0采集步骤:博主信息抓取步骤比较简单:打开要采集的网址>建立翻页循环(点击下一页)>建立循环列表(直接以博主信息区块建立循环列表)>采集并导出数据。

采集结果:一天(24小时)可采集上百万数据。

微博爬虫一天可以抓取多少条数据图1具体采集步骤,请参考以下教程:微博大号-艺术类博主信息采集二、发布的微博抓取采集网址:采集步骤:这类数据抓取较为复杂,打开网页(打开某博主的微博主页,经过2次下拉加载,才会出现下一页按钮,因而需对步骤,进行Ajax下拉加载设置)>建立翻页循环(此步骤与打开网页步骤同理,当翻到第二页时,同样需要经过2次下来加载。

因而也需要进行Ajax下拉加载设置)>建立循环列表(循环点击每条微博链接,以建立循环列表)>采集并导出数据(进入每条微博的详情页,采集所需的字段,如:博主ID、微博发布时间、微博来源、微博内容、评论数、转发数、点赞数)。

采集结果:一天(24小时)可采集上万的数据。

微博爬虫一天可以抓取多少条数据图2具体采集步骤,请参考以下教程:新浪微博-发布的微博采集三、微博评论采集采集网址:https:///mdabao?is_search=0&visible=0&is_all=1&is_tag=0&profile_fty pe=1&page=1#feedtop采集步骤:微博评论采集,采集规则也比较复杂。

基于网络爬虫的新浪微博数据抓取技术

1引言随着移动互联网的飞速发展,人们越来越多地在社交网络上发表自己的见解,分享自己的生活,与他人进行交流讨论。

新浪微博作为国内最大的社交平台之一,同时也成了各类消息发布的最主要渠道之一。

截至2017年9月,微博月活跃用户3.76亿,日活跃用户1.65亿,每天都有用户发布上亿条微博,评论、转发或点赞其他微博。

一个如此庞大和公开的社交平台,每天都能产生海量信息,能为各种舆情监控、商业推广分析、自然语言处理等系统提供大量的数据支持[1]。

在国外,开展了针对于Twitter和Facebook等社交平台的一系列研究,但是不同于国外的Twitter和Facebook等平台,微博官方并没有提供相关接口给人们下载与微博相关的数据集,并且微博的登录、浏览等操作都有较敏感的反爬虫机制,这给数据的采集带来了困难,对普通的想获取相关数据的人员来说是个极大的挑战。

因此,快速获得微博数据的方法就是构建一个稳定高效的爬虫抓取系统。

2网络爬虫2.1原理网络爬虫(Web Crawler),是自动地抓取万维网信息的程序或者脚本,它们被广泛用于互联网搜索引擎或其他类似网站。

爬虫一般分为数据采集、处理和储存三个部分。

传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL 放入队列,直到满足系统的一定停止条件。

2.2网络爬虫框架ScrapyScrapy是Python开发的一个快速、可扩展的Web抓取框架,用于抓取Web站点并从页面中提取结构化的数据。

通过Scrapy中的Spider模块,能方便地定义网址爬取和数据提取的规则。

3微博爬虫策略现在各种爬虫的搜索策略[2]主要为:深度优先搜索策略、广度优先搜索策略、非完全PageRank策略以及大站优先搜索策略。

微博跟其他普通网站相比,动态性和网页结构都比较复杂,其对于爬虫的防范也更加严格,普通的爬虫程序一般不能直接获取到相应的网页内容,但其网页内容中的数据格式较为统一。

基于Python的新浪微博爬虫程序设计与实现

基于Python的新浪微博爬虫程序设计与实现孙握瑜(安徽商贸职业技术学院信息与人工智能学院安徽芜湖241000)摘要:在互联网时代,各类新媒体平台出现使得信息数据得到广泛传播。

为加强对新浪微博内容的监管和分析,应对舆情分析的需求,该文主要研究采用Python语言设计新浪微博爬虫程序,在对网络爬虫基本概念和原理研究的基础上,设计了具有配置、爬取、存储、分析这4个功能模块的应用程序,为媒体内容监管和数据分析提供了技术支持。

关键词:Python新浪微博网络爬虫舆情分析中图分类号:TP393.092;TP391.1文献标识码:A文章编号:1672-3791(2022)06(b)-0034-04 Design and Lmplementation of Sina Weibo Crawler ProgramBased on PythonSUN Woyu(School of Information and Artificial Intelligence,Anhui Business College of Vocational Technology,Wuhu,AnhuiProvince,241000China)Abstract:In the Internet era,the emergence of various new media platforms makes information and data widely disseminated.In order to strengthen the management of Sina Weibo information and meet the needs of public opinion analysis,this paper focuses on the design of Sina Weibo crawler program in Python language.Based on the research on the basic concept and principle of web crawler,an application program with four functional modules of configuration,crawling,storage and analysis is designed.It provides technical support for media content manage‐ment and data analysis.Key Words:Python;Sina Weibo;Web crawler;Public opinion analysis随着互联网技术的快速革新,新媒体平台层见叠出,广大网民可以通过互联网平台发表观点和记录日常生活,各类消息事件也得到了广泛传播,为我们带来了信息爆炸的时代,拓宽了广大人民群众的视野,同时也带来了一系列舆情风险。

基于新浪微博的用户信息爬虫及分析

目录摘要 (I)Abstract (II)1 引言 (3)1.1 选题背景与意义 (3)1.2 系统开发工具 (3)1.2.1 vs 2008 (3)1.2.2 oracle 11g (3)1.2.3 boost库 (3)1.2.4 GZIP压缩算法函数库 (3)1.2.5 JSON格式文件转换函数库 (4)2 系统需求分析与设计 (5)2.1 系统需求 (5)2.1.1 名词说明 (5)2.1.2 系统功能需求说明 (5)2.1.3 系统总体功能设计 (7)2.2 系统数据库构建 (9)2.2.1 数据库设计 (9)2.2.2 数据库详细设计 (9)3 系统详细设计与实现 (12)3.1 爬虫系统详细设计 (12)3.1.1 HTTP请求数据包 (12)3.1.2 HTTP返回数据包 (13)3.1.3 数据分析与提取 (13)3.1.4 AnaData类 (13)3.1.5 数据入库 (15)3.2服务端详细设计 (16)3.3客户端详细设计 (17)3.3.1 登录页面 (17)3.3.2 注册新用户和忘记密码页面 (18)3.3.3 用户关注列表查询界面 (19)3.3.4 微博用户标签分类查询 (20)3.3.4 发布微博并@列表框中的微博用户昵称 (20)3.3.5 微博用户昵称模糊搜索 (21)3.3.6 微博用户微博查询 (21)4 系统部署与测试 (22)4.1 系统部署图 (22)4.2 系统测试 (22)5 结束语 (29)参考文献 (30)致谢 (31)摘要随着互联网信息技术的发展,在这个信息时代,数据量的增长速度已经远远超过的我们的想象。

迅速的对这些数据进行处理,进行信息的提取已经成为目前计算机领域一个巨大的难题。

而且无论是政府还是企业,对于大数据的掌握都可以起着至关重要的作用。

数据处理技术蕴含的巨大的商业价值必将被慢慢的挖掘出来。

本文以新浪微博作为信息载体。

对新浪微博的用户信息进行收集和分析,对新浪微博信息数据转化成价值的可行性进行了尝试。

基于Python的新浪微博爬虫研究

文章分析了新浪API的一些认证 限制,新版的API需要被

方法,构建相应的URL来模拟这一滚动过程 。

搜索用户提供相应 的授权 ,因此采用传统爬虫的方 式。然后

4 关 键 词 的提 取

模 拟 登陆 、网页分 析、关键 词 提取等 三个方 面介 绍 了如何 爬 取

这个爬虫程序还有一个可以对爬取 到的微博内容进行分 新浪微博信息,研究用户登陆微博的过程 ,从 网页源代码中

仔 细观察可 以发现 ,每 条微 博都 以<div class=’WB

过 滤 掉之 后 ,可能会 有 多个 词出现 的次 数一 样多,但 这并

cardwrap …>作为起 始,而其 中的<a class=”W texta 不意味着这些词的关键性是一样 的。因此 ,还需要一个重要

w—fb”…>节点含有 昵称 ,<p class=”comment txt”>节点 性调整系数来衡量一个词是不是常见词。如果某个词比较少

出现 ,于是,进行 “词频”(TF)统计。但 是,出现次数最多的

【参考文献】

【1]郭晓云.基于Python和Selenium的新浪微博数据访 问【J].电脑编程技巧与维护,2012. [2]齐鹏,李隐峰,宋玉伟.基于Python的web数据采集技术 [J].电子科技 ,2012. [33]阮二 峰 TF_IDF与余 弦相 似 性 的应 用 【EB/OL】.(2013-03-15).http://www.ruanyifeng.com/blog/2013/03/tf-idf.html

第 6期 2015年 3月

无 线 互 联 科 技 ·计 算 机 世 界

N0.6 MarCh,2015

基于Python的新浪微博爬虫分析

2019年软 件2019, V ol. 40, No. 4作者简介:杜晓旭(1994-),女,在读硕士,研究方向:大数据分析;贾小云(1971-),女,副教授、CCF 会员,硕士,研究方向:大数据分析、软件工程。

基于Python 的新浪微博爬虫分析杜晓旭,贾小云(陕西科技大学,陕西 西安 710021)摘 要: 在大数据时代下,新浪微博的出现为人们获取和参与信息数据及其传播提供了全新的途径。

而面对新浪微博不断增加的信息数据,人们对于提高微博获取的精确性和时效性也提出了更高的要求。

在这一背景下,本文将重点围绕基于Python 的新浪微博爬虫进行简要分析研究,在对Python 与网络爬虫的基本概念进行明确的基础上,尝试设计一种Python 的新浪微博爬虫程序,为相关研究人员提供相应理论参考。

关键词: Python ;新浪微博;网络爬虫;程序设计中图分类号: TP311.1 文献标识码: A DOI :10.3969/j.issn.1003-6970.2019.04.039本文著录格式:杜晓旭,贾小云. 基于Python 的新浪微博爬虫分析[J]. 软件,2019,40(4):182-185Python-based Crawler Analysis of Sina WeiboDU Xiao-xu, JIA Xiao-yun(Shaanxi University of Science and Technology, Xi'an, Shaanxi 710021)【Abstract 】: During big data era, emergence of Sina Weibo provides new way for people to access and participate in information data and its dissemination. With increasing information and data of Sina Weibo, people put forward higher requirements for improving accuracy and timeliness of microblog acquisition. Under the backgroud, the pa-per analyzes and researches Python-based Sina Weibo crawler briefly, defines basic concepts of Python and Internet crawler, and attempts to design a Python Weibo crawler program, to provide related theoretical reference for re-searchers.【Key words 】: Python; Sina Weibo; Web crawler; Programming0 引言虽然目前以新浪微博为代表的众多社会媒体均为研发人员提供了部分数据访问编程接口,使其能够准确获取相关信息数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

目录摘要 (I)Abstract (II)1 引言 (3)1.1 选题背景与意义 (3)1.2 系统开发工具 (3)1.2.1 vs 2008 (3)1.2.2 oracle 11g (3)1.2.3 boost库 (3)1.2.4 GZIP压缩算法函数库 (3)1.2.5 JSON格式文件转换函数库 (4)2 系统需求分析与设计 (5)2.1 系统需求 (5)2.1.1 名词说明 (5)2.1.2 系统功能需求说明 (5)2.1.3 系统总体功能设计 (7)2.2 系统数据库构建 (9)2.2.1 数据库设计 (9)2.2.2 数据库详细设计 (9)3 系统详细设计与实现 (12)3.1 爬虫系统详细设计 (12)3.1.1 HTTP请求数据包 (12)3.1.2 HTTP返回数据包 (13)3.1.3 数据分析与提取 (13)3.1.4 AnaData类 (13)3.1.5 数据入库 (15)3.2服务端详细设计 (16)3.3客户端详细设计 (17)3.3.1 登录页面 (17)3.3.2 注册新用户和忘记密码页面 (18)3.3.3 用户关注列表查询界面 (19)3.3.4 微博用户标签分类查询 (20)3.3.4 发布微博并@列表框中的微博用户昵称 (20)3.3.5 微博用户昵称模糊搜索 (21)3.3.6 微博用户微博查询 (21)4 系统部署与测试 (22)4.1 系统部署图 (22)4.2 系统测试 (22)5 结束语 (29)参考文献 (30)致谢 (31)摘要随着互联网信息技术的发展,在这个信息时代,数据量的增长速度已经远远超过的我们的想象。

迅速的对这些数据进行处理,进行信息的提取已经成为目前计算机领域一个巨大的难题。

而且无论是政府还是企业,对于大数据的掌握都可以起着至关重要的作用。

数据处理技术蕴含的巨大的商业价值必将被慢慢的挖掘出来。

本文以新浪微博作为信息载体。

对新浪微博的用户信息进行收集和分析,对新浪微博信息数据转化成价值的可行性进行了尝试。

设计出了一个可以获取新浪微博信息的数据收集系统,并进行一定的数据分析和数据展示。

关键词:C++,新浪微博,数据挖掘AbstractWith the Internet development of information technology, in this age of information, the amount of data growth has far exceeded our imagination. Rapid processing of these data, the extraction of information has become a huge problem in the computer field. And whether government or corporate, can grasp for big data plays a vital role. The tremendous commercial value of data processing technology is bound to be slowly excavated.In this paper, Sina Weibo as an information carrier. Sina Weibo user information collection and analysis the Sina microblogging data into the value of the feasibility of a try. Design one can get the the Sina microblogging information system of data collection and data analysis and data presentation.Keywords: c++ ,Sina Weibo,Data Mining1 引言1.1 选题背景与意义随着互联网信息技术的发展,目前的信息增长的速度已经进入了飞速膨胀的阶段。

“如果说IBM的主机拉开了信息化革命的大幕,那么‘大数据’才是第3次浪潮的华彩乐章。

”著名未来学家、当今世界最具影响力的社会思想家之一托夫勒在《第三次浪潮》中说过的内容如今已将逐渐成为事实,大数据正在改变这我们的生活。

IDC(国际数据公司)在2011年6月的数据统计[1],全球数据量在2011年已达到1.8ZB,在过去5年时间里数据量增加了5倍。

1.8ZB是什么样的概念?1ZB等于1万亿GB,1.8ZB 也就相当于18亿个1T的硬盘。

有效的对这些数据处理,去噪和提取信息,将数据转换成价值的技术已成为目前市场最为广阔的研究课题。

例如数据挖掘,分布式计算,机器学习等等新的信息技术的产生,他们目的都是为了能够从这无比巨大的数据中,获取能够用于商业决策和企业管理的信息[2]。

新浪微博于2009年正式上线,至2010年11月,新浪召开首届微博开发者大会时披露其微博用户突破5000万。

2011年3月,新浪CEO曹国伟在发布财报时介绍称,其微博的注册用户总数已超过1亿。

目前,新浪微博用户量已达到5亿。

因此,新浪微博的数据具有极大的开发潜力。

新浪微博数据平台是一个良好的数据载体。

除了足够大的数据量,相比与腾讯QQ 空间,百度贴吧等,新浪微博还具有其他一些优点,如:1)具有一定的实名制,一些社会名人的加入提高了微博的影响力。

2)可追寻的关系链。

3)具有极快速的传播能力。

因此,我选择了新浪微博作为爬虫进行用户分析的数据载体。

1.2 系统开发工具1.2.1 vs 20081.2.2 oracle 11g1.2.3 boost库Boost库是一个可移植、提供源代码的C++库,作为标准库的后备,是C++标准化进程的发动机之一。

Boost库有些内容有望成为下一代C++标准库内容。

甚至替代现在的STL库。

boost库在多线程处理上具有更多的优势,可以在linux 和window系统中使用而不用修改代码,除了强大的可移植性,boost在运行中也具有极大的稳定性,因为加入了智能指针的概念,提高了开发效率。

[3]1.2.4 GZIP压缩算法函数库从新浪接口获取的数据数经过gzip压缩加密的数据,进行解压后即可获得json文件格式的数据。

GZIP最早由Jean-loup Gailly和Mark Adler创建,最初用于UNIX系统的文件压缩。

而现今它已经成为Internet 上使用非常普遍的一种数据压缩格式,或者说一种文件格式,可以很好的对数据进行压缩。

GZIP编码是可以很好的提高WEB应用程序的性能。

大流量的WEB站点常常使用GZIP 压缩技术来让用户感受更快的速度。

当访问服务器中的网站时,服务器将网页内容压缩在进行传输,一般对纯文本内容可压缩到原大小的40%.[4]1.2.5 JSON格式文件转换函数库因为新浪微博的数据接口格式为json。

为了获取微博数据,必须从JSON数据里面提取需要的信息。

JSON(JavaScript Object Notation) 是一种轻量级的数据交换格式。

JSON采用完全独立于语言的文本格式,JSON是一种理想的数据交换语言。

易于人阅读和编写,同时也易于机器解析和生成。

[5]2 系统需求分析与设计2.1 系统需求2.1.1 名词说明1)微博用户信息:指的是新浪微博的用户的ID、粉丝数、关注数、注册时间等信息、2)微博信息:指的是微博用户发布的微博的ID、内容、发布时间,评论数,转发数等信息。

3)用户:指的是使用本系统的用户。

2.1.2 系统功能需求说明微博开放平台是一个基于新浪微博客系统的开放的信息订阅、分享与交流平台。

微博开放平台提供了海量的微博信息、粉丝关系、以及随时随地发生的信息裂变式传播渠道。

系统分成三个部分:数据爬虫,服务器端,客户端。

(1)数据爬虫通过调用微博开放平台的接口,获取微博用户及其相应的信息,进行分析后存入数据库。

(2)服务器部分接收客户端的请求,从服务器数据库或新浪平台获取数据后返回相应的数据给客户端。

(3)客户端用于数据的展示。

1)微博数据爬虫部分:为了实现数据爬虫的功能,需要解决的问题是数据的获取,这就需要了解相关的基本的网络知识。

理解了数据传输的原理,并利用现有的开源函数库,就可以完成数据获取函数的编写。

其中,主要要处理的问题有:(1)实现HTTP请求报文的生成(2)实现HTTP返回报文的接收和解压(3)实现对解压后的json文件进行分析和信息提取,如果需要入库,存入入库队列。

2)微博数据爬虫基本需求:(1)数据信息初始化:读取数据库中已有的信息,存入微博用户缓存队列。

为爬虫系统的运行做好准备。

(2)微博用户发现:自动爬取获取新的微博用户信息,如果发现新的微博用户ID,则将该用户信息存入。

(3)微博信息爬取:从微博用户队列中获取微博用户ID,然后进行微博爬取。

(4)微博用户信息更新模块:对数据库中的微博用户信息中的微博数,关注数,粉丝数进行更新。

(5)关注列表信息更新:定期的对关注列表的微博数,总评论数,总转发数等数据。

(6)微博用户信息入库。

将等待入库的数据容器里的数据存入数据库。

(7)微博信息入库。

将等待入库的数据容器里的数据存入数据库。

(8)微博用户标签入库。

将等待入库的数据容器里的数据存入数据库。

(9)数据更新。

当数据库已存在的该数据是,对数据进行更新。

2)服务器部分:(1)命令接收及处理:接收客户的请求,并从数据库和微博平台中获取信息并返回给客户端。

新增的关注微博用户的微博爬取:(2)当客户端新增了微博用户的关注时,进行数据爬取。

微博信息入库。

3)客户端部分:(1)登录模块:(2)新用户注册模块:(3)通过邮箱获取注册验证码进行注册。

(3)忘记密码模块:(4)向注册邮箱发送用户名和密码。

(5)用户关注的微博用户列表查询。

(6)获取关注列表的详细信息。

(7)查询数据库中的用户标签分类后产生的数据:(8)通过标签类别和拟合度两个参数向服务器请求信息。

(9)微博用户模糊联想搜索:(10)通过微博平台的联想搜索接口查询数据。

(11)发布微博并对列表框的微博账号进行@。

2.1.3 系统总体功能设计1)爬虫系统流程如图2-1所示:图2-1 爬虫系统流程图2)接口调用处理流程如图2-2所示:图2-2 数据接口调用流程图3)服务器流程如图3-3所示:图2-3 服务器流程图4)客户端流程图如图2-4所示:图2-4 客户端流程图2.2 系统数据库构建2.2.1 数据库设计系统采用oracle 11g数据库。

数据库名称weibo。