分类与决策树

决策树分类方法

决策树分类方法决策树是一种分类模型,通过树形结构将数据样本分为若干类别。

其主要思想是根据数据的属性值进行一系列的判断和分类,直到达到最终的分类结果。

决策树的分类过程可以分为两个阶段:建立决策树模型和利用决策树对新数据进行分类。

在建立决策树模型时,主要采用三种策略:信息增益策略、信息增益比策略和基尼指数策略。

信息增益策略是一种基于熵的策略。

熵是衡量信息量的度量,可以理解为信息的不确定性。

在建立决策树时,我们希望每个子集的熵都达到最小值,以此来达到最好的分类效果。

信息增益指的是在分类前后,信息熵的变化量。

如果在某个属性上进行分类后,其信息熵减少的量越大,那么这个属性就越适合作为划分数据的依据。

信息增益比策略是一种对信息增益策略的改进。

在处理不平衡数据时,信息增益策略可能出现问题。

信息增益比策略通过引入属性分裂信息度量,解决由于属性具有不同数量的可取值而引起的信息增益偏差的问题。

基尼指数策略是一种基于基尼指数的策略。

基尼指数是用于衡量数据的不纯度。

假设数据集中存在c个类别,对于第i个类别,其出现的概率为p(i),那么基尼指数的定义为:Gini(p)=∑i=1~c p(i)·(1-p(i)) 对于某个属性的每一个可取值,可以计算出其样本的基尼指数,然后计算这些基尼指数的加权平均值,得到最终的基尼指数。

在决策树分类中,我们希望基尼指数尽可能小,以此达到最佳的分类效果。

决策树建立完成后,我们需要利用决策树对新数据进行分类。

具体来说,我们需要根据决策树的节点将数据分到相应的子集中,直到达到叶子节点。

叶子节点表示的就是分类结果。

如果决策树分类的效果不理想,我们就需要进行一些优化。

常见的优化方法包括剪枝和随机森林。

剪枝是针对决策树过拟合问题的一种方法。

在剪枝过程中,我们通过去掉那些对分类结果影响不大的节点,来降低决策树的复杂度和泛化误差。

剪枝分为预剪枝和后剪枝两种方法。

预剪枝是在建立决策树时进行剪枝,具有较好的效果。

决策树模型在文本分类中的应用实践(十)

决策树模型在文本分类中的应用实践随着社会信息化程度不断提高,数据量急剧增加,文本分类成为一种重要的数据挖掘技术。

决策树模型由于其简单易懂、可解释性强的特点,在文本分类中得到了广泛的应用。

本文将分析决策树模型在文本分类中的应用实践,并探讨其优势和局限性。

一、文本分类简介文本分类是指将文本文档按照一定的标准划分到不同的类别中。

在实际应用中,文本分类被广泛应用于垃圾邮件过滤、情感分析、新闻分类等领域。

在面对海量的文本数据时,如何快速准确地对文本进行分类成为一项重要的挑战。

二、决策树模型原理决策树是一种用于分类和预测的监督学习算法。

其核心思想是通过将输入空间划分为一系列互不相交的子集,每个子集对应于一个分类标签,从而构建一棵树形结构。

决策树的节点表示一个属性测试,分支表示属性的取值,叶节点表示类别标签。

决策树的构建过程是一个递归地选择最优属性,并将数据集划分为较小的子集的过程。

三、决策树模型在文本分类中的应用在文本分类中,决策树模型可以很好地应对高维稀疏的文本特征。

对于文本数据,通常需要进行特征提取,常见的方法包括词袋模型、TF-IDF等。

决策树模型可以直接处理这些特征,无需对文本数据进行过多的预处理。

此外,决策树模型具有较好的可解释性,可以清晰地展现出文本分类的逻辑过程,为用户提供良好的可视化效果。

四、决策树模型在情感分析中的应用案例以情感分析为例,决策树模型在文本分类中的应用实践得到了广泛的验证。

情感分析旨在识别文本中的情感极性,分为正面、负面和中性。

研究者通过构建决策树模型,将文本数据进行分类,并对其情感极性进行划分。

通过对大量的文本数据进行训练和测试,决策树模型能够准确地识别文本中所表达的情感,为企业和个人提供有价值的情感信息。

五、决策树模型的优势和局限性决策树模型在文本分类中具有较好的可解释性和适应性,能够有效地处理高维稀疏的文本特征。

然而,决策树模型也存在一些局限性,如容易过拟合、对噪声数据敏感等。

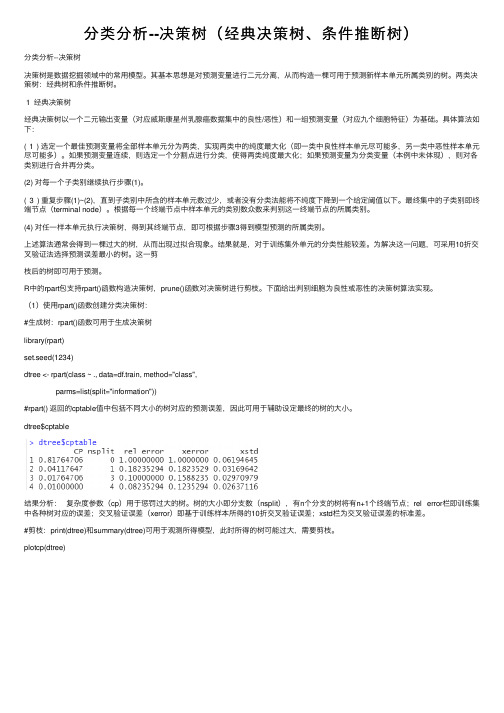

分类分析--决策树(经典决策树、条件推断树)

分类分析--决策树(经典决策树、条件推断树)分类分析--决策树决策树是数据挖掘领域中的常⽤模型。

其基本思想是对预测变量进⾏⼆元分离,从⽽构造⼀棵可⽤于预测新样本单元所属类别的树。

两类决策树:经典树和条件推断树。

1 经典决策树经典决策树以⼀个⼆元输出变量(对应威斯康星州乳腺癌数据集中的良性/恶性)和⼀组预测变量(对应九个细胞特征)为基础。

具体算法如下:(1) 选定⼀个最佳预测变量将全部样本单元分为两类,实现两类中的纯度最⼤化(即⼀类中良性样本单元尽可能多,另⼀类中恶性样本单元尽可能多)。

如果预测变量连续,则选定⼀个分割点进⾏分类,使得两类纯度最⼤化;如果预测变量为分类变量(本例中未体现),则对各类别进⾏合并再分类。

(2) 对每⼀个⼦类别继续执⾏步骤(1)。

(3) 重复步骤(1)~(2),直到⼦类别中所含的样本单元数过少,或者没有分类法能将不纯度下降到⼀个给定阈值以下。

最终集中的⼦类别即终端节点(terminal node)。

根据每⼀个终端节点中样本单元的类别数众数来判别这⼀终端节点的所属类别。

(4) 对任⼀样本单元执⾏决策树,得到其终端节点,即可根据步骤3得到模型预测的所属类别。

上述算法通常会得到⼀棵过⼤的树,从⽽出现过拟合现象。

结果就是,对于训练集外单元的分类性能较差。

为解决这⼀问题,可采⽤10折交叉验证法选择预测误差最⼩的树。

这⼀剪枝后的树即可⽤于预测。

R中的rpart包⽀持rpart()函数构造决策树,prune()函数对决策树进⾏剪枝。

下⾯给出判别细胞为良性或恶性的决策树算法实现。

(1)使⽤rpart()函数创建分类决策树:#⽣成树:rpart()函数可⽤于⽣成决策树library(rpart)set.seed(1234)dtree <- rpart(class ~ ., data=df.train, method="class",parms=list(split="information"))#rpart() 返回的cptable值中包括不同⼤⼩的树对应的预测误差,因此可⽤于辅助设定最终的树的⼤⼩。

深入浅出决策树分类(精彩故事引入)

03

数据划分

将数据集划分为训练集、验证集和测试集,以便进行模型训练和评估。

特征工程在决策树分类中应用示例

特征选择

01

通过计算特征重要性、绘制特征相关性热力图等方法,选择对

分类结果影响较大的特征。

特征构造

02

根据业务理解和数据探索,构造新的特征以增强模型的表达能

力。

特征转换

03

通过特征离散化、特征交互等方式,将原始特征转换为更适合

04 决策树分类实践案例分析

数据集选择与预处理操作指南

01

数据集选择

选择适合决策树分类的数据集,如Iris、Titanic等经典数据集,或根据

实际业务需求选择相关数据集。

02

数据预处理

包括数据清洗(处理缺失值、异常值等)、特征编码(将非数值特征转

换为数值特征)、特征缩放(将不同特征缩放到同一尺度)等操作。

采用适当的剪枝策略,简化决策树结 构,避免过拟合现象。

集成学习

将多个决策树结合起来,形成随机森 林等集成学习方法,提高分类性能和 稳定性。

特征选择

在构建决策树前,进行特征选择和降 维处理,以提高分类效率和准确性。

引入领域知识

在构建决策树时引入领域知识,指导 决策树的生成和剪枝过程。

06 拓展知识:集成学习方法 在决策树中应用

Bagging是一种并行式的集成学习 方法,它基于自助采样法,通过有 放回地重复采样来生成多个不同的 数据集,然后对每个数据集独立地 训练出一个基学习器,最后将这些 基学习器的预测结果进行结合。

Boosting是一种串行式的集成学 习方法,它通过改变训练样本的 权重,使得每轮训练都更加关注 于前一轮被错误分类的样本,从 而逐步提高学习器的性能。

分类及其应用案例

添加数据源节点

编辑“数据源节点”

节点重命名

加入表节点

“选择”节点

A1="?"

or @NULL(A2) or @NULL(A3) or A4="?" or A5="?" or A6="?" or A7="?" or @NULL(A8) or A9="?" or A10="?" or @NULL(A11) or A12="?" or A13="?" or @NULL(A14) or @NULL(A15) or A16="?"

设S代表训练数据集,由s个样本组成。A是

S的某个属性,有m个不同的取值,根据这 些取值可以把S划分为m个子集,Si表示第i 个子集(i=1,2,…,m),|Si|表示子集Si中的 样本数量。那么:

| Si | | Si | Split _ Info( S , A) ( log 2 ) s s i 1

If (年龄<40) and (职业=“学生” or职业=“教师”) Then 信用等级 =“优” If (年龄<40) and (职业!=“学生”and职业!=“教师”) Then 信用等级 =“良” If (年龄≥40) and (月薪<1000) Then 信用等级=“差” If (年龄≥40) and (月薪≥1000 and月薪≤3000) Then 信用等级=“良” If (年龄≥40) and (月薪>3000) Then 信用等级=“优”

,

“类型”节点

“抽样”节 点

“C5.0”节点

生成的决策树模型

决策树算法介绍

3.1 分类与决策树概述3.1。

1 分类与预测分类是一种应用非常广泛的数据挖掘技术,应用的例子也很多。

例如,根据信用卡支付历史记录,来判断具备哪些特征的用户往往具有良好的信用;根据某种病症的诊断记录,来分析哪些药物组合可以带来良好的治疗效果。

这些过程的一个共同特点是:根据数据的某些属性,来估计一个特定属性的值。

例如在信用分析案例中,根据用户的“年龄”、“性别”、“收入水平"、“职业”等属性的值,来估计该用户“信用度”属性的值应该取“好”还是“差",在这个例子中,所研究的属性“信用度"是一个离散属性,它的取值是一个类别值,这种问题在数据挖掘中被称为分类。

还有一种问题,例如根据股市交易的历史数据估计下一个交易日的大盘指数,这里所研究的属性“大盘指数”是一个连续属性,它的取值是一个实数。

那么这种问题在数据挖掘中被称为预测.总之,当估计的属性值是离散值时,这就是分类;当估计的属性值是连续值时,这就是预测.3。

1.2 决策树的基本原理1.构建决策树通过一个实际的例子,来了解一些与决策树有关的基本概念.表3—1是一个数据库表,记载着某银行的客户信用记录,属性包括“姓名”、“年龄”、“职业”、“月薪”、..。

..。

、“信用等级”,每一行是一个客户样本,每一列是一个属性(字段)。

这里把这个表记做数据集D.银行需要解决的问题是,根据数据集D,建立一个信用等级分析模型,并根据这个模型,产生一系列规则。

当银行在未来的某个时刻收到某个客户的贷款申请时,依据这些规则,可以根据该客户的年龄、职业、月薪等属性,来预测其信用等级,以确定是否提供贷款给该用户。

这里的信用等级分析模型,就可以是一棵决策树. 在这个案例中,研究的重点是“信用等级”这个属性。

给定一个信用等级未知的客户,要根据他/她的其他属性来估计“信用等级”的值是“优”、“良"还是“差”,也就是说,要把这客户划分到信用等级为“优”、“良"、“差"这3个类别的某一类别中去.这里把“信用等级”这个属性称为“类标号属性”。

使用决策树进行分类和回归的方法

使用决策树进行分类和回归的方法决策树是一种常见且简单易懂的机器学习算法,在数据分类和回归问题中经常被使用。

它通过构建树状结构来进行决策,将数据集分割成多个子集,每个子集对应一个决策节点。

本文将介绍使用决策树进行分类和回归的方法,并探讨其优缺点以及应用场景。

第一部分:决策树分类方法决策树分类方法是指利用决策树模型对给定数据进行分类的过程。

其基本原理是通过特征选择、节点划分、树构建和剪枝等步骤来生成一个高效、准确的分类器。

1. 特征选择:特征选择是决策树分类的第一步,它决定了每个节点应该选择哪个特征进行划分。

常用的特征选择算法包括信息增益、信息增益率和基尼系数等,这些算法都是通过计算特征的纯度或不确定性来选择最优的特征。

2. 节点划分:节点划分是指根据选择的特征将数据集分割成多个子集的过程。

划分过程一般根据特征的取值将数据分成多个不同的子集,直到所有数据都属于同一类别或达到停止条件。

3. 树构建:树构建是将选择的特征逐步添加到决策树中的过程。

树构建过程中,可以采用递归算法或迭代算法来生成一个完整的决策树。

4. 剪枝:剪枝是为了避免过拟合现象,提高决策树的泛化能力。

剪枝可以通过预剪枝和后剪枝两种方式进行,预剪枝是在树构建过程中,判断是否继续划分节点;后剪枝是在树构建完成后,通过剪枝来优化决策树模型。

第二部分:决策树回归方法决策树回归方法是指利用决策树模型对给定数据进行回归的过程。

与分类相比,回归问题更关注预测数值型数据。

1. 划分依据:决策树回归方法中,每个节点的划分依据不再是纯度或不确定性的度量,而是基于平方误差、均方差或平均绝对误差等度量指标。

划分依据是为了找到能够使子集数据的目标值尽量接近的特征。

2. 节点划分和树构建:节点划分和树构建的过程与分类问题类似,不同之处在于目标值的处理。

在回归问题中,节点划分过程应根据目标值的大小将数据集划分成多个子集。

3. 预测值计算:决策树回归模型的预测值是通过对决策树进行遍历,找到与待预测样本最匹配的叶子节点,并返回该节点的目标值作为预测结果。

决策树名词解释

决策树名词解释决策树(DecisionTree)是一种常见的数据挖掘技术,也称为决策树分类(Decision Tree Classification)。

决策树是一种以树状结构表示数据的模型,它可以用来描述一组数据集的概念,它可以用来作出决策。

策树是一种数据挖掘的常用算法,它可以用于分类、回归任务,以及关联规则建模,它可以帮助智能系统理解数据,从而实现更好的决策。

决策树的基本原理很简单,它是一种将每个属性值与实例的关联转换成树形结构的方法。

在这种树形结构中,每个节点存储关联属性的值,从而决定一个决策。

策树通常用于研究一组已知数据,它可以用来预测未知数据的结果,也可以用来归类数据,从而发现数据的规律性。

决策树的建立有很多步骤,但是大致可以分为以下几个步骤:(1)数据集准备:首先,需要对数据集进行预处理,将数据分成训练集和测试集。

(2)决策树划分:根据训练集中的特征属性,将数据集划分为不同的分支,并且不断划分,直到达到决策树模型所需要的精度或停止条件为止。

(3)估属性:根据训练集中的数据,选择最优的划分属性,用于对训练集进行划分。

(4)决策树剪枝:新建的决策树可能过度拟合训练数据,这会使训练出来的决策树在测试数据上的表现变差,因此,需要使用剪枝算法,来减少决策树的过拟合现象。

(5)测试:根据训练好的决策树,对测试集数据进行分类,统计测试集分类正确率,从而对决策树进行评估。

决策树在实际应用中可以用于社会决策分析、企业决策分析、关联规则挖掘等应用场景,但是决策树也有若干缺点。

其一,决策树生成过程中属性之间的关系可能非线性,而决策树假设属性之间的关系是线性的,因此可能导致决策树模型的准确性不足。

其二,决策树的剪枝操作可能会过度剪枝,也影响模型的准确性。

总之,决策树是一种常用的数据挖掘技术,它可以用于推理和预测数据,它可以用来帮助智能系统理解数据,从而改善决策效率。

但是,因为决策树的局限性,仍然需要其他的数据挖掘技术来提高决策的准确性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

银 ID

行1

贷2

款 数

3

据4

集5

6

7

8

9

10

11

12

13

14

15

Age

Young Young Young Young Young Middle Middle Middle Middle Middle Old Old Old Old Old

Has_job

No No Yes Yes No No No Yes No No No No Yes Yes No

• CHAID(chi-squared automatic interaction detection,卡方自动交互检测)

二叉或多叉

建立决策树

• 树的生长

– 分裂属性及其条件的选择 – 何时结束分裂

• 树的选择

1. 裂分目标与属性选择

• 裂分目标 使分裂后数据子集的纯度比裂分前数据集的纯度

最大限度的提高;即不同类别的观测尽量分散在不 同的子集中。 • 指标

Has_job

No No Yes Yes No No No Yes No No No No Yes Yes No

Own_home

No No No Yes No No No Yes Yes Yes Yes Yes No No No

Credit

Fair Good Good Fair Fair Fair Good Good Excellent Excellent Excellent Good Good Excellent Fair

分类方法

•决策树方法 •贝叶斯分类法 •LOGISTIC回归 •神经网络方法 •K近邻分类法 •SVM分类法 ……….

决策树(decision tree)

Root

Node

Leaf 规则1:If refund=no and (marst=single or marst=divorced) and taxincome>80k then cheat=yes ……

分析数据集应该包括哪些客户?

ID Age

1 Young 2 Young 3 Young 4 Young 5 Young 6 Middle 7 Middle 8 Middle 9 Middle 10 Middle 11 Old 12 Old 13 Old 14 Old 15 Old

银行贷款申请 Has_job

银 ID

行1

贷2

款 数

3

据4

集5

6

7

8

9

10

11

12

13

14

15

Age

Young Young Young Young Young Middle Middle Middle Middle Middle Old Old Old Old Old

Has_job

No No Yes Yes No No No Yes No No No No Yes Yes No

Own_home

No No No Yes No No No Yes Yes Yes Yes Yes No No No

Credit

Fair Good Good Fair Fair Fair Good Good Excellent Excellent Excellent Good Good Excellent Fair

Class

No No Yes Yes No No No Yes Yes Yes Yes Yes Yes Yes No

银行贷款案例数据集的分类误差: CE=1- 9/15=6/15=0.4

二、建立决策树

常用算法 • ID3-ID5,C4,C4.5,C5.0

二叉或多叉 信息熵

• CART(Classification and Regression Trees分 类与回归树) (C&RT) 二叉 GINI 指数

建模

模型评估

规则1:If refund=no and

marst=married then cheat=no

模

……

型

应

用

分类的过程

• 数据集分区

– 训练集:建立模型 – 验证集:调整和选择模型 – 测试集:评估模型的预测能力

• 建立模型 • 评估并选择模型 • 运用模型

新数据(打分集)

思考:分类模型在什么情况下不适合用于新数据?

Age

Young

Middle

Old

Yes:2 No:3

Yes:3 No:2

Yes:4 No:1

裂分后数据集的熵EntropyAge(T)= 5/15* Entropy(T1)+ 5/15* Entropy(T2)+ 5/15* Entropy(T3) = 5/15*(− 3/5*log2(3/5) − 2/5*log2(2/5) )+

– 信息增益与信息增益率 – GINI指数的下降 – 二分指数 – 卡方检验 – C-SEP、…

信息增益

Information Gain = 裂分前数据集的熵 – 裂分后各子数据集的熵

加权和

其中:权重为每个子集中的观测数在裂分前总 观测数中所占的比例

案例数据集基于own_home属性划分

ID Age

No

No

Fair

Class

No No Yes Yes No No No Yes Yes Yes Yes Yes Yes Yes No

分类与预测

• 分类:

– 目标变量为非数值型

• 预测:

– 目标变量为数值型

• 根据历史数据集(已知目标变 量),构建模型描述目标变量 与输入变量之间的关系,并依 据模型来分类或预测新数据( 目标变量值未知)。 分类模型也称为分类器。

纯度与混杂度

混杂度的常用测度指标

• 信息熵 ( Entropy) • 基尼指数( Gini Index) • 分类误差(classification error)

信息熵 ( Entropy)

Pj 是数据集合中类别j的相对比例.

entropy = pi log 2 pi

i

什么情况下,熵最小? 什么情况下,熵最大?

Class

No No Yes Yes No No No Yes Yes Yes Yes Yes Yes Yes No

银行贷款案例数据集的基尼指数: gini=1-(6/15)2-(9/15)2=0.48

分类误差(classification error)

CE最大=?1-1/2 (目标变量为二元变量) CE最小=?0

No

15 Old

No

No

Fair

No

Good

No

Good

Yes

Fair

Yes

Fair

No

Fair

No

Good

No

Good

Yes

Excellent Yes

Excellent Yes

Excellent Yes

Good

Yes

Good

Yes

Excellent Yes

Fair

No

案例数据集基于age属性划分

Has_job Own_home Credit

Class

1 Young No

No

2 Young No

No

3 Young Yes

No

4 Young Yes

Yes

5 Young No

No

6 Middle No

No

7 Middle No

No

8 Middle Yes

Yes

9 Middle No

Yes

10 Middle No

Class

Noቤተ መጻሕፍቲ ባይዱNo Yes Yes No No No Yes Yes Yes Yes Yes Yes Yes No

银行贷款案例数据集的熵:

Entropy(T)=−6/15*log2(6/15) − 9/15*log2(9/15)=0.971

Gini 指数

Pj 是数据集合中类别j的相对比例.

GINI最大=?1-1/2 (目标变量为二元变量) GINI最小=?0

Yes

Good

Yes

Excellent Yes

Fair

No

案例数据集基于ownhome属性划分

Yes

Yes:6 No:0

Own_home

No

Yes:3 No:6

裂分前数据集的熵:Entropy(T0)=−6/15*log2(6/15) − 9/15*log2(9/15)=0.971

划分后数据集的熵EntropyOwn_home(T)= 6/15* Entropy(T1)+ 9/15* Entropy(T2) = 6/15*(− 6/6*log2(6/6) − 0/0*log2(0/6) )+

分类与预测

Vicky

银行个人住房贷款审批

银行个人客户提出住房贷款申请,根据历史 数据发现:部分贷款客户不能按时还款。为尽量 降低这种现象,需要发现不能按时还款客户的特 征,以便对以后住房贷款申请的审批提供依据。

2006年年底,由SAS机构与招商银行启动了全 行个人住房贷款评分卡开发与推广项目。

该项目利用客户的历史数据构建评分卡模型, 然后将该模型应用到新客户上,最后决定是否接 受新客户的贷款申请。

Yes:1

Yes:4

Yes:4

No:4

No:2

No:0

根据hasjob 和credit划分后的熵分O别w为n_home

EntropyHas_job(TY)=e0s.647

EntropyCredit(T)=0.608