广义线性模型与正则化方法

generalized additive model (gam)

generalized additive model (gam)(原创实用版)目录1.广义加性模型(GAM)的概述2.GAM 的优点和应用场景3.GAM 的局限性和改进方向正文广义加性模型(Generalized Additive Model,简称 GAM)是一种用于预测分类变量或连续变量的统计模型。

GAM 基于加性模型,可以看作是多项逻辑回归(Logistic Regression)和线性回归(Linear Regression)的扩展。

GAM 模型不仅具有强大的预测能力,而且可以处理各种数据类型,如离散、连续和混合数据。

GAM 的优点主要体现在以下几个方面:1.灵活性:GAM 可以拟合各种复杂的非线性关系,因此能够更好地捕捉到数据中的潜在模式。

这使得 GAM 在处理实际问题时具有较高的准确性。

2.通用性:GAM 可以同时处理分类变量和连续变量,因此在研究中可以广泛应用。

3.容易解释:GAM 的输出结果可以很容易地解释,有助于研究人员理解模型的预测机制。

尽管 GAM 具有很多优点,但仍然存在一些局限性:1.计算成本:由于 GAM 需要拟合复杂的非线性函数,因此计算成本较高,可能导致计算速度较慢。

2.过拟合风险:GAM 的拟合能力较强,容易陷入过拟合的困境,从而降低模型的泛化能力。

为了克服这些局限性,研究人员提出了一些改进方向:1.使用正则化方法:通过 L1 正则化和 L2 正则化等方法,可以降低模型的复杂度,减少过拟合风险。

2.逐步回归:通过逐步筛选变量,可以降低模型的复杂度,提高模型的泛化能力。

3.模型选择和评估:使用交叉验证等方法,可以帮助研究人员选择最佳模型,并评估模型的性能。

总之,广义加性模型(GAM)是一种具有强大预测能力的统计模型,可以广泛应用于各种研究领域。

正则化方法

正则化方法正则化方法是一种有效的优化技术,它是用来减少模型的复杂性,避免过拟合,促进模型的泛化性能。

它把模型参数空间中不重要的变量设置为空并移除,以提高模型的效果。

正则化方法可以有效控制过拟合,有助于提高模型的性能和运行效率,在机器学习和深度学习领域得到广泛应用。

正则化方法有多种形式。

常用的正则化方法有L2正则化,L1正则化,Max-norm正则化,Dropout正则化等。

例如,L2正则化(也称为权重衰减)是一种数学技术,它引入了一个系数来改变参数的取值范围。

一般来说,改变参数的系数越大,则缩小参数的范围越多,也就是模型越不复杂,所以参数就越不容易过拟合。

L1正则化也可以减少模型参数的复杂性,它使模型的参数值更接近于0,从而达到降维的效果,有助于改善模型的泛化能力。

Max-norm正则化主要用于约束参数的W矩阵中元素的大小,通过控制模型参数中单个参数值的大小,来减少模型参数的复杂性,从而降低过拟合风险,增加模型的泛化性能。

Dropout正则化是一种常用的深度学习正则化方法,它通过跳过一些神经网络激活函数来简化神经网络结构,从而避免过拟合,增强模型的泛化能力。

正则化可以有效地降低模型的复杂度,让模型在训练集和测试集上的表现更加一致,从而促进模型的有效运用。

正则化方法在实际应用中也存在一定的问题,例如,由于L1正则化会使参数的范围变得非常小,它会使模型的训练变得很慢,并且影响模型的精度。

对于一些复杂的模型,Max-norm正则化可能会限制模型的学习能力,从而影响模型的性能。

正则化方法在实践中表现出很强的耐受性,它可以解决过拟合问题,提高模型的泛化性能。

不同的正则化方法都有各自的优势和劣势,在实际应用中,根据具体情况选择合适的正则化方法,才能最大程度地发挥正则化方法的优势,提高模型的性能。

总之,正则化方法是一种有效的优化技术,它通过减少模型的复杂性,解决过拟合问题,从而提高模型的泛化性能,在机器学习和深度学习领域得到广泛应用。

广义线性回归

广义线性回归

广义线性回归(Generalized Linear Regression)是传统的线性回归的

普遍拓展,它采用损失函数(lossfunction)和正则化(regularization)技术来适应这些数字常用分布,可以帮助研究者更好地分析在实例中出现的状况以及预测未来。

广义线性回归是利用传统线性回归概念来拓展和扩展可用其他数据分布,

而不仅仅是正态分布。

与传统线性回归不同,这种拓展可以处理非正态分布的回归模型,不仅可以拟合二次形式的度量,而且可以用于不同的度量,包括离差、分位数和对数等度量类型,甚至可以处理稀疏类型。

由于这种拓展,广义线性回归现在在互联网行业中被广泛应用,可以很好地处理大量非正态性分布型数据,并且它具有良好的参数估计能力,这可以大大提高数据处理的效率和精确度。

在互联网行业中,广义线性回归可以有效地提取出数据中的重要信息,帮

助企业分析网站用户行为,有助于了解用户口味和习惯。

此外,它还可以帮助网站提高搜索引擎排名,有效地减少投入和提高营销收入。

而且,广义线性回归还可以让开发者们更快地、更准确地定位和探索有价值的数据,帮助他们轻松地处理复杂,稀疏的数据,很好地支持大规模网站数据分析。

总结来讲,广义线性回归是传统线性回归的拓展,可以有效地处理大量非

正态性分布数据,可以有效地提取出数据中的重要信息,更好地支持网站决策,并能够在互联网行业中发挥重要作用,帮助企业分析用户行为,有效提高搜索引擎排名,并有效提升网站的数据分析能力。

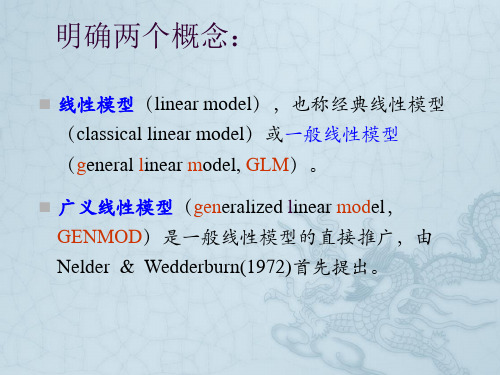

广义线性模型

2 1/ 2 2

1

3 2

伽玛分布

1

ln

1

1

2

二项分布 ln p

ln1 e 1

1 p

Poisson 分布 ln

e

1

p

e 1 e

e

p1 p

负二项分布 ln

e

k

e

k2

何为“广义线性模型”?(续)

一个广义线性模型包括以下三个组成部分: (1)线性成分(linear component ) :

SAS软件中的PROC GENMOD:

The GENMOD Procedure

The GENMOD procedure fits generalized linear models. The class of generalized linear models is an extension of traditional linear models that allows the mean of a population to depend on a linear predictor through a nonlinear link function and allows the response probability distribution to be any member of an exponential family of distributions. Many widely used statistical models are generalized linear models. These include classical linear models with normal errors, logistic and probit models for binary data, and log-linear models for multinomial data. Many other useful statistical models can be formulated as generalized linear models by the selection of an appropriate link function and response probability distribution.

函数性广义线性模型曲线选择的正则化方法

Brd e, Gr up M CP,Elsi ta d M n ts o d g o u ei a e u t. ig o a tc Ne n e h we o d n m rc lr s ls Ke r y wo ds: un to a ne aie n a o e ;Cu v e e to F ci n lGe r l d Li e rM d l z r e S l cin; Re ulrz d M eho s g a i

我们 不得 不 进行 变量 选择 。变 量选 择 的传统 方 法有

最 优子集 法 和逐 步 回归 法结 合 A C I I 、BC或 者 C 准 。

回归模 型 的一个 主要 目的是 : 给 定 n个 观测 在

则进 行最 优模 型 的选 择 。但 是 这些 方法 有 比较 大 的 缺点 , 先最 优子 集 法计算 量 大 , 计算 复杂 度是 变 首 其

拟发现 , r pBi e G opMC 、 l t e 和 Mnt G o r g 、 ru P Ea i N t u d sc e 表现 出较好 的数值结果 。

关键 词 : 函数 性 广 义 线 性 模 型 ; 曲线 选 择 ; 则 化 方 法 正 中 图分 类 号 :22 3 F 2 . 文献 标 识 码 : A 文 章 编 号 :0 2— 5 5 2 1 ) 9— 0 5—0 10 4 6 ( 0 2 0 0 9 8

Scikit-learn 使用手册中文版

Table of Contents1.21.2.11.2.21.2.31.2.41.2.5绪言This book is translated from official user guide of scikit-learn.1.1. 广义线性模型英文原文以下介绍的方法均是用于求解回归问题,其目标值预计是输入变量的一个线性组合。

写成数学语言为:假设是预测值,则有在本节中,称向量为 coef_ ,{% math %}w0{% endmath %}为`intercept`若要将通用的线性模型用于分类问题,可参见Logistic回归1.1.1 普通最小二乘法LinearRegression 使用系数拟合一个线性模型。

拟合的目标是要将线性逼近预测值()和数据集中观察到的值()两者之差的平方和尽量降到最小。

写成数学公式,即是要解决以下形式的问题LinearRegression 的 fit 方法接受数组X和y作为输入,将线性模型的系数存在成员变量 coef_ 中:>>> from sklearn import linear_model>>> clf = linear_model.LinearRegression()>>> clf.fit ([[0, 0], [1, 1], [2, 2]], [0, 1, 2])LinearRegression(copy_X=True, fit_intercept=True, n_jobs=1, normalize=False)>>> clf.coef_array([ 0.5, 0.5])需要注意的是,普通最小二乘法的系数预测取决于模型中各个项的独立性。

假设各个项相关,矩阵的列总体呈现出线性相关,那么就会很接近奇异矩阵,其结果就是经过最小二乘得到的预测值会对原始数据中的随机误差高度敏感,从而每次预测都会产生比较大的方差。

广义线性模型(GeneralizedLinearModels)

⼴义线性模型(GeneralizedLinearModels)在线性回归问题中,我们假设,⽽在分类问题中,我们假设,它们都是⼴义线性模型的例⼦,⽽⼴义线性模型就是把⾃变量的线性预测函数当作因变量的估计值。

很多模型都是基于⼴义线性模型的,例如,传统的线性回归模型,最⼤熵模型,Logistic回归,softmax回归。

指数分布族在了解⼴义线性模型之前,先了解⼀下指数分布族(the exponential family)指数分布族原型如下如果⼀个分布可以⽤上⾯形式在表⽰,那么这个分布就属于指数分布族,⾸先来定义⼀下上⾯形式的符号:η:分布的⾃然参数(natural parameter)或者称为标准参数(canonical parameter)T (y):充分统计量,通常⽤T(y) = ya(η):对数分割函数(log partition function):本质上是⼀个归⼀化常数,确保概率和为1。

当给定T时,a、b就定义了⼀个以η为参数的⼀个指数分布。

我们变化η就得到指数分布族的不同分布。

论证伯努利分布和⾼斯分布为指数分布族,伯努利分布均值φ,记为Bernoulli(φ),y ∈ {0, 1},所以p(y = 1; φ) = φ; p(y = 0; φ) = 1 − φ对⽐指数分布族的表达式可以得到:η = log(φ/(1-φ)) 我们将φ⽤η表⽰,则:φ=1/(1+e-η),是不是发现和sigmoid函数⼀样了。

这就表明,当我们给定T,a,b,伯努利分布可以写成指数分布族的形式,也即伯努利分布式指数分布族。

同理,在⾼斯分布中,有:对⽐指数分布族,我们得到:因为⾼斯分布的⽅差与假设函数⽆关,因⽽为了计算简便,我们设⽅差=1,这样就得到:所以这也表明,⾼斯分布也是指数分布族的⼀种。

构造⼴义线性模型(Constructing GLMs)怎么通过指数分布族来构造⼴义线性模型呢?要构建⼴义线性模型,我们要基于以下三个假设:1. 给定特征属性和参数后,的条件概率服从指数分布族,即。

基于广义线性模型的分类问题

基于广义线性模型的分类问题一、引言分类问题是机器学习领域中最基础的问题之一,其目的是将数据点归到不同的类别中。

在实际应用中,分类问题的应用场景非常广泛,包括但不限于电子商务的推荐系统、医疗诊断、金融风控等领域。

广义线性模型(Generalized Linear Model,GLM)是一种常用的统计学习方法,用于建立因变量与自变量之间的关系。

广义线性模型通过给定自变量的函数形式和一个分布族,来建立自变量与因变量之间的关系。

本文将介绍基于广义线性模型的分类问题。

具体地,本文将讨论如何使用广义线性模型来解决二分类问题和多分类问题。

二、基于广义线性模型的二分类问题二分类问题是将数据点分到两个不同的类别之一。

在基于广义线性模型的二分类问题中,我们假设因变量Y 是离散的二元变量,且服从伯努利分布。

伯努利分布是一种二元分布,其代表了一次试验中成功和失败的概率。

伯努利随机变量的概率质量函数可以表示为:$$P(Y=y) = \theta^y(1-\theta)^{1-y}$$ 其中,$0\leq \theta\leq 1$ 表示成功的概率。

为了建立基于广义线性模型的二分类问题,我们需要确定$\theta$ 与自变量 $X$ 之间的关系。

具体地,我们采用如下函数形式:$$logit(\theta) = \beta_0 + \beta_1 X_1 + ... + \beta_p X_p$$ 其中,logit 函数指数函数,可以将 $\theta$ 转化为一个线性函数,并保证 $\theta$ 的取值范围在 [0,1] 之间。

$\beta_0,\beta_1,...,\beta_p$ 是待估计的系数。

建立好了模型之后,我们需要估计系数$\beta$。

在估计系数时,通常使用最大似然估计。

最大似然估计的过程即是通过最大化似然函数得到系数$\beta$。

对于二分类问题,似然函数可以表示为:$$L(\beta) = \prod_{i=1}^n [\theta_i^{y_i}(1-\theta_i)^{(1 -y_i)}]$$ 其中,$y_i$ 表示第 i 个样本的类别,$\theta_i$ 是预测样本 $i$ 属于类别 1 的概率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

广义线性模型与正则化方法

在众多统计学习方法中,广义线性模型是一种常见且实用的方法。

广义线性模型是一种对于连续因变量和一个或多个解释变量

之间关系的多元线性回归建模方法。

广义线性模型包括众多的回归方法,例如:线性回归、逻辑回归、泊松回归、广义加性模型等等。

根据模型拟合的误差分布的

不同,可以使用不同的广义线性模型。

比如说,线性回归模型的

误差服从正态分布,而逻辑回归模型的误差服从伯努利分布。

在广义线性模型的建模过程中,常常会出现维数灾难问题和过

拟合问题。

为了解决这些问题,通常可以采用正则化方法。

正则化方法是统计学习方法中常用的一种方法,它可以通过在

目标函数中增加一个惩罚项来限制模型的复杂度。

惩罚项通常有

L1正则化和L2正则化两种。

L1正则化可以认为是一种稀疏性参数寻找方法。

它通过在模型目标函数中增加模型参数的L1范数乘以一个正则化系数λ来进行

模型压缩。

该方法通过约束模型参数的绝对值之和小于一个阈值。

L1正则化的主要思想是让部分模型参数取0,从而实现对数据中

无用特征的忽略,以达到降低模型复杂度、提高泛化性能的目的。

L2正则化是一种常用的权重衰减方法,它通过在模型目标函数中增加模型参数的L2范数乘以一个正则化系数λ来进行模型压缩。

该方法通过约束模型参数的平方之和小于一个阈值。

L2正则化的

主要思想是尽量降低参数的值,而不像L1正则化那样将某些参数

直接设为0,因此L2正则化一般产生比L1正则化更平滑且稳定

的参数值,并不易产生稀疏解。

除了L1和L2正则化,还有一种名为Elastic Net的方法,它是

L1和L2正则化的结合。

Elastic Net正则化的优点在于,对于存在

关联性高的特征来说,L1正则化可能会对其中某些特征误判,而

L2正则化则没有这个问题。

所以,引入Elastic Net正则化可以稳

健地解决上述问题。

总结

在统计学习方法中,广义线性模型是一种常见、实用的建模方法。

在模型的建立过程中,会出现模型参数过多或维度灾难等问题,解决这些问题,我们可以采用正则化方法。

正则化方法可以

通过限制模型复杂度,避免过拟合而提高模型的泛化能力。

其中,L1、L2正则化是广泛使用的方法,而Elastic Net则是将L1、L2

正则化两者有关的优点结合起来。