Lucene简介

Lucene_入门简介

索引相关类

Document Field(URL) Field(Title )

• • •

Analyzer Field(Body )

IndexWriter

•

•

通过IndexWriter来写索引,通过IndexReader读索引。 一段有意义的文字需要通过Analyzer分割成一个个词语后才能按关键词搜索。 Analyzer就是分析器,StandardAnalyzer是Lucene中最常用的分析器。 TokenStream实例保存着当前的Attribute状态。 Attribute 是一个接口,实 现中包含一个代表词本身含义的字符串和该词在文章中相应的起止偏移位置, Attribute还可以用来存储词类型或语义信息。 一个Document代表索引库中的一条记录。要搜索的信息封装成Document 后通过IndexWriter写入索引库。调用Searcher接口按关键词搜索后,返回的也是 一个封装后的Document的列表。 一个Document可以包含多个列,叫做field。例如一篇文章可以包含“标 题”、“正文”、“修改时间”等field,创建这些列对象以后,可以通过 Document的add方法增加这些列。

搜索

// read-only=true IndexSearcher isearcher = new IndexSearcher(directory, true); // Parse a simple query that searches for "text": QueryParser parser = new QueryParser(Version.LUCENE_CURRENT,"fieldname", analyzer); Query query = parser.parse("text"); //返回前1000条搜索结果 ScoreDoc[] hits = isearcher.search(query, 1000).scoreDocs; //遍历结果 for (int i = 0; i < hits.length; i++) { Document hitDoc = isearcher.doc(hits[i].doc); System.out.println(hitDoc.get("fieldname")); } isearcher.close(); directory.close();

Lucene简介(共36张)

不做索引,用于存放不搜索的内容

Index.TOKENIZED 分词索引,用于存放可搜索的内容

Index.UM_TOKENIZED

不分词索引,用于存放ID

18

第18页,共36页。

Field示例(shìlì)

public static Document getDocument(Info info){ Document document = new Document(); Field field = null;

分词组件(Tokenizer)

1、将文档分成一个一个单独的单词。 2、去除标点符号。 3、去除停词(Stop word)。

词元(Token) 经过分词(Tokenizer)后得到的结果称为词元(Token)

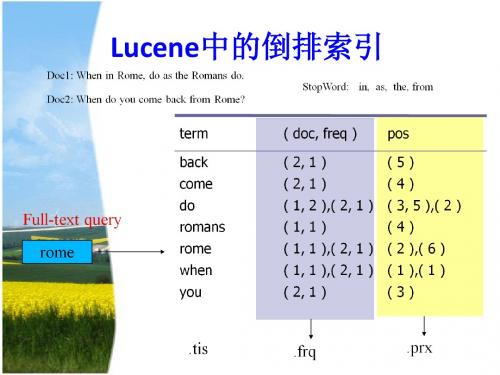

倒排(Posting List)链表 1、Document Frequency 即文档频次,表示总共有多少文件包含此词(Term)。 2、Frequency 即词频率,表示此文件中包含了几个此词(Term)。

一个高效的,可扩展的,全文检索库。 全部用Java实现,无须配置 。

仅支持纯文本文件的索引(Indexing)和搜索(Search)。 不负责由其他格式的文件抽取纯文本文件,或从网络中抓取文件的过

程.

Mr. Ajax

8 第8页,共36页。

Lucene的总体(zǒngtǐ)架构

9 第9页,共36页。

4、域(Field):

a、一篇文档包含不同类型的信息,可以分开索引,比如标题,时间,正文,作者 等,都可以保存在不同的域里。 b、不同域的索引方式可以不同

5、词(Term):

词是索引的最小单位,是经过词法分析和语言处理后的字符串。

16àn):Lucene

基于Lucene全文检索系统的研究与实现

基于Lucene全文检索系统的研究与实现[摘要] lucene是一个开放源代码的全文检索引擎工具包,利用它可以快速地开发一个全文检索系统。

利用lucene开发了一个全文检索系统,通过其特殊的索引结构,实现了传统数据库不擅长的全文索引机制,提供了对非结构化信息的检索能力。

[关键词] lucene 信息检索全文检索索引一、引言计算机技术及网络技术的迅速发展,使得internet成为人类有史以来资源最多、品种最全、规模最大的信息资源库。

如何在这海量的信息里面快速、全面、准确地查找所需要的资料信息已经成了人们关注的焦点,也成了研究领域内的一个热门课题。

这些信息基本上可以分做两类:结构化数据和非结构化数据(如文本文档、word 文档、pdf文档、html文档等)。

现有的数据库检索,是以结构化数据为检索的主要目标,实现相对简单。

但对于非结构化数据,即全文数据,由于复杂的数据事务操作以及低效的高层接口,导致检索效率低下。

随着人们对信息检索的要求也越来越高,而全文检索因为检索速度快、准确性高而日益受到广大用户的欢迎, lucene是一个用java写的全文检索引擎工具包,可以方便地嵌入到各种应用中实现针对应用的全文索引和检索功能。

这个开源项目的推出及发展,为任何应用提供了对非结构化信息的检索能力。

二、全文检索策略通常比较厚的书籍后面常常附关键词索引表(比如,北京:12,34页,上海:3,77页……),它能够帮助读者比较快地找到相关内容的页码。

而数据库索引能够大大提高查询的速度原理也是一样,由于数据库索引不是为全文索引设计的,因此,使用like “%keyword%”时,数据库索引是不起作用的,在使用like查询时,搜索过程又变成类似于一页页翻书的遍历过程了,所以对于含有模糊查询的数据库服务来说,like对性能的危害是极大的。

如果是需要对多个关键词进行模糊匹配:like“%keyword1%”and like “%keyword2%”……其效率也就可想而知了。

lucene 的模糊匹配原理

一、lucene模糊匹配原理概述lucene是一个开源的全文检索引擎工具,提供了强大的文本搜索和分析功能。

在实际应用中,经常需要进行模糊匹配,以处理用户输入的错别字、拼写错误或者同义词。

模糊匹配是lucene中非常重要的功能,它可以帮助用户找到相关的文档,提高搜索的准确性和全面性。

二、lucene模糊匹配的算法原理1. Levenshtein Distance算法Levenshtein Distance是衡量两个字符串相似程度的一种算法,也称为编辑距离。

在lucene中,模糊匹配主要使用Levenshtein Distance算法来实现。

该算法通过计算两个字符串之间的距离,从而确定它们的相似程度。

具体来说,它通过插入、删除和替换操作,将一个字符串转换成另一个字符串所需的最小步骤数来衡量相似度。

2. 模糊查询的实现方式在lucene中,模糊查询可以通过FuzzyQuery类来实现。

利用FuzzyQuery,可以指定一个最大编辑距离,从而允许匹配到具有一定相似度的文档。

FuzzyQuery会基于Levenshtein Distance算法来进行模糊匹配,找到编辑距离小于等于指定值的文档。

三、模糊匹配的应用场景1. 处理用户输入错误当用户在搜索框中输入错别字或者拼写错误时,模糊匹配可以帮助系统找到相关的文档,并提供纠正建议,提高搜索的准确性和用户体验。

2. 同义词匹配在自然语言处理中,同一个概念可能有多种不同的表达方式。

通过模糊匹配,可以将具有相似含义的词语进行匹配,从而提高搜索的全面性。

3. 解决词形变化问题词形变化是自然语言中常见的现象,同一个词可能有不同的变形形式。

通过模糊匹配,可以将不同词形的单词对应起来,使得搜索更加全面和准确。

四、模糊匹配的优化策略1. 设置合适的编辑距离阈值在使用模糊匹配时,需要根据具体的应用场景来设置合适的编辑距离阈值。

如果编辑距离过小,可能会产生大量的不必要匹配;如果编辑距离过大,可能会包含过多的无关文档。

lucene面试题

lucene面试题一、Lucene简介Lucene是一个开源的全文检索引擎工具包,可以轻松地将其集成到应用程序中,以方便地实现全文检索功能。

它提供了强大且灵活的API接口,使用户可以对文档中的内容进行快速、高效的搜索和索引。

Lucene的核心是基于倒排索引原理,通过将文档中的单词映射到文档的地址来进行搜索,从而提高了搜索的速度和效率。

二、Lucene的特点和优势1. 高性能:Lucene使用高效的倒排索引和缓存机制,能够快速处理大量数据和复杂查询。

2. 可扩展性:Lucene提供了灵活的架构和API接口,可以根据需求进行扩展和定制。

3. 多语言支持:Lucene支持多种语言的分词器,可以处理各种类型的文档。

4. 高度可配置:Lucene的配置项丰富,可以根据需要进行灵活的配置和调优。

5. 支持多种数据格式:Lucene能够处理各种格式的数据,包括文本文件、HTML、XML、Word文档等。

三、Lucene的应用场景1. 搜索引擎:Lucene可以用于构建搜索引擎,实现快速、准确的搜索和检索功能。

2. 文本分析:Lucene提供了丰富的文本处理和分析功能,可以对文档进行分词、词性标注、去重等操作。

3. 数据挖掘:Lucene可以对大量数据进行索引和搜索,用于数据挖掘和信息提取。

4. 商业应用:Lucene可以用于构建企业内部搜索、电子文档管理系统、知识库等应用。

四、Lucene面试常见问题1. 什么是Lucene的倒排索引原理?2. 如何创建一个基本的Lucene索引?3. Lucene中的Query和Filter有什么区别?如何使用它们?4. 什么是Analyzer?有哪些常见的分词器?5. Lucene的排序原理是什么?如何进行排序?6. Lucene如何处理关键词的模糊匹配?7. Lucene的搜索结果评分算法是怎样的?8. 如何在Lucene中实现多字段的搜索?9. 如何优化Lucene的性能?10. Lucene与Elasticsearch有何区别?五、结语通过对Lucene的介绍和常见面试问题的概述,希望能够对读者了解Lucene的基本概念和使用方法有所帮助。

Lucene入门+实现

Lucene⼊门+实现Lucene简介详情见:()lucene实现原理其实⽹上很多资料表明了,lucene底层实现原理就是倒排索引(invertedindex)。

那么究竟什么是倒排索引呢?经过Lucene分词之后,它会维护⼀个类似于“词条--⽂档ID”的对应关系,当我们进⾏搜索某个词条的时候,就会得到相应的⽂档ID。

不同于传统的顺排索引根据⼀个词,知道有哪⼏篇⽂章有这个词。

图解:Lucene在搜索前⾃⾏⽣成倒排索引,相⽐数据库中like的模糊搜索效率更⾼!Lucene 核⼼API索引过程中的核⼼类1. Document⽂档:他是承载数据的实体(他可以集合信息域Field),是⼀个抽象的概念,⼀条记录经过索引之后,就是以⼀个Document的形式存储在索引⽂件中的。

2. Field:Field 索引中的每⼀个Document对象都包含⼀个或者多个不同的域(Field),域是由域名(name)和域值(value)对组成,每⼀个域都包含⼀段相应的数据信息。

3. IndexWriter:索引过程的核⼼组件。

这个类⽤于创建⼀个新的索引并且把⽂档加到已有的索引中去,也就是写⼊操作。

4. Directroy:是索引的存放位置,是个抽象类。

具体的⼦类提供特定的存储索引的地址。

(FSDirectory 将索引存放在指定的磁盘中,RAMDirectory ·将索引存放在内存中。

)5. Analyzer:分词器,在⽂本被索引之前,需要经过分词器处理,他负责从将被索引的⽂档中提取词汇单元,并剔除剩下的⽆⽤信息(停⽌词汇),分词器⼗分关键,因为不同的分词器,解析相同的⽂档结果会有很⼤的不同。

Analyzer是⼀个抽象类,是所有分词器的基类。

搜索过程中的核⼼类1. IndexSearcher :IndexSearcher 调⽤它的search⽅法,⽤于搜索IndexWriter 所创建的索引。

2. Term :Term 使⽤于搜索的⼀个基本单元。

lucene简介原理及实践(共48张)

Analyzer

在一个文档被索引之前,首先需要对文档内容进行分词处理, 并且而剔除一些冗余的词句(例如:a,the,they等),这部分工作

就是由 Analyzer 来做的。

Analyzer 类是一个抽象类,它有多个实现。

BrazilianAnalyzer, ChineseAnalyzer, CJKAnalyzer, CzechAnalyzer, DutchAnalyzer, FrenchAnalyzer, GermanAnalyzer, GreekAnalyzer, KeywordAnalyzer, PatternAnalyzer, PerFieldAnalyzerWrapper, RussianAnalyzer, SimpleAnalyzer, SnowballAnalyzer, StandardAnalyzer, StopAnalyzer, ThaiAnalyzer, WhitespaceAnalyzer

通过实现特定API,完成文档建立索引的工 作

第7页,共48页。

Lucene搜索机制-B 基于(jīyú)索引搜索

Lucene通过特定的类,可以对索引进行操 作

通过特定的类,封装搜索结果,供应用程 序处理

第8页,共48页。

Lucene系统结构

第9页,共48页。

Lucene包结构(jiégòu)功能表

第19页,共48页。

Field

Field 对象(duìxiàng)是用来描述一个文档的某个属性的,比如一封电子邮件的标 题和内容可以用两个 Field 对象分别描述。

Field(String name, byte[] value, Field.Store store) Create a stored field with binary value.

lucene对比中文近义词用法

标题:探讨Lucene对比中文近义词用法1. 简介为了更好地理解Lucene对比中文近义词用法,我们首先需要了解Lucene的基本概念和中文近义词的特点。

Lucene是一个全文检索引擎库,它提供了丰富的API,可以用于构建强大的全文搜索功能。

而中文近义词则是指在中文语境中,表达相似意义的词语,这些词语在不同的语境中可能会有微小的差别,但整体的意思是相通的。

2. Lucene的基本原理和功能Lucene通过倒排索引的方式来快速定位文档中的关键词,从而实现全文搜索的功能。

它采用了分词器来处理文本,将文本分割成若干个独立的单词,并将这些单词进行索引。

在搜索时,用户输入的查询语句也经过相同的分词处理,再与索引进行匹配,最终返回相关的文档。

3. 中文近义词的特点在中文语境中,由于词语的复杂性和多义性,往往会存在大量的近义词。

这些近义词可能在不同的场景中有不同的使用方式,但它们的基本意思是一致的。

“喜欢”和“爱好”就是一对中文近义词,它们都表示喜爱或偏好的意思,只是在语感上有细微的区别。

4. Lucene对比中文近义词用法在使用Lucene进行搜索时,对于中文近义词的处理往往是一个挑战。

由于中文的特殊性,同一个词可能存在多种不同的表达方式,而传统的搜索引擎很难将它们准确地匹配在一起。

针对这一问题,Lucene提供了同义词扩展的功能,可以将一些近义词视作同一个词来处理。

这样一来,用户在搜索时无需考虑到所有的近义词,只需要输入其中一个,就能够搜索到相关的文档。

5. 个人观点和总结通过对Lucene对比中文近义词用法的探讨,我们可以发现,Lucene在处理中文近义词时的确存在一些挑战,但它也提供了相应的解决方案。

在实际应用中,我们可以根据具体的需求,合理地进行同义词扩展,以提升搜索结果的准确性和覆盖范围。

对于中文近义词的掌握也需要结合具体的语境和语气来理解,不能简单地进行机械替换。

Lucene对比中文近义词用法的探讨,有助于我们更好地理解和应用这一强大的全文搜索引擎库。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

在应用中加入全文检索功能——基于Java的全文索引引擎Lucene简介作者:车东 Email: /写于:2002/08 最后更新:09/09/2006 17:09:05Feed Back >> (Read this before you ask question)版权声明:可以任意转载,转载时请务必以超链接形式标明文章原始出处和作者信息及本声明/tech/lucene.html关键词:Lucene java full-text search engine Chinese word segment内容摘要:Lucene是一个基于Java的全文索引工具包。

1.基于Java的全文索引引擎Lucene简介:关于作者和Lucene的历史2.全文检索的实现:Luene全文索引和数据库索引的比较3.中文切分词机制简介:基于词库和自动切分词算法的比较4.具体的安装和使用简介:系统结构介绍和演示5.Hacking Lucene:简化的查询分析器,删除的实现,定制的排序,应用接口的扩展6.从Lucene我们还可以学到什么基于Java的全文索引/检索引擎——LuceneLucene不是一个完整的全文索引应用,而是是一个用Java写的全文索引引擎工具包,它可以方便的嵌入到各种应用中实现针对应用的全文索引/检索功能。

Lucene的作者:Lucene的贡献者Doug Cutting是一位资深全文索引/检索专家,曾经是V-Twin搜索引擎(Apple的Copland操作系统的成就之一)的主要开发者,后在Excite担任高级系统架构设计师,目前从事于一些INTERNET底层架构的研究。

他贡献出的Lucene的目标是为各种中小型应用程序加入全文检索功能。

Lucene的发展历程:早先发布在作者自己的,后来发布在SourceForge,2001年年底成为APACHE基金会jakarta的一个子项目:/lucene/已经有很多Java项目都使用了Lucene作为其后台的全文索引引擎,比较著名的有:Jive:WEB论坛系统;∙Eyebrows:邮件列表HTML归档/浏览/查询系统,本文的主要参考文档“TheLucene search engine: Powerful, flexible, and free”作者就是EyeBrows系统的主要开发者之一,而EyeBrows已经成为目前APACHE项目的主要邮件列表归档系统。

∙Cocoon:基于XML的web发布框架,全文检索部分使用了Lucene∙Eclipse:基于Java的开放开发平台,帮助部分的全文索引使用了Lucene对于中文用户来说,最关心的问题是其是否支持中文的全文检索。

但通过后面对于Lucene的结构的介绍,你会了解到由于Lucene良好架构设计,对中文的支持只需对其语言词法分析接口进行扩展就能实现对中文检索的支持。

全文检索的实现机制Lucene的API接口设计的比较通用,输入输出结构都很像数据库的表==>记录==>字段,所以很多传统的应用的文件、数据库等都可以比较方便的映射到Lucene的存储结构/接口中。

总体上看:可以先把Lucene当成一个支持全文索引的数据库系统。

比较一下Lucene和数据库:全文检索≠ like "%keyword%"通常比较厚的书籍后面常常附关键词索引表(比如:北京:12, 34页,上海:3,77页……),它能够帮助读者比较快地找到相关内容的页码。

而数据库索引能够大大提高查询的速度原理也是一样,想像一下通过书后面的索引查找的速度要比一页一页地翻内容高多少倍……而索引之所以效率高,另外一个原因是它是排好序的。

对于检索系统来说核心是一个排序问题。

由于数据库索引不是为全文索引设计的,因此,使用like "%keyword%"时,数据库索引是不起作用的,在使用like查询时,搜索过程又变成类似于一页页翻书的遍历过程了,所以对于含有模糊查询的数据库服务来说,LIKE对性能的危害是极大的。

如果是需要对多个关键词进行模糊匹配:like"%keyword1%" and like "%keyword2%" ...其效率也就可想而知了。

所以建立一个高效检索系统的关键是建立一个类似于科技索引一样的反向索引机制,将数据源(比如多篇文章)排序顺序存储的同时,有另外一个排好序的关键词列表,用于存储关键词==>文章映射关系,利用这样的映射关系索引:[关键词==>出现关键词的文章编号,出现次数(甚至包括位置:起始偏移量,结束偏移量),出现频率],检索过程就是把模糊查询变成多个可以利用索引的精确查询的逻辑组合的过程。

从而大大提高了多关键词查询的效率,所以,全文检索问题归结到最后是一个排序问题。

由此可以看出模糊查询相对数据库的精确查询是一个非常不确定的问题,这也是大部分数据库对全文检索支持有限的原因。

Lucene最核心的特征是通过特殊的索引结构实现了传统数据库不擅长的全文索引机制,并提供了扩展接口,以方便针对不同应用的定制。

可以通过一下表格对比一下数据库的模糊查询:全文检索和数据库应用最大的不同在于:让最相关的头100条结果满足98%以上用户的需求Lucene的创新之处:大部分的搜索(数据库)引擎都是用B树结构来维护索引,索引的更新会导致大量的IO操作,Lucene在实现中,对此稍微有所改进:不是维护一个索引文件,而是在扩展索引的时候不断创建新的索引文件,然后定期的把这些新的小索引文件合并到原先的大索引中(针对不同的更新策略,批次的大小可以调整),这样在不影响检索的效率的前提下,提高了索引的效率。

Lucene和其他一些全文检索系统/应用的比较:关于亚洲语言的的切分词问题(Word Segment)对于中文来说,全文索引首先还要解决一个语言分析的问题,对于英文来说,语句中单词之间是天然通过空格分开的,但亚洲语言的中日韩文语句中的字是一个字挨一个,所有,首先要把语句中按“词”进行索引的话,这个词如何切分出来就是一个很大的问题。

首先,肯定不能用单个字符作(si-gram)为索引单元,否则查“上海”时,不能让含有“海上”也匹配。

但一句话:“北京天安门”,计算机如何按照中文的语言习惯进行切分呢?“北京天安门” 还是“北京天安门”?让计算机能够按照语言习惯进行切分,往往需要机器有一个比较丰富的词库才能够比较准确的识别出语句中的单词。

另外一个解决的办法是采用自动切分算法:将单词按照2元语法(bigram)方式切分出来,比如:"北京天安门" ==> "北京京天天安安门"。

这样,在查询的时候,无论是查询"北京" 还是查询"天安门",将查询词组按同样的规则进行切分:"北京","天安安门",多个关键词之间按与"and"的关系组合,同样能够正确地映射到相应的索引中。

这种方式对于其他亚洲语言:韩文,日文都是通用的。

基于自动切分的最大优点是没有词表维护成本,实现简单,缺点是索引效率低,但对于中小型应用来说,基于2元语法的切分还是够用的。

基于2元切分后的索引一般大小和源文件差不多,而对于英文,索引文件一般只有原文件的30%-40%不同,目前比较大的搜索引擎的语言分析算法一般是基于以上2个机制的结合。

关于中文的语言分析算法,大家可以在Google查关键词"wordsegment search"能找到更多相关的资料。

安装和使用下载:/lucene/注意:Lucene中的一些比较复杂的词法分析是用JavaCC生成的(JavaCC:JavaCompilerCompiler,纯Java 的词法分析生成器),所以如果从源代码编译或需要修改其中的QueryParser、定制自己的词法分析器,还需要从https:///下载javacc。

lucene的组成结构:对于外部应用来说索引模块(index)和检索模块(search)是主要的外部应用入口简单的例子演示一下Lucene的使用方法:索引过程:从命令行读取文件名(多个),将文件分路径(path字段)和内容(body 字段)2个字段进行存储,并对内容进行全文索引:索引的单位是Document对象,每个Document对象包含多个字段Field对象,针对不同的字段属性和数据输出//使用方法:: IndexFiles [索引输出目录] [索引的文件列表] ...public static void main(String[] args) throws Exception {String indexPath = args[0];IndexWriter writer;//用指定的语言分析器构造一个新的写索引器(第3个参数表示是否为追加索引)writer = new IndexWriter(indexPath, new SimpleAnalyzer(), false);for (int i=1; i<args.length; i++) {System.out.println("Indexing file " + args[i]);InputStream is = new FileInputStream(args[i]);//构造包含2个字段Field的Document对象//一个是路径path字段,不索引,只存储//一个是内容body字段,进行全文索引,并存储Document doc = new Document();doc.add(Field.UnIndexed("path", args[i]));doc.add(Field.Text("body", (Reader) new InputStreamReader(is))); //将文档写入索引writer.addDocument(doc);is.close();};//关闭写索引器writer.close();}}索引过程中可以看到:∙语言分析器提供了抽象的接口,因此语言分析(Analyser)是可以定制的,虽然lucene缺省提供了2个比较通用的分析器SimpleAnalyser和StandardAnalyser,这2个分析器缺省都不支持中文,所以要加入对中文语言的切分规则,需要修改这2个分析器。

∙Lucene并没有规定数据源的格式,而只提供了一个通用的结构(Document 对象)来接受索引的输入,因此输入的数据源可以是:数据库,WORD文档,PDF文档,HTML文档……只要能够设计相应的解析转换器将数据源构造成成Docuement对象即可进行索引。