十几种著名的神经网络

神经网络的发展历程与应用

神经网络的发展历程与应用神经网络是一种仿生的人工智能技术,它模拟了人类大脑中神经元之间的连接和信息传递方式,具有自学习和适应性强的特点。

神经网络的发展历程可以追溯到上世纪50年代,经过了长期的理论研究和应用实践,如今已经成为了人工智能领域中的重要技术之一。

本文将从神经网络的发展历程、基本模型、优化算法以及应用领域等方面进行介绍。

一、神经网络的发展历程神经网络的发展历程可以分为三个阶段,分别是感知机、多层前馈神经网络和深度学习。

1. 感知机感知机是神经网络的起源,由美国心理学家罗森布拉特于1957年提出。

感知机是一种单层神经网络,由若干感知器(Perceptron)组成。

每个感知器接收输入信号并进行加权和,然后经过一个阈值函数得到输出。

该模型的最大缺点是只能处理线性可分问题,无法解决非线性问题。

2. 多层前馈神经网络为了克服感知机的局限性,科学家们开始尝试使用多层前馈神经网络来处理非线性问题。

多层前馈神经网络由输入层、隐藏层和输出层组成。

每个神经元都有一个激活函数,用于将输入信号转换为输出。

这种结构可以处理非线性问题,并且可以通过反向传播算法来训练网络参数。

多层前馈神经网络在图像识别、语音识别、自然语言处理等领域得到了广泛应用。

3. 深度学习深度学习是指使用多层神经网络来学习高层次特征表示的一种机器学习方法。

深度学习在计算机视觉、自然语言处理等领域有着广泛的应用。

其中最著名的就是卷积神经网络(CNN)和循环神经网络(RNN)。

卷积神经网络主要用于图像识别和分类问题,循环神经网络主要用于序列预测和语言建模。

二、神经网络的基本模型神经网络的基本模型可以分为三类,分别是前馈神经网络、反馈神经网络和自组织神经网络。

1. 前馈神经网络前馈神经网络是指信息只能从输入层到输出层流动的神经网络。

其中最常用的是多层前馈神经网络,它由多个隐藏层和一个输出层组成。

前馈神经网络的训练主要使用反向传播算法。

2. 反馈神经网络反馈神经网络是指信息可以从输出层到输入层循环反馈的神经网络。

neural information processing systems介绍

neural information processing systems介绍Neural information processing systems,简称neural nets,是一种模拟人类神经系统的计算模型,用于处理和解释大量数据。

它们在许多领域都有广泛的应用,包括但不限于机器学习、人工智能、自然语言处理、图像识别等。

一、神经网络的基本原理神经网络是由多个神经元互联而成的计算系统,通过模拟人脑的工作方式,能够学习和识别复杂的数据模式。

神经元是神经网络的基本单元,它接收输入信号,通过非线性变换和权重的加权和,产生输出信号。

多个神经元的组合形成了一个复杂的网络结构,能够处理大量的输入数据,并从中提取有用的信息。

二、神经网络的类型神经网络有多种类型,包括感知机、卷积神经网络(CNN)、循环神经网络(RNN)、长短期记忆(LSTM)和Transformer等。

每种类型都有其特定的应用场景和优势,可以根据具体的问题和数据特点选择合适的网络模型。

三、神经网络的发展历程神经网络的发展经历了漫长的历程,从最初的感知机到现在的深度学习技术,经历了多次变革和优化。

在这个过程中,大量的研究者投入了大量的时间和精力,不断改进网络结构、优化训练方法、提高模型的泛化能力。

四、神经网络的应用领域神经网络的应用领域非常广泛,包括但不限于图像识别、语音识别、自然语言处理、推荐系统、机器人视觉等。

随着技术的不断发展,神经网络的应用场景也在不断扩展,为许多领域带来了革命性的变革。

五、神经网络的未来发展未来神经网络的发展将面临许多挑战和机遇。

随着数据量的不断增加和计算能力的提升,神经网络将更加深入到各个领域的应用中。

同时,如何提高模型的泛化能力、降低计算复杂度、解决过拟合问题等也是未来研究的重要方向。

此外,神经网络的算法和理论也需要不断完善和深化,为未来的应用提供更加坚实的基础。

六、结论神经信息处理系统是一种强大的计算模型,具有广泛的应用领域和巨大的发展潜力。

神经网络介绍

神经网络简介神经网络简介:人工神经网络是以工程技术手段来模拟人脑神经元网络的结构和特征的系统。

利用人工神经网络可以构成各种不同拓扑结构的神经网络,他是生物神经网络的一种模拟和近似。

神经网络的主要连接形式主要有前馈型和反馈型神经网络。

常用的前馈型有感知器神经网络、BP 神经网络,常用的反馈型有Hopfield 网络。

这里介绍BP (Back Propagation )神经网络,即误差反向传播算法。

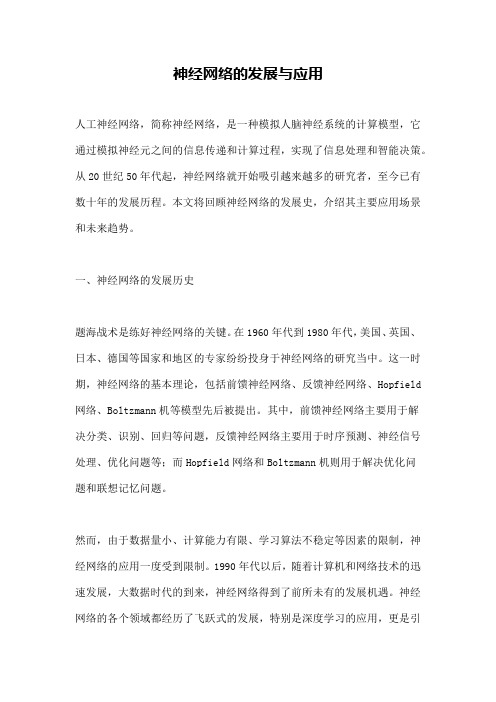

原理:BP (Back Propagation )网络是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一。

BP 神经网络模型拓扑结构包括输入层(input )、隐层(hide layer)和输出层(output layer),其中隐层可以是一层也可以是多层。

图:三层神经网络结构图(一个隐层)任何从输入到输出的连续映射函数都可以用一个三层的非线性网络实现 BP 算法由数据流的前向计算(正向传播)和误差信号的反向传播两个过程构成。

正向传播时,传播方向为输入层→隐层→输出层,每层神经元的状态只影响下一层神经元。

若在输出层得不到期望的输出,则转向误差信号的反向传播流程。

通过这两个过程的交替进行,在权向量空间执行误差函数梯度下降策略,动态迭代搜索一组权向量,使网络误差函数达到最小值,从而完成信息提取和记忆过程。

单个神经元的计算:设12,...ni x x x 分别代表来自神经元1,2...ni 的输入;12,...i i ini w w w 则分别表示神经元1,2...ni 与下一层第j 个神经元的连接强度,即权值;j b 为阈值;()f ∙为传递函数;j y 为第j 个神经元的输出。

若记001,j j x w b ==,于是节点j 的净输入j S 可表示为:0*nij ij i i S w x ==∑;净输入j S 通过激活函数()f ∙后,便得到第j 个神经元的输出:0()(*),nij j ij i i y f S f w x ===∑激活函数:激活函数()f ∙是单调上升可微函数,除输出层激活函数外,其他层激活函数必须是有界函数,必有一最大值。

神经网络的发展与应用

神经网络的发展与应用人工神经网络,简称神经网络,是一种模拟人脑神经系统的计算模型,它通过模拟神经元之间的信息传递和计算过程,实现了信息处理和智能决策。

从20世纪50年代起,神经网络就开始吸引越来越多的研究者,至今已有数十年的发展历程。

本文将回顾神经网络的发展史,介绍其主要应用场景和未来趋势。

一、神经网络的发展历史题海战术是练好神经网络的关键。

在1960年代到1980年代,美国、英国、日本、德国等国家和地区的专家纷纷投身于神经网络的研究当中。

这一时期,神经网络的基本理论,包括前馈神经网络、反馈神经网络、Hopfield 网络、Boltzmann机等模型先后被提出。

其中,前馈神经网络主要用于解决分类、识别、回归等问题,反馈神经网络主要用于时序预测、神经信号处理、优化问题等;而Hopfield网络和Boltzmann机则用于解决优化问题和联想记忆问题。

然而,由于数据量小、计算能力有限、学习算法不稳定等因素的限制,神经网络的应用一度受到限制。

1990年代以后,随着计算机和网络技术的迅速发展,大数据时代的到来,神经网络得到了前所未有的发展机遇。

神经网络的各个领域都经历了飞跃式的发展,特别是深度学习的应用,更是引领了神经网络技术的潮流。

二、神经网络的应用场景神经网络已经成为人工智能、机器学习中最重要的技术手段之一,几乎涉及到所有方面的应用场景。

以下将介绍几个具有代表性的应用案例。

1. 图像识别在图像识别领域,卷积神经网络(CNN)是当今最流行的神经网络之一。

它可以对图像进行特征提取和识别,广泛应用于人脸识别、车辆识别、智能安防等领域。

例如,当今最先进的人脸识别技术,就是基于CNN网络实现的。

2. 语音识别语音识别是另一个广泛应用神经网络的领域。

深度循环神经网络(RNN)和长短时记忆网络(LSTM)都是可以处理语音信号序列的网络模型,它们的应用范围包括语音识别、文本转语音(ConvTTS)等,可以极大地提高语音识别的准确率和稳定性。

神经网络

RBF神经网络学习算法需要求解的参数有3个:

基函数的中心、隐含层到输出层权值以及节点基 宽参数。根据径向基函数中心选取方法不同, RBF网络有多种学习方法,如梯度下降法、随机 选取中心法、自组织选区中心法、有监督选区中

心法和正交最小二乘法等。下面根据梯度下降法

,输出权、节点中心及节点基宽参数的迭代算法 如下。

讲 课 内 容

神经网络的概述与发展历史 什么是神经网络 BP神经网络 RBF神经网络 Hopfield神经网络

1.神经网络概述与发展历史

神经网络(Neural Networks,NN)是由大量的、 简单的处理单元(称为神经元)广泛地互相连接 而形成的复杂网络系统,它反映了人脑功能的许 多基本特征,是一个高度复杂的非线性动力学习 系统。 神经网络具有大规模并行、分布式存储和处理、 自组织、自适应和自学能力,特别适合处理需要 同时考虑许多因素和条件的、不精确和模糊的信 息处理问题。

4.RBF神经网络

使用RBF网络逼近下列对象:

2 F 20 x1 10cos2x1 x2 10cos2x2 2

4.RBF神经网络

RBF网络的优点:

神经网络有很强的非线性拟合能力,可映射任意复杂的非线 性关系,而且学习规则简单,便于计算机实现。具有很强 的鲁棒性、记忆能力、非线性映射能力以及强大的自学习 能力,因此有很大的应用市场。 ① 它具有唯一最佳逼近的特性,且无局部极小问题存在。

1.自学习和自适应性。

由于神经元之间的相对 决定的。每个神经元都可以根据接受 5.分布式存储。 独立性,神经网络学习的 到的信息进行独立运算和处理,并输 “知识”不是集中存储在网 出结构。同一层的不同神经元可以同 络的某一处,而是分布在网 时进行运算,然后传输到下一层进行 络的所有连接权值中。 处理。因此,神经网络往往能发挥并 行计算的优势,大大提升运算速度。

循环神经网络RNN发展史概述

循环神经网络RNN发展史概述循环神经网络(ReCUrrentNeura1Network,RNN)是一类以序列(sequence)数据为输入,在序列的演进方向进行递归(recursion)且所有节点(循环单元)按链式连接的递归神经网络(recursiveneura1network)o对循环神经网络的研究始于二十世纪80-90年代,并在二H世纪初发展为深度学习(deepIearning)算法之一,其中双向循环神经网络(BidireCtionaIRNN,Bi-RNN)和长短期记忆网络(1ongShort-TermMemorynetworks,1STM)是常见的循环神经网络。

1982年,美国加州理工学院物理学家JOhnHoPfie1d发明了一种单层反馈神经网络Hopfie1dNetwork,用来解决组合优化问题。

这是最早的RNN的雏形。

86年,另一位机器学习的泰斗MiChaeI1Jordan定义了Recurrent的概念,提出JordanNetwork o1990年,美国认知科学家Jeffrey1.E1man对JordanNetwork进行了简化,并采用BP算法进行训练,便有了如今最简单的包含单个自连接节点的RNN模型。

但此时RNN 由于梯度消失(GradientVaniShing)及梯度爆炸(GradientEXPIOding)的问题,训练非常困难,应用非常受限。

直到1997年,瑞土人工智能研究所的主任JurgenSchmidhuber提出长短期记忆(1STM),1STM使用门控单元及记忆机制大大缓解了早期RNN训练的问题。

同样在1997年,MikeSChUSter提出双向RNN模型(BidireCtiona1RNN)o这两种模型大大改进了早期RNN结构,拓宽了RNN的应用范围,为后续序列建模的发展奠定了基础。

此时RNN虽然在一些序列建模任务上取得了不错的效果,但由于计算资源消耗大,后续几年一直没有太大的进展。

五大神经网络模型解析

五大神经网络模型解析近年来,人工智能的快速发展使得深度学习成为了热门话题。

而深度学习的核心就在于神经网络,它是一种能够模拟人脑神经系统的计算模型。

今天,我们就来一起解析五大神经网络模型。

1.前馈神经网络(Feedforward Neural Network)前馈神经网络是最基本的神经网络模型之一。

在前馈神经网络中,信息是单向传输的,即神经元的输出只会被后续神经元接收,不会造成回流。

前馈神经网络能够拟合线性和非线性函数,因此在分类、预测等问题的解决中被广泛应用。

前馈神经网络的一大优势在于简单易用,但同时也存在一些缺点。

例如,神经网络的训练难度大、泛化能力差等问题,需要不断探索解决之道。

2.循环神经网络(Recurrent Neural Network)与前馈神经网络不同,循环神经网络的信息是可以进行回流的。

这意味着神经元的输出不仅会传向后续神经元,还会传回到之前的神经元中。

循环神经网络在时间序列数据的处理中更为常见,如自然语言处理、语音识别等。

循环神经网络的优点在于增强了神经网络处理序列数据的能力,但是它也存在着梯度消失、梯度爆炸等问题。

为了解决这些问题,一些变种的循环神经网络模型应运而生,如长短期记忆网络(LSTM)、门控循环单元(GRU)等。

3.卷积神经网络(Convolutional Neural Network)卷积神经网络是一种类似于图像处理中的卷积操作的神经网络模型。

卷积神经网络通过卷积神经层和池化层的堆叠来对输入数据进行分层提取特征,从而进一步提高分类性能。

卷积神经网络在图像、视频、语音等领域的应用非常广泛。

卷积神经网络的优点在于对于图像等数据具有先天的特征提取能力,可以自动识别边缘、角点等特征。

但是,卷积神经网络也存在着过拟合、泛化能力欠佳等问题。

4.生成对抗网络(Generative Adversarial Network)生成对抗网络可以说是最近几年最热门的神经网络模型之一。

它基于博弈论中的对抗训练模型,由两个神经网络构成:生成器和判别器。

了解神经网络的不同类型及其优势

了解神经网络的不同类型及其优势神经网络是一种模拟人脑神经系统的计算模型,它通过各个神经元之间的连接以及连接权值的调整来实现信息的处理和学习。

随着人工智能领域的发展,神经网络在图像识别、自然语言处理、推荐系统等应用中发挥着重要的作用。

本文将介绍神经网络的不同类型及其优势。

一、前馈神经网络(Feedforward Neural Network)前馈神经网络是最基本的神经网络类型之一,它的信息流只能沿着前向的路径传递,不允许回路出现。

前馈神经网络通常由输入层、隐含层(可能存在多个)、输出层组成。

其中,输入层接收外部输入的数据,隐含层进行信息的处理和转换,输出层输出网络的结果。

前馈神经网络的优势在于其简单性和易于理解。

通过调整连接权值和选择合适的激活函数,前馈神经网络可以实现各种复杂的非线性映射关系,从而适用于多种任务。

二、循环神经网络(Recurrent Neural Network)循环神经网络是一种具有循环连接的神经网络类型,它可以根据以前的计算结果进行自我反馈。

相比于前馈神经网络,循环神经网络具有记忆功能,适用于处理序列数据,比如语音识别、语言模型等。

循环神经网络的优势在于其能够捕捉序列数据中的时间依赖关系。

通过循环连接,网络可以利用之前的状态信息来影响当前的输出,从而实现对历史信息的记忆和利用。

三、卷积神经网络(Convolutional Neural Network)卷积神经网络是一种专门用于处理网格结构数据的神经网络类型,如图像、视频等。

其核心思想是利用卷积层和池化层来提取图像中的特征,最终通过全连接层进行分类或回归任务。

卷积神经网络的优势在于其能够自动学习图像中的特征。

通过卷积操作,网络可以提取图像的局部特征,并通过池化操作减少参数量,使网络具有更好的计算效率和推广能力。

四、生成对抗网络(Generative Adversarial Network)生成对抗网络是由生成器和判别器两个部分组成的,它们通过对抗的方式相互协调来提高网络的性能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1977

解释概念形成,分类和知识处理(从资料中抽取知识)

只能作一次性决策,无重复性共振。

这是具有最小均方差的单层自联想网络。类似于双向联想记忆,可对片断输入补全。

Neocognition

(新认知机)

FukushimaK

福岛邦彦(日本广播协会)

1978—1984

手写字母识别

需要大量加工单元和联系。

是一多层结构化学符识别网络。是已开发的最复杂网络之一,对输入模式的大小、平移和旋转无关,能识别复杂字(如汉字)。

Self-Organizing feature map(自组织特征映射网络)

Tuevo Kohonen(芬兰Helsinki技术大学)

1980

语音识别,机器人控制,工业过程控制(特别是半导体生产中的扩散工艺过程),通信自适应器、图像压缩、雷达、专家系统等。

十几种著名的神经网络

名称

发明人或开发人

起止年代

主要应用领域

局限性

评述

Perceptron

(感知机)

Frank Rosenblatt

(康奈尔大学)

1957

文学识别(打字字母识别),声音识别,声纳信号识别以及学习记忆问题的研究。

不能识别复杂字形(如汉字),对字的大小,平移和歪斜敏感。

是一组可训练的线性分类的单层网络。这是最古老的网络,已制成硬件,这种最简单的感知机已很少用。

Adaline(Adaptive linear element)和Madaline(多适应线性单元)

Bernard Widrow

(斯坦福大学)

1960—1962

雷达天线控制、自适应均衡机回波抵消,雷达干扰的适应性消除,适应性调制解调,电话线中适应性补偿等方面。

假定输入和输出之间呈线性关系。

具有最小方差学习功能的线性网络,学习功能强。Madaline是Adaline的扩展,商业上应用已有二十多年了。

需要大量处理单元和连接,需要高度准确。

这是一种在功能上作为统计最优化和概率密度函数分析的网络。

由相同神经元构成的双向联想式单层网络,具有学习功能。最容易学的一种网络,是一种好的教具,能把对象的片断联系称完整的对子。

Counter

Propagation

(CPN)

RobertBiblioteka Hecht-Nielsen

1986

神经网络计算机Mark 3,Mark 4(1985),Anza(1987),Anza Plus(1988)图像分析和统计分析。

这是使用一噪声过程来取代价函数的全局极小值的网络,在这种简单的网络中使用噪声函数去寻找全局最优。

Bidirectional Associative Memory(BAM)(双向联想记忆自适应BAM)

Bart Kosko

(南加州大学)

1985—1988

内容寻址的联想记忆。

存储的密度低。

资料数据必须适应编码。

Avalanche

(雪崩网)

S.Grossberg

(波士顿大学)

1967

连续读音识别,机器人手臂运动的教学指令。

会重演一系列错误动作,不易改变运动速度和插入运动。

只是一类网络而已,没有一种简单的网络能做所有这些任务。

Cerellatron

(小脑自动机)

D.marr(麻省理工学院)

J.Albus(NBS)

A.Pellionez(NYU)

1969—1982

控制机器人的手臂运动。

需要复杂的控制输入。

类似于Avalanche网络,能调和各种指令序列,按需要缓慢地插入动作。

Back Propagation

(反传网络)

P.Werbos(哈佛大学)

David Rumelhart and James McClelland

需要大量的联系和训练。

描述某种最优映射,能把某一几何区域映射到另一区。对于空气动力学计算优于许多数值计算方法。

Hopfield网络

John Hopfield

(加州理工学院)

1982

求解TSP问题,线性规划,货流问题,联想记忆和用于辨识。

不能学习,权重必须实现给定。连续需要对称。

由相同元件构成的单层而且不带学习功能的自联想网络。从片断资料或图像取回完整的。能在大规模尺度中实现。

Adaptive

Resonance Theory

(自适应谐振理论ART)现已有ART1到ART3三种类型

G Carpenter and

S Grossberg(波士顿大学)

1976—1990

模式识别,特别是复杂模式或者对人来说不熟悉的模式(雷达或声纳讯号,声控打印等)。最近在图像识别、语音识别及生产中得到应用

Boltzman and Cauchy machines(玻尔兹曼机和柯希机)

J.Hinton(多伦多大学)

T.Sejnowski

(霍布金斯大学)

Ackley

Harold H Szu(斯华龄)(海军研究所实验室)

1985—1986

图像、声纳、雷达等模式识别。

玻尔兹曼机训练时间长,柯希机在某些统计分布情况下产生噪声。

(斯坦福大学)

D.Parker

(斯坦福大学)

1974—1985

课文的语言合成,机器人手臂的适应控制,语言识别,慢过程有滞后环节的工业过程控制,银行贷款的信用打分,股票和保险等方面,自适应控制。

仅是有教师(指导)的训练,必须有大量的输入输出样本来纠正。

是多层映射网络,采用最小均方差的学习方式。时至今日,仍然是最普及和最广泛应用的网络,工作良好,容易学习。

受平移、歪斜及尺度的影响。

ART1和ART2可以对任意多和任意复杂的二维模式进行自组织、自稳定和大规模并行处理,前者用于二进制输入,后者用于连续信号输入。系统太复杂,难以用硬件实现,应用受到限制

名称

发明人或开发人

起止年代

主要应用领域

局限性

评述

BrainStatein a Box

(BSB网络)

James Anderson