分布式系统中的数据一致性问题33页PPT文档

分布式系统概念--第一篇一致性协议、一致性模型、拜占庭问题、租约、副本协议

分布式系统概念--第⼀篇⼀致性协议、⼀致性模型、拜占庭问题、租约、副本协议1,⼀致性协议两阶段提交协议与Raft协议、Paxos协议①两阶段提交协议在分布式系统中,每个节点虽然可以知晓⾃⼰的操作时成功或者失败,却⽆法知道其他节点的操作的成功或失败。

当⼀个事务跨越多个节点时,为了保持事务的特性,需要引⼊⼀个作为协调者的组件来统⼀掌控所有节点(称作参与者)的操作结果并最终指⽰这些节点是否要把操作结果进⾏真正的提交(⽐如将更新后的数据写⼊磁盘等等)。

因此,⼆阶段提交的算法思路可以概括为:参与者将操作成败通知协调者,再由协调者根据所有参与者的反馈情报决定各参与者是否要提交操作还是中⽌操作。

因此,系统包含两类节点,⼀类是协调者,⼀类是参与者,协议的执⾏由两个阶段组成:具体参考:两阶段协议是阻塞的,节点在等待对⽅的应答消息时,它不能做其他事情且持有的资源也不释放。

它主要是⽤来保证跨多个节点的操作的原⼦性--要么都操作,要么都不操作,⽽像Raft协议则诸如⽤来保证操作的⼀致性,即各个节点都执⾏相同的操作。

两阶段协议的举例参考:②Raft协议和Paxos协议Raft与Paxos 在分布式应⽤中的基本功能相似,但是Paxos难于理解,相对⽽⾔Raft算法要简单⼀些。

关于Raft协议有⼀篇经典的论⽂:其中⽂翻译地址参考:还有⼀篇⽂章详细解释了Raft算法的相关实现:Raft论⽂的第 31 号参考⽂献。

下⾯仅记录⼀下看论⽂过程中出现的⼀个问题:为什么 “⼤多数规则” 能够保证对于⼀个给定的任期,只会有⼀个候选⼈最终赢得选举成为Leader?在Raft中,对于⼀个给定的任期号,每⼀台Server按照先来先服务原则对该任期号最多只投⼀张票,若某Candidate发送的请求投票RPC带有的任期号获得超过半数的Server的同意,则该Candidate成为Leader。

正是由于每个Server对某个任期只最多投⼀次票,且获得的投票要超过半数才能成为Leader,故在⼀个给定的任期投票中,最终只会有⼀个Candidate成为Leader。

数据库中的数据一致性

数据库中的数据一致性随着互联网的快速发展,各种应用程序和软件系统的数量急剧增加,这些系统中存储的数据也随之增加。

每个软件系统都有自己的数据库,其中包含了各种各样的数据,如用户的账户信息、商品的信息和订单信息等。

但是,如何确保这些数据在不同的系统中的一致性呢?这就需要数据库中的数据一致性来保证。

一、数据库中的数据一致性概述1.1 什么是数据库中的数据一致性?数据库中的数据一致性是指数据在不同的系统中的一致性,也就是说,当一个用户在一个系统中修改了数据后,其他系统中存储的数据也应该相应地进行更新。

例如,当一个用户在一个电商平台上购买商品时,他的订单信息应该保存在订单系统中,商品的信息应该保存在商品系统中,账户信息应该保存在账户系统中。

如果这些系统中的数据不一致,可能会导致严重的问题,如商品被重复购买或订单被错误地处理。

1.2 数据库中的数据一致性问题数据库中的数据一致性问题主要包括以下两方面:1.2.1 数据复制问题在分布式数据库中,数据通常会被存储在多个节点中,这些节点之间需要进行数据复制,以确保数据在不同的节点中的一致性。

然而,在数据复制过程中,可能会出现数据丢失、数据不一致和数据干扰等问题,从而导致数据一致性问题。

1.2.2 并发访问问题在数据库中,多个用户可以同时访问同一份数据,这就会导致并发访问问题。

并发访问问题主要包括以下两个方面:(1)读写冲突:当多个用户同时尝试修改同一份数据时,可能会出现读写冲突,从而导致数据的更新丢失或数据不一致。

(2)脏读:当一个用户读取一个未提交的数据时,可能会导致脏读问题,从而导致数据的更新丢失或数据不一致。

二、数据库中的数据一致性解决方案2.1 数据分片数据分片是指将数据库中的数据分成多个分片(或分区),每个分片都存储在不同的节点上。

当多个用户同时访问同一份数据时,可以将其分配到不同的分片中,从而避免了读写冲突和脏读问题。

同时,数据分片也可以提高系统的性能和可扩展性。

《分布式算法》课件

负载均衡

总结词

在分布式系统中,负载均衡是确保各个节点能够均匀地承担处理任务,避免部 分节点过载的关键问题。

详细描述

负载均衡涉及到如何将任务分配给多个节点,以便每个节点都能以最小的负担 完成工作。这需要考虑到任务的性质、节点的性能和网络状况等多个因素,以 确保系统的整体性能和稳定性。

数据同步

总结词

特点包括:节点自治性、通信能力、任务并行性、系统可扩展性等。

分布式系统的通信协议

01

通信机制与规则

02

通信协议是分布式系统中节点间进行信息 交互的规则和标准。

03

常见的通信协议包括TCP/IP、HTTP、FTP 等。

04

协议中规定了数据传输的格式、数据交换 的规则、数据传输的路由等。

分布式系统的数据一致性

大数据处理

在大数据处理中,数据被分散到 多个节点上进行处理,分布式算 法用于协调各个节点的计算任务 ,提高数据处理效率。

物联网

在物联网中,各种设备需要相互 通信和协作以实现智能化,分布 式算法用于实现设备的协同工作 。

02

分布式系统基础

分布式系统的定义与特点

核心定义与特性

分布式系统是一种由多个独立节点通过网络互连,协同完成共同任务的计算机系统 。

系统中节点可能随时失效,需 要算法具备容错性。

数据一致性与完整性

在分布式环境中保持数据一致 性和完整性是重要挑战。

分布式算法的未来发展方算,处 理海量数据。

人工智能与机器学习

利用分布式算法加速AI和机器学习模型的训 练和应用。

物联网

结合物联网设备,实现更广泛的分布式系统 应用。

Paxos算法

适用场景

适用于需要强一致性的分布式系统, 如数据库、分布式存储等。

解决分布式计算中的数据传输和同步问题

解决分布式计算中的数据传输和同步问题在分布式计算中,数据传输和同步问题是非常关键的,直接影响到系统的性能和可靠性。

在这篇文章中,我们将探讨如何解决这些问题,并介绍一些常用的技术和方法。

一、数据传输问题在分布式计算中,数据传输通常是指将数据从一个节点传输到另一个节点。

数据传输问题主要包括传输速度、数据可靠性和传输延迟等方面的挑战。

1.传输速度传输速度是指在单位时间内传输的数据量。

在分布式计算中,数据量通常很大,因此传输速度是一个关键因素。

为了提高传输速度,可以采取以下几种方法:-使用高速网络:采用高速网络(如千兆以太网、光纤网络等)可以显著提高数据传输速度。

-减少传输数据量:可以采取压缩算法或只传输数据的摘要或差异,从而减少传输数据量。

-并行传输:将数据分成多个部分,并通过多个通道并行传输,从而提高传输速度。

2.数据可靠性数据可靠性是指在传输过程中数据不发生丢失或损坏。

为了确保数据的可靠性,可以采取以下几种方法:-使用校验和:在传输数据前计算数据的校验和,并在接收端校验。

如果校验和不匹配,则说明数据损坏。

-使用冗余数据:传输数据时添加冗余信息,如校验和、冗余位等,以便在数据发生损坏时进行恢复。

-数据确认机制:在传输过程中,接收方向发送方发送确认信息,以确保数据的正确传输。

3.传输延迟传输延迟是指数据从发送方到接收方的时间延迟。

在分布式计算中,传输延迟可能会对系统的性能产生重大影响。

为了降低传输延迟,可以采取以下几种方法:-使用高速网络:采用高速网络可以显著降低传输延迟。

-数据预取:提前将数据缓存到接收方节点,以便在需要时能够立即访问。

-数据分片:将数据分成多个小块进行传输,从而降低传输延迟。

二、数据同步问题在分布式计算中,数据同步是指多个节点之间保持数据一致性的过程。

数据同步问题主要包括数据一致性、并发控制和数据冲突等方面的挑战。

1.数据一致性数据一致性是指多个节点之间的数据保持一致。

在分布式计算中,由于节点之间的通信延迟和可能的节点故障,很难保证数据的一致性。

分布式系统的数据一致性考核试卷

B.应用程序

C.中间件

D.网络设施

14.以下哪个概念用于描述分布式系统中数据在不同节点间的复制过程?()

A.数据同步

B.数据分区

C.数据冗余

D.数据压缩

15.在分布式系统中,以下哪种情况可能导致数据不一致?()

A.网络延迟

B.硬盘故障

C.操作系统故障

D.所有以上情况

16.以下哪个概念用于描述分布式系统中多个副本之间的数据同步状态?()

2.描述分布式系统中的CAP定理,并解释为什么在实际应用中很难同时满足这三个属性。

3.详细说明Paxos算法的基本原理,以及它是如何解决分布式系统中的数据一致性问题。

4.讨论分布式系统中的数据分区和复制策略,包括它们的优势和可能带来的挑战。

标准答案

一、单项选择题

1. B

2. C

3. A

4. B

5. C

D.所有以上策略

13.分布式系统中,哪些技术可以用来减少数据冗余?()

A.数据去重

B.数据压缩

C.数据加密

D.数据分区

14.以下哪些是分布式系统中的常见一致性协议?()

A. Raft

B. Paxos

C. Gossip

D. HTTP

15.在分布式系统中,哪些因素可能导致读取到旧数据?()

A.网络延迟

B.数据复制延迟

1.分布式系统中,CAP定理描述了三个基本属性,分别是_______、_______和_______。

2.在分布式系统中,为了提高可用性,通常会采用_______和_______的策略。

3.分布式一致性算法Paxos和Raft都是为了解决_______问题。

4.在分布式数据库中,_______一致性保证了客户端总是能读取到最新的写入数据。

分布式数据同步方案

分布式数据同步方案引言在分布式系统中,数据的同步是一个重要的问题。

由于分布式系统中的节点分布在不同的地理位置和网络环境下,数据同步的实现变得非常困难。

本文将介绍一种分布式数据同步的方案,该方案可以有效地解决数据同步的问题,并确保数据在分布式系统中的一致性。

方案概述我们提出的分布式数据同步方案基于主从式架构。

主节点负责接收数据更新并传播给从节点,从节点则负责接收并应用这些更新。

主从节点之间通过一种可靠的通信通道进行数据传输,以确保数据的可靠性和一致性。

方案细节节点角色我们的方案中共有两种节点角色:主节点(master)和从节点(slave)。

•主节点:主节点负责接收来自系统中的其他节点发送的数据更新,并将这些更新传播给从节点。

主节点保持了整个分布式系统中的数据状态的真实拷贝。

•从节点:从节点接收主节点发送的数据更新,并将其应用到本地数据状态中,以保持与主节点的数据一致。

数据更新传播数据更新是通过主节点向从节点发送消息来实现的。

主节点将数据更新打包成一条消息,并通过网络发送给从节点。

从节点收到消息后,将其解析并将数据更新应用到本地数据状态中。

为了确保数据的可靠性和一致性,我们提出了以下几个机制:1.确认机制:主节点在发送数据更新给从节点后,等待从节点的确认消息。

只有在收到从节点的确认消息后,主节点才认为数据更新已经成功传播给从节点。

2.重试机制:如果主节点在发送数据更新给从节点时遇到网络错误或者从节点没有及时响应,主节点将进行重试。

主节点将会持续尝试发送数据更新,直到收到从节点的确认消息。

3.容错机制:在分布式系统中,节点的故障是不可避免的。

为了应对节点故障,我们引入了备份节点的概念。

备份节点可以接管主节点的工作,确保数据更新的传播不受到影响。

数据一致性数据一致性是分布式数据同步的关键问题之一。

为了保持数据的一致性,我们使用了以下的策略:1.顺序保证:主节点按照更新顺序将数据发送给从节点。

从节点按照接收到数据的顺序应用到本地数据状态中。

如何解决分布式数据库中的数据不一致问题

解决分布式数据库中的数据不一致问题在当今互联网时代,分布式系统和数据库的应用已经司空见惯。

分布式数据库的出现,为处理大规模数据提供了便利,但同时也引发了数据一致性的问题。

不同节点之间的数据同步困难,可能造成数据不一致的情况。

这个问题一直以来困扰着软件工程师和数据库管理员。

本文将从几个方面讨论如何解决分布式数据库中的数据不一致问题。

一、理解数据一致性问题数据一致性是指在分布式系统中,多个节点之间的数据必须保持一致。

由于网络延迟、节点故障等原因,不同节点之间的数据同步可能出现延迟或错误。

而这个延迟或错误就导致了数据不一致的问题。

例如,用户在一个节点上修改了数据,但在同步到其他节点之前,其他节点已经读取了旧数据,就会导致数据的不一致性。

二、实现数据同步设计为了解决数据不一致问题,我们需要实现数据同步设计。

主要有以下几种方法:1. 异步复制异步复制是一种常见的数据同步方法。

在异步复制模式下,写操作不会等待数据同步到其他节点,而是立即返回成功,由后台进程负责将数据同步到其他节点。

这种模式可以提高写操作的性能,但数据同步有延迟,可能导致数据不一致的风险。

2. 同步复制同步复制是一种保证数据一致性的方法。

在同步复制模式下,写操作必须等待数据同步到所有节点之后才返回成功。

这样可以确保数据的一致性,但同时会牺牲写操作的性能。

在关键场景下,可以选择同步复制模式来保证数据的准确性。

3. 两阶段提交两阶段提交是一种常用的解决分布式数据库数据一致性问题的方法。

在两阶段提交过程中,有一个协调节点,负责协调各个参与者的数据操作。

首先,协调节点询问各个参与者是否能够提交事务,如果所有参与者都同意提交,协调节点再发送提交指令,否则发送中止指令,并撤销已经提交的事务。

两阶段提交可以保证所有节点的数据一致性,但同时增加了系统的复杂性和开销。

三、实现数据冲突解决机制除了数据同步设计,还需要考虑解决数据冲突的机制。

由于分布式系统的复杂性,不同节点可能在同一时间对同一数据进行修改操作,导致冲突。

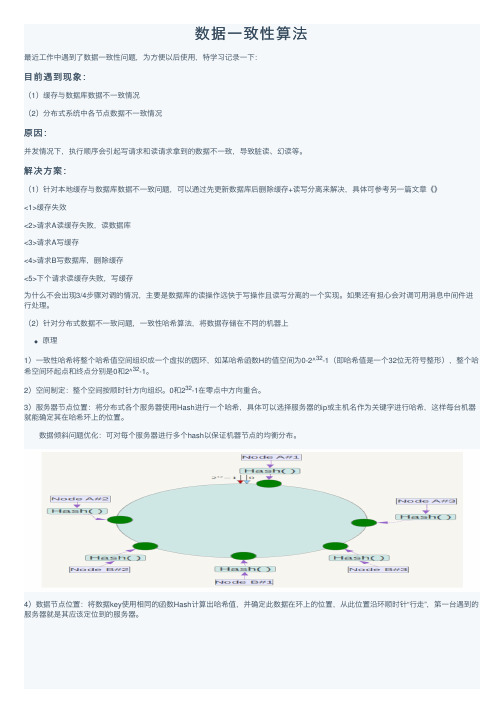

数据一致性算法

数据⼀致性算法最近⼯作中遇到了数据⼀致性问题,为⽅便以后使⽤,特学习记录⼀下:⽬前遇到现象:(1)缓存与数据库数据不⼀致情况(2)分布式系统中各节点数据不⼀致情况原因:并发情况下,执⾏顺序会引起写请求和读请求拿到的数据不⼀致,导致脏读、幻读等。

解决⽅案:(1)针对本地缓存与数据库数据不⼀致问题,可以通过先更新数据库后删除缓存+读写分离来解决,具体可参考另⼀篇⽂章《》<1>缓存失效<2>请求A读缓存失败,读数据库<3>请求A写缓存<4>请求B写数据库,删除缓存<5>下个请求读缓存失败,写缓存为什么不会出现3/4步骤对调的情况,主要是数据库的读操作远快于写操作且读写分离的⼀个实现。

如果还有担⼼会对调可⽤消息中间件进⾏处理。

(2)针对分布式数据不⼀致问题,⼀致性哈希算法,将数据存储在不同的机器上原理1)⼀致性哈希将整个哈希值空间组织成⼀个虚拟的圆环,如某哈希函数H的值空间为0-2^32-1(即哈希值是⼀个32位⽆符号整形),整个哈希空间环起点和终点分别是0和2^32-1。

2)空间制定:整个空间按顺时针⽅向组织。

0和232-1在零点中⽅向重合。

3)服务器节点位置:将分布式各个服务器使⽤Hash进⾏⼀个哈希,具体可以选择服务器的ip或主机名作为关键字进⾏哈希,这样每台机器就能确定其在哈希环上的位置。

数据倾斜问题优化:可对每个服务器进⾏多个hash以保证机器节点的均衡分布。

4)数据节点位置:将数据key使⽤相同的函数Hash计算出哈希值,并确定此数据在环上的位置,从此位置沿环顺时针“⾏⾛”,第⼀台遇到的服务器就是其应该定位到的服务器。

实操1. hash值计算:通过⽀持MD5与MurmurHash两种计算⽅式。

2. ⼀致性的实现:通过java的TreeMap来模拟环状结构,实现均匀分布 1.hash计算⽅法:MD5import java.security.MessageDigest;import java.security.NoSuchAlgorithmException;/** 实现⼀致性哈希算法中使⽤的哈希函数,使⽤MD5算法来保证⼀致性哈希的平衡性*/public class HashFunction {private MessageDigest md5 = null;public long hash(String key) {if (md5 == null) {try {md5 = MessageDigest.getInstance("MD5");} catch (NoSuchAlgorithmException e) {throw new IllegalStateException("no md5 algrithm found");}}md5.reset();md5.update(key.getBytes());byte[] bKey = md5.digest();//具体的哈希函数实现细节--每个字节 & 0xFF 再移位long result = ((long) (bKey[3] & 0xFF) << 24)| ((long) (bKey[2] & 0xFF) << 16| ((long) (bKey[1] & 0xFF) << 8) | (long) (bKey[0] & 0xFF));return result & 0xffffffffL;}}2.环的定义for (int i = 0; i < numberOfReplicas; i++) {// 对于⼀个实际机器节点 node, 对应 numberOfReplicas 个虚拟节点/** 不同的虚拟节点(i不同)有不同的hash值,但都对应同⼀个实际机器node* 虚拟node⼀般是均衡分布在环上的,数据存储在顺时针⽅向的虚拟node上*/circle.put(hashFunction.hash(node.toString() + i), node);}3.数据hash映射关系确定if (!circle.containsKey(hash)) {//数据映射在两台虚拟机器所在环之间,就需要按顺时针⽅向寻找机器SortedMap<Long, T> tailMap = circle.tailMap(hash);hash = tailMap.isEmpty() ? circle.firstKey() : tailMap.firstKey();}4.测试package erbuss;import java.util.*;public class ConsistentHash<T> {private HashFunction hashFunction;private int numberOfReplicas;// 节点的复制因⼦,实际节点个数 * numberOfReplicas = 虚拟节点个数private final SortedMap<Long, T> circle = new TreeMap<Long, T>();// 存储虚拟节点的hash值到真实节点的映射 public ConsistentHash(HashFunction hashFunction, int numberOfReplicas,Collection<T> nodes) {this.hashFunction = hashFunction;this.numberOfReplicas = numberOfReplicas;for (T node : nodes) {add(node);}}public void add(T node) {for (int i = 0; i < numberOfReplicas; i++)// 对于⼀个实际机器节点 node, 对应 numberOfReplicas 个虚拟节点/** 不同的虚拟节点(i不同)有不同的hash值,但都对应同⼀个实际机器node* 虚拟node⼀般是均衡分布在环上的,数据存储在顺时针⽅向的虚拟node上*/circle.put(hashFunction.hash(node.toString() + i), node);}public void remove(T node) {for (int i = 0; i < numberOfReplicas; i++)circle.remove(hashFunction.hash(node.toString() + i));}/** 获得⼀个最近的顺时针节点,根据给定的key 取Hash* 然后再取得顺时针⽅向上最近的⼀个虚拟节点对应的实际节点* 再从实际节点中取得数据*/public T get(Object key) {if (circle.isEmpty())return null;long hash = hashFunction.hash((String) key);// node ⽤String来表⽰,获得node在哈希环中的hashCodeif (!circle.containsKey(hash)) {//数据映射在两台虚拟机器所在环之间,就需要按顺时针⽅向寻找机器SortedMap<Long, T> tailMap = circle.tailMap(hash);hash = tailMap.isEmpty() ? circle.firstKey() : tailMap.firstKey();}return circle.get(hash);}public long getSize() {return circle.size();}/** 查看MD5算法⽣成的hashCode值---表⽰整个哈希环中各个虚拟节点位置*/public void testBalance(){Set<Long> sets = circle.keySet();//获得TreeMap中所有的KeySortedSet<Long> sortedSets= new TreeSet<Long>(sets);//将获得的Key集合排序System.out.println("[1]节点为: ----");for(Long hashCode : sortedSets){System.out.print(hashCode);System.out.print(",");}System.out.println("----");System.out.println("[2]节点间距为: ----");/** 查看⽤MD5算法⽣成的long hashCode 相邻两个hashCode的差值*/Iterator<Long> it = sortedSets.iterator();Iterator<Long> it2 = sortedSets.iterator();if(it2.hasNext())it2.next();long keyPre, keyAfter;while(it.hasNext() && it2.hasNext()){keyPre = it.next();keyAfter = it2.next();System.out.print(keyAfter - keyPre);System.out.print(",");}System.out.println("----");}//根据key查找对应的节点public String getNodeForKey(String key) {long hash = hashFunction.hash(key);if (!circle.containsKey(hash)) {//数据映射在两台虚拟机器所在环之间,就需要按顺时针⽅向寻找机器SortedMap<Long, T> tailMap = circle.tailMap(hash);hash = tailMap.isEmpty() ? circle.firstKey() : tailMap.firstKey();}return circle.get(hash)+",hash为:"+hash;}public static void main(String[] args) {Set<String> nodes = new HashSet<String>();nodes.add("A");nodes.add("B");nodes.add("C");ConsistentHash<String> consistentHash = new ConsistentHash<String>(new HashFunction(), 2, nodes); System.out.println("hash circle size: " + consistentHash.getSize());consistentHash.testBalance();System.out.println("[3]数据分配情况为: ----");for (int i = 0; i < 10; i++){String Key="user_" + i;System.out.println("Key:"+i+"分配到的Server为:"+consistentHash.getNodeForKey(Key));}//新加⼀节点consistentHash.add("D");System.out.println("hash circle size: " + consistentHash.getSize());consistentHash.testBalance();System.out.println("[3]数据分配情况为: ----");for (int i = 0; i < 10; i++){String Key="user_" + i;System.out.println("Key:"+i+"分配到的Server为:"+consistentHash.getNodeForKey(Key));}//删除⼀节点consistentHash.remove("A");System.out.println("hash circle size: " + consistentHash.getSize());consistentHash.testBalance();System.out.println("[3]数据分配情况为: ----");for (int i = 0; i < 10; i++){String Key="user_" + i;System.out.println("Key:"+i+"分配到的Server为:"+consistentHash.getNodeForKey(Key));}}}结果hash circle size: 6[1]节点为: ----748451404,769404186,1696944585,1830063320,3862426151,3864615324,----[2]节点间距为: ----20952782,927540399,133118735,2032362831,2189173,----[3]数据分配情况为: ----Key:0分配到的Server为:B,hash为:748451404Key:1分配到的Server为:B,hash为:1696944585Key:2分配到的Server为:A,hash为:1830063320Key:3分配到的Server为:A,hash为:3862426151Key:4分配到的Server为:A,hash为:3862426151Key:5分配到的Server为:B,hash为:748451404Key:6分配到的Server为:A,hash为:3862426151Key:7分配到的Server为:B,hash为:748451404Key:8分配到的Server为:B,hash为:748451404Key:9分配到的Server为:A,hash为:3862426151hash circle size: 8[1]节点为: ----748451404,769404186,1696944585,1830063320,3372629518,3766042698,3862426151,3864615324,----[2]节点间距为: ----20952782,927540399,133118735,1542566198,393413180,96383453,2189173,----[3]数据分配情况为: ----Key:0分配到的Server为:B,hash为:748451404Key:1分配到的Server为:B,hash为:1696944585Key:2分配到的Server为:A,hash为:1830063320Key:3分配到的Server为:D,hash为:3372629518Key:4分配到的Server为:D,hash为:3372629518Key:5分配到的Server为:B,hash为:748451404Key:6分配到的Server为:D,hash为:3766042698Key:7分配到的Server为:B,hash为:748451404Key:8分配到的Server为:B,hash为:748451404Key:9分配到的Server为:D,hash为:3372629518hash circle size: 6[1]节点为: ----748451404,769404186,1696944585,3372629518,3766042698,3864615324,----[2]节点间距为: ----20952782,927540399,1675684933,393413180,98572626,----[3]数据分配情况为: ----Key:0分配到的Server为:B,hash为:748451404Key:1分配到的Server为:B,hash为:1696944585Key:2分配到的Server为:D,hash为:3372629518Key:3分配到的Server为:D,hash为:3372629518Key:4分配到的Server为:D,hash为:3372629518Key:5分配到的Server为:B,hash为:748451404Key:6分配到的Server为:D,hash为:3766042698Key:7分配到的Server为:B,hash为:748451404Key:8分配到的Server为:B,hash为:748451404Key:9分配到的Server为:D,hash为:3372629518从上⾯执⾏结果可以看出哈希⼀致性算法的优势,对于删除节点或新增节点仅影响对于⽚区内的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

对同步变量(可与信号量类比)的访问是顺序一致的; 在所有以前的写操作结束之前,不的访问同步变量; 在先前所有的同步变量访问完成以前,不得访问共享数 据。

第五章 分布式系统中的数据一致性问题

实现考虑:

为保证第一点,对同步变量的访问必须立即广播。在广播完成之前, 其他程序不的访问别的同步变量;

见并保持顺序一致。并发的写操作在不同计算机上看来可以 顺序不同。

[例1] 程序P1:W(x,1) … W(x,3)

P2: R(x)1 W(x,2)

P3: R(x)1 …

R(x)2 R(x)3

P4: R(x)1 …

R(x)3 R(x)2

符合因果一致性要求,但违反了顺序一致性。因为P3和P4见 到访问顺序不同。

但是,打印结果只有6个数字、64种可能。其中,000000 和001001显然不可能。

应该承认所有合理的结果。例如,001011,表示执行的次 序为:

A=1 print(b,c) b=1 print(a,c) c=1

print(a,b)

第五章 分布式系统中的数据一致性问题

● 因果一致性:可能因果相关的写操作应对所有程序可

因果一致性在实现时必须建立与维护依赖图,这里涉及 到语义上的以来,是相当困难的。

第五章 分布式系统中的数据一致性问题

● PRAM一致性:一个程序的写操作被其他进程以指定

的顺序见到,不同程序的写操作在不同程序看来次序可以不 同。

[例1] P1: W(x,1) …

P2: … R(x)1 W(x,2)

P3:

不使用同步操作

严格:所有访问时间绝对顺序

最强

顺序:所有程序以相同所有

因果联系事件

PRAM:所有程序按预定次序到来自一 台机器的写操作,来自其他机

器的写操作顺序不必相同

使用同步操作 弱:同步完成后共享数据才保持一致 释放:离开临界区后共享数据才保持

一致 入口:进入临界区时共享数据保持一致

程序A a=1

Print(b,c)

程序B … a=1 …

程序C … a=1 …

…

Print(a,c)

Print(a,b)

…

…

C=1

b=1

…

…

这里只列出本程序感兴趣(与自己的打印有关)的语句执行次序

第五章 分布式系统中的数据一致性问题

PRAM一致性要求虽然较弱,但它要求程序的写操作必 须被其他程序看到(尽管他们的顺序可以不同)。实际上, 这样的要求有点过高,每一个程序只要能够看到与自己有关 的其他程序的写操作就可以了。

程序在访问共享变量之前必须成功完成“获取”操作; 完成“释放”操作前,程序的访问操作必须结束; “获取”、“释放”应保证顺序一致性。 释放一致性与用信号量和P、V操作来保证临界区访问正 确性何其相似乃尔!

与此相对应,还可以有入口一致性。

第五章 分布式系统中的数据一致性问题

小结:

一致性模型可以分为两类:

第五章 分布式系统中的数据一致性问题

第五章 分布式系统中的数据一致性问题

§1.分布式系统中数据一致性存在的困 难

1.高度并行带来的问题

本机内多任务并行带来的困难 多机并行带来的困难 网络延迟不可预测

2.多副本带来的问题

系统中存在多个副本,数据的修改通常会在不同的副 本上进行

第五章 分布式系统中的数据一致性问题

3. 空间数据所存在的特殊困难 跨机图幅的接边问题 拓扑关系的全局动态改变与生成问题

(即所有程序的访问操作在别的程序看来都是一样的), 每个程序的操作都以程序规定的次序实现,结果都应该被 接受。

[例1] 程序P1:W(x,1)…

程序P2 :

…

R(x)0 R(x)1 …

或者两次都为1,都应该接受。

顺序一致性看似很“弱”,实际很强,对多副本一致

性有很强的要求,实际实现也是难以做到的。只能在单一 服务器上使用。

第五章 分布式系统中的数据一致性问题

[例2] P1: W(x,1) …

P2: … R(x)1 W(x,2)

P3:

…

R(x)1 R(x)2

P4:

…

R(x)2 R(x)1

违反了因果一致性。因为P2读出了x=1,所以P1和P2的两 个写操作顺序必定为W(x,1)在W(x,2)前。 P3的结果才 是正确的。

第五章 分布式系统中的数据一致性问题

[例2] 程序A

程序B

程序C

a=1;

b=1;

c=1;

print(b,c) print(a,c) print(a,b)

理论上有90个执行的次序。以a=1开头说明,共有5!=120 个顺序,但b=1不能在print(a,c)之后,因此一半是无效 的;同理程序C也如此,只剩下30个有效,共90个有效顺序。

4. 分布式系统中数据一致性保证的不同模型

● 严格一致性:读出的数据始终为最近写入的数据

太严格!实现 难度极大!几 乎不可能!

读x

计算机A

计算机A

时刻T1

时刻T2

写x

计算机A

T2 〉T1,如果两 者非常接近,有 可能因为网络原 因读请求比写请 求晚到!

第五章 分布式系统中的数据一致性问题

● 顺序一致性:只要所有的程序都以一定的顺序运行

P1:W(x,1) S1 W(y,2)S2

P2:

S1 R(x)1

P3:

s2 R(y)2

弱一致性的缺陷在于没有区分对 共享变量的修改与读取。所以同 步变量的访问即要确保本地写全 部完成(所有副本均已更新)还 要收集其它计算机的写操作信息。

第五章 分布式系统中的数据一致性问题

● 释放一致性:类似临界区,提供“获取”和“释放” 两类原子同步操作。强制:

对第二点,强制要求所有的同步访问开始前,已经开始的所有的写操 作必须完成,在更新共享数据后立即进行同步,将新值传遍所有副本;

第三点,保证在读共享数据之前,完成同步操作,以便可以读到最新 值。

做法:

任何程序编制时,在对共享数据写操作后都必须紧接着访问同步变量;

任何读共享数据操作前,访问同步变量。

例如:

…

R(x)1 R(x)2

P4:

…

R(x)2 R(x)1

符合PRAM一致性的要求。

PRAM与顺序一致性的差别在于,后者虽然为确定语句

的顺序,但要求所有程序遵从共同的顺序;而前者则允许不 同程序见到的顺序可以不同。

第五章 分布式系统中的数据一致性问题

[例2] 在前面的例子中,结果001001是可以接受的。这时, 各程序看到的顺序: