2018校招笔试题-图像算法工程师(深度学习)B卷

高级图像处理工程师面试准备考试

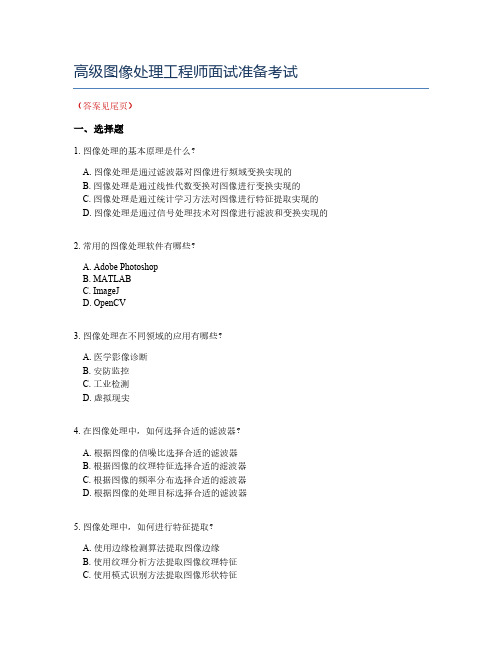

高级图像处理工程师面试准备考试(答案见尾页)一、选择题1. 图像处理的基本原理是什么?A. 图像处理是通过滤波器对图像进行频域变换实现的B. 图像处理是通过线性代数变换对图像进行变换实现的C. 图像处理是通过统计学习方法对图像进行特征提取实现的D. 图像处理是通过信号处理技术对图像进行滤波和变换实现的2. 常用的图像处理软件有哪些?A. Adobe PhotoshopB. MATLABC. ImageJD. OpenCV3. 图像处理在不同领域的应用有哪些?A. 医学影像诊断B. 安防监控C. 工业检测D. 虚拟现实4. 在图像处理中,如何选择合适的滤波器?A. 根据图像的信噪比选择合适的滤波器B. 根据图像的纹理特征选择合适的滤波器C. 根据图像的频率分布选择合适的滤波器D. 根据图像的处理目标选择合适的滤波器5. 图像处理中,如何进行特征提取?A. 使用边缘检测算法提取图像边缘B. 使用纹理分析方法提取图像纹理特征C. 使用模式识别方法提取图像形状特征D. 使用机器学习方法提取图像复杂特征6. 在图像处理中,如何评估处理效果?A. 通过对比原始图像和处理后的图像来判断B. 通过计算处理后的图像的信噪比来评估C. 通过计算处理后的图像的峰值信噪比来评估D. 通过计算处理后的图像的均方误差来评估7. 图像处理中,如何优化算法?A. 优化算法的时间复杂度B. 优化算法的空间复杂度C. 优化算法的可扩展性D. 优化算法的鲁棒性8. 在图像处理中,如何处理遮挡问题?A. 使用基于颜色的遮挡检测方法B. 使用基于纹理的遮挡检测方法C. 使用基于形状的遮挡检测方法D. 使用基于深度信息的遮挡检测方法9. 图像处理中,如何处理图像缩放?A. 使用双线性插值方法进行图像缩放B. 使用双三次插值方法进行图像缩放C. 使用邻近像素插值方法进行图像缩放D. 使用混合插值方法进行图像缩放10. 在高级图像处理工程师的面试中,关于图像处理算法的优化,以下哪个选项是正确的?A. 零均值规范化可以提高图像处理算法的鲁棒性。

2018-百度校园招聘笔试题目精选-优秀word范文 (2页)

本文部分内容来自网络整理,本司不为其真实性负责,如有异议或侵权请及时联系,本司将立即删除!== 本文为word格式,下载后可方便编辑和修改! ==百度校园招聘笔试题目精选一、主观题1、编程实现strncpy(char *dest,char* src, stze_t n);2、编程实现逆波兰式,函数原型double CalRpn(int oprnum,char*Opstr[]),实现计算逆波兰式的结果。

比如中序遍历为1+2*3,逆波兰是式为12+3*3、一段英语翻译file descriptor和lock,forks等二、简答题1、RSA、SHA、DES、BASE6X哪个不可逆?2、指令寻址方式3、RISC指令系统的特点(从指令长度、指令种类、寻址方式、寄存器数目)4、磁盘扇区访问时间5、采用不同寻址方式的目的6、指针和引用的区别7、static类型8、虚函数继承9、排序算法最坏情况时间复杂度和不稳定排序算法10、二叉树高度计算11、进程中的线程堆和栈的关系(共享堆,独占栈)12、进程就绪、阻塞、运行示意图13、创建进程条件14、HTTP403表示什么15、数据库索引的意义16、不能用于window进程同步的是哪个:mutex,event,临界区、信号量17、进程和线程的区别18、MFC中的基本类,由Cobject派生的类有哪些(CWindow等)19、MFC界面如何实现将一个界面分成两个部分20、三个道士和三个野人过河,如果野人的数目多于道士的数目,野人就会把道士吃掉,河里面的船一次只能载两个人,如何实现,使用模式识别的方法21、操作系统中堆、栈、数据区等作用22、IPV4和IPV6头部问题23、数据结构中图的最短路径、最小生成树24、发送一个数据包到一个地方(比如新浪),经过的路径?25、平衡树、红黑树、B+树等区别,优缺点26、全局变量生存期27、C++在main函数之前声明一个全局的类的对象,问该对象执行时是在进入main函数之前还是之后,如果是之前,是由什么调用的28、1000瓶饮料,3个瓶子可以再换一瓶,一共可以喝多少瓶,算法描述?以下文字仅用于测试排版效果, 请使用时删除!冬是清寒的。

slam算法工程师招聘笔试题及解答(某大型集团公司)

招聘slam算法工程师笔试题及解答(某大型集团公司)一、单项选择题(本大题有10小题,每小题2分,共20分)1、SLAM(Simultaneous Localization and Mapping)技术主要应用于以下哪个领域?A. 视频监控B. 智能驾驶C. 生物信息学D. 机器人控制答案:B解析:SLAM技术是同时定位与建图技术,广泛应用于机器人、无人车、无人机等智能移动设备的定位与导航。

智能驾驶领域对SLAM技术的需求尤为明显,因此选项B 是正确答案。

2、以下哪种SLAM算法不依赖于视觉信息?A. ORB-SLAMB. RTAB-MapC. DVOD. VIO答案:C解析:ORB-SLAM、RTAB-Map和VIO都是基于视觉的SLAM算法,它们通过处理图像信息来估计相机位姿和构建环境地图。

而DVO(Direct Visual Odometry)是一种基于直接视觉里程计的SLAM算法,它不依赖于视觉信息,而是通过直接估计相机位姿来进行定位和建图。

因此,选项C是正确答案。

3、题干:以下关于SLAM(Simultaneous Localization and Mapping)系统的描述,哪项是错误的?A、SLAM系统旨在同时进行机器人的定位和地图构建。

B、SLAM系统通常使用激光雷达(LiDAR)传感器来获取环境信息。

C、视觉SLAM系统使用图像特征点来进行位姿估计。

D、SLAM系统在室内环境比在室外环境中更难以工作。

答案:D解析:D选项错误,因为SLAM系统在室内环境中通常比在室外环境中更容易工作。

室内环境相对封闭,容易获得稳定的特征点,而室外环境则可能因为光照变化、天气条件等因素导致特征点不稳定,从而增加SLAM系统的难度。

其他选项均为SLAM系统的正确描述。

4、题干:以下关于视觉SLAM中特征点匹配算法的描述,哪项是错误的?A、特征点匹配算法是视觉SLAM中的核心步骤之一。

B、SIFT(Scale-Invariant Feature Transform)和SURF(Speeded-Up Robust Features)是常用的特征点检测和描述算法。

机器视觉工程师招聘笔试题及解答(某大型集团公司)2024年

2024年招聘机器视觉工程师笔试题及解答(某大型集团公司)(答案在后面)一、单项选择题(本大题有10小题,每小题2分,共20分)1、题干:在机器视觉系统中,用于检测图像中的边缘信息的关键算法是:A. 区域生长B. 苏贝尔(Sobel)边缘检测C. 卡尔森(Canny)边缘检测D. 直方图均衡化2、题干:以下哪种技术不是机器视觉系统中常用的图像预处理技术?A. 平滑滤波B. 降噪处理C. 归一化处理D. 颜色转换3、在机器视觉领域,以下哪项技术不属于图像预处理阶段?A. 图像增强B. 图像滤波C. 图像分割D. 深度学习4、在机器视觉系统中,以下哪项不是相机标定的主要目的?A. 获取相机内参B. 获取相机外参C. 优化图像质量D. 提高图像分辨率5、在机器视觉中,以下哪种方法用于通过图像处理提取物体的边缘?A. 颜色滤波B. 颜色直方图C. 边缘检测算法(如Sobel算子、Canny算子)D. 颜色匹配6、在机器视觉系统中,以下哪个不是常用的图像预处理步骤?A. 噪声去除B. 亮度和对比度调整C. 形态学处理D. 光流计算7、以下哪种技术不属于机器视觉的预处理步骤?A. 归一化B. 二值化C. 轮廓提取D. 透视变换8、在机器视觉中,以下哪种算法属于特征匹配算法?A. SIFT算法B. Hough变换C. K-means聚类D. 梯度下降法9、以下哪种传感器通常用于测量物体的距离?A. 红外传感器B. 激光传感器C. 气敏传感器D. 温度传感器 10、在机器视觉中,以下哪个术语描述了图像在经过预处理后的效果?A. 图像增强B. 图像压缩C. 图像分割D. 图像重建二、多项选择题(本大题有10小题,每小题4分,共40分)1、以下哪些是机器视觉系统中的主要组成部分?()A、光源B、相机C、图像处理软件D、机械结构E、控制系统2、以下哪些算法或技术常用于图像分割?()A、阈值分割B、边缘检测C、形态学操作D、小波变换E、聚类算法3、以下哪些技术是机器视觉系统常用的图像预处理技术?()A. 灰度转换B. 直方图均衡化C. 高斯模糊D. 形态学操作E. 颜色空间转换4、以下哪些算法常用于图像特征提取?()A. SIFT(尺度不变特征变换)B. HOG(方向梯度直方图)C. SURF(加速稳健特征)D. ORB(Oriented FAST and Rotated BRIEF)E. 梯度直方图5、以下哪些技术或方法通常用于提高机器视觉系统的准确性和鲁棒性?()A. 特征提取B. 深度学习C. 多尺度检测D. 增强学习E. 硬件加速6、在机器视觉系统中,以下哪些是图像预处理步骤?()A. 归一化B. 轮廓提取C. 噪声过滤D. 形态学操作E. 透视变换7、以下哪些技术是机器视觉系统中常见的图像处理技术?()A. 图像分割B. 图像增强C. 图像配准D. 特征提取E. 目标跟踪8、以下哪些是机器视觉系统中常见的相机标定方法?()A. 张正友标定法B. 增广矩阵标定法C. 自由标定法D. 自动标定法E. 卡赛标定法9、以下哪些技术是机器视觉系统中常用的图像处理技术?A. 边缘检测B. 颜色分割C. 透视变换D. 光流估计E. 高斯滤波 10、以下哪些是机器视觉系统中常用的深度学习方法?A. 卷积神经网络(CNN)B. 生成对抗网络(GAN)C. 长短期记忆网络(LSTM)D. 聚类算法E. 支持向量机(SVM)三、判断题(本大题有10小题,每小题2分,共20分)1、机器视觉系统的核心是图像处理算法,而不依赖于硬件设备。

2023年图像算法工程师岗位要求图像处理算法工程师笔试题(17篇)

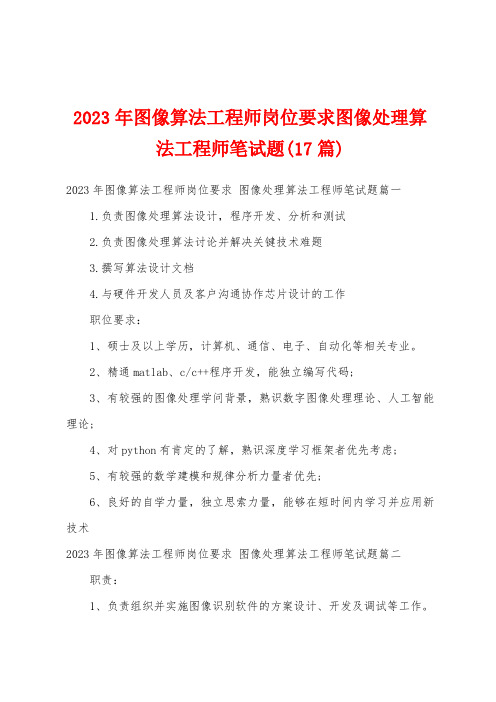

2023年图像算法工程师岗位要求图像处理算法工程师笔试题(17篇)2023年图像算法工程师岗位要求图像处理算法工程师笔试题篇一1.负责图像处理算法设计,程序开发、分析和测试2.负责图像处理算法讨论并解决关键技术难题3.撰写算法设计文档4.与硬件开发人员及客户沟通协作芯片设计的工作职位要求:1、硕士及以上学历,计算机、通信、电子、自动化等相关专业。

2、精通matlab、c/c++程序开发,能独立编写代码;3、有较强的图像处理学问背景,熟识数字图像处理理论、人工智能理论;4、对python有肯定的了解,熟识深度学习框架者优先考虑;5、有较强的数学建模和规律分析力量者优先;6、良好的自学力量,独立思索力量,能够在短时间内学习并应用新技术2023年图像算法工程师岗位要求图像处理算法工程师笔试题篇二职责:1、负责组织并实施图像识别软件的方案设计、开发及调试等工作。

2、负责落实完成生产和市场中图像识别软件质量问题的改良和维护。

3、负责跟踪前沿讨论成果,持续优化现有图像识别算法,提升识别性能。

4、负责组织治理开发工程的技术文件、产品标准、检验标准、物料选购标准、工艺标准的编制、公布与培训;5、负责学问产权申报、学术论文、技术专著、技术鉴定、产品检测、产品注册和工程申报所需技术支持文档的编制提交。

任职要求:1、本科及以上学历,图像处理、电子等相关专业;2、5年以上技术开发治理阅历;3个以上机电、电子或影像产品研发工程治理阅历;3、精通c/c++/python,能独立编写程序,有良好的数学功底和规律思维力量;4、了解常用的机器学习算法及思想,熟识目标检测领域主流的算法,熟识opencv等图像处理库;5、了解数字图像、电子技术、软件等专业学问,有产品开发设计的指导和治理力量;了解医学检验设备的进展方向、法律法规对医疗器械的技术要求,熟识质量治理体系。

2023年图像算法工程师岗位要求图像处理算法工程师笔试题篇三职责:1、建立算法实现原型,算法优化以及算法测试工作;2、负责医学图像分割,配准相关算法讨论、实现和改良;3、对临床医学图像问题的反应进展分析,依据临床需求进展算法调整;4、依据产品需求定义研发新的图像处理及显示算法;5、负责撰写算法相关技术描述文档,并基于讨论成果撰写创造专利;6、帮助测试工程师完成算法测试用例的设计;任职要求:1、应用数学、电子计算机相关专业毕业;3年以上工作经受,硕士以上学历(特殊优秀可放宽至本科);2、把握c++/c#/python一门语言, 熟识运用opencv、matlab快速实现以及改良相关图像分析算法;3、具备gpu和cuda应用开发和图像分层处理阅历优先;4、熟识图像处理的有关学问,如图像增加、图像切割等;5、良好的英文阅读力量。

2018校招笔试题-图像算法工程师(深度学习)B卷

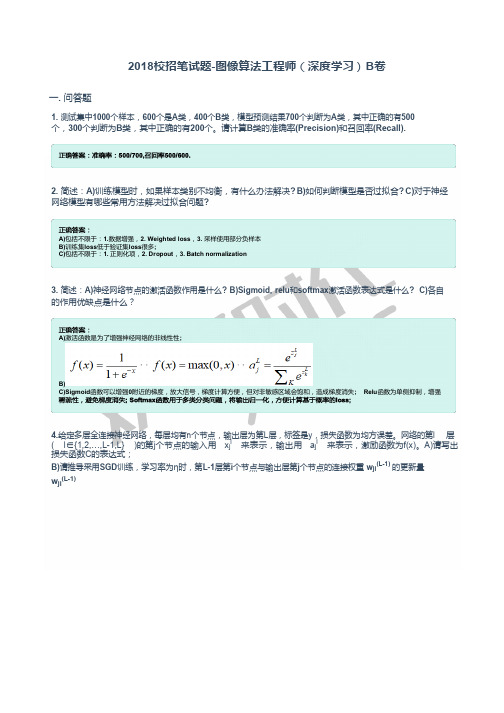

2018校招笔试题-图像算法工程师(深度学习)B 卷一. 问答题1. 测试集中1000个样本,600个是A 类,400个B 类,模型预测结果700个判断为A 类,其中正确的有500 个,300个判断为B 类,其中正确的有200个。

请计算B 类的准确率(Precision)和召回率(Recall).2. 简述:A)训练模型时,如果样本类别不均衡,有什么办法解决? B)如何判断模型是否过拟合? C)对于神经网络模型有哪些常用方法解决过拟合问题?3. 简述:A)神经网络节点的激活函数作用是什么? B)Sigmoid, relu 和softmax 激活函数表达式是什么? C)各自的作用优缺点是什么?4.给定多层全连接神经网络,每层均有n 个节点,输出层为第L 层,标签是y ,损失函数为均方误差。

网络的第l 层( l ∈{1,2,…,L -1,L} )的第j 个节点的输入用 x j l 来表示,输出用 a j l 来表示,激励函数为f(x)。

A)请写出损失函数C 的表达式;B)请推导采用SGD 训练,学习率为η时,第L-1层第i 个节点与输出层第j 个节点的连接权重 w ji (L-1) 的更新量w ji (L-1)A)包括不限于:1.数据增强,2. Weighted loss ,3. 采样使用部分负样本B)训练集loss 低于验证集loss 很多;C)包括不限于:1. 正则化项,2. Dropout , 3. Batch normalizationA)激活函数是为了增强神经网络的非线性性;B) C)Sigmoid 函数可以增强0附近的梯度,放大信号,梯度计算方便,但对非敏感区域会饱和,造成梯度消失; Relu 函数为单侧抑制,增强5.Design a three layer neural network whose decision boundary is show in figure, The gray region belongs to class 1, and other region belongs to class 0, Show your network structure, weights and nonlinear activation function.6. 请计算VGG19的模型大小与计算量大小(输入RGB图片大小为224x224);并指出对其进行模型压缩的思路,模型结构如图所示:7. 实现一个卷积层的forward 函数,输入map 的shape 为[w, h, ci],卷积核shape 为[k,k,ci,co], padding 大小为p 的zero-padding ,stride 为1,可以使用C++/Python/Matlab 语言。

深度学习(一)-------算法岗面试题

深度学习(⼀)-------算法岗⾯试题● BatchNormalization的作⽤参考回答:神经⽹络在训练的时候随着⽹络层数的加深,激活函数的输⼊值的整体分布逐渐往激活函数的取值区间上下限靠近,从⽽导致在反向传播时低层的神经⽹络的梯度消失。

⽽Batch Normalization的作⽤是通过规范化的⼿段,将越来越偏的分布拉回到标准化的分布,使得激活函数的输⼊值落在激活函数对输⼊⽐较敏感的区域,从⽽使梯度变⼤,加快学习收敛速度,避免梯度消失的问题。

●梯度消失参考回答:在神经⽹络中,当前⾯隐藏层的学习速率低于后⾯隐藏层的学习速率,即随着隐藏层数⽬的增加,分类准确率反⽽下降了。

这种现象叫做消失的梯度问题。

●循环神经⽹络,为什么好?参考回答:循环神经⽹络模型(RNN)是⼀种节点定向连接成环的⼈⼯神经⽹络,是⼀种反馈神经⽹络,RNN利⽤内部的记忆来处理任意时序的输⼊序列,并且在其处理单元之间既有内部的反馈连接⼜有前馈连接,这使得RNN可以更加容易处理不分段的⽂本等。

●什么是Group Convolution参考回答:若卷积神将⽹络的上⼀层有N个卷积核,则对应的通道数也为N。

设群数⽬为M,在进⾏卷积操作的时候,将通道分成M份,每个group对应N/M个通道,然后每个group卷积完成后输出叠在⼀起,作为当前层的输出通道。

●什么是RNN参考回答:⼀个序列当前的输出与前⾯的输出也有关,在RNN⽹络结构中中,隐藏层的输⼊不仅包括输⼊层的输出还包含上⼀时刻隐藏层的输出,⽹络会对之前的信息进⾏记忆并应⽤于当前的输⼊计算中。

●训练过程中,若⼀个模型不收敛,那么是否说明这个模型⽆效?导致模型不收敛的原因有哪些?参考回答:并不能说明这个模型⽆效,导致模型不收敛的原因可能有数据分类的标注不准确,样本的信息量太⼤导致模型不⾜以fit整个样本空间。

学习率设置的太⼤容易产⽣震荡,太⼩会导致不收敛。

可能复杂的分类任务⽤了简单的模型。

百度校园招聘笔试试题深度学习算法研发工程师——百度资料文档

百度20××校园招聘笔试题——深度学习算法研发工程师.今天上午到腾迅那里,没有叫到笔试通知,是去霸笔的。

原本以为是可以霸笔的,因为像阿里,360等大公司都专门的考场给霸笔的人准备的,但是腾迅不是这样,只有两个很小教室给那些霸笔的人考试,一会就都占满了,太少了,还有一大批没收到通知人不让考试。

参加腾迅笔试的也够火爆的,一条走廊全占满了人,都是霸笔的,等了半小时者不让进,太不厚道了。

下午到百度的笔试,比腾迅大气多了,给那些霸笔的人提供了3个大教室,每个教室能容纳100多人,而且有专门的人安排座位。

百度的职位真多啊,有一二十个,我选择的是B13深度学习算法研发工程师,一个教室还就我一个人选这个职位。

试卷一发下来,我愣了,真难度也太大了,好多我见都没见过……现将题目贡献如下:一、简答题1.深度神经网络目前有哪些成功的应用?简述原因。

(10分)2.列举不同进程共享数据的方式(至少三种)。

(10分)3.对于N个样本,每个样本为D维向量,采用欧式距离使用KNN 做类预测。

(10分)1).给出预测时间复杂度。

2).当N很大时,有哪些方法可以降低复杂度?3).k取值的大小对预测方差和偏差有何影响?二、算法和程序设计1.给出一个数据A=[a_0, a_1, a-2, ... a_n](其中n可变),打印出该数值元素的所有组合。

(15分)2.有这样一个数组A,大小为n,相邻元素差的绝对值都是1,如A={4,5,6,5,6,7,8,9,10,9}。

现在给定数组A和目标整数t,请找到t在数组中的位置。

(15分)3.在平面上有一组间距为d的平行线,将一根长度为l(l<d)的针任意掷在这个平面上,求此针与平行线中任意一根相交的概率,用高等数学(微积分、概率的方法)求解,基于布丰投针的结论,任选一种编程语言(C/C++, matlab, python, java),写出模拟投针实验(程序中允许把一个理想的Pi作为常量使用),求解圆周率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2018校招笔试题-图像算法工程师(深度学习)B 卷

一. 问答题

1. 测试集中1000个样本,600个是A 类,400个B 类,模型预测结果700个判断为A 类,其中正确的有500 个,300个判断为B 类,其中正确的有200个。

请计算B 类的准确率(Precision)和召回率(Recall).

2. 简述:A)训练模型时,如果样本类别不均衡,有什么办法解决? B)如何判断模型是否过拟合? C)对于神经网络模型有哪些常用方法解决过拟合问题?

3. 简述:A)神经网络节点的激活函数作用是什么? B)Sigmoid, relu 和softmax 激活函数表达式是什么? C)各自的作用优缺点是什么?

4.给定多层全连接神经网络,每层均有n 个节点,输出层为第L 层,标签是y ,损失函数为均方误差。

网络的第l 层( l ∈{1,2,…,L -1,L} )的第j 个节点的输入用 x j l 来表示,输出用 a j l 来表示,激励函数为f(x)。

A)请写出损失函数C 的表达式;

B)请推导采用SGD 训练,学习率为η时,第L-1层第i 个节点与输出层第j 个节点的连接权重 w ji (L-1) 的更新量w ji (L-1)

A)包括不限于:1.数据增强,2. Weighted loss ,3. 采样使用部分负样本

B)训练集loss 低于验证集loss 很多;

C)包括不限于:1. 正则化项,2. Dropout , 3. Batch normalization

A)激活函数是为了增强神经网络的非线性性;

B) C)Sigmoid 函数可以增强0附近的梯度,放大信号,梯度计算方便,但对非敏感区域会饱和,造成梯度消失; Relu 函数为单侧抑制,增强

5.Design a three layer neural network whose decision boundary is show in figure, The gray region belongs to class 1, and other region belongs to class 0, Show your network structure, weights and nonlinear activation function.

6. 请计算VGG19的模型大小与计算量大小(输入RGB图片大小为224x224);并指出对其进行模型压缩的思路,模型结构如图所示:

7. 实现一个卷积层的forward 函数,输入map 的shape 为[w, h, ci],卷积核shape 为[k,k,ci,co], padding 大小为p 的zero-padding ,stride 为1,可以使用C++/Python/Matlab 语言。