平均互信息量和各种熵关系

信息论第二章(2)

若有两个消息xi,yj 同时出现,它们所带有的信息量, 称为联合自信息量

I ( xi y j ) log p( xi y j ) (bit)

6 条件自信息量:

事件xi在事件yj给定的条件下的自信息量,称为条件自 信息量

I ( xi y j ) log p( x|y j ) (bit) | i

i

j

1 H (( X ))=(p( xy) log p( xy) H XY H X | Y ) X ,Y

平均互信息与各类熵之间关系的集合图(维拉图)表示:

I(X;Y) = H(X) - H(X|Y) = H(Y) - H(Y|X) = H(X)+H(Y)-H(XY) 图中,左边的圆代表 H(XY)= H(X)+H(Y)- I(X;Y) 随机变量X的熵,右 边的圆代表随机变量 Y的熵,两个圆重叠 H(X|Y) 部分是平均互信息 H(Y|X) I(X;Y)。每个圆减去 =H(X)-I(X;Y) =H(Y)-I(X;Y) I(X;Y)后剩余的部分 代表两个条件熵。 I(X;Y)

i 1 i

n

★定义自信息的数学期望为平均自信息量H

n 1 H ( X ) E log p ( xi ) log p ( xi ) (bit/符号) p ( xi ) i 1

(X),称为信息熵:

★熵的含义:

① 熵是从整个集合的统计特性来考虑的,它从平均意义上来表征 信源的总体特征。 ② 在信源输出后,信息熵H(X)表示每个消息提供的平均信息量;

复习

3 离散信源的数学模型:

x2 x3 ... ... xn X x1 P ( x) P ( x ) P ( x ) P ( x ) ... ... P( x ) 1 2 3 n 要满足的条件: P ( xi ) 0,

信息论举例讲解信息量熵及互信息量

计算机科学领域的应用

数据压缩

计算机科学中的数据压缩技术同样基于信息论的原理,通 过去除数据中的冗余信息,实现数据的压缩存储和传输。

加密与安全

信息论在密码学和安全领域也有广泛应用,如利用信息论中的 混淆和扩散原则设计加密算法,保护信息的机密性和完整性。

机器学习

在机器学习中,信息论用于特征选择、模型评估等方面。例如 ,利用互信息来衡量特征与目标变量之间的相关性,从而进行

熵的性质

非负性

熵的值总是非负的,表示系统的不确定性或混乱程度不可能为负值。

可加性

对于相互独立的事件或系统,其熵的和等于各事件或系统熵的和, 表示不确定性或混乱程度可以叠加计算。

最大值性

当系统中各个事件发生的概率相等时,该系统的熵达到最大值,表 示此时系统的不确定性或混乱程度最高。

熵的计算举例

二进制信源熵的计算

举例1

对于离散随机变量 X 和 Y,其联合概率分布为 p(x,y)=[0.1, 0.2, 0.3, 0.4],边缘概率分布为 p(x)=[0.3, 0.7] 和 p(y)=[0.5, 0.5]。根据互信息量的定义公式,可以计算出 I(X;Y)=0.1979。

举例2

对于连续随机变量 X 和 Y,其联合概率密度函数为 f(x,y),边缘概率密度函数为 fX(x) 和 fY(y)。可以通过 数值积分的方法计算出互信息量。例如,对于正态分布 N(0,1) 和 N(0,2) 的随机变量 X 和 Y,其互信息量 为 I(X;Y)=0.5×log2≈0.3466。

要点一

目的

通过举例讲解信息量、熵和互信息量的概念,使读者更好 地理解和掌握这些概念。

要点二

意义

信息量、熵和互信息量是信息论中的基本概念,对于理解 和应用信息论具有重要意义。通过本次讲解,读者可以更 加深入地了解这些概念,并能够在实际问题中加以应用。 同时,这些概念在其他领域也有广泛的应用,如计算机科 学、控制论、统计学等,因此本次讲解也有助于读者在其 他领域中更好地应用信息论的知识。

平均互信息量

n

m

1 p ( xi / y j )

H (X ) H (X /Y)

H(X/Y) —信道疑义度/损失熵。 Y关

于X的后验不确定度。表示收到变量 Y后,对随机变量X仍然存在的不确 定度。代表了在信道中损失的信息。

H(X) —X的先验不确定度/无条件熵。 I(X;Y)—收到Y前、后关于X的不确

举 例

[例2.1.5] 把已知信源 接到图2.1.7所示的信道上, 求在该信道上传输的平均互信息量I(X;Y),疑义度 H(X/Y),噪声熵H(Y/X),联合熵H(XY)。

X x1 , x2 P( X ) 0.5, 0.5

解:(1) 求联合概率

p(xi yj)=p(xi)p(yj/xi) p(x1 y1)=p(x1)p(y1/x1)=0.5×0.98=0.49 p(x1 y2)=p(x1)p(y2/x1)=0.5×0.02=0.01 p(x2 y1)=p(x2)p(y1/x2)=0.5×0.20=0.10 p(x2 y2)=p(x2)p(y2/x2)=0.5×0.98=0.40 (2) 求Y的各消息概率

i 1 j 1

1 2 p( y j )

p( xi y j ) log 2

i 1 j 1

n

m

1 p ( y j / xi )

H (Y ) H (Y / X )

H(Y/X)—噪声熵。表示发出随机变量X 后,对随机变量Y仍然存在的平均不确 定度。如果信道中不存在任何噪声,发 送端和接收端必存在确定的对应关系, 发出X后必能确定对应的Y,而现在不 能完全确定对应的Y,这显然是由信道 噪声所引起的。 I(Y;X) —发出X前、后关于Y的先验不 确定度减少的量。

信息论基础复习提纲

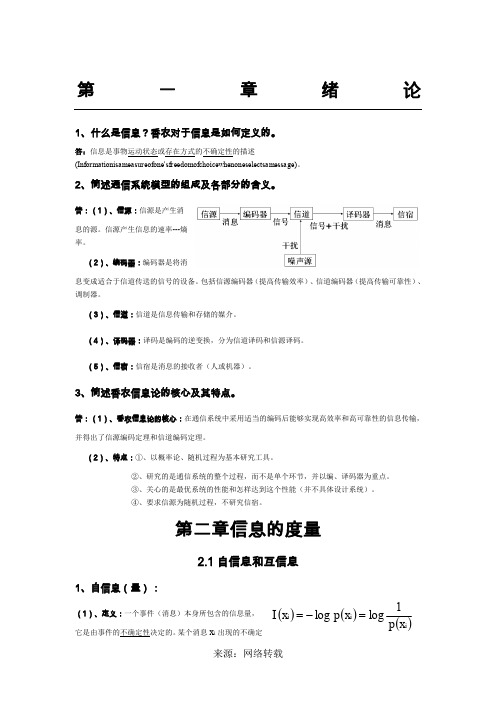

第一章绪论1、什么是信息?香农对于信息是如何定义的。

答:信息是事物运动状态或存在方式的不确定性的描述(Informationisameasureofone'sfreedomofchoicewhenoneselectsamessage )。

2、简述通信系统模型的组成及各部分的含义。

第二章信息的度量2.1自信息和互信息1、自信息(量):(1)、定义:一个事件(消息)本身所包含的信息量,它是由事件的不确定性决定的。

某个消息i x出现的不确定()()()i i i x p x p x I 1loglog =-=性的大小定义为自信息,用这个消息出现的概率的对数的负值来表示: (2)、性质:①、()i x I是()i x p 的严格递减函数。

当()()21x p x p <时()()21x I x I >概率越小,事件发生的不确定性越大,事件发生以后所包含的自信息量越大。

②、极限情况下,当()0=i x p 时()∞→i x I ;当()1=i x p 时,()0→i x I 。

(8)、上凸性: 3、联合熵:联合自信息的 数学期望。

它是二维随机 变量XY 的不确定性的度量。

4、条件熵:5、各类熵之间的关系: 21111()()()()log ()n m n mi j i j i j i j i j i j H XY p x y I x y p x y p x y ======-∑∑∑∑22(/)(/)X Y (/X)()log(/) (X /)()log (/)i i i ijj i i j i j ijijx H Y x H Y x H Y p x y p y x H Y p x y p x y =-=-∑∑∑∑由于不同的,是变化的,对的所有可能值进行统计平均,就得出给定时,的条件熵122()n n n n1212[(1)]()(1)()f x x f x f x λλλλ+-≥+-(1)、联合熵与信息熵、条件熵之间的关系:)/()()(X Y H X H XY H +=。

熵,条件熵,相对熵,互信息的相关定义及公式推导

熵,条件熵,相对熵,互信息的相关定义及公式推导

熵,条件熵,相对熵,互信息的相关定义及公式推导

熵是随机变量不确定性的度量,不确定性越⼤,熵值越⼤,若随机变量退化成定值,熵为0,均匀分布是最不确定的分布。

熵其实定义了⼀个函数(概率分布函数)到⼀个值(信息熵)的映射。

熵的定义公式如下:

在经典熵的定义中,底数是2,此时熵的单位是bit,若底数是e,则熵的单位是nat(奈特)

两个随机变量X, Y的联合分布,可以形成联合熵Joint Entropy,⽤H(X,Y)表⽰,那么我们不禁要问:H(X,Y) - H(Y)代表什么呢?

事实上,(X,Y)发⽣所包含的熵,减去Y单独发⽣包含的熵,在Y发⽣的前提下,X发⽣的新带来的熵。

于是有了条件熵:H(X|Y)的定义:

下⾯是条件熵的推导公式:

相对熵,⼜称为互熵,交叉熵,鉴别信息,KL散度,假设p(x), q(x)是X中取值的两个概率分布,则p对q的相对熵是:

对于相对熵,可以度量两个随机变量的距离,⼀般的p对q的相对熵和q对p的相对熵不相等。

对于已知的随机变量p,要使得相对简单的随机变量q,尽量接近p,那么我们可以采⽤相对熵进⾏求解:

假定使⽤KL(Q||P),为了让距离最⼩,则要求在P为0的地⽅,Q尽量为0。

会得到⽐较“窄”的分布曲线;

假定使⽤KL(P||Q),为了让距离最⼩,则要求在P不为0的地⽅,Q也尽量不为0。

会得到⽐较“宽”的分布曲线;

互信息

两个随机变量X,Y的互信息,定义为X,Y的联合分布和独⽴分布乘积的相对熵。

对于互信息,我们可以有如下的推导公式:。

互信息和信息熵

互信息与信息熵的区别

01

互信息只衡量两个随机变量之间的相关性,而信息 熵则衡量单个随机变量的不确定性。

02

互信息可以是负值,表示两个随机变量之间的负相 关性;而信息熵总是非负的。

03

互信息的计算需要考虑联合概率分布,而信息熵的 计算只需要单个随机变量的概率分布。

互信息与信息熵的应用场景

互信息可以应用于信号处理、模式识 别、机器学习等领域,例如在特征选 择和降维中用于衡量特征之间的相关 性。

机器学习中信息熵的运用

分类问题

在分类问题中,信息熵可以用于构建决策边界,通过最大化类别信息熵来提高分类器的 泛化能力。

聚类分析

信息熵在聚类分析中可以用于衡量聚类结果的纯度,通过最小化簇内信息熵来实现更有 效的聚类。

互信息和信息熵在机器学习中的优劣比较

互信息的优点

能够衡量特征间的相关性,有助于特征选择和降维;能够发现非线性 关系,适用于非高斯分布的数据。

互信息的缺点

计算量大,尤其是当特征维度较高时;无法处理连续型特征;可能受 到异常值和噪声的影响。

信息熵的优点

能够度量数据的混乱程度,适用于分类和聚类问题;能够处理连续型 特征。

信息熵的缺点

对数据的分布敏感,对于非高斯分布的数据可能表现不佳;在处理不 平衡数据集时可能会受到较大影响。

06

互信息和信息熵在通信系统 中的应用

在不确定性较大的数据中效果较差。

互信息和信息熵在数据压缩中各有优劣,实际应用中 可以根据具体情况选择使用。

05

互信息和信息熵在机器学习 中的应用

机器学习中互信息的运用

特征选择

互信息可以用于特征选择,衡量特征与目标变量之间的关联程度,帮助去除无关或冗余特征,从而提高模型的性 能。

信息论与编码复习期末考试要点

30

1

1

2 W1

2W3

W1

Wi pij Wj

i

1 4W1

13W2

3 4

W3

15W4

W2

W3

2 3

W2

4 5

W4

W4

W1 W2 W3 W4 1

• 稳态分布概率

W 1 3 3 5 , W 2 3 6 5 , W 3 1 2 3 3 3 6 5 5 ,1 3 W 3 6 4 5 1 4 7 4 3 6 5 1 5 7 4 3 9 5

14

三、互信息

• 互信息

• 定义为 xi的后验概率与先验概率比值的对数

I(xi;yj)lo2gp(p x(ix|iy)j)

• 互信息I(xi;yj):表示接收到某消息yj后获得 的关于事件xi的信息量。

15

平均互信息

• 平均互信息定义

I ( X ; Y ) H ( X ) H ( X |Y ) H ( Y ) H ( Y |X )

I(X ; Y ) H (X ) H (Y )

38

• 2)无嗓有损信道 –多个输入变成一个输出(n>m)

p(bi | aj ) 1或0

p(ai

|

bj

)

1或0

• 噪声熵H(Y|X) = 0 • 损失熵H(X|Y) ≠ 0

I(X ; Y )H (Y )H (X )

Cm axI(X ;Y )m axH (Y ) p(a i) 39

加密

y 信道编码

k 加密 密钥

z

信

解密 密钥

道 z'

信宿 v

信源解码

x' 解密

y'

信道解码

信息论与编码试卷及答案

一、(11')填空题(1)1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

(2)必然事件的自信息是0 。

(3)离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的N倍。

(4)对于离散无记忆信源,当信源熵有最大值时,满足条件为__信源符号等概分布_。

(5)若一离散无记忆信源的信源熵H(X)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为3 .(6)对于香农编码、费诺编码和霍夫曼编码,编码方法惟一的是香农编码. (7)已知某线性分组码的最小汉明距离为3,那么这组码最多能检测出_2_______个码元错误,最多能纠正___1__个码元错误。

(8)设有一离散无记忆平稳信道,其信道容量为C,只要待传送的信息传输率R__小于___C(大于、小于或者等于),则存在一种编码,当输入序列长度n足够大,使译码错误概率任意小. (9)平均错误概率不仅与信道本身的统计特性有关,还与___译码规则____________和___编码方法___有关三、(5')居住在某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1。

6米以上的占总数的一半。

假如我们得知“身高1.6米以上的某女孩是大学生”的消息,问获得多少信息量?解:设A表示“大学生”这一事件,B表示“身高1.60以上”这一事件,则P(A)=0。

25 p(B)=0.5 p(B|A)=0.75 (2分)故 p(A|B)=p(AB)/p(B)=p(A)p(B|A)/p(B)=0。

75*0。

25/0。

5=0。

375 (2分)I(A|B)=—log0.375=1。

42bit (1分)四、(5')证明:平均互信息量同信息熵之间满足I(X;Y)=H(X)+H(Y)—H(XY)证明:(2分)同理(1分)则因为(1分)故即(1分)五、(18’)。

黑白气象传真图的消息只有黑色和白色两种,求:1)黑色出现的概率为0。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

X

P(

X

)

x1, p( x1

),

x2 , p( x2

L ),L

, ,

xi p( xi

, ),L

L ,

, xn p( xn

)

其中,输入离散事件集 X {xi ,i 1, 2,..., n},

对每一个事件xi X ,相应的概率为p(xi ),简记为pi,

n

P {pi ,i 1, 2,..., n},且 pi 0,i 1, 2,..., n; pi 1 i 1

平均互信息量I(X;Y)是信源概率分布p(xi)的上凸函数;

该性质是研究信道容量的理论基础

平均互信息量I(X;Y)是信道传递概率p(yj/xi)的下凸函数。

该性质是研究率失真函数的理论基础

15

HUST Furong WANG--- Information and Coding Theory

HUST Furong WANG--- Information and Coding Theory

第2章 信源熵

2.1 单符号离散信源

2.1.1 单符号离散信源的数学模型 2.1.2 自信息和信源熵 2.1.3 信源熵的基本性质和定理 2.1.4 加权熵的概念及基本性质 2.1.5 平均互信息量

求平均互信息I(X;Y)-例题

平均互信息I ( X ;Y ) H (Y ) H (Y / X ) 由信道特性决定的条件熵

22

H (Y / X )

p(xi ) p( y j / xi ) log2 p( y j / xi )

5

HUST Furong WANG--- Information and Coding Theory

平均条件互信息量

定 平 在 定义均整义:条个式件为X中互以在信p联息(x合量i |集等ydXej于f)Y后由上验,y概j所由率提y加j供提权的供的互的平信关均息于值量集,IX其(的xi ; y j )

平均互信息量

定义:平均互信息量I(X;Y)是平均条件互信息量I(X;yj)在整个 集Y上的概率加权平均值。其定义式为

I ( X ;Y ) p( y j )I ( X ; y j )

Y

定义:互信息量I(xi;yj)在联合概率空间P(XY)中的统计平均值

I(X;Y)

n i1

m

p(xi y j )I (xi; y j )

一、平均互信息量定义 二、平均互信息量物理意义 二、平均互信息量性质 2.1.6 各种熵之间的关系

1

HUST Furong WANG--- Information and Coding Theory

离散集的平均互信息量

不同概率空间集合之间的平均互信息量对于通信问题的 探讨十分重要。

通信的目的是在接收端准确地或以尽可能小的失真复现 发送的消息。一般通信系统的输入和输出存在一定的概 率关系。

XY

XY

等号成立的条件是, 对于i, j 都有p(xi ) p(xi | y j ), ( p( y j ) 0)

即 当且仅当X 与Y相互独立时, I (X ;Y ) 0

证毕

13

HUST Furong WANG--- Information and Coding Theory

性质2:对称性I(X;Y)=I(Y;X)的证明

且

pij=p( y j

/ xi )

p(xi y j ) ; p(xi )

pji =p( xi

/

yj)

p(xi y j ) p(yj )

若对于所有的i, j,事件xi和y j ;彼此统计独立,且有p(xi y j ) p(xi ) p( y j ) i, j 成立,

则称集X 与Y统计独立,否则称集X 与Y统计相关

XY p( xy)

x1 y1, p(x1 y1

),

x1 y2 , L p(x1y2 ),L

, xi y j , L , xn ym , p(xi y j ),L , p(xn ym )

其中,X 和Y的联合空间 XY {xi y j ; xi X , yj Y ,i 1, 2,..., n; j 1, 2,..., m},

11

HUST Furong WANG--- Information and Coding Theory

平均互信息的性质

1、互易性(对称性) I(X;Y)= I(Y;X)

该性质表示从集Y中获得关于X的信息量等于从集X中获 得关于Y的信息量。

当集X和集Y统计独立时,有I(X;Y)= I(Y;X)=0 它意味着不能从一个集获得关于另一个集的任何信息

对每组事件(积事件)xi y j XY相应的概率二维联合概率p(xi y j ),

nm

m

n

且

p(xi y j ) 1; p(xi ) p(xi y j ); p( y j ) p(xi y j );

i1 j1

j 1

i 1

一般有条件概率p( y j / xi )和p(xi / y j ), 分别简记为pij和pji

以{Y , P}表示输出离散概率空间

Y

P(Y

)

y1,

p(

y1

),

y2, L p( y2 ),L

, ,

y j , L , ym

p( y j ),L

,

p(

ym

)

其中,输出离散事件集 Y {y j , j 1, 2,..., m},

对每一个事件y

j

Y

,

相应的概率为p(

y

j

),简记为p

,

j

m

P {p j ,j 1, 2,..., m},且 p j 0,j 1, 2,..., m; p j 1

4

j 1

HUST Furong WANG--- Information and Coding Theory

输入X、输出Y的联合空间XY

以{XY , p(xy)}表示二维联合概率空间

得

I(X;yj)

X

p( xi

|

y

j

)

p(xi ) p(xi | y

j

)

1

log

e

X

p(xi ) p(xi | y j ) log e 0

故 I(X;yj) 0

当且仅当 p(xi ) p(xi | y j ) 时,I (X ; y j ) 0 证毕

8

HUST Furong WANG--- Information and Coding Theory

| xi ) log

p( y j | xi ) p(yj )

def

I ( X ;Y ) p(xi y j )I (xi ; y j )

XY

其中I (xi ;

yj)

log

p(xi | y j ) p(xi )

log

p( y j | xi ) p(yj )

当xi和y j相互独立时,I (xi ; y j ) 0 (i

I(X; yj)仍然是一个随机变量,随yj的变化而变化, 因此,不能作为信道中流通信息量的整体测度。

7

HUST Furong WANG--- Information and Coding Theory

定理 I(X;yj)≥0 的证明

证明: 将平均条件互信息量的表示式

I (X ; yj )

X

互信息量I(xi;yj)是定量研究信息流通问题的重要 基础。

它只能定量地描述输入随机变量发出某个具体消息xi, 输出变量出现某一具体消息yj时,流经信道的信息量。

“输入xi ,输出yj”是一个概率为p(xi yj) 的随机事件, 相应的I(xi;yj)也是随xi和yj变化而变化的随机量。

互信息量I(xi;yj)不能从整体上作为信道中信息流 通的测度。

XY

p(xi y j ) log

p(xi ) ; p(xi | y j )

利用不等式 ln w w 1; 和关系式log w ln wlog e

I (X ;Y )

XY

p( xi

|

y

j

)

p(

y

j

)

p( p( xi

xi ) |y

j

)

1

log

e

p(xi ) p( y j )

p(xi | y j )p( y j )log e 0

1, 2,L

;

j

1, 2,L

) 且I ( X ;Y ) 0 10

HUST Furong WANG--- Information and Coding Theory

平均互信息的性质

平均互信息量有以下基本性质:

1、互易性(对称性) 2、非负性 3、极值性 4、凸函数性

5、数据处理定理 平均互信息和各类熵的关系

j 1

n i1

m

p(xi y j ) log

j 1

p(xi / y j ) p(xi )

称I(X;Y)是Y对X的平均互信息量,简称平均互信息,也称平均 交互信息量或交互熵。

平均互信息I(X;Y)克服了互信息量I(xi;yj)的随机性,成为一 个确定的量,因此,可以作为信道中流通信息量的整体测度。

平均互信息量I(X;Y)的凸函数性-例题

二元对称信道的X 输入概率空间为

X 0 1

P(X)

p

1 p

0

q

0

1-q

信道的转移概率图为右图所示

求平均互信息量I(X;Y),并画图

1-q

1

q

1

二元对称信道

16

HUST Furong WANG--- Information and Coding Theory

I ( X ; y j ) p(xi | y j )I (xi ; y j ) X