平均互信息量和各种熵关系

信息论与编码试题集与答案(新)

1. 在无失真的信源中,信源输出由 H (X ) 来度量;在有失真的信源中,信源输出由 R (D ) 来度量。

2. 要使通信系统做到传输信息有效、可靠和保密,必须首先 信源 编码, 然后_____加密____编码,再______信道_____编码,最后送入信道。

3. 带限AWGN 波形信道在平均功率受限条件下信道容量的基本公式,也就是有名的香农公式是log(1)C W SNR =+;当归一化信道容量C/W 趋近于零时,也即信道完全丧失了通信能力,此时E b /N 0为 -1.6 dB ,我们将它称作香农限,是一切编码方式所能达到的理论极限。

4. 保密系统的密钥量越小,密钥熵H (K )就越 小 ,其密文中含有的关于明文的信息量I (M ;C )就越 大 。

5. 已知n =7的循环码42()1g x x x x =+++,则信息位长度k 为 3 ,校验多项式 h(x)= 31x x ++ 。

6. 设输入符号表为X ={0,1},输出符号表为Y ={0,1}。

输入信号的概率分布为p =(1/2,1/2),失真函数为d (0,0) = d (1,1) = 0,d (0,1) =2,d (1,0) = 1,则D min = 0 ,R (D min )= 1bit/symbol ,相应的编码器转移概率矩阵[p(y/x )]=1001⎡⎤⎢⎥⎣⎦;D max = 0.5 ,R (D max )= 0 ,相应的编码器转移概率矩阵[p(y/x )]=1010⎡⎤⎢⎥⎣⎦。

7. 已知用户A 的RSA 公开密钥(e,n )=(3,55),5,11p q ==,则()φn = 40 ,他的秘密密钥(d,n )=(27,55) 。

若用户B 向用户A 发送m =2的加密消息,则该加密后的消息为 8 。

二、判断题1. 可以用克劳夫特不等式作为唯一可译码存在的判据。

(√ )2. 线性码一定包含全零码。

(√ )3. 算术编码是一种无失真的分组信源编码,其基本思想是将一定精度数值作为序列的 编码,是以另外一种形式实现的最佳统计匹配编码。

信息论举例讲解信息量熵及互信息量

计算机科学领域的应用

数据压缩

计算机科学中的数据压缩技术同样基于信息论的原理,通 过去除数据中的冗余信息,实现数据的压缩存储和传输。

加密与安全

信息论在密码学和安全领域也有广泛应用,如利用信息论中的 混淆和扩散原则设计加密算法,保护信息的机密性和完整性。

机器学习

在机器学习中,信息论用于特征选择、模型评估等方面。例如 ,利用互信息来衡量特征与目标变量之间的相关性,从而进行

熵的性质

非负性

熵的值总是非负的,表示系统的不确定性或混乱程度不可能为负值。

可加性

对于相互独立的事件或系统,其熵的和等于各事件或系统熵的和, 表示不确定性或混乱程度可以叠加计算。

最大值性

当系统中各个事件发生的概率相等时,该系统的熵达到最大值,表 示此时系统的不确定性或混乱程度最高。

熵的计算举例

二进制信源熵的计算

举例1

对于离散随机变量 X 和 Y,其联合概率分布为 p(x,y)=[0.1, 0.2, 0.3, 0.4],边缘概率分布为 p(x)=[0.3, 0.7] 和 p(y)=[0.5, 0.5]。根据互信息量的定义公式,可以计算出 I(X;Y)=0.1979。

举例2

对于连续随机变量 X 和 Y,其联合概率密度函数为 f(x,y),边缘概率密度函数为 fX(x) 和 fY(y)。可以通过 数值积分的方法计算出互信息量。例如,对于正态分布 N(0,1) 和 N(0,2) 的随机变量 X 和 Y,其互信息量 为 I(X;Y)=0.5×log2≈0.3466。

要点一

目的

通过举例讲解信息量、熵和互信息量的概念,使读者更好 地理解和掌握这些概念。

要点二

意义

信息量、熵和互信息量是信息论中的基本概念,对于理解 和应用信息论具有重要意义。通过本次讲解,读者可以更 加深入地了解这些概念,并能够在实际问题中加以应用。 同时,这些概念在其他领域也有广泛的应用,如计算机科 学、控制论、统计学等,因此本次讲解也有助于读者在其 他领域中更好地应用信息论的知识。

信息论举例讲解信息量熵及互信息量

1/4

1/3

0

0

x1

001

1/4

1/3

0

0

X2

010

1/8

1/6

1/2

0

X3

011

1/8

1/6

1/2

1

X4

100

1/16

0

0

0

X5

101

1/16

0

0

0

X6

110

1/16

0

0

0

x7I ( x3 ;011111)

lo1g/16p(x3 0011) p(x3 )

单位为比特

lo0g

1 1

8

30

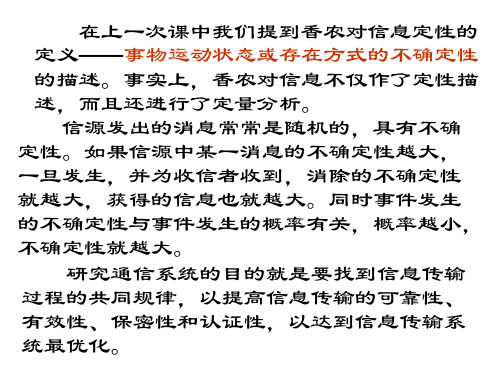

熵是信源平均不确定性的度量, 一般情况下,它并不等于信宿所获得 的平均信息量,只有在无噪情况下,二 者才相等.为此我们需要学习条件熵. 同时我们由条件熵引出平均互信息量 的概念,其可以用来衡量一个信道的 好坏.

故:

I (x) I (x | y) log p(x | y) log p( y | x) I ( y) I ( y | x)

Hale Waihona Puke p(x)p( y)

这样,用I(x;y)或I(y;x)记该差式, 称为x与y之间的互信息量,单位也为比特。

互信息量的性质

一、对称性:I(x;y)=I(y;x),其通信意 义表示发出x收到y所能提供给我们的信 息量的大小;

xi

0

1

2

P(xi) 1/3

1/6

1/2

单位:比I(特xi) log3

log6

log2

自信息量的涵义

自信息量代表两种含义: 一、事件x发生以前,I(x)表示事件x发生的不 确定性; 二、当事件x发生以后,I(x)表示事件x所提供 的信息量(在无噪情况下)。

第二章-信息论基本概念(2)(1)

前面所述熵为单符号信源情况, 前面所述熵为单符号信源情况,是最简单的离散 信源。事务是普遍联系的,两个随机变量 , 之间 信源。事务是普遍联系的,两个随机变量X,Y之间 也是相互联系的,比如: 在某种程度上 也是相互联系的,比如:

1、 离散无记忆信源 扩展信源 、 离散无记忆信源(扩展信源 扩展信源) 概率空间: (1)定义:若单符号离散信源 概率空间: )定义:若单符号离散信源X概率空间

X a1 , a2 , L , ai , L , aq P( X ) = p(a ), p(a ),L , p(a ),L , p(a ) , ∑ p(ai ) = 1 i 2 i q 1

0( p )

q

X

[例] 二进制对称信道 例

1( p )

q q

q

0

Y

1

H ( X ) = H ( p) = − p log p − p log p

I(X;Y)

H (Y / X ) = H (q) = −q log q − q log q

H (Y ) = H ( pq + pq)

0

1-H(q) 0.5 I(X;Y) H(p) 1 p

5. 数据处理定理 I(X;Z) ≤ I(X;Y) I(X;Z) ≤ I(Y;Z) [意义 信息不增原理 意义] 信息不增原理 原理—— 意义 处理, 每经一次 处理,可能丢失一部分信息 X Y P(Z/;Y) = H(X) – H(X/Y) = H(Y) – H(Y/X) H(XY) = H(X) + H(Y/X) = H(Y) + H(X/Y) I(X;Y) = H(X) + H(Y)- H(XY) -

信息论与编码复习期末考试要点

30

1

1

2 W1

2W3

W1

Wi pij Wj

i

1 4W1

13W2

3 4

W3

15W4

W2

W3

2 3

W2

4 5

W4

W4

W1 W2 W3 W4 1

• 稳态分布概率

W 1 3 3 5 , W 2 3 6 5 , W 3 1 2 3 3 3 6 5 5 ,1 3 W 3 6 4 5 1 4 7 4 3 6 5 1 5 7 4 3 9 5

14

三、互信息

• 互信息

• 定义为 xi的后验概率与先验概率比值的对数

I(xi;yj)lo2gp(p x(ix|iy)j)

• 互信息I(xi;yj):表示接收到某消息yj后获得 的关于事件xi的信息量。

15

平均互信息

• 平均互信息定义

I ( X ; Y ) H ( X ) H ( X |Y ) H ( Y ) H ( Y |X )

I(X ; Y ) H (X ) H (Y )

38

• 2)无嗓有损信道 –多个输入变成一个输出(n>m)

p(bi | aj ) 1或0

p(ai

|

bj

)

1或0

• 噪声熵H(Y|X) = 0 • 损失熵H(X|Y) ≠ 0

I(X ; Y )H (Y )H (X )

Cm axI(X ;Y )m axH (Y ) p(a i) 39

加密

y 信道编码

k 加密 密钥

z

信

解密 密钥

道 z'

信宿 v

信源解码

x' 解密

y'

信道解码

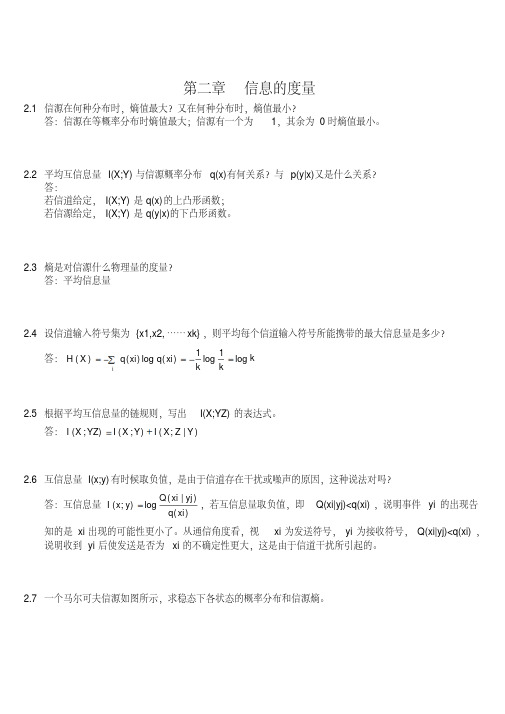

信息论与编码第二章答案

第二章信息的度量2.1信源在何种分布时,熵值最大?又在何种分布时,熵值最小?答:信源在等概率分布时熵值最大;信源有一个为1,其余为0时熵值最小。

2.2平均互信息量I(X;Y)与信源概率分布q(x)有何关系?与p(y|x)又是什么关系?答:若信道给定,I(X;Y)是q(x)的上凸形函数;若信源给定,I(X;Y)是q(y|x)的下凸形函数。

2.3熵是对信源什么物理量的度量?答:平均信息量2.4设信道输入符号集为{x1,x2,……xk},则平均每个信道输入符号所能携带的最大信息量是多少?答:kk k xi q xi q X H i log 1log 1)(log )()(2.5根据平均互信息量的链规则,写出I(X;YZ)的表达式。

答:)|;();();(Y Z X I Y X I YZ X I 2.6互信息量I(x;y)有时候取负值,是由于信道存在干扰或噪声的原因,这种说法对吗?答:互信息量)()|(log );(xi q yj xi Q y x I ,若互信息量取负值,即Q(xi|yj)<q(xi),说明事件yi 的出现告知的是xi 出现的可能性更小了。

从通信角度看,视xi 为发送符号,yi 为接收符号,Q(xi|yj)<q(xi),说明收到yi 后使发送是否为xi 的不确定性更大,这是由于信道干扰所引起的。

2.7一个马尔可夫信源如图所示,求稳态下各状态的概率分布和信源熵。

答:由图示可知:43)|(41)|(32)|(31)|(41)|(43)|(222111110201s x p s x p s x p s x p s x p s x p 即:43)|(0)|(41)|(31)|(32)|(0)|(0)|(41)|(43)|(222120121110020100s s p s s p s s p s s p s s p s s p s s p s s p s s p 可得:1)()()()(43)(31)()(31)(41)()(41)(43)(210212101200s p s p s p s p s p s p s p s p s p s p s p s p得:114)(113)(114)(210s p s p s p )]|(log )|()|(log )|()[()]|(log )|()|(log )|()[()]|(log )|()|(log )|()[(222220202121211111010100000s s p s s p s s p s s p s p s s p s s p s s p s s p s p s s p s s p s s p s s p s p H 0.25(bit/符号)2.8一个马尔可夫信源,已知:0)2|2(,1)2|1(,31)1|2(,32)1|1(x x p x x p x x p x x p 试画出它的香农线图,并求出信源熵。

信息论与编码试题集与答案

信息论与编码试题集与答案1. 在⽆失真的信源中,信源输出由 H (X ) 来度量;在有失真的信源中,信源输出由 R (D ) 来度量。

2. 要使通信系统做到传输信息有效、可靠和保密,必须⾸先信源编码,然后_____加密____编码,再______信道_____编码,最后送⼊信道。

3. 带限AWGN 波形信道在平均功率受限条件下信道容量的基本公式,也就是有名的⾹农公式是log(1)C W SNR =+;当归⼀化信道容量C/W 趋近于零时,也即信道完全丧失了通信能⼒,此时E b /N 0为 -1.6 dB ,我们将它称作⾹农限,是⼀切编码⽅式所能达到的理论极限。

4. 保密系统的密钥量越⼩,密钥熵H (K )就越⼩,其密⽂中含有的关于明⽂的信息量I (M ;C )就越⼤。

5. 已知n =7的循环码42()1g x x x x =+++,则信息位长度k 为 3 ,校验多项式 h(x)= 31x x ++ 。

6. 设输⼊符号表为X ={0,1},输出符号表为Y ={0,1}。

输⼊信号的概率分布为p =(1/2,1/2),失真函数为d (0,0) = d (1,1) = 0,d (0,1) =2,d (1,0) = 1,则D min = 0 ,R (D min )= 1bit/symbol ,相应的编码器转移概率矩阵[p(y/x )]=1001??;D max = 0.5 ,R (D max )= 0 ,相应的编码器转移概率矩阵[p(y/x )]=1010??。

7. 已知⽤户A 的RSA 公开密钥(e,n )=(3,55),5,11p q ==,则()φn = 40 ,他的秘密密钥(d,n )=(27,55) 。

若⽤户B 向⽤户A 发送m =2的加密消息,则该加密后的消息为 8 。

⼆、判断题1. 可以⽤克劳夫特不等式作为唯⼀可译码存在的判据。

(√ )2. 线性码⼀定包含全零码。

(√ )3. 算术编码是⼀种⽆失真的分组信源编码,其基本思想是将⼀定精度数值作为序列的编码,是以另外⼀种形式实现的最佳统计匹配编码。

2信源与信息熵2

• 联合自信息量

I ( xi y j ) log2 p( xi y j )

• 条件自信息量和联合自信息量同样满足非负 性和单调递减性。 • 关系

I ( xi y j ) log2 p( xi ) p( y j / xi ) I ( xi ) I ( y j / xi ) log2 p( y j ) p( xi / y j ) I ( y j ) I ( xi / y j )

信源熵与自信息量的关系1:定性

• 信源熵用以表征信源的平均不确定性:一个 信源,无论是否输出符号,由于具有特定的 概率统计特性,因此具有特定的熵值。 • 信息量则只有当信源输出的符号被接收者收 到后才有意义。平均自信息量是能够消除信 源不确定性时所需信息的量度,即收到一个 信源符号,全部解除了这个符号的不确定性。 或者说获得这样大的信息量后,信源不确定 性就被消除了。

• 平均自信息量:表示信源中发出每个符号平均所能 提供的信息量。它只与信源中各个符号出现的概率 有关,可以用来表示信源输出信息的总体量度。 • 信源X的平均不确定度:表示总体平均意义上的信 源符号的不确定度(不管是否发出)。数值上等于平 均自信息量。 • 这个平均自信息量的表达式和统计物理学中热熵的 表达式很相似。在统计物理学中,热熵是一个物理 系统杂乱性(无序性)的度量。这在概念上也有相似 之处。所以,可以把信源X的平均不确定度称为 “信源熵”。

例2-5/6

• 例2-5(P19):

• 例2-6(P19): • 由于符号间通常存在关联性,实际信息量往 往远远小于理论值。

例2-7

• 例2-7(P19):二元信源的信息熵。

• 自信息量是针对无条件概率计算的,可以在 数学上进行简单的推广:将无条件概率换为 条件概率或联合概率。

信息论复习提纲

信道传递概率可以用信道矩阵来表示:

x1 x2 P xr

y1 p( y1 | x1 ) p( y | x ) 1 2 p( y1 | xr )

y2 p( y2 | x1 )

p( y2 | x2 ) p( y2 | xr )

ys p( ys | x1 ) 1 p( ys | x2 ) p( ys | xr )

i

第四章:信道及信道容量

二、离散单符号信道及其信道容量

1.离散单符号信道的数学模型(续14)

例3:求二元删除信道的 H ( X )、H (Y )、H ( X | Y )和I ( X ;Y ) 。

已知

1 3 PX 4 4

1 1 2 2 0 P 1 2 0 3 3

3. 后验概率(后向概率): 贝叶斯公式

p ( xi | y j ) p ( xi y j ) p( y j ) p ( xi ) p ( y j | xi )

p( x ) p( y

i 1 i

r

j

| xi )

(i =1,2,…,r;j =1,2,…,s)

且

p ( xi | y j ) 1

Y y2

ys

i 1, 2,..., r ; j 1, 2,..., s

满足: (1)0≤ p(yj|xi) ≤ 1 (i=1,2,…,r;j=1,2,…,s) (2)

p( y j | xi ) 1

j 1

s

(i=1,2,…,r)

第四章:信道及信道容量

二、离散单符号信道及其信道容量

1.离散单符号信道的数学模型(续2)

r s

第四章:信道及信道容量

《熵和互信息量 》课件

THANKS

决策优化

互信息量可以用于决策优化,通过分析不同 决策之间的互信息量,可以找到最优的决策

方案。

机器学习与深度学习

数据表示

熵和互信息量可以用于数据表示,将数据转换为更有意 义的特征表示,从而提高机器学习模型的性能。

模型优化

熵和互信息量可以用于模型优化,通过分析模型参数的 熵和互信息量,可以找到最优的模型参数配置,提高模 型的泛化能力。

06 熵和互信息量的关系与区别

熵和互信息量的关系

01

熵是系统不确定性的度量,表示系统内部信息的平 均量。

02

互信息量用于衡量两个随机变量之间的相互依赖程 度。

03

当两个随机变量独立时,互信息量为零;当两个随 机变量完全相关时,互信息量达到最大值。

熵和互信息量的区别

01

熵是对整个系统不确定性的度 量,而互信息量是衡量两个随 机变量之间的相互依赖程度。

05 熵和互信息量的应用场景

信息压缩与编码

信息压缩

熵是衡量数据不确定性的度量,可用于信息压缩。通过去除 冗余信息,将数据压缩到更小的空间,从而提高存储和传输 效率。

数据编码

互信息量可以用于数据编码,通过对数据进行分类和编码, 降低数据的熵,从而实现更有效的数据传输和存储。

决策理论

风险评估

熵可以用于风险评估,衡量决策的不确定性 和风险。通过计算不同决策方案的熵值,可 以评估方案的优劣和风险大小。

VS

熵的单位

熵的单位是比特(bit),这是因为log2 p(x)是以2为底的对数函数,其单位是比 特。

熵的物理意义

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

由于互信息 I ( xi ; y j )是表示观测到 y j 后获得的关于 事件 xi 的信息量,即 p ( xi | y j ) I ( xi ; y j ) log p ( xi ) 故平均条件互信息量又可以表示为

I ( X ; y j ) p ( xi | y j ) log

互信息量I(xi;yj)不能从整体上作为信道中信息流 通的测度。

这种测度应该是从整体的角度出发,在平均意义上度量 每通过一个符号流经信道的平均信息量。 作为一个测度,它不能是随机量,而是一个确定的量。

3

HUST Furong WANG--- Information and Coding Theory

9

HUST Furong WANG--- Information and Coding Theory

平均互信息量的其它定义

平均互信息量I(X;Y)也可定义为

I ( X ; Y ) p ( xi y j ) log

XY def def

p ( xi | y j ) p ( xi ) p ( y j | xi ) p( y j )

平均条件互信息量

定义: 在联合集XY上,由 y j提供的关于集X的 平均条件互信息量等于由 y j 所提供的互信息量I ( xi ; y j ) 在整个X中以p( xi | y j )后验概率加权的平均值,其 定义式为 def

I ( X ; y j ) p( xi | y j ) I ( xi ; y j )

X

T Furong WANG--- Information and Coding Theory

互信息量—信道中信息流通的测度?

互信息量I(xi;yj)是定量研究信息流通问题的重要 基础。

它只能定量地描述输入随机变量发出某个具体消息xi, 输出变量出现某一具体消息yj时,流经信道的信息量。 “输入xi ,输出yj”是一个概率为p(xi yj) 的随机事件, 相应的I(xi;yj)也是随xi和yj变化而变化的随机量。

10

当xi 和y j 相互独立时,I ( xi ; y j ) 0 (i 1, 2,; j 1, 2,) 且I ( X ; Y ) 0

HUST Furong WANG--- Information and Coding Theory

平均互信息的性质

平均互信息量有以下基本性质:

13

HUST Furong WANG--- Information and Coding Theory

性质2:对称性I(X;Y)=I(Y;X)的证明

证明:按定义

I ( X ; Y ) p ( xy ) log

7

HUST Furong WANG--- Information and Coding Theory

定理

I(X;yj)≥0 的证明

p( xi | y j ) p ( xi ) 改写为 I ( X ; y j ) p( xi | y j ) log p( xi ) p ( xi | y j ) X

n m

定义:互信息量I(xi;yj)在联合概率空间P(XY)中的统计平均值

I ( X ; Y ) p( xi y j ) I ( xi ; y j ) p ( xi y j ) log

i 1 j 1 i 1 j 1

n

m

p( xi / y j ) p( xi )

称I(X;Y)是Y对X的平均互信息量,简称平均互信息,也称平均 交互信息量或交互熵。 平均互信息I(X;Y)克服了互信息量I(xi;yj)的随机性,成为一 个确定的量,因此,可以作为信道中流通信息量的整体测度。

p

i 1

n

i

1

p

j 1

m

j

1

4

HUST Furong WANG--- Information and Coding Theory

输入X、输出Y的联合空间XY

以{ XY , p ( xy )}表示二维联合概率空间 XY x1 y1 , x1 y2 , , xi y j , , xn ym p ( xy ) p ( x y ), p ( x y ), , p ( x y ), , p ( x y ) i j n m 1 2 1 1 其中, 和Y的联合空间 XY {xi y j ; xi X , yj Y , i 1, 2,..., n; j 1, 2,..., m}, X 对每组事件(积事件)xi y j XY 相应的概率二维联合概率p ( xi y j ), 且 p ( xi y j ) 1; p ( xi ) p ( xi y j ); p ( y j ) p ( xi y j );

8

HUST Furong WANG--- Information and Coding Theory

平均互信息量

定义:平均互信息量I(X;Y)是平均条件互信息量I(X;yj)在整个 集Y上的概率加权平均值。其定义式为

I ( X ; Y ) p( y j ) I ( X ; y j )

Y

5

若对于所有的i, j,事件xi 和y j ; 彼此统计独立, 且有p ( xi y j ) p ( xi ) p ( y j ) i, j 成立, 则称集X 与Y 统计独立, 否则称集X 与Y 统计相关

HUST Furong WANG--- Information and Coding Theory

X

p ( xi | y j ) p ( xi )

6

HUST Furong WANG--- Information and Coding Theory

定理

定理: 联合集XY上的平均条件互信息量有 I(X; yj ) 0 等号成立当且仅当X集中的各个 xi 都与事件 y j 相互 独立。

平均条件互信息量表示观测到yj后获得的关于集X 的平均信息量。 I(X; yj)仍然是一个随机变量,随yj的变化而变化, 因此,不能作为信道中流通信息量的整体测度。

2、非负性I(X;Y)≥0

当且仅当X与Y相互独立时,等号成立。即如果X与Y相互 独立,它们之间相互不能提供任何信息。

12

HUST Furong WANG--- Information and Coding Theory

性质1:非负性I(X;Y)≥0的证明

证明: 按照平均互信息的定义式 p ( xi ) I ( X ; Y ) p ( xi y j ) log ; p ( xi | y j ) XY 利用不等式 ln w w 1; 和关系式 log w ln w log e p ( xi ) I ( X ; Y ) p ( xi | y j ) p ( y j ) 1 log e XY p ( xi | y j ) p ( xi ) p ( y j ) p( xi | y j ) p ( y j ) log e 0 XY XY 等号成立的条件是, 对于i, j 都有p ( xi ) p ( xi | y j ), ( p( y j ) 0) 即 当且仅当X 与Y 相互独立时, I ( X ; Y ) 0 证毕

证明 : 将平均条件互信息量的表示式 I ( X ; y j ) p( xi | y j ) log

X

p( xi ) 令 w 则有 I ( X ; y j ) p( xi | y j ) log w p ( xi | y j ) X 利用不等式 ln w w 1; log w ln w log e p( xi ) 得 I ( X ; y j ) p ( xi | y j ) 1 log e p ( xi ) p ( xi | y j ) log e 0 X X p( xi | y j ) 故 I(X ; yj ) 0 当且仅当 p ( xi ) p ( xi | y j ) 时,I ( X ; y j ) 0 证毕

HUST Furong WANG--- Information and Coding Theory

第2章 信源熵

2.1 单符号离散信源

2.1.1 单符号离散信源的数学模型 2.1.2 自信息和信源熵 2.1.3 信源熵的基本性质和定理 2.1.4 加权熵的概念及基本性质 2.1.5 平均互信息量 一、平均互信息量定义 二、平均互信息量物理意义 二、平均互信息量性质 2.1.6 各种熵之间的关系

I ( X ; Y ) p ( xi ) p ( y j | xi ) log

XY

I ( X ; Y ) p ( xi y j ) I ( xi ; y j )

XY

def

其中I ( xi ; y j ) log

p ( xi | y j ) p ( xi )

log

p ( y j | xi ) p( y j )

输入X、输出Y的离散概率空间描述

以{ X , P}表示输入离散概率空间 X x1 , x2 , , xi , , xn P ( X ) p ( x ), p ( x ), , p( x ), , p( x ) 1 2 i n 其中,输入离散事件集 X {xi , i 1, 2,..., n}, 对每一个事件xi X , 相应的概率为p ( xi ),简记为pi, P { pi ,i 1, 2,..., n}, pi 0,i 1, 2,..., n; 且 以{Y , P}表示输出离散概率空间 Y y1 , y2 , , y j , , ym P (Y ) p ( y ), p ( y ), , p ( y ), , p( y ) 1 2 j m 其中,输出离散事件集 Y { y j , j 1, 2,..., m}, 对每一个事件y j Y , 相应的概率为p ( y j ),简记为p j, P { p j ,j 1, 2,..., m}, p j 0,j 1, 2,..., m; 且